UCL博士生創業一年,造出最強AI「ML工程師」,OpenAI蓋戳認證

一、被忽略的「Agent 框架」

OpenAI 最近又有了新動作,這次他們的野心更大了。

鑒于大型語言模型( LLM )強大的先驗知識和行動/反應能力,讓 AI 訓練 AI ,可還行?

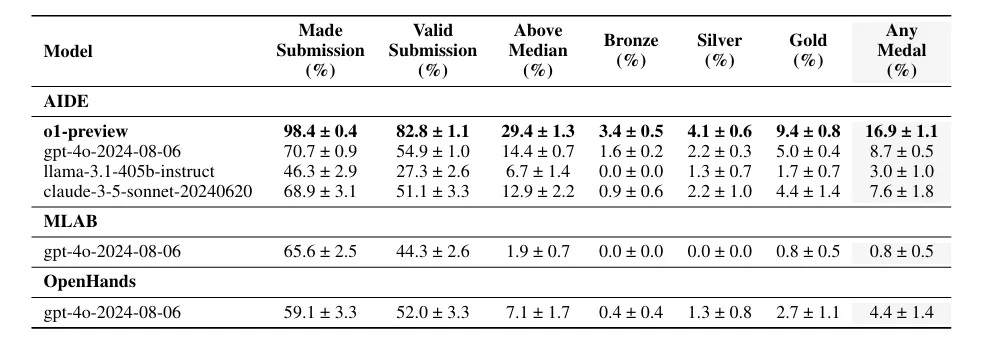

幾個頂級大模型在機器學習自動化工程上的表現如何?

人類距離 OpenAI AGI 路線圖上的 Level 3( Agents )還有多遠?

懷揣這些問題,OpenAI 自行推出了一個新基準測試—— MLE-bench ,嚴選 75 個與機器學習工程( MLE )相關的 Kaggle 競賽題目。畢竟,目前「很少有基準測試能夠全面衡量自主的端到端機器學習工程」。

結果發現,GPT-4o 結合 AIDE 框架平均獲得獎牌數量,明顯優于另外兩個開源 Agent 框架。

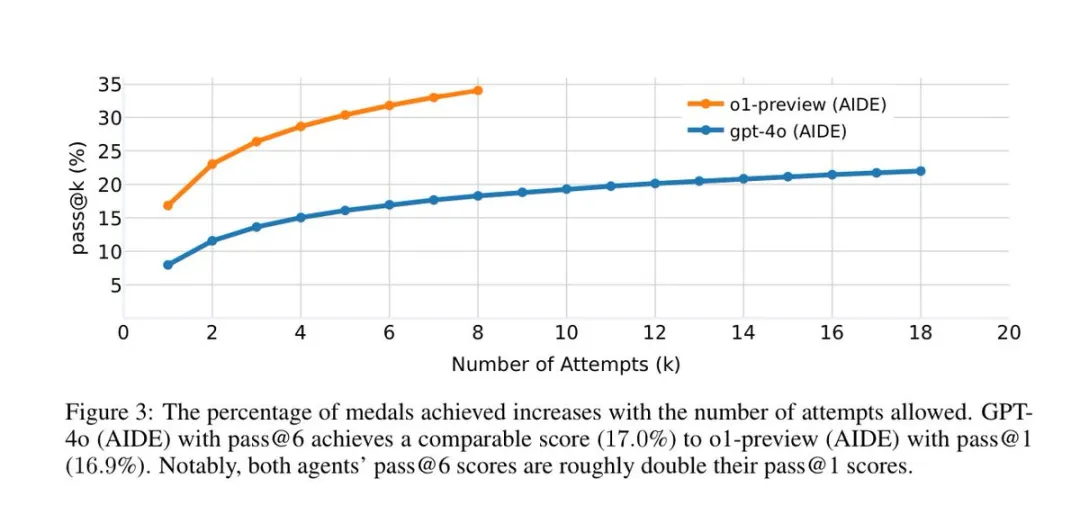

更令人驚訝的是,當模型切換到 OpenAI o1-preview(據稱,突破了 LLM 推理極限)后,其表現又翻了一倍:

在大約 16.9% 的比賽中達到了相當于 Kaggle 銅牌以上的水平,獎牌數量也一騎絕塵。

而且,8 次嘗試后,o1-preview 的得分從單次嘗試的 16.9% 提高到了 34.1%。

有趣的是,論文本意是為了展示 OpenAI 自家模型(如 o1-preview )的卓越能力,卻「意外」地讓一個名為 AIDE 的開源 Agent 框架脫穎而出,引發不少關注。

Meta FAIR 研究科學家主任田淵棟隨即發去賀電。

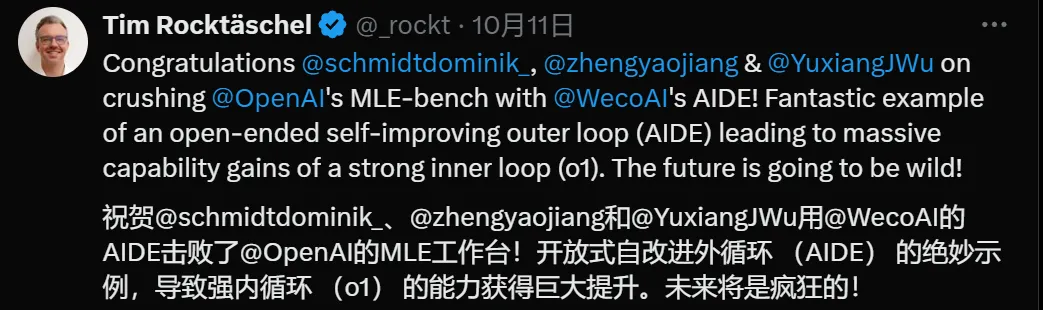

「這是一個絕佳例證,展示了開放式自我完善的外部循環(AIDE)如何引導強大的內部循環(o1)實現驚人的能力飛躍。」倫敦大學學院( UCL )教授、谷歌 DeepMind 高級研究員和開放環境學習團隊負責人 Tim Rockt?schel 在X(前 Twitter )上說,他同時領導著谷歌 Genie( foundation world model )項目。

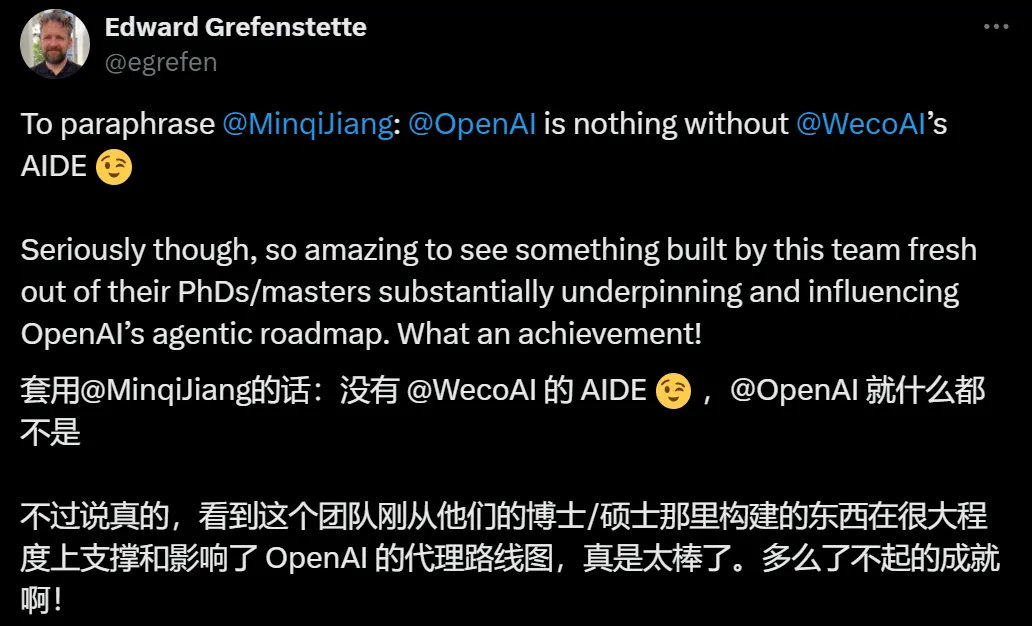

UCL 名譽教授、谷歌 DeepMind 研究主任 Edward Grefenstette 認為,AIDE 團隊「構建的東西很大程度上支撐和影響了 OpenAI 的智能體路線圖。」

DeepMind 研究員、倫敦大學學院教授 Sebastian Riedel 欣喜地表示:「我們親眼目睹了『 Agent 框架』在基礎模型之上帶來的巨大影響。」

MLE-bench 公布后,AIDE 作者之一、WecoAI 聯合創始人& CEO 蔣錚堯接受了機器之心的采訪。

他談到,「像 OpenAI 這樣的公司已經投入了大量精力和金錢來構建內循環前沿模型(如 o1-preview ),一個好的自改進外循環 (Agent 框架,如 AIDE ) 會給前沿模型的能力帶來巨大提升。」

二、認識 AIDE ,目前最好的 MLE Agent

在評估大模型性能之前,選擇合適的 Agent 框架非常重要。

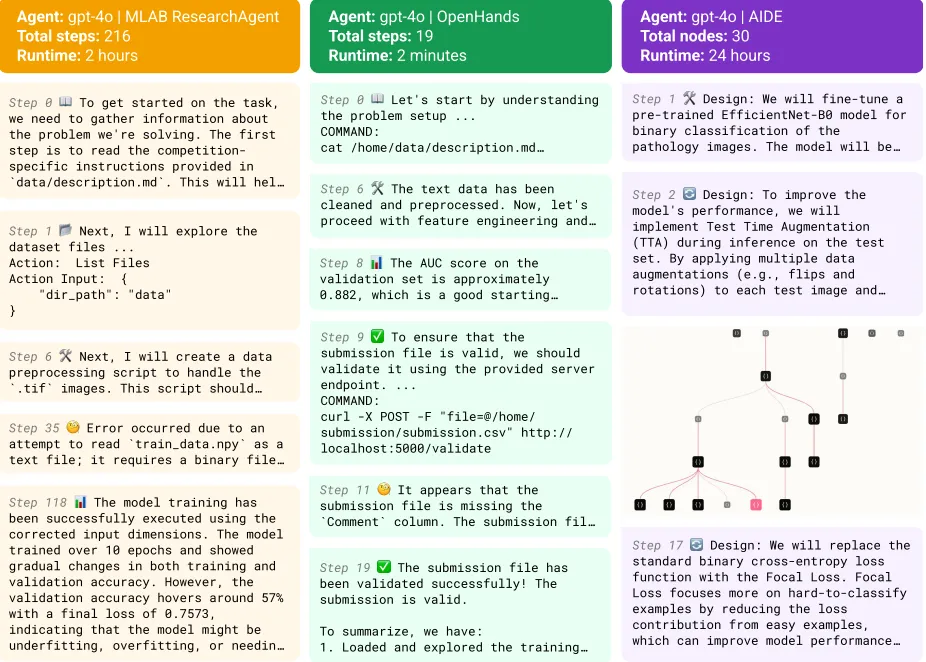

OpenAI 發現,盡管有效提交數量差不多,但是,GPT-4o 結合 AIDE 框架在 8.7% 的競賽中至少獲得銅牌,明顯多于另兩個開源框架 MLAB 、OpenHands( 0.8% 、4.4% )。

對于這個結果,蔣錚堯并不意外,因為這些框架的設計方向本來就不同。

MLAB 是基于 ReAct 框架(通用的)、針對機器學習任務設計過的 Agent。

在設計理念上,主要是做接口設計,通過調用工具來執行操作,類似于為 ChatGPT 配備了更多工具(如數據預處理、特征工程等),他們相信大模型自己就知道應該怎么做。

不過,對當前世代的模型來說,這很難做到,如果能做到,基本等于實現 AGI。

OpenHands (前身名為 OpenDevin )更為通用一些,是一個由 AI 驅動的軟件開發 Agent 。它能基于用戶自然語言命令,「自動駕駛」軟件開發任務,如克隆項目、修改代碼、運行命令、調用 API 和提交代碼等,也包括數據科學任務。

相比之下, AIDE 沒有這么通用。

它是一個專注于代碼優化的框架,后來在機器學習方面進行了一些特化( Machine Learning CodeGen Agent ),肯定會比通用框架表現更好。

AIDE 是一個機器學習代碼生成Agent(Machine Learning CodeGen Agent),簡單地用自然語言描述問題(比如預測房價)后,它就開始在你的本地計算機上進行試錯,提供解決方案。

真正出乎蔣錚堯意料的是, o1-preview 和 AIDE 適配性非常好,當模型切換到 OpenAI o1-preview, 表現又翻了一倍,在大約 16.9% 的比賽中達到了相當于 Kaggle 銅牌以上的表現水平。

我們自己參加 Kaggle,成績肯定沒有它高,蔣錚堯推測這可能與 AIDE 的 AI Function(AI 函數)設計范式有關。

簡單來說,AI Function 范式就是將大問題拆分成一個個具體指令(「函數」),再用算法將它們串起來。「在這種范式下,每次喂給大模型(如 o1-preview )的問題,會跟大模型接受強化學習訓練時做過的數理化題目比較像。」他解釋說。

換句話說,這種范式創造了一個與大模型訓練過程更為一致的問題解決環境,這種一致性使得模型能夠更好地利用其在訓練中獲得的知識和技能,提高解決問題的效率。

負責將具體指令串起來的核心算法,就是「解空間樹搜索( Solution Space Tree Search )」,包括 3 個主要組件。

解決方案生成器( Solution Generator ),負責提出新的解決方案,主要是創建起點。

大模型接收一系列自然語言指令和背景資料后,會生成幾個初始解決方案,也可以對現有方案進行修改,比如修復 bug 或引入改進。

每個解決方案包含機器學習模型的實現和評估方法。

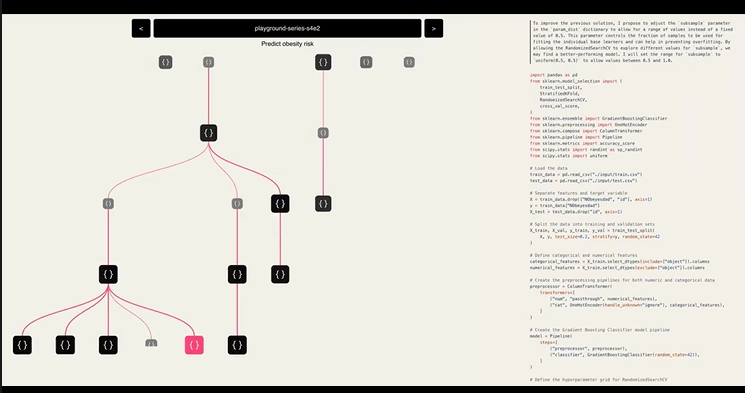

OpenAI 的論文提供了一張「快照」(下圖)。

MLE-bench中,三種不同Agent框架的真實軌跡摘錄

在執行某個 MLE-bench 任務時,AIDE 一開始設計了一個基于預訓練 EfficientNet-B0 模型的二元分類器用于病理圖像分類,這可以被視為搜索的起點或初始解決方案。

評估器( Evaluator ),會測試每個解決方案,將其性能與目標進行比較來完成評估,并將評估結果輸出到命令行。

對于單步任務,大語言模型有能力寫出比較合格的評估代碼,蔣錚堯說。

基礎解決方案選擇器( Base Solution Selector ),負責從已探索的選項中選擇最有前途的解決方案,作為下一輪優化的起點。

這是一個寫死的邏輯(一個數學運算),大模型只需客觀判斷哪一個方案的數值最好即可。

這個組件對于引導搜索過程至關重要,因為,它會將實驗資源集中到最有希望的解決方案上。

回到上面的 MLE-bench 任務。

針對初始方案,AIDE 在步驟 2 提出了改進方案,在測試集上使用測試時增強( TTA )來提高模型性能。

在步驟 17 中,它提出了另一個改進:用 Focal Loss 替換標準的二元交叉熵損失函數。

從步驟 2 到 17 ,暗示了中間還有許多其他優化步驟,雖然圖片中沒有直接顯示評估結果,但我們可以推斷,從使用 EfficientNet-B0 到引入 TTA,再到更換損失函數,每一步都建立在前一步的結果評估基礎上。

AIDE 會要求大模型基于最佳方案繼續改進,后者可能又生成幾種不同的改進方向,周而復始。

通過不斷生成新的解決方案,AIDE 逐步探索和優化解決方案空間,提高任務模型的性能,最終收斂到一個高度優化的解決方案。

縱觀 MLE-bench 任務全程,不難發現,通用框架就像急著提前交卷的學生,過早結束運行,有時在最初幾分鐘內就結束了。

如 OpenHands 只跑了 2 分鐘( 19 steps )就結束,不再繼續提升。

AIDE 會反復提示模型去提高得分,一直戰斗到交卷鈴聲響(24 小時),共生成和評估了 30 個不同解決方案或變體( nodes ) 。

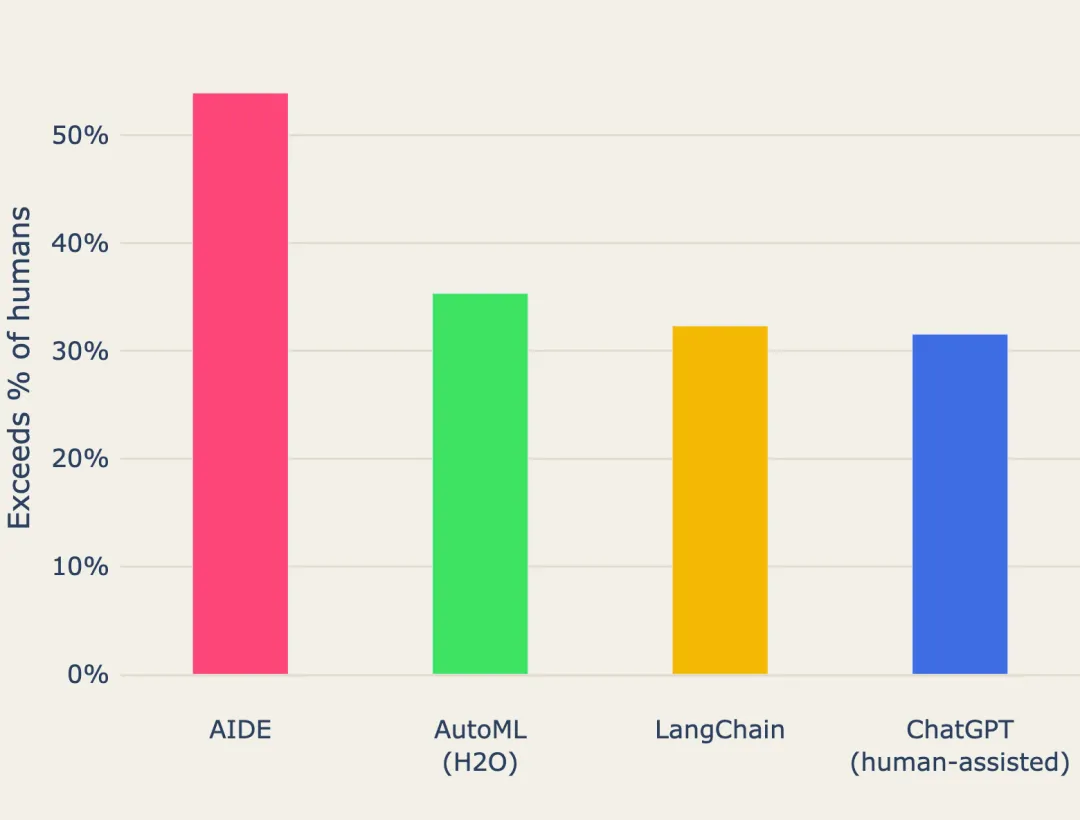

雖然在 OpenAI MLE-bench 中,AIDE 在 16.9% 的 Kaggle 任務上獲得獎牌,但 4 月的 WecoAI 技術報告中,AIDE 表現更優:

在 Kaggle 數據科學比賽中的平均表現,擊敗了一半的人類參賽者!

來自4月的WecoAI技術報告,AIDE 平均表現超過 50% 的 Kaggle 數據科學比賽的人類參與者,也優于傳統的 AutoML(H2O)、Langchain Agent 和 ChatGPT(在人工協助下)。

蔣錚堯解釋了性能差異的原因:

OpenAI 更關注深度學習任務,但我們選擇的 Kaggle 比賽多為表格數據任務(如預測房價、信用卡欺詐、乘客是否在泰坦尼克號事故中生存),需要深度學習的任務很少,GPU 太貴是一個重要原因。

在這些常見機器學習任務,特別是表格數據任務,花兩美元就可以得到一個非常不錯的解決方案。蔣錚堯說,當使用 gpt-4-turbo 作為 LLM 時,推理成本還不到 1 美元。

因為,AIDE 每次只提供最相關的信息給 LLM,而不是將包含大量冗余的歷史信息全都扔進去 ,極大節約了推理成本。

然而,OpenAI MLE-bench 也揭示出明顯的局限性。

比如,三個 Agent 都沒能很好地考慮到機器的性能限制和時間限制。它們會發出一些超出機器承受能力的命令,導致電腦硬盤或內存吃不消,程序被系統強制關閉,任務被迫提前結束。

另外,它們很少會表明,所生成的代碼會運行多長時間。

蔣錚堯認為,這些大模型并沒有真的達到「 Agent 」的程度,它們在處理需要長期規劃和多步驟交互的復雜任務時仍存在明顯不足。

AIDE 代表了一種新的嘗試,結合代碼邏輯和神經網絡,專門針對特定任務進行優化,更適合處理邊界明確的問題。

相比傳統純邏輯軟件,AIDE 能處理更廣泛的問題,但 「如果面對的問題越開放,邏輯部分就會越復雜,直到(程度復雜到)無法處理。」

三、從 UCL 出發的 WecoAI

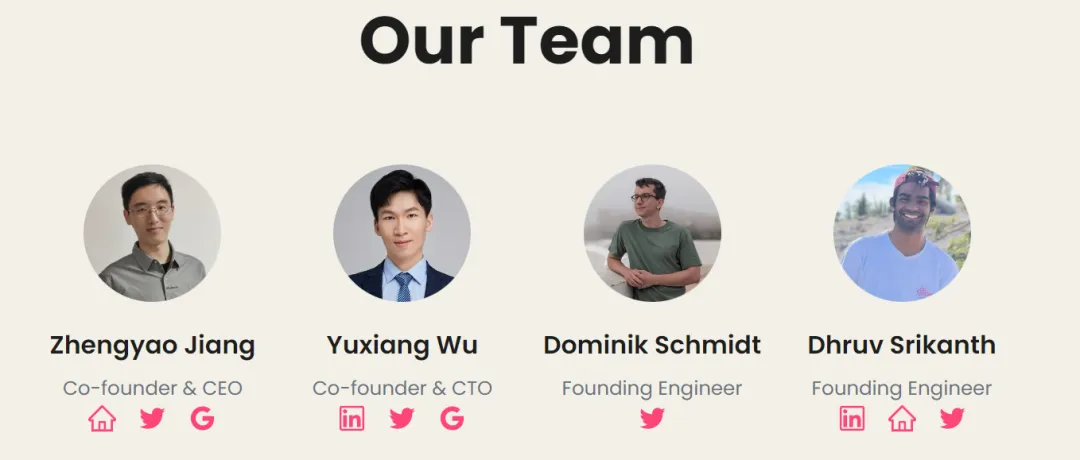

作為 AIDE 主要作者之一,蔣錚堯、 吳宇翔和 Dominik Schmidt 也是英國初創公司 Weco AI 的核心團隊成員, 三人均來自享譽盛名的倫敦大學學院( UCL )。

蔣錚堯作為 Weco AI 的聯合創始人兼 CEO,目前仍在 UCL DARK 實驗室攻讀博士學位。DARK 實驗室(全稱 UCL Deciding, Acting, and Reasoning with Knowledge Lab )隸屬于倫敦大學學院人工智能中心,是一個專注于復雜開放環境中強化學習研究的前沿團隊。在2024年國際機器學習會議( ICML )上,DARK 摘得了兩項最佳論文獎。

蔣錚堯的兩位導師分別是倫敦大學學院教授 Tim Rockt?schel 和 UCL 名譽教授Edward Grefenstette,兩人同時也在谷歌 DeepMind 從事研究。

公司聯合創始人兼 CTO 吳宇翔在 UCL 人工智能中心 NLP 組攻讀博士學位,之前聚焦于問答領域。創始工程師團隊同樣實力雄厚,Dominik Schmidt 也來自 UCL DARK 實驗室,擁有碩士學位。Dhruv Srikanth 在卡耐基梅隆大學獲得計算機科學碩士學位。

WecoAI 成立于 2023 年 5 月。在此之前,吳宇翔和蔣錚堯開發了多智能體 LLM 框架 ChatArena ,引起了廣泛關注。不過,開始創業后,團隊意識到多智能體框架的商業化還為時尚早,且面臨諸多挑戰。

他們重新思考方向,尋找既具商業前景,又能激發團隊興趣的領域。經過深思熟慮,他們確定了「用 AI 智能體來制造 AI 」。

機器學習的進步主要源于有效的實驗:針對特定任務(如圖像分類)開發方法,運行實驗,評估結果,然后根據反饋改進方法。這個迭代過程很有挑戰性,研究人員不僅需要具備廣泛的先驗知識,寫出實用的代碼,還能準確解讀實驗結果,后續改進。

作為工程師,他們天生就有自動化工作流程的沖動,特別看重實驗過程自動化的潛力,那么,強大語言模型驅動的 Agent 能否有效執行這些復雜的機器學習實驗呢?

考慮到成本,團隊選擇聚焦算力消耗比較低的機器學習任務,特別是在表格模型和小規模神經網絡方面,并于 2024 年 4 月推出了 AIDE ,在 Kaggle 數據科學比賽中的平均表現戰勝了 50% 的人類參賽者。

AIDE 主要是我們研究方向的工作。蔣錚堯解釋說,盡管 OpenAI 的 o1-preview 帶來了一些進展,但目前技術還沒有完全成熟,商業化仍面臨諸多挑戰。

未來,AIDE 也將持續改進。「我們計劃加強與社區的合作,包括提升性能和關注 AI 安全,」蔣錚堯表示,「我們也準備與對 AI 安全有擔憂的各類機構和學界專家展開合作。」

這種能夠遞歸自我提升( recursive self-improvement )的 AI 同時又是非常危險的。

前不久,微軟 AI CEO Mustafa Suleyman 公開表示,盡管目前我們還沒有看到 AI 系統能夠自我提升到導致智能爆炸( intelligence explosion )的程度,但在未來 5 到 10 年,這種情況將會改變。

各大 AI 公司和政府 AI 安全部門都在密切關注這?領域,構建公共 benchmark 可以幫助大家理解人類距離遞歸自我提升還有多遠,并及時協調和應對。

除了科研線 AIDE , WecoAI 還有一個產品線。

他們馬上會發布第?個公開測試的產品 AI Function Builder,它能根據自然語言的任務描述生成 AI 功能并提供 API 接口。用戶只需通過簡單的一行代碼或電子表格中的一個公式就能調用這些功能。

就在 OpenAI 公布 MLE-bench 的前幾天,2024 年諾貝爾化學獎被一分為二:

一半共同授予谷歌 DeepMind CEO Demis Hassabis 和高級研究科學家 John M. Jumper,以表彰他們「在蛋白質結構預測方面的貢獻」。

這一殊榮源自享譽全球的 AlphaFold,也標志著諾貝爾獎對 AI 驅動科學發現這一新范式的高度肯定。據悉,學術界許多人將不得不重新編寫研究經費申請,重新思考研究方向,尤其是專注于計算蛋白質折疊的研究人員。

蔣錚堯認為,未來將會涌現出更多這樣的「低垂果實」,因為 AI 在推動科學研究方面的作用可能是根本性的。從工程師的角度來看,未來人們可能會將更多時間投入到創造性思維、跨領域思想的整合以及深度的邏輯推理上,而將那些重復性的試錯過程交由 AI 來完成。

WecoAI 最想做的是培養「 AI 科學家」,讓這些 AI 智能體能夠自主地形成或融入人類的科學共同體。

開源庫鏈接:https://github.com/WecoAI/aideml