當視覺大模型陷入認知失調,馬里蘭大學構建了一個幻覺自動生成框架

本文的共同第一作者是馬里蘭大學電子計算機工程系的博士生吳曦旸(https://wuxiyang1996.github.io/)和計算機科學系的關天瑞(https://tianruiguan.phd/)。吳曦旸的研究方向主要涵蓋強化學習、自動駕駛,以及大語言模型在機器人導航和計算機視覺中的應用。關天瑞的研究則聚焦于計算機視覺和視覺語言模型在機器人、自動駕駛等領域的應用。本文的指導老師為李典奇,周天翼教授 (https://tianyizhou.github.io/)和 Dinesh Manocha 教授 (https://www.cs.umd.edu/people/dmanocha)。

想象一下,有一天你在沙漠中看到一個雪人,或者在雪地里發現一棵棕櫚樹。面對這些與周圍環境格格不入的景象,你是否會感到心理上的不適?

在認知科學領域,研究者普遍認為人腦傾向于利用以往的經驗來解讀觀察到的信息并構建記憶。然而,當人腦接收到與以往認知不符的信息時,可能會因為 “認知失調”(Cognitive Dissonance)而對外部環境產生誤判,進而在行為上表現出矛盾。例如,我們通常認為電腦是由人類操控的,但如果我們看到一只章魚在操控電腦,這種不符合常理的場景會讓人腦產生認知失調的不適感。

隨著對大模型的深入研究,研究人員發現,在認知和推理任務上,大模型的思維過程與人腦有一定相似之處。因此,針對人腦認知失調特點設計的實驗也能使大模型出現類似的 “幻覺” 現象。

基于這一觀察,馬里蘭大學的研究團隊提出了一個名為 AutoHallusion 的視覺大模型幻覺自動生成框架。這一工作基于團隊之前在 CVPR 2024 上發表的工作 HalluionBench(https://arxiv.org/pdf/2310.14566)。它通過在場景圖像中插入或刪除特定物體,并針對這些修改后的圖像提問,從而檢測大模型在回答時可能出現的幻覺現象。

這一方法能夠自動生成大量的大模型幻覺案例,有效緩解當前大模型幻覺研究中數據集缺乏的問題。在 GPT-4V、Gemini 和 Claude 等大模型上的實驗表明,這些模型在本文提出的提出的基準數據集上問答準確率最高僅為 66.0%。該研究成果已發表于 EMNLP 2024。

- 論文標題:AUTOHALLUSION: Automatic Generation of Hallucination Benchmarks for Vision-Language Models

- 論文鏈接:https://arxiv.org/pdf/2406.10900

- 項目主頁及代碼:https://wuxiyang1996.github.io/autohallusion_page/

文章概述

大型視覺語言模型(LVLMs)在內容生成、自動駕駛和機器人等領域中扮演著重要角色。然而,它們也會出現 “幻覺” 現象,即生成的響應中包含視覺內容中不存在的信息。這些幻覺通常是由于語言模塊過度依賴語言先驗信息而忽略視覺輸入所致。

為了解決這一問題,之前的工作通常收集幻覺案例建立基準數據集,并以此對大模型進行微調,以減少可能存在的幻覺。然而,手動創建幻覺案例和基準既耗時又昂貴。此外,之前的工作對大模型產生幻覺的機制研究有限,在缺乏足夠代表性案例的情況下對大模型進行微調,可能會導致模型出現過擬合現象。

為此,本文提出了 AUTOHALLUSION 框架,可以自動生成各種幻覺案例并進行批量生產。該框架基于認知科學原理,針對大模型產生幻覺的原因,提出了三種主要策略:插入異常物體、插入成對物體和移除相關物體,通過操控場景中的物體構成來創建與語言先驗相沖突的圖像。

為了生成能夠觸發大模型幻覺的(圖像 - 問題)組合,本文針對修改后的圖像,設計相應的問題探測大模型的語言模塊,定位特定物體或其在相關情境中的語言先驗信息。如果大模型的推理受到語言先驗的偏見影響,例如在根據圖片回答某一特定物體的問題時,大模型根據場景圖片的先驗知識而非物體本身傳遞的信息來作答,那么就可能生成與事實不符或前后不一致的響應,從而導致幻覺現象。

AUTOHALLUSION 在包括 GPT-4V、Gemini、Claude 和 LLaVA 等最新的大模型上進行了實驗,并整理發布了一個基準數據集,來評估模型性能。在該基準數據集上的實驗結果表明,GPT-4V 等大模型的問答準確率最高僅為 66.0%。

數據集地址:https://github.com/wuxiyang1996/AutoHallusion

研究方法

AUTOHALLUSION 的整體流程分為四個部分:

1. 場景生成:AUTOHALLUSION 使用合成或真實世界圖像作為場景圖。例如,在辦公室場景中,假設場景中有電腦、辦公桌、辦公椅等與辦公室主題一致的物體,而不會有炒鍋等與主題無關的物體。圖像可以通過 DALL-E 等圖像生成模型根據提示生成,也可以從 MSCOCO 等公開數據集中提取場景。

2. 圖像處理:AUTOHALLUSION 采用三種策略操控場景中的物體構成,以創建與語言先驗相沖突的圖像:

- 插入異常物體:將與場景主題不相關的異常物體添加到場景中,例如,在辦公室場景中添加通常不會出現的炒鍋。

- 插入成對物體:對通常一起出現的兩個物體進行分離,保留一個并移除另一個。例如,牙刷和牙膏通常一起出現,而在修改后的圖像中,只保留牙刷并移除牙膏。

- 移除相關物體:從原場景中移除一個相關物體,例如,在辦公室場景中抹除顯示器。

3. 構造問題:AUTOHALLUSION 針對圖像處理過程中插入或刪除的物體進行提問,并相應地構造事實信息。問題主要分為兩類:

- 存在性問題:詢問目標物體是否存在于圖像中,問題提示信息的細節級別不一,從不提供額外信息到提供完整的圖像描述。

- 空間關系問題:詢問目標物體與場景中其他物體的相對位置,并在問題提示中提供場景物體的名稱或描述。

4. 幻覺檢測:AUTOHALLUSION 通過對比大模型的回答與事實信息或其他回答,來判斷其回答中是否存在幻覺。目前,AUTOHALLUSION 能夠檢測以下兩種類型的大模型幻覺:

- 正確性:大模型的回答與基本事實不一致。

- 一致性:大模型在面對包括不同級別的補充信息的問題時,無法給出一致的答案,或者在針對某一特定物體的提問中,未能提供與圖像描述一致的答案。

實驗結果

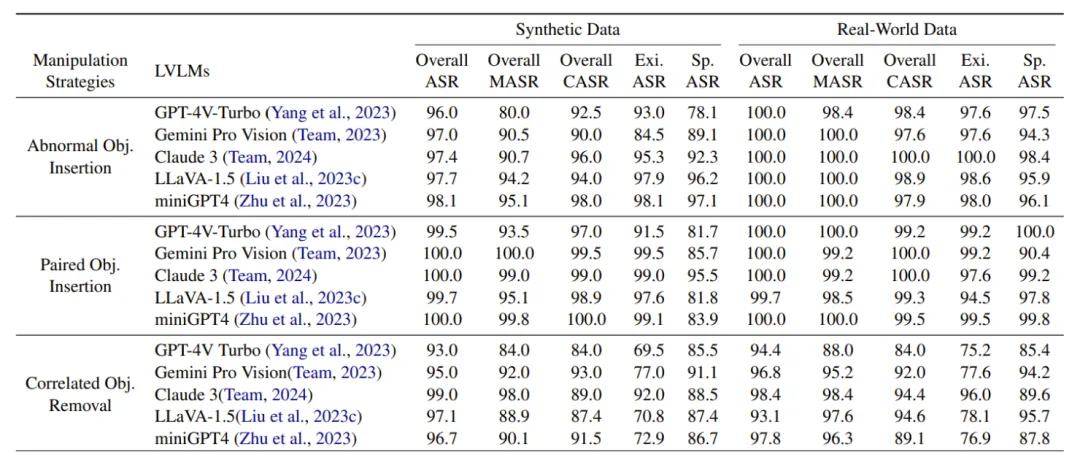

下表展示了通過 AutoHallusion 生成的大模型幻覺案例的成功率,結果顯示出以下幾個主要發現:

- 插入物體的幻覺生成策略比刪除物體的策略更有效。

- 基于物體存在性構建的問題比基于物體空間關系的問題更容易引發幻覺。

- GPT-4V 在防止大模型幻覺方面表現最好。

- 針對真實世界數據集構建的幻覺案例成功率高于合成數據集。本文認為,這可能是由于大模型難以處理真實世界圖像中物體語義關系的復雜性所致。

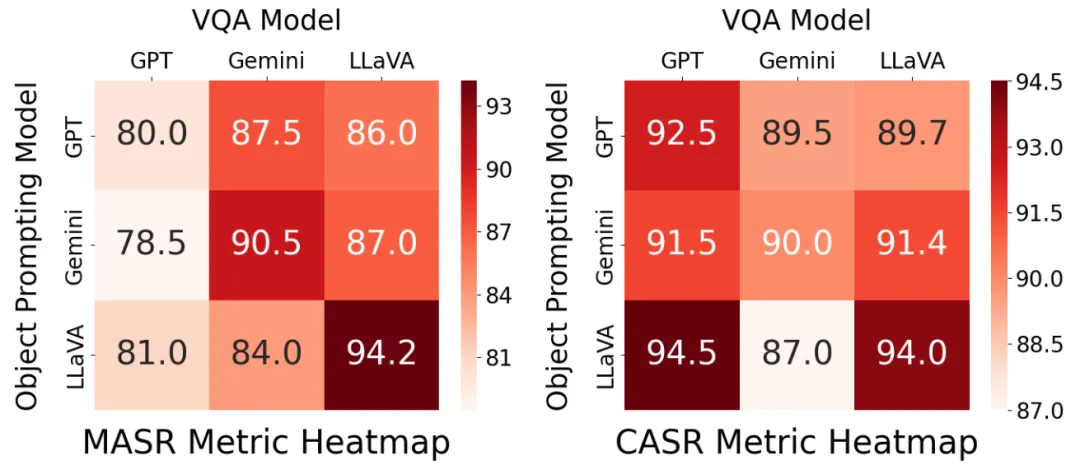

下圖展示了針對物體 - 場景對齊關系的消融實驗結果。在該實驗中,本文采用不同的大模型來生成用于圖像編輯的物體,并在視覺問答(VQA)任務中進行評估。

基準數據集指標

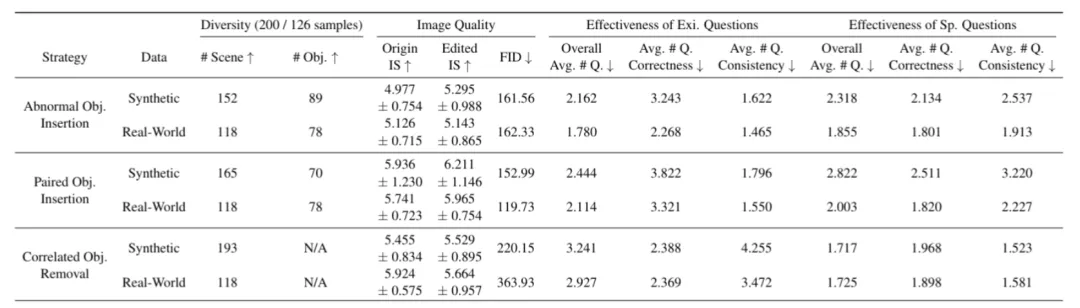

本文從以下三個方面評估了通過 AutoHallusion 生成的基準數據集:

- 多樣性:衡量數據集中不同場景和對象的數量,包括 200 個(合成)/160 個(真實世界)樣本。

- 圖像質量:通過原始圖像和編輯圖像的 IS(Inception Score)分數,以及原始圖像與編輯圖像之間的 Frechet Inception Distance (FID) 距離來評估。

- 有效性:通過每個樣本中引發幻覺的平均問題數量來衡量。

下表展示了 GPT-4V、Gemini、Claude 和 LLaVA 等大模型在通過 AutoHallusion 生成的基準數據集上的表現。