北大等發布多模態版o1!首個慢思考VLM將開源,視覺推理超越閉源模型

北大等出品,首個多模態版o1開源模型來了——

代號LLaVA-o1,基于Llama-3.2-Vision模型打造,超越傳統思維鏈提示,實現自主“慢思考”推理。

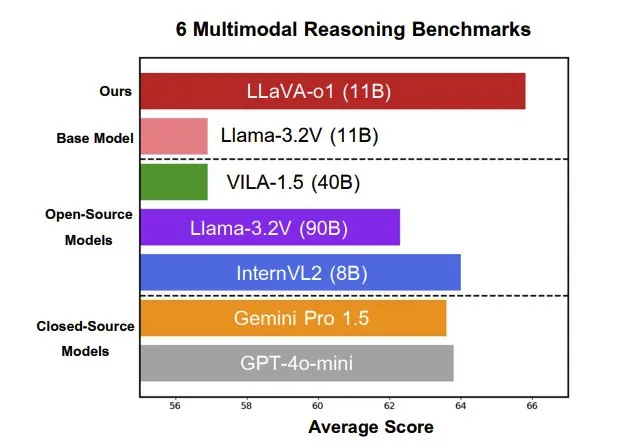

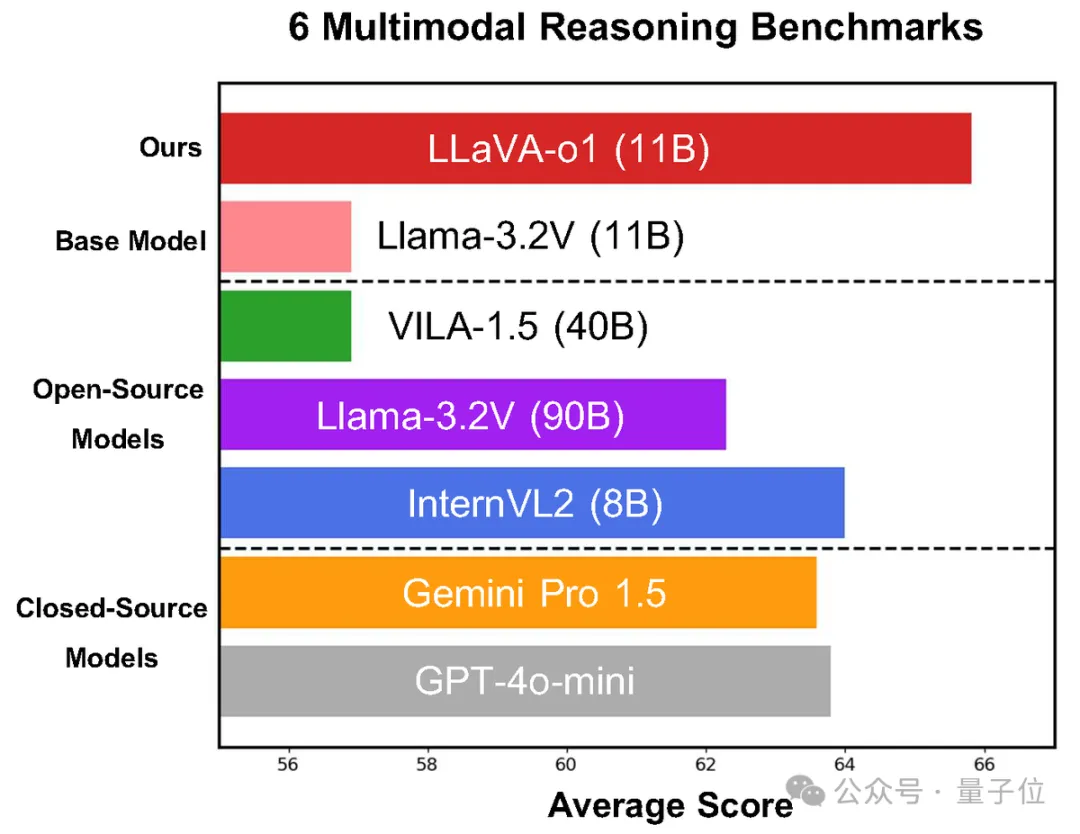

在多模態推理基準測試中,LLaVA-o1超越其基礎模型8.9%,并在性能上超越了一眾開閉源模型。

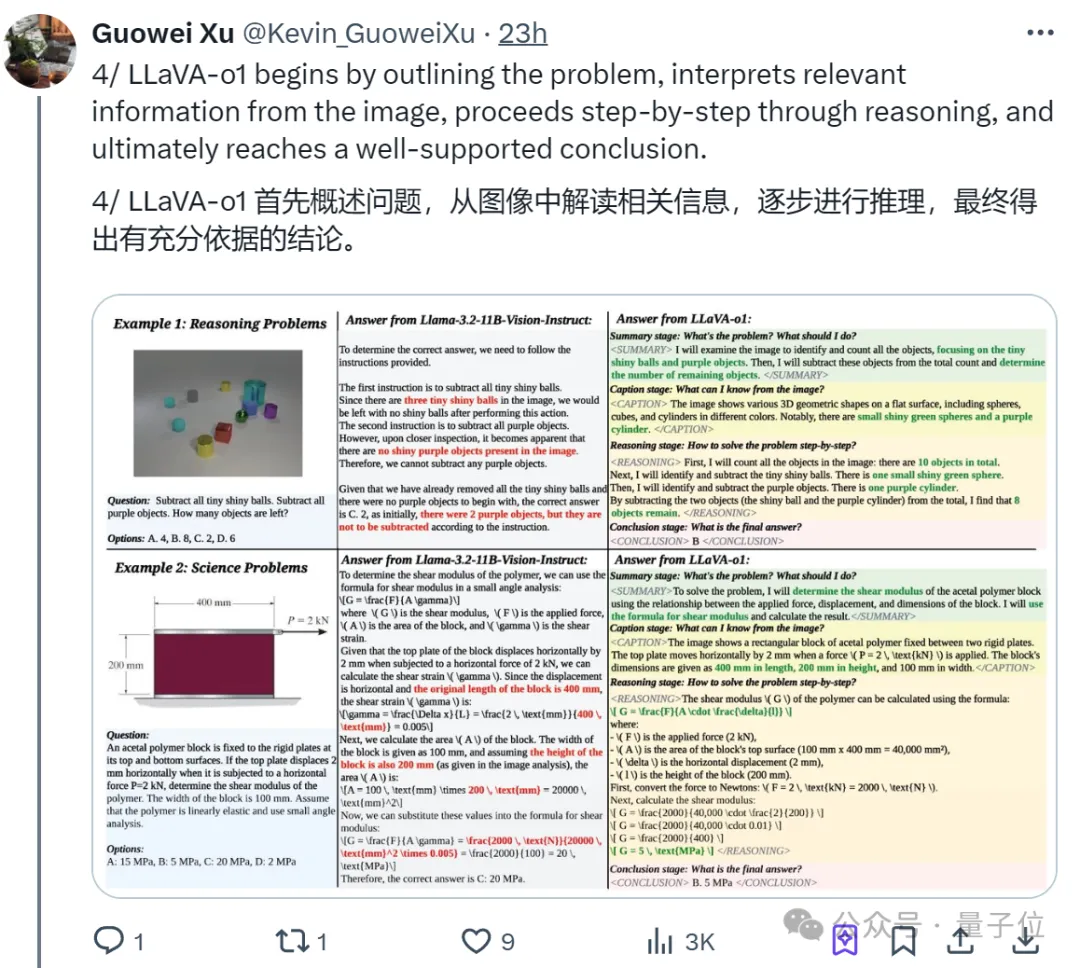

新模型具體如何推理,直接上實例,比如問題是:

減去所有的小亮球和紫色物體,剩下多少個物體?選項:A. 4,B. 8,C. 2,D. 6

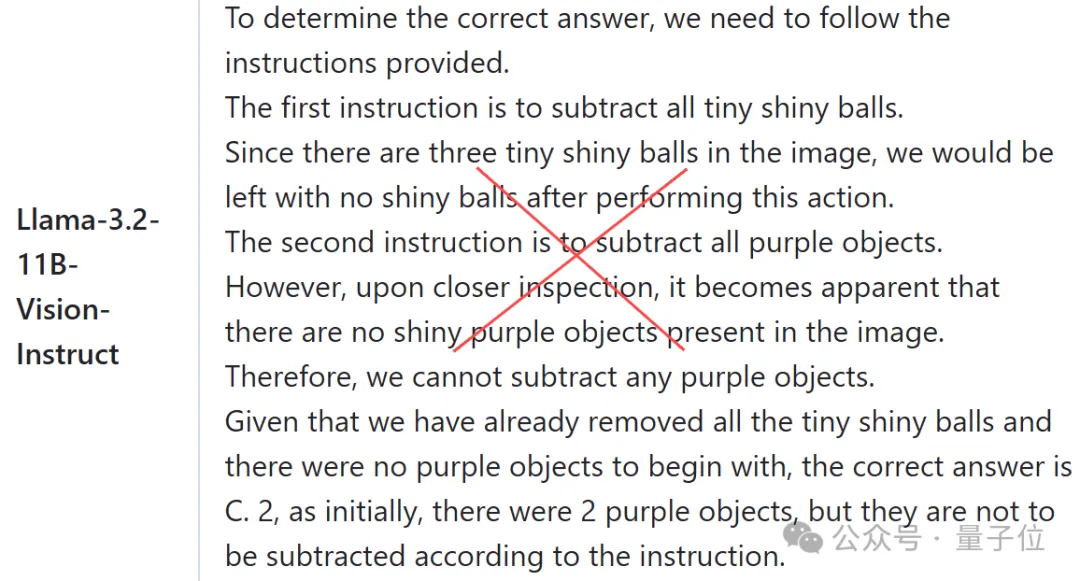

傳統提示詞方法還是老路子,讓Llama-3.2-11B-Vision-Instruct打個樣就是:

第一步減去所有的小亮球;

第二步減去所有紫色物體;

最后給出答案,鑒于我們已經移除了所有的小亮球,而且一開始就沒有紫色物體,正確答案是C. 2;

哐哐一頓輸出,得出錯誤結果。

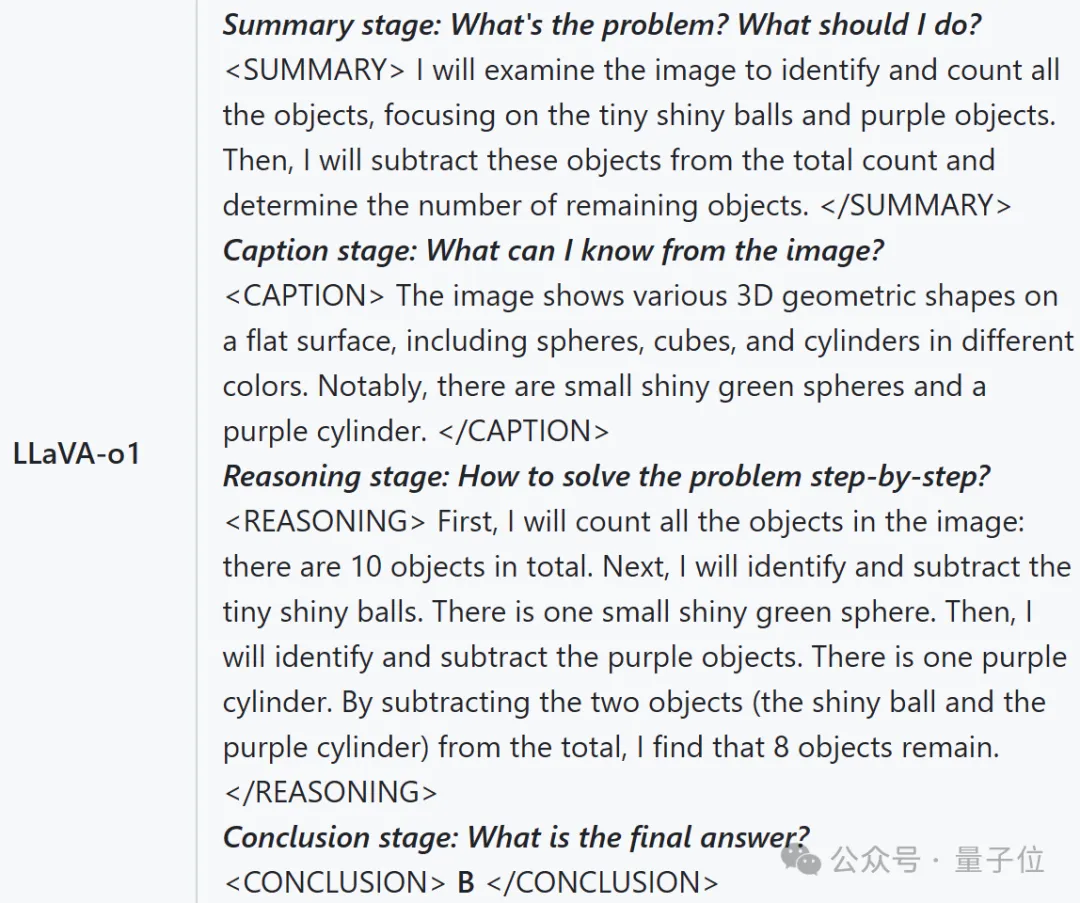

我們再來看LLaVA-o1的推理過程:

總結階段:問題是什么?我應該怎么做?

注釋階段:我能從這張圖片中知道什么?

推理階段:如何一步一步解決問題?

結論階段:最終答案是什么?

是不是明顯不同。這就對了,LLaVA-o1超越傳統COT思維鏈,采用了結構化、多步驟推理。

簡單說,它將推理過程劃分為四個階段,并在每一階段采用優中選優策略來為下一階段提供響應。

難怪看完最新效果,網友們直呼:推理 is all you need!

看來,讓模型思考更多在多模態領域也同樣適用——

“第一個能自發、系統推理的視覺語言模型”

前一陣,o1模型的發布又帶火了COT思維鏈這一推理模式。(像人類一樣步步思考)

于是,讓模型思考更多是否會提高模型能力成為新的研究熱點。

這不,除了像o1這樣的通用大語言模型,北大團隊還瞄上了多模態這一領域——

他們超越傳統COT思維鏈,采用結構化、多步驟推理,一舉推出多模態版o1模型——LLaVA-o1。

作者先澄清了一下, 雖然最近的VLM模型有類似名稱,但LLaVA-o1是建立在Llama-3.2-Vision模型之上,而不是LLaVA。

那么,學會逐步推理的LLaVA-o1有多大提升呢?

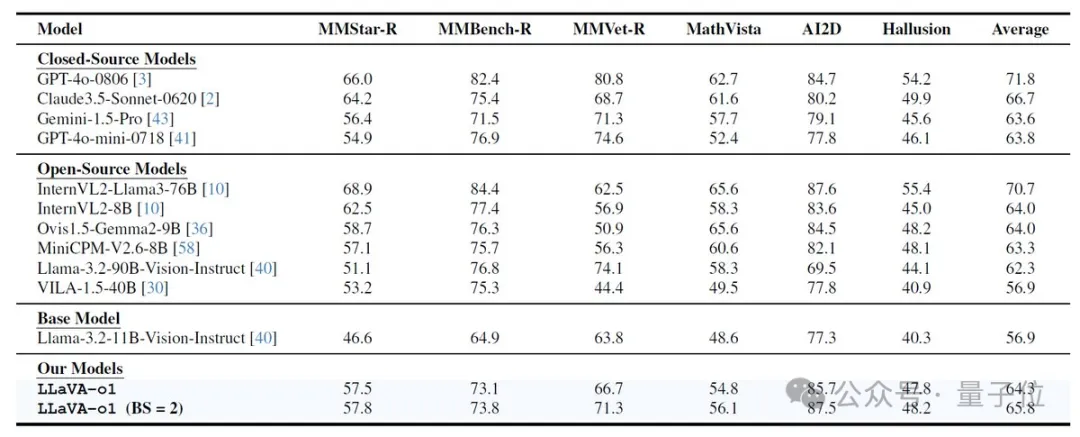

根據論文介紹,僅用一個包含10萬訓練樣本的數據集,LLaVA-o1在多模態推理基準測試中超越了其基礎模型8.9%,并且在性能上超越了更大的模型。

甚至包括一些閉源模型,如Gemini-1.5-pro、GPT-4o-mini和Llama-3.2-90B-Vision-Instruct。

針對這一提升,團隊也發現了背后的關鍵原因:

結構化響應顯著提高了模型的系統推理能力

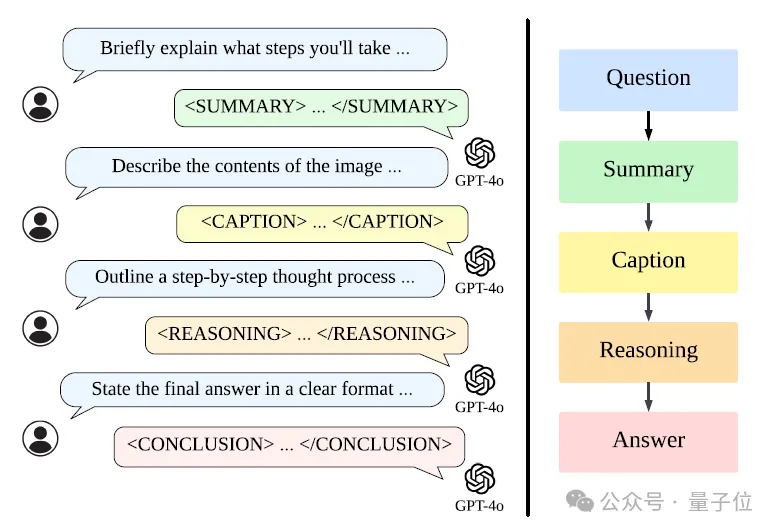

為了使LLaVA-o1更加結構化和系統化,團隊設計了4個標簽來幫助模型識別當前的推理階段,并使用GPT-4o來生成LLaVA-o1-100k數據集。

- <摘要>:該模型簡要解釋了接下來的任務

- <標題>:它描述了圖像中的重要細節(如果有)

- <理由>:它詳細分析了這個問題

- <結論>:它基于分析提供最終答案

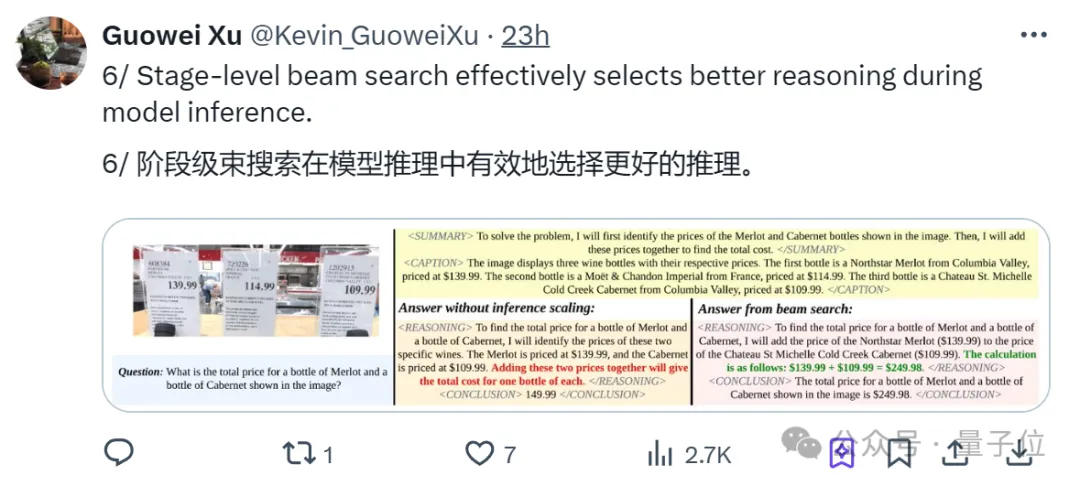

借助這些標簽,LLaVA-o1將推理過程劃分為四個明確的階段:總結(Summary)、視覺解釋(Caption)、邏輯推理(Reasoning)和結論生成(Conclusion)。

與思維鏈提示不同,LLaVA-o1獨立參與了這些連續階段。

不過需要提醒,在LLaVA-o1的推理過程中,前三個階段都在內部處理(對用戶隱藏),而最終結論階段才是用戶可以看到并直接與之交互的。

采用這種設計,可以使模型在不向用戶暴露復雜推理細節的情況下,提供清晰和準確的答案。

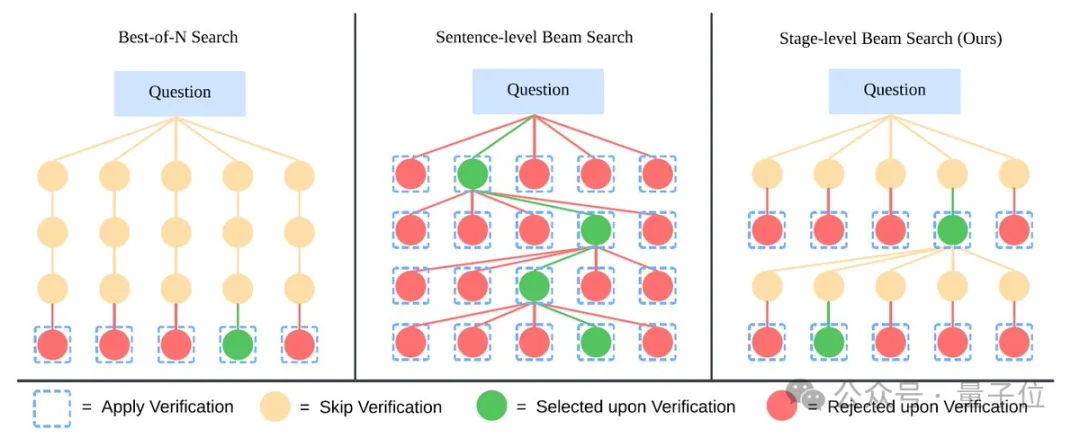

接下來,LLaVA-o1通過監督微調和階段級光束搜索方法(stage-level beam search method)來進一步提升推理能力和推理時間的可擴展性。

這里我們重點說一下團隊創新提出的階段級光束搜索方法。

簡單說,團隊為每個階段(用標簽標記)生成多個響應,并選擇其中最佳的一個進入下一階段。

更具體的,這是一種用于推理時間擴展(Inference-time scaling)的技術,與傳統方法不同,階段級光束搜索專注于模型推理過程中的每個獨立階段。

在這種方法中,模型在每個推理階段生成多個候選結果,然后從中選擇最佳的結果繼續下一個階段的推理。

由于它允許模型在每個階段進行選擇和優化,從而提高了整體推理的質量。

通過這種分階段的搜索策略,LLaVA-o1能夠更有效地進行推理,尤其是在處理復雜的多模態推理任務時。

最后,通過對Llama-3.2-11B-Vision-Instruct模型的微調,結果顯示:

LLaVA-o1在多模態推理基準測試上使用10萬個訓練樣本和簡單的推理時間擴展方法,實現了8.9%的性能提升,超越了同等規模以及更大或閉源的模型。

北大、鵬城實驗室等團隊出品

簡單認識一下研究背后的團隊,論文作者一共6人,下面一一介紹。

Guowei Xu,目前本科就讀于清華姚班,對強化學習、機器人和科學領域的AI應用感興趣。

去年入學以來,他已在國際學術會議上參與發表多篇論文,并獲得2024新生一等獎。

Peng Jin(金鵬),曾在清華大學獲得學士學位,目前是北大三年級博士生,師從袁粒。

他對文本-視頻檢索、跨模態表示學習以及多模態大語言模型感興趣,從2022年9月至今,已有11篇論文被頂會接收。

和他同樣北大博三,師從袁粒的,還有Hao Li(李昊),不過李昊之前畢業于北大計算機科學系。

李昊對多模態學習、視覺理解和化學科學人工智能感興趣,至今已在國際頂會上發表了20多篇論文,總谷歌學術引用量300+。

而他們的老師袁粒,量子位的讀者想必都很熟悉了。

袁粒目前是北大深圳研究生院助理教授,專注于多模態深度學習研究方向,一作論文單篇被引用千余次。

屢屢登上熱搜的ChatExcel、ChatLaw等垂直領域產品,都是出自他的團隊。

另外兩位作者:

Yibing Song(宋奕兵),目前是阿里達摩院研究員/研究經理,之前還是復旦大學的一名教師,并在騰訊AI實驗室擔任高級研究員。

他當前主要對多模態AI感興趣,至今發表了50多篇頂級論文,而且被斯坦福大學選為全球前2%的科學家之一。

Lichao Sun,目前是美國萊赫大學計算機科學與工程系助理教授。

在此之前,他于2020年在伊利諾伊大學芝加哥分校獲得計算機科學博士學位。

他還是多項獎項的獲得者,包括2024年微軟加速基礎模型研究獎、2024年OpenAI研究員獎和NSF CRII獎。

接下來,團隊宣布LLaVA-o1的代碼、預訓練權重、數據集等即將全部開源。

感興趣的童鞋可以蹲一波了~

論文:https://arxiv.org/abs/2411.10440

GitHub:https://github.com/PKU-YuanGroup/LLaVA-o1