向視覺版o1出擊,階躍張祥雨團隊推出“慢感知”,實現感知層面的推理時scaling

視覺版o1的初步探索,階躍星辰&北航團隊推出“慢感知”。

研究人員認為:1)目前多模領域o1-like的模型,主要關注文本推理,對視覺感知的關注不夠。2)精細/深度感知是一個復雜任務,且是未來做視覺推理的重要基礎。

而思路之一是如何把感知做“慢”,即通過某種任務拆解(step-by-step)實現感知層面的inference time scaling。

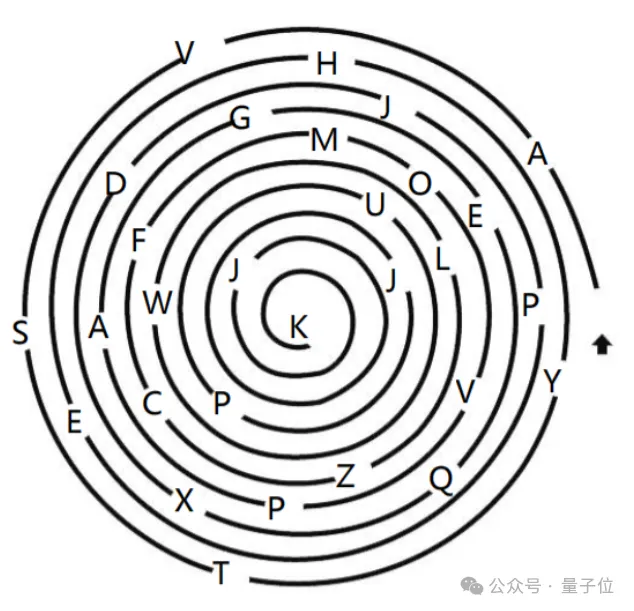

這里有個簡單的例子:

題目是:按照螺旋線的順序,報出每個字母。

這是一道5歲小孩的測試題,但是目前國內外還沒有一個多模模型能夠正確解答。該題讓人來做的話,會先感知并trace這條螺旋線,在attention到字母的位置將其記錄下來,越靠近螺旋線中心,字母挨得會近一些,我們trace的速度也會更慢一點,即申請一部分額外“推理計算量”,以保證不會出錯。

很明顯,這是典型的視覺o1任務,且該過程似乎不太需要偏文本的做題式“思考”,它更偏向于深度“感知”。

基于以上分析,研究人員提出了慢感知(slow perception)的概念,主要想傳達的是,不僅思考需要慢下來,感知同樣需要。

作者選擇幾何parsing任務對慢感知進行初步建模,原因主要有三點:

1)文本reasoning向的多摸態o1-like模型經常pr做幾何題,但如果模型連準確地copy幾何都做不到,怎么可能真正理解幾何內部復雜的點線關系;

2)幾何parsing任務其實足夠難,一直被大家overlook,目前國內外沒有一個多模態大模型能做好這件感知任務;

3)幾何圖形是人對自然場景的抽象,想把system2視覺模型做general,總得先從描一根線開始。

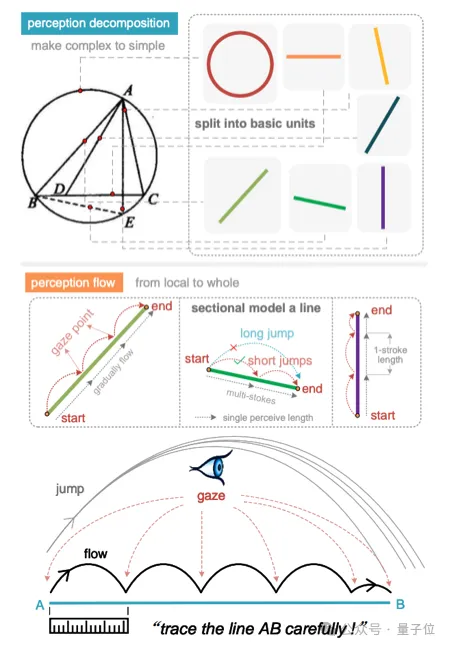

△圖1. 慢感知的兩個階段:感知分解和感知流動

方法&實驗:

慢感知(slow perception)分為兩個階段:

第一階段稱為感知分解(perception decomposition),該過程將幾何圖形分解為基本的形狀單元 ——線:不管是幾邊形,都是由最基本的線構成。這樣做的好處是可以統一復雜的幾何表征,一定程度上避免多峰優化問題。如圖1中有8個三角形,而且互相嵌套,直接讓模型寫matplotlib/tikz代碼都會遇到多峰問題。這一階段的目的是“化繁為簡”。

第二階段稱為感知流動(perception flow)。人在trace一條線的時候,尤其是長線,很難一筆到位,即對于長程依賴的感知決策,不太會出現1-hop-1-decision,對模型來說也是一樣。作者受人使用尺子配合眼動的描線過程啟發(如圖1下),提出了perception flow。

具體地,模型基于一個虛擬的感知尺(perceptual ruler),從線段的初始點逐步描向終止點。作者把“眼動”過程中停留的位置稱為凝視點(gaze),對于一條長于感知尺的線段,整個感知過程被建模為在一個決策點通過多次眼跳到達下一個決策點的過程(multi-hop-1-decision)。

感知尺的長度在一次訓練中是固定的,這樣短線和長線的推理計算量變得不同,這更符合直覺與上文的分析。當然感知尺長度在訓練前可以隨意設置,作者發現其長度設置的越短,幾何解析的性能越好。感知尺短說明模型描一條線用的推理計算量大,即慢感知建模方案存在感知層面的inference time scaling。

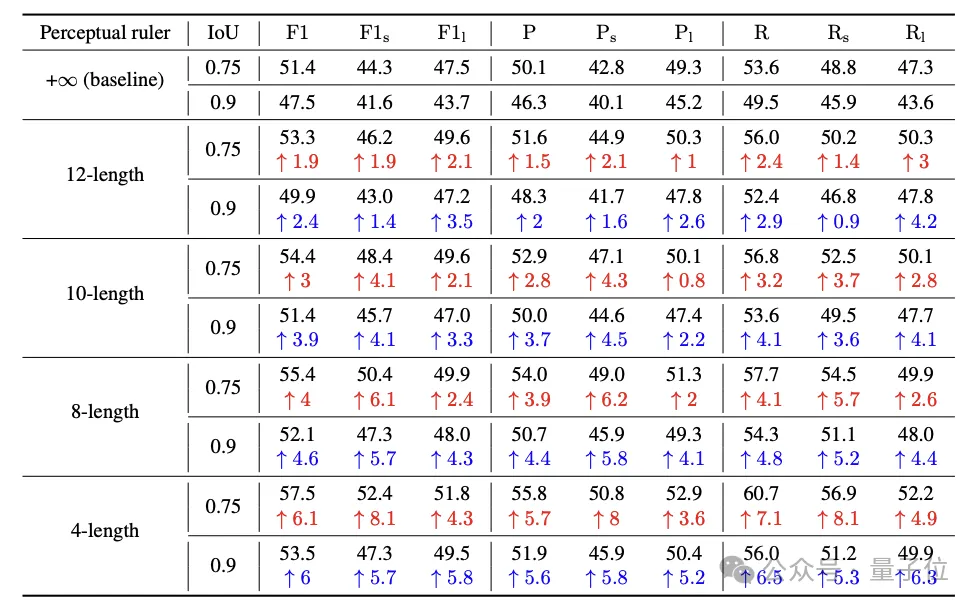

△表1. 慢感知性能

△表1. 慢感知性能

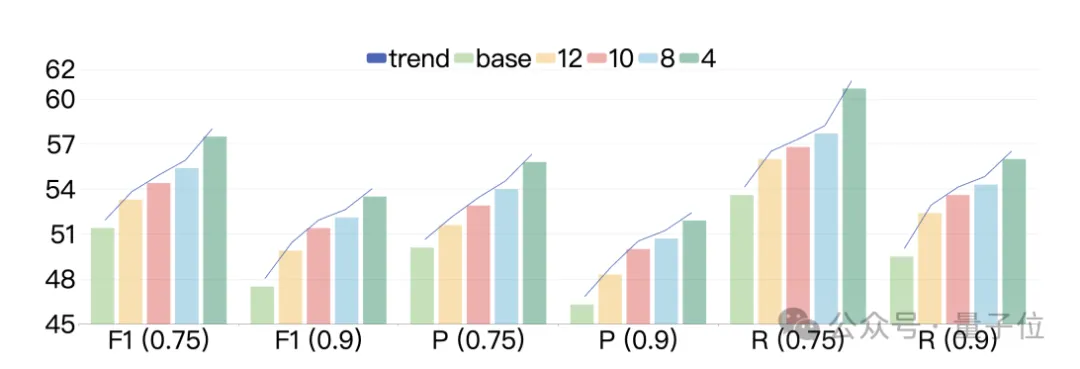

△圖2. 慢感知inference scaling

△圖2. 慢感知inference scaling

如上表1所示,baseline代表感知尺無限長,即所有線段均從初始點直接預測終止點。n-length代表感知尺長度為n,n是matplotlib繪制距離,所有幾何圖形繪制在-10到10的坐標系中。可以看到感知尺長度從12到4,所有指標(包括F1,Precision,Recall)都在上漲。感知尺越短,描一根線的停頓(gaze點)越多,計算量越大,inference time也會越久。圖2展示了慢感知inference time scaling的趨勢。

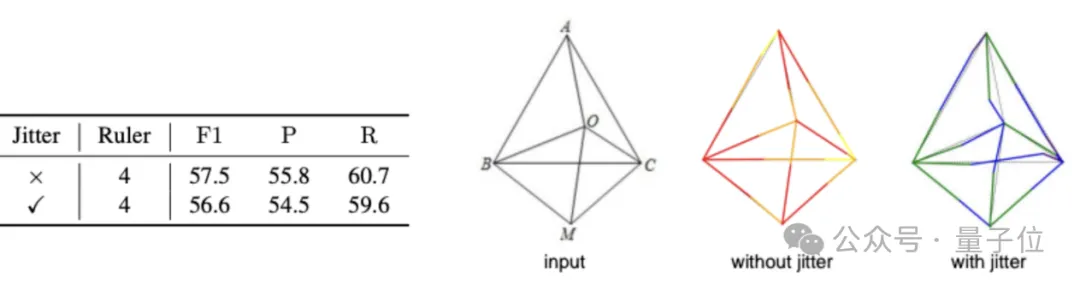

△圖3. 抖動凝視(gaze)點

△圖3. 抖動凝視(gaze)點

為了驗證感知流動是否依賴精準的凝視(gaze)點,作者抖動了gaze點真值進行訓練和測試,對比結果如圖3所示。可以看到即便是基于抖動過的gaze點,模型性能依舊遠高于baseline(56.6% F1 vs. 51.4% F1),也僅比不抖動的情況低了1%:慢感知最關鍵的是要建模一種從初始決策點到下一個決策點感知的正確流向,而中間的具體過程可能沒有那么關鍵。這一結論會大大降低將該方法用在通用場景上的標注難度。

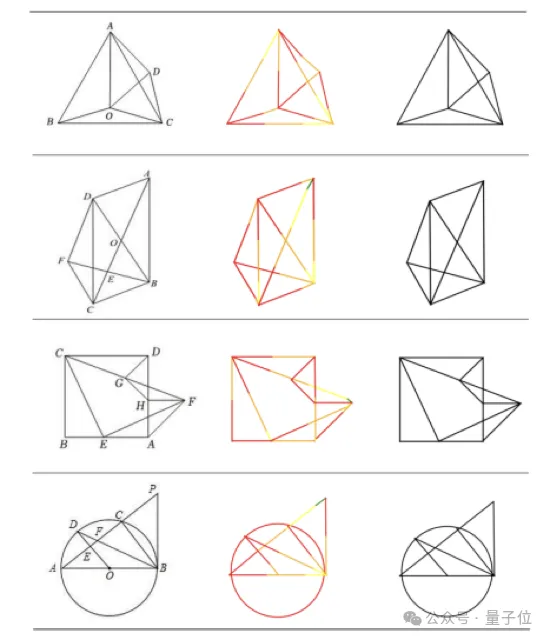

△圖4. 可視化結果

更多可視化結果如圖4所示,左邊是輸入,中間是slow perception每一筆的可視化,筆畫順序用彩虹色(紅-橙-黃-綠)表示,最后一欄是最終幾何解析的效果。

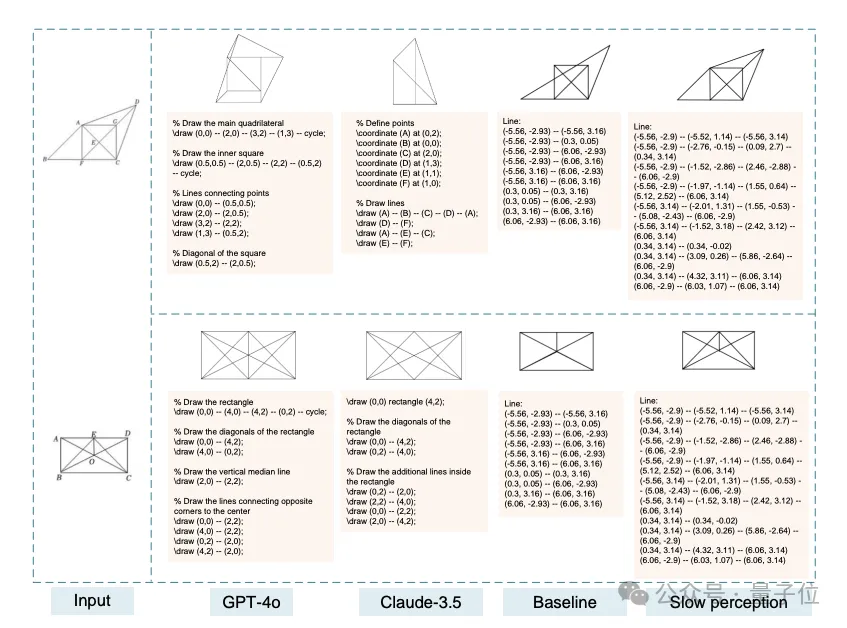

△圖5. 幾何解析結果最終比較

△圖5. 幾何解析結果最終比較

不同多模態大模型幾何解析能力對比如圖5所示,可以看到慢感知建模方案使得模型對幾何線段的感知能力更強。更多有趣的結論和效果請看原文。

結論:

當前基于system1感知的多模態大模型,看圖過輕,感知不夠精細,這限制了其進一步發展:當我們拿著一張片子給醫生看,而醫生不到1秒鐘就看完了,告訴你啥事沒有,我們會請他再看看,要求他看的再仔細點。

視覺語言模型想要有更多的落地場景,system2感知能力是第一步,感知要慢下來。slow perception是研究人員基于幾何parsing任務,在視覺sys2上的初步探索,他們也在積極往更通用的任務上遷移,并取得了初步的效果。大家敬請期待。