騰訊版Sora發(fā)布即開源!130億參數(shù),模型權(quán)重、推理代碼全開放

130億參數(shù),成為目前參數(shù)量最大的開源視頻生成模型。模型權(quán)重、推理代碼、模型算法等全部上傳GitHub與Hugging Face,一點(diǎn)沒藏著。

實(shí)際效果如何呢?

不瞞你們說,我真的看見一只大熊貓,在跳廣場(chǎng)舞、吃火鍋、打麻將,請(qǐng)看VCR:

到底是來自四川的貓!

目前該模型已上線騰訊元寶APP,用戶可在AI應(yīng)用中的“AI視頻”板塊申請(qǐng)?jiān)囉谩?/p>

API同步開放測(cè)試,開發(fā)者可通過騰訊云接入。

騰訊混元視頻生成主打四大特點(diǎn):

- 超寫實(shí)畫質(zhì),模型生成的視頻內(nèi)容具備高清質(zhì)感、真實(shí)感,可用于工業(yè)級(jí)商業(yè)場(chǎng)景例如廣告宣傳、創(chuàng)意視頻生成等商業(yè)應(yīng)用。

- 高語義一致,用戶可以進(jìn)行細(xì)致的刻畫,例如生成主體的細(xì)節(jié),人物概念的組合等。模型可以準(zhǔn)確的表達(dá)出文本的內(nèi)容。

- 運(yùn)動(dòng)畫面流暢,可生成大幅度的合理運(yùn)動(dòng),運(yùn)動(dòng)鏡頭流暢、符合物理規(guī)律,不易變形。

- 原生鏡頭轉(zhuǎn)換,模型原生具備自動(dòng)生成多視角同主體的鏡頭切換畫面,增強(qiáng)畫面敘事感。

那么實(shí)際表現(xiàn)能否符合描述?下面結(jié)合實(shí)例一一拆解。

實(shí)測(cè)騰訊首個(gè)文生視頻模型

首先是沖浪題材,涉及到畫面大幅度運(yùn)動(dòng),水的物理模擬等難點(diǎn)。

提示詞中還特別指定了攝像頭的運(yùn)動(dòng),騰訊混元表現(xiàn)出流暢運(yùn)鏡的能力,只是在“最后定格在…”這個(gè)要求上稍顯不足。

提示詞:超大海浪,沖浪者在浪花上起跳,完成空中轉(zhuǎn)體。攝影機(jī)從海浪內(nèi)部穿越而出,捕捉陽光透過海水的瞬間。水花在空中形成完美弧線,沖浪板劃過水面留下軌跡。最后定格在沖浪者穿越水簾的完美瞬間。

鏡子題材,考驗(yàn)?zāi)P蛯?duì)光影的理解,以及鏡子內(nèi)外主體運(yùn)動(dòng)是否能保持一致。

提示詞中的白床單元素又加大了難度,涉及到的布料模擬,也符合物理規(guī)律。

不過人們想象中的幽靈一般沒有腳,AI似乎沒學(xué)到,又或者是跳舞涉及大量腿部動(dòng)作,產(chǎn)生了沖突。

穿著白床單的幽靈面對(duì)著鏡子。鏡子中可以看到幽靈的倒影。幽靈位于布滿灰塵的閣樓中,閣樓里有老舊的橫梁和被布料遮蓋的家具。閣樓的場(chǎng)景映照在鏡子中。幽靈在鏡子前跳舞。電影氛圍,電影打光。

接下來是騰訊混元視頻生成主推的功能之一,在畫面主角保持不變的情況下自動(dòng)切鏡頭,據(jù)了解是業(yè)界大部分模型所不具備的能力。

一位中國美女穿著漢服,頭發(fā)飄揚(yáng),背景是倫敦,然后鏡頭切換到特寫鏡頭。

再來一個(gè)綜合型的復(fù)雜提示詞,對(duì)主角外貌、動(dòng)作、環(huán)境都有細(xì)致描述,畫面中還出現(xiàn)其他人物,騰訊混元表現(xiàn)也不錯(cuò)。

特寫鏡頭拍攝的是一位60多歲、留著胡須的灰發(fā)男子,他坐在巴黎的一家咖啡館里,沉思著宇宙的歷史,他的眼睛聚焦在畫外走動(dòng)的人們身上,而他自己則基本一動(dòng)不動(dòng)地坐著,他身穿羊毛大衣西裝外套,內(nèi)襯系扣襯衫,戴著棕色貝雷帽和眼鏡,看上去很有教授風(fēng)范,片尾他露出一絲微妙的閉嘴微笑,仿佛找到了生命之謎的答案,燈光非常具有電影感,金色的燈光,背景是巴黎的街道和城市,景深,35毫米電影膠片。

最后附上來自官方的寫prompt小tips:

- 用法1:提示詞=主體+場(chǎng)景+運(yùn)動(dòng)

- 用法2:提示詞=主體(主體描述)+場(chǎng)景(場(chǎng)景描述)+運(yùn)動(dòng)(運(yùn)動(dòng)描述)+(鏡頭語言)+(氛圍描述)+(風(fēng)格表達(dá))

- 用法3:提示詞=主體+場(chǎng)景+運(yùn)動(dòng)+(風(fēng)格表達(dá))+(氛圍描述)+(運(yùn)鏡方式)+(光線)+(景別)

- 多鏡頭生成:提示詞=[場(chǎng)景1]+鏡頭切換到[場(chǎng)景2]

- 兩個(gè)動(dòng)作生成:提示詞=[主體描述]+[動(dòng)作描述]+[然后、過了一會(huì)等連接詞]+[動(dòng)作描述2]

怎么樣,你學(xué)會(huì)了嗎?

更多騰訊混元生成的視頻,以及與Sora同提示詞PK,還可以看看量子位在內(nèi)測(cè)階段的嘗試。

最大的開源視頻生成模型。

看完效果,再看看技術(shù)層面有哪些亮點(diǎn)。

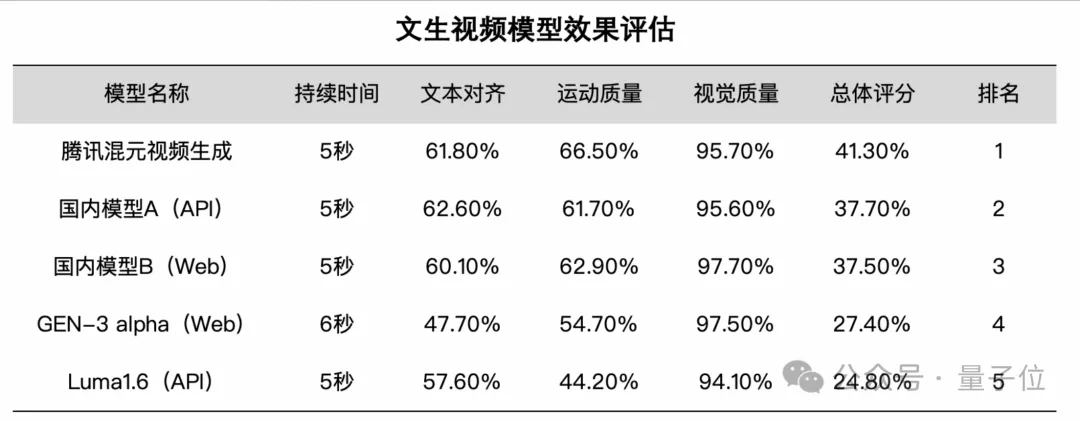

首先從官方評(píng)估結(jié)果看,混元視頻生成模型在文本視頻一致性、運(yùn)動(dòng)質(zhì)量和畫面質(zhì)量多個(gè)維度效果領(lǐng)先。

然后從目前公開資料看,騰訊混元視頻生成模型還有三個(gè)亮點(diǎn)。

1、文本編碼器部分,已經(jīng)適配多模態(tài)大模型

當(dāng)下行業(yè)中多數(shù)視覺生成模型的文本編碼器,適配的主要是上一代語言模型,如OpenAI的CLIP和谷歌T5及各種變種。

騰訊在開源圖像生成模型Hunyuan-DiT中適配的是T5和CLIP的結(jié)合,這次更進(jìn)一步,直接升級(jí)到了新一代多模態(tài)大語言模型(Multimodal Large Language Model)。

由此能夠獲得更強(qiáng)大的語義跟隨能力,體現(xiàn)在能夠更好地應(yīng)對(duì)畫面中存在的多個(gè)主體,以及完成指令中更多的細(xì)節(jié)。

2、視覺編碼器部分,支持混合圖片/視頻訓(xùn)練,提升壓縮重建性能

視頻生成模型中的視覺編碼器,在壓縮圖片/視頻數(shù)據(jù),保留細(xì)節(jié)信息方面起著關(guān)鍵作用。

混元團(tuán)隊(duì)自研了3D視覺編碼器支持混合圖片/視頻訓(xùn)練,同時(shí)優(yōu)化了編碼器訓(xùn)練算法,顯著提升了編碼器在快速運(yùn)行、紋理細(xì)節(jié)上的壓縮重建性能,使得視頻生成模型在細(xì)節(jié)表現(xiàn)上,特別是小人臉、高速鏡頭等場(chǎng)景有明顯提升。

3、從頭到尾用full attention(全注意力)的機(jī)制,沒有用時(shí)空模塊,提升畫面流暢度。

混元視頻生成模型采用統(tǒng)一的全注意力機(jī)制,使得每幀視頻的銜接更為流暢,并能實(shí)現(xiàn)主體一致的多視角鏡頭切換。

與“分離的時(shí)空注意力機(jī)制”分別關(guān)注視頻中的空間特征和時(shí)間特征,相比之下,全注意力機(jī)制則更像一個(gè)純視頻模型,表現(xiàn)出更優(yōu)越的效果。

更多細(xì)節(jié),可以參見完整技術(shù)報(bào)告~

官網(wǎng):https://aivideo.hunyuan.tencent.com

代碼:https://github.com/Tencent/HunyuanVideo

模型:https://huggingface.co/tencent/HunyuanVideo

技術(shù)報(bào)告:https://github.com/Tencent/HunyuanVideo/blob/main/assets/hunyuanvideo.pdf