阿里開源版Sora上線即屠榜,4070就能跑,免費商用

開源模型,還是得看杭州。

前腳發完QwQ-Max,阿里就在深夜開源了視頻生成模型Wan 2.1,14B參數直接屠榜VBench,什么Sora、Gen-3通通不是它的對手。

從官方Demo中看,復雜運動細節非常到位,5個人一起跳hip-hop也能做到動作同步。

而且在靜態圖像生成中都還是老大難問題的文字,現在也被萬相給攻克了。

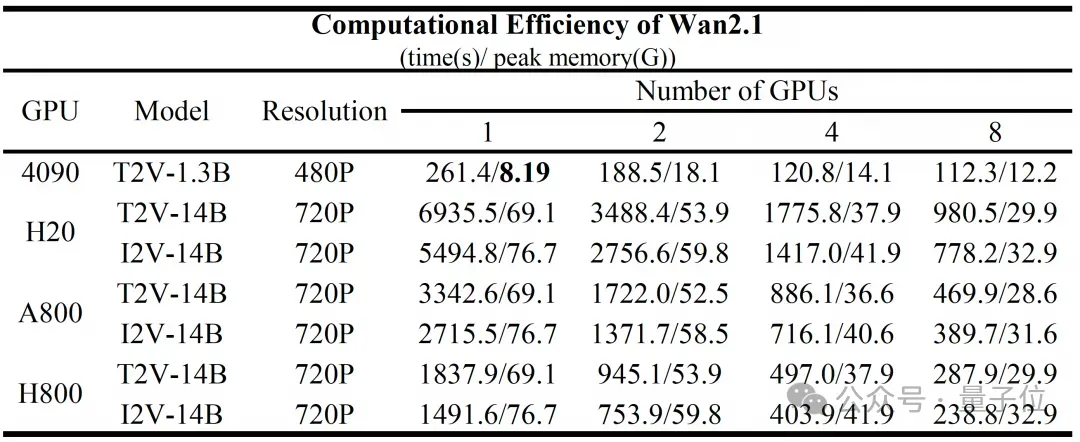

當然了,14B的參數量說大不大,但在個人消費級顯卡上本地部署還是比較吃力的。

不過14B(支持分辨率720P)之外,還有一個1.3B的小號版本(支持分辨率480P),在一塊4090上占用顯存是8個多GB,消耗時間4分21秒。

如此觀之,用12GB的4070,也是能帶動的。

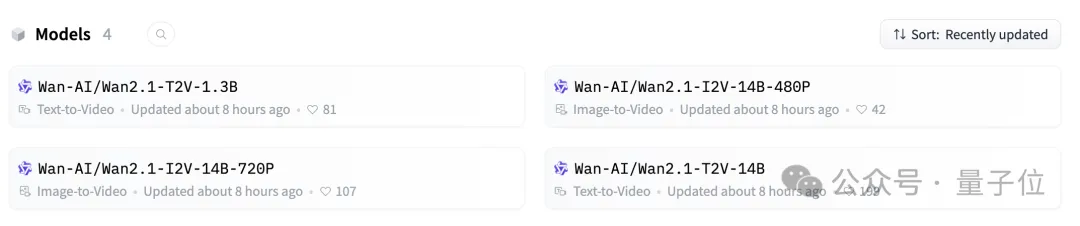

同時阿里還上線了兩個圖生視頻模型,都是14B但分為480P和720P兩個版本。

四個模型全都是Apache 2.0,也就是免費商用。

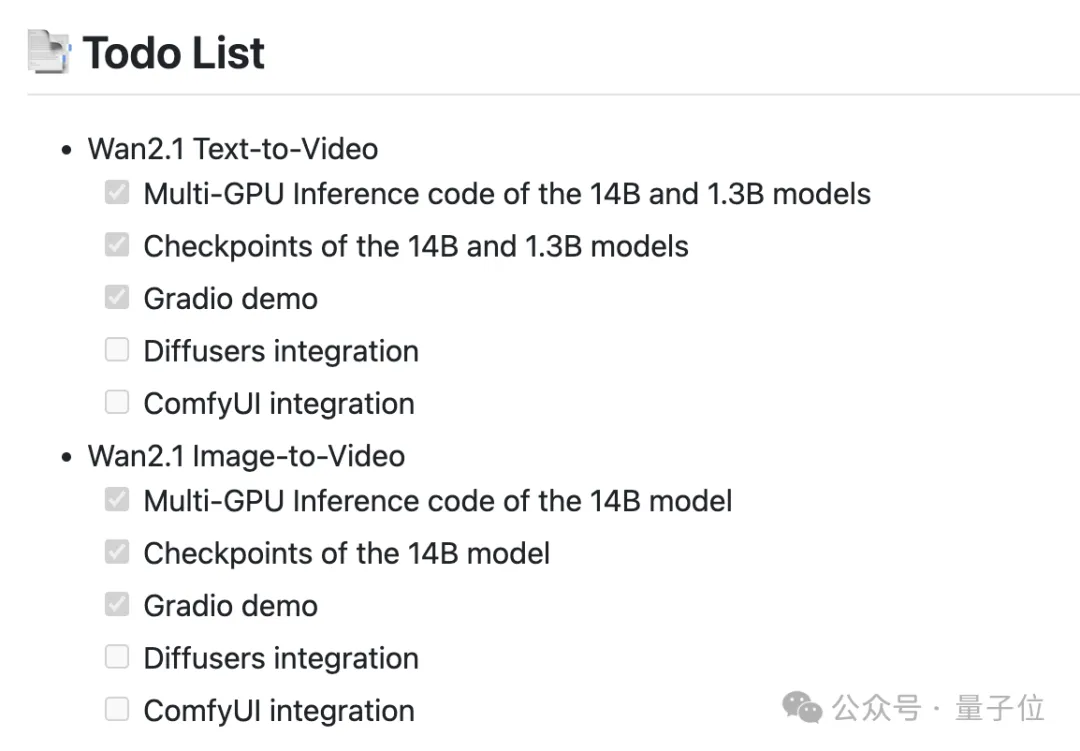

而且官方也放出計劃表,AI創作者們非常喜歡的ComfyUI,之后也會集成。

視頻生成模型會寫字了

目前可以玩到Wan 2.1的途徑有很多,最簡單的方法是通過通義萬相自己的平臺。

在平臺里,1.3B和14B版本分別叫做極速版和專業版,每次消耗5個或3個“靈感值”(新用戶默認有50個,還可通過簽到等多種方式免費獲得)。

不過由于熱度實在太高,等待的時間也會比較長,甚至有時會出現“過于火爆”的情況。

動手能力稍強的話,可以根據官方的教程通過HuggingFace、魔搭社區或者本地等方式自行折騰,當然還有一些第三方平臺也進行了跟進。

網友們也是玩出了各種花活,有人用它生成了《我的世界》風格的故事場景。

△作者:X/@TheXeophon

再看看官方案例,從效果維度上看,Wan 2.1最大的亮點,可能就是支持在視頻中生成文字了。

而且不是生硬地加入,會根據文字所處位置的材質進行合理變化,以及隨載體一同運動。

當然相對文字來說更基礎的動作細節,技術也同樣過關。

讓兩個人跳一段華爾茲,多次轉身前后人物形象依然保持一致,背景的轉動也很自然。

并且也更懂物理規律,一支箭射出后,弓弦的抖動刻畫得非常到位。

小狗切菜的過程當中,被切的西紅柿也沒有出現畸變。

還有像人從水面中探出頭這種場景,不僅界面處處理得很好,帶起的水也是從水流逐漸變化成水滴。

唯一的瑕疵之處是,頭出來的時候人物的嘴是張著的。

另外關于圖像生視頻,也有網友進行了體驗,沒用任何提示詞就得到了這樣的日漫風動畫:

△作者:X/@seiiiiiiiiiiru

除了效果本身,1.3B版本8個多GB的低顯存占用,對個人創作者來說也是一個極好的消息。

那么,Wan 2.1是如何實現又好又省的呢?

創新3D變異自動編碼器

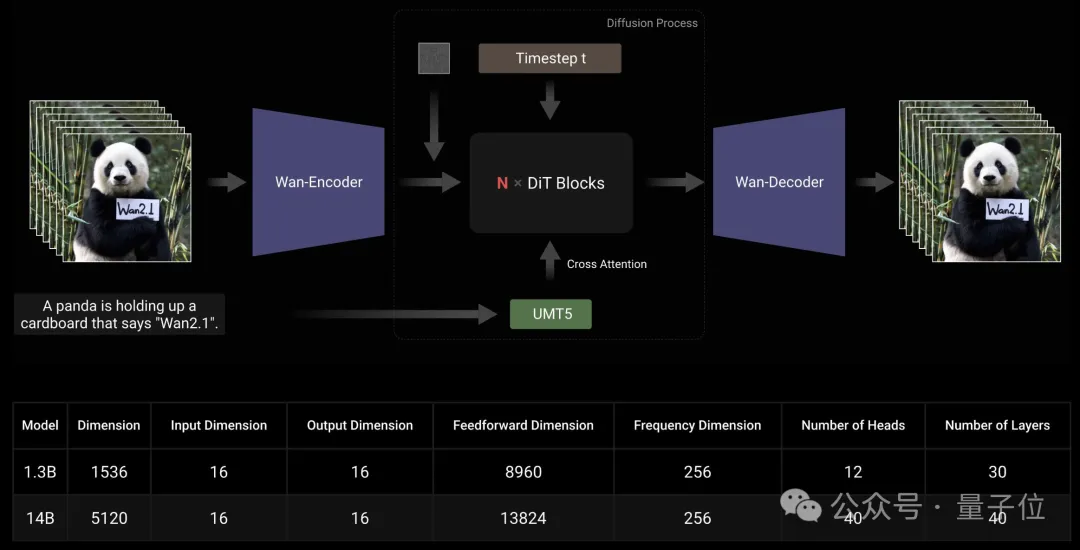

和主流的視頻生成技術路線一樣,Wan 2.1的主體采用了DiT(Diffusion Transformer)架構。

Wan利用T5編碼器對輸入的多語言文本進行編碼,并在每個Transformer塊內加入交叉注意力機制,將文本嵌入到模型架構中。

此外,Wan采用線性層和SiLU層來處理輸入時間嵌入并分別預測六個調制參數。這樣的MLP在所有Transformer塊之間共享,每個塊都學習一組不同的偏差。

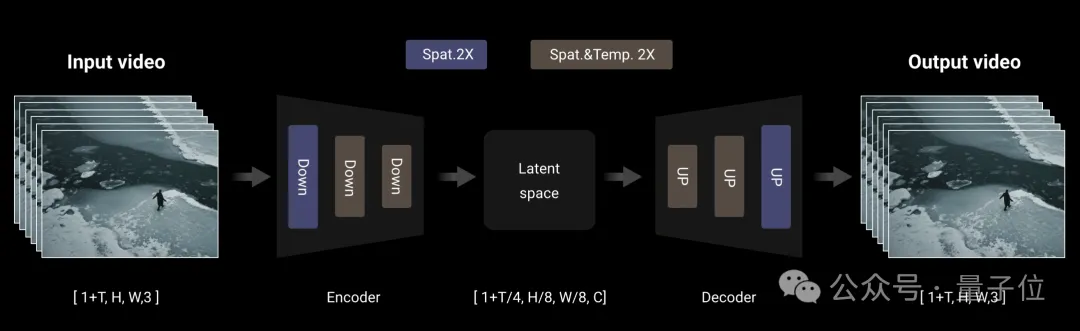

編碼上,Wan采用了3D變異自動編碼器,這是一種專門為視頻生成設計的3D因果關系體系結構。

它在卷積模塊中實現了特征緩存機制,并結合了多種策略來改善時空壓縮,減少記憶使用情況并確保時間因果關系。

具體來說,由于視頻序列幀數遵循1+T輸入格式,因此Wan將視頻分成1+T/4個塊,與潛在特征的數量一致。

在處理輸入視頻序列時,該模型采用逐塊策略,其中每個編碼和解碼操作僅處理與單個潛在表示相對應的視頻塊。

基于時間壓縮比,每個處理塊中的幀數最多限制為4,從而有效防止GPU內存溢出。

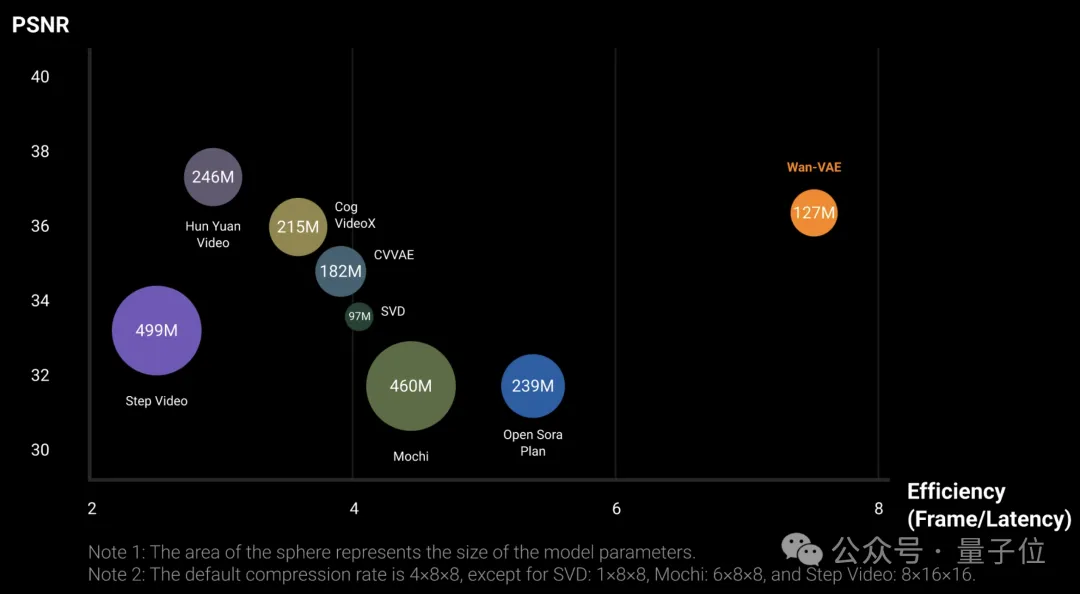

實驗結果表明,在單塊A800上,Wan的VAE的重建速度比現有的SOTA方法快2.5倍。

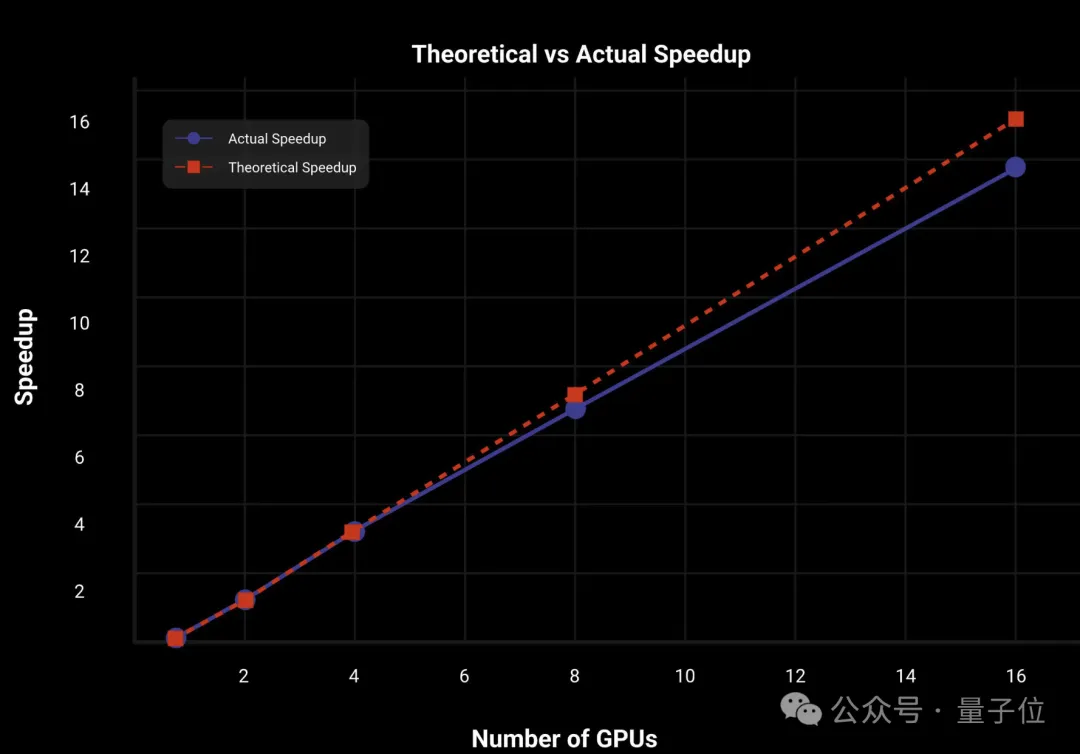

為了使模型擴展并提高訓練效率,Wan對編碼器采用FSDP模型切分與上下文并行性(CP)相結合的分布式策略;對于DiT模塊則采用DP、FSDP、RingAttention、Ulysses混合的并行策略。

在推理階段,為了使用多卡減少生成單個視頻的延遲,還需要通過CP來進行分布式加速。

在14B版本的Wan上,2D上下文并行和FSDP并行策略,讓DiT達到了幾乎線性的加速。

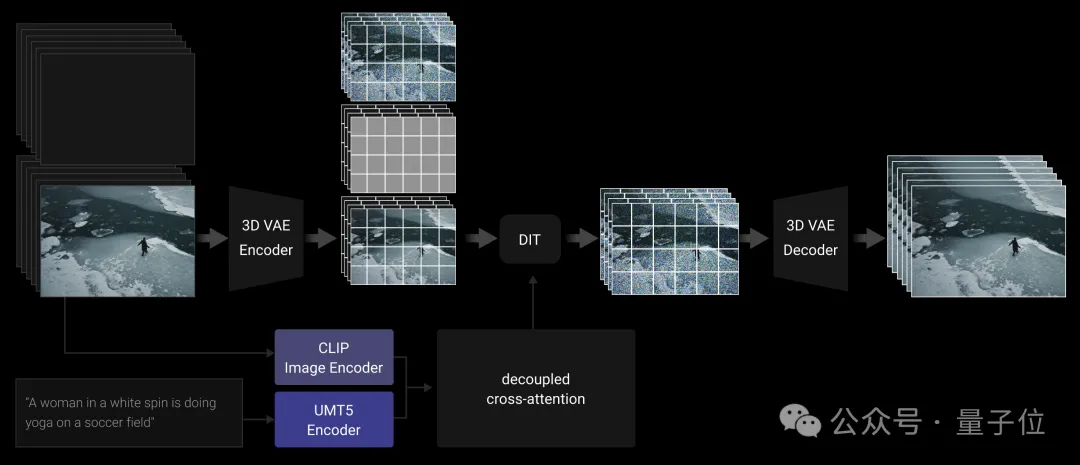

I2V部分,Wan引入了額外的條件圖像作為第一幀來控制視頻合成,用CLIP圖像編碼器從條件圖像中提取特征表示。

具體而言,條件圖像沿時間軸與零填充幀連接,形成指導幀。然后,這些指導幀由3D VAE壓縮為條件潛在表示。

另外由于I2V DiT模型的輸入通道比T2V模型多,因此I2V版本中還使用了額外的投影層,并用零值初始化。

之后阿里還會放出更詳細的報告,對技術細節感興趣的讀者可以持續關注~