重磅!北大聯合字節VAR模型獲NeurIPS 2024最佳論文:改寫圖像生成的未來范式

人工智能頂會NeurIPS 2024大會公布了本年度最佳論文獎,今年大會共收到15671篇論文,最終接收率只有25.8%,其中兩篇文章獲得最佳論文獎

一是由北大與字節跳動團隊共同完成的《Visual AutoRegressive Modeling: Scalable Image Generation via Next-Scale Prediction》(VAR)獲得(尷尬的是論文一作田柯宇被字節起訴,我們這里就不八卦了,網上有很多瓜,還是專注于解讀技術)。這篇論文提出了一種顛覆性的新型圖像生成框架,不僅首次讓自回歸模型超越擴散模型,還開創了“逐尺度預測”的全新范式,為視覺生成領域開辟了全新的方向

另一篇是由新加坡國立大學、 Sea AI Lab 研究者共同完成的《Stochastic Taylor Derivative Estimator: Efficient amortization for arbitrary differential operators》論文一作為 Zekun Shi

北大與字節的獲獎論文推出的模型VAR是首個在視覺領域驗證“規模化定律”的模型,個人認為這是中國本土從0到1的生成式人工智能基礎研究重大突破

paper:https://openreview.net/pdf?id=gojL67CfS8

paper:https://openreview.net/pdf?id=gojL67CfS8

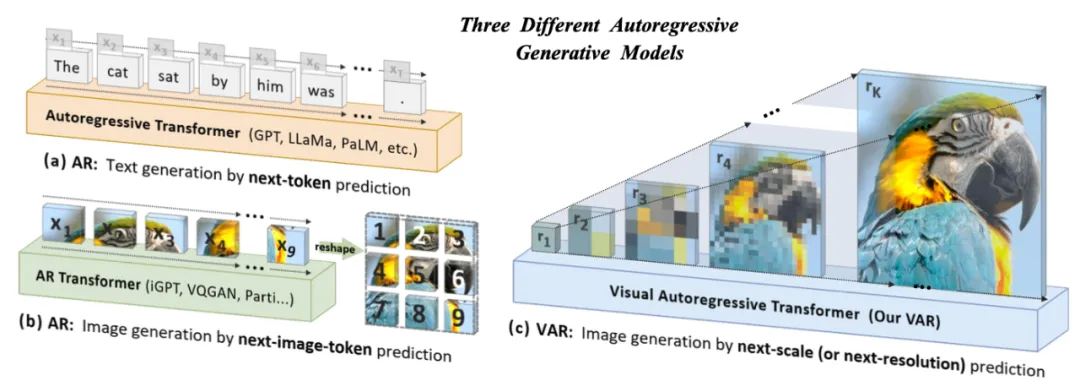

從“逐像素”到“逐尺度”

VAR模型最核心的創新在于重新定義了圖像生成的過程,將傳統的逐像素生成方式徹底顛覆:

1. 多尺度預測的新范式

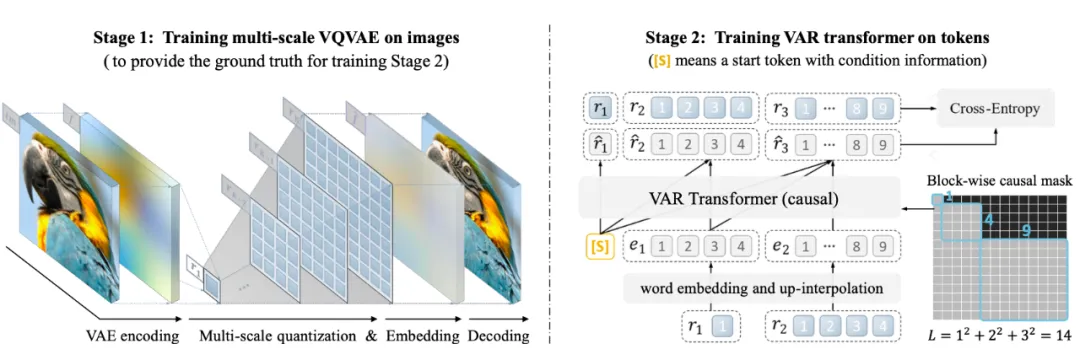

傳統自回歸方法采用“逐像素”的方式,即從圖像的左上角逐行生成,依賴每個像素的前置依賴。這種方法不僅效率低,還容易丟失圖像的全局結構感。而VAR模型則通過引入多尺度VQVAE,將圖像分解為從粗到細的多層次token。生成時,VAR從最低分辨率的全局token開始,逐層生成更高分辨率的細節,從而實現了對圖像的“逐尺度預測”

實現細節:

? 首先通過多尺度VQVAE將原始圖像編碼為多層分辨率token

? 在每一層分辨率上,自回歸模型并行生成token,并利用上下文信息預測更高分辨率的細節

這種方式不僅保留了圖像的空間局部性,還避免了傳統方法中將圖像展平成一維序列所引入的空間破壞

2. 效率的極大提升

傳統自回歸模型需要逐像素生成,每個步驟依賴所有前置像素,時間復雜度高達

?VAR則通過“逐尺度并行”的方式,將復雜度降低至

?這一優化使VAR在推理速度上比擴散模型快20倍,同時接近于GAN的實時生成速度

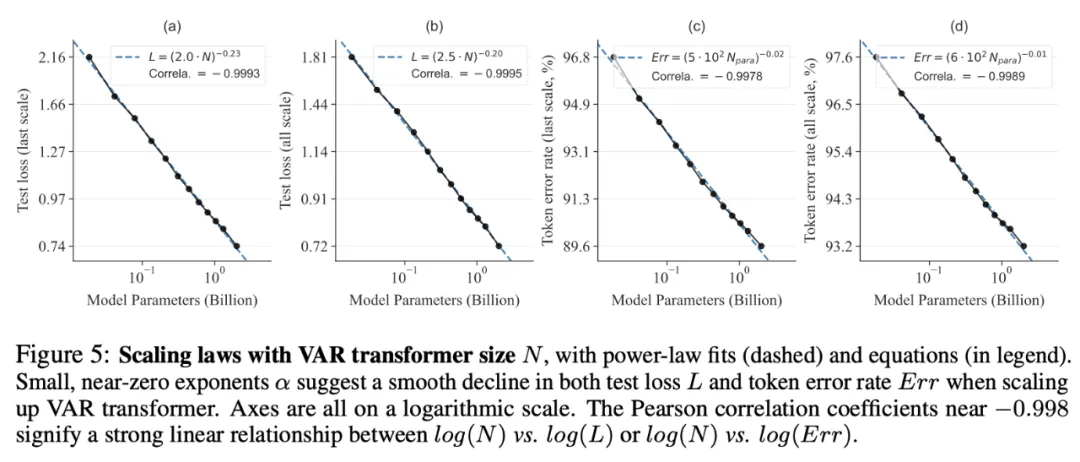

3. 視覺生成的“Scaling Law”

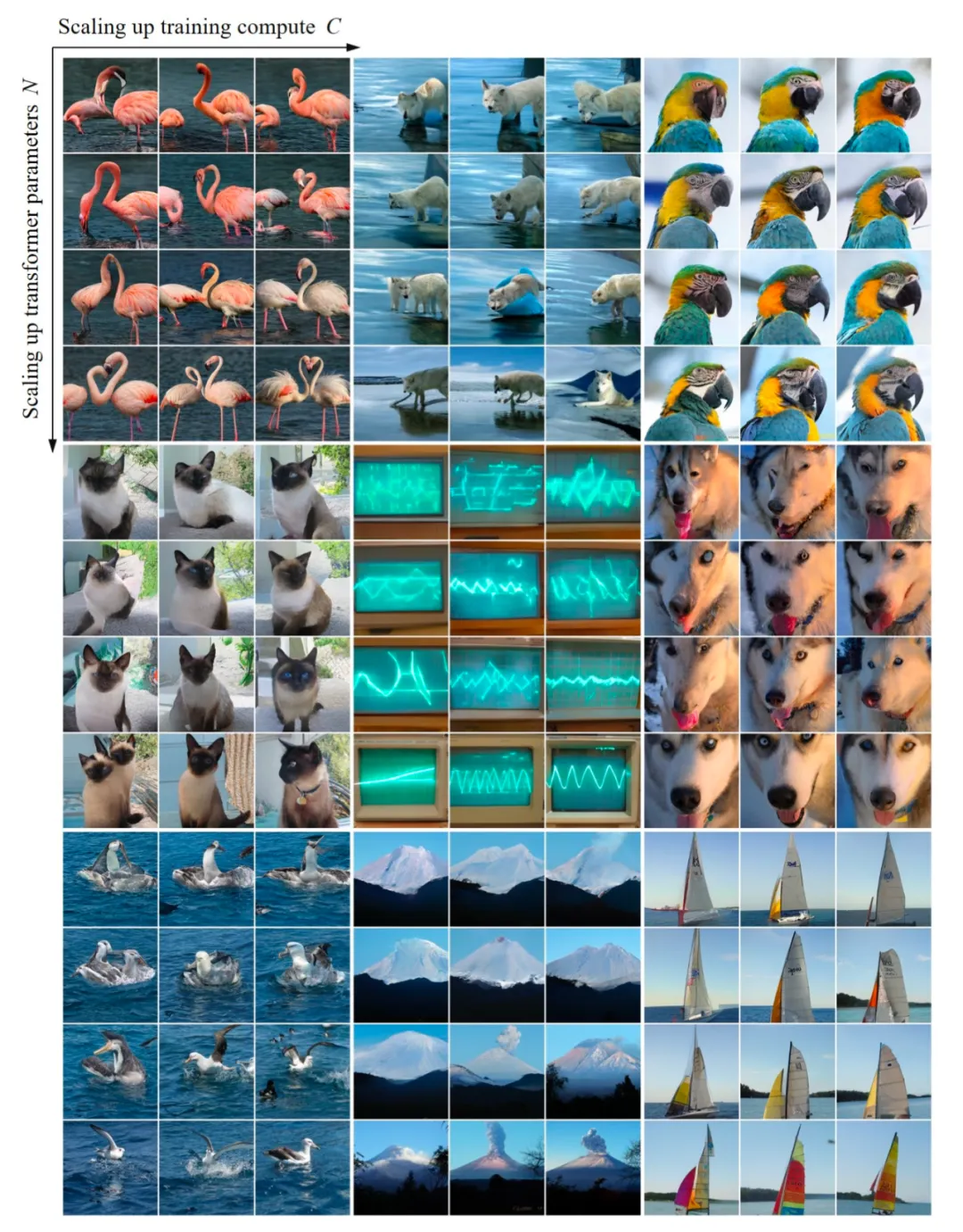

VAR模型首次在視覺領域系統性地驗證了‘規模化定律’,展示了模型參數和訓練計算量與性能提升之間的強線性關系。團隊通過實驗發現,VAR模型的性能隨著參數規模的增加呈現出線性提升,與大語言模型的擴展性相似。這種特性不僅使VAR在圖像生成中具備更強的性能預測能力,還為更高效的資源分配提供了理論依據

通過實驗對VAR模型進行規模化(即增大模型參數和計算量)時的學習效果進行可視化分析,并驗證了規模化定律的有效性

首度擊敗擴散模型

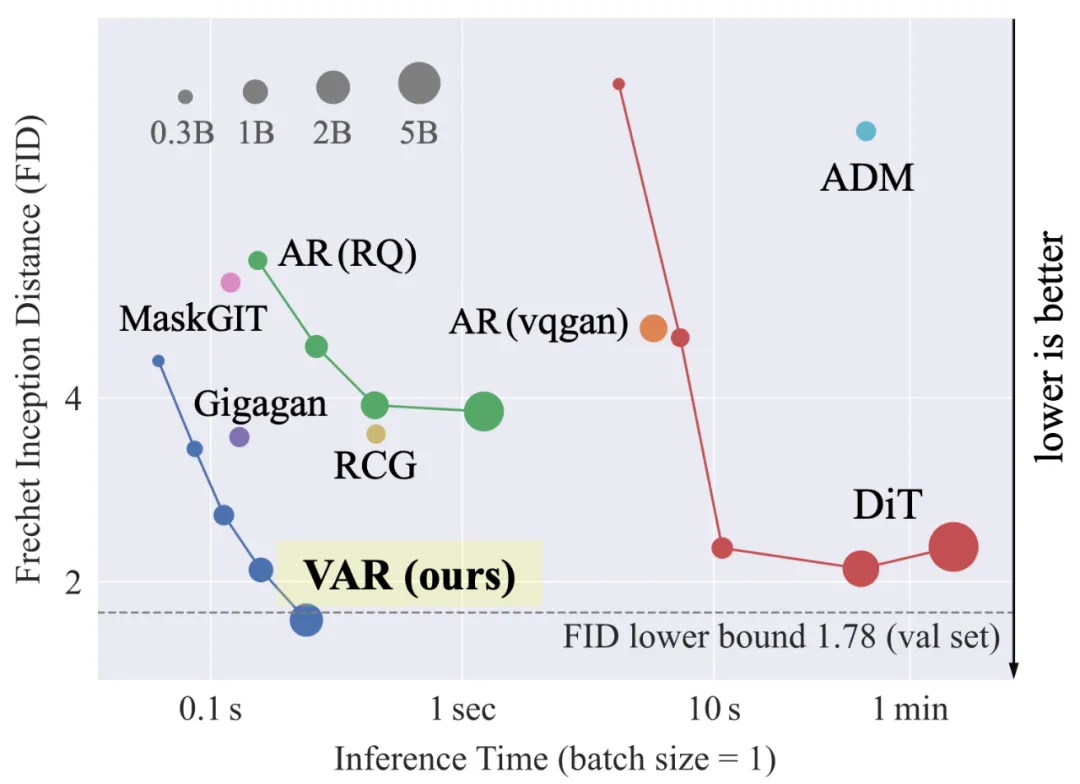

在ImageNet 256×256基準測試中,VAR的表現堪稱驚艷:

1. 生成質量

VAR的FID分數達到1.73(分數越低越好),顯著超越擴散模型(如DiT-XL/2的2.27)和傳統自回歸方法(如VQGAN的15.78)

在IS(生成圖像多樣性)指標上,VAR也達到了350.2的高分

2. 推理速度

VAR比擴散模型快20倍,并且在計算資源消耗上更高效。它僅需10步推理即可生成高質量圖像,而擴散模型通常需要250步以上

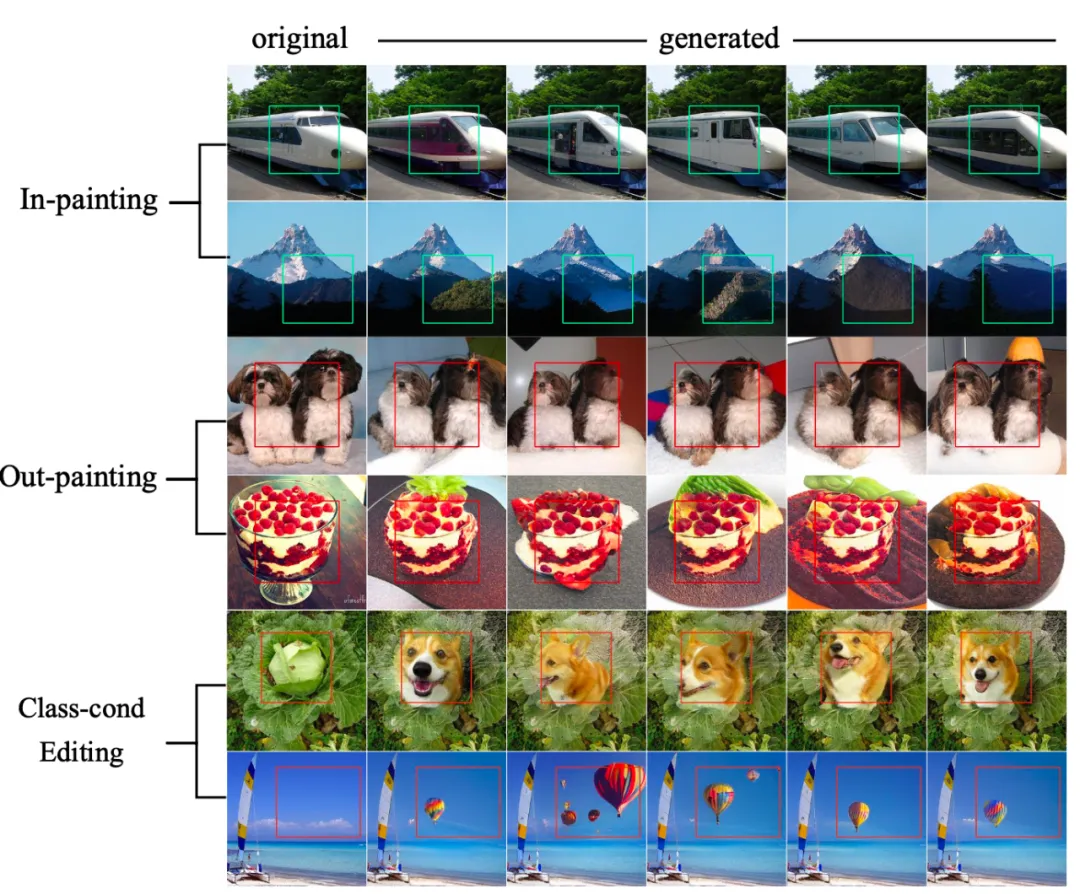

3. 零樣本泛化能力

VAR無需額外訓練即可勝任多種任務,包括圖像修復(in-painting)、擴展(out-painting)以及條件編輯。這一能力得益于VAR對圖像多尺度結構的深度建模,使其在陌生任務中也能展現出驚人的靈活性

從圖像到多模態智能

VAR的潛力不僅局限于圖像生成,其應用場景和未來發展方向同樣令人期待:

- 1. 文本到圖像生成:團隊計劃將VAR與大型語言模型結合,實現更強大的文本到圖像生成能力,例如通過提示生成高質量的插畫或藝術作品

- 2. 視頻生成的革命:VAR天然支持視頻生成的擴展,通過將“逐尺度預測”應用于時間維度,VAR有望解決傳統視頻生成方法在時間一致性上的難題,為影視制作和虛擬現實領域注入新活力

- 3. 產業應用:在游戲開發、電影特效、教育可視化等領域,VAR模型將為用戶提供更快、更高效的視覺生成解決方案

結語:

VAR模型的成功不僅是技術上的突破,更是一種范式轉變。它讓我們看到,大語言模型的成功經驗可以移植到視覺領域,從而激發出更強大的多模態智能。隨著更多模型代碼和數據的開源,VAR有望成為視覺生成領域的開山之作,推動下一代AI技術的發展

VAR項目地址:

https://github.com/FoundationVision/VAR