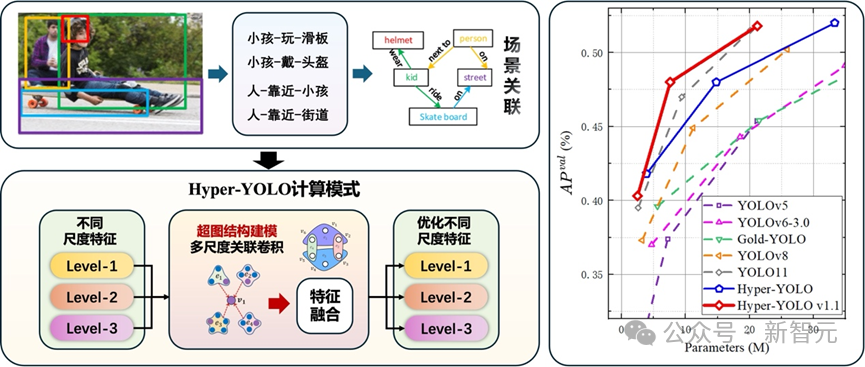

超圖計算+目標檢測,性能新SOTA!清華發(fā)布Hyper-YOLO:用超圖捕捉高階視覺關(guān)聯(lián)

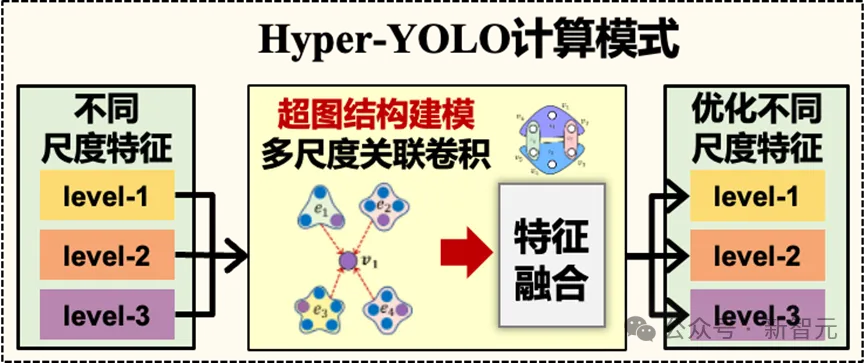

YOLO(You Only Look Once)系列是目標檢測領域中的主流方法,以其高效性和實時性而著稱。然而,現(xiàn)有的YOLO模型在處理跨層特征融合和復雜的高階特征關(guān)系時存在局限,無法充分捕捉跨位置和跨尺度的復雜特征關(guān)聯(lián)。

為了解決這一難點,清華大學提出了Hyper-YOLO:一種基于超圖計算的目標檢測方法。Hyper-YOLO首次將超圖計算集成到目標檢測網(wǎng)絡,對特征圖中的復雜高階關(guān)聯(lián)進行建模,實現(xiàn)了高階信息的跨層次和跨位置傳播。

圖片

圖片

作者列表:Yifan Feng, Jiangang Huang, Shaoyi Du, Shihui Ying, Junhai Yong, Yipeng Li, Guiguang Ding, Rongrong Ji, Yue Gao.

論文地址:https://arxiv.org/abs/2408.04804

Github倉庫:https://github.com/iMoonLab/Hyper-YOLOv1.1

零代碼平臺:http://hyperyolo.gaoyue.org:28501/#/predict

圖片

圖片

使用超圖計算結(jié)合YOLO,性能在各種規(guī)模模型中都達到頂尖,在COCO數(shù)據(jù)集上的表現(xiàn)明顯優(yōu)于其他模型,尤其是對中小目標提升更加顯著。其中,相比于最新的YOLOv9-T、YOLO11-S,同規(guī)模的Hyper-YOLO分別實現(xiàn)了2%和1%的平均精度提升。

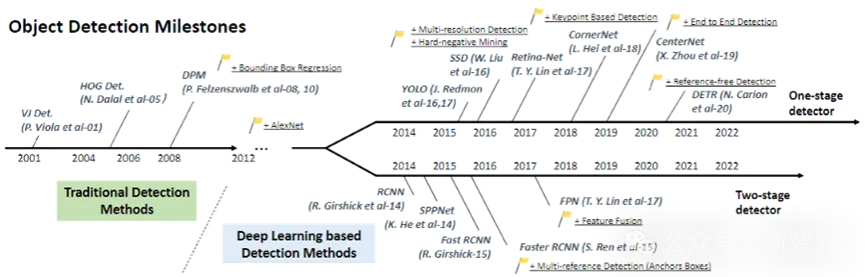

目標檢測的困境

近年來,隨著深度學習的快速發(fā)展,YOLO(You Only Look Once)系列模型憑借其高效的單階段檢測架構(gòu),在目標檢測領域中脫穎而出。YOLO模型通過將目標檢測簡化為回歸問題,在保持高精度的同時實現(xiàn)了實時檢測能力,受到了廣泛關(guān)注和應用。

圖片

圖片

然而,隨著應用場景的復雜化,現(xiàn)有的YOLO模型在處理跨層次特征融合和高階特征關(guān)系時暴露出了一定的局限性。

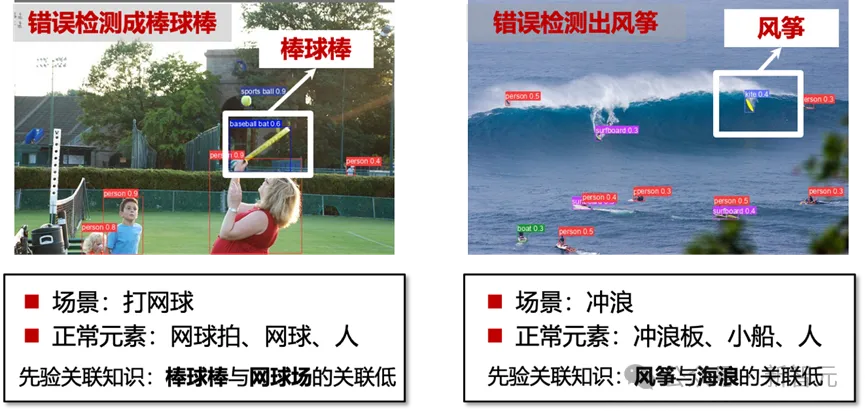

下圖展示了幾個典型的案例 (YOLOv8為例)。在打網(wǎng)球的場景中,現(xiàn)有模型將網(wǎng)球拍誤判為了棒球棒;在沖浪的場景中,現(xiàn)有模型將沖浪板誤判為了風箏。這種錯誤正是由于現(xiàn)有的模型難以捕捉視覺對象之間的復雜關(guān)系。

圖片

圖片

因而,不同目標間的高階語義關(guān)聯(lián)推理限制了目標檢測的性能。

高階關(guān)聯(lián)的建模方法

為了解決這些問題,學術(shù)界一直在探索更加先進的模型設計與優(yōu)化方法。其中,超圖計算作為一種能夠捕捉多方關(guān)系的數(shù)學工具,逐漸被應用于包括社交網(wǎng)絡、腦網(wǎng)絡等復雜數(shù)據(jù)結(jié)構(gòu)分析中。

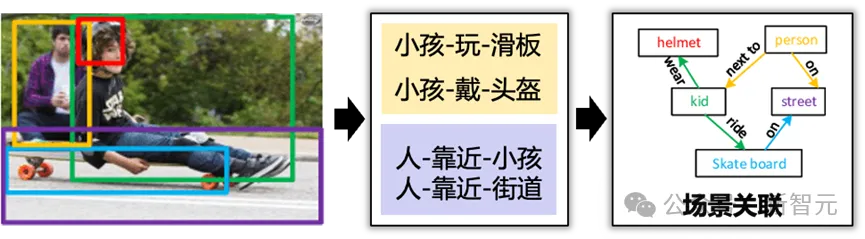

超圖覆蓋了多種關(guān)聯(lián),是復雜關(guān)聯(lián)計算的有效方法。在Hyper-YOLO中,作者首次將超圖計算引入目標檢測領域,以實現(xiàn)視覺高階語義關(guān)聯(lián)的建模與學習。

模型效果

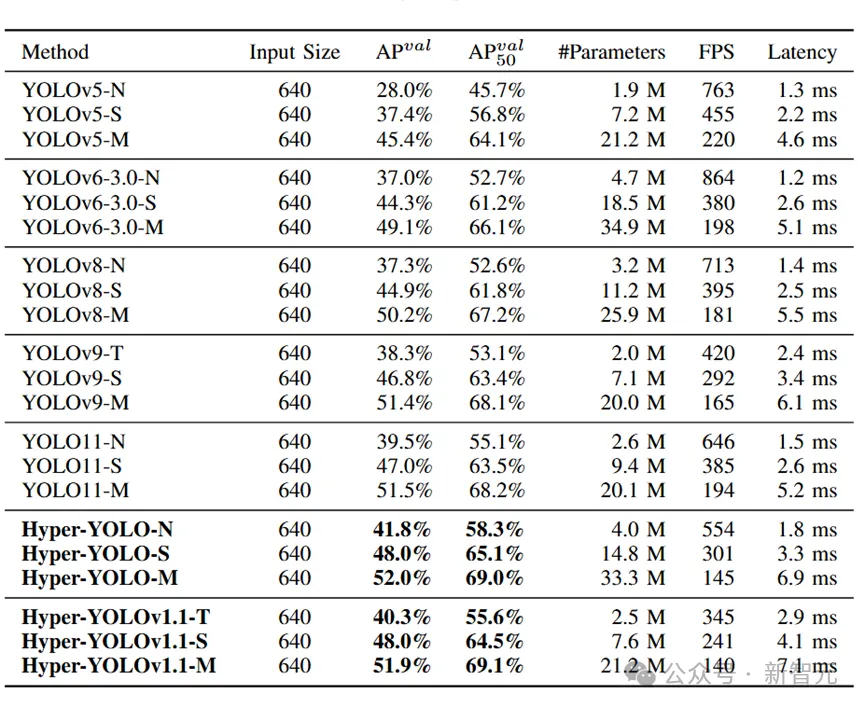

該工作在COCO數(shù)據(jù)集上進行了豐富的實驗。Hyper-YOLOv1.1提供了3種規(guī)模的版本(Tiny, Small , Medium),在對比實驗中,均明顯優(yōu)于最新的YOLO模型。

其中,Tiny版本的平均精度(mAP)指標相比于YOLOv8、YOLOv9、YOLO11的同規(guī)模版本分別提升3.0%、2.0%、0.8%;Small版本的mAP指標相比于YOLOv8、YOLOv9、YOLO11的同規(guī)模版本分別提升3.1%、1.2%、1.0%。此外,對于骨干網(wǎng)絡、Kernel大小、特征增強策略、超圖構(gòu)建策略的消融實驗證明了所提出的方法的先進性。

圖片

圖片

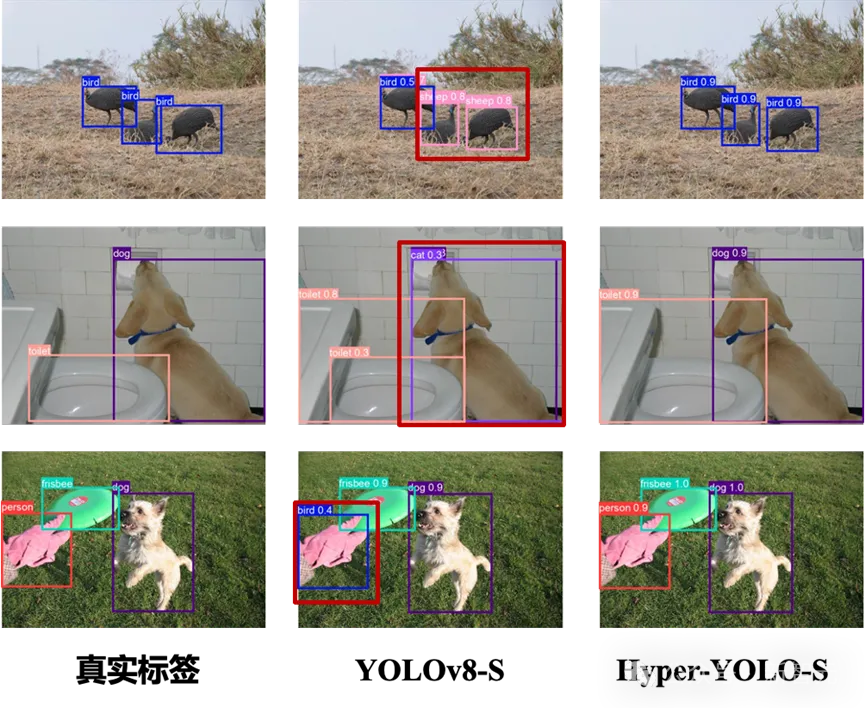

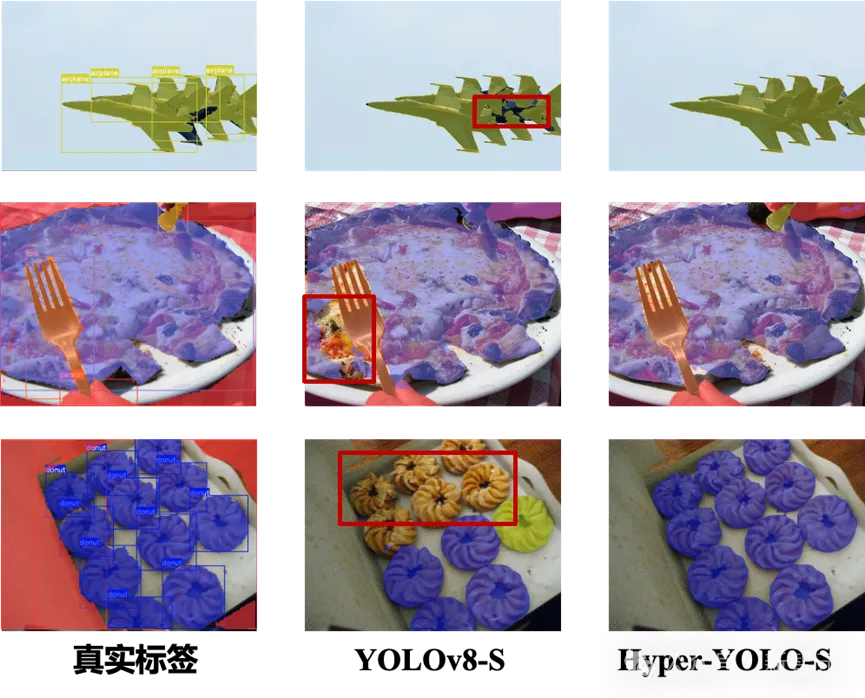

以下兩圖為YOLOv8、Hyper-YOLO在目標檢測和實例分割任務下的可視化結(jié)果。

圖片

圖片

圖片

圖片

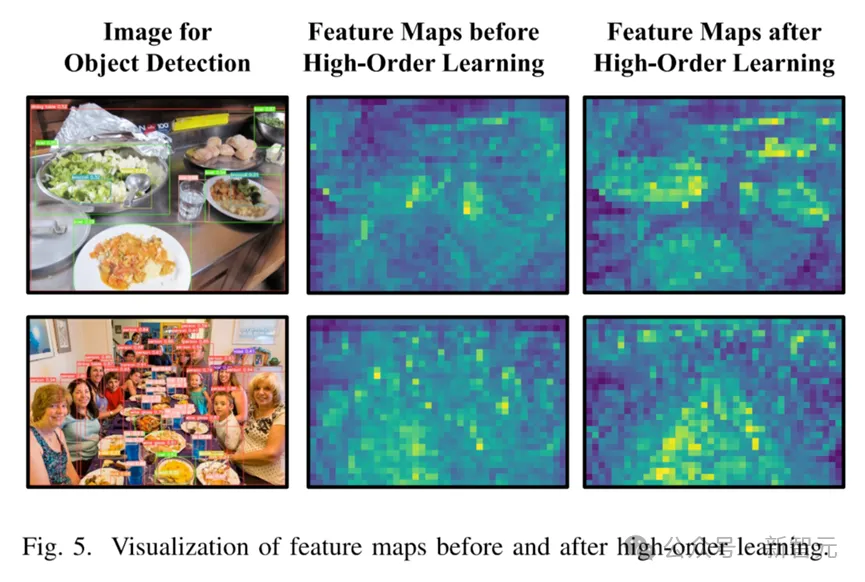

下圖為使用高階關(guān)聯(lián)學習對特征圖增強前后的可視化圖(通過HyperC2Net前后的特征圖)。

圖片

圖片

上述實驗結(jié)果證明,Hyper-YOLO具有目前最先進的檢測性能,尤其對場景中不同視覺對象的高階關(guān)系具有更準確的理解能力。

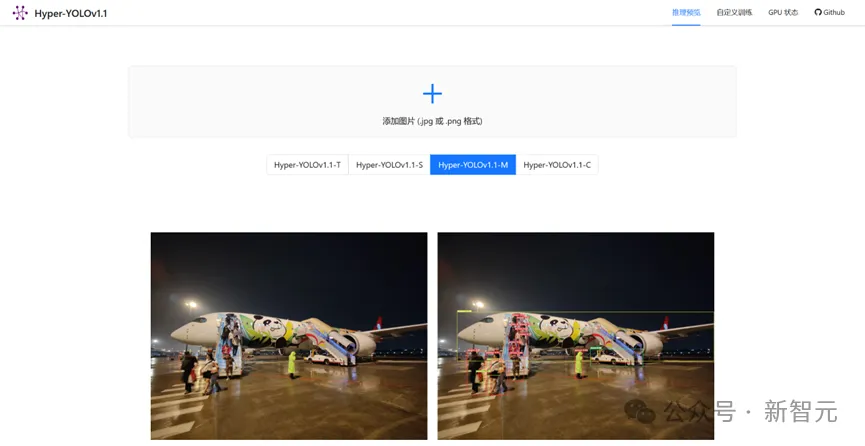

Hyper-YOLO零代碼平臺

智能媒體與認知實驗室還推出了一款基于Hyper-YOLO的零代碼訓練平臺。在該平臺上,無需配置環(huán)境、修改配置文件等繁瑣操作,既可以一鍵上傳圖像利用訓練好的Hyper-YOLO模型進行推理,也可以上傳數(shù)據(jù)集自定義訓練、直觀展示訓練過程。(推薦使用PC端chrome/Edge瀏覽器)

圖片

圖片

項目鏈接:http://hyperyolo.gaoyue.org:28501/#/predict

項目支持自定義訓練。

圖片

圖片

在訓練完成后,可以對驗證數(shù)據(jù)進行推理和評估,并可視化檢測結(jié)果:

圖片

圖片

方法概述

超圖計算

超圖是圖的推廣形式,是一種高效的特征表示學習方法。在超圖中,一條超邊可以連接多個頂點,從而表示對象之間的高階關(guān)聯(lián)。超圖神經(jīng)網(wǎng)絡作為超圖計算的核心方法,通常包含以下幾個步驟:

1. 從原始數(shù)據(jù)構(gòu)建超邊

2. 從頂點到超邊的消息聚合(超邊卷積)

3. 從超邊到頂點的消息分發(fā)(節(jié)點卷積)

超圖神經(jīng)網(wǎng)絡由于其靈活性和豐富的表達能力,廣泛應用于社交網(wǎng)絡分析、生物信息學、推薦系統(tǒng)等領域,能夠更有效地建模和分析復雜的多層次數(shù)據(jù)關(guān)聯(lián)。

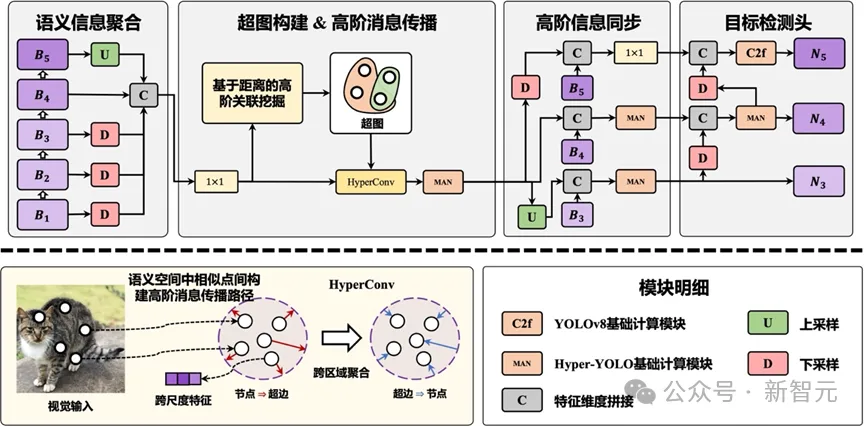

Hyper-YOLO整體架構(gòu)

Hyper-YOLO 繼承了典型的 YOLO 架構(gòu),骨干網(wǎng)絡通過引入混合聚合網(wǎng)絡(MANet)來增強特征提取能力,從五個特征層中獲取信息。

圖片

圖片

頸部網(wǎng)絡(Neck)采用基于超圖的跨層次和跨位置表示網(wǎng)絡(HyperC2Net),通過超圖計算集成多尺度特征,實現(xiàn)高階信息的跨層次和跨位置傳播,從而生成適用于目標檢測的語義特征,顯著提升模型的檢測性能。

基于超圖的跨層次和跨位置表示網(wǎng)絡

在傳統(tǒng)YOLO模型中,頸部為連接骨干網(wǎng)絡和預測頭之間的部分,通常采用類似PANet的結(jié)構(gòu),承擔多尺度特征提取與融合的功能。雖然這類結(jié)構(gòu)能夠進行一定的多尺度特征融合,但直接的信息交互局限在相鄰層之間。

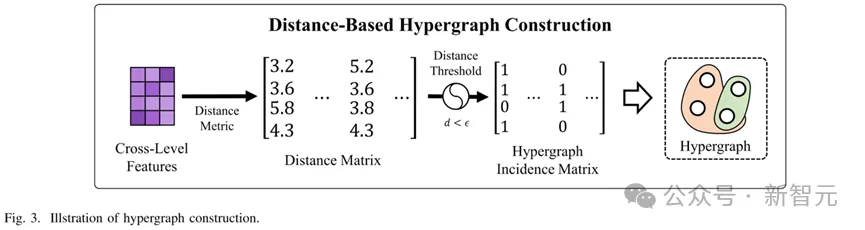

而基于超圖的跨層次跨位置表示網(wǎng)絡(Hypergraph-Based Cross-Level and Cross-Position Representation Network, HyperC2Net)則突破了這一瓶頸,主要過程如下:

1. 超圖構(gòu)建:HyperC2Net將來自不同層次的特征圖進行拼接,形成跨層次的視覺特征集合。然后通過計算特征點之間的距離,構(gòu)建一個超圖,其中每個超邊連接多個頂點,代表多個特征點之間的高階關(guān)系。超圖能夠表達跨層次和跨位置的復雜關(guān)系,而非簡單的相鄰層信息融合。

圖片

圖片

2. 超圖卷積:在構(gòu)建超圖后,HyperC2Net利用超圖卷積在特征圖上進行消息傳播。通過這種方式,不同位置和層次的特征點可以相互傳遞信息,建模特征點之間的高階關(guān)聯(lián),增強了模型對于復雜場景中目標的識別能力。特別是在跨位置特征交互方面,相比于傳統(tǒng)的卷積操作,超圖卷積能夠捕捉到更廣泛和復雜的特征關(guān)聯(lián)。

圖片

圖片

總結(jié)

Hyper-YOLO通過引入超圖計算方法,突破了傳統(tǒng)YOLO模型在多尺度特征融合上的局限。超圖的高階關(guān)聯(lián)建模能力使得HyperC2Net能夠在跨層次和跨位置的信息傳播中表現(xiàn)出色,不僅在特征點之間實現(xiàn)高效的信息聚合和分發(fā),還通過跨層次的消息傳遞顯著提升了目標檢測性能,尤其在處理復雜場景和多目標檢測任務中表現(xiàn)優(yōu)異。

參考資料:

[1] Feng Y, Huang J, Du S, et al. Hyper-YOLO: When visual object detection meets hypergraph computation[J]. arXiv preprint arXiv:2408.04804, 2024.

[2] Feng Y, You H, Zhang Z, et al. Hypergraph neural networks[C]//Proceedings of the AAAI conference on artificial intelligence. 2019, 33(01): 3558-3565.

[3] Gao Y, Feng Y, Ji S, et al. HGNN+: General hypergraph neural networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 45(3): 3181-3199.