ELMo模型可用于訓(xùn)練動態(tài)詞向量,該模型有哪些優(yōu)缺點? 與BERT模型之間的區(qū)別是什么?

ELMo(Embeddings from Language Models)是一種基于深度學(xué)習(xí)的動態(tài)詞向量模型,它通過雙向LSTM(長短期記憶網(wǎng)絡(luò))來生成詞的表示,相較于傳統(tǒng)的靜態(tài)詞向量方法,如Word2Vec和GloVe,ELMo能夠根據(jù)上下文生成不同的詞向量。這使得ELMo能夠更好地處理同義詞、歧義詞以及多義詞的上下文依賴關(guān)系,從而提升自然語言處理(NLP)任務(wù)的表現(xiàn)。然而,ELMo也存在一些局限性,例如模型訓(xùn)練復(fù)雜、計算資源消耗較大以及缺乏對長距離依賴的建模等。與ELMo類似,BERT(Bidirectional Encoder Representations from Transformers)也是一種預(yù)訓(xùn)練語言模型,它通過Transformer架構(gòu)提供更強大的表示能力,并且能夠捕捉更為豐富的上下文信息。BERT與ELMo的主要區(qū)別在于BERT采用了Transformer而非LSTM作為基礎(chǔ)架構(gòu),并且BERT是雙向的,能夠同時考慮左側(cè)和右側(cè)的上下文信息,這使得BERT在許多NLP任務(wù)中表現(xiàn)出色。

在自然語言處理領(lǐng)域,詞向量的表示方式一直是研究的核心之一。傳統(tǒng)的靜態(tài)詞向量,如Word2Vec和GloVe,雖然取得了顯著的成果,但它們無法處理詞義隨上下文變化的情況,這導(dǎo)致在一些復(fù)雜任務(wù)中效果有限。隨著深度學(xué)習(xí)的飛速發(fā)展,ELMo和BERT等基于上下文的詞向量模型應(yīng)運而生,極大地推動了NLP技術(shù)的進(jìn)步。這些模型不僅在理論上突破了傳統(tǒng)靜態(tài)詞向量的局限,更在實際應(yīng)用中展現(xiàn)了優(yōu)越的性能。那么,究竟ELMo與BERT有什么不同?它們各自的優(yōu)缺點在哪里?

圖片

圖片

1. ELMo模型簡介

ELMo(Embeddings from Language Models)是由AllenNLP團隊在2018年提出的,它通過深度雙向LSTM來生成詞的上下文相關(guān)詞向量。與傳統(tǒng)的靜態(tài)詞向量模型如Word2Vec和GloVe不同,ELMo的詞向量是動態(tài)的,意味著相同的詞在不同的上下文中會有不同的表示。這種方式能夠更好地處理同義詞、歧義詞等問題,從而提高了NLP任務(wù)的表現(xiàn)。

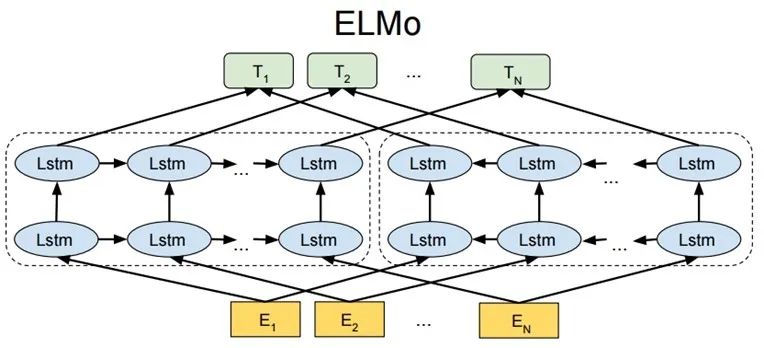

1.1 ELMo的架構(gòu)

ELMo的核心思想是在傳統(tǒng)的預(yù)訓(xùn)練語言模型基礎(chǔ)上,利用雙向LSTM來生成詞的上下文向量。具體而言,ELMo首先訓(xùn)練一個語言模型(LM),這個語言模型能夠預(yù)測文本中的下一個詞。為了生成上下文相關(guān)的詞向量,ELMo利用雙向LSTM分別從左到右和從右到左學(xué)習(xí)文本的上下文信息,結(jié)合這兩種信息后生成最終的詞向量。這種雙向編碼的方式使得ELMo能夠更好地理解和表示詞語在上下文中的語義。

1.2 ELMo的優(yōu)勢

上下文敏感的詞向量:ELMo能夠根據(jù)上下文的不同為詞生成不同的表示,這對于處理多義詞、同義詞等語言特性具有重要作用。

提升性能:ELMo在多項NLP任務(wù)上均表現(xiàn)出色,尤其是在命名實體識別、情感分析、機器翻譯等任務(wù)中,ELMo能夠有效提升模型的準(zhǔn)確性。

易于集成:ELMo的設(shè)計可以非常方便地與其他深度學(xué)習(xí)模型結(jié)合,只需要將ELMo生成的詞向量作為輸入傳遞給下游任務(wù)模型,極大地簡化了集成過程。

1.3 ELMo的缺點

計算資源要求高:由于ELMo采用了雙向LSTM,因此在訓(xùn)練時需要消耗大量的計算資源,尤其是在大規(guī)模數(shù)據(jù)集上進(jìn)行預(yù)訓(xùn)練時,訓(xùn)練成本非常高。

建模長距離依賴的能力有限:盡管ELMo能夠有效捕捉局部的上下文信息,但由于LSTM本身的限制,它在處理長距離依賴時的效果并不理想。

訓(xùn)練復(fù)雜性:ELMo的訓(xùn)練需要較復(fù)雜的模型架構(gòu)和較長的訓(xùn)練時間,導(dǎo)致模型的應(yīng)用和推廣受到一定的限制。

圖片

圖片

2. BERT模型簡介

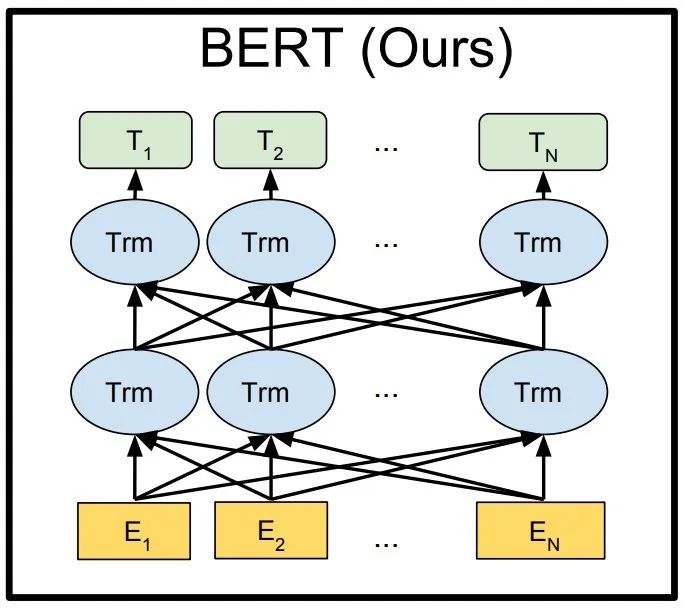

BERT(Bidirectional Encoder Representations from Transformers)是由Google在2018年提出的預(yù)訓(xùn)練語言模型。與ELMo使用雙向LSTM不同,BERT采用了基于Transformer架構(gòu)的編碼器。Transformer架構(gòu)通過自注意力機制(Self-Attention)來捕捉全局上下文信息,能夠更有效地建模長距離依賴。

2.1 BERT的架構(gòu)

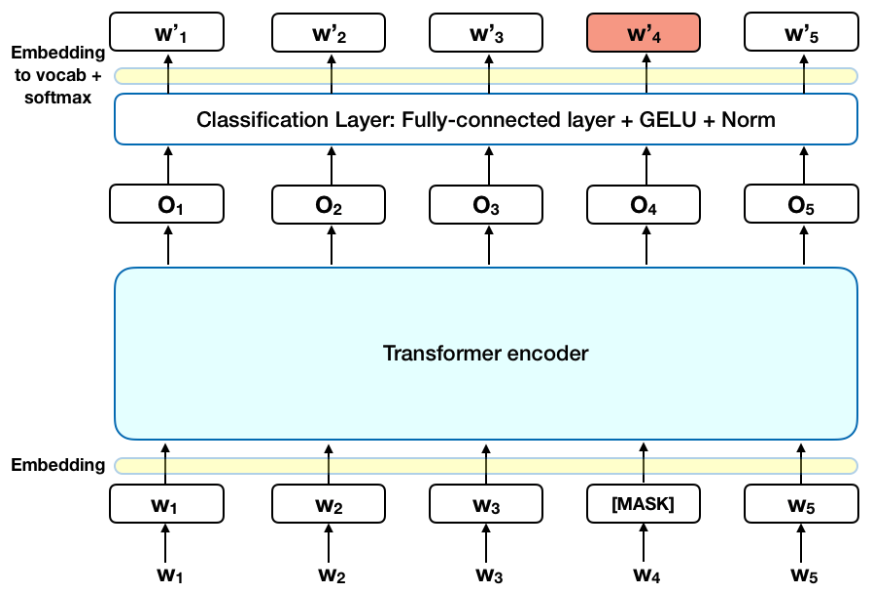

BERT的核心創(chuàng)新在于其使用了Transformer架構(gòu),特別是基于自注意力機制的Encoder部分。BERT通過預(yù)訓(xùn)練兩個任務(wù)——Masked Language Model(MLM)和Next Sentence Prediction(NSP)——來學(xué)習(xí)語言的表示。MLM任務(wù)通過遮掩輸入文本中的部分詞語,讓模型根據(jù)上下文預(yù)測被遮掩的詞。NSP任務(wù)則讓模型判斷兩個句子是否在原始文本中相鄰。這兩種任務(wù)共同作用,使得BERT能夠有效地學(xué)習(xí)詞語之間的深層次關(guān)系和句子結(jié)構(gòu)。

2.2 BERT的優(yōu)勢

雙向編碼:與ELMo的單向編碼不同,BERT通過Transformer架構(gòu)實現(xiàn)了雙向編碼,能夠同時利用左右兩側(cè)的上下文信息,從而獲得更加全面的詞表示。

強大的上下文理解能力:得益于Transformer的自注意力機制,BERT在捕捉長距離依賴和復(fù)雜的句法結(jié)構(gòu)方面表現(xiàn)出色。

廣泛的適用性:BERT的預(yù)訓(xùn)練模型可以輕松地遷移到各種NLP任務(wù),包括問答、情感分析、命名實體識別等,且效果顯著優(yōu)于許多傳統(tǒng)方法。

2.3 BERT的缺點

計算資源消耗大:盡管BERT在性能上非常強大,但其龐大的模型參數(shù)和復(fù)雜的訓(xùn)練過程使得BERT在訓(xùn)練和推理時對計算資源的需求非常高。

推理速度較慢:由于BERT需要處理整個輸入序列的上下文信息,這導(dǎo)致它在推理時的速度較慢,尤其是在處理長文本時。

大規(guī)模數(shù)據(jù)依賴:BERT的預(yù)訓(xùn)練需要海量的文本數(shù)據(jù),這使得BERT的應(yīng)用需要較強的數(shù)據(jù)支持。

圖片

圖片

3. ELMo與BERT的比較

盡管ELMo和BERT都屬于基于上下文的詞向量模型,但它們在架構(gòu)、訓(xùn)練方法和應(yīng)用場景上存在明顯的差異。

3.1 架構(gòu)差異

ELMo:基于雙向LSTM,能夠從左右兩個方向分別學(xué)習(xí)上下文信息,但由于LSTM的局限性,其對長距離依賴的建模效果較差。

BERT:基于Transformer架構(gòu),能夠通過自注意力機制同時處理序列中所有詞的上下文信息,且可以更好地捕捉長距離依賴。

3.2 預(yù)訓(xùn)練任務(wù)

ELMo:通過傳統(tǒng)的語言模型任務(wù)進(jìn)行訓(xùn)練,即預(yù)測下一個詞。

BERT:通過Masked Language Model(MLM)和Next Sentence Prediction(NSP)任務(wù)進(jìn)行訓(xùn)練,能夠?qū)W習(xí)更豐富的上下文信息。

3.3 性能表現(xiàn)

ELMo:在許多NLP任務(wù)中表現(xiàn)優(yōu)秀,尤其是在處理詞的上下文關(guān)系時。

BERT:在多項NLP任務(wù)中,尤其是問答、文本分類和命名實體識別等任務(wù)中,BERT表現(xiàn)出色,常常超越其他模型。

3.4 計算資源

ELMo:由于采用雙向LSTM,訓(xùn)練和推理時需要較多的計算資源,尤其是在處理大規(guī)模數(shù)據(jù)時。

BERT:盡管BERT在性能上較為強大,但其龐大的參數(shù)量和計算復(fù)雜度使得其在訓(xùn)練和推理時的計算資源需求更為高昂。

4. 結(jié)論

ELMo和BERT作為兩種基于上下文的詞向量模型,都在自然語言處理任務(wù)中展現(xiàn)了強大的能力。ELMo的優(yōu)點在于其簡單易用且能夠根據(jù)上下文生成詞向量,但它的計算資源消耗較大,且無法處理長距離依賴問題。BERT則通過Transformer架構(gòu)克服了這些局限,提供了更強大的上下文理解能力,尤其在長文本和復(fù)雜句法分析中表現(xiàn)優(yōu)越。盡管BERT的計算開銷較大,但其性能優(yōu)勢使其成為當(dāng)前NLP領(lǐng)域的主流模型。