潞晨尤洋:視頻生成的GPT-4時刻,3年后可以見證 | MEET 2025

奧特曼說,Sora代表了視頻生成大模型的GPT-1時刻。

從開年到現在,國內外、初創獨角獸到互聯網大廠,都紛紛投入視頻生成領域,帶來一個個新鮮模型的同時,視頻、影視行業也隨之發生巨變。

不可否認,當下的視頻生成模型還遇到諸多問題,比如對空間、對物理規律的理解,我們都期待著視頻生成的GPT-3.5/4時刻到來。

在國內,有這樣一家從加速訓練出發的初創公司,正在為此努力。

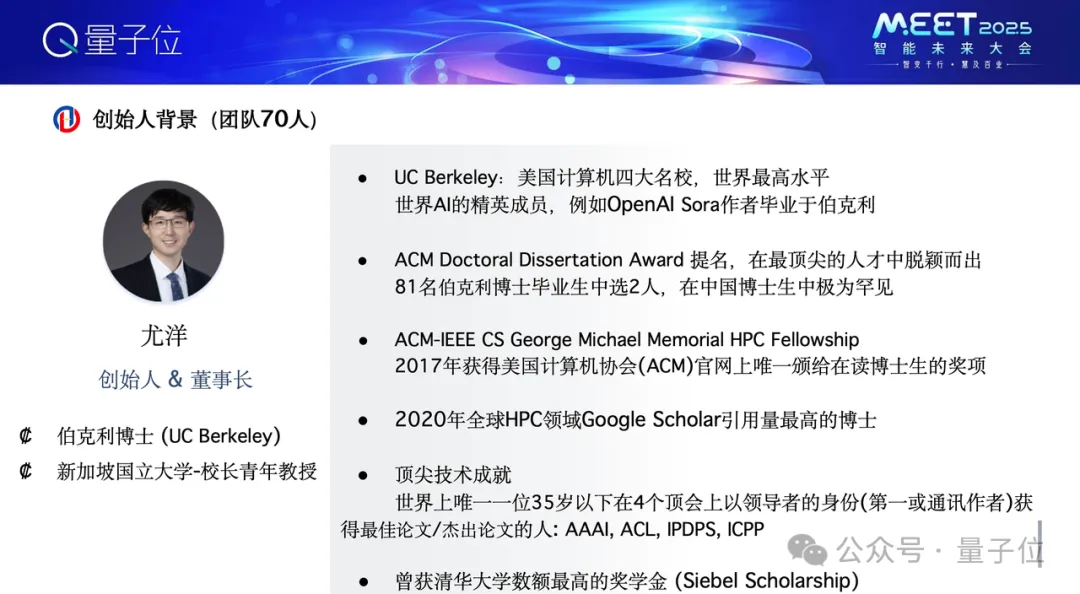

它就是潞晨科技,創始人尤洋博士畢業于UC伯克利,后赴新加坡國立大學擔任校長青年教授。

今年潞晨科技在加速計算領域之外,開發視頻生成模型VideoOcean,為行業帶來更具性價比的選擇。

在MEET 2025現場,尤洋博士也向我們分享這一年對于視頻生成領域的理解與認知。

MEET 2025智能未來大會是由量子位主辦的行業峰會,20余位產業代表與會討論。線下參會觀眾1000+,線上直播觀眾320萬+,獲得了主流媒體的廣泛關注與報道。

核心觀點梳理

- 視頻生成模型應該實現精細化文本控制、任意機位/任意角度、角色一致性、風格定制化

- 3年后或許就能迎來視頻生成的GPT-3.5/GPT-4時刻

- 視頻生成大模型的一個直接應用價值就是突破現實的限制,極大降低真實場景復現難度。

(為更好呈現尤洋的觀點,量子位在不改變原意的基礎上做了如下梳理)

3年后或是視頻大模型的GPT-3.5時刻

今天非常開心來到量子位大會,非常開心和大家交流,今天講一下我們在視頻大模型領域做的一些工作。

首先是我和我的創業公司潞晨科技的介紹。我從UC伯克利畢業到新加坡國立大學任教,很榮幸創辦了潞晨科技。

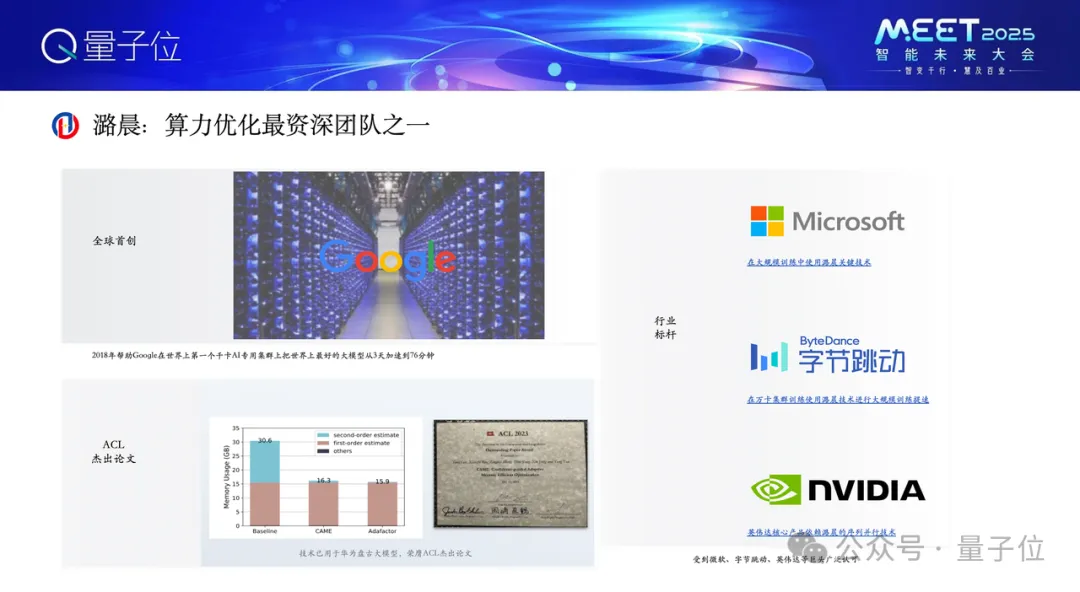

我們之前是做算力優化的。2018年谷歌打造了世界上第一個千卡集群TPU Pod,當時世界上最大的模型還是BERT。我們幫助谷歌,將(當時)世界上最大模型的訓練時間從3天壓縮到76分鐘。

也很榮幸,去年華為盤古大模型的一個工作也是我們一起來做的,并獲得了ACL最佳論文。我們的技術幫助華為盤古大模型在訓練中更高效。微軟、英偉達等公司團隊也使用了我們的技術做一些分布式訓練,我們希望讓大模型訓練更快、成本更低。

步入今天的話題,來重點介紹一下視頻生成大模型。

我們打造了一個產品叫Video Ocean,現在正處在測試階段。先來介紹一下產品,后面再探討我覺得視頻大模型將會如何發展。

首先,我覺得視頻大模型第一個重要的方面是,它應該能夠實現精細化的文本控制。

其實我們今天都在用AI去生成大模型了,我們肯定希望它能夠精準反映出想要的東西。但很遺憾,比如現在用文生圖APP去生成圖片時,還是會發現很多圖片內容無法做到精準控制,所以我認為這方面還有很大的發展空間。

在Video Ocean模型訓練過程中,我們做了一些初步探索。一個比較好的例子,我們能夠精準地提供一些描述,戴著墨鏡,長的胡茬的歐洲男人。顯而易見這個視頻里面確實是我們想要的那個感覺,藍天、海岸、沙灘、背光、單手持相機、黑色T恤,也有對著鏡頭說話。

我認為AI視頻大模型未來3年可能最重要的還是實現視頻大模型的Scaling Law。

這個過程不需要非常炫酷的產品能力,最重要的是把它的模型與現實世界的連接能力做到極致。我覺得最終形態就是人們說一段話、給一段描述,它能精準地把描述以視頻的方式展示出來。

所以我覺得未來3年,AI視頻大模型就像山姆·奧特曼說的那樣,今天是Video的GPT-1時刻,可能3年后到視頻大模型的GPT-3.5、GPT-4時刻。

這里展示一下Video Ocean的Demo,目前我們做到了這樣的水平。

第二點是未來視頻大模型怎樣能夠實現任意機位、任意角度。

現在拍電影、拍紀錄片可以拿著手機、攝像機不斷地晃,想怎么晃就怎么晃,這樣是對鏡頭有真實控制的。未來AI視頻大模型,首先應該做到這一點,同樣的描述,換一下角度、換一個鏡頭,它的形象是不應該改變的,它就是同樣一個物體。

更進一步講,未來AI視頻大模型還能顛覆很多行業。比如現在看足球、看籃球賽,我們看到的鏡頭是現場編導給我們看的鏡頭。他給我們看遠景、近景。

未來能不能依靠AI視頻大模型,人來控制鏡頭,決定想要看哪,相當于在體育場里可以瞬間移動,移動到教練席、最后一排、第一排。任意機位、任意角度的控制。我覺得未來AI視頻大模型在這方面也是非常關鍵的,當然當然Video Ocean現在做了一些嘗試,初步效果還是不錯的。

我覺得第三點重要的是角色一致性。

因為做出AI視頻大模型,最終肯定是需要產生營收、實現變現的。誰會愿意為這個付費,比如廣告工作室、廣告商、電商博主、影視行業。如果深入這些行業的話,一個關鍵點是角色一致性。

比如一個產品的廣告,肯定從頭到尾這個視頻中的衣服、鞋、車,樣貌不能有太大變化,物體角色保持一致性。

拍一部電影,從開頭到結尾,主演的樣貌、關鍵配角的樣貌肯定也不能變化,在這方面Video Ocean也做一些很好的探索。

再一個是風格的定制化。我們知道現在演員人工成本是非常貴的,道具成本也很高。

未來3年之內,如果AI視頻大模型正常發展,我感覺會有一種需求,比如一個導演可以讓一個演員在游泳池里拍一段戲,然后拿到素材通過AI將它轉成泰坦尼克場景下的游泳,轉成阿凡達場景下的游泳,這種能力反而是AI最擅長的。賦予電影感、藝術感的畫面。

總之大模型一個直接的應用價值就是突破現實的限制,能夠極大降低真實場景復現的難度。

可能之前大家聽過一個段子,好萊塢導演想制造一個爆炸鏡頭,他算了一下預算,第一種方案是蓋一個城堡把它炸掉,第二個方案是用計算機模擬這個畫面。成本算下來之后,發現這兩種方案的成本都很高,當時用計算機模擬的成本更高,現在AI就是要大幅降低大模型對于生成電影的成本。

如果這一點實現后,我們可以不受場地、天氣等外部因素的限制,并減少對真實演員的依賴。這倒不是搶演員的飯碗,因為一些關鍵鏡頭是非常危險的,比如演員跳飛機、跳樓,演員去解救即將引爆的炸彈之類,這種鏡頭未來只需要演員的身份和肖像權,AI可以把這樣的鏡頭做好,所以對電影行業能夠極大做到降本增效。

正如昆侖萬維方漢老師剛才說的,雖然我們的計算資源有限,但是我們發現通過更好的算法優化確實能夠訓出更好的效果,比如Meta使用6000多個GPU訓練30B的模型,最近我們會在一個月內發一個10B版的模型,我們僅用了256卡。

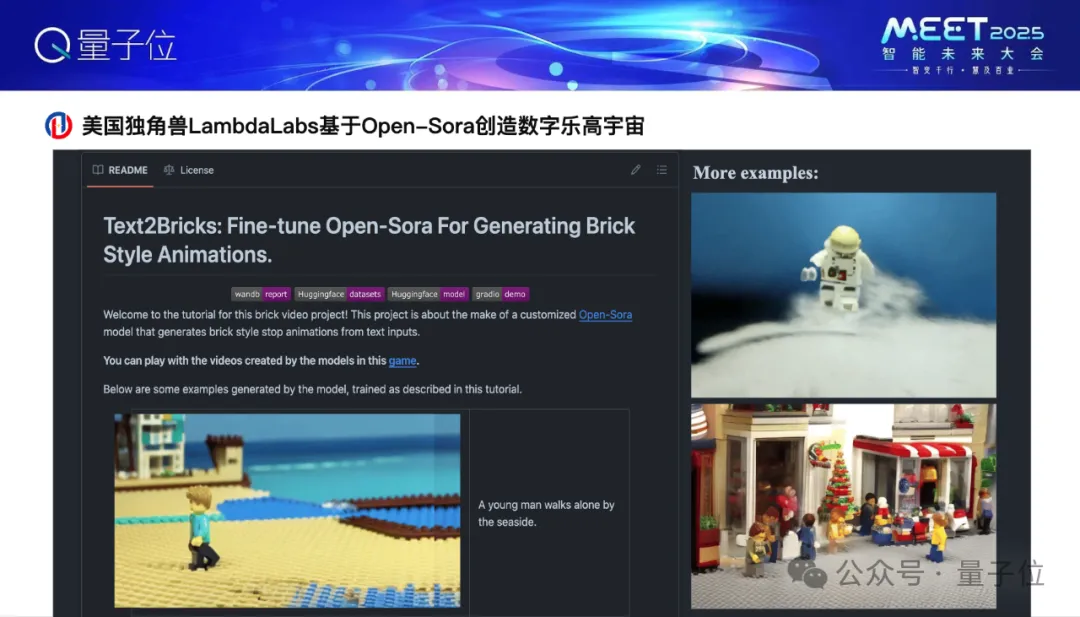

Video Ocean前身是我們團隊先打造了一個Open-Sora的開源產品,這個開源產品是完全免費的,在Github上,效果非常不錯,比如美國獨角獸Lambda labs做了一個火爆的應用數字樂高,其實這個數字樂高就是基于Open-Sora做的。

今年年初Sora出來之后,各種短視頻巨頭都對視頻大模型這一塊比較重視,比如中國的快手、抖音,美國就是Instagram、TikTok、SnapChat,這可以看到SnapChat的視頻模型也在早些時候發布了,叫Snap Video,這是它的官方論文,他們就引用了我們訓練視頻大模型的技術,所以說這些技術也幫助一些巨頭真正把視頻大模型訓得更快,精度更高,智能程度更高。

謝謝大家!

點擊[閱讀原文]或https://video.luchentech.com可體驗Video Ocean更多詳細能力