字節 & 清華大學提出 AnyDressing :通過潛在擴散模型實現可定制的多服裝虛擬試穿

今天的文章來自公眾號粉絲投稿,清華大學聯合字節提出了一項虛擬試穿新方法AnyDressing: 可以利用參考的服飾和文本prompt定制化人物,核心是解決多服飾組合搭配、文本響應以及服飾細節的問題。

? 可靠性: AnyDressing 適合各種場景和復雜的服裝。

? 兼容性: AnyDressing 兼容 LoRA 以及 ControlNet 和 FaceID 等插件。

相關鏈接

? Project page: https://crayon-shinchan.github.io/AnyDressing/

? Huggingface: https://huggingface.co/papers/2412.04146

? Code: https://github.com/Crayon-Shinchan/AnyDressing

? Paper: https://arxiv.org/abs/2412.04146

論文閱讀

AnyDressing:通過潛在擴散模型實現可定制的多服裝虛擬穿衣

摘要

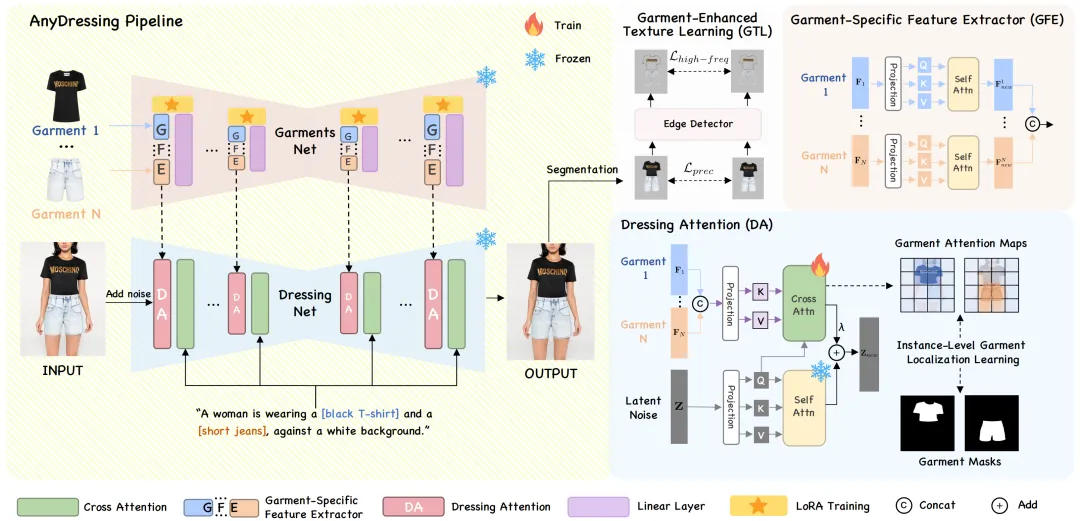

基于擴散模型的以服裝為中心的文本和圖像提示圖像生成方面的最新進展令人印象深刻。然而,現有的方法缺乏對各種服裝組合的支持,并且難以在忠實于文本提示的同時保留服裝細節,從而限制了它們在不同場景中的表現。在本文中,我們專注于一項新任務,即多服裝虛擬穿衣,并提出了一種新穎的AnyDressing方法,用于根據任意服裝組合和任意個性化文本提示定制角色。AnyDressing包含兩個主要網絡,分別為GarmentsNet和DressingNet,分別用于提取詳細的服裝特征和生成定制圖像。具體而言,我們在GarmentsNet中提出了一個高效且可擴展的模塊,稱為服裝特定特征提取器,用于并行單獨編碼服裝紋理。這種設計在確保網絡效率的同時防止了服裝混淆。同時,我們在DressingNet中設計了一種自適應的穿衣注意機制和一種新穎的實例級服裝定位學習策略,以將多服裝特征準確地注入到它們相應的區域。該方法有效地將多件服裝的紋理線索整合到生成的圖像中,并進一步增強了文本與圖像的一致性。此外,我們引入了服裝增強紋理學習策略來改善服裝的細粒度紋理細節。得益于我們精心設計,AnyDressing 可以作為插件模塊,輕松與任何社區控制擴展集成以用于擴散模型,從而提高合成圖像的多樣性和可控性。大量實驗表明,AnyDressing 取得了最先進的成果。

它是如何工作的?

AnyDressing給定N 件目標服裝,定制穿著多件目標服裝的角色。GarmentsNet 利用服裝特定特征提取器 (GFE)模塊從多件服裝中提取細節特征。DressingNet 使用Dressing-Attention (DA)模塊和實例級服裝定位學習機制將這些特征集成在一起進行虛擬穿衣。此外,服裝增強紋理學習 (GTL)策略進一步增強細節。

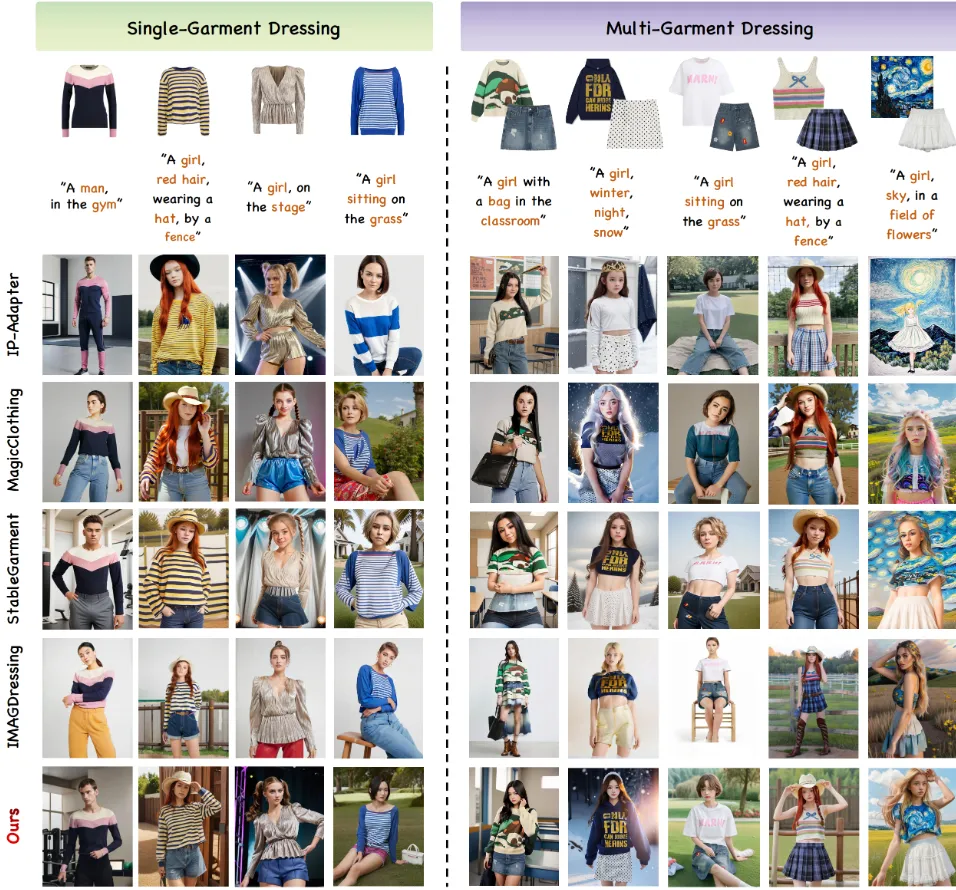

與最新技術的比較

與最先進的單件服裝和多件服裝穿衣方法 進行定性比較。

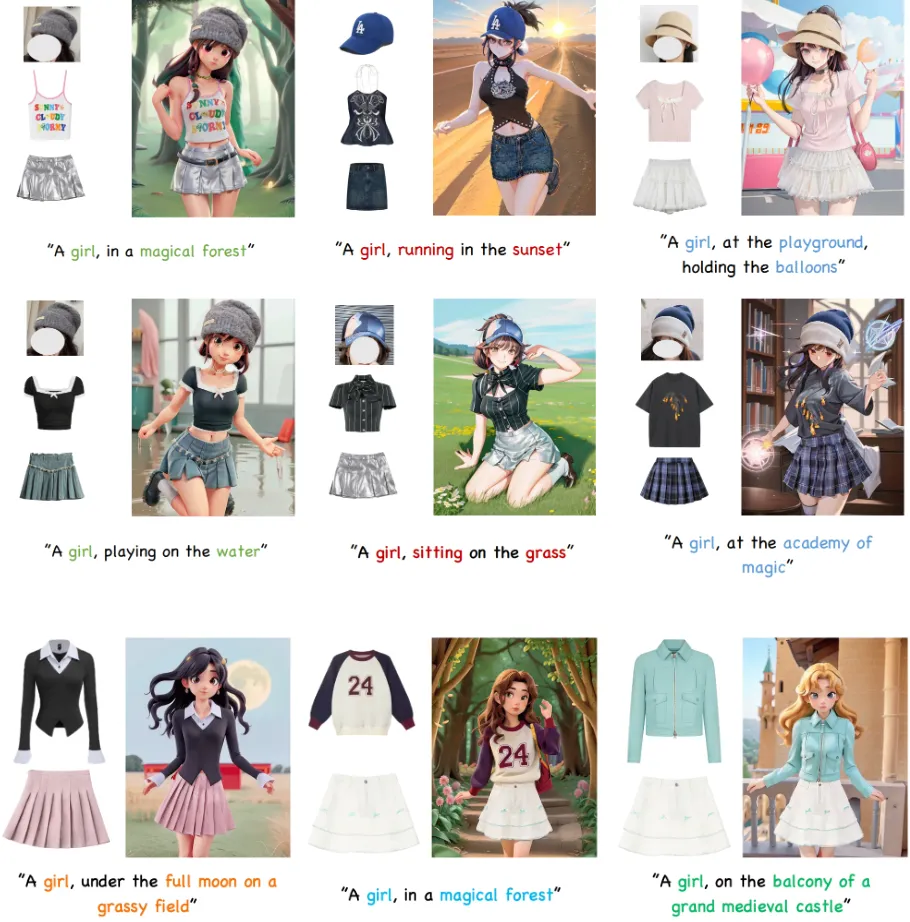

各種虛擬試衣效果

逼真的場景

風格化的場景

AnyDressing + IPA 和 ControlNet

AnyDressing + LoRA

結論

本文介紹了由兩個核心網絡(GarmentsNet 和 DressingNet)組成的 AnyDressing,重點關注一項新任務,即多服裝虛擬穿衣。 GarmentsNet 采用服裝特定特征提取器模塊,高效地并行編碼多服裝特征。DressingNet 使用 Dressing-Attention 模塊和實例級服裝定位學習機制將這些特征集成到虛擬穿衣中。此外,論文還設計了一種服裝增強紋理學習策略,以進一步增強紋理細節。該方法可以與任何社區控制插件無縫集成。大量實驗表明,AnyDressing 取得了最先進的成果。