斯坦福打臉大模型數學水平:題干一改就集體降智,強如o1也失準,能力涌現怕不是檢索題庫

只是換一下數學題的變量名稱,大模型就可能集體降智??

斯坦福大學最新研究表明,在他們最新提出的Putnam-AXIOM測試集上,僅僅是更換一下原題目的變量名稱、變量取值范圍,模型的準確率就直線下降。

也就是說,大模型的數學推理能力并不是真正掌握了解題邏輯,很可能只是檢索已存儲的題目……

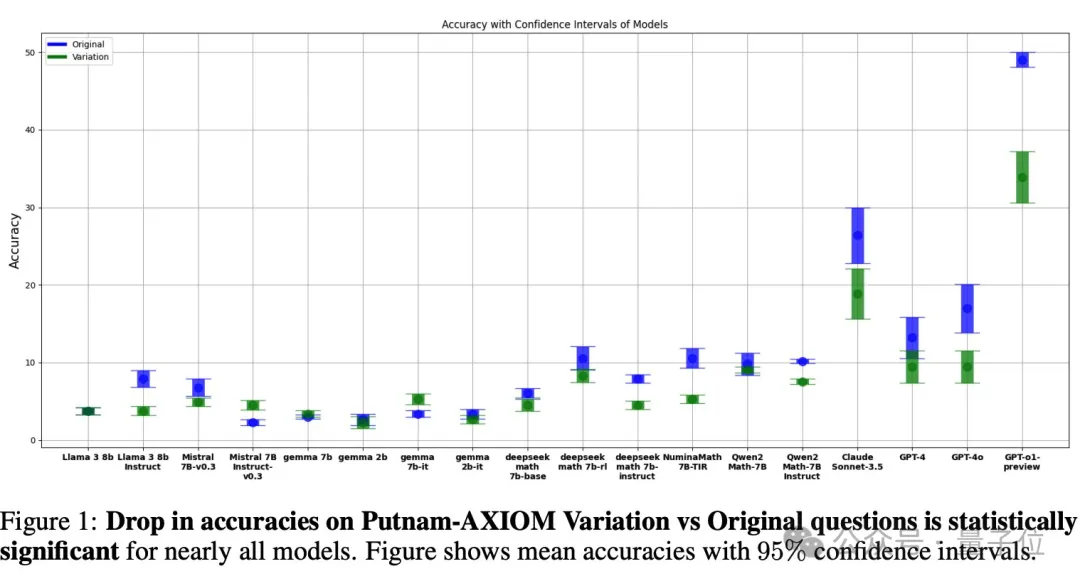

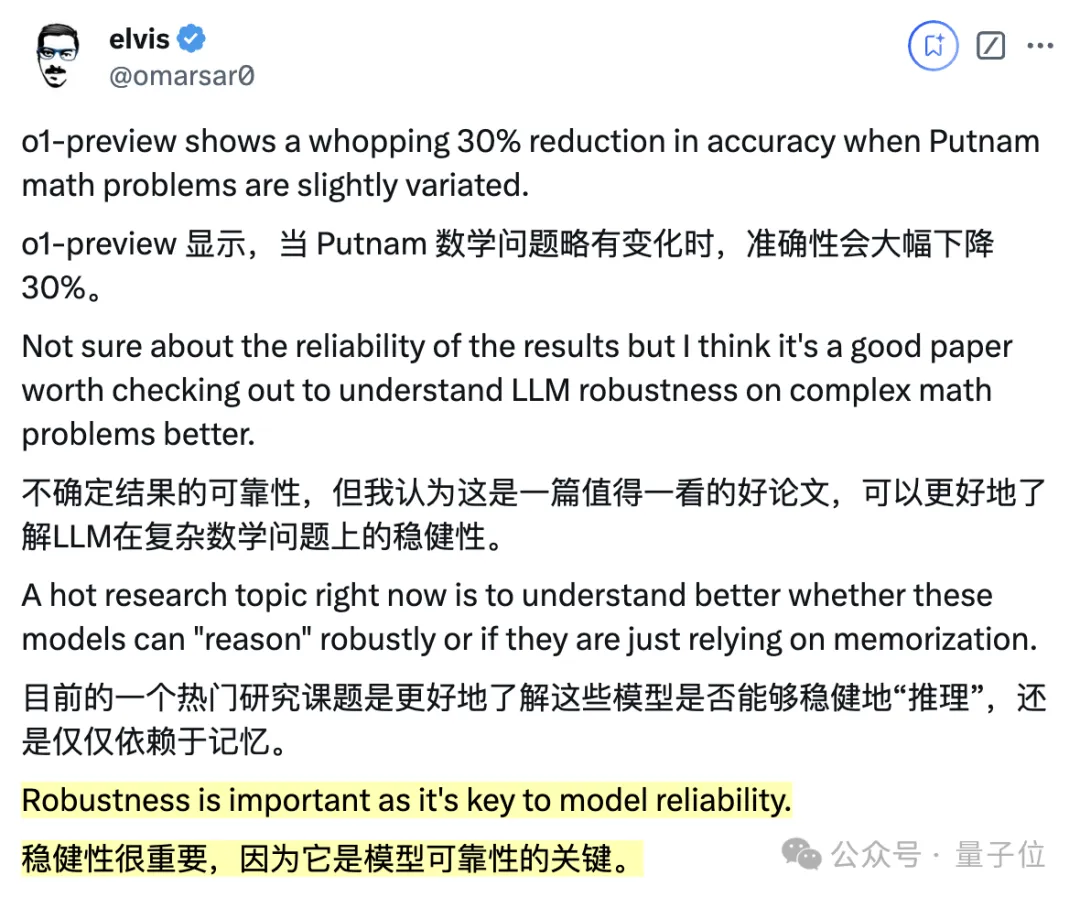

即使是表現最好的o1-preview,它的成績也從50%下降到了33.96%,GPT-4o、Claude、Deepseek、Qwen等模型也幾乎是全軍覆沒。

要知道,模型推理能力的穩健性可是非常重要的指標,能代表他們是否真正掌握了解決方法:

有網友銳評到:o1的o不會是overfitting的o吧?(doge)

還有熱心網友做了解釋,他認為模型的搜索空間會隨著深度指數級增長,搜索時間越長,搜索的難度也會更高。

全新無污染的數學測試基準

LLM在復雜數學問題上的推理能力逐漸成為模型發展的關鍵挑戰,然而現有的評估基準,如MMLU、MMMU、GSM8K和MATH等卻面臨著很多問題。

一方面,數據污染可能導致模型在評估中表現虛高,因為模型可能在訓練過程中接觸到了評估基準中的問題。

另一方面,最先進的模型在許多現有基準上已經達到或超過人類水平,這使得這些基準失去了應有的評估價值。

對此,斯坦福研究團隊提出了Putnam-AXIOM基準,專用于評估模型在解決復雜數學問題上的能力。

該基準的原始數據集涵蓋了1985-2023年William Lowell Putnam數學競賽的236個問題。

隨便舉個例題大家感受一下:

這些題目涵蓋了11個不同數學領域的問題,團隊也進行了篩選,確保能產生便于自動化評估的\boxed{}答案。

同時,他們還借鑒MATH數據集的方法進行模型評估,并設計了一個等價函數,可以解決字符串不一致問題、和復雜的數學等價同質化問題。

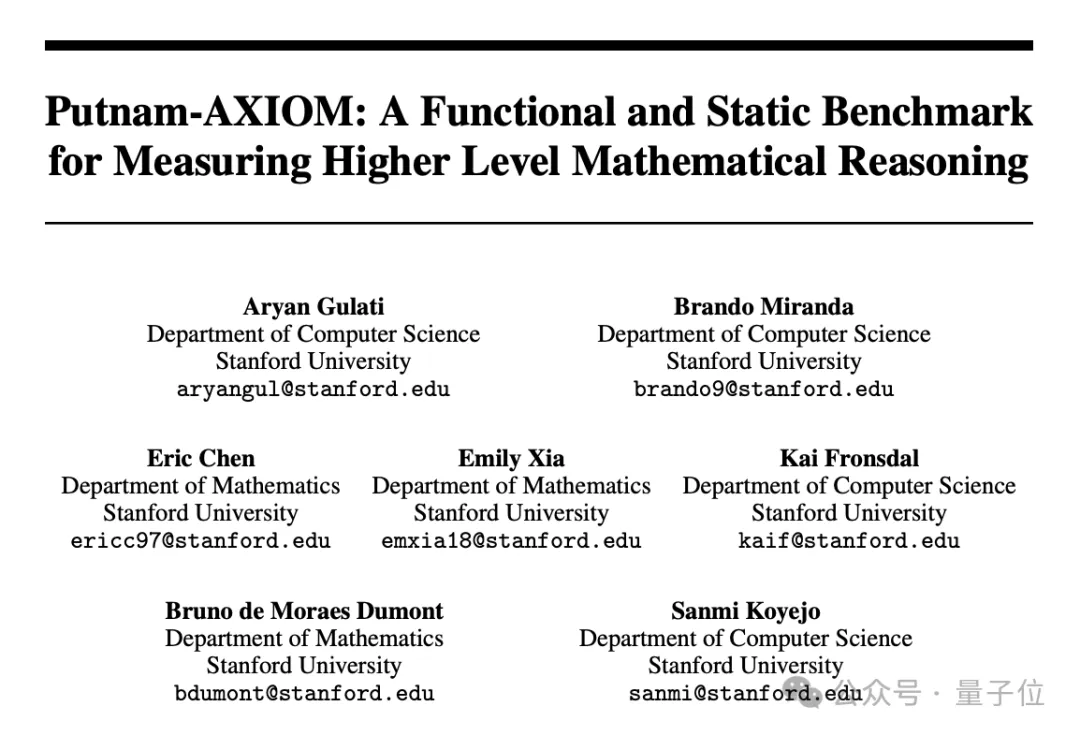

除此之外,為防止模型在訓練過程中遇到Putnam原問題而出現評估偏差,團隊還引入了功能變異構建變異數據集。

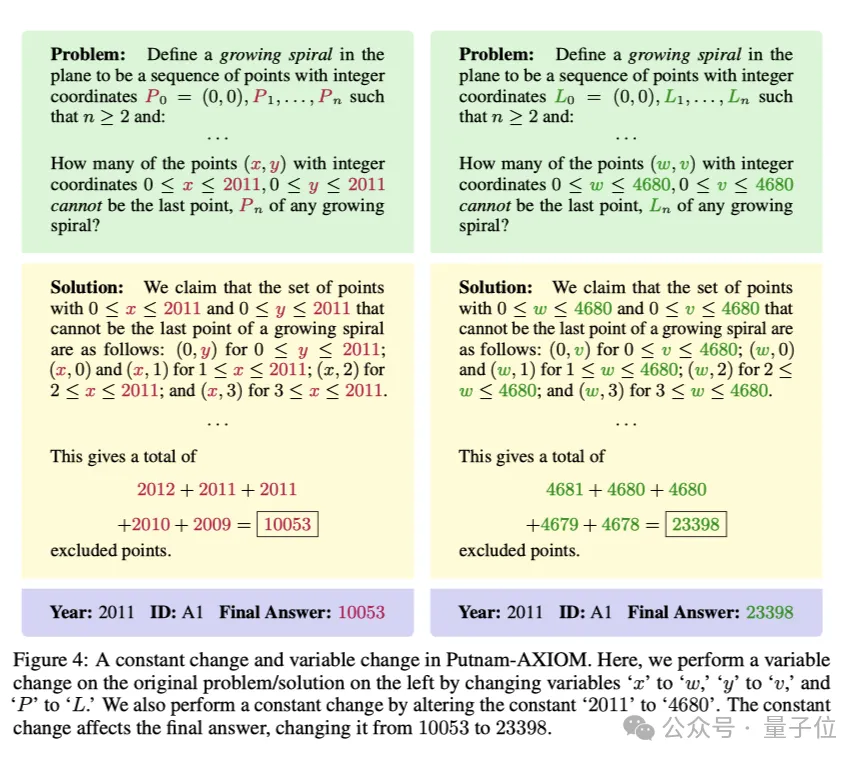

變異分為變量變化(僅改變量名)和常數變化(修改數值屬性)兩類,能生成無限多相同難度的新問題,而且這些問題在互聯網上沒有現成的答案。

具體的變化形式就像這樣:

在實驗中,研究人員將1985-2023年的競賽中的236個問題整理成標準化格式,使用LM Harness評估框架對多個開源模型的SOTA LLMs進行評估。

樣本包括236個原始問題和52個變異問題,參與測試的模型包含OpenAI的o1-preview、GPT-4o、Claude-3.5 Sonnet等多種模型。

題目一變,模型集體懵

實驗結果有些令人意外,模型們的表現都不太樂觀。

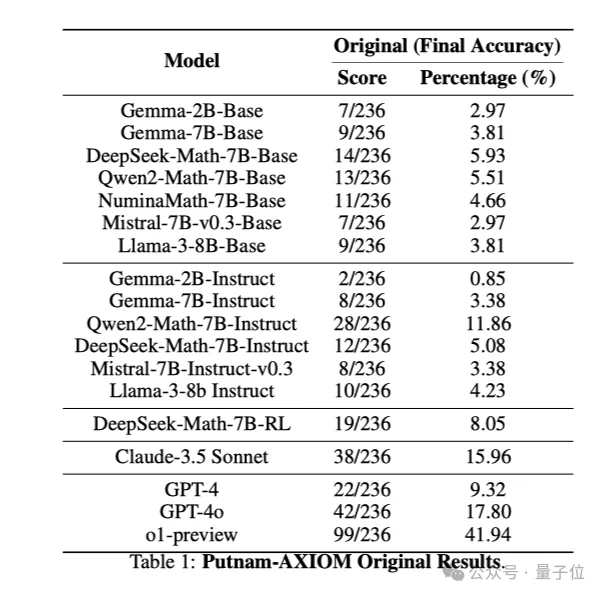

首先來看看模型們在原始數據集上的表現。

多數模型的準確率都低于10%,曾獲AI數學奧林匹克競賽冠軍的NuminaMath僅為4.66%,可見Putnam-AXIOM數據集難度真的很高。

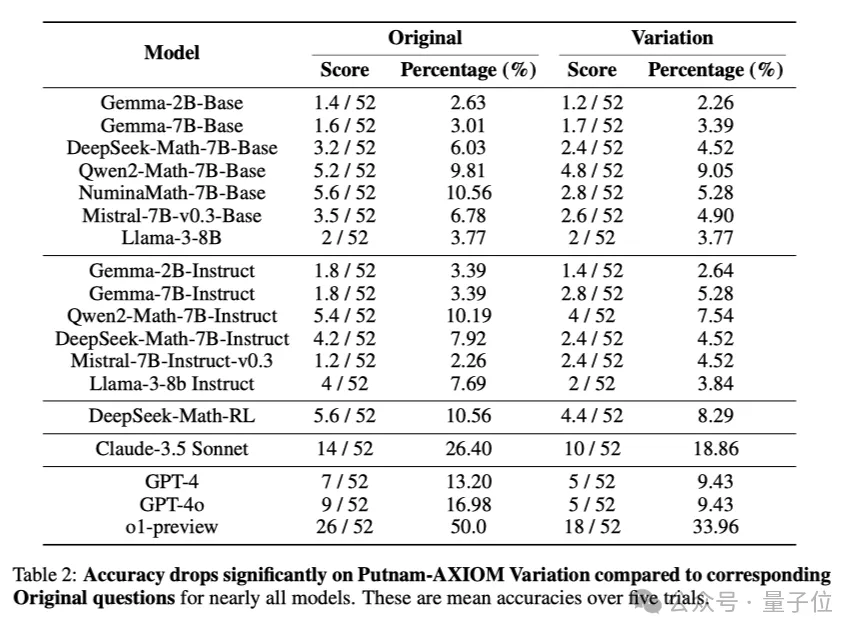

而在變異數據集上,模型們的準確率則顯著下降。

比如在原始數據集上表現最好的o1-preview,準確率為50%,而在變異數據集中則降到了33.96%。

也就是說,o1-preview模型在原始問題上表現可能虛高,之前的得分主要是依賴記憶而非真正的推理能力。

排名第二的Claude在原始數據集上的準確率為26.40%,而在變異數據集上的準確率降至18.86%,其他模型的分數也基本都下降了。

團隊還進一步對OpenAI o1-preview和GPT-4o的答案進行了分析。

結果發現它們的錯誤都比較嚴重,在邏輯推理和數學嚴謹性方面存在著明顯的缺陷。

下面一起康康幾個例子。

比如o1-preview在解答問題時就沒能提供充分的證明,它聲稱m的最大可能值是n,理由是m的上界是2n,但它沒有說明為什么m的值介于n和2n之間不可行。

而GPT-4o則存在邏輯跳躍和不連貫的推理,比如在下面這道題中,它從邏輯上直接跳轉到面積最小的幾何形狀是矩形這一觀點,但并沒有證明這一說法的合理性,而是將其默認為事實。

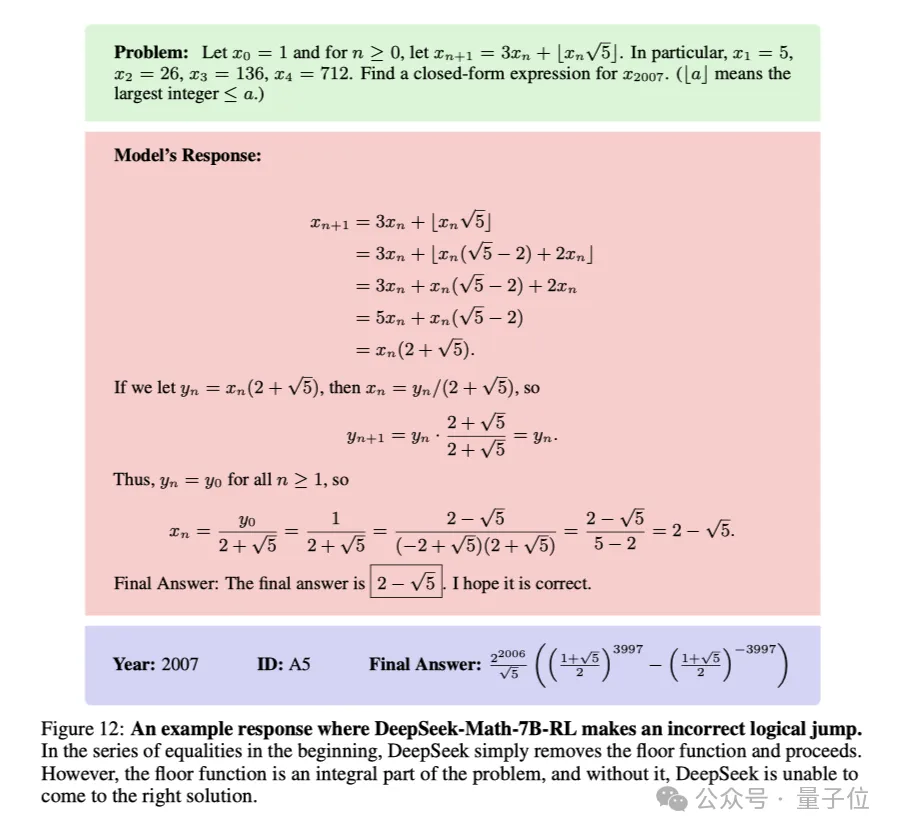

DeepSeek的模型也在關鍵步驟思維發生了跳躍,導致最終結果失誤。

看來,提升大模型的數學能力還是任重道遠呀!

不過斯坦福大學這篇文章中的Putnam-AXIOM基準的確緩解了現有基準飽和的問題。

它不僅為評估模型的數學推理能力提供了一個非常有挑戰性的新方法,還實現了完全自動化評估、并提供了豐富多樣的變體數據集。

團隊也表示,雖然目前變體數據集生成過程復雜耗時,但未來如果能優化變體生成方法,將更有助于加速關于人工推理的研究。

論文:https://openreview.net/forum?id=YXnwlZe0yf¬eId=yrsGpHd0Sf

代碼:https://anonymous.4open.science/r/putnam-axiom-B57C/README.md