3D服裝生成新SOTA!谷歌和CMU提出FabricDiffusion:可將織物紋理從單個圖像遷移到3D服裝

本文經AIGC Studio公眾號授權轉載,轉載請聯系出處。

3D服裝生成新工作!谷歌和CMU提出FabricDiffusion:一種將織物紋理從單個服裝圖像遷移到任意形狀的 3D 服裝的方法。FabricDiffusion性能表現SOTA!同時可以泛化到unseen的紋理和服裝形狀!收錄頂會SIGGRAPH Asia 2024!

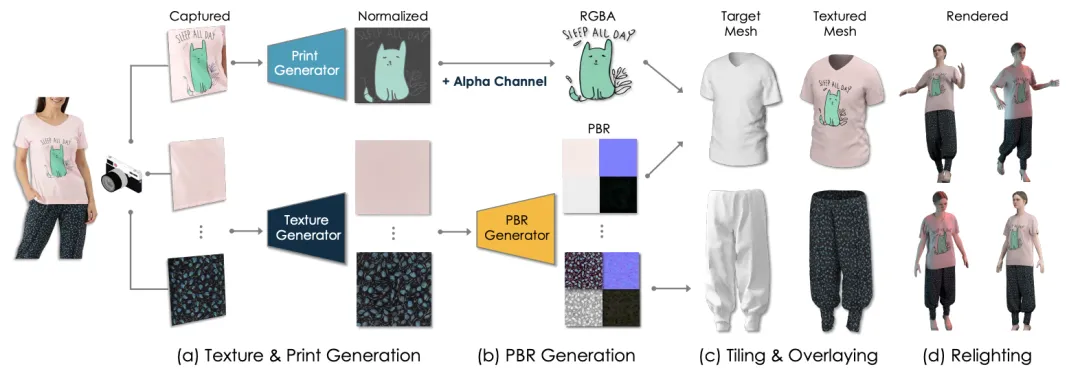

給定一個現實世界的 2D 服裝圖像和一個原始的 3D 服裝網格,我們提出使用 FabricDiffusion 自動從參考圖像中提取高質量的紋理貼圖和打印件,并將其轉移到目標 3D 服裝表面。我們的方法可以處理不同類型的紋理、圖案和材料。此外,FabricDiffusion 不僅能夠生成漫反射反照率,還能生成粗糙度、法線和金屬紋理貼圖,從而能夠在各種照明條件下對制作的 3D 服裝進行精確的重新照明和渲染。

給定一個現實世界的 2D 服裝圖像和一個原始的 3D 服裝網格,我們提出使用 FabricDiffusion 自動從參考圖像中提取高質量的紋理貼圖和打印件,并將其轉移到目標 3D 服裝表面。我們的方法可以處理不同類型的紋理、圖案和材料。此外,FabricDiffusion 不僅能夠生成漫反射反照率,還能生成粗糙度、法線和金屬紋理貼圖,從而能夠在各種照明條件下對制作的 3D 服裝進行精確的重新照明和渲染。

論文閱讀

摘要

我們引入了 FabricDiffusion,這是一種將織物紋理從單個服裝圖像轉移到任意形狀的 3D 服裝的方法。現有方法通常通過 2D 到 3D 紋理映射或通過生成模型進行深度感知修復來合成服裝表面的紋理。不幸的是,這些方法通常難以捕捉和保留紋理,這表明我們的模型在合成數據和現實世界中的服裝圖像上的表現明顯優于最先進的方法,同時可以推廣到看不見的紋理和服裝形狀。

方法

FabricDiffusion 概述。 給定一張真實的服裝圖像及其面料材料和印花的區域捕獲,(a) 我們的模型提取歸一化的紋理和印花,(b) 然后生成高質量的基于物理的渲染 (PBR) 材料和透明印花。(c) 這些材料和印花可以應用于任意形狀的目標 3D 服裝網格 (d) 以實現逼真的重新照明。我們的模型純粹使用合成數據進行訓練,并實現了對真實世界圖像的零樣本泛化。

FabricDiffusion 概述。 給定一張真實的服裝圖像及其面料材料和印花的區域捕獲,(a) 我們的模型提取歸一化的紋理和印花,(b) 然后生成高質量的基于物理的渲染 (PBR) 材料和透明印花。(c) 這些材料和印花可以應用于任意形狀的目標 3D 服裝網格 (d) 以實現逼真的重新照明。我們的模型純粹使用合成數據進行訓練,并實現了對真實世界圖像的零樣本泛化。

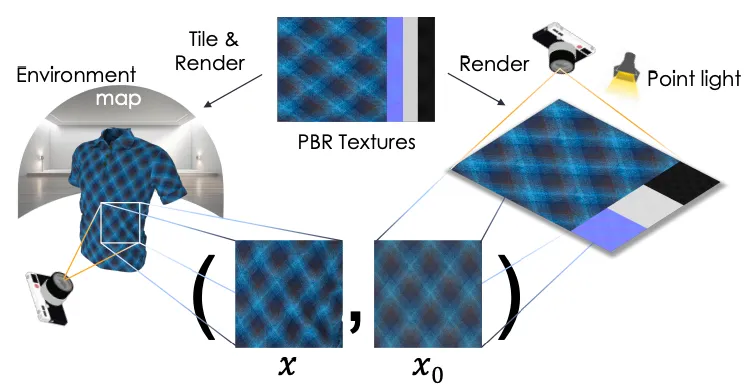

配對訓練數據構建管道。給定 PBR 材質的紋理,我們將其應用于目標原始 3D 服裝網格和普通網格。3D 服裝使用環境貼圖渲染,而普通網格使用來自上方的點光源照亮。兩個網格生成的渲染圖像 (??, ??0 ) 作為訓練紋理生成模型的配對訓練示例。

實驗

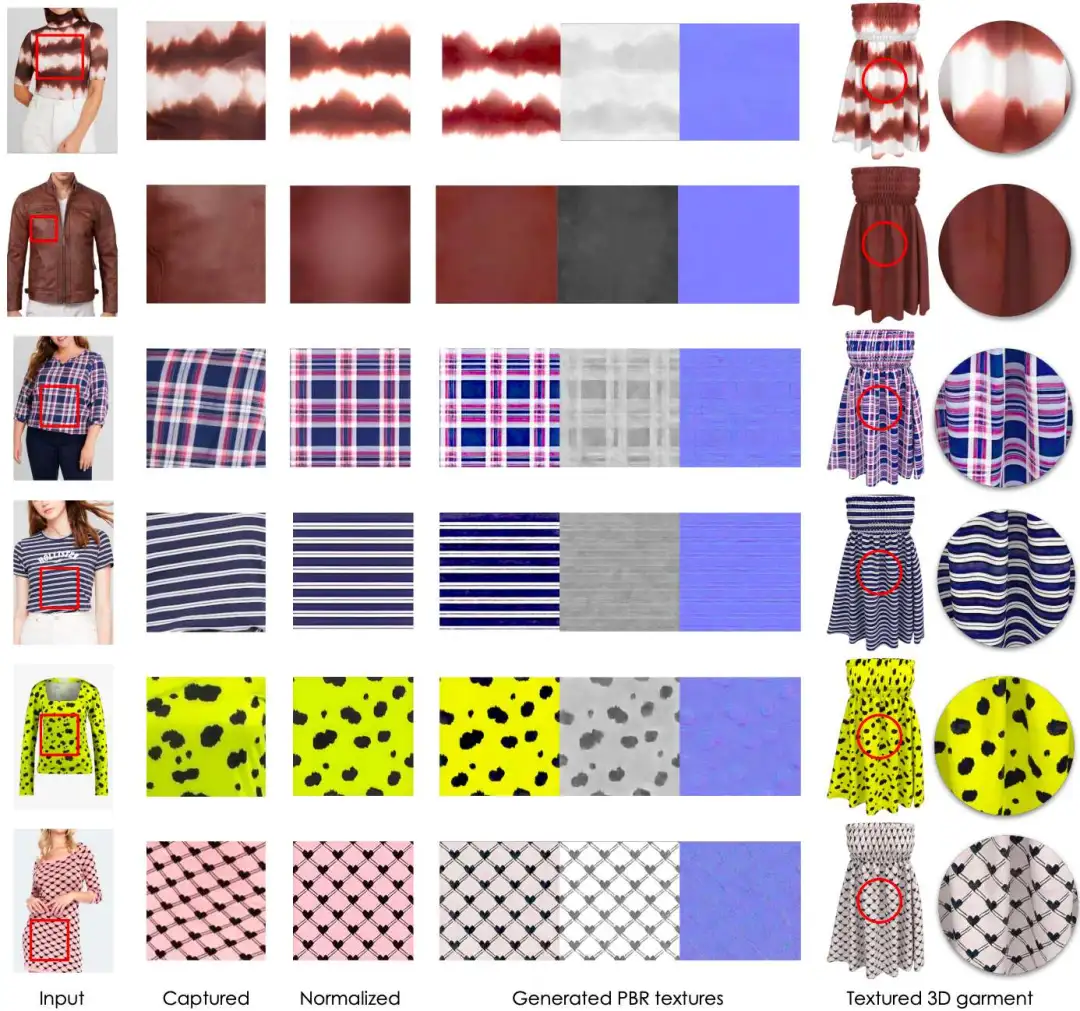

真實世界服裝圖像上的紋理轉移結果。我們的方法可以處理真實世界的服裝圖像以生成規范化的紋理貼圖,以及相應的 PBR 材料。PBR 貼圖可以應用于 3D 服裝,以實現逼真的重新照明和渲染。

真實世界服裝圖像上的紋理轉移結果。我們的方法可以處理真實世界的服裝圖像以生成規范化的紋理貼圖,以及相應的 PBR 材料。PBR 貼圖可以應用于 3D 服裝,以實現逼真的重新照明和渲染。

印花和徽標上的結果可轉移到真實世界的圖像上。給定一張帶有印花和/或徽標的真實服裝圖像,以及印花所在區域的裁剪補丁。我們的方法會生成無失真且透明的印花元素,可將其應用于目標 3D 服裝以實現逼真的渲染。請注意,背景紋理也是使用我們的方法進行傳輸的。

印花和徽標上的結果可轉移到真實世界的圖像上。給定一張帶有印花和/或徽標的真實服裝圖像,以及印花所在區域的裁剪補丁。我們的方法會生成無失真且透明的印花元素,可將其應用于目標 3D 服裝以實現逼真的渲染。請注意,背景紋理也是使用我們的方法進行傳輸的。

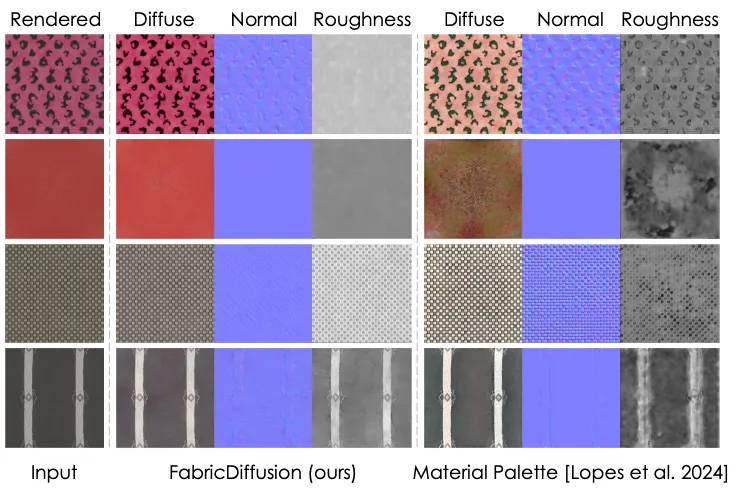

圖像到服裝紋理轉移的比較。FabricDiffusion忠實地捕捉并保留輸入服裝的紋理圖案。

PBR 材料提取的定性比較。材料調色板幾乎無法捕捉織物材料,而我們的 FabricDiffusion 模型能夠恢復織物紋理的物理特性,尤其是在粗糙度和漫反射圖上。

結論

本文介紹了FabricDiffusion,這是一種將織物紋理和印花從單個現實世界服裝圖像轉移到具有任意形狀的 3D 服裝上的新方法。該方法完全使用合成渲染圖像進行訓練,能夠從野外服裝圖像中生成未失真的紋理和印花。雖然該方法在真實照片和多樣化紋理圖案方面表現出強大的泛化能力,但它在某些輸入方面面臨挑戰。

具體來說,FabricDiffusion 在重建非重復圖案時可能會產生錯誤,并且難以準確捕捉復雜印花或徽標中的精細細節,特別是因為我們的重點是具有均勻背景、中等復雜度和中等失真的印花。