一文讀懂:DeepSearch 前生今世

眾所周知,在當今信息爆炸的時代,如何從海量數據中高效、精準地提取有價值的內容,成為人工智能領域的重要課題。DeepSearch 作為一種創新的迭代搜索系統,以其獨特的循環推理機制和強大的信息挖掘能力,逐漸嶄露頭角,成為解決復雜查詢與研究需求的利器。

本文將帶大家深入探索 DeepSearch 的前世今生——從其概念的萌芽、技術原理的演進,到如今在智能搜索與知識生成領域的廣泛應用。通過梳理其發展脈絡與核心優勢,我們將為您揭開這一技術背后的奧秘,呈現一幅清晰而立體的全景圖景,讓大家在“一文”之中,輕松讀懂 DeepSearch 的獨特魅力與未來潛力...

一、DeepSearch 在大模型中的應用

作為搜索技術進入了一個全新的時代的興起標志,DeepSearch 和 DeepResearch 通過深度學習和大型語言模型,實現了從關鍵詞匹配到語義理解、從靜態索引到動態推理的轉型,為用戶提供了更智能、更個性化的搜索體驗。與此同時,這些技術的開源與專有并存的模式,刺激了全球 AI 生態的競爭與合作,促使搜索應用在學術研究、企業服務和日常生活中得到更廣泛的落地。

截至 2025 年 3 月,這些技術已開始在多個領域展現潛力:從學術界的高效文獻檢索,到企業級的實時商業情報,再到消費者的個性化內容發現,DeepSearch 和 DeepResearch 正重塑搜索的未來。它們的興起不僅體現了 AI 技術的快速發展,也預示著搜索領域將迎來更加智能化和多樣化的新時代。

二、DeepSearch & DeepResearch 的發展歷程

眾所周知,在 2025 年初,人工智能驅動的搜索技術迎來了革命性突破,DeepSearch 和 DeepResearch 儼然已成為搜索領域的新標準。這些創新技術的興起標志著搜索功能從傳統的關鍵詞匹配和靜態索引,向基于大型語言模型(LLM)與深度學習的高級語義理解和知識推理轉型,極大地提升了搜索的準確性、相關性和智能化水平。

1. DeepSeek 的 DeepSeek-r1:開源先鋒

2025 年 1 月 20 日,DeepSeek 公司發布其開源大型語言模型 DeepSeek-r1,迅速成為 DeepSearch 領域的標桿。該模型以其強大的語義搜索能力、開放源碼特性以及高效的訓練效率吸引了全球開發者和研究者的廣泛關注。DeepSeek-r1 結合了先進的變換器架構和自監督學習技術,能夠處理復雜查詢并提供深度語境理解,特別適用于學術研究、商業情報和個性化推薦場景。其開源特性促使社區迅速圍繞 DeepSeek-r1 構建生態,涵蓋插件、優化工具和行業應用,加速了 DeepSearch 的普及和創新。

2. Google 與 OpenAI 的 DeepResearch:專有技術引領

而僅僅兩周后,即 2025 年 2月 2 日,Google 和 OpenAI 聯合發布了專有技術 DeepResearch,進一步推動了搜索領域的智能化升級。DeepResearch 整合了 Google 的搜索索引能力和 OpenAI 的生成式 AI 技術(如 GPT 系列的最新迭代),實現了從簡單查詢到復雜推理的跨越。DeepResearch 特別優化了多模態搜索(如文本、圖像、視頻的綜合檢索)和實時知識更新能力,適用于企業級應用、高端科研和精準商業決策。雖然其專有性質限制了源碼公開,但 Google 和 OpenAI 通過云服務和 AP I接口使其廣泛可用,迅速在金融、醫療和法律等領域獲得采用。

3. 行業跟進:全球與國內大模型廠商的積極響應

隨后,Jina AI 推出了開源項目 node-deepresearch,進一步豐富了 DeepSearch 和 DeepResearch 的生態。構建在 Jina AI 的神經搜索框架之上,node-deepresearch 專注于分布式搜索和邊緣計算場景,特別適合低延遲、高吞吐量的搜索需求。

其開源特性使其迅速與 DeepSeek-r1 形成互補,吸引了中小企業和開源社區的廣泛參與。node-deepresearch 通過輕量級設計和跨平臺支持,填補了大型專有模型在資源受限環境中的應用空白。

與此同時,其他 AI 領域領先企業也迅速跟進。Hugging Face 整合其模型中心(Model Hub)推出了基于 DeepSearch 的開源搜索工具,優化了社區模型的檢索與應用。Perplexity 則推出了專有搜索增強產品,結合其對話式 AI 能力,進一步提升用戶體驗。

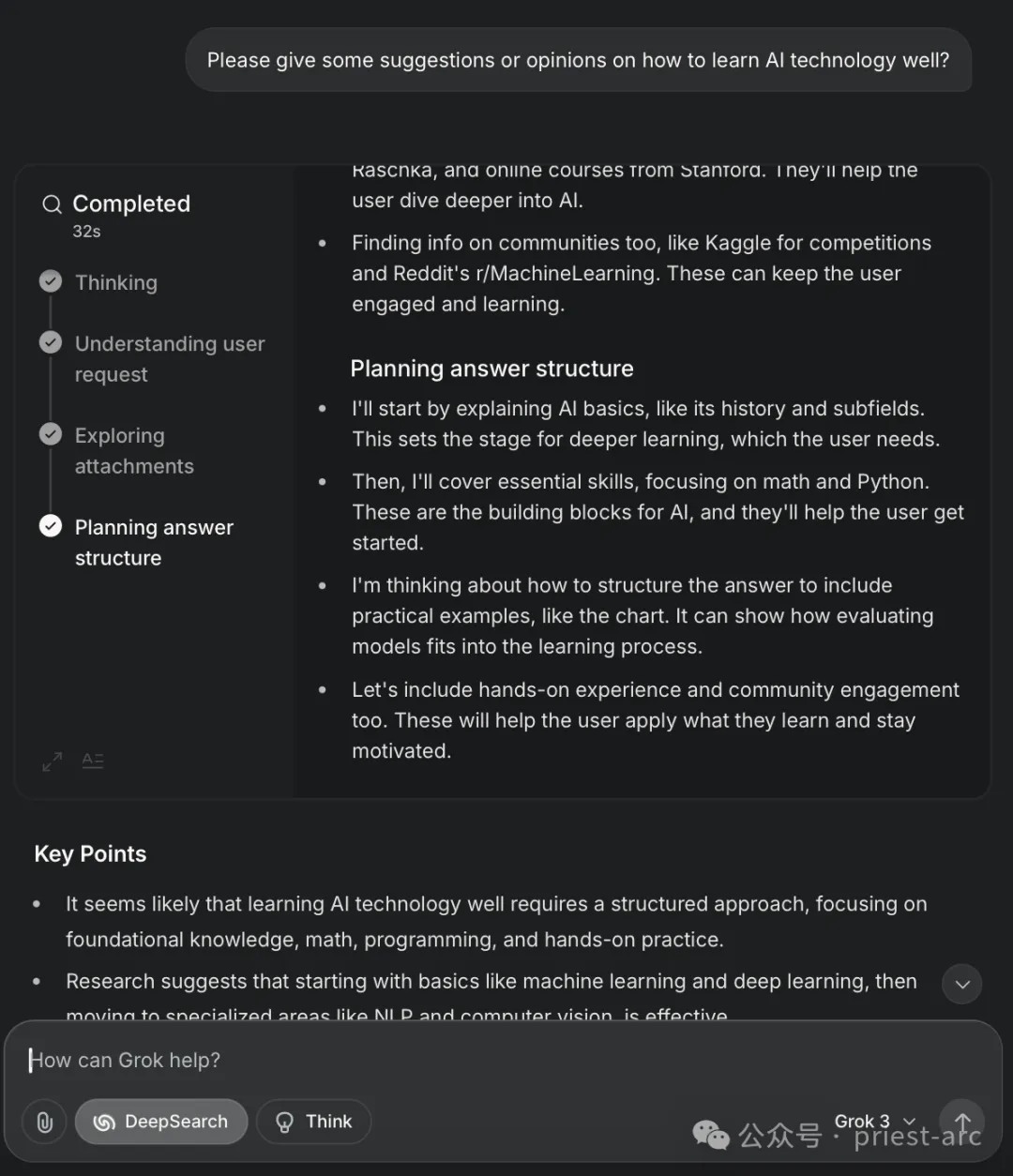

xAI(Grok3)也不甘示弱,利用其獨特的多模態理解能力,推出了面向科研和創新的 DeepSearch 解決方案,強調知識發現的深度與廣度。此外,國內大模型廠商如百度(文心大模型)、阿里(通義千問)和字節跳動(抖音大腦)也迅速響應,推出了各自的 DeepSearch 和 DeepResearch 變種,結合本地化數據和語言特性,服務于中國市場的搜索需求。這些廠商的跟進不僅加速了技術的全球化傳播,也推動了區域化創新。

三、那么, DeepSearch 為何神秘之物?實現機制是怎樣的?

作為一種先進的迭代搜索系統,DeepSearch 的核心在于通過不斷循環執行三個基本動作,直至挖掘出最優答案。其圍繞三個動作展開,具體可參考如下:

- 搜索:充分利用網絡搜索引擎,廣泛探索互聯網上的資源和信息;

- 閱讀:深入剖析特定網頁或文檔的內容,提取關鍵信息并理解其上下文;

- 推理:綜合評估當前的搜索狀態,分析已有信息的質量與相關性,并據此決定下一步的行動方向。

與傳統的檢索增強生成(RAG)系統不同,傳統 RAG 系統通常僅執行一次搜索并直接生成答案,而 DeepSearch 的獨特之處在于其迭代性,會持續進行多次搜索-分析-優化的循環,直到滿足預設的停止條件為止。

這些條件可能包括令牌(token)使用量的上限、失敗嘗試的次數閾值,或系統判定已找到充分可靠的答案。這樣的設計使得 DeepSearch 能夠逐步逼近問題的核心,避免單次搜索可能導致的淺層或不準確的結果。

而對于 DeepResearch 而言,其在 DeepSearch 基礎之上,進一步擴展了 DeepSearch 的功能,專注于生成結構化、邏輯清晰的長篇研究報告。其工作流程可以分為三個階段:

- 目錄生成:根據研究主題,首先構建一個詳細的綱要或目錄,明確報告的各個章節和邏輯結構;

- 章節填充:針對目錄中的每一部分,調用 DeepSearch 系統進行深入的信息挖掘和內容生成;

- 內容整合:將所有章節的內容進行合并與優化,確保整體報告在邏輯連貫性、內容深度和表達一致性上達到更高標準。

通過這種方式,DeepResearch 不僅繼承了 DeepSearch 的迭代搜索能力,還增加了對復雜研究任務的支持,適用于需要系統性分析和長篇輸出的場景。

DeepSearch 和 DeepResearch 依托一系列精心設計的技術機制,以確保系統在效率、準確性和穩定性方面達到最佳水平。以下是對其關鍵技術實現的深入解析。

1. 循環推理機制

系統采用循環推理(Iterative Reasoning)方式,通過一個 While 循環持續執行推理任務。每次迭代包含搜索、閱讀和推理三個核心步驟,并依據預設終止條件判斷是否繼續運行。這種動態調整策略使系統能夠在每輪推理中充分利用新獲取的信息,不斷優化決策,直至滿足以下任一條件:

- 成功找到滿足需求的答案

- 達到資源預算上限(例如令牌消耗超出設定閾值)

- 該機制確保推理過程高效可控,并最大化信息挖掘能力。

2. 系統提示工程優化

在提示工程(Prompt Engineering)設計上,系統采用 XML 結構化標記方式,將不同的任務模塊(如搜索指令、內容分析、推理決策)進行明確劃分。例如:

<prompt>

<search>查詢關鍵詞優化</search>

<analysis>內容解析策略</analysis>

<reasoning>推理路徑選擇</reasoning>

</prompt>這種分區方式增強了模型對復雜任務的理解能力,并提升了輸出的穩定性和可控性。具體而言,該策略具有以下優勢:

- 提高解析準確性:使 LLM 能夠精確區分不同功能區域,減少指令歧義。

- 增強任務可控性:通過清晰的結構引導推理邏輯,確保模型執行預期操作。

- 提升復雜任務的穩定性:避免因長文本提示導致的混淆,提高多步驟任務的可靠性。

3. 知識缺口的高效處理

當系統在推理過程中檢測到知識缺口(Knowledge Gaps)或未解問題時,它不會直接進入遞歸求解模式,而是采用先進先出(FIFO)隊列進行子問題管理。這種策略的核心優勢包括:

- 避免遞歸引發的計算復雜度激增,降低系統資源消耗。

- 確保問題處理的順序性,有序推進多層級問題的解析。

- 動態調整推理流程,優先解決高優先級子問題,提高整體任務完成效率。

這種隊列驅動的推理機制使得系統在處理多層次推理任務時更加高效穩定。

4. 查詢重寫與多元化信息覆蓋

為了優化信息檢索能力,系統采用查詢重寫(Query Rewriting)技術,針對初始搜索請求生成等價但形式多樣的查詢語句,以提高信息覆蓋范圍。關鍵優化策略包括:

- 同義詞擴展:使用不同術語表達相同概念,如 AI 計算 ?人工智能計算?深度學習算力

- 語言多樣化:支持跨語言查詢優化,提升全球范圍內的信息獲取能力。

- 多格式覆蓋:針對不同信息載體(如學術論文、新聞文章、技術論壇)優化查詢表達,提高搜索結果的廣度與深度。

這種多維度搜索優化策略確保了系統能夠充分挖掘與目標任務相關的關鍵信息,提高檢索的全面性和精準度。

5. 內存管理與知識存儲優化

在大語言模型(LLM)的上下文管理中,系統采用記憶(Memory)與知識(Knowledge)分離策略,實現高效的內存管理:

- 記憶(短期上下文):存儲當前推理過程中需要保留的臨時信息,確保上下文連貫性。

- 知識(長期積累):將高價值信息結構化存儲,以供后續任務復用,避免重復推理。

此外,系統通過動態內存清理策略,在推理過程中定期移除冗余或低價值信息,優化計算資源利用率,確保推理效率最大化。

6. 生成與評估分離的答案優化機制

系統在答案生成階段采用“生成-評估” 雙階段流程,確保最終輸出的內容質量可靠。

生成階段(Answer Generation):

- 專注于內容生成,確保回答的流暢性與邏輯性。

- 采用多輪推理優化,提升內容的準確度與完整性。

評估階段(Answer Evaluation):

- 獨立執行答案質量檢測,包括準確性、相關性、完整性評估。

- 使用自動化檢測工具(如基于 LLM 的內容審查)驗證答案質量,確保可信度。

這種解耦式生成-評估框架避免了傳統 LLM 直接輸出可能導致的誤導性問題,提高答案的可靠性和可信度。

7. 預算控制與“野獸模式”優化策略

為應對計算資源限制,系統引入預算控制(Resource Budgeting)機制,在推理過程中動態監測令牌使用量、計算資源占用率等關鍵指標,并在接近上限時觸發“野獸模式”(Beast Mode),優化推理流程。

在“野獸模式”下,系統采取如下策略以確保輸出質量:

- 精簡推理路徑:減少冗余計算,僅關注核心問題,快速得出可用答案。

- 優化信息利用率:優先處理高價值信息,剔除低影響因素,提高推理效率。

- 確保最優解的可用性:即便在受限計算環境下,也能提供實用性較強的答案,避免因資源消耗殆盡導致任務失敗。

該機制使系統能夠在不同計算環境下靈活調整推理策略,實現資源利用的最優化。

Happy Coding ~

Reference :

- [1] https://forums.developer.nvidia.com/

- [2] https://www.run.ai/