Ilya錯了?Scaling另有他用,ViT大佬力挺谷歌1000億數據新發現

預訓練Scaling Law到盡頭了?

ViT大佬翟曉華(Xiaohua Zhai)并不這樣認為,至少在多模態模型上并非如此。

他公布了最新的關于多模態Scaling的最新見解,而訓練數據達到了1000億的規模!

什么長尾任務的新發現讓他興奮?

一句話就是,Illya所說的「Scaling Law」即將終結,不太對。

新研究通過實驗表明,1000億數據規模對已有基準測試提升可能非常小,但顯著影響了一些「非主流」的小眾探索領域。

讓大牛翟曉華眼前一亮點是:泰盧固語(Telugu)表現顯著提升,即使僅占數據集的0.036%!

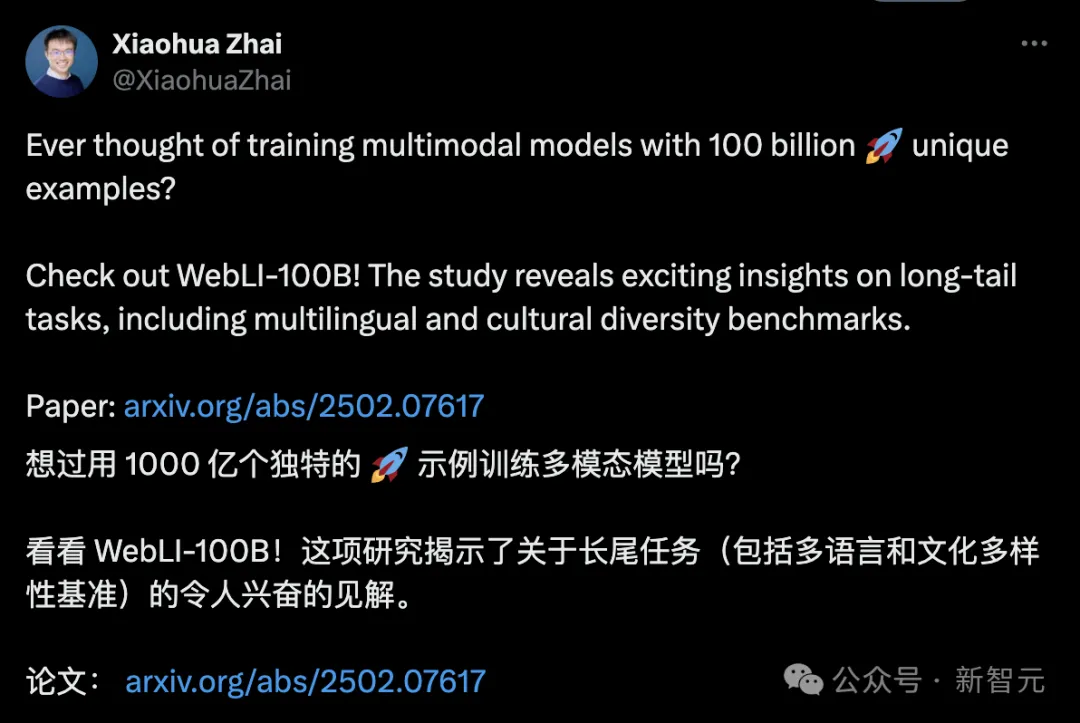

數據集中語言的長尾分布:左二表示泰盧固語的比例

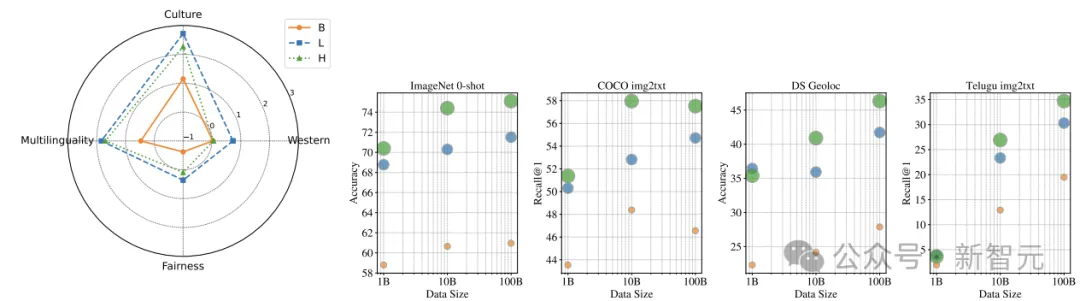

圖1總結了通過數據擴展實現的文化多樣性和多語言性的提升。

圖1:數據擴展所實現的文化多樣性和多語言性的提升

左圖顯示了將數據規模從100億擴展到1000億訓練數據,在文化多樣性和多語言能力方面的提升比其他指標更加顯著。

右圖給出了數據規模影響的示例說明。最左邊的兩個是以為西方中心的指標,擴展數據到1000億時,收益不大;而最右邊的兩個則展示了文化多樣性和多語言能力的提升。

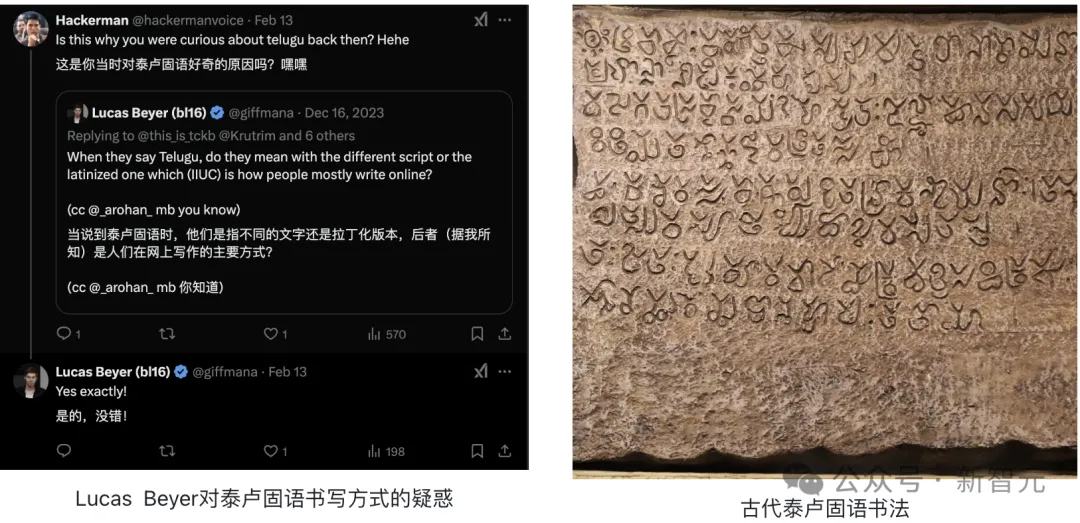

這讓OpenAI的工程師Lucas Beyer不禁發帖質疑下列流傳甚廣的觀點:

預訓練scaling結束了

10-40億圖片足夠了

他認為這類觀點都是些縹緲的「神話」,而此類論斷之所以甚囂塵上,是因為忽視了下列提醒:

-你一葉障目,目光短淺

-不要只盯著美國可疑的評估指標

-拓展到1000億預訓練圖片,會極大促進模型的文化和語言包容性

2023年,還在谷歌的Lucas Beyer見到實驗結果時,就燃起了對泰盧固語的興趣:

新研究的主要貢獻如下:

1. 數據規模對于構建真正包容的多模態系統至關重要。

2. 質量過濾器(例如基于CLIP的過濾器)雖然通常用于提高整體數據質量,但可能會不經意限制數據集的多樣性。

3. 發布了史無前例的1000億視覺-語言數據集,并實證研究了數據集的潛力。

論文鏈接:https://arxiv.org/abs/2502.07617

Scaling Law的信仰:數據規模x10

視覺-語言模型(VLMs)的進展,與大規模數據集的可用性密切相關。

在過去,模型的發展,就是「大力出奇跡」:數據規模越大,模型誤差越小,性能越高。

數據規模與模型性能之間的關系通常遵循冪律:

??(??) = ?????? + ??,

其中??(??)是模型性能指標如誤差率,??是數據規模。

這就是「縮放定律」(Scaling Law)。

重要的是,冪律表明,增加訓練數據的量雖然會導致準確性和性能的收益逐漸遞減,但依然能夠帶來物超所值的提升。

在Scaling Law信念的引領下,擴大數據集規模是視覺-語言(vision-language)的領域重點:

- 早期的數據集如Conceptual Captions,提供了數百萬對圖像-描述對用于預訓練。

- 利用大規模網絡爬蟲技術Common Crawl項目,將數據集規模推向了數十億對圖像-文本對,從而加速了視覺-語言模型(VLMs)的進展。

- 截至文章發表時,報告的最大圖像-文本對數據集已經停留在約100億的規模上。

- 新的數據集WebLI100B包含1000億圖像-文本對,數據量增長了10倍。

項目鏈接:https://commoncrawl.org/

這類似于圖像識別領域的情形, 比如數據集ImageNet加速了監督圖像預訓練的進展。

這引出了問題:將數據規模提高10倍,達到1000億這個規模,能解鎖哪些進一步的好處?

比如說:對人而言「讀萬卷書,行萬里路」「見多識廣」,對AI模型這些話也成立嗎?

實驗設置

訓練數據

為了評估視覺-語言模型在大規模圖像-文本數據上的表現,新研究構建了一個包含1000億對圖像-文本的數據集,稱為WebLI-100B。

從1000億數據集中分別隨機抽取1%和10%的樣本,創建了分別代表1億和10億樣本的子集,分別稱為WebLI-1B和WebLI-10B。

在此研究中,僅應用了必要的數據過濾,如去除有害圖像和個人身份信息。這種方法確保數據集保持盡可能多語言和多樣化。使用與每張圖像關聯的alt文本和頁面標題作為配對文本。

為了確保公平評估,從數據集中去除了90多個常見視覺-語言任務中的近重復圖像。

為了研究數據擴展對質量過濾數據的影響,采用常見方法,使用 CLIP-L/14 模型作為過濾器,保留一個包含50億對圖像和英文替代文本的高質量數據集。

論文鏈接:https://arxiv.org/abs/2103.00020

為了進一步鞏固研究結果,研究人員在網絡數據上訓練了一個VLM,用于對齊或不對齊圖像-文本對分類,并調整其閾值,以重新訓練另一個大小相同的過濾數據集。

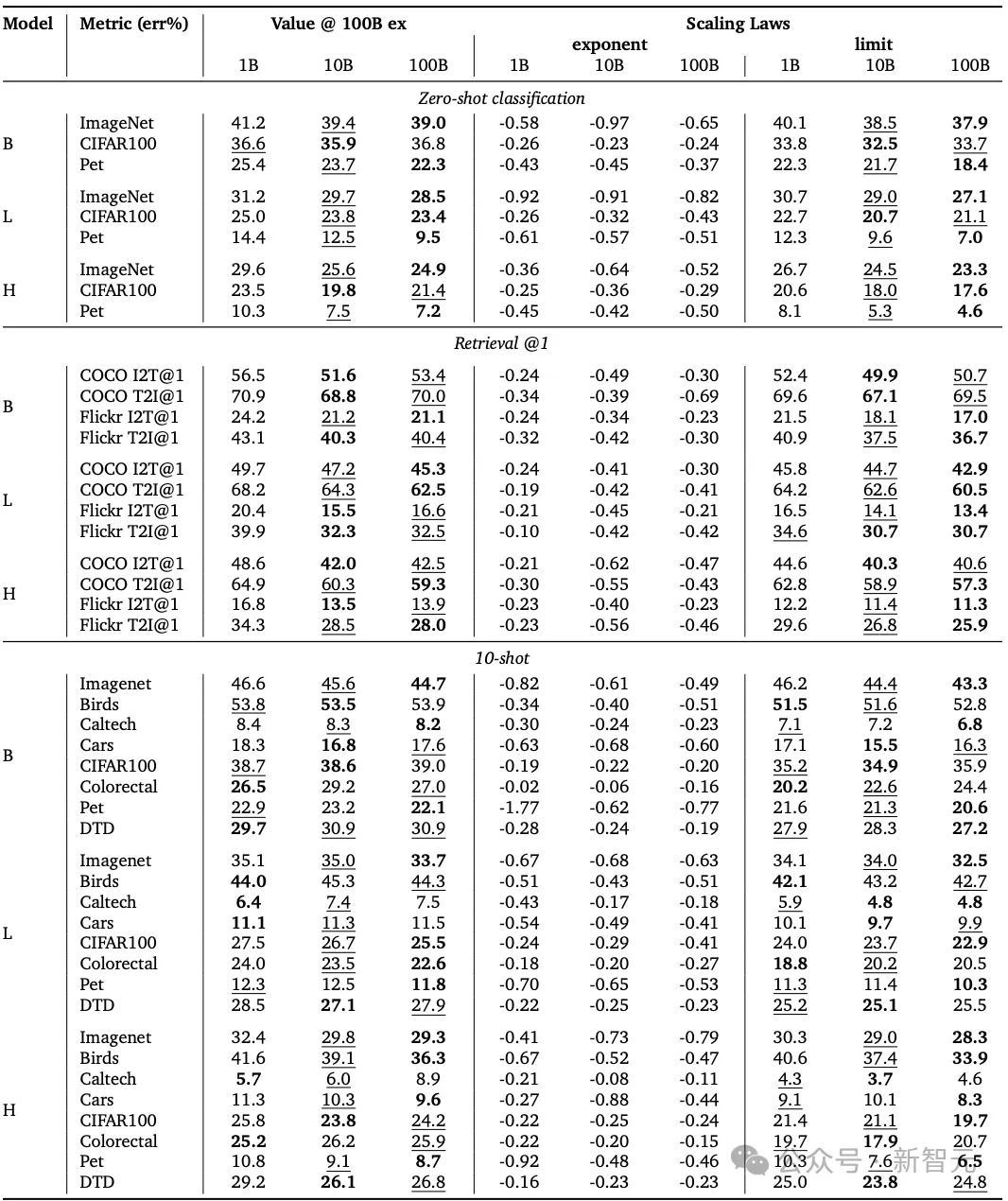

對比視覺-語言預訓練

為了研究數據規模對模型性能的影響,使用三種不同的數據集大小(10億、100億和1000億)訓練了SigLIP模型,見表2中1B,10B, 100B對應的數據列。

還通過使用ViT-B/16、ViT-L/16和ViT-H/14架構來調整模型大小,分別用于圖像和文本編碼器,見表2中B、L以及H對應的數據行。

在大型、嘈雜的網絡數據集上,對比學習已成為獲取強大視覺表示的主導方法,這種弱監督范式超越了傳統的監督學習方法。

這里采用SigLIP對比學習方法。

與標準的對比學習方法不同,Sigmoid損失僅在圖像-文本對上操作。

同時允許批量大小的進一步擴展,而且在批量較小時也表現得更好。

論文鏈接:https://arxiv.org/abs/2303.15343

在對比訓練過程中,其他設置如下:

批量大小:32K;

學習率:逆平方根調度;

預熱和冷卻階段數據量:2億;

學習率:0.001

權重衰減:0.0001。

在預處理階段,圖像被調整為224x224像素的分辨率,文本則使用多語言mt5分詞器進行分詞,最大序列長度為64個tokens。

所有模型的訓練最大示例數為1000億。

在多個訓練步驟后冷卻模型,并評估它們在冷卻后的表現。所有模型在計算資源匹配的條件下進行比較。

通過這種方法,能夠評估不同數據規模和模型規模對SigLIP模型性能的影響,并探討如何根據數據規模調整訓練過程以實現最優的性能。

測試結果

流行的基準測試結果

第一組評估使用了多樣且廣泛認可的基準測試,主要從上到下分為3類任務:

- 表2頂部表示零樣本分類(zero-shot classification部分),使用ImageNet、CIFAR-100和Oxford-IIIT Pet數據集。

- 表2中間部分表示零樣本檢索(retirval@1部分),使用COCO Captions和Flickr30k數據集,包括圖像到文本檢索和文本到圖像檢索。

- 表2底部表示10-shot評估(10-shot部分),使用了Caltech-UCSD Birds、Caltech 101、Cars196、Colorectal Histology和Describable Textures Dataset (DTD)基準測試來評估視覺模型的表示能力。

如表2所示,將數據集的規模從100億增加到1000億個樣本并未顯著提升性能,通過Wilcoxon符號秩檢驗,該檢驗的??值為0.9,表明差異不具有統計顯著性。

此外,針對模型和數據集的不同組合,擬合了數據Scaling Law,從而評估在無限計算資源的情況下,性能差距是否會增加或減少。在表2中報告了結果中的擴展指數和漸近性能極限。同樣,在95%的置信水平下,沒有觀察到顯著差異(??值為0.09)。

下圖中,帶下劃線表示結果較差,而加粗的表示評估結果較好,可以看到1000億(下圖100B)的訓練數據并不總會帶來最佳結果,而且普遍提升的效果有限。

表2:從10B到100B的訓練樣本擴展,收益有限。

在ImageNet和CoCo檢索中出現了收益遞減現象,與縮放定律保持一致。

但這些基準測試的評估,主要反映的是西方(特別是英語國家)的語言文化。

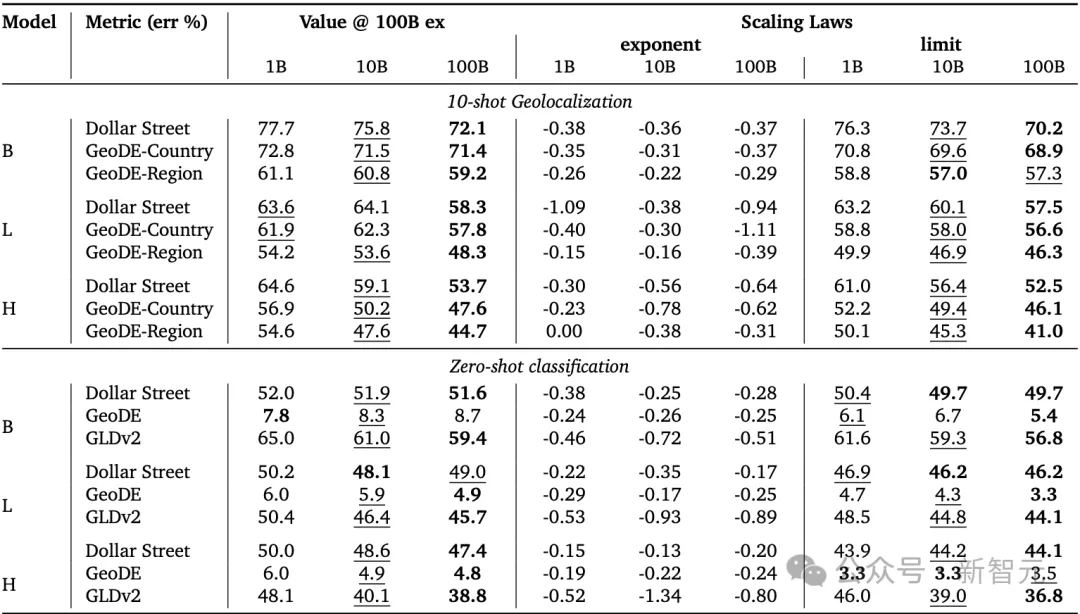

文化多樣性測評結果

近期的研究表明,為了提升視覺-語言模型性能而采用的流行技術,如基于英語語言的篩選,可能會無意中削弱文化理解。因此,研究人員這次也對文化多樣性進行了評估,這些評估分為兩類:

第一類:地理定位,涉及通過少量樣本分類預測圖像的來源國或地區。

第二類:在從不同地理區域策劃的數據集上進行zero-shot分類,包括Dollar Street、GeoDE和Google Landmarks Dataset v2 (GLDv2)。

其中Dollar Street包含來自63個國家的38K張家庭物品圖像。GeoDE包含來自不同地理位置的62K張手動標注圖像。最后,GLDv2包含來自84個國家的1,542張圖像,代表884個地標,用于評估模型在識別具有文化重要性的地點方面的表現。

與以西方為導向的測試標準不同,文化多樣性呈現出完全不同的結果。

新研究發現,當數據集的規模從100億擴展到1000億時,文化多樣性任務的表現有顯著提升。

如表3所示,將訓練數據從100億擴展到1000億個樣本,在Dollar Street的10-shot分類任務中,ViT-L和ViT-H的絕對提升分別為5.8%和5.4%,遠超在以西方為導向的10-shot度量標準上通常觀察到的不到1%的改善。

使用Wilcoxon符號秩檢驗,得到??值為0.002,表明在99%的置信水平下,這一差異具有統計學顯著性。

表3 | 文化多樣性基準的評估和擴展規律,其中從100億到1000億個樣本的擴展顯示出更大的優勢。

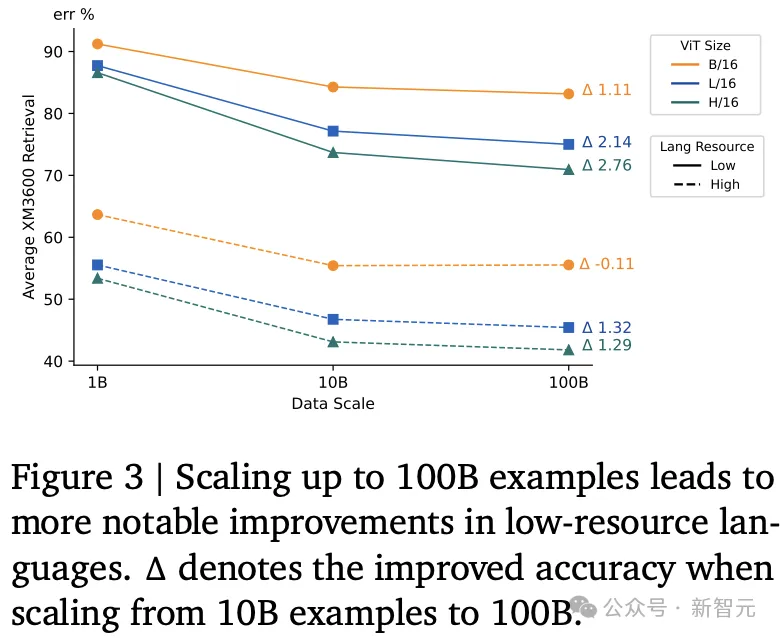

多語言性

使用Crossmodal-3600數據評估模型的多語言能力,該數據集包含來自36種語言的3600張具有人工生成標題的地理多樣化圖像。

下圖3展示了性能提升的差異:低資源語言在1000億規模下比高資源語言受益更多。這種差異不論模型參數規模大小都存在,而且隨著模型規模的增大,差距逐漸加大。

每種語言的詳細結果,可以參考下表8。

實驗分析

質量過濾器的影響

盡管這些過濾器在傳統任務中通常有益,但它們通過減少某些文化背景的表現,可能會對數據多樣性產生負面影響。

原始網絡數據通常噪聲過大,難以有效訓練視覺-語言模型。為了解決這一問題,常見的一種策略是使用數據過濾模型,去除不太相關的圖像-文本對。

在新研究中,在下列三個數據集上訓練了ViT-L模型:

- 利用CLIP-L/14模型對原始數據進行過濾,并重新訓練了50億個高質量的英文圖像-文本對。

- 為了進行對比,還在原始網絡數據上訓練了一個分類模型,得到了一個大小相同的過濾數據集。

- 此外,還從原始數據中抽取了一個相同大小的英文子集,作為基準。

CLIP過濾器在以西方為中心的任務中表現出色,這與數據驅動的研究一致,表明有效的數據過濾能夠提升模型性能。

然而,所有經過過濾的數據集在其他任務中表現較差,尤其是在涉及文化多樣性的任務中。

這是數據過濾的一個主要缺點,即它可能無意中將偏見引入過濾后的數據集,這與先前的研究結果一致。

數據質量過濾可能會妨礙文化多樣性(圖4中)和公平性(圖4右),即使它在以西方為中心的任務(圖4左)中有所幫助,具體結果如下:

圖4:數據質量過濾對不同任務的影響

語言再平衡

在原始數據中,低資源語言的比例僅為0.5%,這導致模型無法充分學習這些語言或地區中的概念。

為了解決這個問題,將每種低資源語言的樣本量上采樣到固定的1%比例。

通過這種再平衡,如圖5所示,模型在低資源語言基準上的表現有所提升。相應地,高資源語言的表現略有下降,但仍然保持在可比范圍內(這也適用于其他僅基于英文的zero-shot檢索任務),從而在整個多語言基準上實現了總體的提升。

此外,還觀察到,在文化多樣性任務中有輕微的改善,而在其他任務中結果略有下降,這可能是由于減少了以西方為中心的示例所致,因為大多數評估都基于英文數據。

具體結果見圖5。

圖5:語言再平衡的結果

定性示例

通常,經過更大規模數據訓練的模型,會更加專注于語義相關的區域。

例如,在「伊戈洛舞蹈」(Igorot Dance)圖像中,100B訓練的模型能夠捕捉到更精細的細節,如傳統裝飾品上的復雜圖案和具有文化意義的物品。

在「冰屋」(Igloo)圖像中,100B訓練的模型準確地聚焦于冰屋的結構細節(其圓頂形狀),與其他模型不同,后者被背景中的山脈和冰雪等元素分散了注意力。

除了低資源概念,100B數據還可以提高常見概念的性能。如「野牛」(Bison)圖像所示,經過更大數據集訓練的模型能夠更準確地捕捉到野牛,而不是周圍的景觀。

不同數據規模下,訓練的 ViT-L/16 模型的注意力圖可視化區域比較。

作者簡介

另外值得一提的是,共一華人作者Xiao Wang。

2008年,他本科畢業于南京大學計算機軟件工程專業;2011年,碩士畢業于北京大學計算機軟件工程專業。

在國內積累了5年經驗后,于2015年加入谷歌DeepMind,任高級軟件工程師。