譯者 | 朱先忠

審校 | 重樓

引言

多年來,基于Transformer的大型語言模型(LLM)在從簡單的信息檢索系統(tǒng)到能夠進(jìn)行編碼、寫作、開展研究的復(fù)雜智能體等一系列任務(wù)上取得了長足的進(jìn)步。然而,盡管這些模型功能強(qiáng)大,但它們在很大程度上仍然是黑匣子。給定輸入,它們可以完成任務(wù),但我們?nèi)狈χ庇^的方法來理解任務(wù)的具體完成方式。

LLM旨在預(yù)測統(tǒng)計(jì)上最佳的下一個(gè)單詞/標(biāo)記。但是,它們是否只專注于預(yù)測下一個(gè)標(biāo)記,還是會提前規(guī)劃?例如,當(dāng)我們要求模型寫一首詩時(shí),它是一次生成一個(gè)單詞,還是在輸出單詞之前預(yù)測押韻模式?或者,當(dāng)我們被問及一些基本的推理問題,例如達(dá)拉斯所在的州首府是什么?它們通常會產(chǎn)生看起來像是一連串推理的結(jié)果,但模型真的運(yùn)用了這些推理嗎?我們無法洞察模型的內(nèi)部思維過程。要理解LLM,我們需要追溯其底層邏輯。

對大型語言模型(LLM)內(nèi)部計(jì)算的研究屬于“機(jī)械可解釋性”領(lǐng)域,旨在揭示模型的計(jì)算回路。Anthropic是致力于可解釋性研究的領(lǐng)先人工智能公司之一。2025年3月,他們發(fā)表了一篇題為《回路追蹤:揭示語言模型中的計(jì)算圖》的論文,旨在解決回路追蹤問題。

本文旨在解釋他們的論文工作背后的核心思想,并為理解LLM中的回路追蹤奠定基礎(chǔ)。

LLM中的回路是什么?

在定義語言模型中的“回路”之前,我們首先需要了解LLM的內(nèi)部結(jié)構(gòu)。它是一個(gè)基于Transformer架構(gòu)的神經(jīng)網(wǎng)絡(luò);因此,將神經(jīng)元視為基本計(jì)算單元,并將其跨層激活模式解釋為模型的計(jì)算回路,這似乎是顯而易見的。

然而,論文《邁向單義性》表明,僅僅追蹤神經(jīng)元的激活并不能清楚地理解這些神經(jīng)元被激活的原因。這是因?yàn)閱蝹€(gè)神經(jīng)元通常是多義的,它們會對一系列不相關(guān)的概念做出反應(yīng)。

此論文進(jìn)一步表明,神經(jīng)元由更基本的單元(稱為特征)組成,這些單元能夠捕獲更多可解釋的信息。事實(shí)上,一個(gè)神經(jīng)元可以被看作是多個(gè)特征的組合。因此,我們的目標(biāo)是追蹤特征激活,而不是追蹤神經(jīng)元激活,也就是驅(qū)動(dòng)模型輸出的實(shí)際意義單元。

這樣,我們可以將回路定義為模型用來將給定輸入轉(zhuǎn)換為輸出的特征激活和連接序列。

現(xiàn)在,我們知道了我們在尋找什么。接下來,讓我們更深入地了解一下基于Transformer的大型語言模型的基本架構(gòu)。

技術(shù)架構(gòu)

目前,我們已經(jīng)確定需要追蹤特征激活而不是神經(jīng)元激活。為了實(shí)現(xiàn)這一點(diǎn),我們需要將現(xiàn)有LLM模型的神經(jīng)元轉(zhuǎn)換為特征,即構(gòu)建一個(gè)以特征形式表示計(jì)算的替代模型。

在深入探討這個(gè)替代模型是如何構(gòu)建的之前,我們先簡單回顧一下基于Transformer的大型語言模型的架構(gòu)。

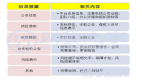

下圖展示了基于Transformer的語言模型的運(yùn)作方式。其思路是,使用嵌入將輸入轉(zhuǎn)換為標(biāo)記(token)。這些標(biāo)記被傳遞到注意力模塊,該模塊計(jì)算標(biāo)記之間的關(guān)系。然后,每個(gè)標(biāo)記被傳遞到多層感知器(MLP)模塊,該模塊使用非線性激活函數(shù)和線性變換進(jìn)一步細(xì)化標(biāo)記。在模型生成最終輸出之前,此過程會在多層中重復(fù)進(jìn)行。

本圖片由作者本人繪制

既然我們已經(jīng)闡述了基于Transformer的LLM的結(jié)構(gòu),接下來我們來看看什么是轉(zhuǎn)碼器。作者使用了一個(gè)“轉(zhuǎn)碼器”來開發(fā)替換模型。

轉(zhuǎn)碼器

轉(zhuǎn)碼器本身是一種神經(jīng)網(wǎng)絡(luò)(通常比LLM的維度高得多),旨在用更易于解釋、功能等效的組件(特征)替換轉(zhuǎn)換器模型中的MLP塊。

本圖片由作者本人繪制

它分三個(gè)階段處理來自注意力模塊的標(biāo)記:編碼、稀疏激活和解碼。實(shí)際上,它將輸入縮放到更高維空間,應(yīng)用激活以強(qiáng)制模型僅激活稀疏特征,然后在解碼階段將輸出壓縮回原始維度。

本圖片由作者本人繪制

在對基于轉(zhuǎn)換器的LLM和轉(zhuǎn)碼器有了個(gè)基本了解之后,讓我們看看如何使用轉(zhuǎn)碼器來構(gòu)建替換模型。

構(gòu)建替代模型

如前所述,Transformer模塊通常由兩個(gè)主要組件組成:注意力模塊和MLP模塊(前饋網(wǎng)絡(luò))。為了構(gòu)建替換模型,需要將原始Transformer模型中的MLP模塊替換為轉(zhuǎn)碼器。這種集成是無縫的,因?yàn)檗D(zhuǎn)碼器經(jīng)過訓(xùn)練可以模擬原始MLP的輸出,同時(shí)通過稀疏和模塊化特征公開其內(nèi)部計(jì)算。

雖然標(biāo)準(zhǔn)轉(zhuǎn)碼器在單個(gè)Transformer層中訓(xùn)練以模仿MLP行為,但本文作者使用了跨層轉(zhuǎn)碼器(CLT),它可以捕獲跨多個(gè)層級的多個(gè)轉(zhuǎn)碼器塊的組合效應(yīng)。這一點(diǎn)非常重要,因?yàn)樗刮覀兡軌蜃粉櫮硞€(gè)特征是否分布在多個(gè)層級上,而這對于回路追蹤至關(guān)重要。

下圖展示了如何使用跨層轉(zhuǎn)碼器(CLT)構(gòu)建替換模型。第一層的轉(zhuǎn)碼器輸出有助于構(gòu)建所有上層模型的MLP等效輸出,直至最后。

本圖片由作者本人繪制

提示:下圖來自本文開始處的論文,展示了如何構(gòu)建替換模型。它是利用特征替換原始模型的神經(jīng)元。

本圖片的出處是這里

現(xiàn)在,我們了解了替換模型的架構(gòu)。接下來,讓我們看看如何在替換模型的計(jì)算路徑上構(gòu)建可解釋的表示。

模型計(jì)算的可解釋呈現(xiàn):歸因圖

為了構(gòu)建模型計(jì)算路徑的可解釋表示,我們從模型的輸出特征出發(fā),逆向追溯特征網(wǎng)絡(luò),以發(fā)現(xiàn)哪個(gè)先前的特征對其做出了貢獻(xiàn)。這通過后向雅可比矩陣來實(shí)現(xiàn),該矩陣可以計(jì)算前一層的特征對當(dāng)前特征激活的貢獻(xiàn)程度,并遞歸應(yīng)用直至到達(dá)輸入。每個(gè)特征被視為一個(gè)節(jié)點(diǎn),每個(gè)影響因素被視為一條邊。此過程可能生成包含數(shù)百萬條邊和節(jié)點(diǎn)的復(fù)雜圖,因此需要進(jìn)行剪枝以保持圖的緊湊性和手動(dòng)可解釋性。

作者將此計(jì)算圖稱為歸因圖,并開發(fā)了檢查它的工具,這成為了本文的核心貢獻(xiàn)。

下圖展示了一個(gè)示例歸因圖。

本圖片的出處是這里

現(xiàn)在,有了所有這些理解,我們就可以討論特征可解釋性了。

使用歸因圖實(shí)現(xiàn)特征可解釋性

研究人員使用Anthropic公司的Claude 3.5Haiku模型的歸因圖來研究其在不同任務(wù)中的表現(xiàn)。在詩歌生成中,他們發(fā)現(xiàn)該模型不僅僅是生成下一個(gè)詞,它還會進(jìn)行一種規(guī)劃,既向前規(guī)劃,又向后規(guī)劃。在生成一行詩之前,該模型會識別幾個(gè)可能押韻或語義合適的詞作為結(jié)尾,然后向后推演,生成一行自然地指向該目標(biāo)的詩句。令人驚訝的是,該模型似乎可以同時(shí)記住多個(gè)候選結(jié)尾詞,并根據(jù)最終選擇的詞重構(gòu)整個(gè)句子。

這項(xiàng)技術(shù)提供了一個(gè)清晰的、機(jī)制化的視角,展現(xiàn)了語言模型如何生成結(jié)構(gòu)化、富有創(chuàng)意的文本。這對于人工智能界來說是一個(gè)重要的里程碑。隨著我們開發(fā)出越來越強(qiáng)大的模型,追蹤和理解其內(nèi)部規(guī)劃和執(zhí)行的能力對于確保人工智能系統(tǒng)的一致性、安全性和可信度至關(guān)重要。

當(dāng)前方法的局限性

歸因圖提供了一種追蹤單個(gè)輸入模型行為的方法,但它們尚無法提供可靠的方法來理解全局回路或模型在多個(gè)示例中使用的一致機(jī)制。這種分析依賴于用轉(zhuǎn)碼器替換多層感知器(MLP)計(jì)算,但目前尚不清楚這些轉(zhuǎn)碼器是真正復(fù)制了原始機(jī)制,還是僅僅近似輸出。此外,當(dāng)前方法僅強(qiáng)調(diào)活躍特征,但非活躍或抑制性特征對于理解模型行為同樣重要。

結(jié)論

總之,通過歸因圖進(jìn)行回路追蹤是理解語言模型內(nèi)部工作原理的早期的但非常重要的一步。雖然這種方法還有很長的路要走,但回路追蹤的引入標(biāo)志著通往真正可解釋性道路上的一個(gè)重要里程碑。

參考文獻(xiàn)

- https://transformer-circuits.pub/2025/attribution-graphs/methods.html

- https://arxiv.org/pdf/2406.11944

- https://transformer-circuits.pub/2025/attribution-graphs/biology.html

- https://transformer-circuits.pub/2024/crosscoders/index.html

- https://transformer-circuits.pub/2023/monosemantic-features

譯者介紹

朱先忠,51CTO社區(qū)編輯,51CTO專家博客、講師,濰坊一所高校計(jì)算機(jī)教師,自由編程界老兵一枚。

原文標(biāo)題:Circuit Tracing: A Step Closer to Understanding Large Language Models,作者:Sudheer Singh