小伙在公司用了個 insert into select 居然被開除了

兄弟們,上周四凌晨三點,手機瘋狂震動,打開工作群一看,運維總監發了條消息:"緊急!支付系統大面積失敗,所有訂單初始化超時!" 我瞬間清醒,光著腳沖進書房打開電腦。

登錄服務器一看,數據庫連接池已經爆了,慢查詢日志里密密麻麻全是 INSERT INTO ... SELECT 語句。順著代碼回溯,發現是新來的實習生小王寫的定時任務。這哥們兒為了圖省事,直接用 insert into select 遷移支付流水表,結果把整個數據庫鎖死了。第二天早上,HR 找他談話,下午他就背著電腦包離開了公司。

這個故事告訴我們:數據庫操作一時爽,鎖表火葬場。今天咱們就來聊聊這個讓小王丟了飯碗的 insert into select,看看它到底有什么魔力,能讓程序員分分鐘變成 "背鍋俠"。

一、insert into select 到底干了什么?

1. 看似優雅的 SQL 背后

insert into select 語法看起來很美好:一行代碼搞定數據遷移,不用寫循環,不用處理網絡 IO,直接讓數據庫自己干活。但在 MySQL 里,這貨的真實面目其實是個 "鎖表狂魔"。

舉個栗子:假設你有一張 order_today 表,每天新增 30 萬條數據,現在需要把舊數據遷移到 order_record。小王寫的 SQL 是這樣的:

INSERT INTO order_record (order_id, amount, status)

SELECT order_id, amount, status FROM order_today

WHERE pay_time < '2023-01-01';看起來沒毛病對吧?但實際執行的時候,MySQL 會對 order_today 表進行全表掃描,并且逐條加鎖。如果這張表有 700 萬條數據,那數據庫就像被綁了手腳的武林高手,只能慢慢爬。

2. 鎖表的連環暴擊

在默認的 RR(可重復讀)隔離級別下,insert into select 會觸發兩種鎖:

- 表鎖:對目標表(order_record)加 IX 鎖,阻止其他事務對表結構的修改。

- 行鎖 + 間隙鎖:對源表(order_today)掃描到的每一行加 S 鎖,并且鎖住行之間的間隙。這就像在高速公路上設置了無數個收費站,后面的車輛(其他事務)只能排隊等待。

更坑爹的是,如果源表沒有合適的索引,全表掃描會導致鎖表時間長達幾十分鐘。這期間,任何對 order_today 的寫操作都會被阻塞,比如用戶支付時更新訂單狀態,就會直接超時失敗。

二、為什么測試環境沒出問題?

小王在測試的時候,用 1000 條數據模擬了遷移過程,一切正常。但到了生產環境,700 萬條數據直接把數據庫干趴下了。這是因為:

- 數據量差異:測試環境的數據量太小,鎖表時間短,問題被掩蓋了。

- 業務壓力不同:生產環境的并發請求量遠高于測試,鎖沖突更容易爆發。

- 隔離級別差異:有些測試環境可能使用 RC(讀已提交)隔離級別,鎖機制不同,導致問題不重現。

就像你在健身房舉 5 公斤啞鈴沒問題,但突然換成 50 公斤,肯定會閃到腰。數據庫也一樣,沒有金剛鉆,別攬瓷器活。

三、數據庫的鎖機制:程序員的墳場

1. 鎖的類型:從表鎖到行鎖的千層套路

- 表鎖:簡單粗暴,直接鎖整個表,性能最差。

- 行鎖:只鎖需要的行,但在 RR 隔離級別下,可能升級為間隙鎖。

- 間隙鎖(Gap Lock):鎖住兩個行之間的間隙,防止幻讀。比如表中有 id=1 和 id=3 的記錄,間隙鎖會鎖住(1,3)這個區間,阻止插入 id=2 的記錄。

- Next-Key 鎖:行鎖 + 間隙鎖的組合,是 MySQL 在 RR 隔離級別下的默認鎖策略。

舉個栗子:如果表中有 id=1、3、5 三條記錄,執行 SELECT * FROM table WHERE id > 2 FOR UPDATE,MySQL 會鎖住(2,3]、(3,5]、(5, +∞)這三個區間,防止其他事務插入 id=4 或 6 的記錄。

2. 事務隔離級別的坑

MySQL 默認使用 RR 隔離級別,這本來是為了保證可重復讀,但也帶來了鎖表的副作用。如果換成 RC 隔離級別,雖然鎖沖突會減少,但可能引發不可重復讀的問題。比如,在一個事務中兩次查詢同一條記錄,結果可能不同,因為中間被其他事務修改了。

這就像在電影院看電影,RR 隔離級別是給你單獨開了個包間,其他人不能進來;而 RC 隔離級別是大家坐在一起,可能有人中途換座位,導致你看到的畫面不一樣。

四、如何優雅地遷移數據?

1. 索引優化:給數據庫裝個 GPS

最直接的解決辦法是給 WHERE 條件字段加索引。比如在 order_today.pay_time 上創建索引,這樣 SELECT 語句就不會全表掃描,鎖的范圍也會大大縮小。

ALTER TABLE order_today ADD INDEX idx_pay_time (pay_time);加了索引后,MySQL 就像有了 GPS,能直接定位到需要遷移的數據,而不是在整個數據庫里瞎轉悠。

2. 分批次遷移:螞蟻搬家更安全

如果數據量太大,即使有索引,一次性遷移還是可能導致鎖表。這時候可以分批處理,每次遷移 1 萬條數據,中間提交事務釋放鎖。

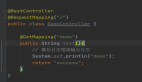

// Java 代碼示例

int batchSize = 10000;

LocalDateTime startTime = LocalDateTime.of(2023, 1, 1, 0, 0);

while (true) {

List<Order> orders = orderDao.queryByPayTime(startTime, batchSize);

if (orders.isEmpty()) {

break;

}

orderDao.batchInsert(orders);

startTime = orders.get(orders.size() - 1).getPayTime().plusSeconds(1);

}這種方法就像螞蟻搬家,雖然慢一點,但不會把數據庫壓垮。

3. 使用 MyBatis 的批量插入

MyBatis 提供了多種批量插入策略,比如 ExecutorType.BATCH,可以顯著減少數據庫交互次數。

SqlSession session = sqlSessionFactory.openSession(ExecutorType.BATCH);

OrderMapper mapper = session.getMapper(OrderMapper.class);

for (Order order : orders) {

mapper.insert(order);

}

session.commit();

session.close();這種方法比逐條插入快得多,但要注意內存占用,避免 OOM。

4. 存儲過程:讓數據庫自己干活

如果遷移邏輯復雜,可以考慮使用存儲過程。存儲過程在數據庫服務器上執行,減少網絡傳輸,同時可以利用事務控制鎖的范圍。

DELIMITER //

CREATE PROCEDURE migrate_orders()

BEGIN

DECLARE done INT DEFAULT FALSE;

DECLARE order_id BIGINT;

DECLARE cur CURSOR FOR SELECT id FROM order_today WHERE pay_time < '2023-01-01';

DECLARE CONTINUE HANDLER FOR NOT FOUND SET done = TRUE;

OPEN cur;

REPEAT

FETCH cur INTO order_id;

IF NOT done THEN

INSERT INTO order_record (order_id, amount, status)

SELECT order_id, amount, status FROM order_today WHERE id = order_id;

END IF;

UNTIL done END REPEAT;

CLOSE cur;

END //

DELIMITER ;存儲過程就像給數據庫寫了個 "腳本",讓它自己按步驟執行,減少對應用服務器的壓力。

五、最佳實踐:避免踩坑的十條軍規

- 永遠不要在生產環境直接執行未經測試的 SQL:尤其是 INSERT INTO ... SELECT 這種危險操作。

- 給 WHERE 條件字段加索引:避免全表掃描和鎖表。

- 分批次處理大數據量:每次處理 1 萬條左右,提交事務釋放鎖。

- 監控慢查詢日志:及時發現執行時間過長的 SQL。

- 使用事務控制鎖的范圍:避免長時間持有鎖。

- 在測試環境模擬生產數據量:不要用小數據量測試來欺騙自己。

- 了解數據庫的鎖機制:尤其是 RR 隔離級別的 Next-Key 鎖。

- 優先使用批量插入工具:如 MyBatis 的批量插入、Spring Batch 等。

- 設置合理的超時時間:防止事務長時間阻塞。

- 做好回滾預案:萬一出問題,能快速恢復數據。

六、總結:數據庫操作的生死線

小王的故事告訴我們,數據庫操作是把雙刃劍,用好了能提高效率,用不好就是 "自殺式攻擊"。insert into select 本身并沒有錯,但在不恰當的場景下使用,就會變成 "程序員的墳場"。

作為開發者,我們需要敬畏數據庫,了解它的脾氣和底線。每次寫 SQL 的時候,都要想想:"這行代碼會不會鎖表?有沒有更好的方法?" 只有這樣,才能避免成為下一個被開除的 "小王"。