天大、南大發(fā)布LPSNet:無(wú)透鏡成像下的人體三維姿態(tài)與形狀估計(jì) | CVPR 2024

通過(guò)無(wú)透鏡成像實(shí)現(xiàn)3D人體姿態(tài)和形狀估計(jì)不僅有利于保護(hù)隱私,而且由于設(shè)備體積小、結(jié)構(gòu)簡(jiǎn)單,可用于軍事等隱秘監(jiān)測(cè)場(chǎng)景。

然而,無(wú)透鏡系統(tǒng)的成像結(jié)果經(jīng)過(guò)了特殊的光學(xué)編碼,目前的圖像恢復(fù)方法無(wú)法得到高質(zhì)量的圖像,因此無(wú)法通過(guò)先恢復(fù)圖像再重建人體的方式來(lái)實(shí)現(xiàn)。

針對(duì)以上問(wèn)題,天津大學(xué)團(tuán)隊(duì)聯(lián)合南京大學(xué)在CVPR 2024的工作中提出了端到端的無(wú)透鏡成像下的人體三維重建框架LPSNet。

代碼:????https://github.com/xiaonan12138/LPSNet?????項(xiàng)目主頁(yè):????https://cic.tju.edu.cn/faculty/likun/projects/LPSNet????

由于無(wú)透鏡成像數(shù)據(jù)結(jié)果經(jīng)過(guò)了特殊的光學(xué)編碼,現(xiàn)有的方法無(wú)法直接從無(wú)透鏡系統(tǒng)的成像結(jié)果中提取有效的特征。

為了直接從無(wú)透鏡成像數(shù)據(jù)中提取有效的特征,作者設(shè)計(jì)了多尺度無(wú)透鏡特征解碼器。

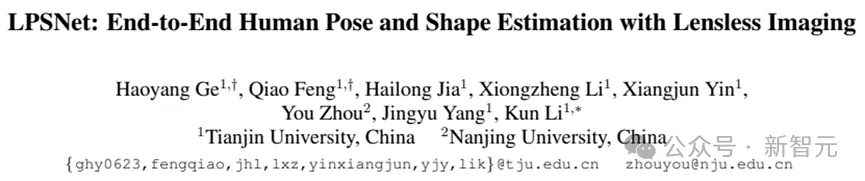

除此之外,為了提高人體姿態(tài)估計(jì)的準(zhǔn)確度,作者加入了雙頭輔助監(jiān)督機(jī)制。最后,作者通過(guò)實(shí)驗(yàn)驗(yàn)證了LPSNet可以通過(guò)無(wú)透鏡成像系統(tǒng)完成3D人體姿態(tài)和形狀估計(jì)。圖一展示了部分實(shí)驗(yàn)結(jié)果。

圖1 第一行:無(wú)透鏡成像數(shù)據(jù)(右下角小圖為對(duì)應(yīng)場(chǎng)景的RGB圖像,僅供參考),作為L(zhǎng)PSNet的輸入;第二行:通過(guò)LPSNet得到的3D人體姿態(tài)和形狀,與對(duì)應(yīng)場(chǎng)景圖像的對(duì)齊結(jié)果展示;第三行:不同視角3D結(jié)果展示

方法動(dòng)機(jī)

近年來(lái),無(wú)透鏡成像因其隱私保護(hù)強(qiáng)、體積小、結(jié)構(gòu)簡(jiǎn)單、成本低等諸多優(yōu)點(diǎn),取得了顯著進(jìn)步。隨著應(yīng)用場(chǎng)景的多樣化,人體姿態(tài)估計(jì)需要更加小型化和輕量化的成像設(shè)備。

無(wú)透鏡成像系統(tǒng)正好可以滿(mǎn)足這些優(yōu)點(diǎn),特別在隱私保護(hù)方面。在本文中,作者提出了LPSNet,其目的是通過(guò)無(wú)透鏡成像系統(tǒng)采集的數(shù)據(jù)(lensless measurement)來(lái)估計(jì)3D人體姿態(tài)和形狀,從而實(shí)現(xiàn)低成本且具有隱私保護(hù)屬性的3D人體姿態(tài)與形狀估計(jì)。

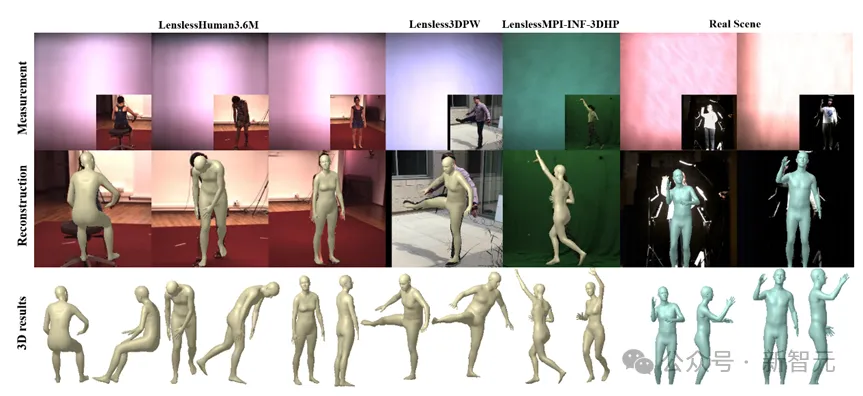

圖2 無(wú)透鏡人體姿態(tài)與形狀估計(jì)方案

不同于傳統(tǒng)相機(jī),無(wú)透鏡成像系統(tǒng)將傳統(tǒng)相機(jī)中的鏡頭替換成一種輕薄且低成本的光學(xué)編碼器。由于無(wú)透鏡成像系統(tǒng)特殊的光學(xué)編碼方法,可以從無(wú)透鏡測(cè)量中獲得更多有價(jià)值的信息。

現(xiàn)階段,無(wú)透鏡成像系統(tǒng)的應(yīng)用十分廣泛,主要應(yīng)用于顯微成像、RGB圖像重建等領(lǐng)域。目前還沒(méi)有方法可以直接通過(guò)無(wú)透鏡成像系統(tǒng)估計(jì)3D人體姿態(tài)與形狀。

一種直接的方法是通過(guò)兩階段的方式完成:如圖2示,首先從無(wú)透鏡成像數(shù)據(jù)中重建RGB圖像,然后從RGB圖像中估計(jì)人體三維姿態(tài)和形狀。

然而圖2實(shí)驗(yàn)結(jié)果表明,重建的RGB圖像質(zhì)量不理想,導(dǎo)致局部特征不完整,人體位置偏差明顯。當(dāng)使用無(wú)透鏡成像數(shù)據(jù)來(lái)重建RGB圖像時(shí),結(jié)合這些因素會(huì)導(dǎo)致不準(zhǔn)確的人體姿態(tài)估計(jì)。同時(shí),使用這種方法需要消耗大量的計(jì)算資源,非常不適合在終端部署。

在這篇論文中,作者的目標(biāo)是使用無(wú)透鏡成像系統(tǒng)來(lái)完成端到端的3D人體姿態(tài)和形狀估計(jì),這需要克服兩個(gè)主要挑戰(zhàn):

1. 如何有效的從無(wú)透鏡成像數(shù)據(jù)中提取特征用于人體姿態(tài)和形狀估計(jì)

- 作者在初期進(jìn)行的無(wú)透鏡人體姿態(tài)估計(jì)嘗試中發(fā)現(xiàn),當(dāng)從無(wú)透鏡成像數(shù)據(jù)中提取特征估計(jì)3D人體姿態(tài)和形狀時(shí),人體四肢的估計(jì)精度很差。

為了解決這些挑戰(zhàn),作者提出了LPSNet,這是第一個(gè)基于無(wú)透鏡成像系統(tǒng)的端到端的人體姿態(tài)和形狀估計(jì)框架。

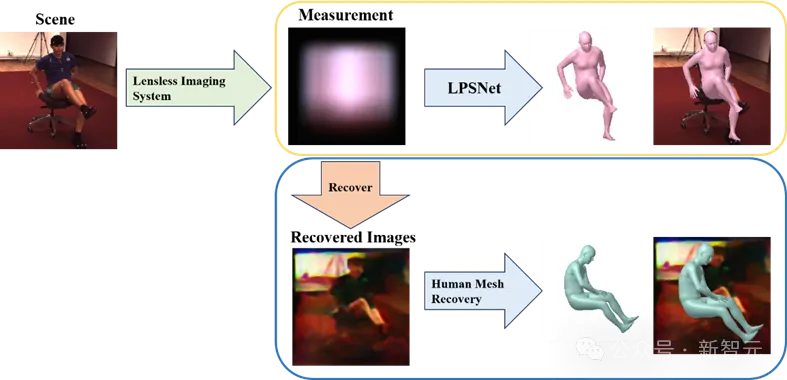

圖3 LPSNet框架總覽

方法思路LPSNet框架總覽LPSNet工作的重點(diǎn)是通過(guò)無(wú)透鏡成像數(shù)據(jù)來(lái)估計(jì)3D人體姿態(tài)和形狀。LPSNet的基本框架如圖3所示,該方法的核心包括以下三個(gè)部分:

1. 作者提出了一個(gè)多尺度無(wú)透鏡特征解碼器(MSFDecoder)它可以有效地解碼由無(wú)透鏡成像系統(tǒng)光學(xué)編碼的信息;

2. 將MSFDecoder輸出的多尺度特征送入人體參數(shù)化模型回歸器中,通過(guò)回歸器估計(jì)人姿態(tài)和形狀參數(shù);

3. 作者還提出了一個(gè)雙頭輔助監(jiān)督機(jī)制(DHAS)可以幫助LPSNet提高人體肢體末端的估計(jì)精度。多尺度無(wú)透鏡特征解碼器

現(xiàn)有的方法無(wú)法直接從無(wú)透鏡成像數(shù)據(jù)中提取有效的特征,因此作者設(shè)計(jì)無(wú)透鏡特征解碼器的目標(biāo)是從無(wú)透鏡成像數(shù)據(jù)中有效的提取多尺度特征 ,并用于后續(xù)3D人體姿態(tài)和形狀的估計(jì)。

,并用于后續(xù)3D人體姿態(tài)和形狀的估計(jì)。

在解碼器 的內(nèi)部作者加入了全局感知層

的內(nèi)部作者加入了全局感知層 ,

, 的設(shè)計(jì)靈感來(lái)源于HRNet[1]。

的設(shè)計(jì)靈感來(lái)源于HRNet[1]。

全局感知層的內(nèi)部,不同分支之間的信息交互彌補(bǔ)了通道數(shù)量減少所造成的信息損失;全局感知層正是繼承了HRNet[1]的許多優(yōu)點(diǎn),才能夠始終保持較高的分辨率,這些優(yōu)點(diǎn)對(duì)于從無(wú)透鏡成像數(shù)據(jù)中提取特征非常重要。

人體參數(shù)化模型回歸

?

作者在本文中使用的人體參數(shù)回歸器借鑒了PyMAF[2]的設(shè)計(jì)。

PyMAF[2]中的人體參數(shù)回歸器使用了通過(guò)反卷積得到的不同尺度特征,然而使用這種做法,會(huì)導(dǎo)致大量有效的信息在不斷的上下采樣過(guò)程中丟失,在LPSNet中,作者設(shè)計(jì)的全局感知層利用了HRNet[1]的結(jié)構(gòu)特性維護(hù)了更多全局高分辨率特征。

雙頭輔助監(jiān)督機(jī)制

?

從無(wú)透鏡成像數(shù)據(jù)中提取的空間特征圖比較粗糙,含有大量的噪聲,對(duì)人體肢體末端的估計(jì)仍然存在一定的偏差。為了提高人體肢體末端估計(jì)的精度,作者引入了雙頭輔助監(jiān)督機(jī)制。

具體來(lái)說(shuō),作者首先通過(guò)上采樣將所有不同尺度的空間特征轉(zhuǎn)換為相同的尺度,然后將它們連接在一起得到 ,特征

,特征 被用于不同的輔助監(jiān)督頭。

被用于不同的輔助監(jiān)督頭。

一方面,作者通過(guò)Classification層生成熱圖表示來(lái)體現(xiàn)二維關(guān)鍵點(diǎn)的位置;另一方面,作者還通過(guò)IUV Predict層估計(jì)密集映射。

雙頭輔助監(jiān)督的損失函數(shù)由兩部分組成,可表示為:

1. 關(guān)鍵點(diǎn)輔助監(jiān)督

作者使用基于SimCC[3]的方法來(lái)預(yù)測(cè)姿態(tài)關(guān)鍵點(diǎn)。這種方法將關(guān)鍵點(diǎn)定位作為水平和垂直坐標(biāo)的分類(lèi)任務(wù)。在訓(xùn)練過(guò)程中,作者沒(méi)有估計(jì)實(shí)際坐標(biāo),而是使用兩個(gè)向量分表表示和的相關(guān)位置信息,同時(shí)2D關(guān)鍵點(diǎn)真值轉(zhuǎn)換為同樣的兩個(gè)向量來(lái)計(jì)算損失。

損失函數(shù)的表達(dá)式為:

式中KL-Loss為Kullback-Leibler散度損失,和分別為處理后2D關(guān)鍵點(diǎn)真值。

2.IUV輔助監(jiān)督

模板網(wǎng)格上的頂點(diǎn)可以使用3D表面空間和2D UV空間之間的預(yù)定義雙射映射將其映射回2D圖像。密集對(duì)應(yīng)表示包括身體部分P的索引和網(wǎng)格頂點(diǎn)的UV值。

實(shí)驗(yàn)數(shù)據(jù)集

LPSNet的輸入是無(wú)透鏡成像數(shù)據(jù),因此經(jīng)典的人體姿態(tài)估計(jì)數(shù)據(jù)集目前還無(wú)法直接使用。為了解決這一問(wèn)題,作者搭建了一個(gè)無(wú)透鏡成像系統(tǒng)用于采集實(shí)驗(yàn)數(shù)據(jù),該成像系統(tǒng)還具備較為可靠數(shù)學(xué)模型,可以用于系統(tǒng)仿真。

作者的實(shí)驗(yàn)的數(shù)據(jù)集來(lái)源可分為以下兩個(gè)方面:

1)真實(shí)數(shù)據(jù)集:使用無(wú)透鏡成像系統(tǒng)采集顯示在屏幕上的圖像作為無(wú)透鏡成像數(shù)據(jù)是目前在無(wú)透鏡領(lǐng)域獲取數(shù)據(jù)集的主要方法。作者使用這種方式收集人體姿態(tài)數(shù)據(jù)集,包括Human3.6M、MPII、COCO、3DPW和MIP-INF-3DHP數(shù)據(jù)集。除此之外作者還采集了真實(shí)場(chǎng)景的人體數(shù)據(jù)。

2) 仿真數(shù)據(jù)集:無(wú)透鏡成像系統(tǒng)的成像過(guò)程可以通過(guò)數(shù)學(xué)模型表示。作者通過(guò)無(wú)透鏡成像系統(tǒng)的數(shù)學(xué)模型將主流人體姿態(tài)數(shù)據(jù)集轉(zhuǎn)換為無(wú)透鏡成像系統(tǒng)采集的結(jié)果。

實(shí)驗(yàn)結(jié)果

由于該工作是第一個(gè)通過(guò)無(wú)透鏡成像數(shù)據(jù)估計(jì)3D人體姿勢(shì)和形狀的工作,缺少對(duì)比的方法,因此作者設(shè)計(jì)了一個(gè)兩階段的baseline進(jìn)行對(duì)比。

Baseline基本結(jié)構(gòu)如圖4所示,作者首先使用了Rego等人提出的無(wú)透鏡圖像重建方法[4]重建出RGB圖像,然后使用PyMAF[2]方法從RGB圖像中估計(jì)人體三維姿態(tài)與形狀。此外,作者還使用了從無(wú)透鏡數(shù)據(jù)重建的圖像對(duì)PyMAF進(jìn)行微調(diào),記為PyMAF?。

圖4 Baseline基本結(jié)構(gòu) (上部)重建圖像與原圖像對(duì)比(下部)

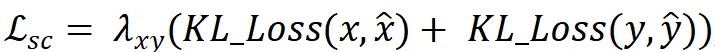

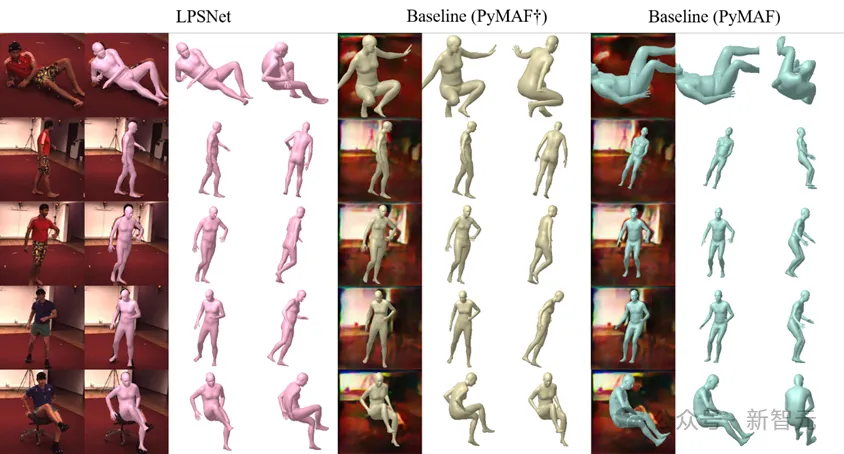

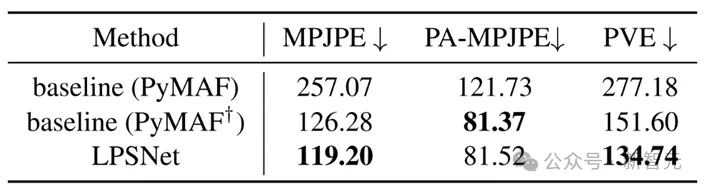

作者對(duì)比了LPSNet、baseline(PyMAF)和baseline(PyMAF?)方法的結(jié)果,如圖5,圖6所示。可以看到,LPSNet的結(jié)果相較于兩種baseline有著較為明顯的提升。表1為定量結(jié)果,LPSNet在MPJPE和PVE兩個(gè)評(píng)價(jià)指標(biāo)上優(yōu)于兩個(gè)baseline方法。

圖5 不同方法的定性對(duì)比結(jié)果

圖6 不同方法的定性對(duì)比結(jié)果(注意:baseline(PyMAF)誤差較大,這里不做誤差分析)

表1 不同方法的定量對(duì)比結(jié)果

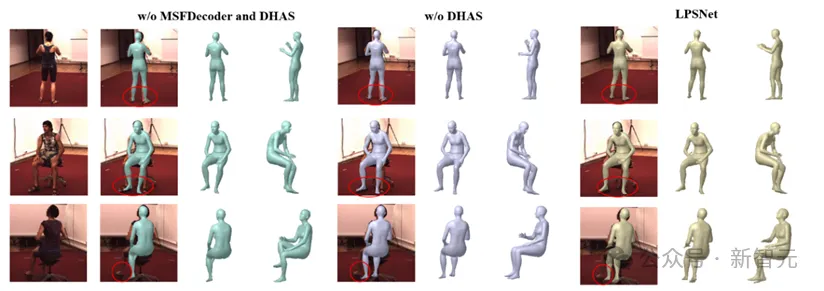

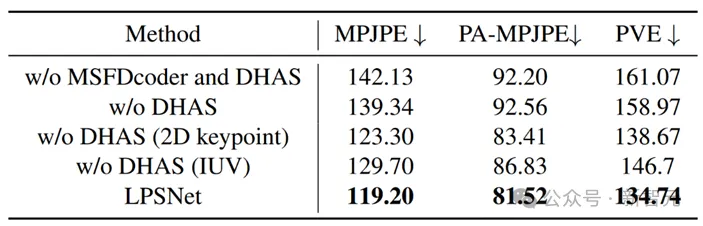

除此之外,作者也提供了較為詳細(xì)的消融實(shí)驗(yàn)。圖7展示了定性結(jié)果,表2展示了定量結(jié)果。通過(guò)消融實(shí)驗(yàn)可以看出,使用了作者設(shè)計(jì)的無(wú)透鏡特征解碼器和雙頭輔助監(jiān)督機(jī)制后,實(shí)驗(yàn)結(jié)果有明顯提升。

圖7 LPSNet消融實(shí)驗(yàn)結(jié)果(定性)

表2 LPSNet消融實(shí)驗(yàn)結(jié)果(定量)

該工作的demo視頻如下:

作者簡(jiǎn)介

葛昊洋,天津大學(xué)22級(jí)碩士研究生,主要研究方向:三維視覺(jué)、無(wú)透鏡成像。

馮橋,天津大學(xué)21級(jí)碩士研究生,主要研究方向:三維視覺(jué)、計(jì)算機(jī)圖形學(xué)。

??https://fengq1a0.github.io??

賈海龍,天津大學(xué)22級(jí)碩士研究生,主要研究方向:三維視覺(jué)、無(wú)透鏡成像。

李雄政,天津大學(xué)19級(jí)博士研究生,主要研究方向:三維視覺(jué)、人體與衣物重建。

殷祥軍,天津大學(xué)19級(jí)博士研究生,主要研究方向:無(wú)透鏡成像、計(jì)算攝像學(xué)。

周游,南京大學(xué)助理教授,主要研究方向:計(jì)算光學(xué)與顯微成像。

??https://zhouyou-nju.github.io/??

楊敬鈺,天津大學(xué)教授、博導(dǎo),主要研究方向:計(jì)算攝像學(xué)、多媒體處理。

李坤(通訊作者),天津大學(xué)教授、博導(dǎo),主要研究方向:三維視覺(jué)、多媒體處理。

??http://cic.tju.edu.cn/faculty/likun??

本文轉(zhuǎn)自 新智元 ,作者:新智元