具身智能體三維感知新鏈條,TeleAI &上海AI Lab提出多視角融合具身模型「SAM-E」

當我們拿起一個機械手表時,從正面會看到表盤和指針,從側面會看到表冠和表鏈,打開手表背面會看到復雜的齒輪和機芯。每個視角都提供了不同的信息,將這些信息綜合起來才能理解操作對象的整體三維。

想讓機器人在現實生活中學會執行復雜任務,首先需要使機器人理解操作對象和被操作對象的屬性,以及相應的三維操作空間,包括物體位置、形狀、物體之間的遮擋關系,以及對象與環境的關系等。

其次,機器人需要理解自然語言指令,對未來動作進行長期規劃和高效執行。使機器人具備從環境感知到動作預測的能力是具有挑戰性的。

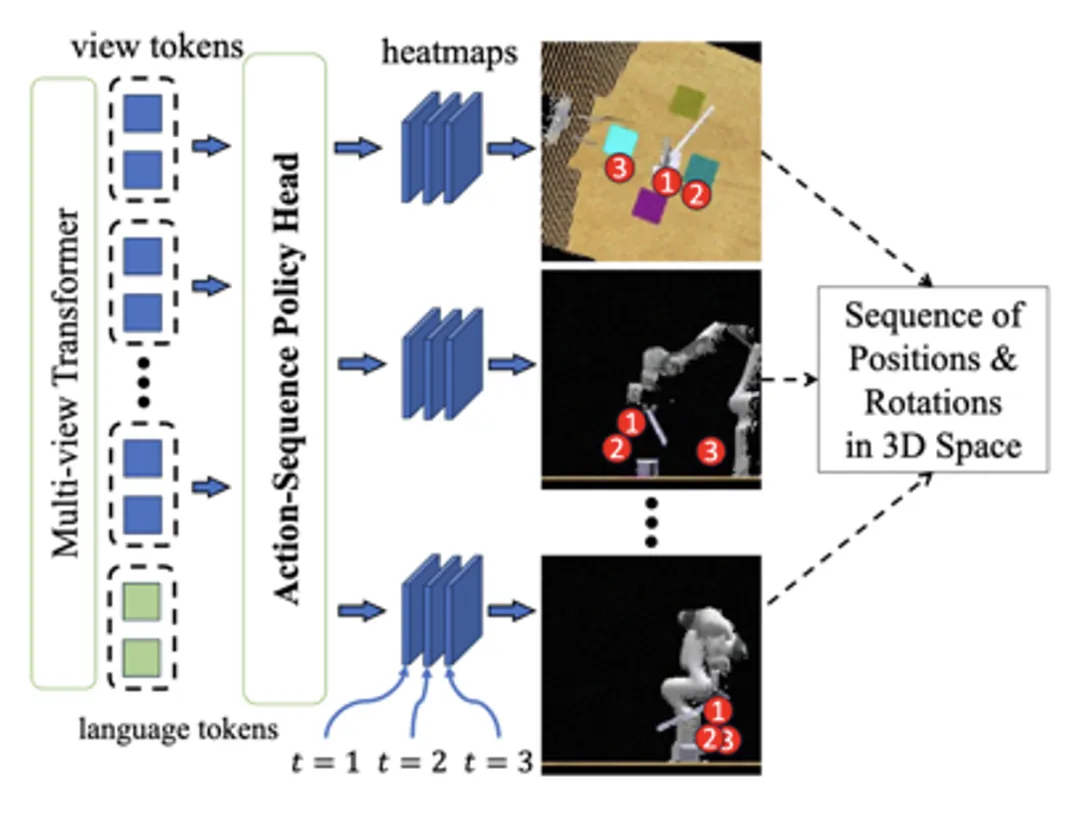

近期,中國電信人工智能研究院(TeleAI)李學龍教授團隊聯合上海人工智能實驗室、清華大學等單位,模擬人「感知—記憶—思維—想象」的認知過程,提出了多視角融合驅動的通用具身操作算法,為機器人學習復雜操作給出了可行解決方案,論文被國際機器學習大會ICML 2024錄用,為構建通用三維具身策略奠定了基礎。

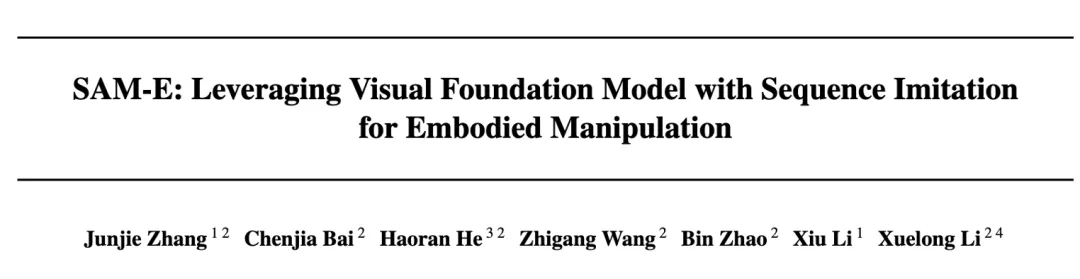

近年來,視覺基礎模型對圖像的理解能力獲得了飛速發展。然而,三維空間的理解還存在許多挑戰。能否利用視覺大模型幫助具身智能體理解三維操作場景,使其在三維空間中完成各種復雜的操作任務呢?受「感知—記憶—思維—想象」的認知過程啟發,論文提出了全新的基于視覺分割模型Segment Anything(SAM)的具身基座模型SAM-E。

首先,SAM- E具有強大可提示(promptable)「感知」能力,將SAM特有的分割結構應用在語言指令的具身任務中,通過解析文本指令使模型關注到場景中的操作物體。

隨后,設計一種多視角Transformer,對深度特征、圖像特征與指令特征進行融合與對齊,實現對象「記憶」與操作「思考」,以此來理解機械臂的三維操作空間。

最后,提出了一種全新的動作序列預測網絡,對多個時間步的動作序列進行建模,「想象」動作指令,實現了從三維場景感知到具身動作的端到端輸出。

- 論文名稱:SAM-E: Leveraging Visual Foundation Model with Sequence Imitation for Embodied Manipulation

- 論文鏈接: ???https://sam-embodied.github.io/static/SAM-E.pdf???

- 項目地址: ????https://sam-embodied.github.io/???

從二維感知到三維感知

在數字時代的浪潮中,隨著人工智能技術的飛速發展,我們正逐漸邁入一個嶄新的時代——具身智能時代。賦予智能體以身體,使其具備與真實世界直接互動的能力,成為了當前研究的重點方向之一。

要實現這一目標,智能體必須具備強大的三維感知能力,以便能夠準確地理解周圍環境。

傳統的二維感知手段在面對復雜的立體空間時顯得力不從心,如何讓具身智能體通過學習掌握對三維空間的精準建模能力,成為了一個亟待解決的關鍵問題。

現有工作通過正視圖、俯視圖、側視圖等等多個視角的視圖還原和重建三維空間,然而所需的計算資源較為龐大,同時在不同場景中具有的泛化能力有限。

為了解決這個問題,本工作探索一種新的途徑——將視覺大模型的強大泛化能力應用于具身智能體的三維感知領域。

SAM-E提出了使用具有強大泛化能力的通用視覺大模型 SAM 進行視覺感知,通過在具身場景的高效微調,將其具有的可泛化,可提示(promptable)的特征提取能力、實例分割能力、復雜場景理解等能力有效遷移到具身場景中。

為了進一步優化SAM基座模型的性能,引入了動作序列網絡的概念,不僅能夠捕捉單個動作的預測,還能夠深入理解連續動作之間的內在聯系,充分挖掘動作間的時序信息,從而進一步提高基座模型對具身場景的理解與適應能力。

圖1. SAM-E總體框架

SAM-E方法

SAM-E方法的核心觀點主要包含兩個方面:

- 利用SAM的提示驅動結構,構建了一個強大的基座模型,在任務語言指令下擁有出色的泛化性能。通過LoRA微調技術,將模型適配到具身任務中,進一步提升了其性能。

- 采用時序動作建模技術,捕捉動作序列中的時序信息,更好地理解任務的動態變化,并及時調整機器人的策略和執行方式,使機器人保持較高的執行效率。

可提示感知與微調

SAM- E核心在于利用任務指令提示驅動的網絡結構,包含一個強大的視覺編碼器和一個輕量的解碼器。

在具身場景中任務「提示」以自然語言的形式呈現,作為任務描述指令,視覺編碼器發揮其可提示的感知能力,提取與任務相關的特征。策略網絡則充當解碼器的角色,基于融合的視覺嵌入和語言指令輸出動作。

在訓練階段,SAM-E 使用 LoRA 進行高效微調,大大減少了訓練參數,使視覺基礎模型能夠快速適應于具身任務。

多視角三維融合

SAM-E引入了多視角Transformer網絡,以融合多視角的視覺輸入,深入理解三維空間。其工作分為兩個階段:視角內注意力(View-wise Attention)和跨視角注意力(Cross-view Attention)。

首先,對多視角特征分別進行視角內部的注意力處理,然后融合多個視角和語言描述進行混合視角注意力,實現多視角的信息融合和圖像—語言對齊。

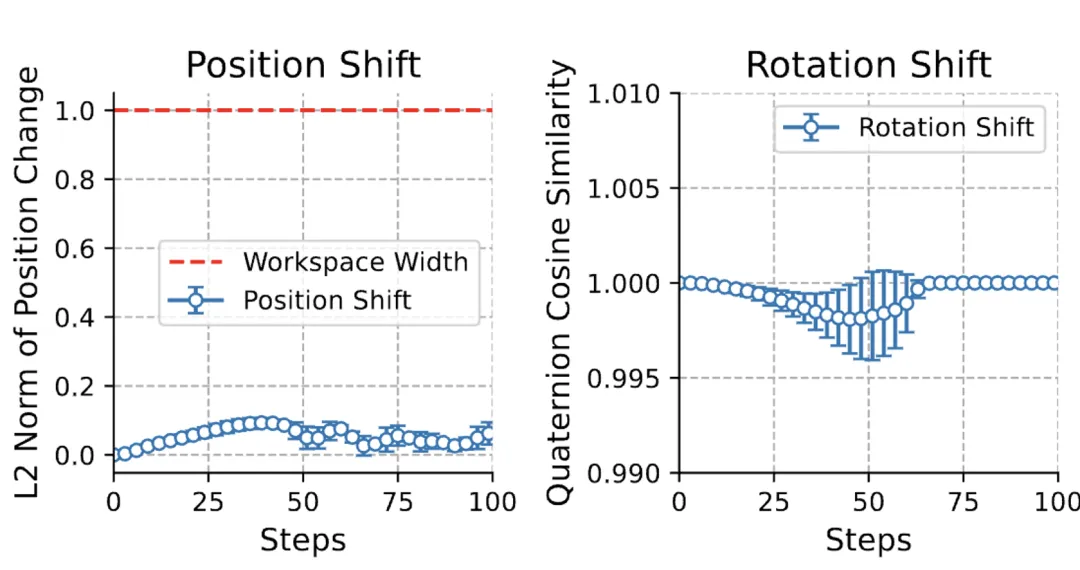

動作序列建模

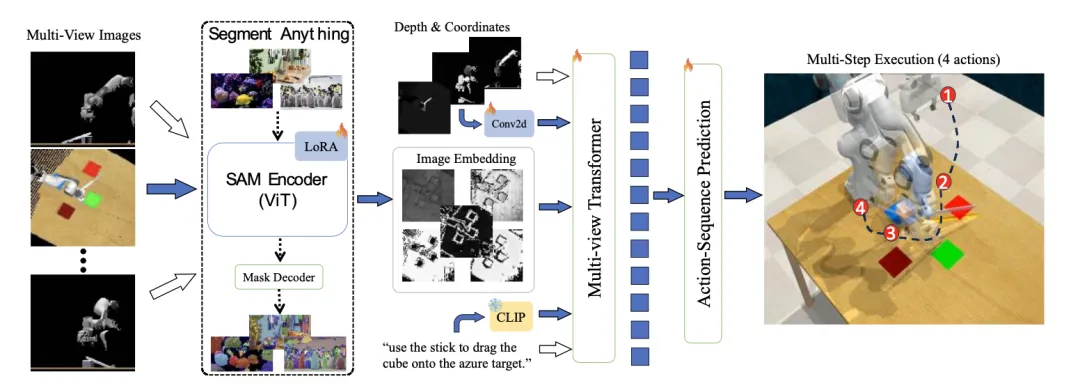

在機械臂執行中,末端執行器的位置和旋轉通常呈現出連續而平滑的變化趨勢。這一特性使得相鄰動作之間存在著密切的聯系和連續性。基于這一觀察,提出了一種新穎的時間平滑假設,旨在充分利用相鄰動作之間的內在關聯,實現對動作序列的有效模仿學習。

具體來說,SAM-E框架通過序列建模技術捕捉動作序列中的模式和關系,為動作預測提供一種隱性的先驗知識,并對動作的連續性加以約束,從而顯著提升動作預測的準確性和一致性。

在實際應用中,SAM-E 允許在一次動作預測中執行后續的多步動作,極大地提高了執行效率。

圖3.連續動作的位置和旋轉變化

圖4.動作序列預測網絡

實驗

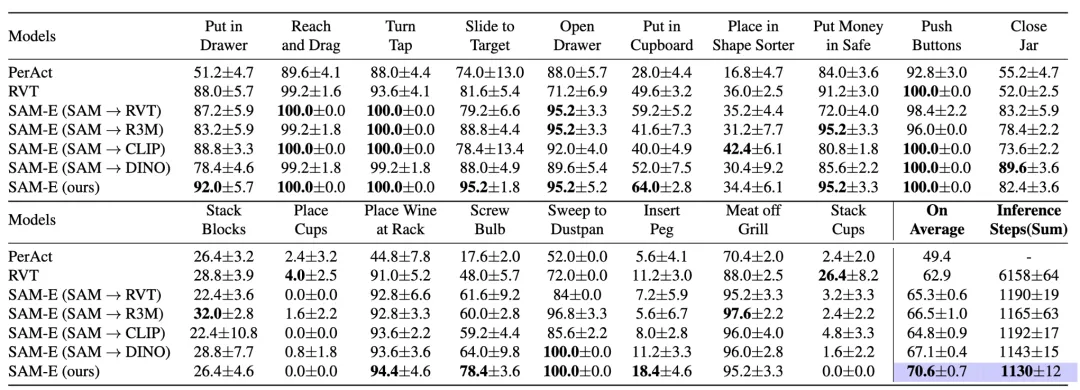

實驗使用具有挑戰性的機械臂任務集合——RLBench,對多視角觀測下的3D操作任務進行了全面評估,SAM-E模型在多個方面均顯著優于其他傳統方法。

- 在多任務場景下,SAM-E模型顯著提高了任務成功率。

- 在面對少量樣本遷移至新任務的情況下,SAM-E憑借強大的泛化性能和高效的執行效率,有效提升新任務的表現。

圖5.三維操作任務結果比較

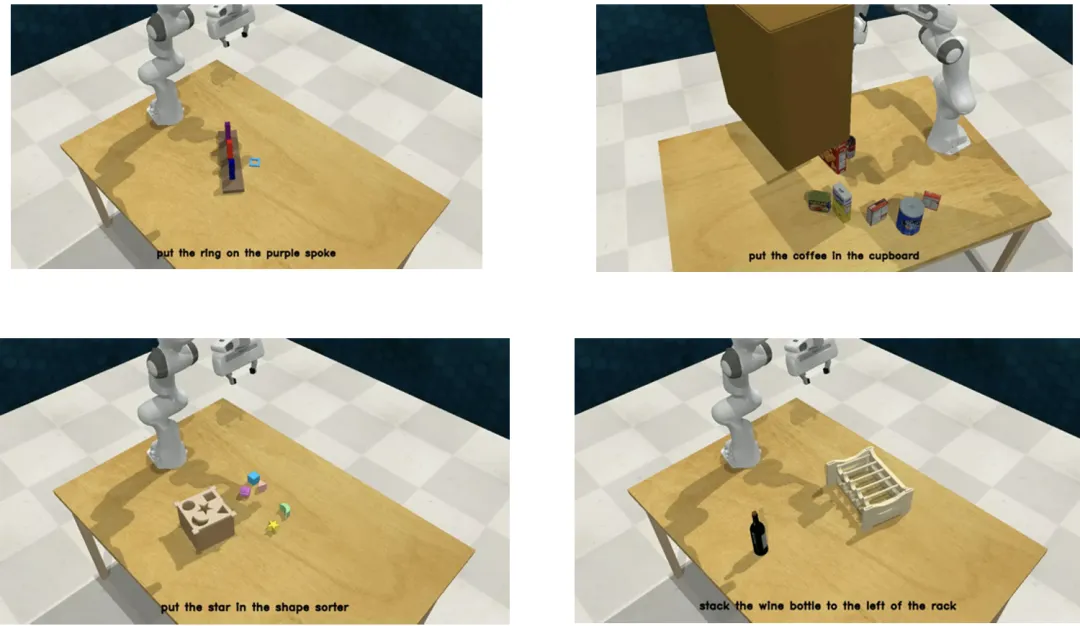

圖6.三維操作任務示例

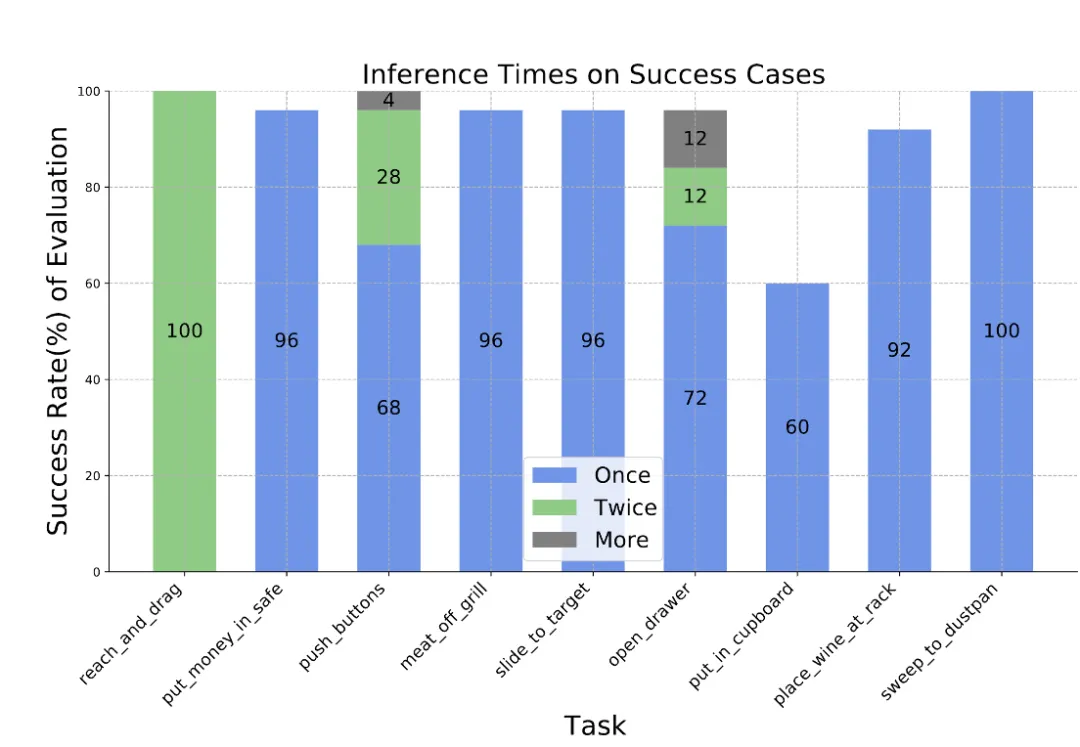

此外,動作序列建模顯著提高了 SAM-E 的執行效率,同時在策略執行階段,相比于單個動作,動作序列執行顯著降低了模型推理次數,測試中甚至能通過一次模型推理完成相應任務。

圖7.任務執行中的模型推理頻率

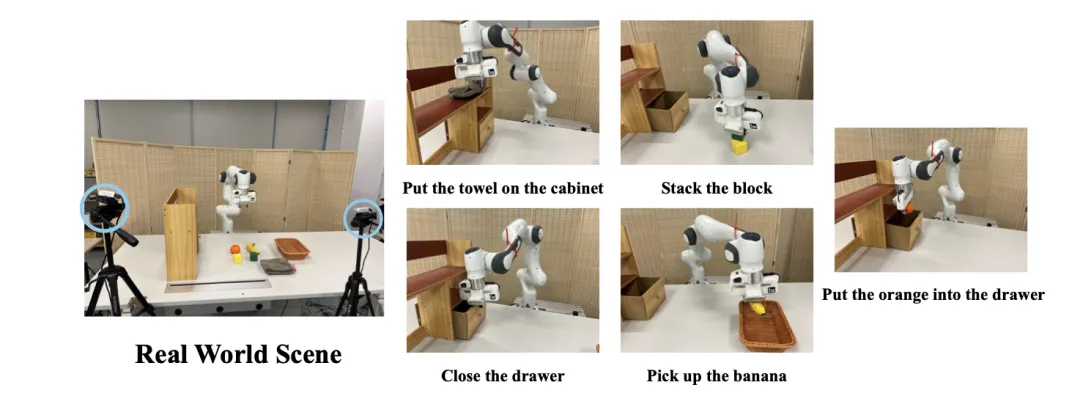

SAM-E在真實機械臂控制中同樣有效,使用兩個第三人稱相機捕獲多視角視覺輸入,在五個真實任務上具有實時的推理能力。

圖8.真實機械臂任務

總結

該工作開創性地提出了一種以多視角融合的基礎的通用具身操作算法,利用視覺分割大模型和多視角融合實現具身智能體的三維物理空間感知。

通過高效的參數微調,將預訓練視覺模型遷移到具身場景中,能夠解決自然語言指令的復雜3D機械臂操作任務。此外,模型可以通過學習少量專家示例,快速泛化到新的任務中,展現出優越的訓練效率和動作執行效率。

更重要的是,SAM-E以「感知—記憶—思維—想象」的認知鏈路,實現了從數據到動作的端到端映射。其意義不僅在于其在具身智能體中的應用,更在于對提升智能體認知能力的啟發。

通過模擬人類的感知和決策方式,智能體能夠更好地理解和適應復雜的環境,從而在更廣泛的領域發揮更大的作用。

團隊負責人介紹:

李學龍,中國電信CTO、首席科學家,中國電信人工智能研究院(TeleAI)院長。主要關注人工智能、臨地安防、圖像處理、具身智能。

本文轉自機器之心 ,作者:機器之心

原文鏈接:??https://mp.weixin.qq.com/s/bLqyLHzFoBrRBT0jgkmZMw??