像俄羅斯方塊一樣生成視頻! 北大聯(lián)合快手AI團(tuán)隊(duì)推出新框架VideoTetris實(shí)現(xiàn)跟隨復(fù)雜指令的文生視頻!

Paper: ??https://arxiv.org/abs/2406.04277??Code: ??https://github.com/YangLing0818/VideoTetris??Project: ??https://videotetris.github.io/???

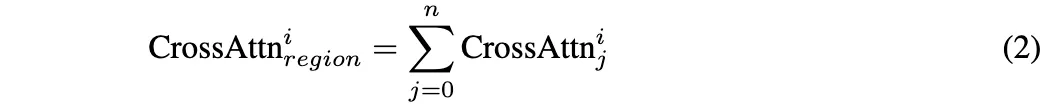

擴(kuò)散模型在文本到視頻(T2V)生成方面取得了巨大成功,視頻生成模型正以飛快的速度發(fā)展。

然而,現(xiàn)有的文生視頻模型在應(yīng)對(duì)復(fù)雜、細(xì)節(jié)豐富、多物體的指令時(shí),仍存在一定的挑戰(zhàn)。

為了生成更精確的復(fù)雜視頻,北京大學(xué)與快手AI團(tuán)隊(duì)推出了 VideoTetris,定義了復(fù)雜組合指令生成任務(wù),并提出了一個(gè)新的框架,實(shí)現(xiàn)復(fù)雜視頻生成。這個(gè)框架不僅能夠直接增強(qiáng)現(xiàn)有模型的組合生成,還能夠支持涵蓋多復(fù)雜指令、多場(chǎng)景變更等更高難度的長(zhǎng)視頻生成。

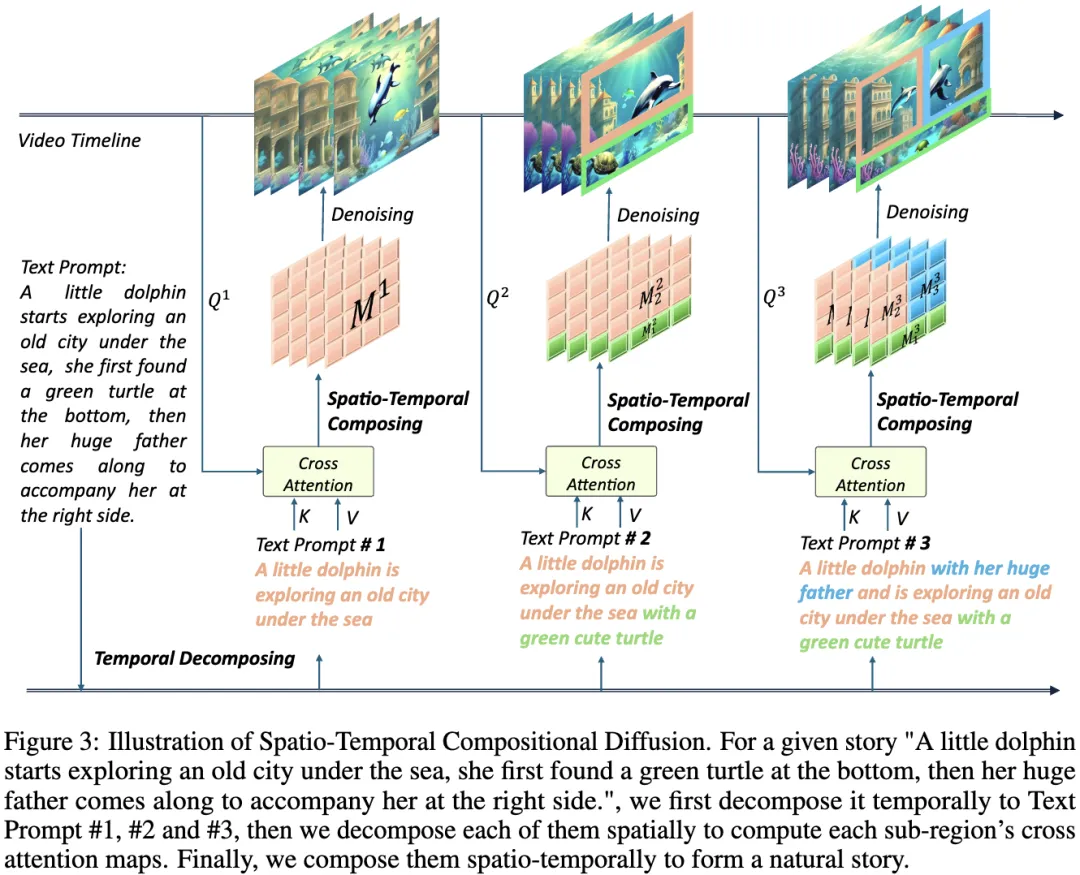

具體而言,提出了時(shí)空合成擴(kuò)散,通過(guò)在空間和時(shí)間上操縱和合成去噪網(wǎng)絡(luò)的注意力圖來(lái)精確地遵循復(fù)雜的文本特征。此外,還提出了一種增強(qiáng)的視頻數(shù)據(jù)預(yù)處理方法,以增強(qiáng)訓(xùn)練數(shù)據(jù)的運(yùn)動(dòng)動(dòng)力學(xué)和快速理解,并配備了一種新的參考幀注意力機(jī)制,以提高自回歸視頻生成的一致性。

就像拼俄羅斯方塊一樣,輕松實(shí)現(xiàn)更精妙的組合細(xì)節(jié)!

總體貢獻(xiàn)總結(jié)如下:

- 介紹了一種時(shí)空合成擴(kuò)散方法,用于處理具有多個(gè)對(duì)象的場(chǎng)景并遵循漸進(jìn)的復(fù)雜提示。

- 開(kāi)發(fā)了一個(gè)增強(qiáng)的視頻數(shù)據(jù)預(yù)處理pipeline,通過(guò)運(yùn)動(dòng)動(dòng)力學(xué)和提示語(yǔ)義增強(qiáng)自回歸長(zhǎng)視頻生成。

- 提出了一種具有參考幀注意力的一致性正則化方法,該方法在合成視頻生成中保持內(nèi)容一致性。

- VideoTetris可以生成最先進(jìn)的高質(zhì)量合成視頻,也可以生成符合漸進(jìn)合成提示的高質(zhì)量長(zhǎng)視頻,同時(shí)保持最佳一致性。

組合生成

在文生圖領(lǐng)域,RPG、Omost等項(xiàng)目已經(jīng)實(shí)現(xiàn)了復(fù)雜的組合式多物體多場(chǎng)景圖片生成。而在文生視頻領(lǐng)域,組合生成自然地?cái)U(kuò)展到時(shí)間和空間維度,這樣的場(chǎng)景還未被廣泛探索。團(tuán)隊(duì)首次定義了組合視頻生成任務(wù),包括兩個(gè)子任務(wù):

1、跟隨復(fù)雜組合指令的視頻生成。

2、跟隨遞進(jìn)的組合式多物體指令的長(zhǎng)視頻生成。在第一個(gè)場(chǎng)景中,我們輸入“左邊一個(gè)可

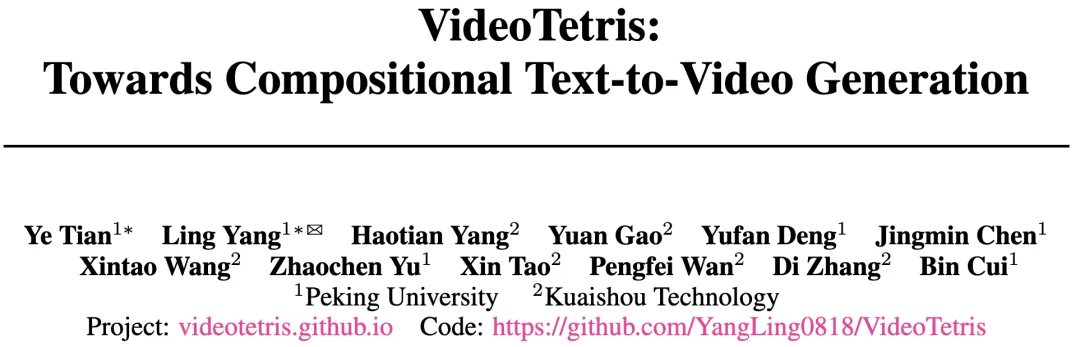

愛(ài)的棕色狗狗,右邊一只打盹的貓?jiān)陉?yáng)光下小憩”這樣的簡(jiǎn)單指令給文生視頻模型。幾乎所有開(kāi)源模型都未能生成正確的視頻,如:

Animatediff:

opensora plan v1.1:

videocrafter2:

這些模型生成出融合了兩個(gè)物體信息的奇怪視頻。而使用 videotetris,生成出的視頻是這樣的:

貓貓和狗狗自然靈動(dòng),同時(shí)保留了所有的位置信息和細(xì)節(jié)特征!甚至說(shuō),如果對(duì)比已經(jīng)商用的 Gen-2 和 Pika呢?

Gen-2:

也生成了融合了貓和狗的一只奇怪生物

Pika:

終于生成了兩個(gè)小動(dòng)物,結(jié)果搞錯(cuò)了左右關(guān)系

可見(jiàn) ,VideoTetris 的組合視頻生成能力即使面對(duì)商用模型也毫不遜色。

在長(zhǎng)視頻生成中,目前的方法支持的可變指令目前還停留在“春夏秋冬”的轉(zhuǎn)化,或單物體從走到跑到騎馬的場(chǎng)景變化階段。

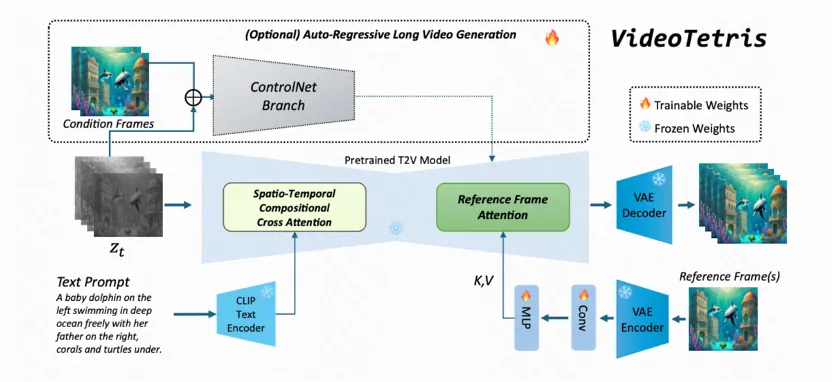

我們輸入一個(gè)簡(jiǎn)單的多指令:“從一只可愛(ài)的棕色松鼠在一堆榛子上過(guò)渡到一只可愛(ài)的棕色松鼠和一只可愛(ài)的白色松鼠在一堆榛子上”。

將這個(gè)指令輸入給 FreeNoise 和 StreamingT2V 這兩個(gè)還不錯(cuò)的長(zhǎng)視頻生成模型中,一次性生成長(zhǎng)達(dá) 30s 的視頻,他們生成的結(jié)果是這樣的:

FreeNoise:

松鼠幾乎一動(dòng)不動(dòng),一個(gè)松鼠從榛子變身而來(lái),最后兩個(gè)竟然都變了色

StreamingT2V:

完全沒(méi)有第二個(gè)松鼠出現(xiàn),甚至在視頻末期出現(xiàn)了嚴(yán)重的偏色

而VideoTetris生成的視頻是這樣的,到視頻最后,生成了一個(gè)靈動(dòng)的白松鼠和另一個(gè)棕松鼠,兩只松鼠還在自然地交換食物

技術(shù)實(shí)現(xiàn)

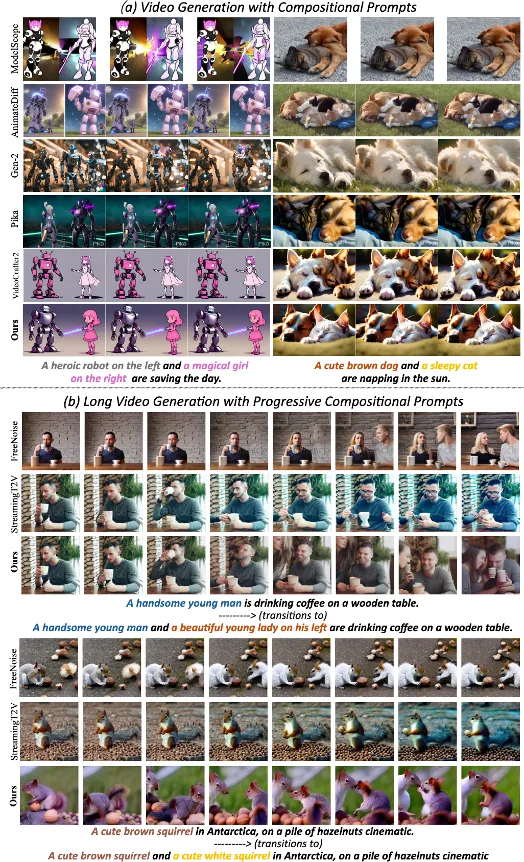

這樣的效果是如何做到的呢?該團(tuán)隊(duì)的 VideoTetris 框架使用了 時(shí)空組合擴(kuò)散 方法。

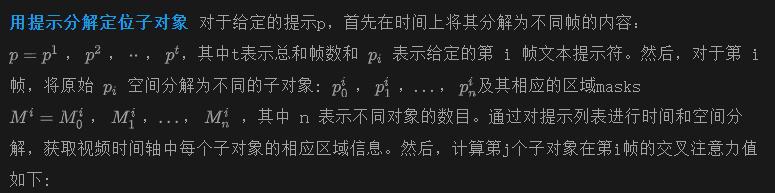

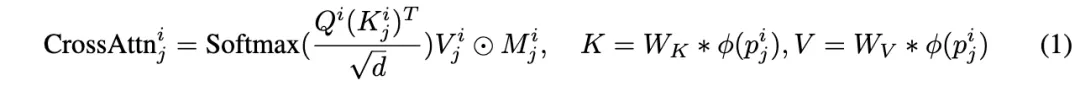

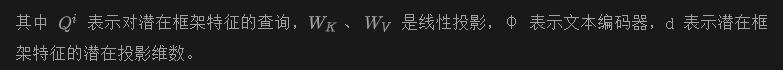

他們將一個(gè)提示詞首先按照時(shí)間解構(gòu),為不同的視頻幀指定好不同的提示信息。

隨后,在每一幀上進(jìn)行空間維度的解構(gòu),將不同物體對(duì)應(yīng)不同的視頻區(qū)域。

最后,通過(guò)時(shí)空交叉注意力進(jìn)行組合,通過(guò)這個(gè)過(guò)程實(shí)現(xiàn)高效的組合指令生成。

而為了生成更高質(zhì)量的長(zhǎng)視頻,該團(tuán)隊(duì)還提出了一種增強(qiáng)的訓(xùn)練數(shù)據(jù)預(yù)處理方法。使得長(zhǎng)視頻生成更加動(dòng)態(tài)穩(wěn)定。此外,還引入了一個(gè)參考幀注意力機(jī)制,使用原生 VAE 對(duì)之前的幀信息編碼,區(qū)別于 StreamingT2V, Vlogger, IPAdapter 等使用 CLIP 編碼的方式,這樣使得參考信息的表示空間和噪聲完全一致,輕松獲取更好的內(nèi)容一致性。

這樣優(yōu)化的結(jié)果是,長(zhǎng)視頻從此不再有大面積偏色的現(xiàn)象,能夠更好地適應(yīng)復(fù)雜指令,并且生成的視頻更具有動(dòng)感,更符合自然。

時(shí)空組合擴(kuò)散模型

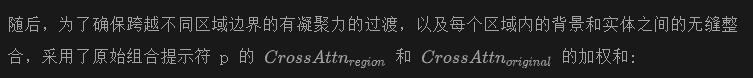

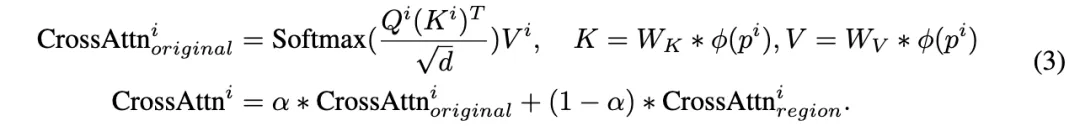

動(dòng)機(jī) 為了實(shí)現(xiàn)自然的組合生成,一個(gè)直接的方法是使用布局作為條件來(lái)指導(dǎo)生成過(guò)程。然而,這種方法提出了幾個(gè)挑戰(zhàn): (i)需要大規(guī)模的訓(xùn)練。鑒于布局到圖像模型改進(jìn)的巨大潛力,訓(xùn)練布局到視頻模型或訓(xùn)練布局到圖像模型的時(shí)間卷積和注意力層將需要大量的計(jì)算資源,并可能難以跟上文本到視頻模型的最新進(jìn)展。(ii)基于布局的生成模型對(duì)目標(biāo)邊界框施加了很大的限制。由于視頻持續(xù)時(shí)間較長(zhǎng),需要不斷調(diào)整這些box的位置和大小,以保持連貫的視頻內(nèi)容,因此需要一個(gè)復(fù)雜的規(guī)劃過(guò)程,這增加了整個(gè)方法的復(fù)雜性。因此,我們提出了一種直接調(diào)整不同目標(biāo)交叉注意力的無(wú)訓(xùn)練方法,而不是訓(xùn)練布局到視頻模型,如下圖3所示。這種方法旨在克服基于布局的方法的局限性,并利用更靈活和高效的生成技術(shù)的潛力。

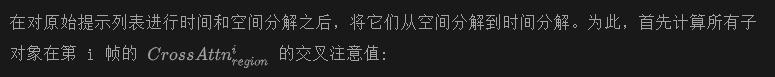

基于 LM 的自動(dòng)時(shí)空分解器(可選) 或者,時(shí)空分解過(guò)程可以直接利用大語(yǔ)言模型(LLM)來(lái)自動(dòng)化任務(wù),因?yàn)?LLM 在語(yǔ)言理解,推理,摘要和區(qū)域生成能力方面具有強(qiáng)大的性能。利用 LLM 的上下文學(xué)習(xí)(ICL)能力,引導(dǎo)模型使用思維鏈(CoT)推理。具體來(lái)說(shuō),首先引導(dǎo) LLM 對(duì)故事進(jìn)行時(shí)間分解,生成框架式提示,并使用 LLM 接收每一個(gè)提示,以獲得更好的語(yǔ)義豐富性。然后,使用另一個(gè) LLM 將每個(gè)提示符空間分解為對(duì)應(yīng)于不同對(duì)象的多個(gè)提示符,并為每個(gè)子提示符分配一個(gè)區(qū)域mask。具體的提示模板,包括任務(wù)規(guī)則(指令) ,上下文示例(演示)見(jiàn)附錄。

利用 α 參數(shù)調(diào)節(jié)全局信息和個(gè)體特征之間的平衡,使視頻內(nèi)容更符合人類(lèi)的審美感知。最后,自然而然地將所有交叉注意值連接起來(lái),這些交叉注意值是沿著時(shí)間維度計(jì)算的:

通過(guò)這種方式,無(wú)論是對(duì)于預(yù)先訓(xùn)練的文本到視頻模型,如 Modelscope,Animatediff,VideoCrafter2和 Latte,還是對(duì)于更長(zhǎng)的視頻生成如 StreamingT2V 的自回歸模型,這種方法可以直接應(yīng)用于無(wú)訓(xùn)練的方式,以獲得合成的,一致的和美觀的結(jié)果。

增強(qiáng)的視頻數(shù)據(jù)預(yù)處理

運(yùn)動(dòng)動(dòng)增強(qiáng)力學(xué) 對(duì)于自回歸視頻生成,我們經(jīng)驗(yàn)性地發(fā)現(xiàn) StreamingT2V在生成一致的內(nèi)容方面是最有效的。然而,在視頻生成的后期階段,有一個(gè)顯著的趨勢(shì),即出現(xiàn)質(zhì)量差的病例和顏色退化。我們把這個(gè)問(wèn)題歸因于原始訓(xùn)練數(shù)據(jù)的次優(yōu)質(zhì)量。為了提高長(zhǎng)視頻生成的運(yùn)動(dòng)一致性和穩(wěn)定性,必須對(duì)視頻數(shù)據(jù)進(jìn)行過(guò)濾,以保持高質(zhì)量的內(nèi)容和一致的運(yùn)動(dòng)動(dòng)力學(xué)。受到 Stable Video Diffusion的啟發(fā),我們經(jīng)驗(yàn)性地觀察到視頻的光流量與其運(yùn)動(dòng)幅度之間存在顯著的相關(guān)性。過(guò)低的光流通常對(duì)應(yīng)于靜態(tài)視頻幀,而過(guò)高的光流通常表明幀有劇烈的變化。為了確保生成平滑和合適的視頻數(shù)據(jù),通過(guò)選擇 RAFT計(jì)算的平均光流分?jǐn)?shù)在指定范圍(s1至 s2)內(nèi)的視頻來(lái)過(guò)濾 Panda-70M。

強(qiáng)化提示語(yǔ)義 雖然Panda-70M的視頻顯示出最好的視覺(jué)質(zhì)量,配對(duì)提示往往是相對(duì)簡(jiǎn)短的,這與我們的目標(biāo),生成視頻堅(jiān)持復(fù)雜的,詳細(xì)的,組合提示。直接使用這些數(shù)據(jù)進(jìn)行訓(xùn)練可能會(huì)導(dǎo)致視頻生成模型不能充分理解復(fù)雜的合成提示。受到最近文本到圖像的研究的啟發(fā),已經(jīng)證明高質(zhì)量的提示可以顯著提高視覺(jué)內(nèi)容的輸出質(zhì)量。因此,在過(guò)濾了最初的一組視頻之后,對(duì)選定的樣本執(zhí)行重述過(guò)程,以確保它們更好地與我們的目標(biāo)保持一致。使用三個(gè)多模態(tài) LLM 來(lái)生成每個(gè)視頻的時(shí)空上錯(cuò)綜復(fù)雜的詳細(xì)描述,然后使用一個(gè) LLM 來(lái)合并這些描述,提取公共元素,并添加進(jìn)一步的信息。

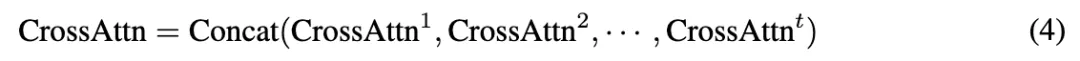

具有參考幀注意的一致性正則化

我們的方法涉及到在長(zhǎng)視頻中添加和刪除不同的對(duì)象,在整個(gè)視頻中保持每個(gè)對(duì)象的一致性對(duì)于最終輸出是至關(guān)重要的。最一致的 ID 控制方法,如 IP-Adapter,StreamingT2V,InstantID和 Vlogger,通常使用圖像編碼器(通常是 CLIP)編碼參考圖像,然后將結(jié)果整合到交叉注意力塊中。然而,由于 CLIP 是在圖像-文本對(duì)上預(yù)訓(xùn)練的,所以它的圖像embedding被設(shè)計(jì)成與文本對(duì)齊。

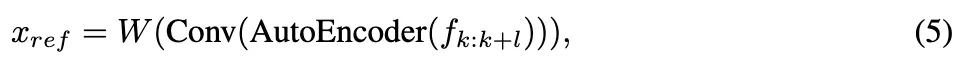

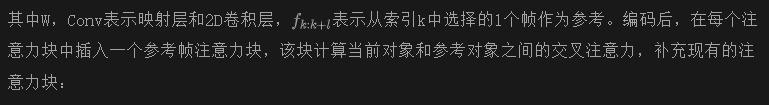

一致性控制則側(cè)重于保證同一物體在不同幀中的特征信息相似,且不涉及文本。我們假設(shè)使用 CLIP 是一種間接的方法,并提出引用框架注意來(lái)保持目標(biāo)特征的幀間一致性。形式上,首先直接對(duì)參考圖像進(jìn)行編碼,這些圖像通常是物體出現(xiàn)的初始幀,使用與預(yù)先訓(xùn)練的 T2V 模型相同的自編碼器。這保證了潛在去噪過(guò)程中的計(jì)算目標(biāo)與隱含表示空間中的參考目標(biāo)在空間上是一致的。然后我們訓(xùn)練一個(gè)2D卷積層和映射層,它們?cè)诮Y(jié)構(gòu)上與原始pipeline中的結(jié)構(gòu)相同。這一過(guò)程可以表現(xiàn)為:

評(píng)測(cè)和效果

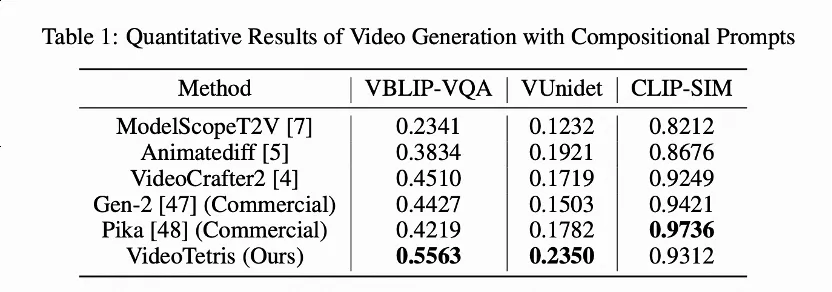

而對(duì)于這種組合生成的結(jié)果評(píng)測(cè)工作,該團(tuán)隊(duì)引入了新的評(píng)測(cè)指標(biāo) VBLIP-VQA 和 VUnidet,將組合生成評(píng)價(jià)方法首次擴(kuò)展到視頻維度。實(shí)驗(yàn)測(cè)試表明,在組合視頻生成能力上,該模型的表現(xiàn)超過(guò)了所有開(kāi)源模型,甚至是商用模型如 Gen-2 和 Pika。

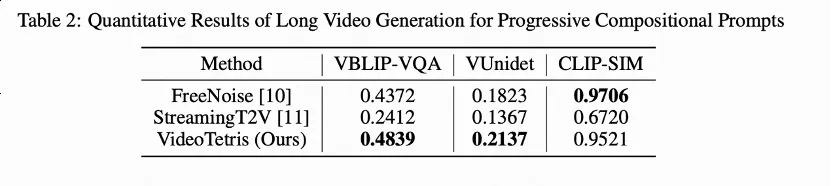

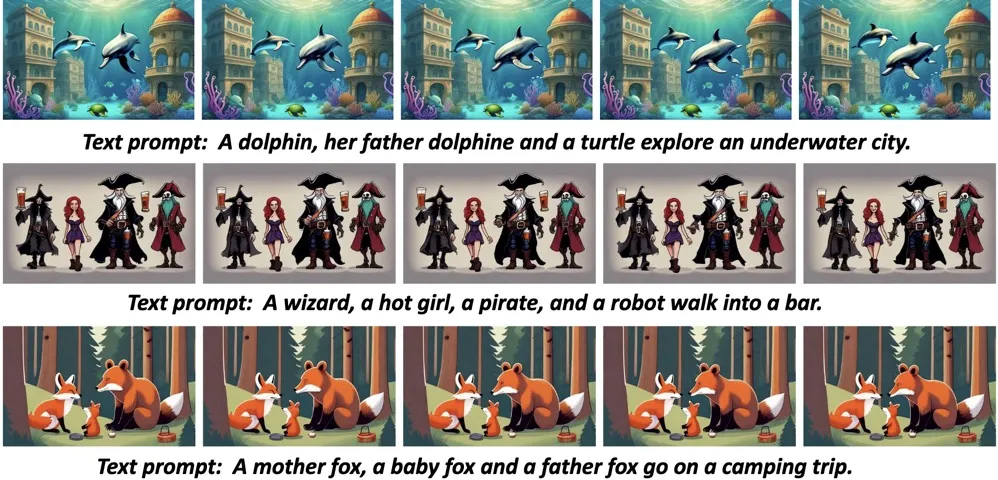

與SOTA文本到視頻模型相比,具有合成提示的視頻生成的定性結(jié)果:

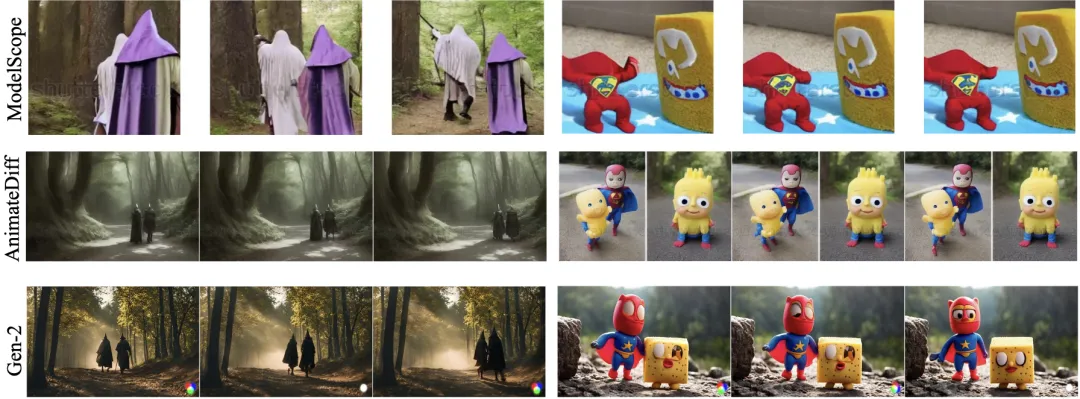

更多VideoTetris的定性結(jié)果:

更多的樣例歡迎訪問(wèn)項(xiàng)目主頁(yè):https://videotetris.github.io/

本文轉(zhuǎn)自 AI生成未來(lái),作者:Ye Tian等