效果超越ControlNet+IP-Adapter和FreeControl!Ctrl-X:可控文生圖新框架(加州大學&英偉達)

文章鏈接:https://arxiv.org/pdf/2406.07540

項目鏈接:https://genforce.github.io/ctrl-x/

最近的可控生成方法,如FreeControl和Diffusion Self-guidance,為文本到圖像(T2I)擴散模型帶來了細粒度的空間和外觀控制,而無需訓練輔助模塊。然而,這些方法針對每種類型的評分函數優化潛在embedding,并采用較長的擴散步驟,使生成過程耗時且限制了它們的靈活性和使用。

本文提出了Ctrl-X,這是一個簡單的T2I擴散控制結構和外觀的框架,無需額外的訓練或引導。Ctrl-X設計了前饋結構控制,以實現與結構圖像的結構對齊,并進行語義的外觀遷移,以促進從用戶輸入圖像進行外觀遷移。

廣泛的定性和定量實驗說明了 Ctrl-X 在各種條件輸入和模型 checkpoints 上的卓越性能。特別是,Ctrl-X支持任何形式的條件圖像的新型結構和外觀控制,與現有工作相比具有更高的圖像質量和外觀遷移,并為任何T2I和文本到視頻(T2V)擴散模型提供即插即用功能。

總結本文的貢獻如下:

- 提出了Ctrl-X,這是一個簡單的即插即用方法,基于預訓練的文本到圖像擴散模型,在生成過程中提供結構和外觀的解耦和 zero-shot 控制,無需額外的訓練或指導。

- Ctrl-X 提出了第一個支持多個條件信號(結構和外觀)和模型架構(例如文本到圖像和文本到視頻)的通用無需引導的解決方案。

- 本文的方法在條件對齊、文本圖像對齊和圖像質量方面與以往基于訓練和指導的基線(如ControlNet + IP-Adapter和FreeControl)相比表現出更好的結果。

無導向結構和外觀控制

Ctrl-X是一個通用框架,用于免訓練、無引導、zero-shot的T2I擴散,具有結構和外觀控制。給定結構圖像和外觀圖像,Ctrl-X操作一個預訓練的T2I擴散模型εθ,生成一個輸出圖像,該圖像繼承了的結構和的外觀。

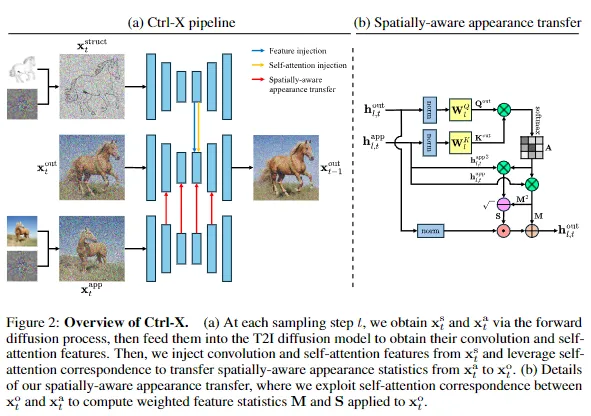

方法概述。方法如下圖2所示,并概括如下:給定干凈的結構和外觀潛變量和,首先通過擴散正向過程直接獲得噪聲結構和外觀潛變量和,然后從預訓練的T2I擴散模型中提取它們的U-Net特征。在對輸出潛變量進行去噪時,從注入卷積和自注意力特征,并利用自注意力對應關系將的空間感知外觀統計信息傳輸到,以實現結構和外觀控制。

前饋結構控制

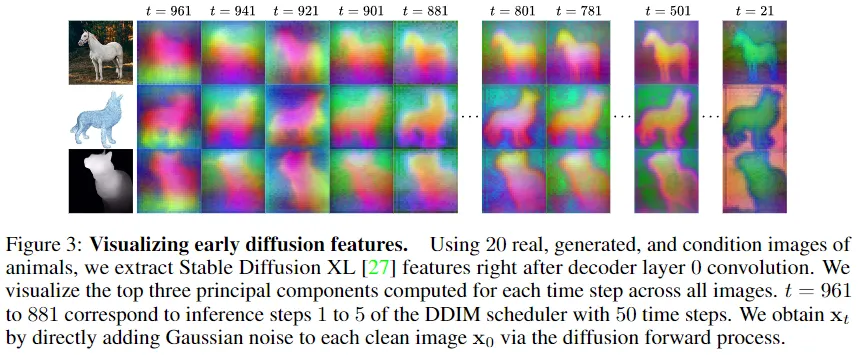

T2I擴散的結構控制需要將結構信息從轉移到,特別是在早期時間步驟中。為此,初始化,并使用和隨機采樣的ε在方程1中通過擴散正向過程獲得。受到擴散特征包含豐富布局信息的觀察的啟發,執行以下特征和自注意力注入:對于U-Net層l和擴散時間步t,令和為來自和的卷積塊后的特征/激活,并且令和為來自和的自注意力塊的注意力映射。然后,替換

與[36, 18, 24]相比,研究者們不執行反演,而是直接使用前向擴散(方程1)獲得。觀察到,通過前向擴散過程獲得的即使在非常早期/高時間步中也包含足夠的結構信息,如下圖3所示。這也減少了由FreeControl觀察到的基于反演的方法常見的外觀泄漏。

對層應用特征注入,并對層進行自注意力注入,對于(歸一化的)時間步τ,其中τ是結構控制計劃。

空間外觀遷移

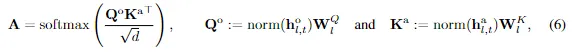

受先前定義外觀為特征統計量的工作的啟發,研究者們認為外觀遷移是一項風格化任務。T2I擴散自注意力用注意力映射A轉換值V,其中后者表示Q中的像素與K中的像素對應的方式。正如Cross-Image Attention所觀察到的那樣,當從每個圖像的特征計算Q和K時,即使兩個圖像在結構上有顯著差異,也可以表示兩個圖像之間的語義對應關系。因此,受AdaAttN的啟發,提出了空間感知外觀遷移,其中利用這種對應關系從生成自注意力加權的均值和標準差圖到規范化:對于任何自注意力層l,讓和分別為和的自注意力之前的擴散特征。然后,計算注意力映射

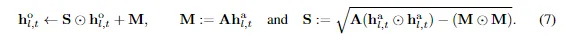

norm是應用于空間維度(hw)的。值得注意的是,我們首先對和進行歸一化,以去除外觀統計信息,從而隔離結構對應關系。然后,計算由A加權的的均值和標準差圖M和S,并使-+用它們對進行歸一化。

由和之間的結構對應加權的M和S是的空間感知特征統計量,它們被轉移到。最后,像平常一樣對執行層l的自注意力。對層應用外觀遷移,對于(歸一化的)時間步τ,其中τ是外觀控制計劃。

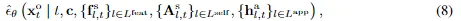

結構和外觀控制。最后,用 Equation 2 中的 εθ 替換

在這里,,和 分別對應于用于特征注入的特征,用于自注意力注入的xst注意力映射,以及用于外觀遷移的特征。

實驗

研究者們提供了大量的定量和定性結果,以展示Ctrl-X在T2I擴散上的結構保留和外觀對齊。

具有結構和外觀控制的T2I擴散

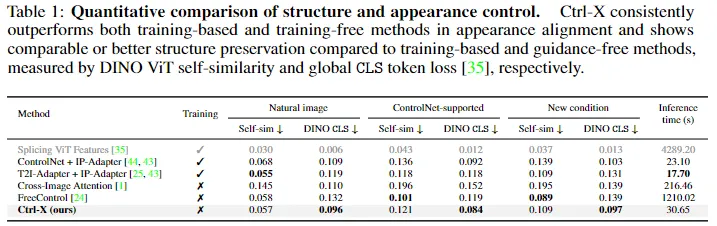

基線。對于基于訓練的方法,ControlNet 和 T2I-Adapter學習了一個輔助模塊,該模塊將條件圖像注入到預訓練的擴散模型中,以實現結構對齊。然后,將它們與IP-Adapter(用于圖像提示和外觀遷移)相結合。Splicing ViT Features針對每個源-外觀圖像對從頭開始訓練一個 U-Net,以最小化它們的 DINO-ViT 自相似性距離和全局 [CLS] token損失。

(對于基于訓練的基準不支持的結構條件,將其轉換為邊緣檢測圖。)對于基于引導的方法,FreeControl 通過從擴散特征子空間計算的反向傳播得到的分數函數來強制結構和外觀對齊。對于無指導的方法,Cross-Image Attention 操縱注意力權重以在保持結構的同時轉移外觀。盡可能在 SDXL v1.0 上運行所有方法,否則使用它們的默認基礎模型。

數據集。本文的方法支持具有外觀遷移和任意條件結構控制的T2I擴散。由于沒有針對這種靈活任務的基準,創建了一個新數據集,包含256個不同的結構-外觀對。結構圖像包括31%的自然圖像,49%的ControlNet支持的條件(如邊緣檢測、深度、分割),以及20%的野外條件(如3D網格、點云),外觀圖像是Web和生成圖像的混合。使用模板和手動注釋來制作結構、外觀和輸出文本提示。

評估指標。對于定量評估,報告了兩個廣泛采用的指標:DINO Self-sim 衡量了DINO-ViT 特征空間中結構圖像和輸出圖像之間的自相似距離,較低的距離表示更好的結構保留;DINO CLS 衡量了外觀圖像和輸出圖像之間的DINO-ViT全局 [CLS] token之間的損失,較低的損失表示更好的外觀對齊。

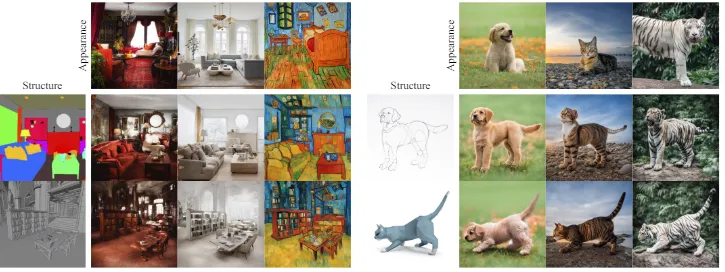

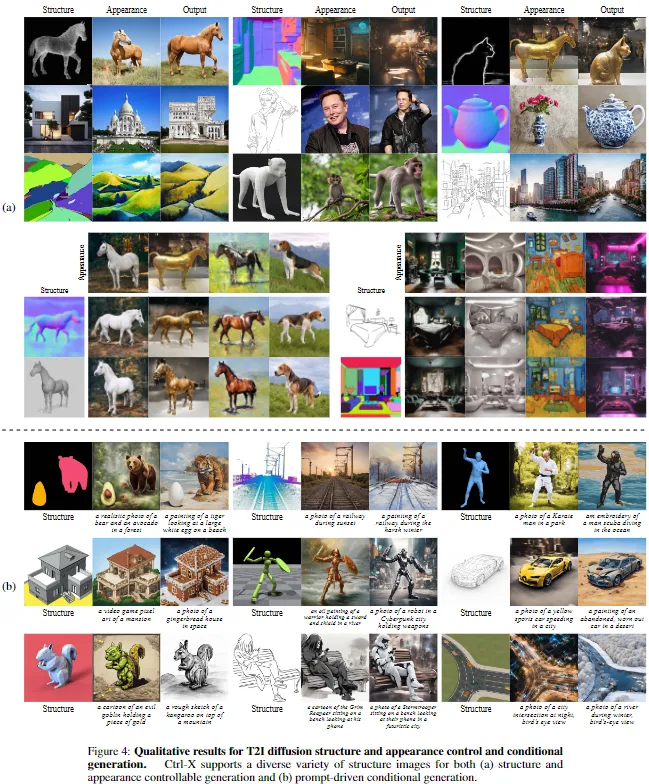

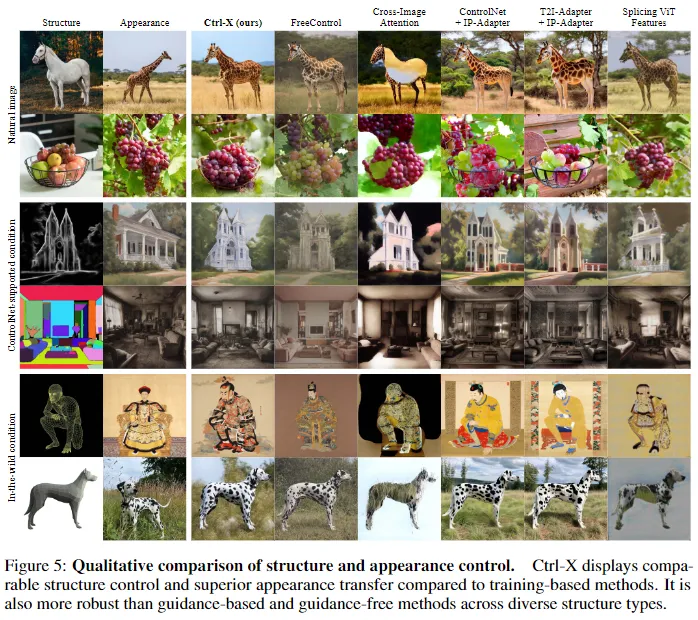

定性結果。如下圖4和圖5所示,Ctrl-X從各種結構圖像中忠實地保留了結構,包括自然圖像和ControlNet支持的條件(如HED、分割),以及野外條件(如線框、3D網格),這在先前的基于訓練的方法中是不可能的,同時靈活地從外觀圖像中轉移外觀,具有語義對應關系。

與基線方法的比較。上圖5和下表1將Ctrl-X與基線方法進行了比較。對于基于訓練和基于指導的方法,盡管T2I-Adapter和FreeControl在結構保留方面更強(較小的DINO自相似距離),但它們通常難以實現忠實的外觀遷移,并且產生更差的全局CLS損失,這在圖5的第1行和第3行特別明顯。由于基于訓練的方法將結構控制模塊(ControlNet和T2I-Adapter)與單獨訓練的外觀遷移模塊IP-Adapter 結合在一起,這兩個模塊有時會以犧牲外觀遷移為代價產生沖突的控制信號(例如第1行)—對于ControlNet來說,也包括結構保留。對于FreeControl來說,其從提取的embedding中獲得的外觀評分函數可能無法充分捕捉更復雜的外觀對應關系,再加上需要每個圖像的超參數調整,導致輸出的對比度較低,并且有時無法進行外觀遷移(例如第4行)。此外,盡管Splicing ViT Features在表1中具有最佳的DINO自相似性和CLS分數,但圖5顯示,其輸出圖像通常模糊不清,并顯示出與非自然圖像的結構圖像外觀泄漏(例如第3行、第5行和第6行)。它之所以在基準測試中表現良好,是因為其每個圖像的訓練直接最小化了這兩個指標。

與無指導基線Cross-Image Attention相比,該方法不夠穩健,對結構圖像的外觀更為敏感,因為反演的結構潛變量包含了強烈的外觀信息。這導致了結構對齊較差,并且經常出現外觀泄漏或偽影(例如第6行),從結構到輸出圖像,導致更差的DINO自相似性距離和全局CLS損失。在實踐中,發現Cross-Image Attention對其遮罩域非常敏感,并且有時無法產生具有跨模態對(例如線框到照片)的輸出。

推理效率。研究者們研究了該方法與基線方法的推理時間,所有方法都使用基礎模型SDXL v1.0,除了Cross-Image Attention(SD v1.5)和Splicing ViT Features(U-Net)。表1報告了使用單個NVIDIA A6000 GPU的平均推理時間。與基于訓練的ControlNet(1.32倍)和T2I-Adapter(1.73倍)及IP-Adapter相比,Ctrl-X稍慢一些,但明顯快于每個圖像訓練的Splicing ViT(0.0071倍)、基于指導的FreeControl(0.025倍)和無指導的Cross-Image Attention(0.14倍)。無訓練和無指導方法達到了與基于訓練的方法相當的運行時,表明了其靈活性。

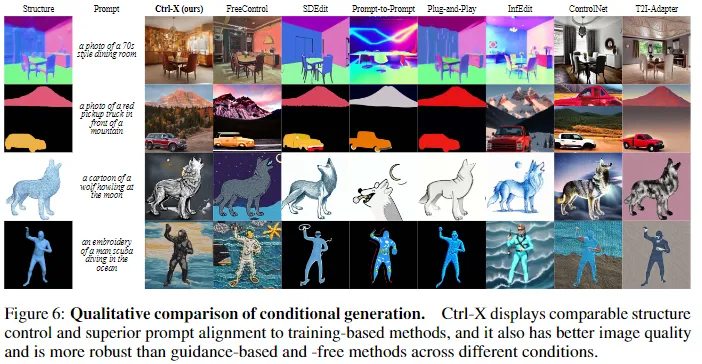

擴展到基于提示的條件生成。Ctrl-X還支持基于提示的條件生成,它生成一個符合給定文本提示的輸出圖像,并與結構圖像對齊,如前面圖4和下圖6所示。受FreeControl的啟發,Ctrl-X可以聯合生成,基于文本提示以及,其中使用方程2從xat中獲得xat?1進行去噪處理而沒有控制。

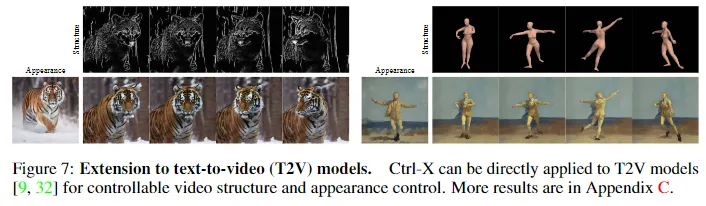

擴展到視頻擴散模型

Ctrl-X無需訓練、無需指導,并且運行時具有競爭力。因此,可以直接將方法應用于文本到視頻(T2V)模型,如下圖7所示。本文的方法將結構圖像和輸出視頻之間的結構緊密對齊,同時從外觀圖像中傳遞時間一致的外觀。

消融實驗

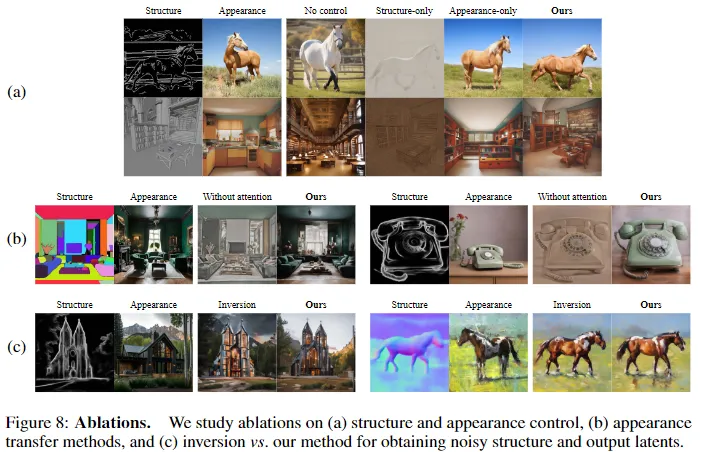

控制效果。如下圖8(a)所示,結構控制負責結構保留(僅外觀 vs. 本文的方法)。此外,僅結構控制不能夠隔離結構信息,會顯示出強烈的結構圖像外觀泄漏和低質量的輸出(僅結構 vs. 本文的方法),因為它僅僅注入了結構特征,這為外觀控制創造了語義對應關系。

外觀遷移方法。由于研究者們將外觀遷移視為一項風格化任務,比較了帶有和不帶有注意力加權的外觀統計量轉移。沒有注意力加權(相當于AdaIN)時,歸一化是全局的,因此不能考慮外觀圖像和輸出圖像之間的語義對應關系,因此輸出看起來對比度低。

反演效果。比較了DDIM反演和前向擴散(本文的方法)來獲得和,如上圖8(c)所示。在具有挑戰性的條件下(左側),反演顯示了從結構圖像中的外觀泄漏,而在其他條件下(右側)與本文的方法類似。考慮到反演成本和額外的模型推理時間,對于本文的方法來說,前向擴散是一個更好的選擇。

結論

本文提出了Ctrl-X,這是一個針對任何T2I和T2V擴散模型的結構和外觀控制的無需訓練和無需引導的框架。Ctrl-X利用了預訓練的T2I擴散模型的特征對應關系,支持任意的結構圖像條件,適用于多種模型架構,并在與基于訓練和指導的方法相比取得了競爭性的結構保留和更優異的外觀遷移,同時享受了無需指導方法的低開銷優勢。

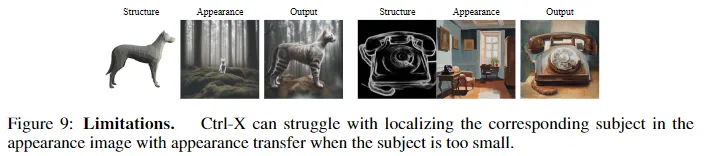

局限性。如下圖9所示,Ctrl-X的關鍵局限性在于語義外觀遷移方法可能無法捕捉到目標外觀,特別是當實例很小時,因為特征圖的低分辨率。希望本文的方法和發現能夠揭示在生成模型變得更大、更強大時,控制生成方面的新可能性和研究。

更廣泛的影響。Ctrl-X通過支持多種條件信號(結構和外觀)和模型架構,而無需額外的訓練或優化計算開銷,使可控生成變得更加易于訪問和靈活。然而,這種易用性也使得將預訓練的T2I/T2V模型用于惡意應用(例如深度偽造)變得更加容易,特別是由于可控性使用戶能夠生成特定圖像,從而引發了關于同意和為使用他們的工作作為條件圖像而給予藝術家的信用的倫理關切。針對這些安全問題,T2I和T2V模型變得更加安全。同樣,Ctrl-X可以繼承相同的安全保障措施,其即插即用的性質允許開源社區審查和改進其安全性。

本文轉自AI生成未來 ?????,作者:Kuan Heng Lin 等