?無需昂貴標注!大幅提升SDXL和SD3-Medium效果!文生圖偏好優化新寵來了

文章鏈接:https://arxiv.org/pdf/2410.18013

亮點直擊

- 合成標注偏好數據集(Syn-Pic):從不同的T2I模型生成圖像,并通過多個預訓練的獎勵模型對其進行標注,這些模型可以估計人類偏好。因此,數據收集過程中無需人工標注,使得數據收集成本更低且易于擴展。通過聚合多個獎勵模型的評分,減輕了獎勵過度優化的問題。與傳統的成對比較不同,為每個提示生成的圖像構建一個排名。雖然聚合多個人工標注者的偏好并構建排名是可行的,但這相比本文的低成本方法會顯著增加標注成本。

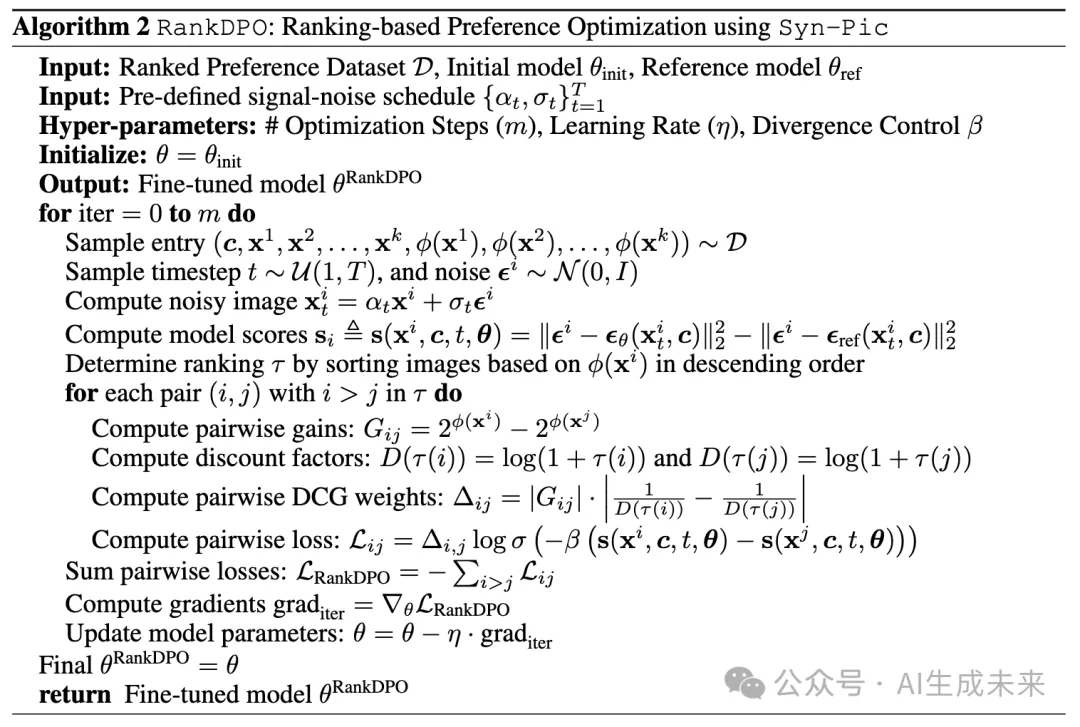

- 基于排名的偏好優化(RankDPO):為利用排名中更豐富的信號,引入了一種排名增強的DPO目標函數RankDPO,借鑒了“學習排序”領域的廣泛文獻。它使用折扣累計增益(DCG)對偏好損失進行加權,使其與首選排名對齊。

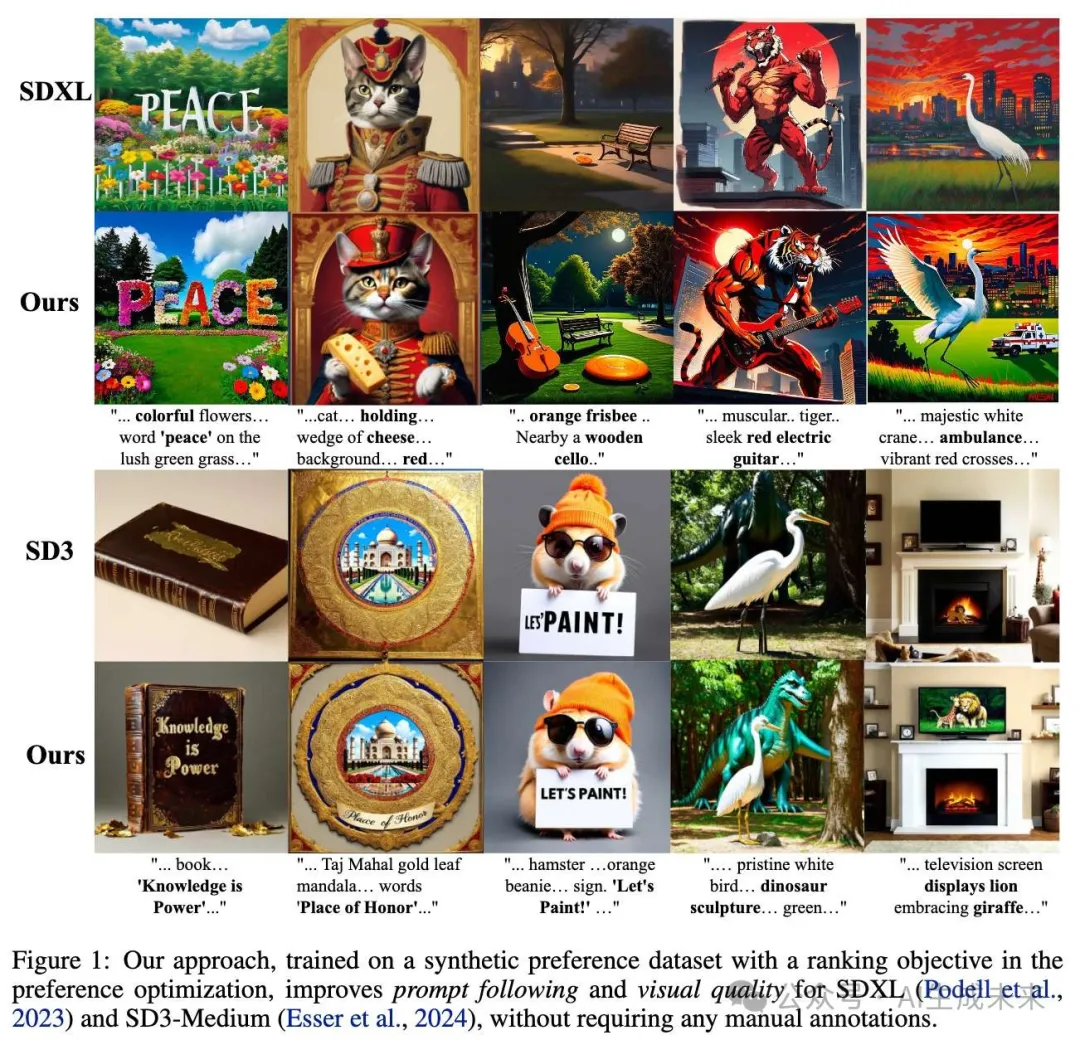

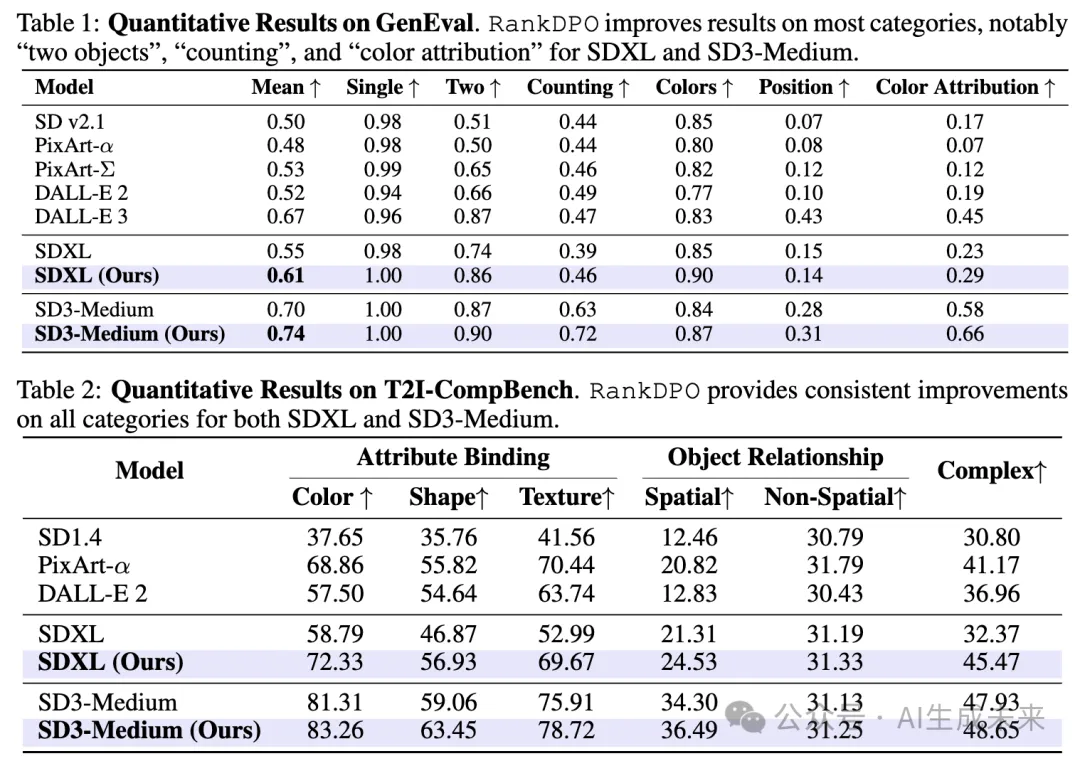

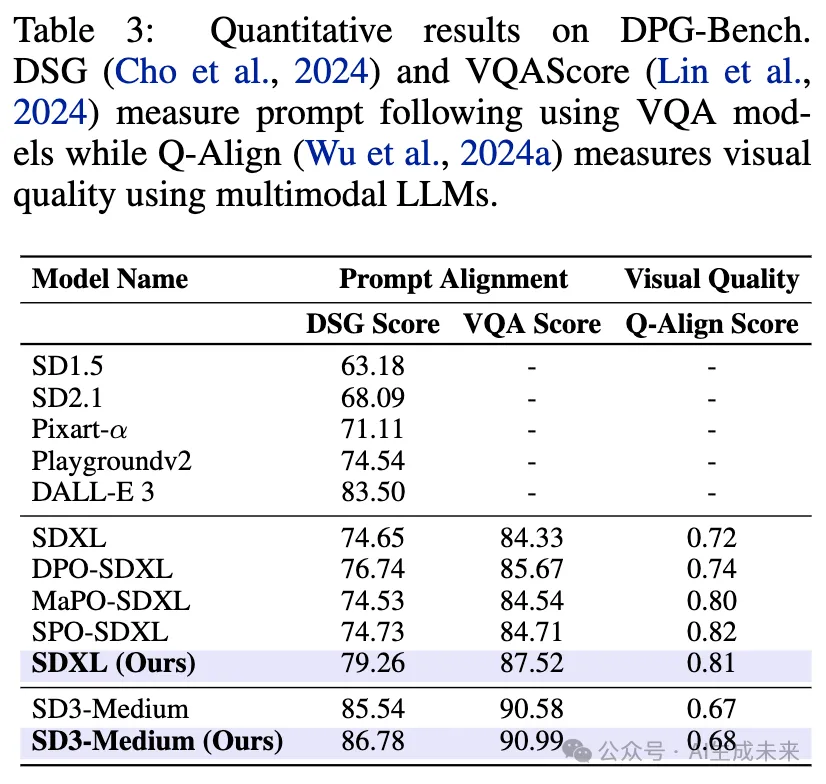

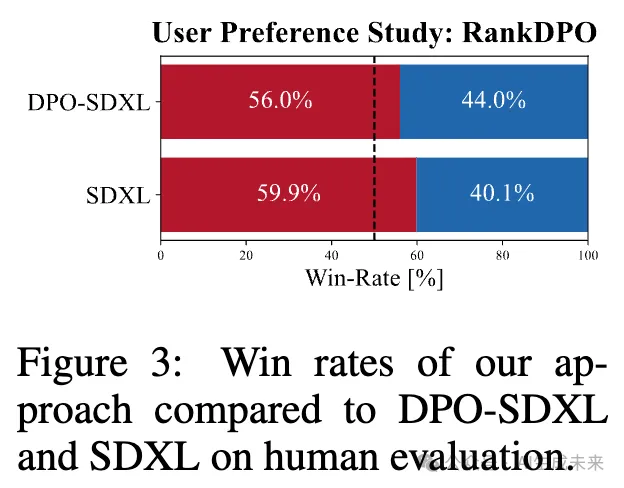

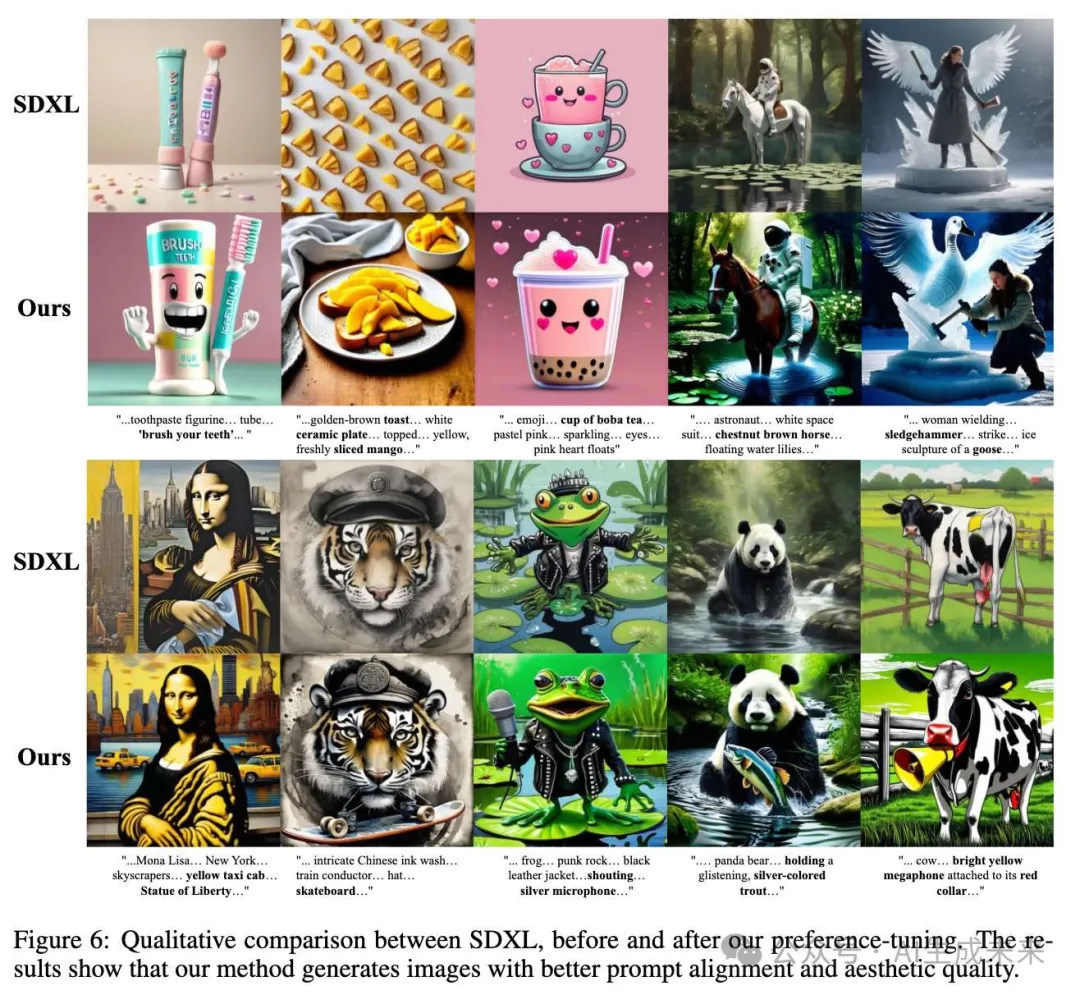

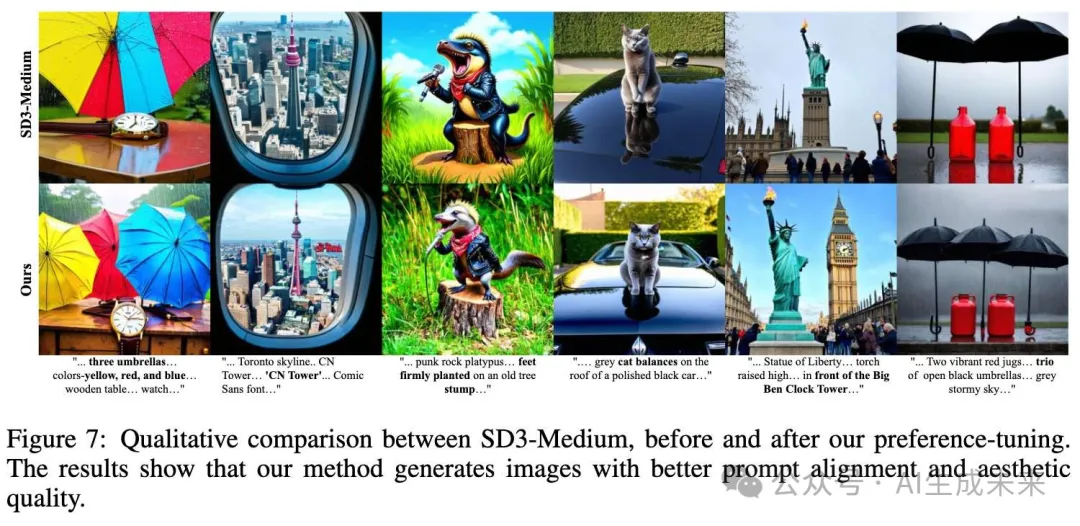

- 使用與Pick-a-Picv2相同的提示,SDXL和SD3-Medium模型的表現顯著提升。展示了在多個基準數據集上的改進結果,包括GenEval(表1)、T2I-Compbench(表2)和DPG-Bench(表3),以及用戶研究中的視覺對比(圖1中的示例和圖3)。

- 與現有的偏好優化方法相比,取得了最新的效果,例如表3。更重要的是,僅使用了Pick-a-Picv2所需圖像數量的三分之一,即表8。

- 盡管SD3-Medium(20億參數)已經通過3M個人偏好數據的DPO進行優化,但使用包含24萬圖像的Syn-Pic數據集仍能進一步實現顯著提升,例如表1、2、3。

總結速覽

解決的問題

傳統的直接偏好優化(DPO)方法依賴大量人工標注的數據集來對文本生成圖像(T2I)模型進行對齊,但這種方法成本高昂,且數據容易過時,難以適應T2I模型快速提升的需求。

提出的方案

本研究提出一種完全合成的數據集收集方法,用于DPO訓練。通過預訓練的獎勵函數生成成對圖像的偏好數據,替代人工標注,極大地提升數據集的收集效率。同時,引入RankDPO方法,通過排名反饋增強DPO訓練,提升模型的偏好學習效果。

應用的技術

采用預訓練的獎勵函數生成成對圖像的偏好數據,并在SDXL和SD3-Medium模型上應用RankDPO技術。數據集“Syn-Pic”用于支持該方法,避免人工參與標注并提供更高效的偏好數據生成方式。

達到的效果

通過使用“Syn-Pic”合成偏好數據集和RankDPO方法,顯著提升了模型的文本跟隨能力(如T2I-Compbench、GenEval和DPG-Bench基準測試)和視覺質量(通過用戶研究驗證),為開發更優質的偏好數據集、提升文本生成圖像模型的性能和安全性提供了一個實用且可擴展的解決方案。

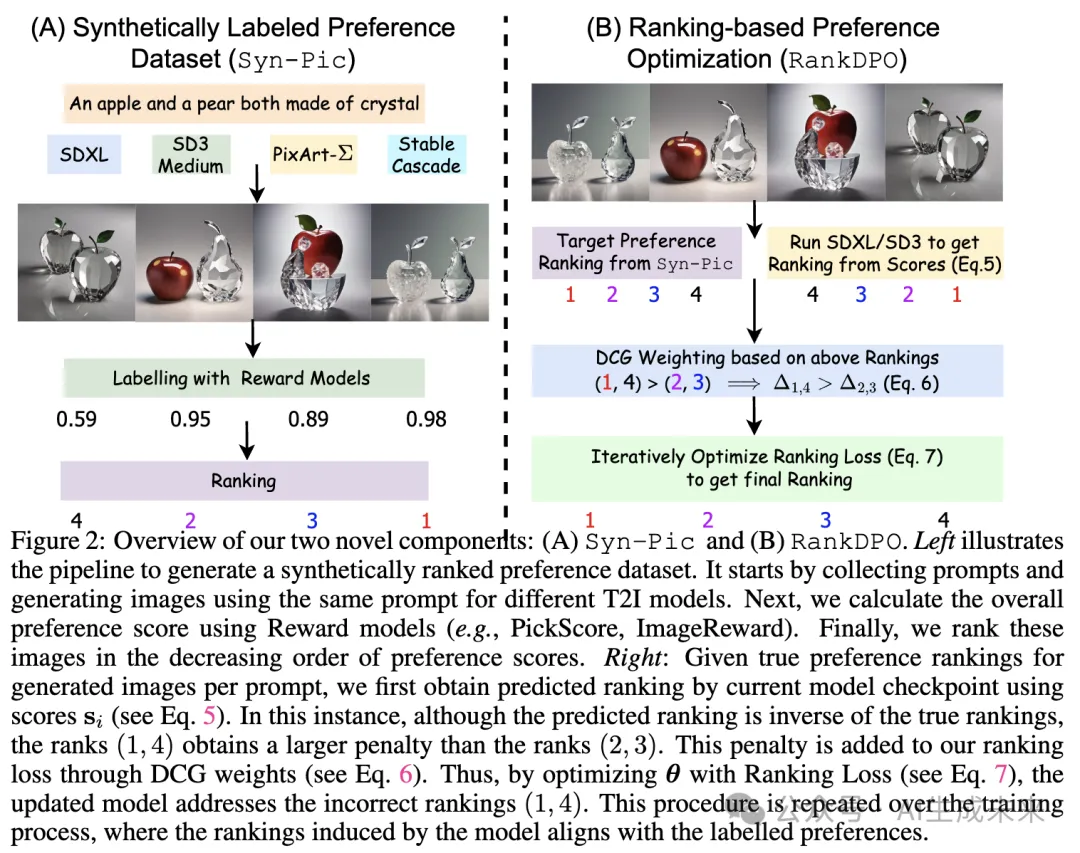

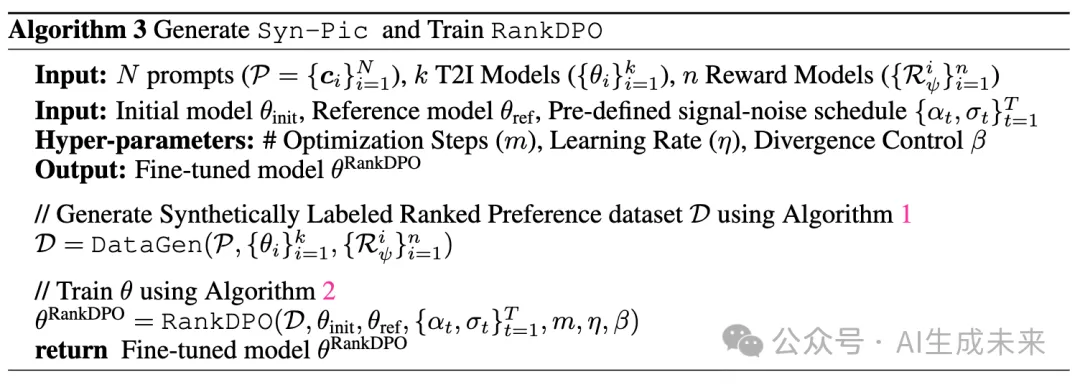

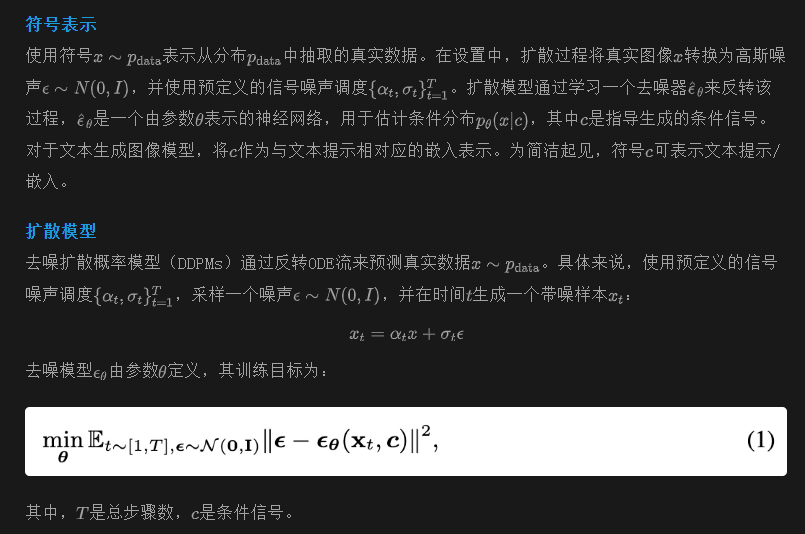

方法

本節首先概述用于文本生成圖像的擴散模型及其直接偏好優化方法。接下來,討論策劃和標注可擴展的偏好優化數據集的過程。最后,描述一種基于排名的偏好優化方法RankDPO,以利用該排序偏好數據集。下圖2中對這兩個組成部分進行了說明。算法3提供了在Syn-Pic上訓練RankDPO的偽代碼。

用于擴散模型的DPO

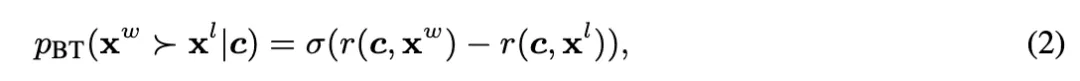

Bradley-Terry(BT)模型通過以下公式定義成對偏好:

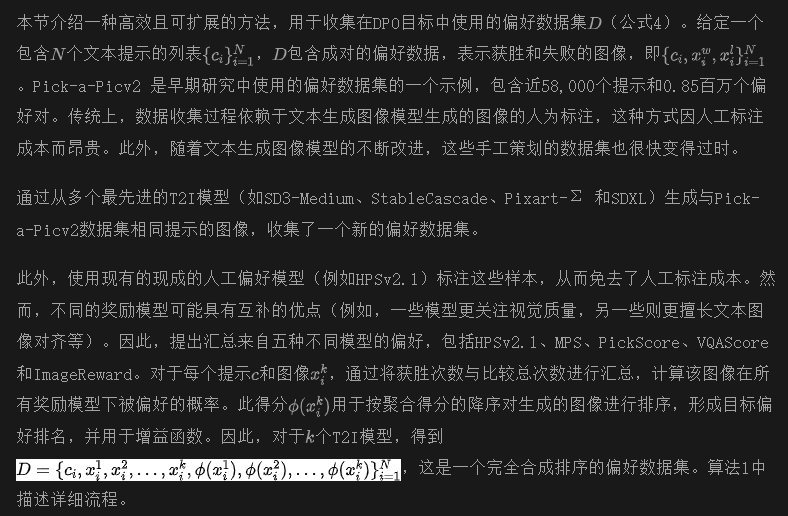

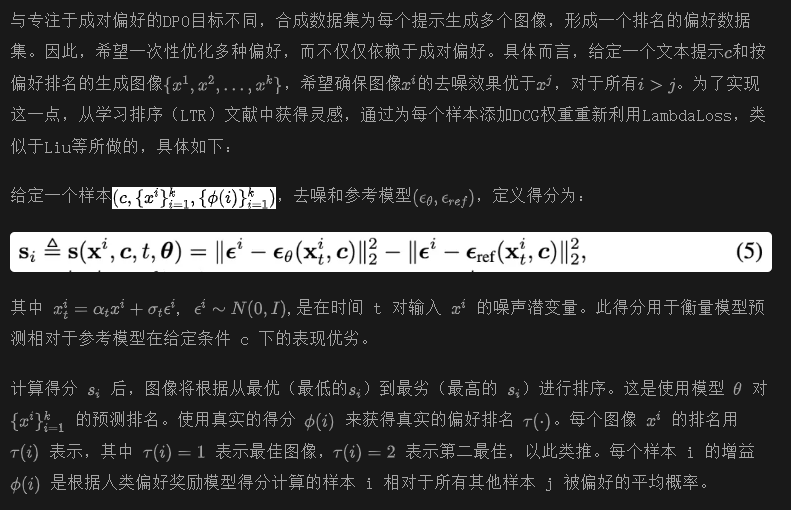

合成標注偏好數據集 (Syn-Pic)

討論

本文的數據收集方法具有以下幾個優點:

- 成本效率:可以生成任意規模的偏好數據集,因為標注環節中沒有人為參與,圖像生成和標注均使用現成的模型,從而降低數據集策劃成本。例如,收集Pick-a-Picv2數據集大約需要50000,可以以約200的成本收集一個類似規模的數據集。

- 可擴展性:隨著數據集收集成本的降低,可以針對新的文本生成圖像模型進行迭代,從而消除了由于新模型出現而導致舊偏好數據集過時的問題。

- 基于排名的偏好優化:由于每個提示運行多個T2I模型,因此收集到的是一個排名的偏好列表,而不僅僅是早期數據集中成對的數據。這能夠在偏好優化中探索排名目標。

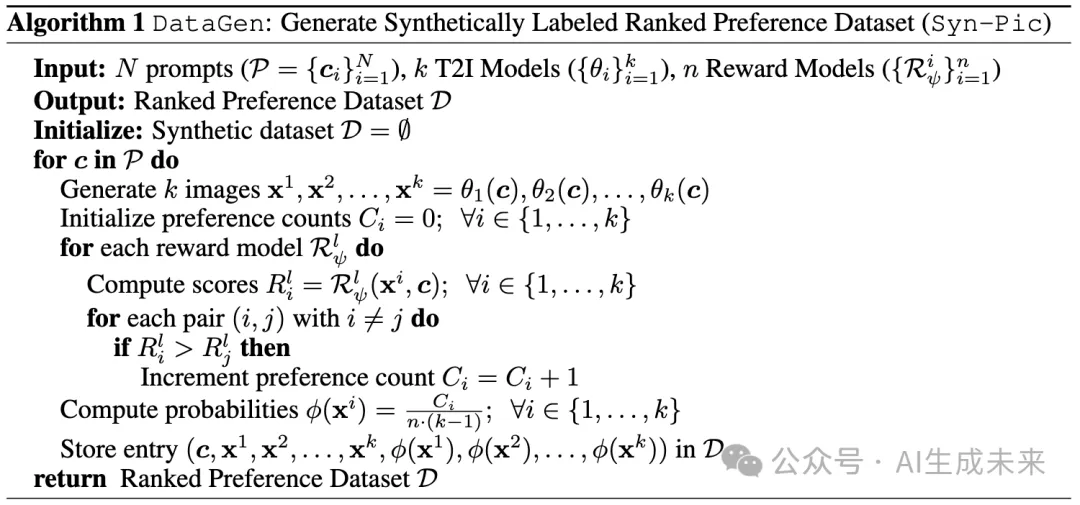

基于排名的偏好優化 (RankDPO)

該損失函數不僅鼓勵模型滿足成對的偏好,還要尊重為相同提示生成的圖像的整體排名。通過使用從排名中獲得的增益和折扣來加權傳統的 DPO 目標,確保模型根據排名優先生成質量更高的圖像,從而在美學和提示對齊方面實現更一致的改進。

實驗

實施細節實驗中使用開源的 SDXL和 SD3-Medium 模型。從 Pick-a-Picv2 收集了 58K 個提示,并使用四個模型,即 SDXL、SD3-Medium、Pixart-Σ 和 Stable Cascade,準備了 Syn-Pic 數據集。在 8 張 A100 GPU 上訓練 RankDPO,持續 16 小時,批次大小為 1024,訓練 400 步。

比較結果

短提示在前面表 1 中,報告了 GenEval上的結果。RankDPO 在幾乎所有類別上都持續改善了性能,使得 SDXL 的平均性能從 0.55 提高到 0.61,SD3-Medium 的平均性能從 0.70 提高到 0.74。特別是觀察到在“兩個物體”、“計數”和“顏色歸屬”等方面有顯著提升,增幅近 10%。在前面表 2 中的 T2I-Compbench中,也觀察到了類似的趨勢,其中 SDXL 在“顏色”和“紋理”上提升超過 10%,并在其他類別中也有改進。

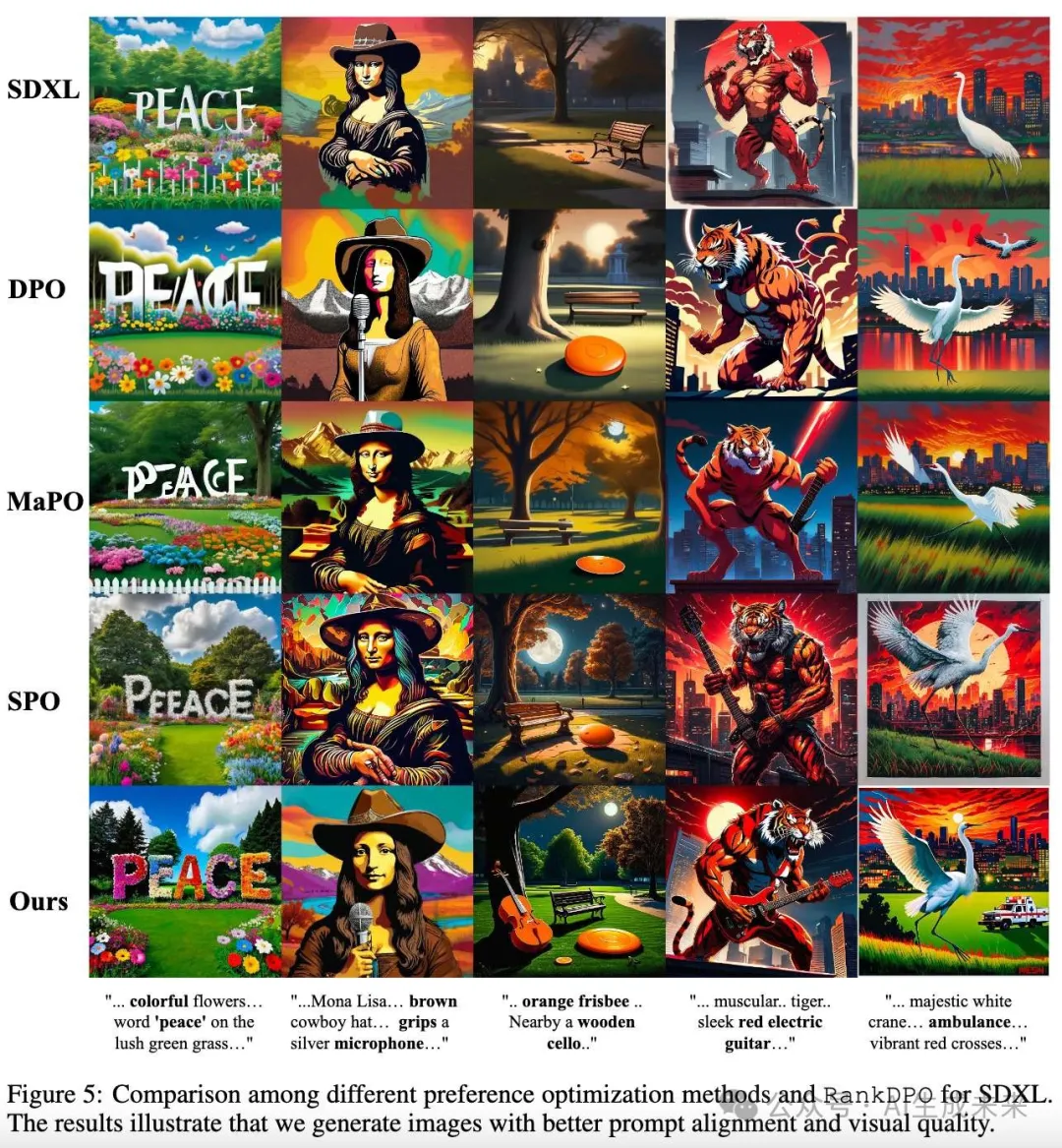

長提示在前面表 3 中,進一步在 DPG-Bench上評估了模型的視覺質量和提示對齊性,該基準包含長且詳細的提示。為了測量提示對齊性,使用了原始 DSG 指標和 VQAScore,而對于視覺質量,使用了 Q-Align 模型。

Diffusion-DPO(標記為 DPO-SDXL)在 Pick-a-Picv2 上訓練,能夠在提示對齊性方面提供有意義的改進,而對 SDXL 進行 MaPO和 SPO的微調(標記為 MaPO-SDXL 和 SPO-SDXL)則提高了視覺質量。然而,盡管 RankDPO 僅在合成偏好上進行訓練,但所有指標都有顯著提升(例如,SDXL 的 DSG 得分從 74.51 提高到 79.26,Q-Align 得分從 0.72 提高到 0.81),并達到了最新的提示對齊指標。對于 SD3-Medium,在使用RankDPO 進行微調后,繼續看到模型性能的提升。

用戶研究

為了進一步驗證本文方法的有效性,在 DPG-Bench 上對 450 個提示進行了用戶研究。要求用戶根據他們的整體偏好(即結合文本與圖像的對齊性和視覺質量)選擇更好的圖像。前面圖 3 顯示,RankDPO 的勝率優于 DPO-SDXL和 SDXL,這表明其在提高生成圖像整體質量方面的有效性。

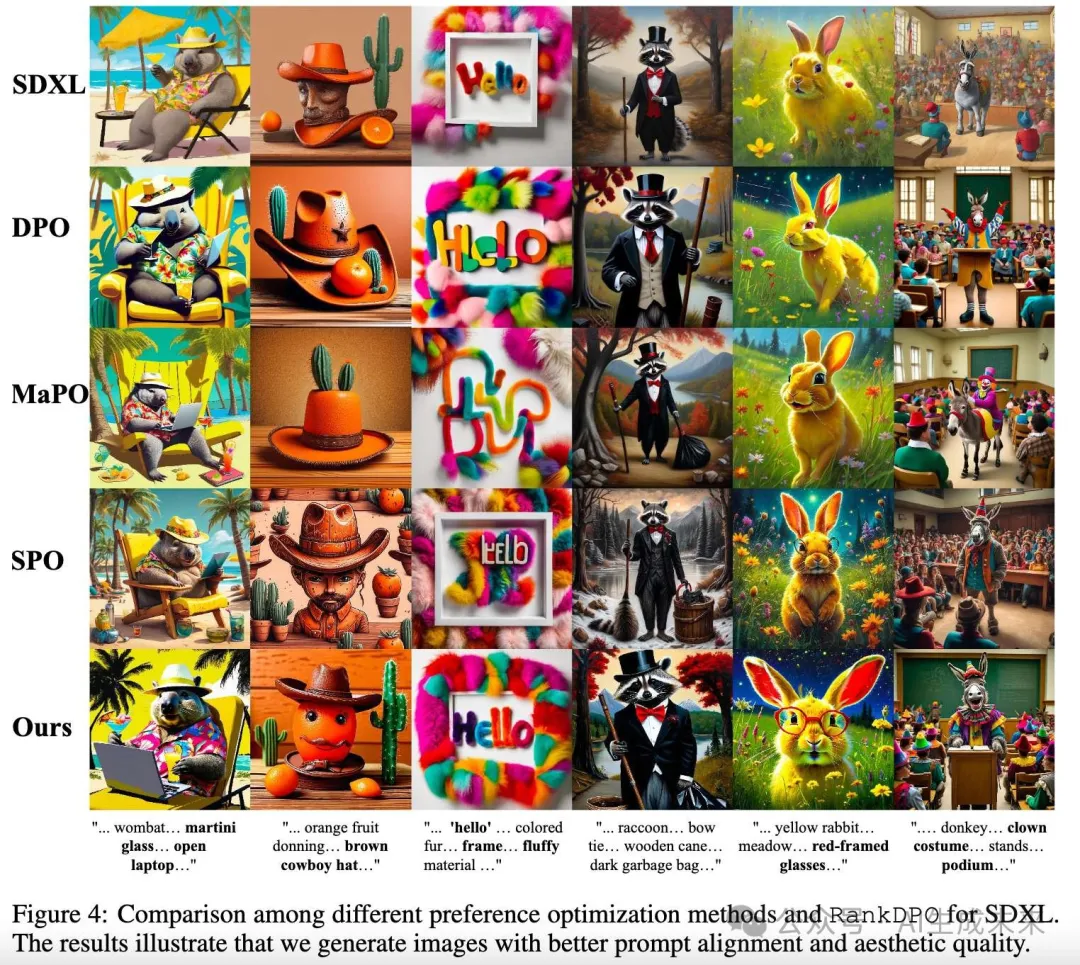

下圖 4 中展示了來自 DPG-Bench的提示的定性示例。與基礎 SDXL 和其他偏好調整模型相比,RankDPO 在文本渲染方面有顯著改進,能夠捕捉到所有提示中描述的對象,而其他模型則遺漏了這些對象,并且在圖像中對對象之間復雜關系的建模更佳。

計算成本討論

需要 10 個 A100 GPU 天來生成圖像并標注偏好,這是一次性成本。在生成數據上運行 RankDPO 進行 400 步訓練,SDXL 在 10242 像素下大約需要 6 個 GPU 天。相比之下,現有的獎勵優化方法在較小的 SD1.5 模型(5122 像素)上需要 64-95 個 A100 GPU 天。類似地,與 Diffusion-DPO相比,RankDPO 在三分之一的數據上訓練,同時避免了手動整理的偏好。還有一些通過使用文本編碼器(如 T5/LLaMA 模型)來增強文本到圖像模型的方法,這些方法需要 1000 萬到 3400 萬個密集標注的圖像,并訓練 50-120 個 A100 GPU 天。

消融分析

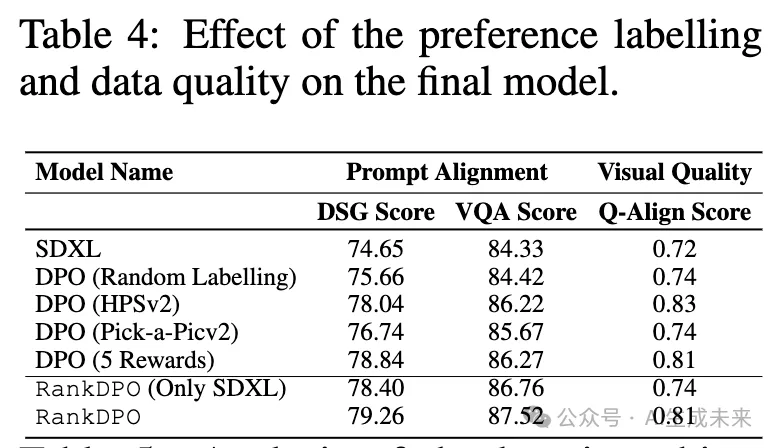

數據和標注函數的影響由于生成偏好是 RankDPO 的關鍵方面,在下表 4 中評估了不同的標注選擇。嘗試隨機標注,即隨機選擇偏好并應用 DPO。這僅能提供有限的性能提升(從 74.65 提升至 75.66 的 DSG 得分)。還展示了來自單一獎勵模型(HPSv2.1)的成對偏好的結果,以及從 5 個模型中平均偏好的結果。雖然 HPSv2.1 對提示對齊和視覺質量都提供了良好的改進,但跨多個模型的預測集成進一步提高了結果。這些結果優于應用于 Pick-a-Picv2 的 DPO,突顯了在構建偏好數據集時圖像質量的重要性。最后,調查了用于構建 Syn-Pic 的不同模型的影響。這是通過僅更改種子,構建與 SDXL 圖像相似的數據集來完成的。雖然在提示對齊方面幾乎得到了相同的改進,但在視覺質量上只看到了小幅提升。這表明,合成偏好調優可以應用于任何模型的輸出,但使用不同模型生成的圖像可以進一步改善結果。

學習目標分析偏好優化的一個關鍵方面是學習目標的選擇,在上表 4 中進行各種實驗進行比較。除了常規的 DPO 公式外,一些研究表明,在經過精心挑選的高質量數據上進行監督微調的好處,也將其納入比較。基線包括以下幾種方法:

- 監督微調:從每對比較中選擇獲勝的圖像,并在此子集上對 SDXL 進行微調。

- 加權微調:在所有樣本上對 SDXL 進行微調,但根據 HPSv2.1 分數為每個樣本分配權重,類似于 Lee et al.。

- DPO + 增益函數加權:通過使用增益函數對樣本加權,可以改善 DPO 目標。

可以看到,RankDPO 實現了最佳結果,突顯了基于成對偏好的排名標準的整合對增強偏好優化的好處。

結論與討論

本文提出了一種強大且具有成本效益的文本到圖像模型偏好優化方法。具體而言,展示了如何通過合成生成偏好優化數據集來收集更優的信號(例如,排名與成對偏好、跨模型集成偏好)。還提出了一種簡單的方法來利用更強的信號,從而在多個基準測試中實現了針對提示跟隨和視覺質量的最新結果,無論是在擴散模型還是修正流模型中。希望本文的工作為未來在文本到圖像模型上擴展有效的后期訓練解決方案鋪平道路。

本文轉自AI生成未來 ,作者:AI生成未來