加州大學伯克利分校等發表的RouteLLM:利用偏好數據學習路由大語言模型

一、結論寫在前面

論文標題:RouteLLM: Learning to Route LLMs with Preference Data

論文鏈接:??https://arxiv.org/pdf/2406.18665v2??

LLM在廣泛的任務中展現出令人印象深刻的能力,然而在選擇使用哪個模型時,往往需要在性能和成本之間做出權衡。更強大的模型雖然有效,但成本更高,而能力較弱的模型則更具成本效益。

為了解決這一難題,論文提出了幾種高效的路由模型,這些模型在推理過程中動態選擇更強大或較弱的LLM,旨在優化成本與響應質量之間的平衡。論文開發了一個利用人類偏好數據和數據增強技術的訓練框架來提升這些路由器的性能。

論文在廣泛認可的基準測試中評估了論文的方法,結果顯示,論文的方法在某些情況下顯著降低了成本——超過2倍——同時不犧牲響應質量。論文的結果還突出了數據集增強在提高路由器性能方面的有效性。僅在Arena數據集上訓練路由器會導致在MMLU和GSM8K上的性能不佳,而通過使用LLM判斷或領域內數據增強訓練數據,論文的路由器能夠在所有基準測試中超越隨機基線。當訓練數據與評估數據高度相似時,性能提升最大,這一點由基準數據集相似性得分所表明。論文相信,這一框架為特定用例提升路由性能提供了一條清晰且可擴展的路徑。

盡管論文的工作展示了強大的成果,但仍存在一些局限性。首先,雖然論文在多樣化的基準測試上進行了評估,但現實世界的應用可能與這些基準存在顯著差異。其次,雖然本工作聚焦于雙模型路由設置,但未來的一個有前景的方向是將此工作擴展到多模型等等。

?二、論文的簡單介紹

2.1 論文的背景?

LLMs的最新進展在廣泛的天然語言任務中展示了卓越的能力。從開放式對話和問答到文本摘要和代碼生成,LLMs展示了令人印象深刻的流暢性和理解能力。這一快速進步得益于架構創新,如Transformer架構,以及在擴展數據和訓練基礎設施方面的改進。

然而,并非所有大型語言模型(LLMs)都一視同仁——LLMs在成本和規模上存在顯著差異,其規模可以從十億到數千億參數不等。LLMs在訓練數據方面也各不相同,這進而導致了不同模型在優勢、劣勢和能力上的差異。總體而言,規模較大的模型往往能力更強,但成本也更高;而規模較小的模型雖然能力較弱,但部署成本更為低廉。

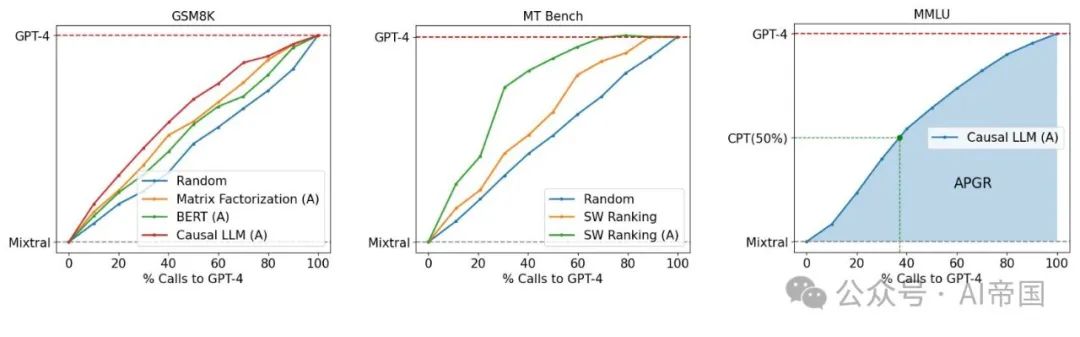

圖1:GPT-4與Mixtral-8x7B在路由性能/成本之間的權衡。(左)論文展示了在OOD評估GSM8K上優于隨機基線的幾種路由器。(中)論文通過數據增強(標記為(A))在MT Bench上展示了路由器性能的提升。(右)論文展示了主要考慮的指標:調用性能閾值(CPT,以綠色表示)和平均性能增益恢復(APGR,以藍色陰影區域表示)

這一異構環境在實際部署LLM于現實應用中提出了一個難題。雖然將所有用戶查詢路由到最大、最有能力的模型可以確保高質量的結果,但這成本高昂。相反,將查詢路由到較小的模型可以節省成本——高達50倍以上(例如,Llama-3-70b對比GPT-4,或Claude-3 Haiku對比Opus-)——但可能導致響應質量較低,因為較小的模型可能無法有效處理復雜查詢。

為此,LLM路由是解決這一問題的有前景的方案,其中每個用戶查詢首先由一個路由器模型處理,然后決定將查詢路由到哪個LLM。這有可能將較簡單的查詢路由到較小的模型,將較困難的查詢路由到較大的模型,優化模型響應質量同時最小化成本。然而,最優LLM路由——定義為在給定成本目標下實現最高質量或在給定質量目標下最小化成本——是一個具有挑戰性的問題。一個強大的路由器模型需要推斷傳入查詢的意圖、復雜性和領域,并理解候選模型的能力,以將查詢路由到最合適的模型。此外,路由器模型需要經濟、快速且適應不斷演變的模型環境,其中不斷引入具有改進能力的新模型。

論文提出了一種基于原則的大型語言模型(LLM)間查詢路由框架。如圖1所示,論文的設置涉及學習在更強的模型和較弱的模型之間進行路由。論文的目標是通過智能地將簡單查詢路由到較弱的模型,并將復雜查詢保留給較強的模型,以最小化成本同時達到特定的性能目標,例如達到較強模型性能的90%。論文開發了一種利用人類偏好數據和數據增強技術的路由系統訓練框架。

?2.2 LLM路由

2.2.1 問題定義?

考慮一組N個不同的LLM模型 ( M = {M_1, M_2, ..., M_N} )。每個模型 ( M_i ) 可以抽象為一個將查詢映射到答案的函數。路由函數 ( R) 是一個 ( N ) 路分類器,它接收一個查詢 ( q ) 并選擇一個模型來回答 ( q ),答案為 ( a )。路由的挑戰在于在提高響應質量和降低成本之間實現最佳平衡。假設論文有權訪問偏好數據: ( D_pref = {(q, l_i,j) | q ∈ Q, i, j ∈ N, l_i,j ∈ C} ),其中 ( q ) 是一個查詢, ( l_i,j ) 是一個標簽,表示在 ( q ) 上比較 ( M_i ) 和 ( M_j ) 的質量結果。區分獎勵建模 和路由至關重要。獎勵建模在LLM生成響應后評估其質量,而路由要求路由器在看到響應之前選擇適當的模型。這需要深入理解問題的復雜性以及可用LLMs的優勢和劣勢。

論文專注于兩種模型類別之間的路由問題:(1) 強模型(M_strong),由能夠生成高質量響應但成本較高的模型組成。這一類別主要包含最先進的閉源模型,如GPT-4。(2) 弱模型(M_weak),由質量相對較低且成本較低的模型組成,例如Mixtral-8x7B。這種二元路由問題在實踐中相當常見,特別是當LLM應用的開發者努力平衡質量和成本時。此外,解決這一問題構成了解決更一般的N路路由問題的基礎。

論文提出了一種基于原則的框架,用于從偏好數據中學習一個二元路由函數R,以在M_weak和M_strong之間進行路由。為此,論文定義了R,它包含兩個組成部分:

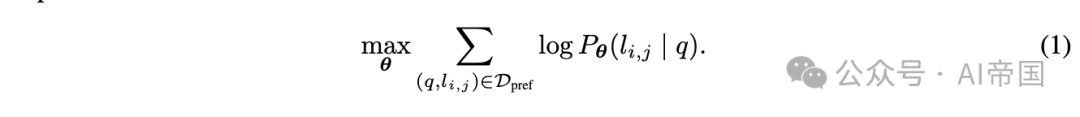

(1) 勝出預測模型,該模型預測強模型Mstrong的勝出概率。在論文的二元分類設置中,這一概率捕捉了兩類模型的勝/負概率。論文可以在偏好數據上使用最大似然估計來學習該模型的參數:

通過在偏好數據上學習勝出概率,論文捕捉了兩類模型在各種查詢上的優勢和劣勢。論文提出了幾種參數化勝出預測模型的方法。

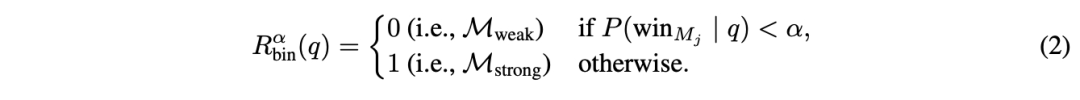

(2)成本閾值,它將勝出概率轉換為在M_strong和M_weak之間的路由決策。給定一個查詢q,路由決策表述為:

閾值 控制質量與成本的權衡:較高的閾值施加更嚴格的成本約束,減少開支但可能犧牲質量。

最后,論文將路由器的響應表示為 M_R,它代表根據路由器決策由弱模型或強模型生成的響應。

2.2.2 評估指標

論文定義了捕獲LLM路由問題中成本與質量之間權衡的評估指標。論文首先獨立評估給定R的質量和成本效率的指標,然后引入兩個復合指標,這些指標將用于論文的實驗評估。

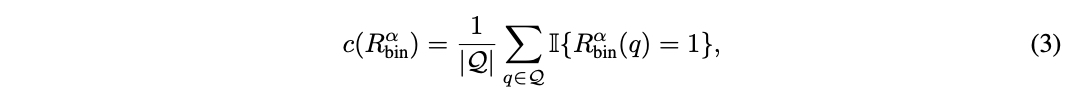

對于成本效率,論文計算調用強模型的百分比:

因為強模型的成本顯著高于弱模型。

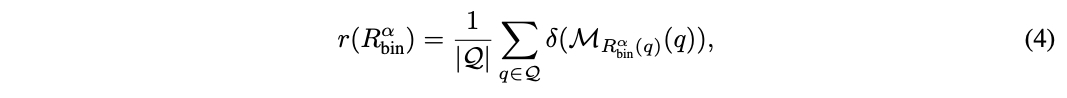

對于質量,論文在評估集 Q 上測量平均響應質量:

該評分可以是預定義指標在黃金標注數據集(例如 MMLU)中測量響應正確性的結果,或者是數值標簽(例如 1-5 或 1-10),其中較高值表示質量更好。

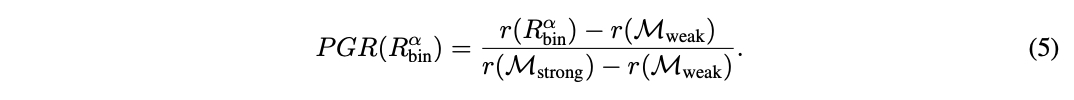

鑒于 R的性能介于弱模型和強模型之間,論文通過量化路由器相對于兩者模型性能差距的表現來定義總體性能增益(PGR):

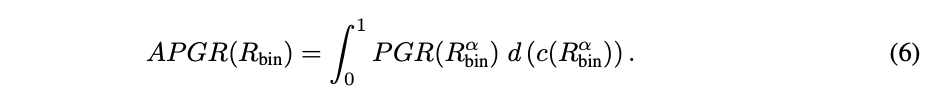

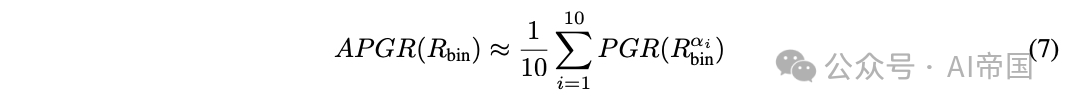

這兩個指標單獨都不充分,因為它們沒有捕捉到路由中的質量-成本權衡。例如,一個將每個查詢都發送到強模型的簡單路由器可以實現完美的 PGR = 1,而沒有任何成本降低。因此,論文通過改變閾值計算路由器 R的調用-性能圖。論文定義平均性能差距恢復(APGR)作為在不同成本約束下路由器恢復性能差距的總體度量:

在圖 1-(右) 中,APGR 由路由器性能曲線與弱模型性能之間的區域表示。實際上,論文將調用百分比區間 [0%, 100%] 離散化為 { c_i }_i∈[1,10]。對于每個 c_i,論文確定滿足成本約束的截止閾值。論文使用以下公式近似 APGR:

在許多實際應用中,量化達到某個性能水平所需的成本是很重要的。因此,論文定義了第二個指標,稱為調用-性能閾值(CPT)。給定所需的路由器性能(以x%的PGR衡量),CPT(x%)指的是獲得所需PGR所需的對強模型調用的最小百分比。

在圖1-(右)中,虛線綠線表示CPT(50%),即達到50% PGR的期望性能所需的對GPT-4的調用百分比;在這里,CPT(50%) ≈ 37%。

?2.3 方法論

2.3.1 偏好數據?

論文首先描述如何獲取用于訓練路由函數的偏好數據。論文主要使用來自在線Chatbot Arena平臺[10]的80k對戰數據。在該平臺上,用戶通過聊天機器人界面提交自選提示。提交后,他們會收到兩個匿名模型的響應,并投票選出獲勝模型或平局。由此產生的數據集,記為D_arena = {(q, M_i, M_j, l_i,j) | q ∈ Q, M_i, M_j ∈ A, l_{i,j} ∈ C},包含用戶查詢、兩個模型的回答M_i、M_j以及基于人類判斷的成對比較標簽。

使用原始Chatbot Arena數據的一個主要問題是標簽稀疏性。例如,任意兩個模型之間的比較標簽平均占比不到0.1%。因此,論文按如下方式推導用于訓練路由器的偏好數據:首先,論文通過將D_arena中的模型聚類成10個不同等級(見附錄A)來減少標簽稀疏性,使用每個模型在Chatbot Arena排行榜上的Elo評分,并通過動態規劃盡量減少每個等級內的變異。論文選擇第一和第二等級的模型來代表強模型M_strong,第三等級的模型代表弱模型M_weak。雖然論文主要在跨這些等級對戰上進行訓練,但也利用涉及其他模型等級的對戰來規范論文的學習方法。關鍵的是,論文省略了D_arena中的實際模型響應,僅保留模型身份。比較標簽l_i,j仍然提供了關于LLM M_i和M_j在不同類型和復雜度查詢q上的相對能力的洞察。

2.3.1.1數據增強

即使在將模型分類到等級后,不同模型類別間的用戶偏好信號仍可能相當稀疏。正如論文在第4.1節中討論的,這可能阻礙泛化,尤其是對于參數龐大的模型。因此,論文探索了兩種數據增強方法:

黃金標注數據集:論文通過形式為D_gold的數據集來增強訓練數據。此類數據集的一個例子是MMLU基準。論文通過簡單比較M_i的響應來計算l_g,用于增強。

LLM-judge-labeled 數據集:論文探索在開放式目的聊天領域使用 LLM 判斷[30]獲取偏好標簽,因為它已證明與人類判斷高度相關。給定一組用戶查詢,論文首先從 M_strong 中的強模型和 Mweak 中的弱模型生成響應,然后使用 GPT-4 作為判斷生成成對比較標簽。這種方法的主要挑戰是大量收集 GPT-4 響應和成對比較的高成本。幸運的是,Nectar 數據集[31]提供了多種查詢及其對應的模型響應。論文通過選擇帶有 GPT-4 響應(作為 M_strong 的代表)的查詢,并在此基礎上生成 Mlixtral-8x7B(作為 M_weak 的代表)的響應,顯著降低了成本。最后,論文獲得了成對比較標簽。

2.3.2 路由方法

論文現在詳細介紹從偏好數據 D_pref 學習勝預測模型 P的方法。

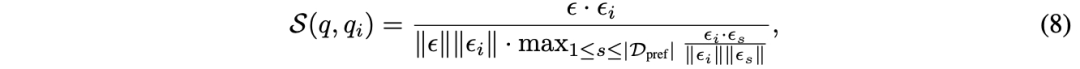

相似性加權(SW)排名 論文采用類似于[10]的 Bradley-Terry(BT)模型。給定用戶查詢 q,論文為訓練集中的每個查詢計算權重,基于其相似性。

論文通過以下方式學習 BT 系數 (代表 10 個模型類別):

其中 l是二元交叉熵損失。對于此路由模式,不需要訓練,求解在推理時進行。

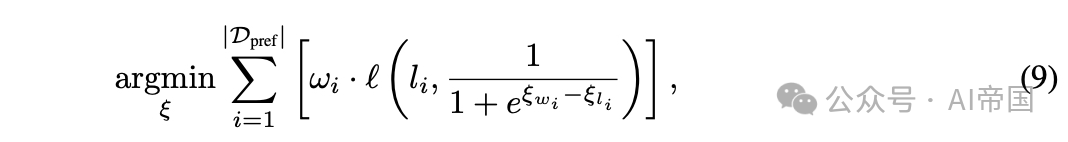

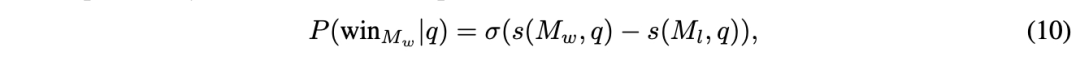

矩陣分解 受推薦系統中矩陣分解模型[18, 25]的啟發,這些模型用于捕捉用戶-物品交互的低秩結構,論文利用這種方法對偏好數據進行訓練。關鍵在于揭示一個隱藏的評分函數 。評分 ( s(M_w, q) ) 應當表示模型 ( M_w ) 對查詢 ( q ) 的回答質量,即如果模型 ( M_w ) 在查詢 ( q ) 上優于模型 ( M_l ),則 ( s(M_w, q) > s(M_l, q) )。論文通過使用BT關系建模獲勝概率來強化這種關系:

論文在偏好數據上優化這一關系。論文將評分函數 ( s ) 建模為模型和查詢的雙線性函數,并將模型身份 ( M ) 嵌入到一個 ( d_m ) 維向量 ( v_m ) 中,將查詢嵌入到一個 ( d_q ) 維向量 ( v_q ) 中;

這種方法本質上是在集合上學習評分矩陣的矩陣分解。論文使用8GB GPU對模型進行10個周期的訓練,批次大小為64,采用學習率為3 x 10^-4、權重衰減為1 x 10^-5的Adam優化器。

BERT分類器 在此,論文探索使用一種標準文本分類方法,該方法的參數數量較之前的方法更多。論文采用BERT-base架構,為用戶的查詢提供上下文嵌入,并定義勝率概率為:

因果LLM分類器 論文最終通過使用Llama 3 8B參數化來擴展論文路由器的能力。論文采用指令遵循范式[28],即論文提供包含用戶查詢的指令提示作為輸入,并以下一詞預測方式輸出獲勝概率,而不是使用單獨的分類頭。值得注意的是,論文將比較標簽作為額外詞匯追加,并計算標簽類別C上的softmax作為獲勝概率。

2.4 實驗?

訓練數據:論文主要使用80K聊天機器人競技場來訓練論文的模型,但保留了5k樣本用于驗證。論文剔除了所有少于16個字符的提示樣本,從而得到了65k對來自64個不同模型的比較。這些對話涵蓋了超過100種語言,其中大部分(81%)為英語,其次是中文(3.1%)和俄語(2.2%)。論文將模型分配到10個類別以減少比較標簽的稀疏性。如第3.1.1節所討論,論文進一步通過以下方式增強訓練數據:

評估基準:論文在三個廣泛使用的學術基準上評估論文的路由器:MMLU 包含57個學科的14,042個問題,MT Bench 使用LLM作為評判的160個開放式問題,以及GSM8K 超過1,000個小學數學問題。此外,論文還進行了評估與訓練數據集之間的交叉污染檢查,并報告了未受污染的結果。論文展示公共基準上的結果,以理解路由器的域外泛化能力。

路由器:對于矩陣分解路由器和相似性加權排序路由器,論文使用OpenAI的嵌入模型text-embedding-3-small來嵌入輸入查詢。論文對BERT和因果LLM進行全參數微調,并使用驗證集進行模型選擇。論文選擇使用gpt-4-1106-preview [20]作為Mstrong中的代表模型,以及Mixtral 8x7B 作為Mweak中的代表模型,以具體評估路由器性能。論文還使用了一個在成本約束下隨機路由查詢的隨機路由器作為基線。

2.4.1 結果

表1:MT Bench結果。注意,CPT在30%時的分數(8.8)是95%的GPT-4性能(9.3)。論文的路由器在Darena訓練時在MT Bench上表現出強勁性能,當數據集增加Djudge時,性能進一步提高,與隨機路由器相比,成本降低了高達75%

表1展示了論文的路由器在MT Bench上的性能。對于在Arena數據集上訓練的路由器,論文觀察到矩陣分解和相似性加權排序都有很強的性能,兩者在所有指標上都顯著優于隨機路由器。值得注意的是,矩陣分解所需的GPT-4調用次數是隨機路由器的一半,以達到50%的PGR。然而,論文的BERT和因果LLM分類器在Arena數據集上訓練時表現接近隨機,論文認為這是由于高容量方法在低數據體制下表現較差。

使用GPT-4法官增強偏好數據,導致所有路由器的性能顯著提升。BERT和因果LLM路由器現在表現遠超隨機基線,BERT分類器的APGR比隨機提升了超過50%。在這個增強數據集上訓練時,矩陣分解是表現最好的路由器,其CPT(80%)幾乎減半,所需的GPT-4調用次數比隨機少50%。

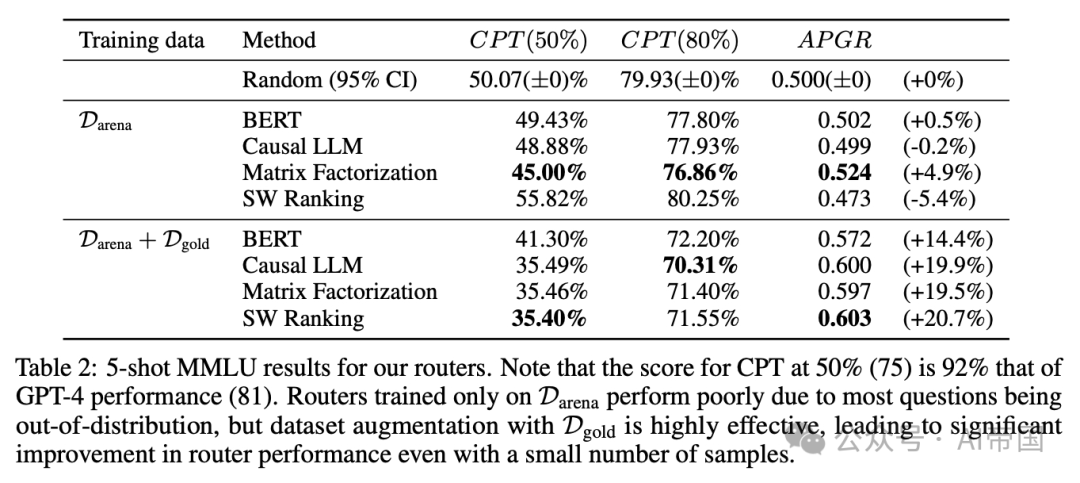

表2:論文的路由器在5-shot MMLU上的結果。請注意,CPT在50%(75)的得分是GPT-4性能(81)的92%。僅在Darena上訓練的路由器表現不佳,因為大多數問題都是分布外的,但使用Dgold進行數據集增強非常有效,即使樣本數量很少,也能顯著提高路由器性能

在MMLU測試集(表2)上,所有路由器在僅使用Arena數據集進行訓練時表現不佳,其水平相當于隨機路由器,論文認為這主要是由于大多數MMLU問題超出了訓練數據的分布范圍。然而,通過在訓練數據集中加入來自MMLU驗證集的金標準數據,所有路由器在MMLU上的性能都得到了顯著提升,所有路由器所需的GPT-4調用次數比隨機路由器減少了約20%,以達到CPT(50%6)。重要的是,盡管額外加入的約1500個金標準樣本僅占總體訓練數據的不到2%,這一結果仍展示了數據集增強在小樣本量情況下的有效性。

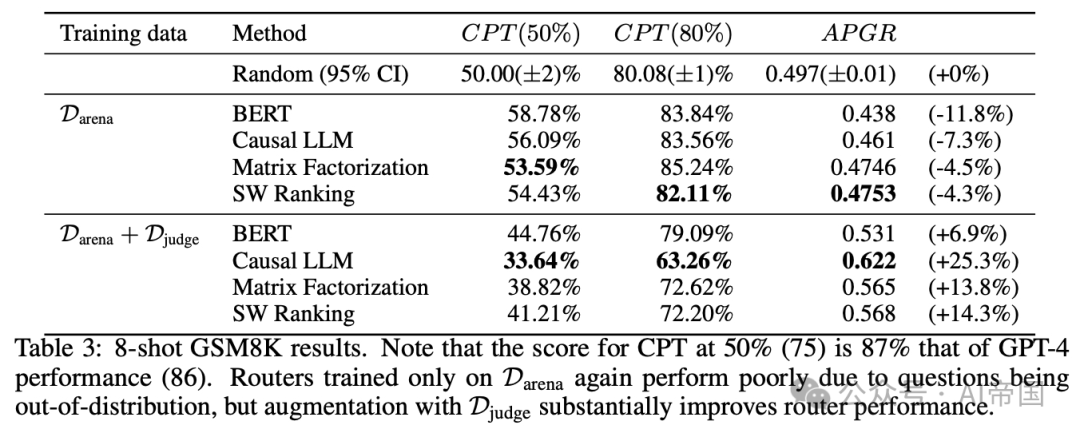

表3:8-shot GSM8K測試結果。注意,CPT在50%時的得分(75)是GPT-4性能(86)的87%。僅在PDarena上訓練的路由器再次因問題超出訓練數據分布而表現不佳,但通過Diudge數據集的增強,路由器性能得到了顯著提升。

最終,在GSM8K上(表3),論文觀察到與MMLU類似,僅在Arena數據集上訓練的所有路由器的性能接近隨機。然而,通過在由LLM法官生成的合成數據增強的數據集上訓練論文的路由器,性能顯著提升,所有路由器的APGR從低于隨機變為高于隨機。當在此增強數據集上訓練時,因果LLM分類器在所有路由器中表現最佳,相比隨機方法,實現CPT(50%)和CPT(80%)所需的GPT-4調用減少了17%。

2.4.2 量化數據集與基準的相似性

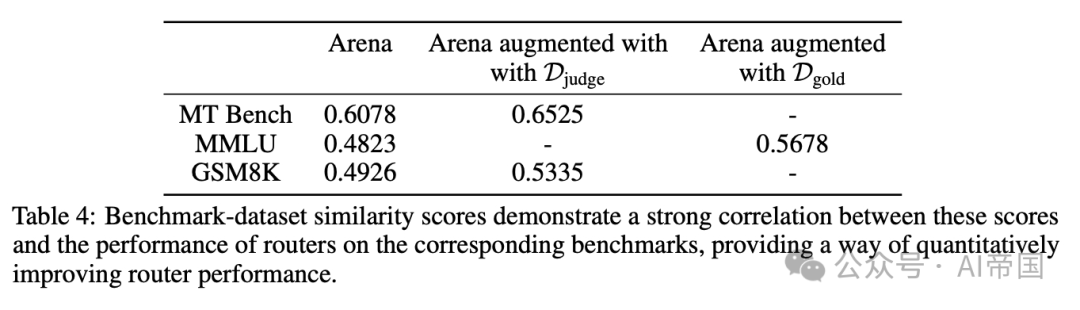

論文將同一數據集上訓練的路由器在不同基準上性能差異歸因于評估數據和訓練數據分布的不同。對于每個基準-數據集對,論文在表4中計算了一個基準-數據集相似度分數,該分數指示評估數據在訓練數據中的代表性程度。

表4:基準-數據集相似度分數顯示這些分數與路由器在相應基準上的性能之間存在強相關性,為定量提升路由器性能提供了一種方法

較高的基準數據集相似度分數與使用相應數據集訓練的路由器在該基準上的更強性能相關,如第4.1節所示。數據集增強,無論是使用黃金標注數據集還是LLM法官標注數據集,都會使偏好數據的整體分布更符合基準,并提高基準數據集相似度分數,從而轉化為性能提升。這種相似度分數對于理解路由器在不同基準上的相對性能也很有用:在Arena數據集上,MT Bench與所有數據集的相似度分數明顯高于其他基準,論文認為這解釋了與GSM8K和MMLU相比,路由器在MT Bench上的相對更強性能。鑒于對查詢分布的了解,基準數據集相似度分數是系統性提升路由器在實際用例中性能的有前景方向。

2.4.3 推廣到其他模型對

論文選擇gpt-4-1106-preview 和Mixtral 8x7B作為上述實驗的代表性強模型和弱模型。然而,為了證明論文的框架對不同模型對的通用性,本節報告了在MT Bench上,當路由器在Claude 3 Opus和Llama 3 8B之間路由時的性能。重要的是,論文使用相同的路由器而無需任何再訓練,僅替換路由到的強模型和弱模型。這兩個模型也不存在于論文的訓練數據中。

表5:Claude 3 Opus / Llama 3 8B在MT Bench上的結果。論文的路由器在不同強弱模型對之間具有很好的泛化能力,無需任何再訓練

再次,論文觀察到即使在更換模型對的情況下,所有現有路由器在MT Bench上的性能依然強勁。所有路由器的性能與原始模型對相當。新模型對和原始模型對的結果仍然明顯強于隨機,論文的路由器在達到CPT(80%)時所需的GPT-4調用次數最多可減少30%。這些結果表明,論文的路由器已經學習了一些能夠區分強弱模型的常見問題特征,這些特征可以泛化到新的強弱模型對,而無需額外訓練。

2.4.4 成本分析

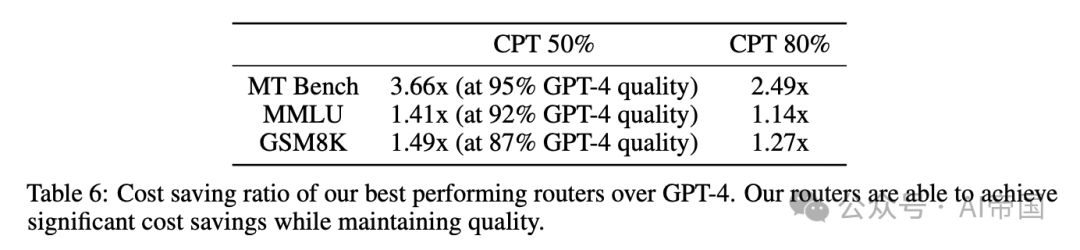

表6:論文的最佳表現路由器相對于GPT-4的成本節約比率。論文的路由器能夠在保持質量的同時實現顯著的成本節約

論文估計使用GPT-4和Mixtral 8x7B的平均成本分別為每百萬 tokens 24.7和0.24。在表6中,論文展示了量化論文方法所實現的成本節約的結果。論文計算了論文的頂級表現路由器相對于隨機基線的GPT-4調用比例的倒數,因為GPT-4的成本是論文分析中的主要因素。論文的路由器實現了高達3.66倍的最優成本節約,表明路由可以在保持響應質量的同時顯著降低成本。

2.4.5 路由開銷

表7:不同路由器的成本和推理開銷。與LLM生成成本相比,部署路由器的成本較小,同時也能支持實際工作負載

與使用單一模型相比,LLM路由的一個擔憂是其路由開銷。因此,論文在表7中測量并報告了論文的路由器的開銷,以展示它們在實際應用中的可行性,使用了從Chatbot Arena隨機抽樣的對話。對于需要GPU的路由器,即矩陣分解和分類器方法,論文使用了包含單個NVIDIA L4 GPU的Google Cloud的g2-standard-4 VM。對于相似性加權排序,論文使用了Google Cloud的僅CPU的n2-standard-8 VM。論文基于GPU的路由器目前比基于CPU的路由器效率高得多,但論文注意到在優化路由器吞吐量方面仍有很大的改進空間。然而,即使是SW排序,論文最昂貴的路由器,與GPT-4生成相比,引入的額外成本也不超過0.4%。

本文轉載自 ??AI帝國??,作者: 無影寺