即插即用!CVD:第一個生成具有相機控制的多視圖一致視頻方案!(斯坦福&港中文) 精華

論文鏈接:https://arxiv.org/abs/2405.17414

項目鏈接:https://collaborativevideodiffusion.github.io/

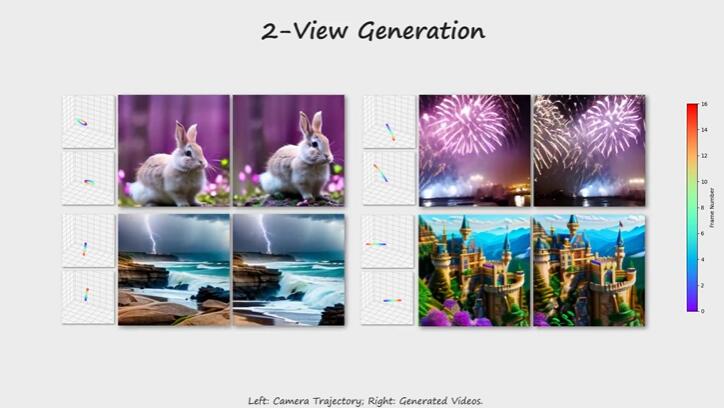

最近對視頻生成的研究取得了巨大進展,使得可以從文本提示或圖像生成高質量的視頻。在視頻生成過程中添加控制是未來的重要目標,而最近一些將視頻生成模型與攝像機軌跡聯系起來的方法正在朝著這個目標邁進。然而,從多個不同的攝像機軌跡生成同一場景的視頻仍然具有挑戰性。解決這個多視頻生成問題可以實現大規模的3D場景生成,其中包括可編輯的攝像機軌跡等應用。本文引入了協作視頻擴散(CVD)作為實現這一愿景的重要一步。CVD框架包括一個新穎的跨視頻同步模塊,通過一個極線注意機制促進了從不同攝像機姿態渲染的同一視頻的相應幀之間的一致性。在基于最先進的視頻生成攝像機控制模塊的基礎上進行訓練,CVD生成了從不同攝像機軌跡渲染的多個視頻,其一致性明顯優于基線,在廣泛的實驗中得到了證明。

介紹

隨著擴散模型的顯著進展,視頻生成也取得了顯著進步,對數字內容創作工作流程產生了深遠影響。最近的模型如SORA展示了生成復雜動態的長視頻的能力。然而,這些方法通常利用文本或圖像輸入來控制生成過程,缺乏對內容和動作的精確控制,而這對于實際應用是至關重要的。先前的努力探索了其他輸入模態的使用,如流、關鍵點和深度,并開發了新的控制模塊,以有效地整合這些條件,實現對生成內容的精確引導。盡管取得了這些進步,但這些方法仍然未能為視頻生成過程提供攝像機控制。

最近的研究開始專注于使用各種技術進行攝像機控制,例如運動LoRAs或場景流。一些代表性的作品如MotionCtrl和CameraCtrl通過將視頻生成模型條件化為一系列攝像機姿態,提供了更靈活的攝像機控制,展示了自由控制視頻攝像機移動的可行性。然而,這些方法局限于單一攝像機軌跡,導致從不同攝像機軌跡生成同一場景的多個視頻時在內容和動態上存在顯著的不一致性。在許多下游應用中,如大規模3D場景生成,具有攝像機控制的一致性多視頻生成是可取的。然而,訓練視頻生成模型以生成具有不同攝像機軌跡的一致性視頻非常具有挑戰性,部分原因是缺乏大規模的多視角野外動態場景數據。

本文介紹了CVD,這是一個即插即用的模塊,能夠生成具有不同攝像機軌跡的視頻,這些視頻共享場景的相同基礎內容和動態。CVD基于一種協作擴散過程設計,生成具有可單獨控制的攝像機軌跡的一致性視頻對。通過引入一個可學習的跨視圖同步模塊,利用極線注意機制實現了視頻中對應幀之間的一致性。為了有效訓練這個模塊,本文提出了一種新的偽極線采樣方案,以豐富極線幾何注意力。由于缺乏用于3D動態場景的大規模訓練數據,本文提出了一種混合訓練方案,其中利用來自RealEstate10k的多視圖靜態數據和來自WebVid10M的單眼動態數據分別學習攝像機控制和動態。據本文所知,CVD是第一個能夠生成具有一致內容和動態的多個視頻,并提供攝像機控制的方法。通過大量實驗證明,CVD確保了強大的幾何和語義一致性,在性能上明顯優于相關基線。總結本文的貢獻如下:

? 據本文所知,CVD是第一個生成具有攝像機控制的多視圖一致視頻的視頻擴散模型;

? 引入了一個新穎的模塊,稱為跨視頻同步模塊,旨在對齊不同輸入視頻的特征,以增強一致性;

? 提出了一種新的協作推理算法,可以將在視頻對上訓練的視頻模型擴展到任意數量的視頻生成;

? 模型在生成具有一致內容和動態的多視圖視頻方面表現出優異性能,明顯優于所有基線方法。

相關工作

視頻擴散模型。 最近在訓練大規模視頻擴散模型方面的努力已經實現了高質量的視頻生成。視頻擴散模型利用3D UNet從圖像和視頻中聯合學習。借助文本到圖像(T2I)生成模型,如Stable Diffusion等,獲得的優質圖像質量,許多最新的工作集中在通過學習時間模塊擴展預訓練的T2I模型。Align-your-latents提出利用3D卷積和分解的時空塊來學習視頻動態。類似地,AnimateDiff在Stable Diffusion的基礎上構建了一個時態模塊,在每個固定的空間層之后添加一個時態模塊,實現了即插即用的功能,允許用戶進行個性化的動畫制作而無需進行任何微調。Pyoco提出了一種時間上連貫的噪聲策略,以有效地建模時間動態。最近,SORA利用transformer架構和時空擴散,向逼真的長視頻生成邁出了重要的一步。

可控視頻生成。 文本條件的模糊性通常導致文本到視頻模型(T2V)的控制不足。為了提供精確的引導,一些方法利用額外的條件信號,如深度、骨架和流來控制生成的視頻。最近的工作,如SparseCtrl和SVD,將圖像作為視頻生成的控制信號。為了進一步控制輸出視頻中的運動和攝像機視圖,DragNUWA和MotionCtrl將運動和攝像機軌跡注入到條件分支中,前者使用放松的光流版本作為類似筆畫的交互式指令,后者直接將攝像機參數連接為附加特征。CameraCtrl提出使用Plückere mbedding 對攝像機參數進行超參數化,并實現更精確的攝像機調節。另外,AnimateDiff訓練攝像機軌跡LoRAs以實現視點移動調節,而MotionDirector也利用LoRAs但過擬合于特定的外觀和動作以獲得它們的解耦。

多視圖圖像生成。 由于缺乏高質量的場景級3D數據集,一系列研究重點關注生成連貫的多視圖圖像。Zero123學習從姿勢條件生成新視圖圖像,并隨后的工作將其擴展為用于更好的視圖一致性的多視圖擴散。然而,這些方法僅限于對象,并一直難以生成高質量的大規模3D場景。MultiDiffusion和DiffCollage促進了360度場景圖像的生成,而SceneScape通過扭曲和修補使用擴散模型生成了放大視圖。類似地,Text2Room生成了房間的多視圖圖像,其中圖像可以通過深度投影以獲得一致的房間網格。DiffDreamer遵循Infinite-Nature的設置,并使用條件擴散模型進行投影和細化的迭代過程。最近的一項工作,PoseGuided-Diffusion,通過在提供攝像機姿勢的多視圖數據集上訓練并添加極線偏差到其關注mask,從單張圖像進行新視圖合成。然而,由于該方法的先驗僅從定義良好的靜態室內數據學習,因此構造的方法無法推廣到野外或動態場景。

Po等人提供了最近在視覺計算中擴散模型方面的進展的全面調查。

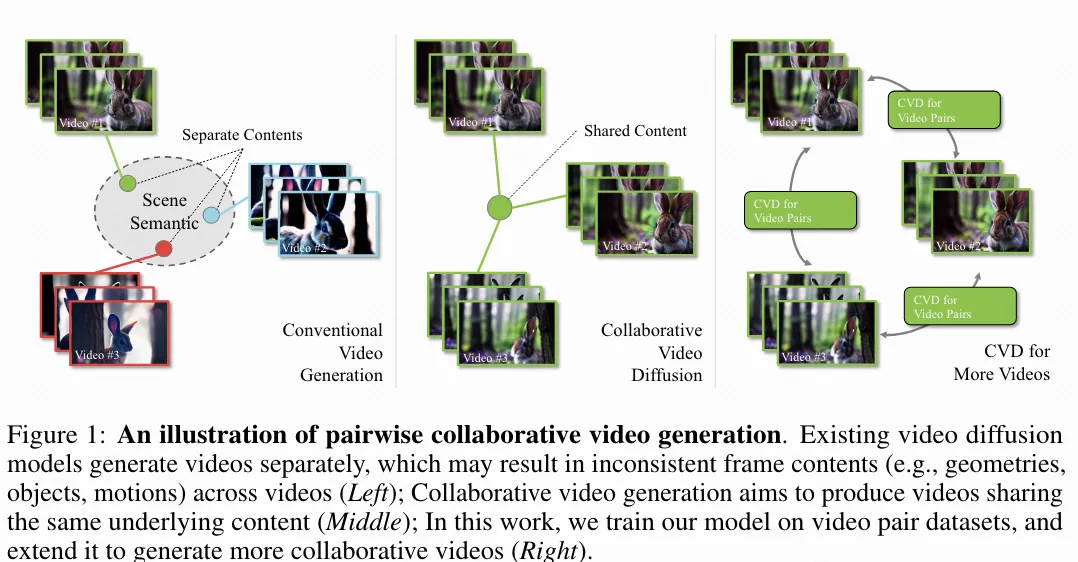

協作視頻生成

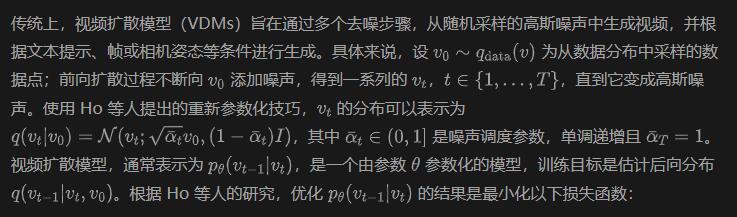

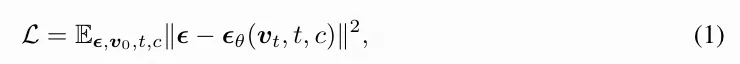

借助現成的大規模視頻數據集,許多最先進的視頻擴散模型(VDMs)已經成功展示了生成時間一致且逼真視頻的能力。然而,這些現有方法的一個關鍵缺點是無法生成一致連貫的多視角視頻。如下圖1所示,在相同文本條件下,由VDM生成的視頻在內容和空間布局上存在差異。雖然可以使用推理階段的技巧,如擴展注意力機制,以增加視頻之間的語義相似性,但這并不能解決結構一致性的問題。為了解決這一問題,本文引入了一種新的目標,即在給定特定語義條件下,VDM能夠同時生成多個結構一致的視頻,并將其命名為協作視頻擴散(Collaborative Video Diffusion, CVD)。

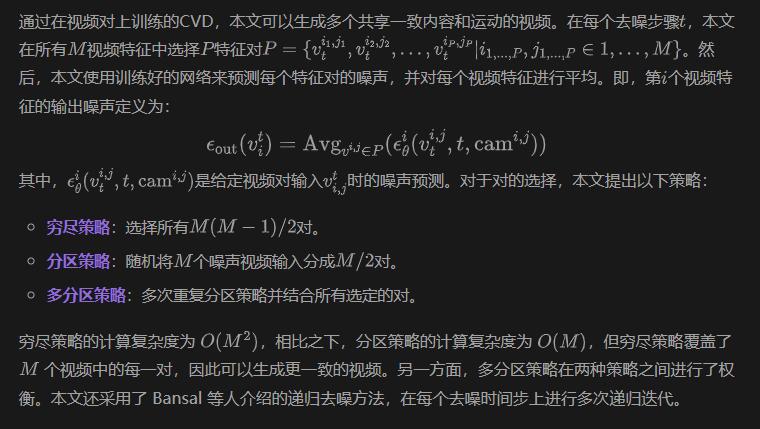

然而,在實際操作中,大規模多視角視頻數據的稀缺性使得本文無法直接訓練一個針對任意數量視頻的模型。因此,本文從現有的單目視頻數據集中構建了一致的視頻對(即 M=2)的訓練數據集,并訓練擴散模型生成共享相同基礎內容和運動的視頻對。本文的模型設計可以適應任意數量的輸入視頻特征,本文還開發了一種推理算法,從本文預訓練的成對 CVD 模型中生成任意數量的視頻。

具有攝像機控制的協作視頻擴散

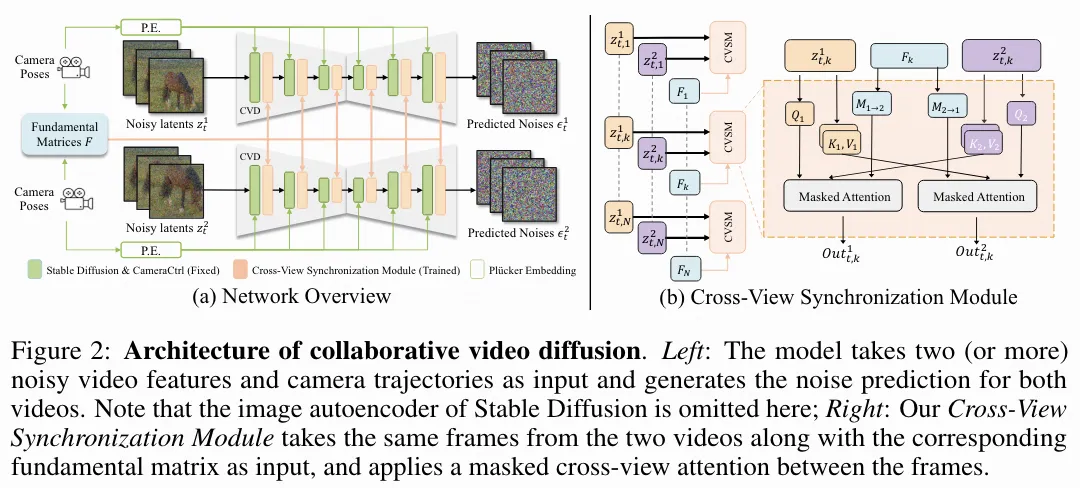

受 [18, 17] 啟發,本文的模型設計為相機控制視頻模型 CameraCtrl的擴展。如下圖 2 所示,本文的模型接收兩個(或更多)帶噪視頻特征輸入,并在一次傳遞中生成噪聲預測。

這些視頻特征通過 CameraCtrl 的預訓練權重,并在本文提出的跨視角同步模塊中同步。該模型使用兩個不同的數據集進行訓練:RealEstate10K,該數據集包含主要靜態場景的相機校準視頻;以及 WebVid10M,該數據集包含不帶姿態的通用視頻。這導致了本文在下文中介紹的兩階段訓練策略。通過本文提出的推理算法,學習到的模型可以推斷任意數量的視頻。

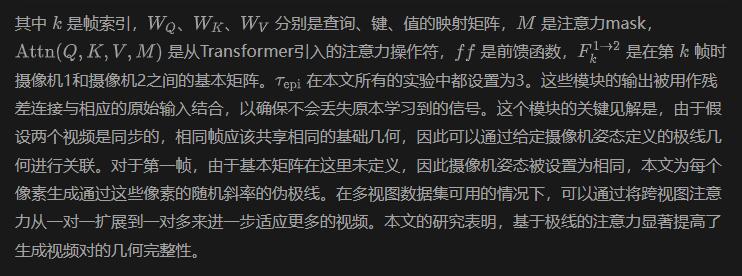

跨視圖同步模塊

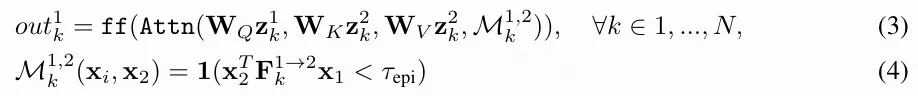

最新的 VDM(視頻擴散模型)通常在空間和時間維度上結合了各種類型的注意力機制:例如 AnimateDiff、SVD、LVDM將空間和時間解耦并應用獨立的注意力層;而最新的突破性工作 SORA在其 3D 空間-時間注意模塊上同時處理這兩個維度。盡管在空間和時間維度上定義的操作在不同幀的不同像素之間帶來了強相關性,但捕捉不同視頻之間的上下文關系需要一種新的操作:跨視頻注意力。

幸好,先前的研究已經表明,擴展注意力技術,即將不同視角的鍵和值拼接在一起,對于在視頻之間保留相同的語義信息是顯然有效的。然而,這種方法無法保持它們之間的結構一致性,導致在幾何上完全不同的場景。因此,受到 [53] 的啟發,本文引入了基于極幾何的跨視角同步模塊,以在生成過程中揭示跨視頻幀之間的結構關系,使視頻在幾何上對齊。

兩個數據集的混合訓練策略

考慮到目前沒有可用的大規模真實世界視頻對數據集,本文選擇利用兩個流行的單目數據集,RealEstate10K和 WebVid10M,來開發一種用于視頻對生成模型的混合訓練策略。

RealEstate10K 與視頻折疊。訓練的第一階段涉及 RealEstate10K,這是一個包含主要靜態室內場景和相應攝像機姿態的視頻剪輯數據集。本文通過簡單地從數據集中的視頻采樣2N-1幀的子序列來采樣視頻對,然后從中間剪切并反轉它們的前半部分,以形成同步的視頻對。換句話說,這些子序列被折疊成兩個共享相同起始幀的視頻剪輯。

WebVid10M 與單應變換增強。 雖然 RealEstate10K 提供了不錯的幾何先驗,但僅在這個數據集上訓練本文的模型并不理想,因為它不包含任何關于動態的知識,并且只包含室內場景。另一方面,WebVid10M 是一個大規模視頻數據集,包含各種類型的視頻,可以作為 RealEstate10K 的良好補充。為了提取視頻對,本文克隆數據集中的視頻,然后對這些克隆視頻應用隨機單應變換。然而,WebVid10M 數據集不包含攝像機信息,這使得它不適合用于基于攝像機條件的模型訓練。為了解決這個問題,本文提出了一種兩階段訓練策略,以適應這兩個數據集(無論是否包含攝像機姿態)用于同一個模型。

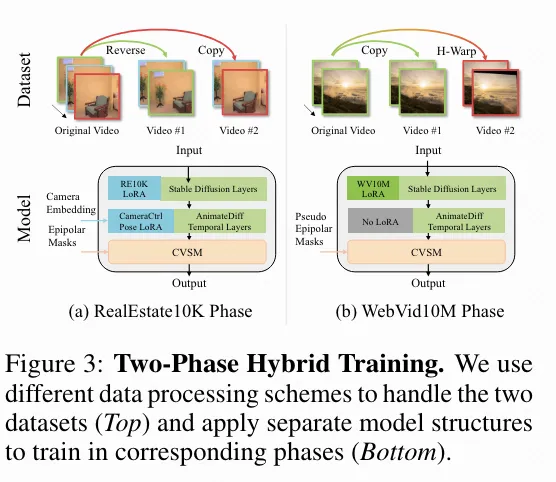

兩階段訓練。 如前所述,本文的模型基于現有的攝像機控制VDM CameraCtrl。它是AnimateDiff的擴展版本,添加了一個姿態編碼器和幾個姿態特征注入器,用于原模型的時間注意力層。AnimateDiff 和 CameraCtrl 都基于 Stable Diffusion。這意味著它們采用相同的潛在空間域,因此可以訓練一個通用適應的模塊。因此,如下圖3所示,本文的訓練方案設計如下:

對于 RealEstate10K 數據集,本文使用在 RealEstate10K 上通過 LoRA 微調的 CameraCtrl 作為骨干,并在跨視頻模塊中應用真實的極線幾何。對于 WebVid10M 數據集,本文使用在 WebVid10M 上通過 LoRA 微調的 AnimateDiff 作為骨干,并在跨視頻模塊中應用偽極線幾何(與在 RealEstate10K 數據集的第一幀中使用的策略相同)。實驗表明,這種混合訓練策略極大地幫助模型生成具有同步運動和良好幾何一致性的視頻。

觀看更多視頻

實驗

定量結果

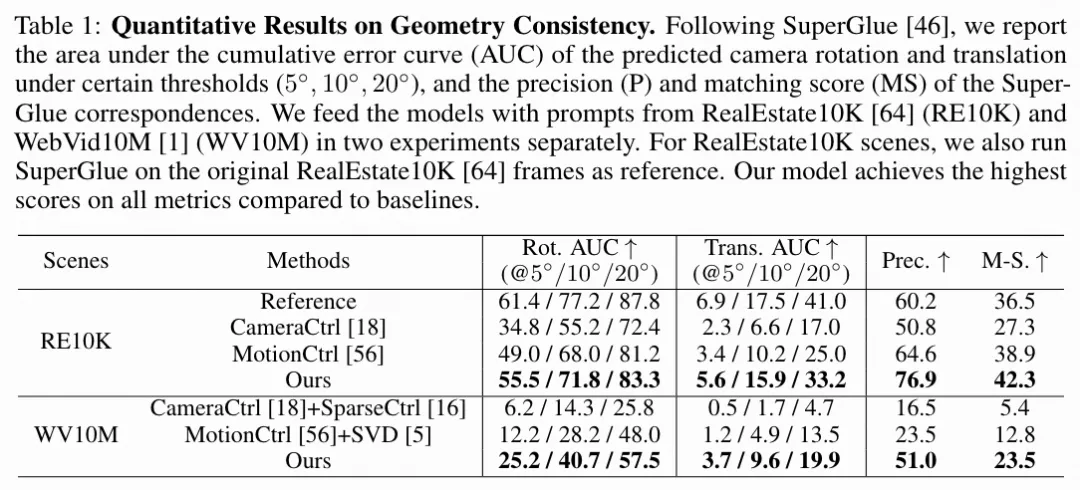

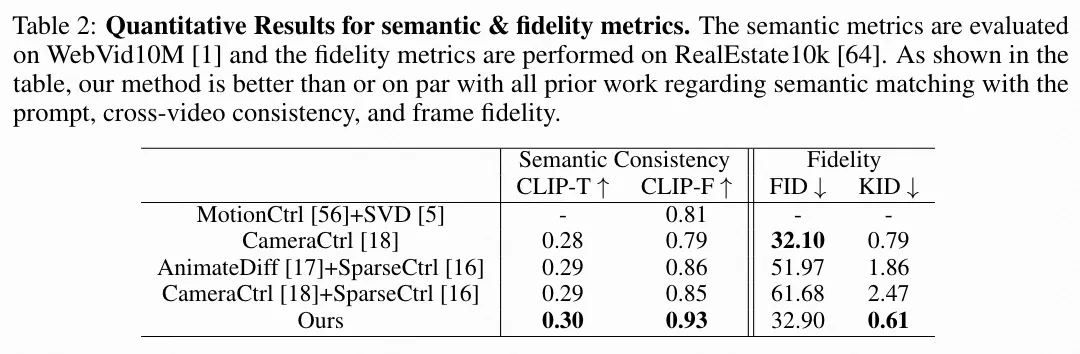

本文將本文的模型與兩個最先進的相機控制視頻擴散模型進行定量評估比較:CameraCtrl 和 MotionCtrl。這兩個基線模型都在 RealEstate10K數據集上進行了相機控制視頻生成的訓練。本文進行了以下實驗來測試所有模型的幾何一致性、語義一致性和視頻保真度:

地產場景中的每視頻幾何一致性。 按照 CameraCtrl的方法,本文首先使用 RealEstate10K(主要由靜態場景組成)中的相機軌跡和文本提示測試本文模型生成的視頻幀之間的幾何一致性。具體來說,本文首先從隨機采樣的相機軌跡對(兩個具有相同起始變換的相機軌跡)和文本標題中生成 1000 個視頻。所有基線模型一次生成一個視頻;本文的模型同時生成兩個視頻。對于每個生成的視頻,本文應用最先進的圖像匹配算法 SuperGlue來提取其第一幀和后續幀之間的對應關系,并使用 RANSAC算法估計它們的相對相機姿態。為了評估對應關系和估計的相機姿態的質量,本文采用了 SuperGlue的相同協議:

- 通過旋轉和平移的角度誤差來評估姿態

- 通過對應的極線誤差(即到真實極線的距離)來評估匹配的對應關系。

結果如下表 1 所示,本文的模型顯著優于所有基線模型。

跨視頻幾何一致性在通用場景中的表現。 除了評估同一視頻中幀與幀之間的一致性外,本文還測試了本文的模型在不同視頻中保持幾何信息的一致性能力。為此,本文隨機抽取了500對視頻(總計1000個視頻),使用了RealEstate10K中的相機軌跡對和WebVid10M字幕中的文本提示。據本文所知,目前沒有可用的大型視頻擴散模型專門設計用于生成通用場景的多視角一致視頻。因此,本文修改了CameraCtrl和MotionCtrl以生成視頻對作為基線。在此,本文首先使用每個模型的文本到視頻版本生成一個參考視頻,然后將其第一幀作為輸入,使用其圖像到視頻版本(即與SparseCtrl和SVD的結合)生成第二個視頻。本文使用與第一個實驗相同的指標,但評估的是兩個視頻中對應幀之間的一致性。結果如上表1所示,本文的模型大大優于所有基線模型。

語義和保真度評估。 按照之前工作的標準實踐,本文報告了CLIPembedding相似性,包括1)輸出視頻的每一幀與對應輸入提示之間的相似性和2)視頻對之間幀的相似性。前者指標記為CLIP-T,用于顯示本文的模型不會破壞基礎模型的外觀/內容先驗,而后者指標記為CLIP-F,旨在顯示跨視圖模塊可以提高生成視頻對之間的語義和結構一致性。為此,本文隨機抽取了1000個視頻,使用RealEstate10K中的相機軌跡對和WebVid10M中的文本字幕(總計生成2000個視頻)。為了進一步展示本文方法保持高保真度生成內容的能力,本文報告了使用實現的FID和KID ×100。

本文不與不共享相同基礎模型的模型進行FID和KID比較,因為這些指標受基礎模型能力的強烈影響。按照之前的工作,本文在RealEstate10K上評估這兩個指標,因為WebVid10M上存在強烈的不良偏差,例如水印。正如下表2所示,本文的模型在基于CLIP的指標上超越了所有基線模型。這證明了本文的模型能夠合成共享場景的協作視頻,同時根據提示保持和提高保真度。本文的模型在保真度指標上也優于或與所有之前的工作相當,這表明了對本文基礎模型所學習的外觀和內容先驗的魯棒性。

定性結果

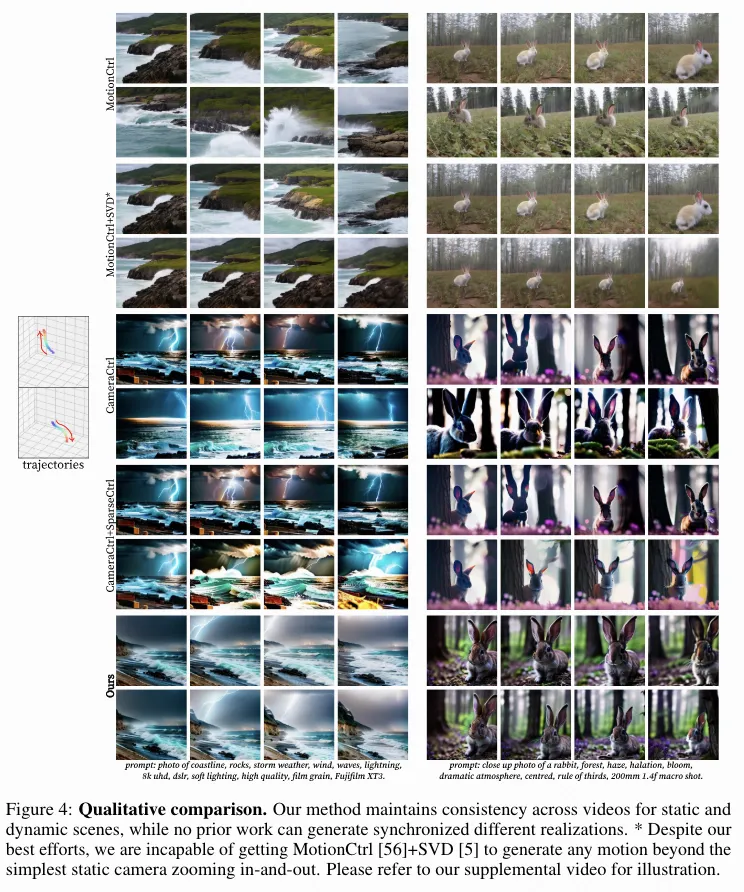

與基線比較

定性比較如下圖4所示。在上文中的定量比較之后,本文對比了CameraCtrl及其與SparseCtrl 的組合、MotionCtrl及其與SVD的組合。結果表明,本文的方法在視頻內容對齊方面具有優越性,包括閃電、海浪等動態內容。

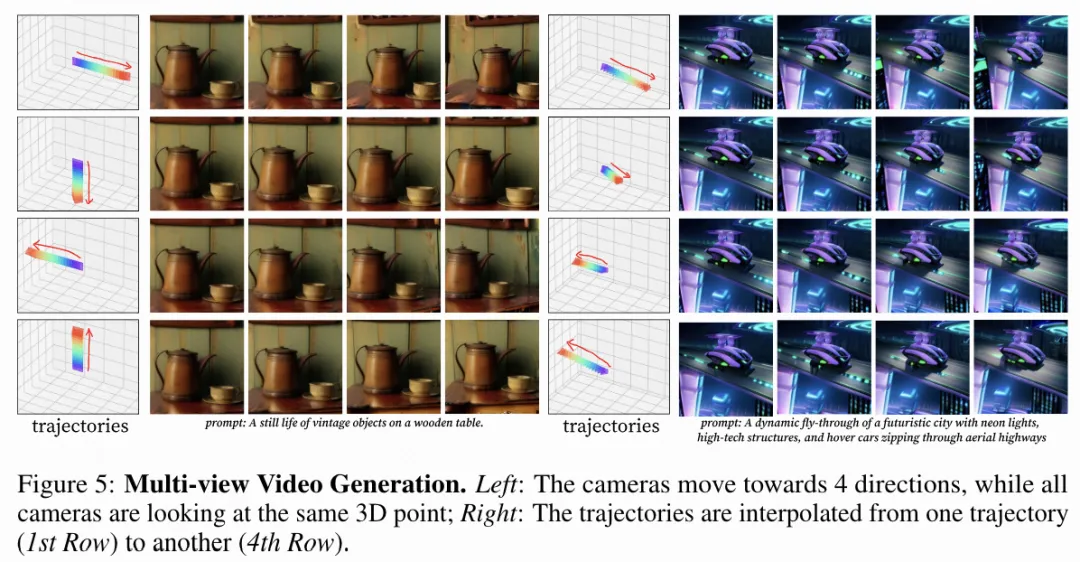

任意視圖生成的附加結果

本文還展示了下圖5中的任意視角生成結果。使用上文介紹的算法,本文的模型可以生成一組不同相機條件下的視頻,這些視頻共享相同的內容、結構和運動。

討論

本文推出了CVD,一種促進協作視頻生成的新框架。它確保視頻實例之間的信息無縫交換,同步內容和動態。此外,CVD提供相機定制功能,以便使用多個相機全面捕捉場景。CVD的核心創新在于其利用重建pipeline中推導出的極幾何作為約束。這種幾何框架微調了預訓練的視頻擴散模型。通過整合動態的、單視角的野外視頻,訓練過程得到了增強,從而保持了多樣的運動模式。在推理過程中,CVD采用多視角采樣策略,促進視頻間的信息共享,從而實現統一視頻輸出的“協作擴散”效果。據本文所知,CVD是首個解決多視角或多軌跡視頻合成復雜性的方案。它顯著超越了現有的多視角圖像生成技術,如Zero123,不僅確保了生成視頻的一致動態,還帶來了視頻合成領域的重要突破,承諾了新的能力和應用。

限制

CVD 面臨一些局限性。首先,CVD 的有效性本質上與其基礎模型 AnimateDiff 和 CameraCtrl的性能密切相關。盡管 CVD 力求促進視頻之間的穩健信息交換,但它并未從根本上解決單個視頻內部一致性的問題。因此,基礎模型中存在的詭異形變和動態不一致等問題可能會持續存在,影響視頻輸出的整體一致性。此外,由于擴散模型計算量大,CVD 無法實時合成視頻。然而,擴散模型優化領域正在迅速發展,未來的進展可能會顯著提高 CVD 的效率。

更廣泛的影響

本文的方法在多攝像頭視頻合成領域代表了一個重要的進步,對電影制作和內容創作等行業具有廣泛的影響。然而,本文也意識到潛在的濫用風險,特別是在制作虛假內容如深度偽造(deepfakes)方面。本文堅決反對利用本文的方法進行任何侵犯道德標準或隱私權的行為。為了應對這種濫用風險,本文倡導持續開發和改進深度偽造檢測技術。