Scaling Law觸礁「數據墻」?Epoch AI發文預測LLM到2028年耗盡所有文本數據

數據和算力,是AI大模型最重要的兩把「鏟子」。

算力方面,英偉達的不斷創新和各家代工廠的產能提高,讓世界各處的數據中心拔地而起,研究人員暫時不用擔心計算資源。

然而,近些年來,數據成為愈發嚴峻的問題。

根據華爾街日報的報道,OpenAI在訓練GPT-5時已經遇到了文本數據不足的問題,正在考慮使用Youtube公開視頻轉錄出的文本。

關于「數據耗盡」這個問題,非營利研究機構Epoch AI在6月4日發布了一篇最新論文。

根據他們的預測,未來10年內,數據增長的速度無法支撐起大模型的擴展,LLM會在2028年耗盡互聯網上的所有文本數據。

論文地址:??https://arxiv.org/abs/2211.04325??

目前這篇論文已被ICML 2024接收。著名的硅谷天才少年Alexandr Wang也轉發了這篇論文,并附上了自己的一番見解。

他創辦的Scale AI專門為AI模型提供訓練數據,估值已經飆升到138億,是當下硅谷最炙手可熱的明星獨角獸。

??估值飆至138億美元!27歲華裔天才少年再獲融資,數據標注會是下一個風口???

論文作者所屬的機構Epoch AI則是一家非營利研究組織,成立于2022年4月,他們致力于調查人工智能的歷史趨勢,并幫助預測其未來發展。

雖然這個組織目前只有13名員工,且分布在世界各地,但他們的工作有非常廣泛的影響。

英國和荷蘭的政府報告都曾引用Epoch AI發表的論文。RAND智庫的研究員表示,Epoch的AI模型數據庫對于政策制定者來說是寶貴的資源,「世界上沒有其他數據庫如此詳盡和嚴謹」。

預測方法

Epoch AI憑什么預測出2028年這個時間點?

說得直白一點,數據量就像一個水池。有存量、有增量,是否夠用就要同時看供給側和需求側,預測AI模型的數據集會不會把水池抽干。

數據存量

首先需要估計目前互聯網上的文本數據存量S。

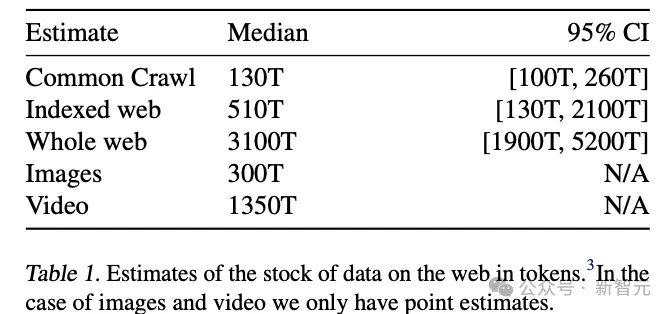

定期更新的開源數據集Common Crawl爬取到了超過2500億個網頁,包含130T tokens。但這不是全部的網絡內容,還需要統計索引網絡的大小。

我們先假設谷歌搜索引擎包含了所有索引網站,可以使用「詞頻法」估計其中的頁面數量。

比如,如果「chair」這個詞出現在Common Crawl 0.2%的頁面中,而且谷歌可以搜索到40B個包含「chair」的網頁結果,就能初步預估出整個索引網絡的大小約為40B/0.002=20T個頁面。

采用這種方法,論文估算出谷歌索引包含約270B個頁面,每個網頁約有1.9KB純文本數據,這表明整個索引網絡的數據量大概為500T,是Common Crawl的5倍。

除此之外,還可以用另一種思路建模,估算整個互聯網的數據總量——從使用人數入手。

網絡上大部分文本數據都是用戶生成的,并存儲在各種平臺上,因此,考慮互聯網用戶數和人均產生數據量,即可估計人類生成的公開文本數據量。

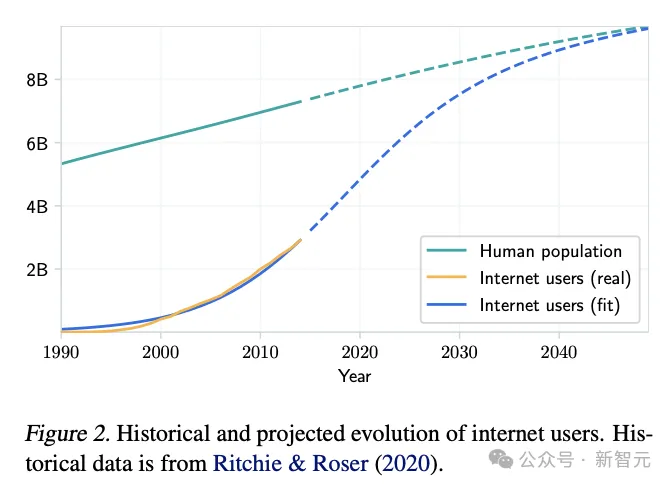

根據人口增長以及互聯網逐漸普及的趨勢,論文對互聯網用戶增長趨勢進行建模,得出的曲線與歷史數據非常吻合。

假設每個用戶平均生成數據率保持不變,論文預計2024年上傳的文本數據總量為180T~500T tokens。

根據這個預測結果以及已知的增長趨勢,論文預估,互聯網上的存量數據為3100T。

由于同時考慮了索引網絡和深層網絡(搜索引擎無法觸及的網頁),這個數字可以看作索引網絡數據量的上限。

數據質量

5G時代的沖浪選手應該都有體會,雖然在同一個互聯網,但文本和文本的質量可以有云泥之別。

比如,在書籍或維基百科的文本上訓練出的模型,與Youtube評論喂出的模型,可能有很大的性能差異。因此,只用token數量衡量數據的話,就過于片面了。

但也不能對網絡數據失去信心。之前有多項研究表明,通過仔細的過濾和數據處理,網絡數據帶來的性能依舊優于人工精心挑選的語料庫。

論文地址:https://arxiv.org/abs/2306.01116

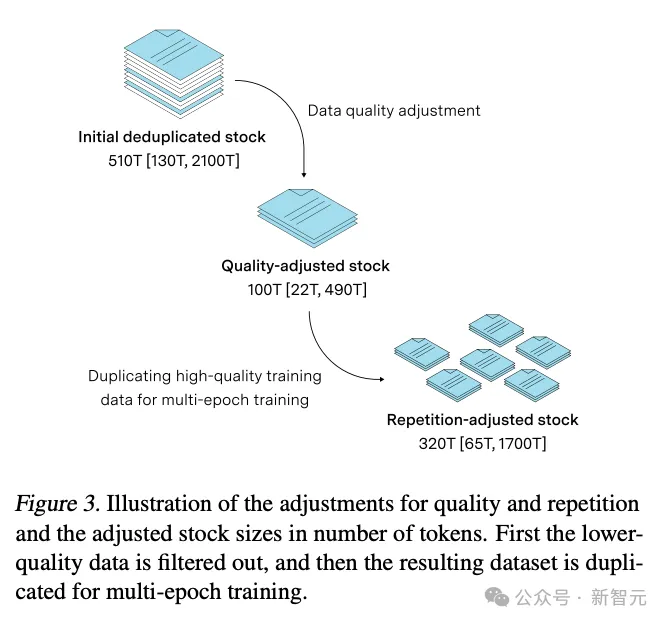

研究人員嘗試對Common Crawl數據集進行類似的處理,發現過濾后數據集大小會降低30%。同時,另一項去年的研究也發現,剪除Common Crawl中50%的重復數據可以實現最佳性能。

因此,有比較充足的理由相信,數據總量的10%-30%可作為高質量數據用于訓練,相當于索引網絡510T數據中的100T左右。

數據集大小

以上是對互聯網數據池的預估,是數據的供給方。接下來,需要對數據使用方——數據集容量(變量D)進行預估。

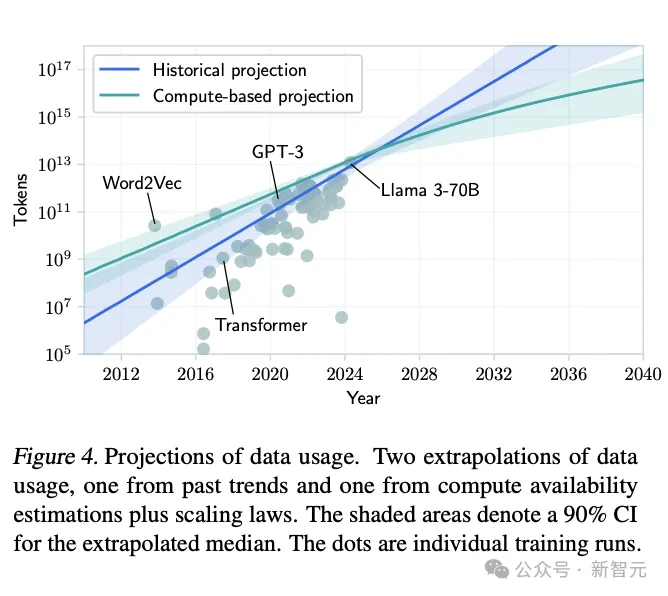

Epoch曾經在2022年發表了一個知名的機器學習模型數據庫,包含了300多個模型,從中選取2010年-2024年間發表的80余個LLM進行分析。

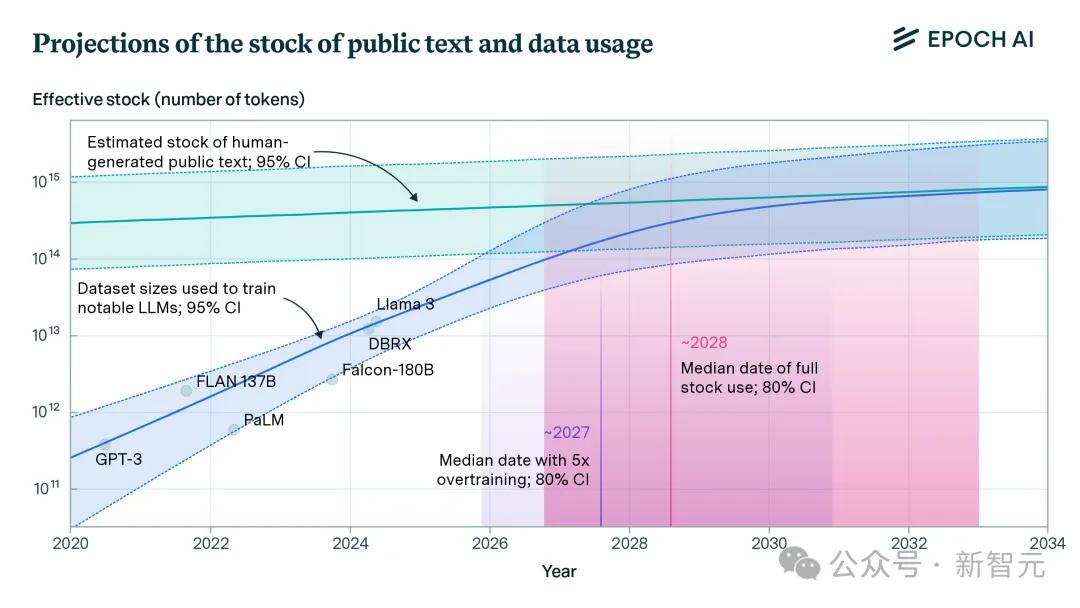

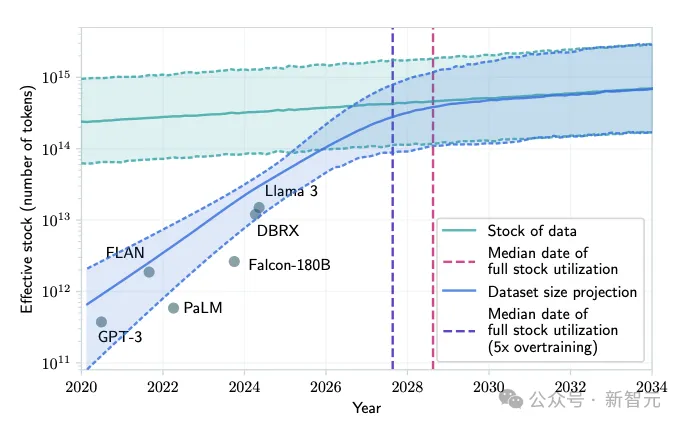

上圖表明,目前LLM使用的最大訓練集約為10T。Epoch AI之前也曾預估過,GPT-4訓練集大小達到了12T tokens。

如果直接根據歷史趨勢進行外插(圖中藍線),那么到2030年,模型可以接受超過1000T tokens的訓練。

但這個結果沒有同時考慮算力的限制。根據Scaling Law,Transformer架構所需的數據量大致隨訓練算力的平方根擴展。

將計算資源和電力資源的約束引入后,就得到了下圖中的預測曲線。

由此,論文就得出了預測結果。按照目前互聯網數據總量和訓練數據集的增長速度,如果以當前趨勢繼續下去,數據耗盡年份的中位數是2028年,最大可能性是2032年。

這意味著,未來10年內,數據將成為LLM的重大瓶頸,「數據墻」將成為現實。

慢著,記不記得之前我們預估過,整個互聯網上的文本數據總量約為3100T,這些數據怎么沒有算進去?

遺憾的是,這部分數據大多分布在Fackbook、Instagram、WhatsApp等社交媒體上,抓取過程不僅復雜、昂貴,而且涉及個人隱私相關的法律問題,因此幾乎無法應用于LLM的訓練。

但Meta公司等機構似乎沒有放棄,仍在探索可能的路徑來利用這些數據。

「數據墻」擋不住LLM?

這篇論文并沒有止步于一個偏向于悲觀的預測結論,因為同時考慮其他的因素,「數據墻」只會讓模型擴展的速度放緩,而不是完全停滯。

Epoch AI的創始人也在此前的采訪中表示過,雖然我們能看到「數據耗盡」的前景,但「目前還沒有感到恐慌的理由。」

目前就至少有兩種策略可以繞過人類文本數據的瓶頸,而且在論文作者看來,這兩種方法都是「前途無量」。

AI生成數據

根據報道,僅OpenAI一家公司的模型每天就能生成100B個單詞,也就是每年36.5T個單詞,相當于Common Crawl中優質單詞的總數。

這遠遠快于人類生成文本的速度,可以讓數據存量急劇擴大,而且在模型輸出相對容易驗證的領域很有前景,比如數學、編程、游戲等等。

使用合成數據訓練的最著名模型莫過于AlphaZero,它通過自我對弈達到了人類棋手都未能企及的水平。

此外2024年最新發布的AlphaGeometry同樣使用合成數據進行訓練,嘗試解決幾何問題。

然而,當合成數據推廣到自然語言領域時,似乎存在一些本質問題。

之前有研究表明,使用模型輸出的文本進行迭代訓練,會丟失有關人類文本數據分布的信息,讓生成的語言越來越同質化且不切實際。

有研究者還把合成數據導致的模型崩潰形象比喻為「近親結婚」,稱這種LLM為「哈布斯堡模型」。

但這個問題也并非無解。有之前的研究證明,通過使用多樣的訓練數據,或者混合一些人類文本數據,既可以合理利用訓練數據,又能一定程度上緩解副作用。

多模態和遷移學習

另一種選擇就是超越文本數據,從其他領域「掘金」。

除了我們熟知的視頻、圖像之外,金融市場數據或科學數據庫也可以使用。有人預測,到2025年,基因組學數據將以每年200-4000萬兆字節的速度增長。

除了這兩種方法,很多實驗室和初創公司也正在積極探索。比如DatologyAI正在研究一種名為「課程學習」(curriculum learning)的方法,把數據按特定順序輸入,以期LLM能夠在概念之間形成更智能的聯系。

2022年他們發表的論文顯示,如果數據無誤,使用這種訓練方法的模型可以用一半的數據實現相同的效果。

也許,Epoch AI創始人的話的確有道理。雖然數據是有限的,「數據墻」也是可預期的,但方法總比困難多。

「最大的不確定性在于,你會看到什么樣的技術突破。」

本文轉自 新智元 ,作者:新智元