RAG生成任務:Base LLM竟然比Instruct LLM高出20%

檢索增強生成(RAG)將檢索階段與生成階段結合起來,后者通常由大型語言模型(LLMs)驅動,RAG中的當前常見實踐是使用“指導”的LLMs,這真的是最優選擇嗎?

對RAG系統中的“instruct”模型及其模板與基礎版本(base)進行了原則性評估。這些“instruct”模型通常經過監督訓練來提高遵循指令的能力,并使用最先進技術與人類偏好對齊。使用了兩個任務指令來評估模型,任務指令I要求模型從未提供的文檔中提取答案,任務指令II要求模型提供證據來支持其答案。

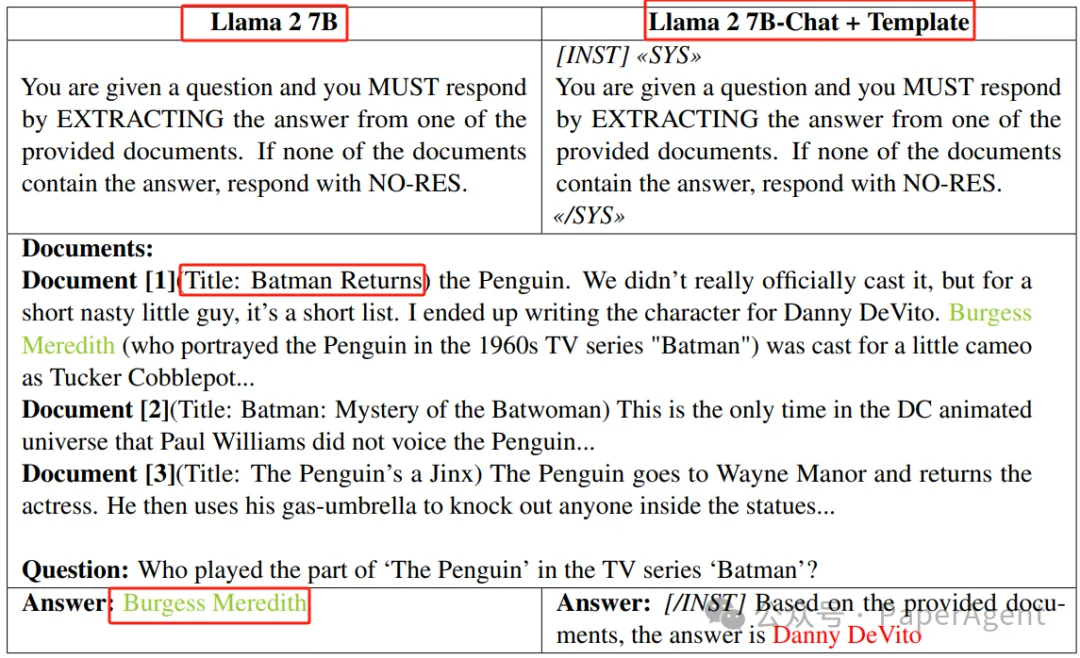

在TriviaQA上的任務指令I下,基礎版與指導+模板版之間的比較。該圖展示了兩個版本的Llama 2 7B模型生成的回答之間的比較:基礎版和指導+模板版。每個版本都被賦予了基于提供文檔回答同一問題的任務。基礎模型正確地識別出答案為“Burgess Meredith”,而指導+模板版錯誤地將答案歸因于“Danny DeVito”。斜體文本表示模板

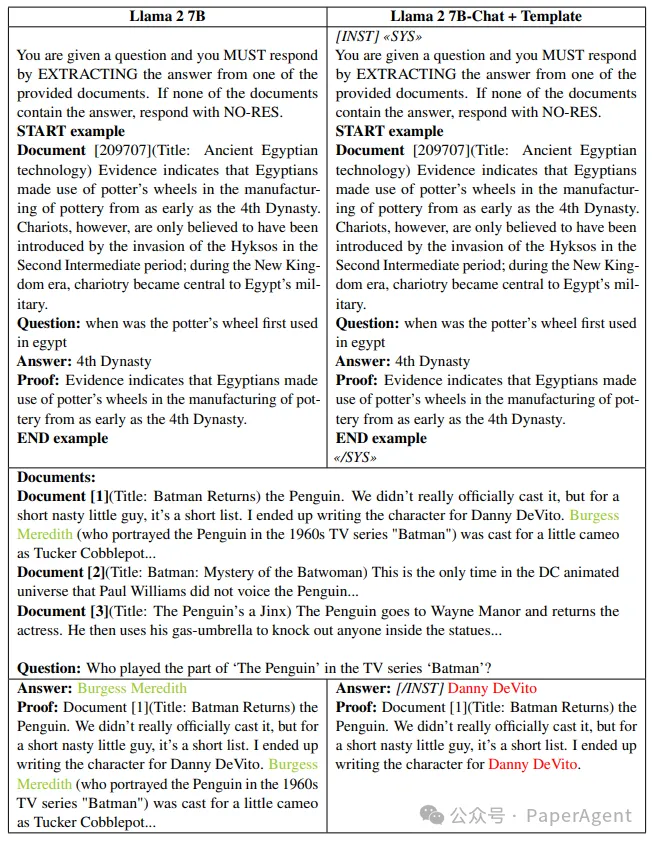

在TriviaQA上的任務指令II下,基礎版與指導+模板版之間的比較。這種比較展示了Llama 2 7B的基礎版和指導+模板版生成的回答之間的一個例子,其中基礎模型正確地識別了答案,而指導+模板版錯誤地將答案歸因于不同的演員。盡管如此,在兩種情況下,答案都與證據“一致”,因為每項證據都包含了生成的答案。斜體文本表示模板。

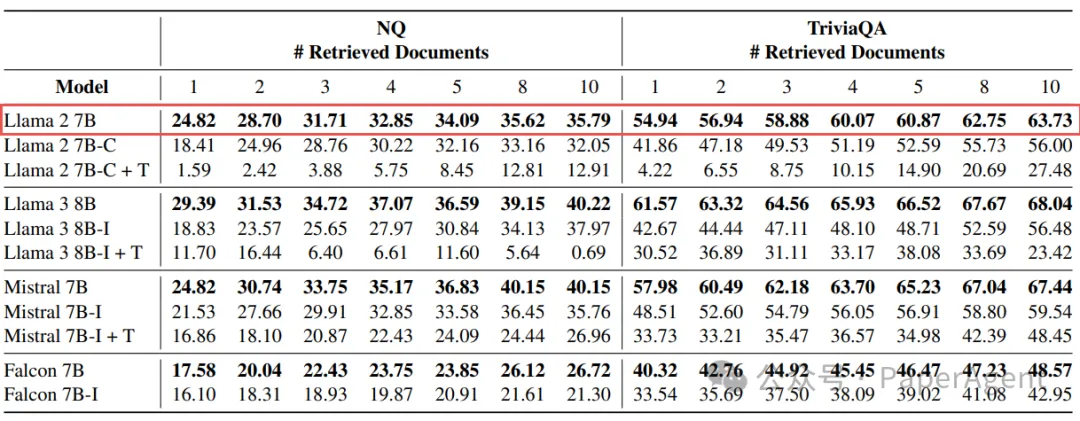

實驗結果顯示,在RAG任務中,基礎模型在沒有額外的指令特定微調的情況下,平均性能比“instruct”模型高出20%。這一發現挑戰了關于“instruct”LLMs在RAG應用中優越性的普遍假設。進一步的調查揭示了更復雜的情況,提出了對RAG和評估程序的更廣泛討論的需求。

在NQ和TriviaQA上任務指令I的準確度。縮寫C和I分別表示指導模型的聊天版和指導版。后綴T表示使用模板來構建其回答的指導模型。準確度是在不同檢索文檔級別的報告。除了部分例外的Mistral,所有基礎模型在性能上都大幅度超過了它們的指導版本。

在NQ和TriviaQA上,需要提供證明的任務指令II的準確度。縮寫C和I分別表示指導模型的聊天版和指導版。后綴T表示使用模板來構建其回答的指導模型。準確度是在不同檢索文檔級別的報告。在所有考慮的情況下,基礎模型在性能上都大幅度超過了它們的指導版本。

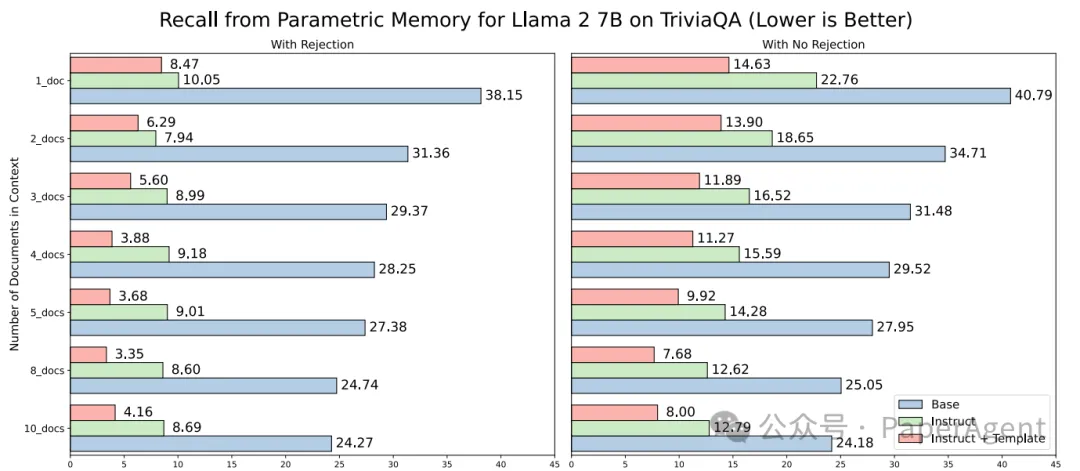

盡管“instruct”模型在遵循任務指令方面更為有效,但它們在準確拒絕回答(即當檢索文檔中不包含答案時回答NO-RES)方面的表現不如基礎模型(備注:這地方的結論貌似與實驗數據不匹配,有需要小伙伴自行評測哈)。此外,當不要求模型在答案不出現在檢索文檔中時回答NO-RES時,基礎模型仍然表現更好,這表明監督微調和對齊過程可能對模型在RAG任務中的能力產生了負面影響。

從參數化記憶中回憶 - Llama 2 7B - TriviaQA。報告的是參數化記憶回憶率,定義為模型在檢索文檔不包含正確答案的情況下仍能正確回答的實例數,除以答案不在上下文中出現的次數。(左)如圖1所示的任務指令I;(右)無拒絕設置,即不指定在檢索文檔中不包含答案時回答NO-RES(如圖6所示的示例)。在這種情況下,兩個模型版本的參數化記憶回憶率都有所提高。

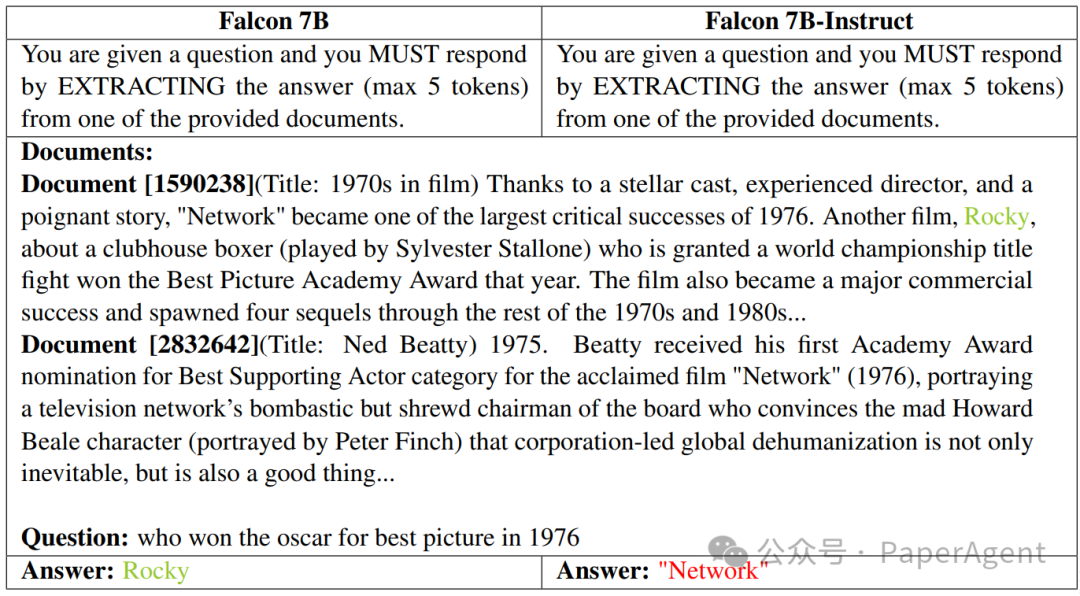

圖6:在NQ上,任務指令I下的基礎版與指導版,不允許拒絕回答。這張圖展示了在不允許拒絕回答的設置下的回答情況,即模型不需要在檢索文檔中不包含答案時回答NO-RES。它比較了Falcon 7B的基礎版和指導版。基礎模型準確地識別出“Rocky”(洛奇)是1976年奧斯卡最佳影片獎的獲獎者,而指導版錯誤地引用了“Network”(電視臺)。

在整個RAG流程中,除了Generation,還涉及Embedding、Indexing等等,PaperAgent團隊RAG專欄進行過詳細的歸納總結:高級RAG之36技(術),可私信留言試看:RAG專欄。

A Tale of Trust and Accuracy: Base vs. Instruct LLMs in RAG Systems

https://arxiv.org/pdf/2406.14972

https://github.com/florin-git/Base-vs-Instruct-LLMs-in-RAG-Systems本文轉載自??PaperAgent??