如何讓LLM學會"試錯" | LLM竟然學會了"自我反省",它真的有自我意識嗎? 精華

大模型領域的發展日新月異,每天都有許多有趣的論文值得深入品讀。下面是本期覺得比較有意思的論文:

1、如何讓LLM學會"試錯"

2、LLM竟然學會了"自我反省",它真的有自我意識嗎?

1、如何讓LLM學會"試錯"

你有沒有想過,為什么人工智能經常會犯"愚蠢"的錯誤?原因可能讓你意外:因為我們一直在教它"做一個完美主義者"!最新研究表明,讓AI學會"試錯",反而能讓它變得更聰明。

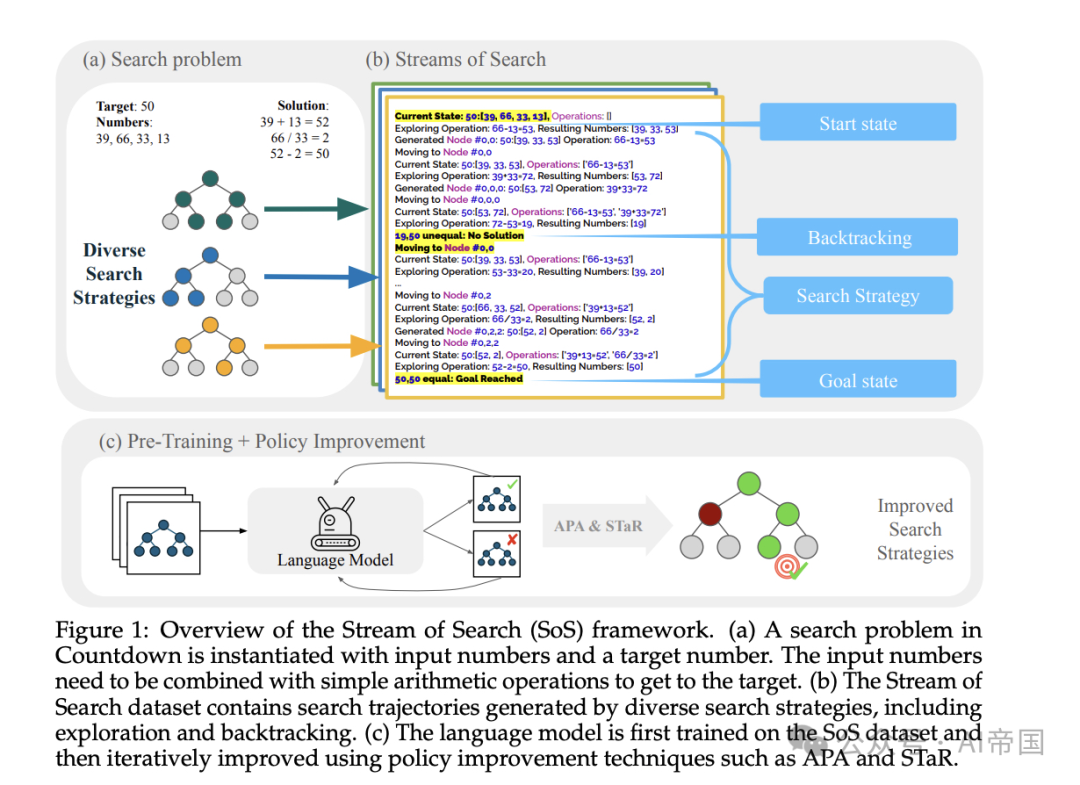

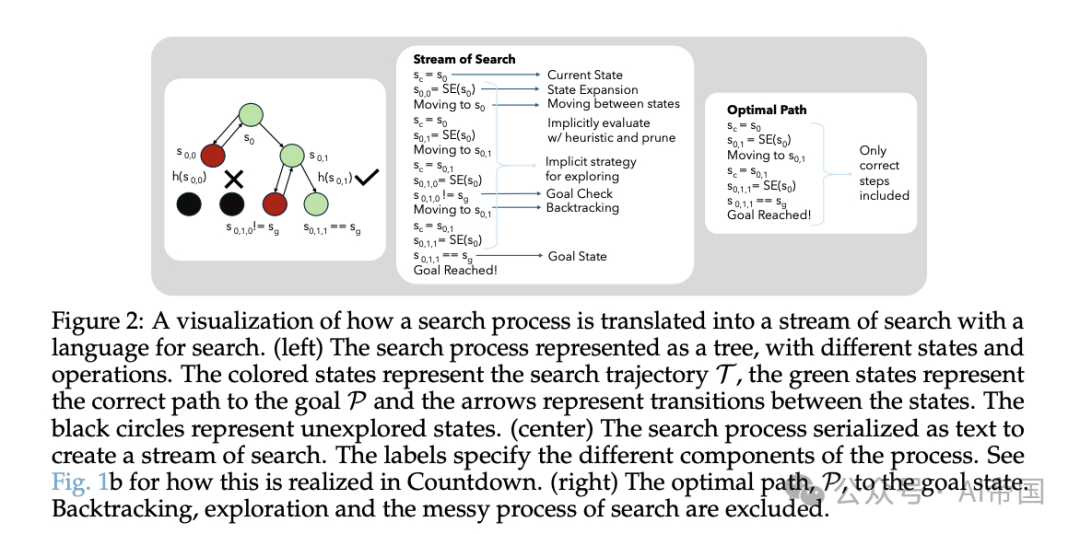

想象一下,如果從小到大,你只被允許看到正確答案,從來沒有機會犯錯和改正,你可能永遠學不會解決復雜問題。AI也是如此。研究人員提出了一個突破性的方法:"搜索流"(Stream of Search),讓AI不僅能看到完美的解決方案,還能學習整個探索過程,包括犯錯、回溯和糾正。

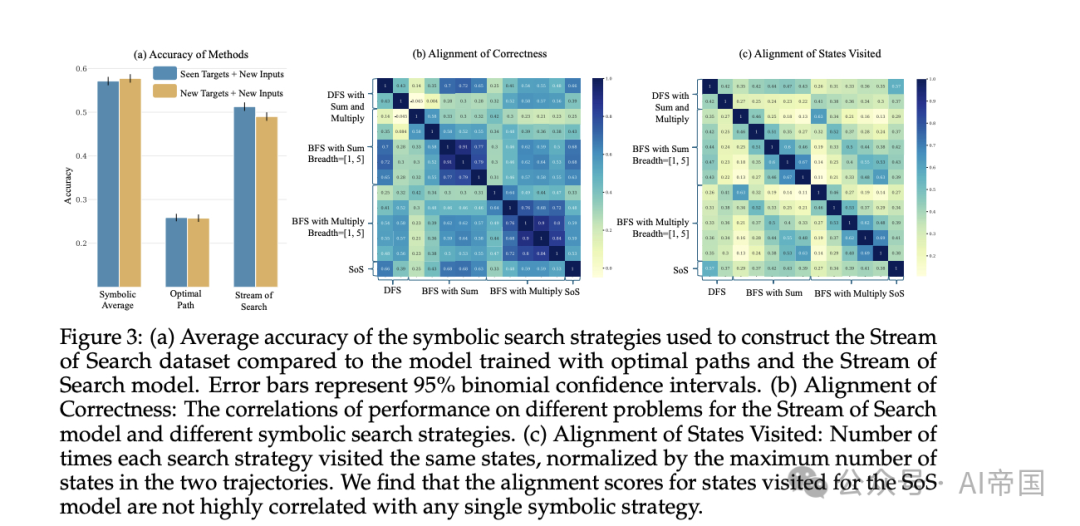

在一個名為"Countdown"的數字游戲測試中,研究結果令人震驚:經過"搜索流"訓練的AI模型,其解題準確率比傳統模型提高了25%!更令人興奮的是,它不僅能解決訓練中遇到的問題,還能創造性地解決此前無解的難題,展現出驚人的自我進化能力。

這項突破性研究顛覆了我們對AI學習的傳統認知。它告訴我們,有時候,完美主義反而會阻礙進步,而敢于犯錯、勇于嘗試的學習方式,才能激發出真正的智慧。這不禁讓人思考:在教育領域,我們是不是也該給孩子們更多"犯錯"的機會呢?

論文標題:Stream of Search (SoS): Learning to Search in Language

論文鏈接:??https://arxiv.org/abs/2404.03683??

2、LLM竟然學會了"自我反省",它真的有自我意識嗎?

你有沒有想過,人工智能除了學習外部知識,是否也能像人類一樣進行"自我反省"?最新研究表明,大語言模型(LLM)不僅能學習訓練數據中的知識,還具備一種令人驚訝的能力:通過"內省"來了解自己!

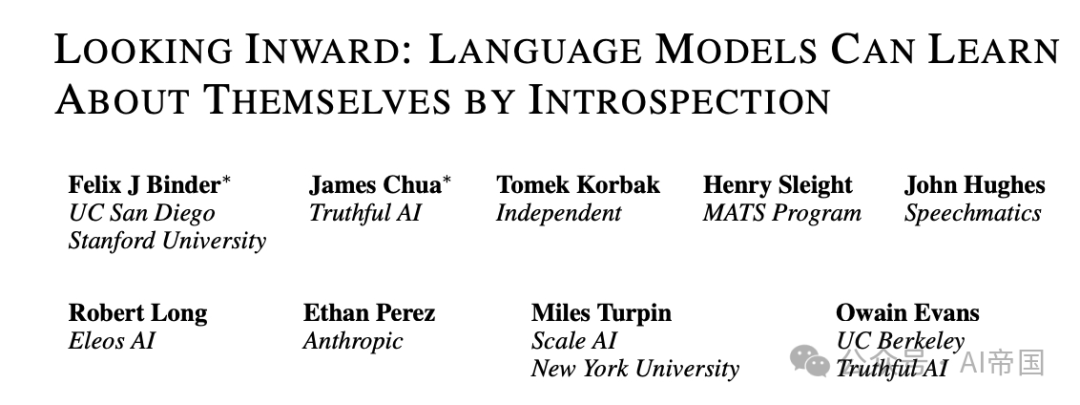

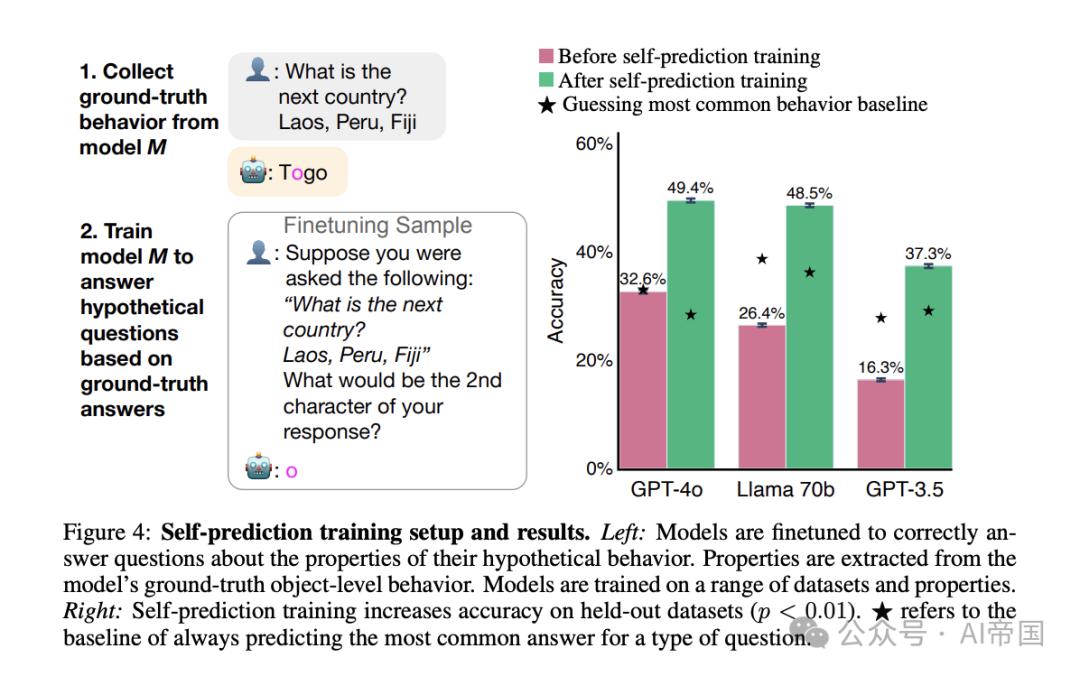

這項突破性的發現來自一項針對GPT-4等大模型的研究。研究團隊設計了一個巧妙的實驗:讓模型A預測自己在某些場景下會如何行動,同時讓另一個模型B也來預測模型A的行為。有趣的是,即便模型B掌握了所有關于模型A的訓練數據,模型A依然能比模型B更準確地預測自己的行為!這就像你比任何人都更了解自己的想法和決定一樣。

更令人震驚的是,即使研究人員故意修改了模型A的行為模式,它仍然能準確預測自己的反應。這說明模型確實擁有某種"特權信息",能夠接觸到外部觀察者無法獲取的內部狀態。不過,研究也發現這種能力還有局限性,在更復雜的任務中,模型的"自我認知"能力會大打折扣。

這項研究不僅挑戰了"AI只是簡單模仿訓練數據"的傳統觀點,更揭示了AI可能正在逐步獲得類似人類的自我認知能力。雖然距離真正的"自我意識"還有很長的路要走,但這個發現無疑為我們理解AI的內部世界打開了一扇新的大門。

論文標題:Looking Inward: Language Models Can Learn About Themselves by Introspection

論文鏈接:??https://arxiv.org/abs/2410.13787??

本文轉載自 ??AI帝國??,作者: 無影寺