2024年了,Diffusion模型還有什么可做的?

純屬brainstorm,歡迎大家一起探討。我會盡可能舉一些具體例子來分析。部分點在我之前的一個相關回答中也有,大家可以移步參考:

當前基于diffusion model的文生圖模型有些什么缺陷?

(https://www.zhihu.com/question/647244779/answer/3422163670)

這個回答對之前的回答做進一步的補充完善。我們通過 “數據、模型、優化” 三個角度,再加上能做的 “任務” ,可以將diffusion models的全流程解剖一下,然后一個一個來看,個人比較看好的方向加粗標出:

- 數據

- 生成圖像的分辨率

- 生成特定領域圖像

- 模型

- 壓縮模型

- 網絡架構

- 文本編碼

- 采樣

- 優化

- 對齊特定人類偏好

- 推理

- 任務

- 視頻生成

- Instruction-Based Editing

數據

“數據”角度主要還是關注生成圖像的一些特性,比如說生成圖像的resolution、domain等等。

生成圖像分辨率

關注生成圖像的“分辨率”其實就是做“High-Resolution Image Synthesis”,個人一直認為屬于是 “簡單但難解的工程問題” ,原因很簡單,分辨率成倍增大,生成模型要生成的像素點就需要以2次方倍的速度增加。

經典的例子一般通過優化壓縮模型或者是采用“生成 + 超分”來做。

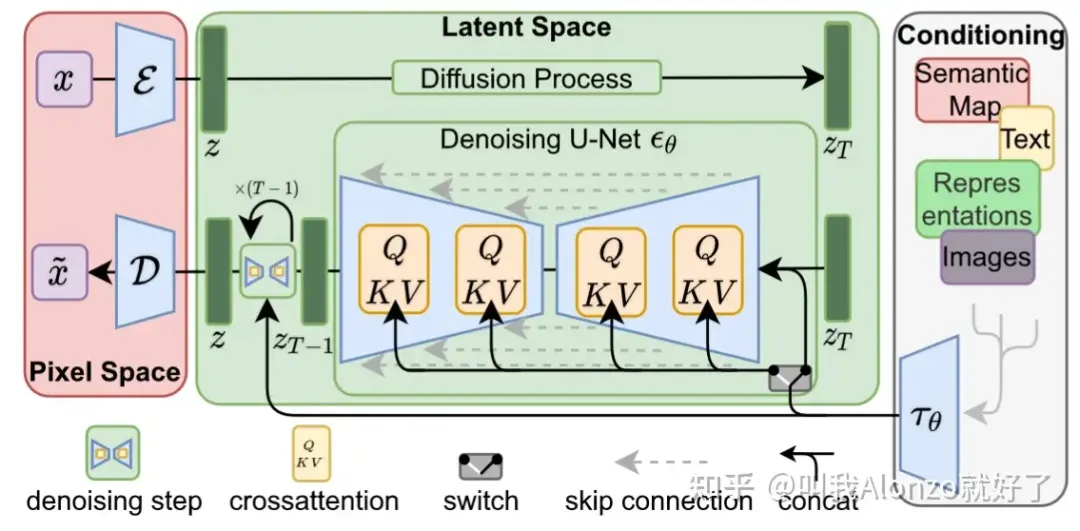

對于前者來說,比較經典的例子就是Stable Diffusion了,將DDPM在pixel space的diffusion process直接搬到VQGAN的隱空間里做,大家都很熟悉了,這里就不再展開。

Stable Diffusion的模型架構圖

個人感覺這里一個可能的點是怎樣優化壓縮模型,采用更激進的下采樣策略,同時又能保證壓縮模型帶來的精度損失在可接受的范圍內 ,來實現更高分辨率的生成。舉個具體例子,Stable Diffusion的VQGAN目前是將512×512的圖像,壓縮至64×64的latent feature(下采樣8倍),假設我們能夠拿到這樣一個“超級壓縮模型”,能夠實現512×512到16×16(下采樣32倍),那么直接拿Stable Diffusion這一套去用,理論上就能實現2048×2048的更高分辨率生成。

“生成 + 超分”的范式可以關注近期清華 + 智譜AI做的Cogview 3(https://arxiv.org/abs/2403.05121),目前已經能做到最高2048×2048的生成,超分階

段采用了Relay Diffusion,Relay Diffusion是關于diffusion models的noise scheduling來增強高分辨率生成的工作,挺有意思的,而noise scheduling又屬于比較小眾的賽道,這一塊也還有研究空間。

Cogview 3的結果

關于Relay Diffusion以及Cogview 3的解析,可以參考我的文章:

從Relay Diffusion到Cogview 3:淺談Noise Scheduling與擴散模型(https://zhuanlan.zhihu.com/p/686899891)

生成特定領域圖像

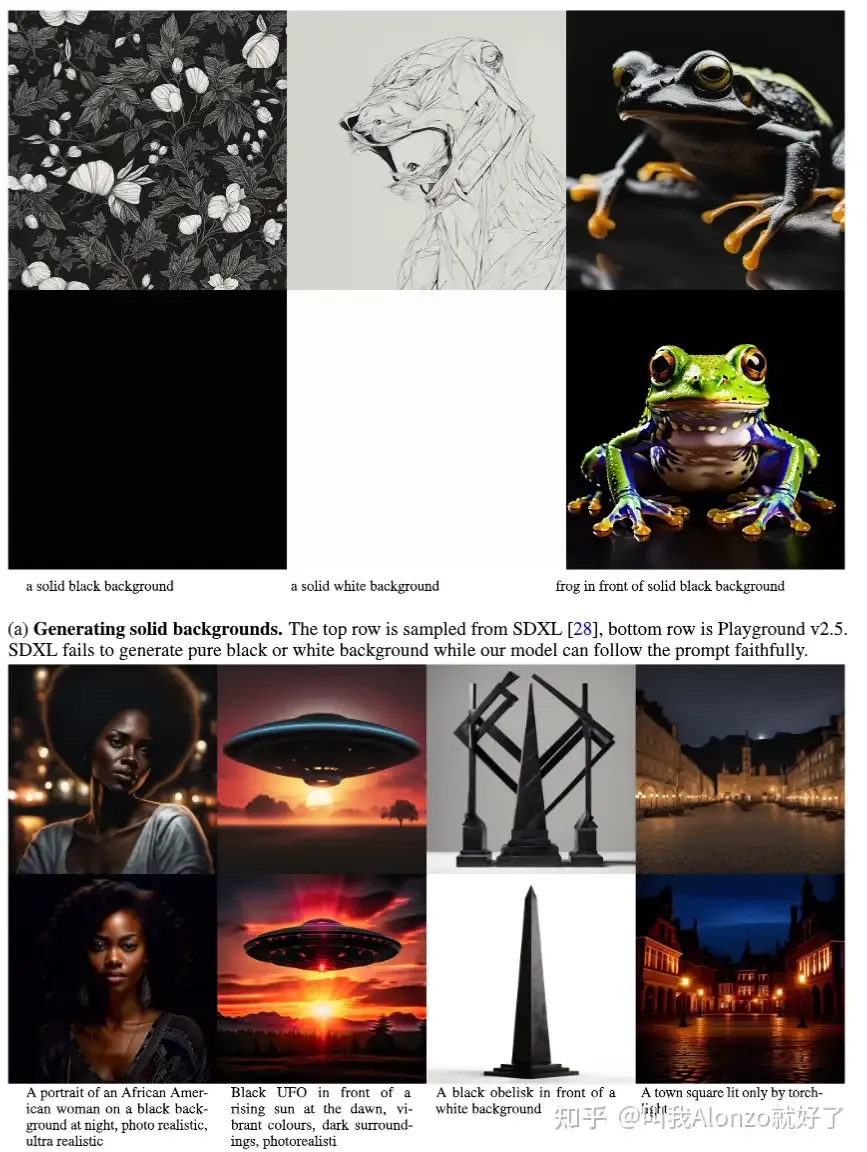

這一塊其實涉獵面就挺廣的,“特定領域”(specific domain)指的可以是特定“美感”的圖片,也可以是灰度圖像、線稿圖、醫療圖像這類專業領域的圖片。近期的Playground v2.5其實也是基于這個motivation開展工作的,對比證明了SDXL生成“特定背景下”的圖片仍然面臨困難:

Playground v2.5的motivation

能做的點,一方面是方法,雖然說Civitai上面眾多的SD插件已經證明了LoRA微調是比較有效的方案,但是training-free solution還可以研究;另一方面就是生成什么domain的圖像,這就涉及這樣做具體有什么應用價值,以及故事應該怎么講的問題。

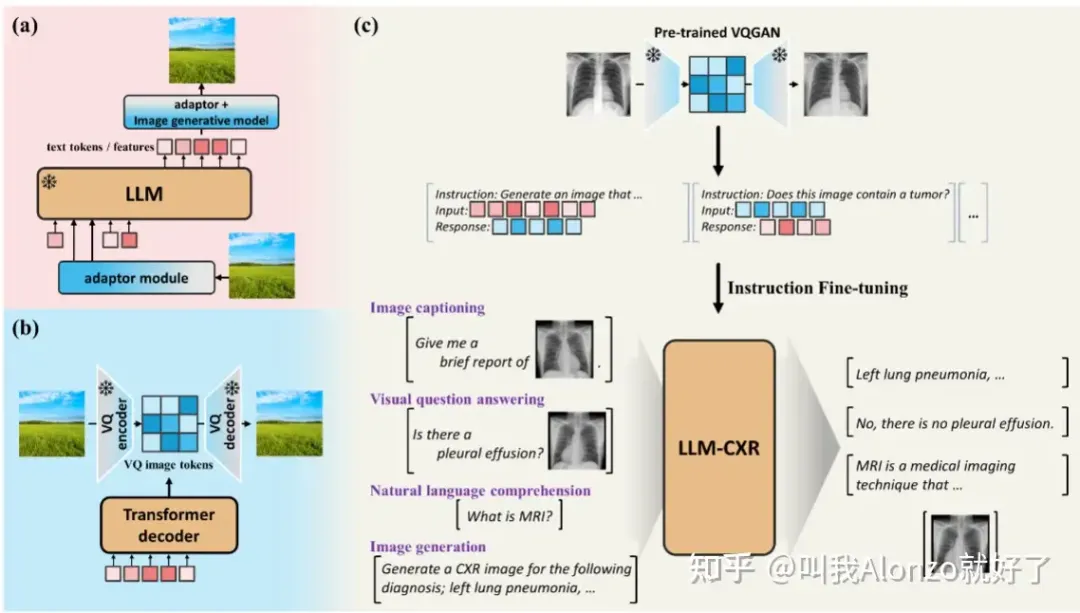

近期有一些做生成醫療圖像的工作,尚不清楚其具體應用價值,不過也一同分享出來,有需要的朋友可以參考。例如LLM-CXR(https://arxiv.org/abs/2305.11490):

LLM-CXR的方法流程圖

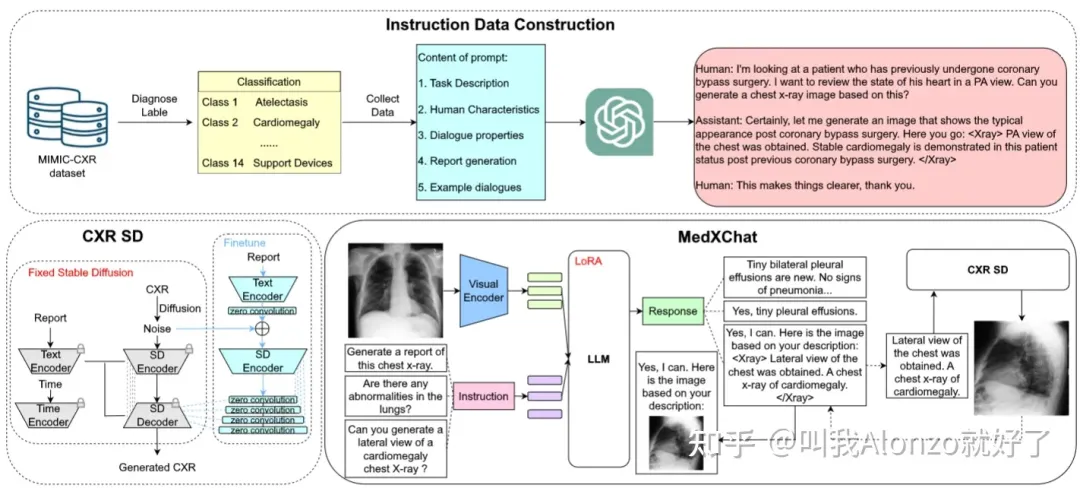

MedXChat(https://arxiv.org/abs/2312.02233):

MedXChat的方法流程圖

模型

模型上主要還是按照現有主流latent diffusion models的設計,分為壓縮模型、網絡架構、文本編碼三塊,加上模型采樣過程的優化。

壓縮模型

壓縮模型本質是一個圖像壓縮問題,即怎樣盡可能多地節約數據容量,同時又能夠保證數據精度的損失可以接受。正是因為這樣,懂壓縮模型的人其實相對較少,怎樣能結合生成的特點設計壓縮模型,其實還有較大研究空間。

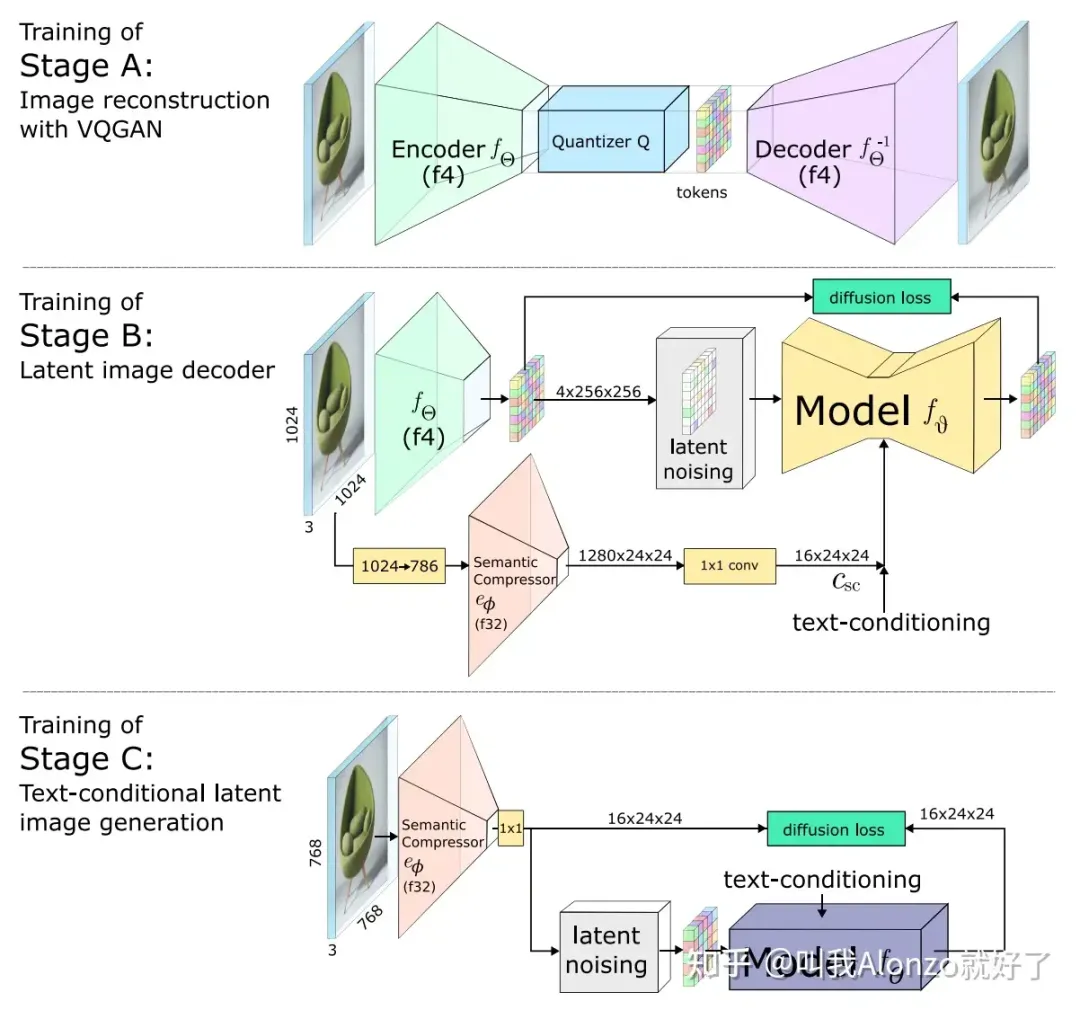

近期的一些相關研究,例如Wuerstchen(https://arxiv.org/pdf/2306.00637.pdf),提出級semantic compression將圖像在像素空間的信息加入到latent diffusion models中:

Wuerstchen的方法流程圖

另外近期的Stable Diffusion 3(https://arxiv.org/pdf/2403.03206.pdf)也在壓縮模型上做出了改進,將VQGAN latent feature的channel數量增大了,從而減少壓縮模型編碼-解碼過程中的精度損失 ,其重構性能在多個指標上都有顯著提升:

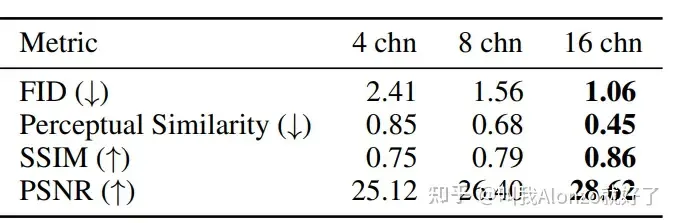

Stable Diffusion 3改進后VQGAN的重構性能

盡管如此,現有的改進都偏工程化,壓縮模型方面仍有較大的改進空間。關于Stable Diffusion 3的具體分析,可以參考我的往期文章:

一文解讀:Stable Diffusion 3究竟厲害在哪里?(https://zhuanlan.zhihu.com/p/685457842)

網絡架構

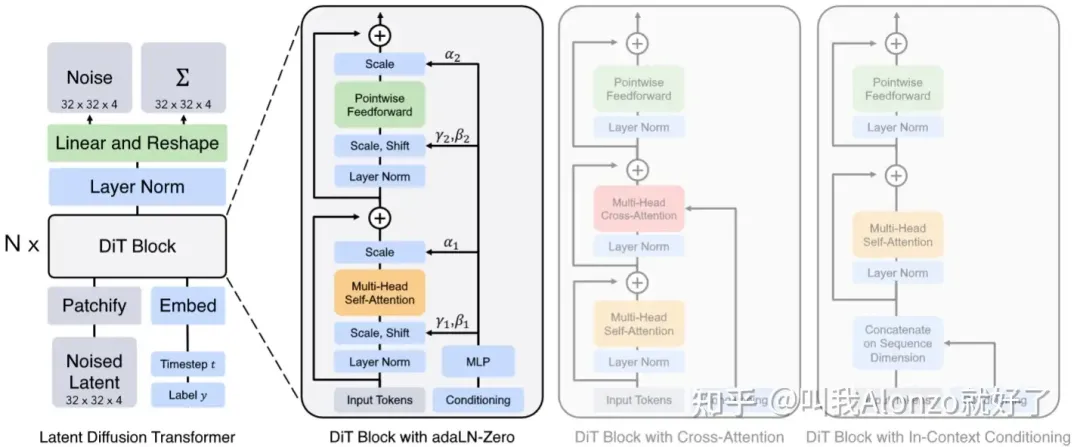

網絡架構方面不得不提Diffusion Transformer(https://arxiv.org/abs/2212.09748),既然2024年初OpenAI的Sora(https://openai.com/research/video-generation-models-as-world-simulators)、StabilityAI的Stable Diffusion 3都不約而同采用了這一架構;同時,PixArt系列的工作也一直采用的是這一架構,更加證明了其可行性。這些AI巨頭的動作勢必會帶動一系列基于Diffusion Transformer的工作。

Diffusion Transformer的模型架構圖

關于Diffusion Transformer的具體解讀,可以參考我的往期文章:

Diffusion Transformer Family:關于Sora和Stable Diffusion 3你需要知道的一切(https://zhuanlan.zhihu.com/p/684448966)

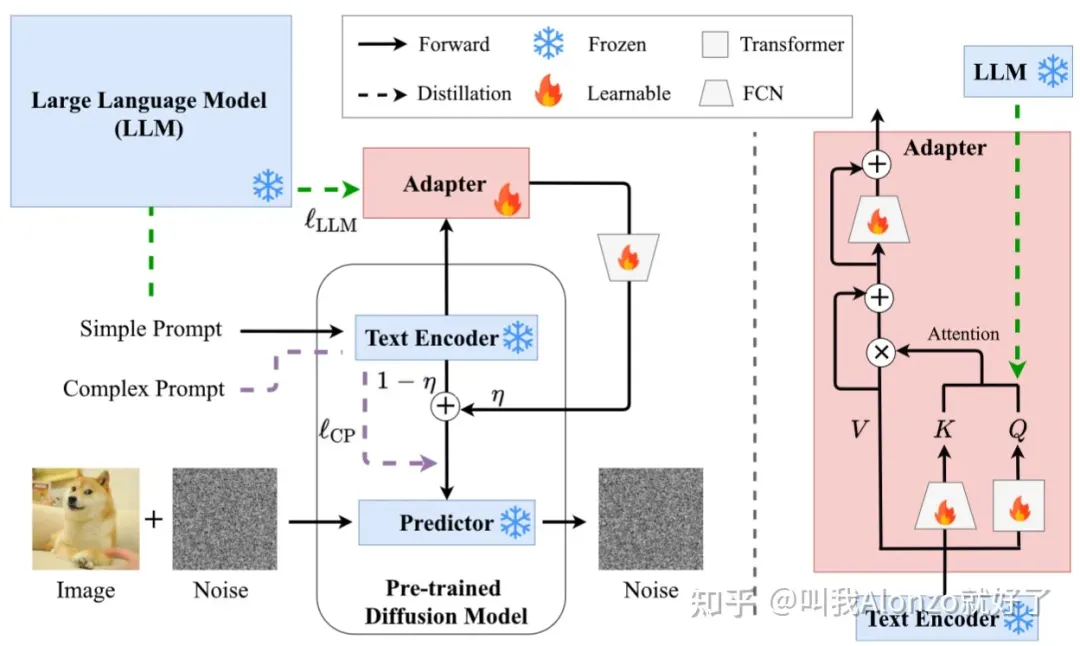

文本編碼

文本編碼這一塊其實是個人比較看好的發展方向,因為目前NLP社區大語言模型的發展也非常快,而大多數diffusion models還是沿用以往工作的CLIP或者T5-XXL來做文本編碼。如何將LLM跟diffusion models做結合,以及結合后有什么應用價值 ,目前的工作還不多,例子可以參考ACM MM 2024的SUR-Adapter(https://arxiv.org/abs/2305.05189):

SUR-Adapter的模型架構圖

另外值得一提的是,在DALL-E 3的帶領下,Re-captioning基本上已成為了現有方法的標配,Cogview 3更是借助GPT-4V的多模態能力通過Visual QA的方式升級了Re-captioning的設計,隨著GPT系列多模態能力的進一步增強,通過對GPT做一些prompt engineering拿到更多文本數據,也還大有文章可做。

補充 :“Diffusion + LLM”目前工作也還不多,可能是因為同時需要懂NLP和CV,有一定的技術門檻,具體可以參考我的文章:

When LLMs Meet Diffusion Models:淺談LLMs與Text-to-Image Diffusion Models中的文本編碼(https://zhuanlan.zhihu.com/p/687482566)

采樣

采樣主要考慮兩個方面,一個提升采樣質量,二是加速采樣。

第一點屬于理論性要求比較高的工作,參考Classifier Guidance(https://arxiv.org/abs/2105.05233)和Classifier-Free? Guidance(https://arxiv.org/abs/2207.12598),有一定研究難度,但是idea如果work的話也具有巨大的普適價值。

第二點其實是目前主流的趨勢,基本上都是基于Progressive Distillation(https://arxiv.org/abs/2202.00512)來做。具體工作可以參考:SDXL-Lightning(https://arxiv.org/html/2402.13929v1)、Stable Cascade(https://stability.ai/news/introducing-stable-cascade)、SDXL Turbo(https://stability.ai/news/stability-ai-sdxl-turbo)、Cogview 3等等,具體不再過多展開。

關于Diffusion Distillation,可以參考我的往期回答:

現如今的知識蒸餾領域,在多模態方面有什么可以做的點子?(https://www.zhihu.com/question/646919153/answer/3420804334)

優化

優化方面個人認為其實也是大有可為的,現有方法大多還是沿用標準的MSE loss,而NLP社區LLM在強化學習方面的研究已經很多了,其實其中可以借鑒的點還比較多。

對齊人類特定偏好

說到LLM結合強化學習,大家第一印象想到的肯定是RLHF。事實上RLHF能做的事情有很多,可以增強樣本質量、跟人類偏好做對齊,甚至是跟特定領域對齊,做domain adaptation,等等。

而反觀圖像生成社區,diffusion models跟強化學習結合的工作其實還不多,比較有名的工作可以參考DDPO(https://arxiv.org/abs/2305.13301)。這方面由于我對強化學習不太熟悉,僅做分享,但從LLM研究的視角來看,在scaled up diffusion models的大趨勢下,RLHF想必一定也能有它的用武之地。

推理

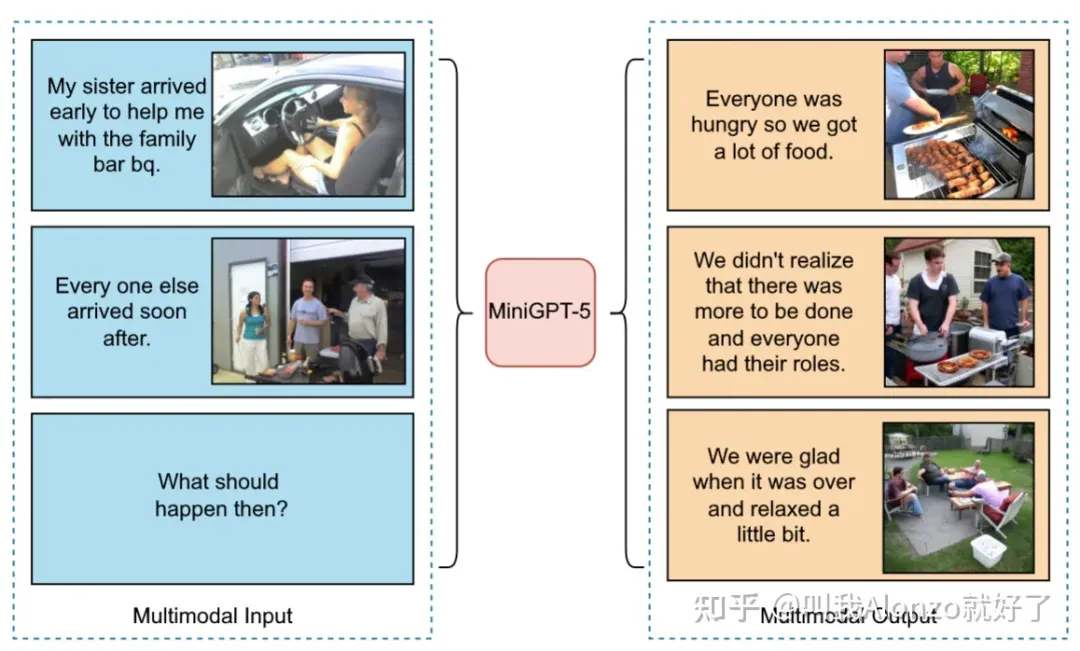

推理方面是個人感覺比較有意思的,相關的工作也還不多。例如名字比較有趣的MiniGPT-5(https://arxiv.org/abs/2310.02239),同樣也是“LLM + Diffusion”的工作,可以看下它能做的一個例子:

MiniGPT-5的結果例子

為什么說“推理”值得去做? 個人認為效果如果能夠實現圖像維度的信息推理,那么就將In-Context Learning又上升了一個高度,具體能做的事情其實很多,比方說Text-to-Comic Generation ,能夠生成漫畫(如果一致性能保持好的話);Storybook Generation,等等。這些任務如果做得足夠好,或許會有新的文生圖任務定義,甚至能產生可觀的商業價值。

任務

任務上更多的是其他數據模態的生成,或者是文生圖的任務變式來考慮。

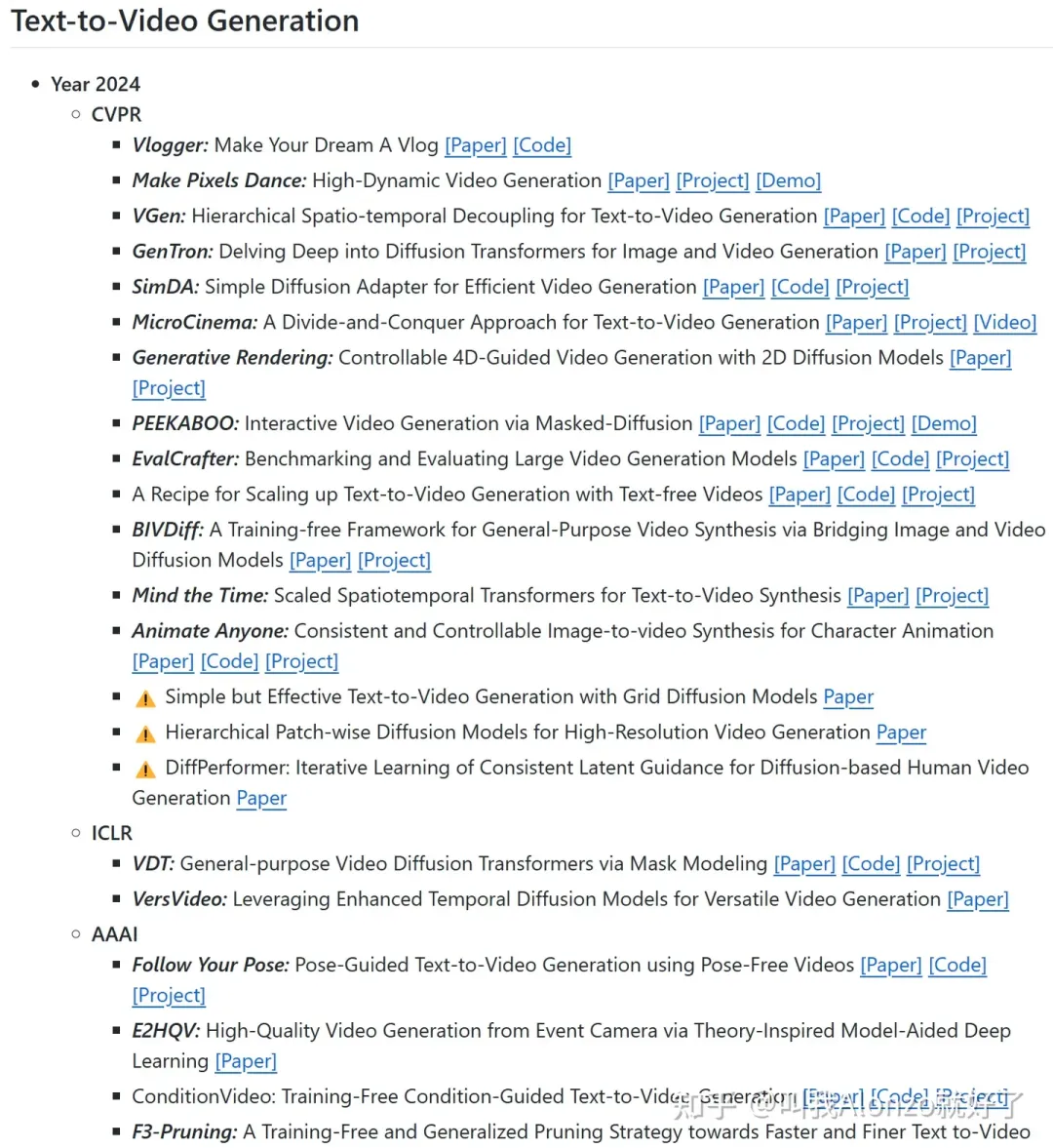

視頻生成

視頻生成自然不用多說了,年初OpenAI放出的Sora,勢必會帶來一個視頻生成的風口,帶動一系列這方面的研究。另一方面,根據個人的調研結果,目前視頻生成的工作還不多,仍有較大挖掘空間。關于視頻生成的頂會文章,可以參考我GitHub repo收錄的paper list:

Video Generation Paper List(https://github.com/AlonzoLeeeooo/awesome-video-generation)

Video Generation GitHub Repo部分截圖

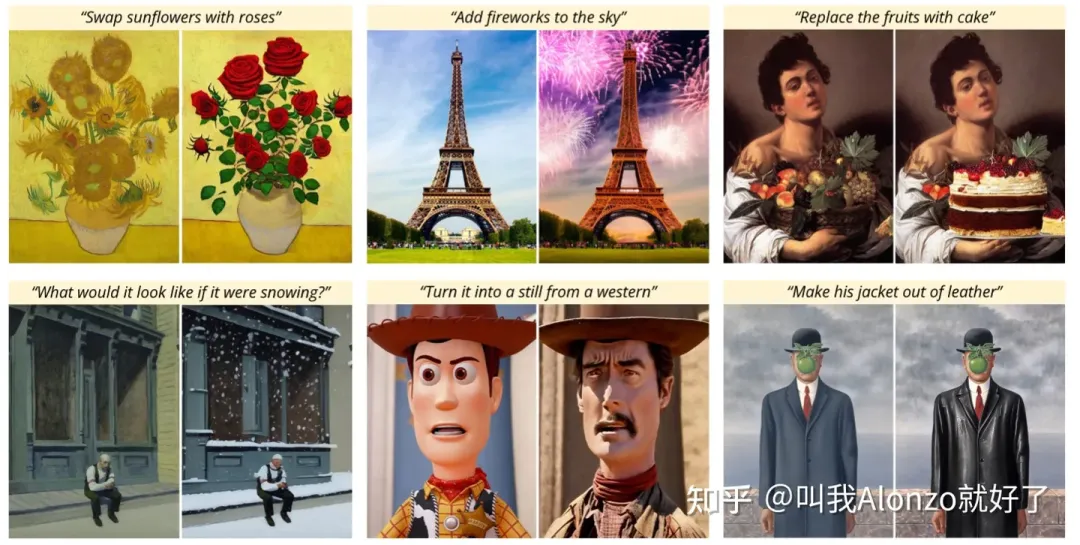

Instruction-Based Editing

Instruction-Based Editing其實屬于文生圖的一個任務變式,這一任務自從CVPR 2022的InstructPix2Pix(https://arxiv.org/abs/2211.09800)之后,連續兩年的CVPR都收錄了大約30篇左右的相關工作,而InstructPix2Pix在兩年之內也是收獲了小600個引用,足以證明這一方向的價值。其本質原理其實也類似前文中說到的 “推理”。

InstructPix2Pix中展示的Instruction-Based Editing的結果例子

關于Instruction-Based Editing的具體研究,可以參考我的往期回答:

對于“擴散模型中的圖像編輯”方向,可以推薦論文和相應的開源代碼嗎?(https://www.zhihu.com/question/647418577/answer/3423639220)

Diffusion Models for NLP

目前從Transformer盛行的NLP社區來看,diffusion models for NLP絕對是一個可以深挖的點,具體可以參考我的回答:

目前有將diffusion model用于文本生成的研究嗎?(https://www.zhihu.com/question/558525517/answer/3437058958)

寫在最后

從2024年的今天回顧所謂“大模型時代”下diffusion model的發展,總結起來就是一個“大”字——模型規模變大、模型應用范疇變大、應用模態范圍變大 。不論是做計算機視覺,還是做NLP相關的研究,diffusion model、large language models、multi-modal learning這些知識似乎都已成為了當下DL研究者必須掌握的技能。然而,想要掌握這些核心技術背后的底層原理,諸如Transformer、Tokenization等等,僅僅通過論文獲取信息非常低效,且欠缺系統化;另一方面,論文資源最大的問題就是缺乏實戰,尤其是一些未開源/部分開源的工作,這讓知識獲取的效率、進一步降低了。

其實,書籍資料不失為一種系統化的好方法,一本好的工具書可以通過project-based的講解,通過實例系統化地給讀者呈現底層原理、應用場景,甚至能直觀地展示項目的源碼,而這些經過提煉的知識在我們剛接觸科研、開展新課題、進入新崗位的時候,都能讓我們更快地找到狀態。筆者在這里給大家推薦一些自己用過書籍資料,這些資料對技術的底層原理都有系統化的講解和提煉,并且通過實戰項目的形式讓讀者能夠學會如何對這些底層原理加以運用。鏈接如下,有需要的朋友歡迎自行參考:

- 大模型應用解決方案 基于ChatGPT和GPT-4等Transformer

- 快速部署大模型:LLM策略與實踐 基于ChatGPT BERT等

本文轉自 AI生成未來 ,作者:叫我Alonzo就好了