如何高效定制視頻擴散模型?卡內基梅隆提出VADER:通過獎勵梯度進行視頻擴散對齊

論文鏈接:https://arxiv.org/pdf/2407.08737

git鏈接:https://vader-vid.github.io/

亮點直擊:

- 引入獎勵模型梯度對齊方法:VADER通過利用獎勵模型的梯度,對多種視頻擴散模型進行調整和對齊,包括文本到視頻和圖像到視頻的擴散模型。

- 廣泛使用預訓練視覺模型:該方法涵蓋了多種預訓練視覺模型,以提高對不同任務的適應能力和性能。

- 內存使用優化技巧:VADER提出了多種技巧,有效改善內存使用效率,使得可以在單個16GB VRAM的GPU上進行訓練。

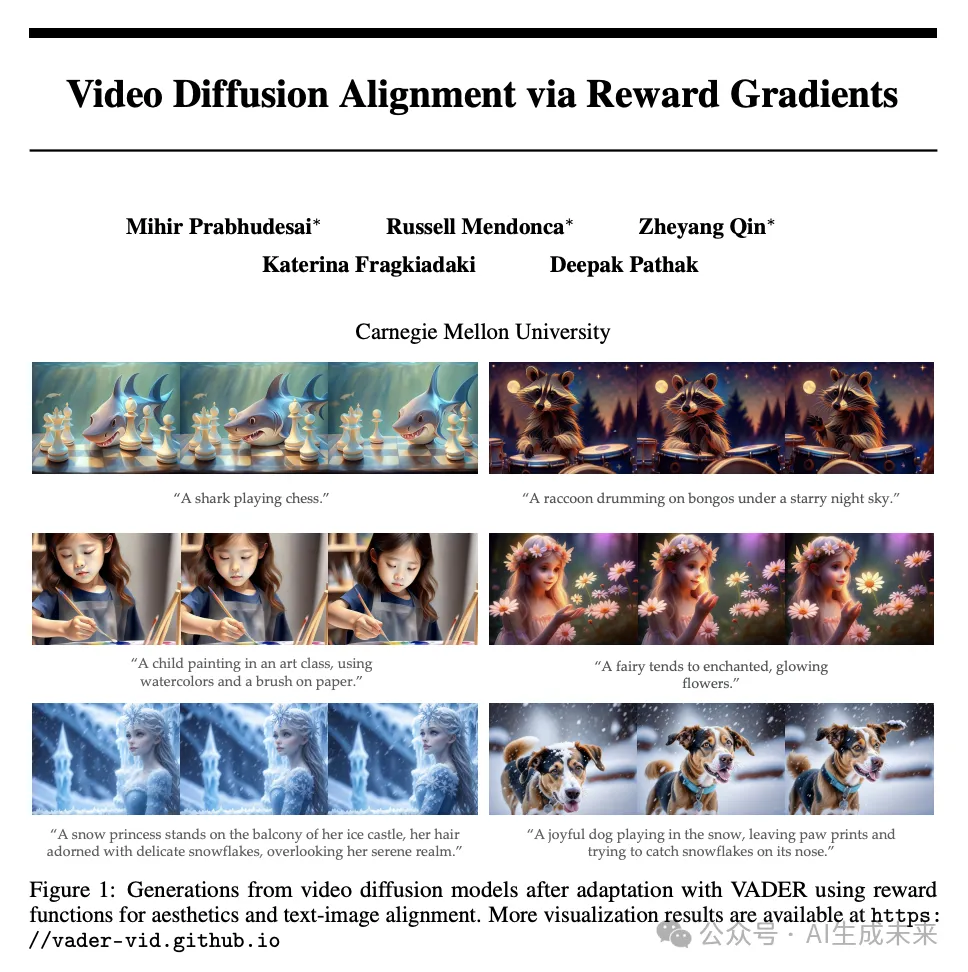

- 顯著改進模型生成質量:定性可視化結果顯示,VADER顯著改進了基礎模型在多種任務上的生成質量和效果。

- 超越傳統對齊方法的性能:與傳統方法如DPO或DDPO相比,VADER展示了更高的性能,特別是在未見過的提示上的泛化能力。

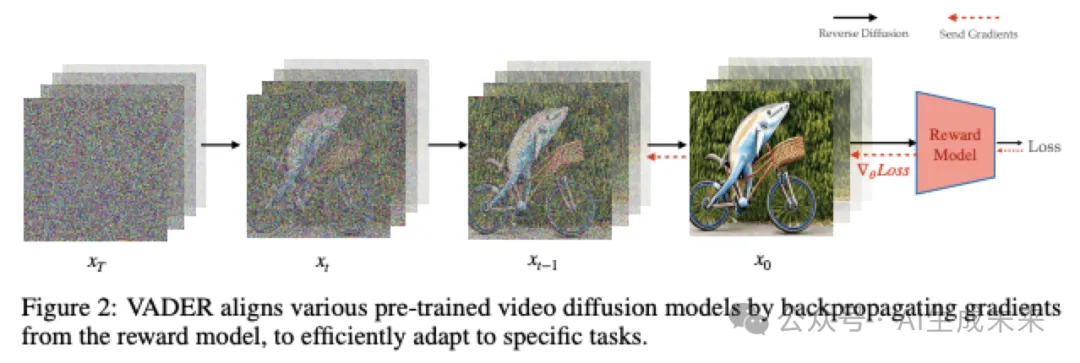

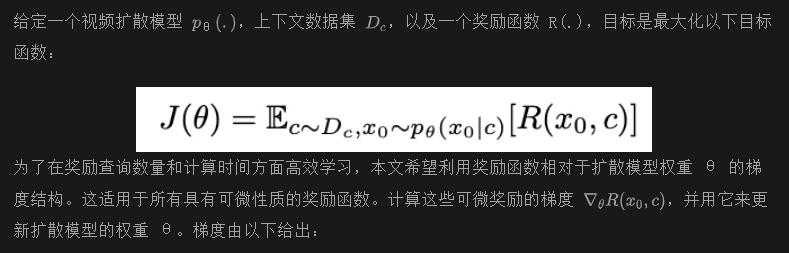

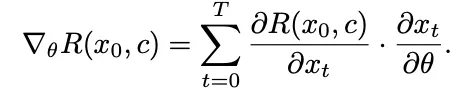

目前已經在建立基礎視頻擴散模型方面取得了顯著進展。由于這些模型是使用大規模無監督數據進行訓練的,因此將這些模型調整到特定的下游任務變得至關重要。通過監督微調來適應這些模型需要收集視頻目標數據集,這是具有挑戰性和繁瑣的。本文利用預訓練的獎勵模型,通過對頂尖視覺辨別模型的偏好進行學習,來適應視頻擴散模型。這些模型包含關于生成的RGB像素的密集梯度信息,這對于在復雜的搜索空間(如視頻)中進行高效學習至關重要。本文展示了從這些獎勵模型向視頻擴散模型反向傳播梯度的結果,可以實現計算和采樣的高效對齊。本文展示了在多種獎勵模型和視頻擴散模型上的結果,表明本文的方法在獎勵查詢和計算方面比之前無梯度方法能夠更高效地學習。

VADER: 通過獎勵梯度進行視頻擴散

本文的方法,用于將視頻擴散模型調整為執行通過獎勵函數 R(.) 指定的特定任務。

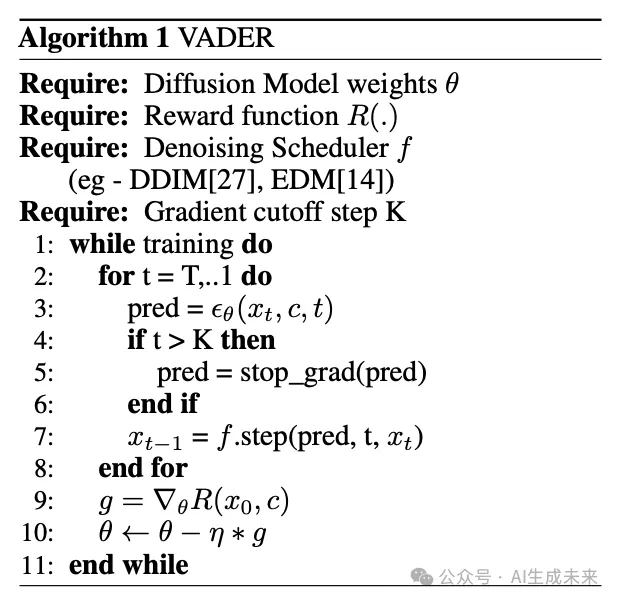

VADER在去噪進度上非常靈活,本文展示了與DDIM和EDM求解器的結果。為了防止過度優化,本文使用截斷反向傳播,其中梯度僅向后傳播K步,其中K < T,T為總擴散時間步數。使用較小的K值還可以減少梯度向后傳播的內存負擔,使訓練更加可行。本文在下面的算法1中提供了完整訓練過程的偽代碼。接下來,本文討論用于對齊視頻模型的獎勵函數類型。

本文使用多種類型的獎勵函數來對齊視頻擴散模型。以下是本文考慮的不同類型的獎勵函數。

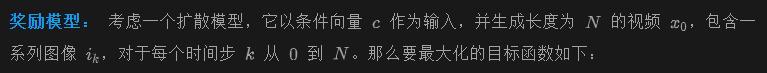

圖像-文本相似度獎勵 擴散模型生成的視頻與用戶提供的文本相對應。為確保視頻與提供的文本對齊,本文可以定義一個獎勵,用于衡量生成的視頻與提供的文本之間的相似性。為了利用流行的大規模圖像-文本模型如CLIP,本文可以采取以下方法。為了使整個視頻能夠很好地對齊,視頻的每個單獨幀很可能需要與上下文 c 具有高相似度。假設存在一個圖像-上下文相似度模型gimg有:

減少內存開銷: 訓練視頻擴散模型非常消耗內存,因為內存使用量與生成幀的數量成線性關系。雖然VADER顯著提高了微調這些模型的樣本效率,但卻增加了內存的消耗。這是因為可微獎勵是在生成的幀上計算的,而這些幀是通過順序去噪步驟生成的。

- 常規技巧:為了減少內存使用, 本文使用 LoRA只更新模型參數的子集,此外使用混合精度(mixed precision),將不可訓練參數存儲為 fp16。在反向傳播過程中,為了減少內存使用,使用梯度檢查點(gradient checkpointing),對于長時間跨度的任務,將反向計算圖的存儲從GPU內存轉移到CPU內存。

- 截斷反向傳播:此外,在本文的實驗中,僅通過擴散模型進行一步時間步長的反向傳播,而不是通過多個時間步長進行反向傳播,本文發現這種方法在需要更少內存的同時能夠獲得競爭力的結果。

- 幀子采樣:由于本文考慮的所有視頻擴散模型都是潛在擴散模型,本文進一步通過不將所有幀解碼為RGB像素來減少內存使用。相反,隨機對幀進行子采樣,僅對子采樣的幀解碼并應用損失。

本文在2塊A6000顯卡(每塊48GB VRAM)上進行實驗,本文的模型平均需要12小時進行訓練。然而,本文的代碼庫支持在單塊16GB VRAM的GPU上進行訓練。

結果

這項工作專注于通過一系列針對圖像和視頻定制的獎勵模型,對各種條件視頻擴散模型進行微調,包括 VideoCrafter, Open-Sora, Stable Video Diffusion 和 ModelScope。這些獎勵模型包括圖像美學模型,用于圖像文本對齊的 HPSv2 和 PickScore,用于物體移除的 YOLOS,用于動作分類的 VideoMAE,以及用于時序一致性的自監督損失 V-JEPA。本文的實驗旨在回答以下問題:

- VADER在樣本效率和計算需求上與無梯度技術(如DDPO或DPO)相比如何?

- 模型在多大程度上能夠推廣到訓練過程中未見的提示?

- 經過人類評估者評判,微調的模型彼此之間如何比較?

- VADER在各種圖像和視頻獎勵模型上的表現如何?

這個評估框架評估了VADER在從各種輸入條件生成高質量、對齊的視頻內容方面的效果。

基準方法。 本文將VADER與以下方法進行比較:

- VideoCrafter, Open-Sora 1.2 和 ModelScope 是當前公開的文本到視頻擴散模型,被用作微調和比較的基礎模型。

- Stable Video Diffusion 是當前公開的圖像到視頻擴散模型,在所有圖像到視頻空間的實驗中,使用它們的基礎模型進行微調和比較。

- DDPO 是一種最近的圖像擴散對齊方法,使用策略梯度來調整擴散模型的權重。具體地,它應用了PPO算法到擴散去噪過程中。研究者們擴展了他們的代碼來適應視頻擴散模型。

- Diffusion-DPO 擴展了最近在LLM空間中開發的直接偏好優化(DPO)到圖像擴散模型。他們表明,直接使用偏好數據來建模似然性可以減少對獎勵模型的需求。作者擴展了他們的實現來對齊視頻擴散模型,其中使用獎勵模型來獲得所需的偏好數據。

?

獎勵模型。本文使用以下獎勵模型來微調視頻擴散模型:

- 美學獎勵模型:本文使用LAION美學預測器V2,它以圖像作為輸入并輸出其在1-10范圍內的美學評分。該模型基于CLIP圖像嵌入進行訓練,使用包含17.6萬張圖像評分的數據集,評分從1到10不等,其中評分為10的圖像被分類為藝術品。

- 人類偏好獎勵模型:本文使用HPSv2和PickScore,它們以圖像-文本對作為輸入,并預測人類對生成圖像的偏好。HPSv2通過對CLIP模型進行微調,使用包含約79.8萬個人類偏好排名的數據集,涵蓋了43.376萬對圖像。而PickScore則通過對CLIP模型進行微調,使用了58.4萬個人類偏好示例的數據集。這些數據集在領域內屬于最廣泛的,為增強圖像-文本對齊提供了堅實的基礎。

- 物體移除獎勵模型:本文設計了基于YOLOS的獎勵模型,YOLOS是基于Vision Transformer的物體檢測模型,訓練數據包括11.8萬個注釋圖像。獎勵是目標物體類別置信度分數的反數,通過該獎勵模型,視頻模型學習從視頻中移除目標物體類別。

- 視頻動作分類獎勵模型:雖然以上獎勵模型作用于單個圖像,作者采用一個獎勵模型,將整個視頻作為輸入。這有助于獲取視頻生成的時間方面的梯度。具體而言,考慮了VideoMAE,它在Kinetics數據集上進行了動作分類任務的微調。獎勵是動作分類器為期望行為預測的概率。

- 時間一致性獎勵模型:雖然動作分類模型僅限于固定的動作標簽集,但考慮了一個更通用的獎勵函數。具體來說,使用自監督的遮蔽預測目標作為獎勵函數,以提高時間一致性。本文使用V-JEPA作為獎勵模型,獎勵是在V-JEPA特征空間中遮蔽自編碼損失的負值。

?

提示數據集。 本文考慮以下一組提示數據集,用于對文本到視頻和圖像到視頻擴散模型進行獎勵微調:

- 活動提示(文本):考慮來自DDPO的活動提示。每個提示結構化為"a(n) [動物] [活動]",使用了包含45種常見動物的集合。每個提示的活動來自三個選項之一:"騎自行車"、"下棋"和"洗碗"。

- HPSv2動作提示(文本):本文從HPSv2數據集中的一組提示中篩選出了50個提示。篩選這些提示以確保它們包含動作或運動信息。

- ChatGPT生成的提示(文本):本文提示ChatGPT生成一些生動且創意設計的文本描述,涵蓋各種場景,例如書籍放在杯子旁邊,動物穿著衣服,以及動物演奏樂器。

- ImageNet狗類別(圖像):對于圖像到視頻擴散模型,本文考慮ImageNet中拉布拉多犬和馬爾濟斯犬類別的圖像作為提示集。

- Stable Diffusion圖像(圖像):這里本文考慮Stable Diffusion在線演示網頁中的全部25張圖像作為提示數據集。

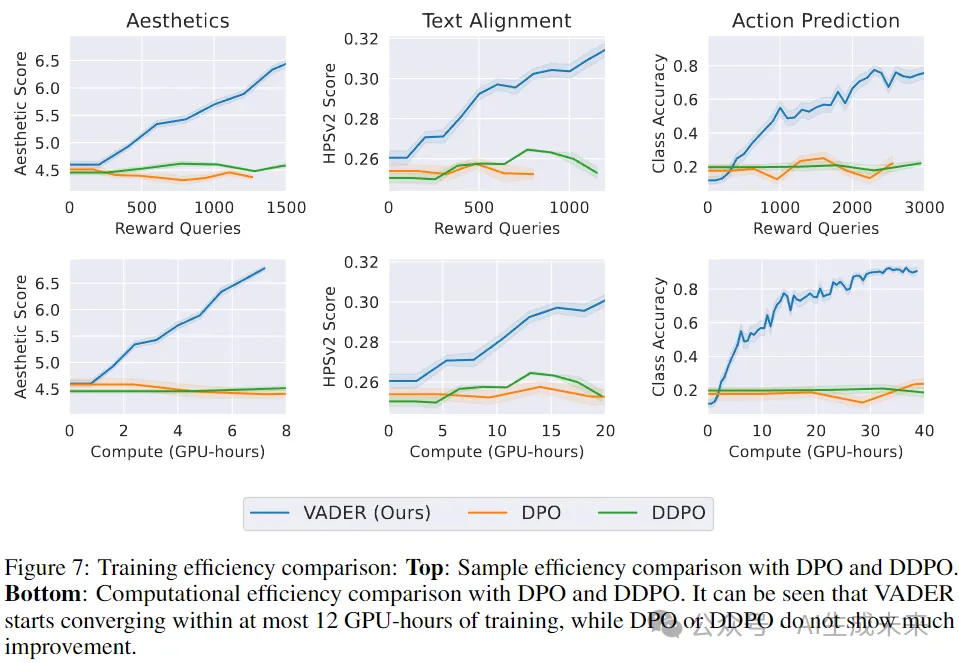

樣本和計算效率

大規模視頻擴散模型的訓練由少數擁有大量計算資源的實體完成;然而,這些模型的微調卻由許多擁有有限計算資源的實體完成。因此,擁有既能提升樣本效率又能提升計算效率的微調方法變得至關重要。

在本節中,將比較VADER在樣本和計算效率上與其他強化學習方法如DDPO和DPO的表現。在下圖7中,可視化了訓練過程中的獎勵曲線,圖中上半部分的x軸是獎勵查詢次數,下半部分的x軸是GPU小時數。從圖中可以看出,與DDPO或DPO相比,VADER在樣本和計算效率上顯著更高。這主要是因為將來自獎勵模型的密集梯度發送到擴散模型的權重中,而基線方法只是反向傳播標量反饋。

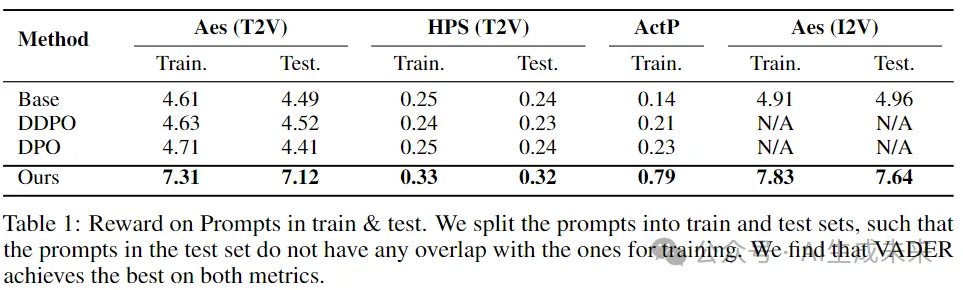

通用化能力

微調的一個期望屬性是泛化能力,即在有限提示集上微調的模型能夠泛化到未見過的提示上。在本節中,通過多個獎勵模型和基準模型廣泛評估這一屬性。在訓練文本到視頻(T2V)模型時,在訓練集中使用了HPSv2行動提示,而在測試集中使用了活動提示。對于訓練圖像到視頻(I2V)模型,在訓練集中使用了拉布拉多犬類別,而馬耳他犬類別則形成了本文的測試集。下表1展示了VADER的泛化能力。

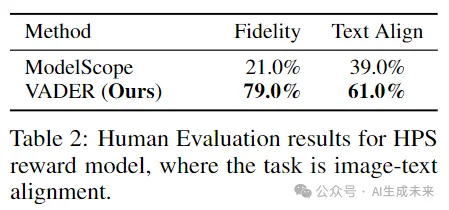

人類評估

研究者們進行了一項研究,通過Amazon Mechanical Turk評估人類偏好。測試包括VADER和ModelScope之間的并排比較。為了測試從這兩種模型生成的視頻如何與它們的文本提示對齊,向參與者展示了由VADER和基線方法生成的兩個視頻,并要求他們選擇哪個視頻更符合給定的文本。為了評估視頻質量,研究者們要求參與者比較以相同提示生成的兩個視頻,一個來自VADER,另一個來自基線方法,并決定哪個視頻的質量更高。每個比較收集了100個回復。下表2中的結果顯示,相比基線方法,人們更偏好VADER。

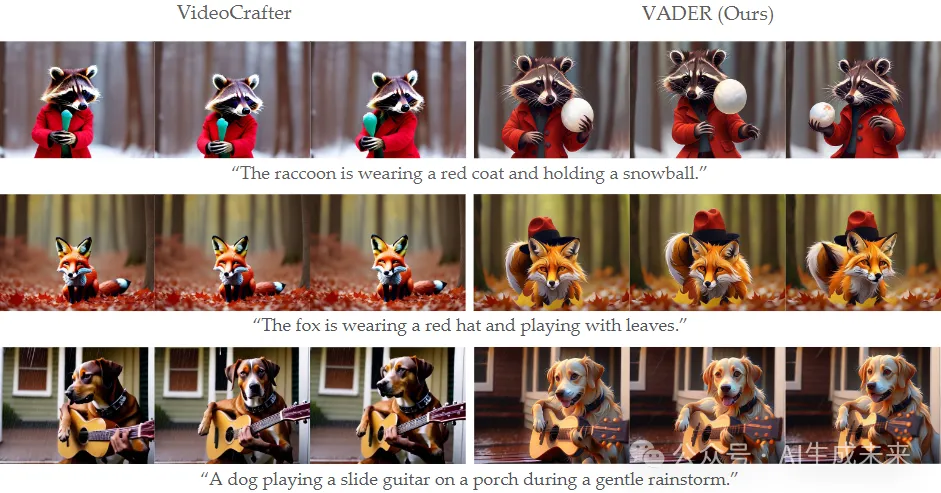

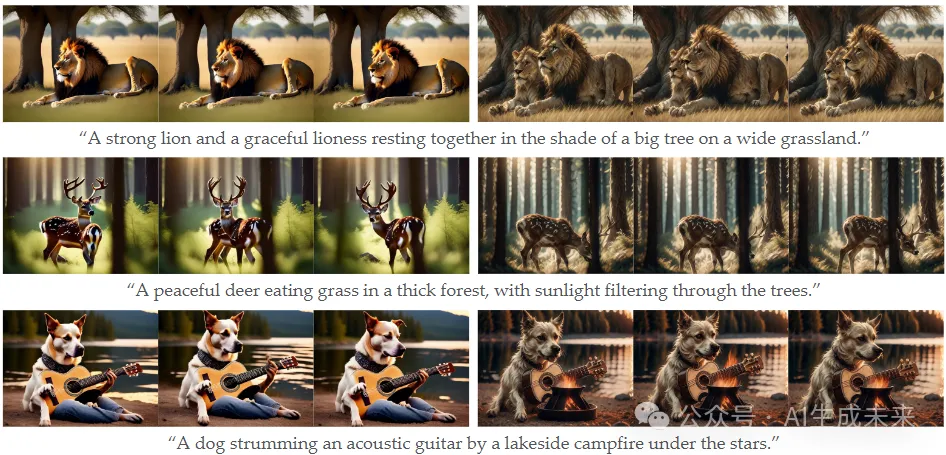

定性可視化

本節將展示VADER生成的視頻及其相應的基準模型。將在各種基礎模型上,通過所有考慮的獎勵函數進行廣泛的可視化展示。

HPS獎勵模型: 在下圖3中,可視化了使用HPSv2.1和美學獎勵函數對VideoCrafter進行微調前后的結果,前三行展示了這些結果。在微調前,浣熊沒有拿著雪球,狐貍也沒有戴帽子,這與文本描述不一致;然而,從VADER生成的視頻中不會出現這些不一致之處。此外,如圖3的第三行所示,VADER成功地泛化到未見過的提示,狗的爪子看起來不像左側視頻中的人類手那樣。類似的改進也可以在使用Open-Sora V1.2和ModelScope生成的視頻中觀察到,如下圖6的第二和第三行所示。

美學獎勵模型: 在上圖3中,前三行可視化了使用美學獎勵函數和HPSv2.1模型組合微調ModelScope前后的結果。此外,還通過美學獎勵函數微調了ModelScope,并在上圖6的最后一行展示了其生成的視頻。觀察到,美學微調使得生成的視頻更具藝術感。

PickScore模型: 在上圖3的最后三行,展示了通過PickScore微調的VideoCrafter生成的視頻。VADER顯示出比基準模型更好的文本到視頻對齊效果。在最后一行,測試了兩個模型對在訓練時未見過的提示的響應。此外,通過PickScore微調的Open-Sora生成的視頻顯示在上圖6的第一行。

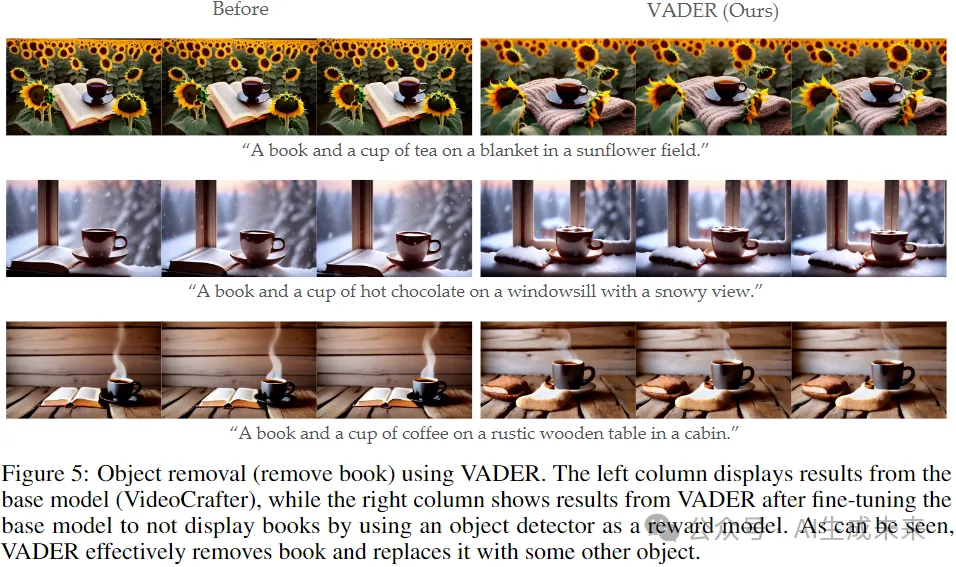

對象移除: 在下圖5中,顯示了經過使用基于YOLOS的對象移除獎勵函數微調后,由VideoCrafter生成的視頻。在這個例子中,書籍是要移除的目標對象。這些視頻展示了成功將書籍替換為其他物體,比如毯子或面包。

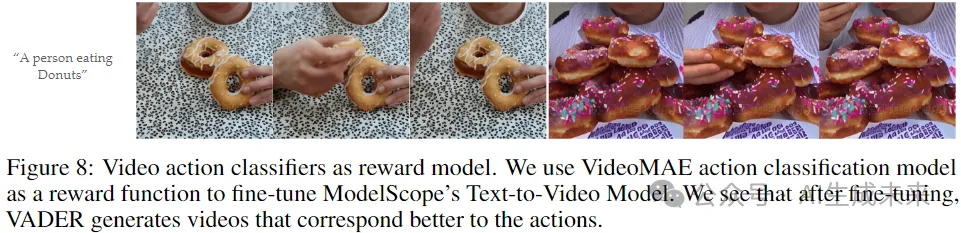

視頻動作分類: 在下圖8中,展示了ModelScope和VADER的視頻生成結果。在這種情況下,使用動作分類目標對VADER進行微調,以符合提示中指定的動作。對于提示中的“一個人在吃甜甜圈”,發現VADER使人臉更加明顯,并在甜甜圈上添加了彩色的糖珠。之前的生成通常被錯誤分類為烘烤餅干,這是Kinetics數據集中的另一個動作類別。向甜甜圈添加顏色和糖珠使其與餅干更易于區分,從而獲得更高的獎勵。

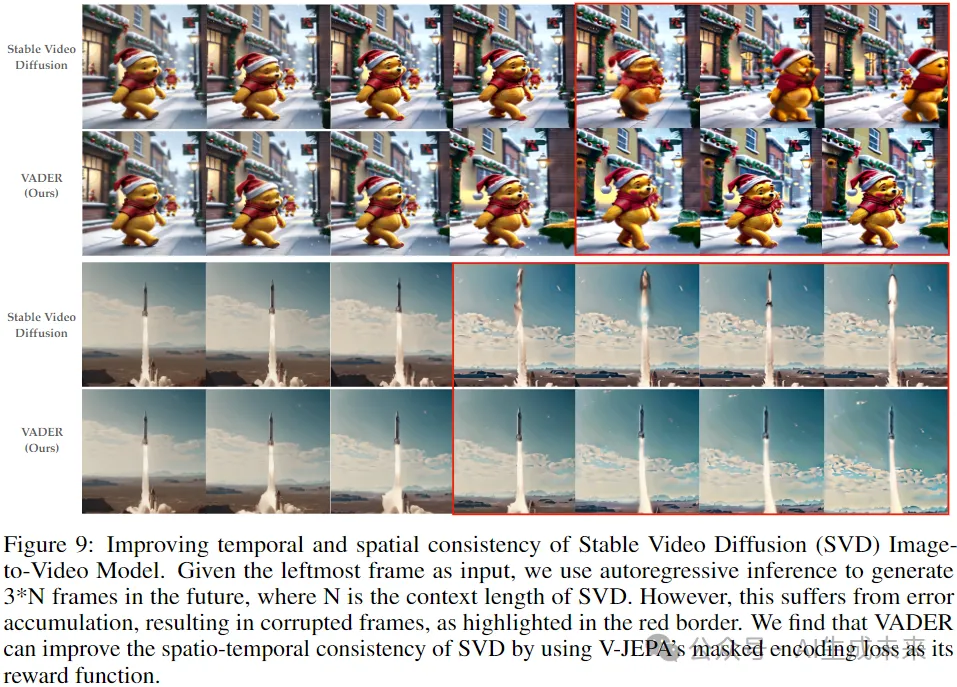

V-JEPA 獎勵模型: 在下圖9中,展示了通過Stable Video Diffusion(SVD)增加視頻長度的結果。為了在SVD上生成長距離視頻,使用自回歸推理,其中由SVD生成的最后一幀作為條件輸入,用于生成下一組圖像。進行了三步推理,因此將SVD的上下文長度擴展了三倍。然而,正如在紅色邊框中可以看到的那樣,在進行一步推理后,SVD開始在預測中累積錯誤。這導致了泰迪熊的變形,或者影響了運動中的火箭。VADER使用V-JEPA目標的掩碼編碼,以強制生成的視頻自一致性。如下圖9所示,這成功解決了生成中的時間和空間差異問題。

結論

本文介紹了VADER,這是一個通過獎勵梯度對預訓練視頻擴散模型進行微調的樣本和計算高效框架。本文利用在圖像或視頻上評估的各種獎勵函數來微調視頻擴散模型。此外,展示了本文的框架對條件無關,并且可以在文本到視頻和圖像到視頻擴散模型上都能工作。希望本文的工作能夠引起更多人對調整視頻擴散模型的興趣。

本文轉自 AI生成未來 ,作者:Zheyang Qin等