高保真+通用!視頻擴散模型加持,稀疏視圖重建任意場景!清華&港科大發布ReconX

文章鏈接:https://arxiv.org/pdf/2408.16767

git鏈接:https://liuff19.github.io/ReconX

亮點直擊

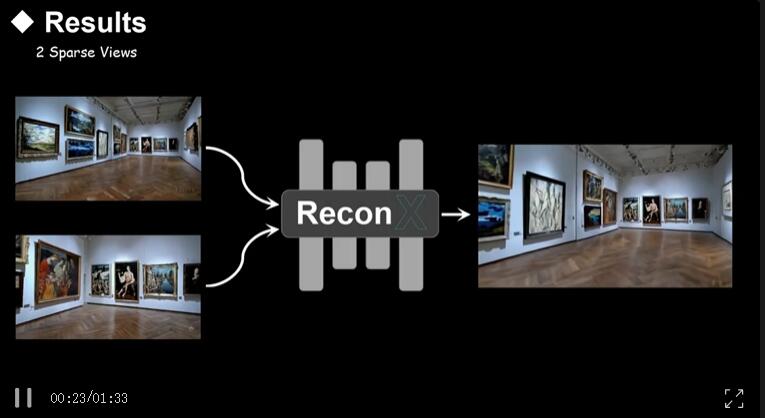

- ReconX,一種新穎的稀疏視角3D場景重建框架,該框架將模糊的重建挑戰重新定義為時間生成任務。

- 將3D結構指導融入視頻擴散模型的條件空間中,以生成3D一致的幀,并提出了一種基于置信度的3D優化方案(3DGS),以便在生成的視頻基礎上重建場景。

- 大量實驗表明,ReconX在各種真實世界數據集上在高保真度和通用性方面優于現有方法。

3D場景重建的進展使得我們能夠將來自現實世界的2D圖像轉換為3D模型,通過數百張輸入照片生成逼真的3D結果。盡管在密集視角重建場景中取得了巨大成功,但從不足的捕捉視角中渲染詳細場景仍然是一個難以解決的優化問題,常常導致未見區域出現偽影和失真。

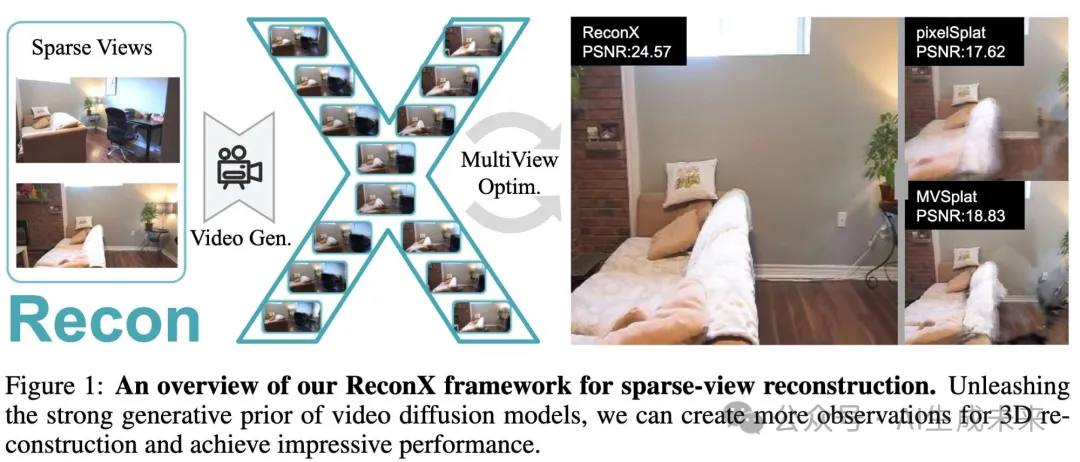

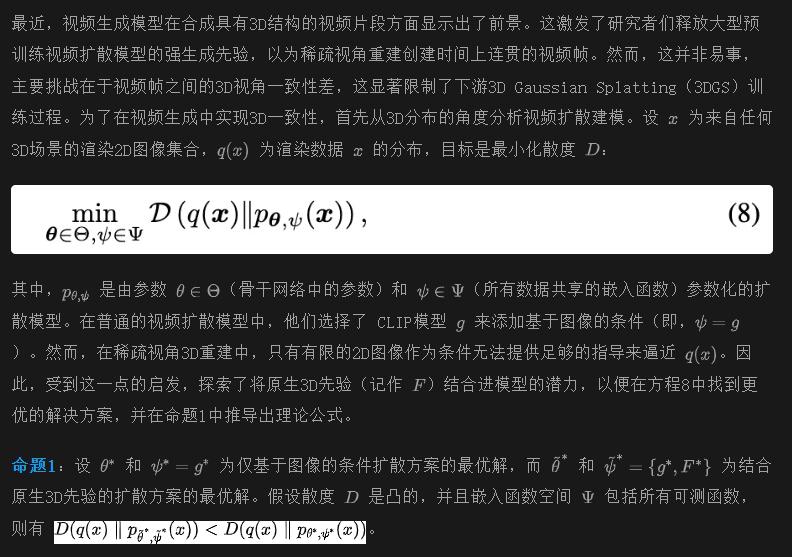

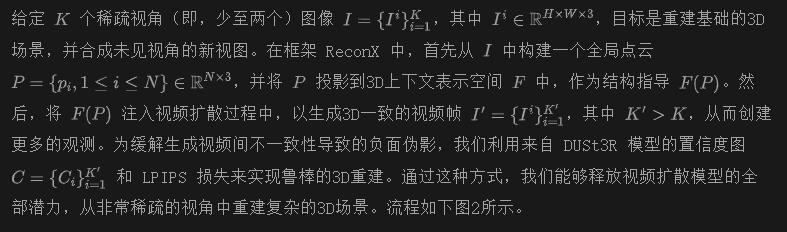

本文提出了ReconX,一種新穎的3D場景重建范式,該范式將模糊的重建挑戰重新定義為時間生成任務。關鍵的洞察在于釋放大型預訓練視頻擴散模型在稀疏視角重建中的強生成先驗。然而,直接從預訓練模型生成的視頻幀難以準確保持3D視角一致性。為了解決這個問題,ReconX首先根據有限的輸入視角構建全局點云,并將其編碼到上下文空間中作為3D結構條件。以此條件為指導,視頻擴散模型生成的幀不僅能保留細節,而且展示高程度的3D一致性,從而確保從不同視角觀看場景的一致性。最后,通過一種基于置信度的3D Gaussian Splatting優化方案從生成的視頻中恢復3D場景。在各種真實世界數據集上的大量實驗表明,ReconX在質量和通用性方面優于現有的最先進方法。

研究ReconX的動機

本文關注的是從非常稀疏的視角(例如,僅兩個視角)圖像中進行3D場景重建和新視角合成(NVS)的基本問題。大多數現有的研究(利用3D先驗和幾何約束(如深度、法線、代價體積)來填補稀疏視角3D重建中觀測到的區域與新區域之間的差距。盡管這些方法能夠從給定的視角生成高度逼真的圖像,但由于視角不足以及由此產生的重建過程不穩定性,它們往往難以在輸入視角不可見的區域生成高質量圖像。為了解決這個問題,一個自然的想法是增加更多觀測,從而將欠定的3D創建問題轉化為一個完全約束的3D重建問題。

為此,通過將3D原生結構指導融入擴散過程中,將固有模糊的重建問題重新定義為生成問題。

方法

ReconX 概述

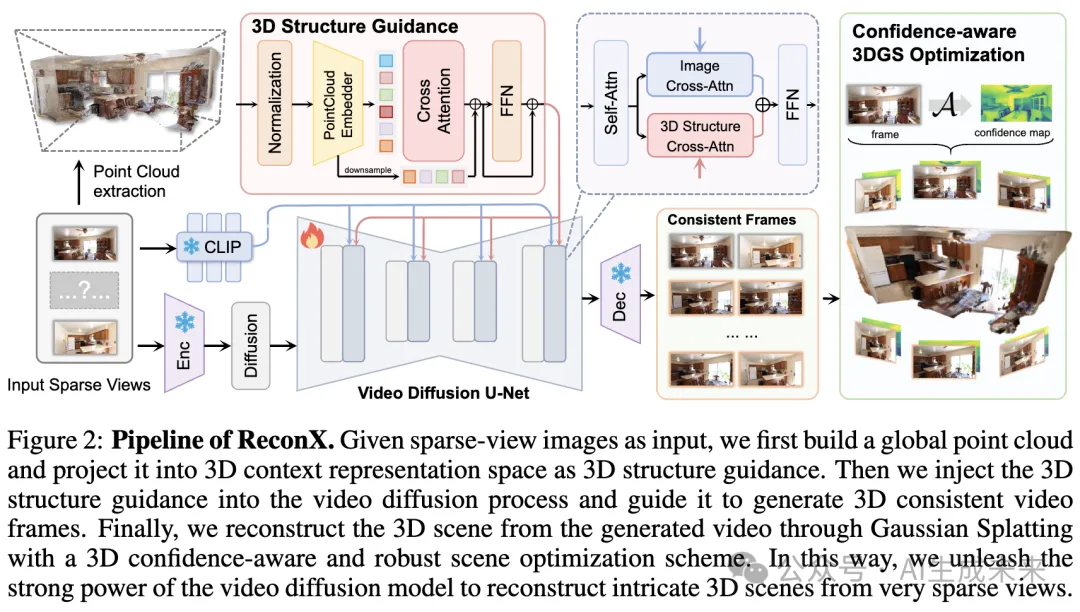

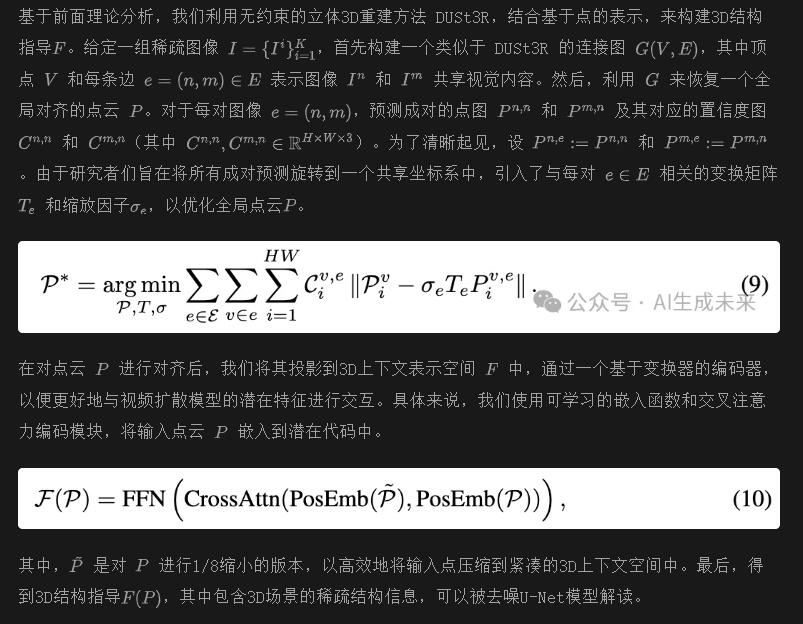

構建3D結構指導

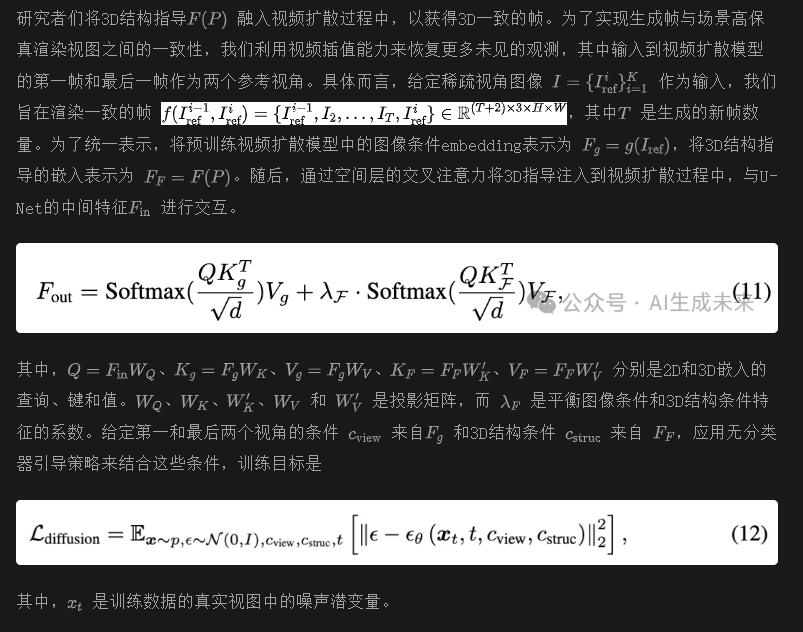

生成3D一致的視頻幀

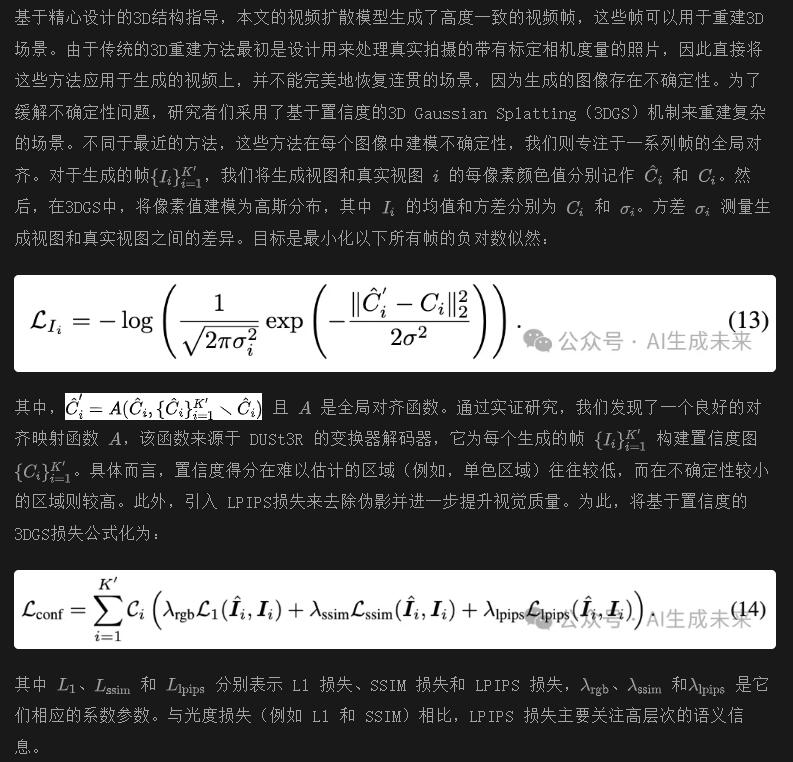

基于置信度的3D Gaussian Splatting優化

實驗

研究者們進行了廣泛的實驗來評估稀疏視角重建框架 ReconX。

實驗設置

數據集

ReconX 的視頻擴散模型在三個數據集上進行訓練:RealEstate-10K、ACID和 DL3DV-10K。RealEstate-10K 是一個從 YouTube 下載的數據集,分為 67,477 個訓練場景和 7,289 個測試場景。ACID 數據集包含自然風景場景,包含 11,075 個訓練場景和 1,972 個測試場景。DL3DV-10K 是一個大規模的戶外數據集,包含 10,510 個視頻,具有一致的拍攝標準。對于每個場景視頻,我們隨機抽取 32 幀連續的幀,并將第一幀和最后一幀作為我們視頻擴散模型的輸入。為了進一步驗證跨數據集的泛化能力,我們還直接在兩個流行的多視角數據集上評估我們的方法:DTU數據集和 NeRF-LLFF數據集,這兩個數據集在 NVS 任務中非常流行。

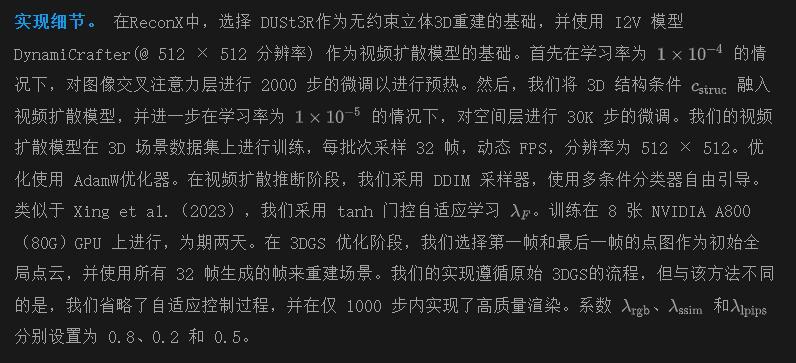

基準和指標

研究者們將 ReconX 與原始 3DGS以及幾種代表性的稀疏視角 3D 重建基準方法進行比較,包括:基于 NeRF 的 pixelNeRF和 MuRF;基于光場的 GPNR和 AttnRend;以及最近的最先進的 3DGS 基于 pixel-Splat和 MVSplat。對于定量結果,報告 NVS 中的標準指標,包括 PSNR、SSIM、LPIPS。為了公平比較,在 256 × 256 分辨率下進行實驗,以符合現有方法的標準。

與基準方法的比較

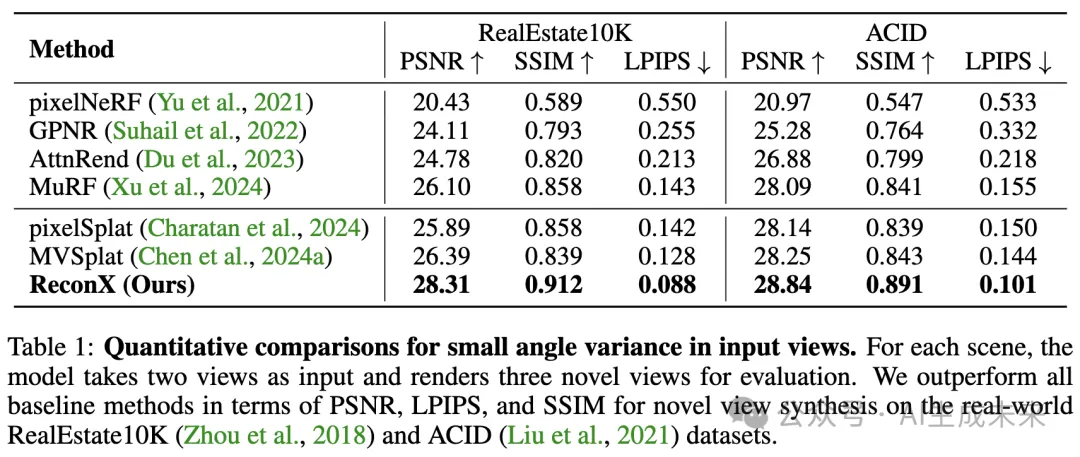

小角度變化下的比較。 為了公平地與基準方法如 MuNeRF、pixelSplat和 MVSplat進行比較,首先在小角度變化的稀疏視角下比較了 ReconX 與這些基準方法(見下表1和圖3)。我們觀察到,ReconX 在所有視覺質量和定性感知指標上超越了所有先前的最先進模型。

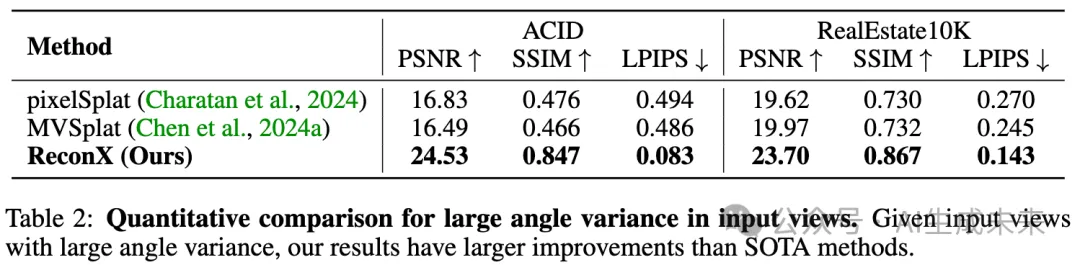

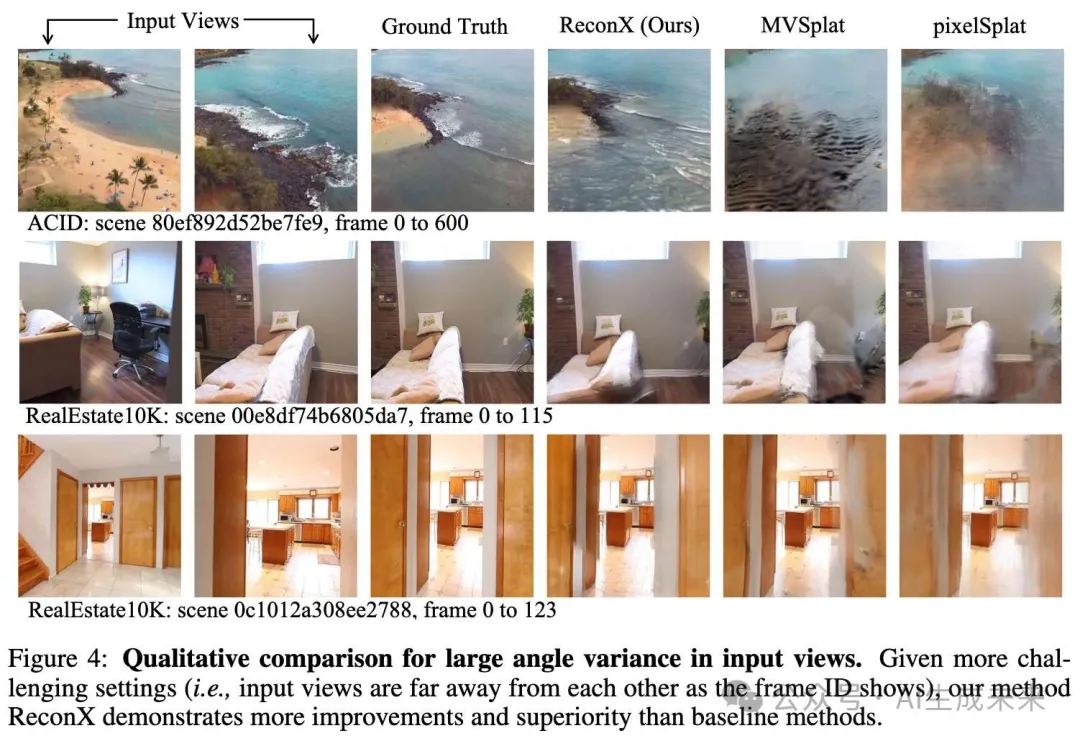

大角度變化下的比較。 由于 MVSplat 和 pixelSplat 相較于以前的基準方法有顯著提升,我們在更困難的設置下(即,給定具有大角度變化的稀疏視角)進行了深入比較。我們提出的 ReconX 在這些更具挑戰性的設置下表現出比基準方法更顯著的改進,特別是在未見過的和廣義視角下(見下表2和圖4)。這清楚地表明,ReconX 在利用視頻擴散生成更一致的觀察結果方面的有效性,從而緩解了固有的稀疏視角重建問題。

跨數據集泛化

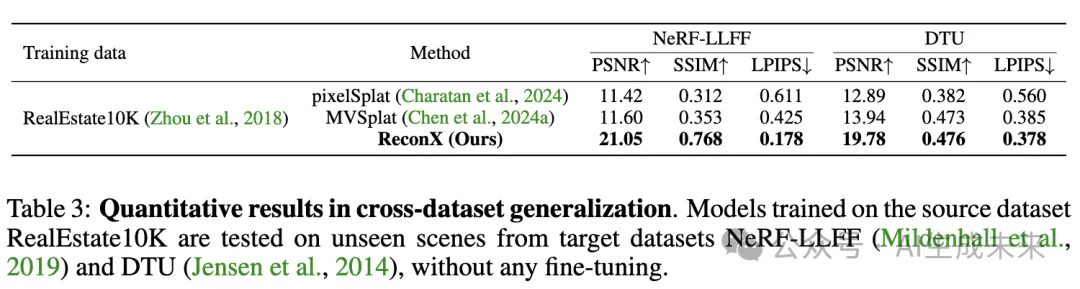

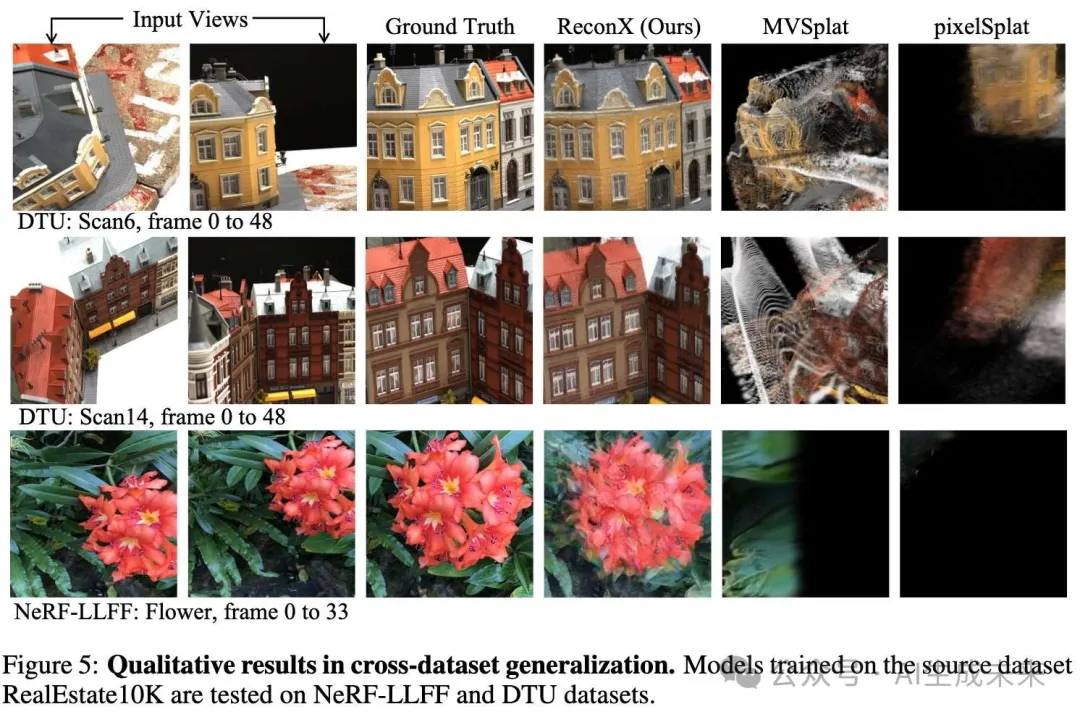

通過 3D 結構指導釋放視頻擴散模型的強大生成能力,我們的 ReconX 在泛化到分布外的新場景方面具有本質上的優勢。為了展示我們的強泛化能力,我們進行了兩項跨數據集評估。為公平比較,僅在 RealEstate-10K 上訓練模型,并直接在兩個流行的 NVS 數據集(即 NeRF-LLFF和 DTU)上進行測試。如下表 3 和圖 5 所示,競爭基準方法 MVSplat和 pixelSplat無法渲染這些包含不同相機分布和圖像外觀的 OOD 數據集,導致性能顯著下降。相比之下,我們的 ReconX 展現了令人印象深刻的泛化能力,當訓練數據和測試數據之間的領域差距增大時,性能提升更為顯著。

視圖數量評估

ReconX 對輸入視圖數量是無關的。具體來說,給定 N 個視圖作為輸入,我們采樣一個合理的相機軌跡來使用我們的 video diffusion 模型渲染圖像對,并最終從所有生成的幀中優化 3D 場景。為了公平比較,我們在 DTU 上使用三個上下文視圖進行測試,驗證這一點。ReconX的結果是:PSNR: 22.83,SSIM: 0.512,LPIPS: 0.317;MVSplat 的結果是:PSNR: 14.30,SSIM: 0.508,LPIPS: 0.371;pixelSplat 的結果是:PSNR: 12.52,SSIM: 0.367,LPIPS: 0.585。與雙視圖結果(上表 3)相比,當給定更多輸入視圖時,ReconX 和 MVSplat 均能取得更好的性能,但ReconX遠優于 MVSplat。然而,pixelSplat 在使用更多視圖時表現更差,這一點也在 Chen et al.(2024a)的研究中得到了體現。更多關于我們結果的可視化可以在我們的項目頁面找到。

消融研究與分析

在 RealEstate-10K 上進行了一系列消融研究,以分析 ReconX 框架的設計,如表 4 和圖 6 所示。將預訓練視頻擴散模型與 Gaussian Splatting 進行的簡單組合被視為“基線”。具體來說,在以下方面對ReconX進行了消融實驗:3D 結構指導、基于置信度的優化和 LPIPS 損失。結果表明,省略這些元素中的任何一個都會導致質量和一致性上的下降。特別是,原始視頻擴散模型與 3DGS 的基本組合導致場景顯著扭曲。缺乏 3D 結構指導會導致生成的幀在遠處輸入視圖中不一致,從而出現模糊和偽影問題。缺少基于置信度的優化會導致某些局部細節區域的結果不佳。將 LPIPS 損失加入到基于置信度的 3DGS 優化中,可以提供更清晰的渲染視圖。這說明了我們整體框架的有效性(見前面圖 2),它在僅給定稀疏視圖作為輸入的情況下,驅動了可泛化和高保真度的 3D 重建。

結論

本文介紹了 ReconX,一種新穎的稀疏視角三維重建框架,該框架將復雜且模糊的重建問題重新定義為生成任務。方法核心在于利用視頻擴散模型強大的生成能力,以生成更為可信的觀測幀,用于稀疏視角的三維重建。通過將三維結構指導融入視頻擴散過程中,提升了三維一致性視頻幀的生成質量。此外,提出的三維置信度感知方案有效地解決了生成幀的不確定性問題,從而改進了最終的三維場景重建。

廣泛實驗表明,ReconX 在高質量和泛化能力方面超越了現有的最先進方法,尤其是在未見數據上表現突出。

限制與未來工作

盡管 ReconX 在重建效果上表現出色,但仍存在一些限制。目前的重建質量在一定程度上受到所使用的擴散模型的限制,特別是基于 U-Net 的 DynamiCrafter。未來可以通過整合更大規模的開源視頻擴散模型(如基于 DiT 框架的模型)來提升性能。

此外,未來工作可以探討將三維結構指導優化直接集成到視頻生成模型中,從而實現更高效的端到端三維場景重建過程。另一個值得關注的方向是探索一致的四維場景重建,這將進一步推進三維場景建模的能力。

總體而言,ReconX 為從視頻擴散模型中創建復雜三維環境提供了一種有前景的方法,并有望激發該領域更多的研究。

本文轉自 AI生成未來 ,作者:Fangfu Liu等