AniPortrait開源上線!音頻驅動逼真人像動畫合成!人人都是歌手!

文章鏈接:https://arxiv.org/pdf/2403.17694

Github鏈接:??https://github.com/Zejun-Yang/AniPortrait??

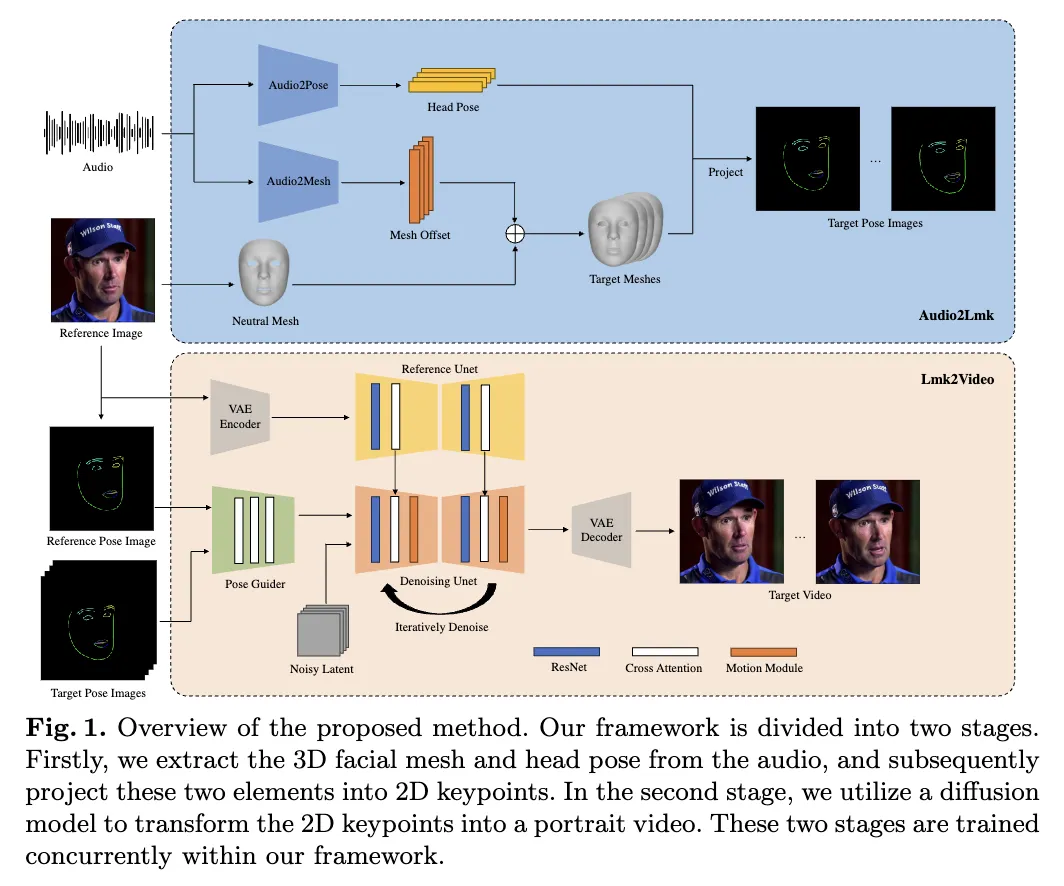

本文提出了AniPortrait,一個新穎的框架,用于生成由音頻和參考人像驅動的高質量動畫。方法分為兩個階段。首先,從音頻中提取3D中間表示,并將它們投影到一系列2D面部關鍵點上。隨后,采用了一個強大的擴散模型,結合一個運動模塊,將關鍵點序列轉換為逼真且時間上連貫的人像動畫。

實驗結果表明,在面部自然性、姿勢多樣性和視覺質量方面,AniPortrait具有優越性,從而提供了增強的感知體驗。此外,我們的方法在靈活性和可控性方面表現出了相當大的潛力,可以有效應用于面部運動編輯或面部再現等領域。

介紹

從音頻和靜態圖像中創建逼真而富有表現力的人像動畫具有各種應用,從虛擬現實和游戲到數字媒體都有涉及。然而,制作視覺上引人入勝且保持時間一致性的高質量動畫是一個重大挑戰。這種復雜性源于需要精細協調嘴唇運動、面部表情和頭部位置,以營造出視覺上引人入勝的效果。

現有方法通常未能克服這一挑戰,主要是因為它們依賴于用于視覺內容創建的容量有限的生成器,如GANs、NeRF或基于運動的解碼器。這些網絡展現出有限的泛化能力,并且在生成高質量內容方面經常缺乏穩定性。最近,擴散模型的出現促進了高質量圖像的生成。一些研究在此基礎上進行了進一步探索,通過引入時間模塊,使擴散模型在創建引人入勝的視頻方面表現出色。

在擴散模型的進展基礎上,介紹AniPortrait,這是一個新穎的框架,旨在生成由音頻和參考圖像驅動的高質量動畫人像。AniPortrait分為兩個明確的階段。

第一個階段,采用基于transformer的模型從音頻輸入中提取一系列3D面部網格和頭部姿勢,隨后將它們投影到一系列2D面部關鍵點上。這一階段能夠從音頻中捕捉微妙的表情和嘴唇運動,以及與音頻節奏同步的頭部運動。

第二個階段,利用了一個強大的擴散模型,結合了一個運動模塊,將面部關鍵點序列轉換為時間一致且逼真的動態人像。具體地,借鑒了AnimateAnyone的網絡架構,該架構利用了強大的擴散模型 Stable Diffusion 1.5,根據身體運動序列和參考圖像生成流暢而逼真的視頻。特別值得注意的是我們對該網絡內姿勢引導模塊的重新設計。這種修改不僅保持了輕量級設計,而且在生成嘴唇運動方面表現出了更高的精度。

實驗結果顯示了AniPortrait在創建具有出色面部自然性、多樣化姿勢和優秀視覺質量的動畫方面的優越性。通過使用3D面部表示作為中間特征,我們獲得了根據需要修改這些表示的靈活性。這種適應性極大地增強了本文的框架在面部運動編輯和面部再現等領域的適用性。

方法

所提出的框架包括兩個模塊,Audio2Lmk 和 Lmk2Video。前者旨在從音頻輸入中提取一系列能夠捕捉復雜面部表情和嘴唇運動的關鍵點序列。后者利用這些關鍵點序列生成具有時間穩定性的高質量人像視頻。下圖1中概述了該框架,并在下文提供了更多細節。

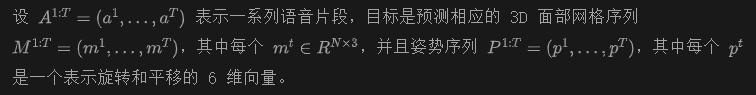

Audio2Lmk

采用預訓練的 wav2vec 來提取音頻特征。該模型具有很高的泛化能力,并且能夠準確識別音頻中的發音和語調,這在生成逼真的面部動畫中起著關鍵作用。通過利用獲得的穩健語音特征,可以有效地使用由兩個全連接層組成的簡單架構將這些特征轉換為 3D 面部網格。觀察到,這種簡單的設計不僅確保了準確性,還提高了推理過程的效率。

在將音頻轉換為姿勢的任務中,我用相同的 wav2vec 網絡作為骨干。然而,不與音頻到網格模塊共享權重。這是因為姿勢與音頻中存在的節奏和語調更為密切相關,這與音頻到網格任務有不同的重點。為了考慮前面狀態的影響,使用 transformer 解碼器來解碼姿勢序列。在此過程中,使用交叉注意力機制將音頻特征集成到解碼器中。對于上述兩個模塊,使用簡單的 L1 損失進行訓練。

在獲得網格和姿勢序列后,使用透視投影將它們轉換為一系列 2D 面部關鍵點。這些關鍵點隨后被用作下一階段的輸入信號。

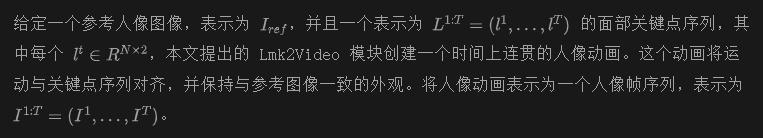

Lmk2Video

Lmk2Video 的網絡結構設計受到 AnimateAnyone 的啟發。本文利用 SD-1.5 作為骨干,集成了一個時間運動模塊,將多幀噪聲輸入有效地轉換為一系列視頻幀。同時,使用一個 ReferenceNet,鏡像了 SD-1.5 的結構,用于從參考圖像中提取外觀信息并將其整合到骨干中。這種戰略性的設計確保了輸出視頻中的人臉ID保持一致。與 AnimateAnyone 不同的是,我們增強了 PoseGuider 的設計復雜性。原始版本僅包括幾個卷積層,之后關鍵點特征與骨干輸入層的潛變量合并。這種基本設計無法捕捉到嘴唇的復雜運動。因此,本文采用了 ControlNet 的多尺度策略,將相應尺度的關鍵點特征合并到骨干的不同模塊中。盡管進行了這些增強,也成功地保持了參數數量相對較低。

本文還引入了一個額外的改進:將參考圖像的關鍵點作為額外輸入。PoseGuider 的交叉注意力模塊促進了參考關鍵點和每幀目標關鍵點之間的交互。這個過程為網絡提供了額外的線索,以理解面部關鍵點和外觀之間的相關性,從而有助于生成具有更精確運動的人像動畫。

實驗

實施細節

在 Audio2Lmk 階段,采用 wav2vec2.0 作為我們的骨干網絡。利用 MediaPipe 提取 3D 網格和 6D 姿勢進行標注。Audio2Mesh 的訓練數據來自內部數據集,該數據集包含來自單個發言者的近一小時高質量語音數據。為了確保 MediaPipe 提取的 3D 網格穩定,我們指示演員在整個錄制過程中保持穩定的頭部位置,面向攝像機。使用 HDTF 訓練 Audio2Pose。所有訓練操作都在一臺 A100 上執行,利用 Adam 優化器,學習率為 le-5。

在 Lmk2Video 過程中,實施了兩步訓練方法。在初始步驟中,專注于訓練骨干網絡、ReferenceNet 和 PoseGuider 的 2D 組件,略過運動模塊。在隨后的步驟中,凍結所有其他組件,并集中精力訓練運動模塊。利用兩個大規模、高質量的面部視頻數據集 VFHQ 和 CelebV-HQ 訓練模型。所有數據經過 MediaPipe 處理,以提取 2D 面部關鍵點。為了增強網絡對嘴唇運動的敏感性,在從 2D 關鍵點渲染姿勢圖像時使用不同的顏色區分上下嘴唇。所有圖像都被調整為 512x512 分辨率。利用 4 個 A100 GPU 進行模型訓練,每個步驟耗時兩天。采用 AdamW 優化器,保持學習率為le-5 。

結果

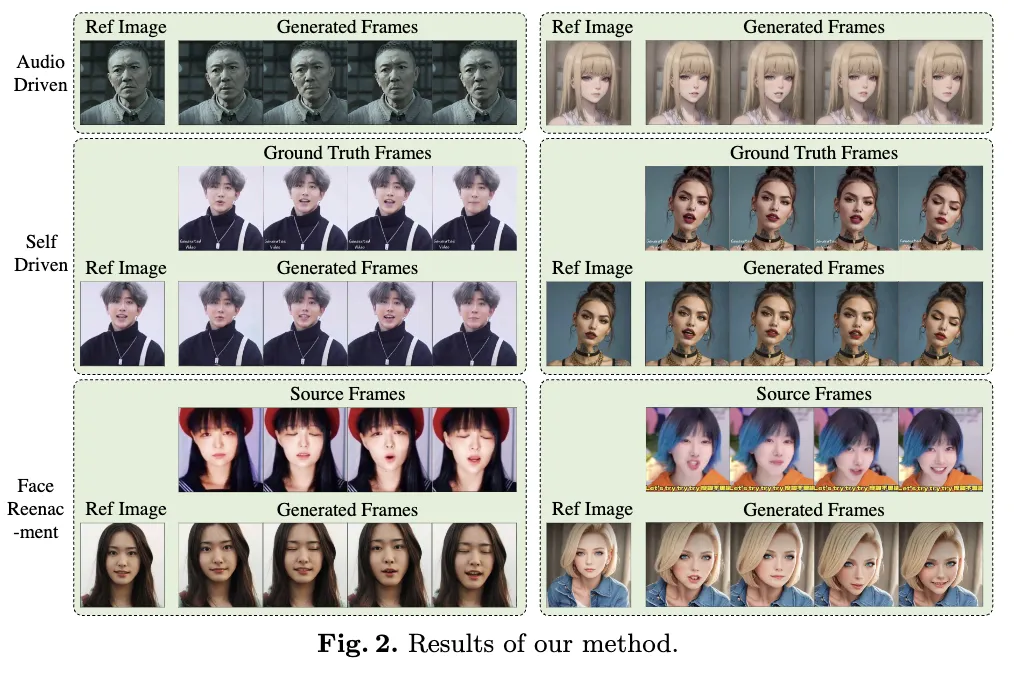

如下圖2所示,我們的方法生成了一系列在質量和真實感上引人注目的動畫。利用中間的3D表示,可以對其進行編輯以操控最終輸出。例如,可以從源中提取關鍵點并改變其ID,從而使我們能夠創建面部重現效果。

結論和未來工作

本研究提出了基于擴散模型的人像動畫框架。通過簡單地輸入音頻片段和參考圖像,該框架能夠生成具有流暢嘴唇運動和自然頭部運動的人像視頻。利用擴散模型強大的泛化能力,該框架創建的動畫展現出令人印象深刻的逼真圖像質量和令人信服的運動。然而,這種方法需要使用中間的3D表示,獲取大規模、高質量的3D數據的成本相當高。因此,生成的人像視頻中的面部表情和頭部姿勢無法擺脫“詭異谷”效應。在未來,我們計劃采用EMO的方法,直接從音頻預測人像視頻,以實現更令人驚嘆的生成結果。

本文轉自 Huawei Wei等 ,作者:AI生成未來