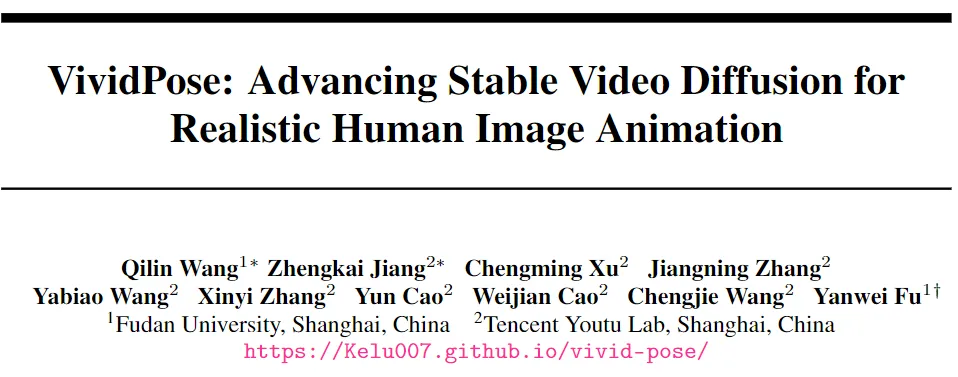

UBCFashion和TikTok新SOTA!復(fù)旦和騰訊優(yōu)圖發(fā)布端到端人像動(dòng)畫生成器VividPose!

文章鏈接:https://arxiv.org/pdf/2405.18156

項(xiàng)目鏈接:https://kelu007.github.io/vivid-pose/

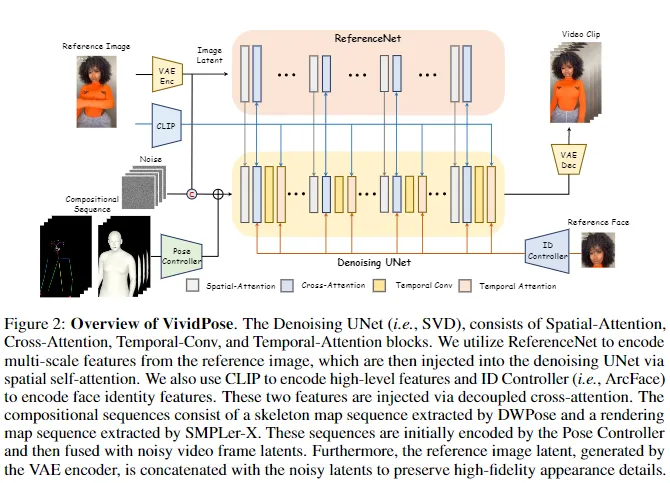

人像動(dòng)畫涉及通過遵循指定的姿勢(shì)序列從靜態(tài)圖像生成視頻。目前的方法通常采用多階段pipeline,分別學(xué)習(xí)外觀和動(dòng)作,這往往導(dǎo)致外觀退化和時(shí)間不一致。今天和大家分享一篇優(yōu)化這些問題的工作————VividPose,這是一種基于Stable Video Diffusion (SVD)的創(chuàng)新端到端pipeline,確保了優(yōu)越的時(shí)間穩(wěn)定性。為了增強(qiáng)人類身份的保留,提出了一種身份感知外觀控制器,該控制器集成了額外的面部信息,同時(shí)不影響服裝紋理和背景等其他外觀細(xì)節(jié)。這種方法確保生成的視頻在各種姿勢(shì)下保持對(duì)人類主體身份的高度保真度,保留關(guān)鍵面部特征。

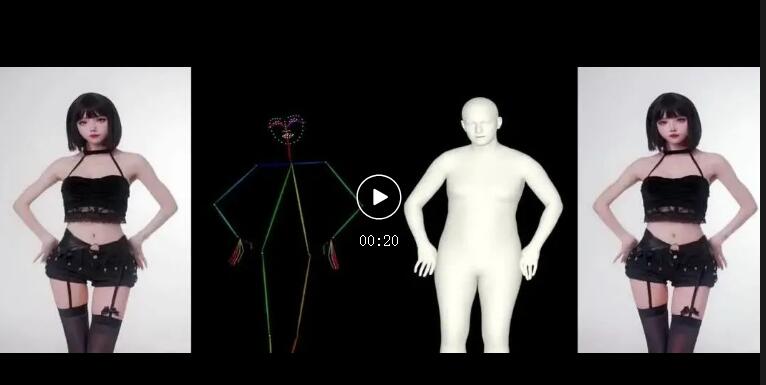

為了適應(yīng)多樣的人體姿勢(shì)和手部動(dòng)作,引入了一種幾何感知姿勢(shì)控制器,該控制器利用SMPL-X的密集渲染圖和稀疏骨架圖。這使得生成的視頻能夠準(zhǔn)確對(duì)齊姿勢(shì)和形狀,提供了一個(gè)能夠處理廣泛的體型和動(dòng)態(tài)手部動(dòng)作的強(qiáng)大框架。在UBCFashion和TikTok基準(zhǔn)上的大量定性和定量實(shí)驗(yàn)表明,本文的方法實(shí)現(xiàn)了最先進(jìn)的性能。此外,VividPose在提出的數(shù)據(jù)集上展示了出色的泛化能力。

本文的主要貢獻(xiàn):

- 提出了VividPose,這是一種利用Stable Video Diffusion的創(chuàng)新端到端pipeline,顯著增強(qiáng)了人像動(dòng)畫視頻的時(shí)間一致性和平滑度。

- 引入了一種身份感知外觀控制器,該控制器集成了額外的面部信息,同時(shí)保留了服裝紋理等其他外觀細(xì)節(jié)。該方法確保在不同姿勢(shì)下對(duì)人物身份的高度保真度。

- 提出了一種幾何感知姿勢(shì)控制器,該控制器利用密集渲染圖和稀疏骨架圖,確保了準(zhǔn)確的體型生成,并有效適應(yīng)各種體型和動(dòng)態(tài)手部動(dòng)作。

方法

概述

預(yù)備知識(shí):Stable Video Diffusion (SVD)SVD 是一種最前沿的視頻生成模型,它通過將潛在擴(kuò)散模型從2D圖像合成擴(kuò)展到高分辨率、時(shí)間一致的視頻創(chuàng)建,接收文本和圖像作為輸入。從技術(shù)上講,SVD 引入了3D卷積和時(shí)間注意力層。這些時(shí)間層也集成到VAE解碼器中。SVD的一個(gè)主要改進(jìn)是從DDPM 噪聲調(diào)度器轉(zhuǎn)換為EDM調(diào)度器,該調(diào)度器使用連續(xù)噪聲尺度σ進(jìn)行更靈活和有效的采樣,取代了離散時(shí)間步長(zhǎng)。這種端到端的訓(xùn)練模式和pipeline在視頻生成中保持了強(qiáng)大的時(shí)間一致性,使其特別適合于人像動(dòng)畫。

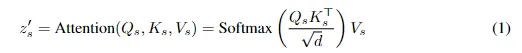

預(yù)備知識(shí):SMPL-X SMPL-X是一種先進(jìn)的3D參數(shù)化人體模型,通過結(jié)合詳細(xì)的面部、手部和身體特征增強(qiáng)了SMPL 模型的能力。它將人體表示為具有固定拓?fù)涞木W(wǎng)格,由形狀、姿勢(shì)和表情參數(shù)控制。形狀參數(shù)(β)捕捉身份特定的屬性,姿勢(shì)參數(shù)(θ)編碼關(guān)節(jié)旋轉(zhuǎn),表情參數(shù)(ψ)模擬面部表情。為了從SMPL-X模型生成2D渲染圖,采用了可微渲染過程。使用相機(jī)投影函數(shù)(Π),渲染過程公式化為:

SMPL-X基礎(chǔ)姿勢(shì)序列在工作中,上述過程準(zhǔn)確地將3D人體模型投影到2D圖像平面。對(duì)于人像動(dòng)畫,從參考圖像中獲取形狀和表情參數(shù)(β和ψ),而姿勢(shì)參數(shù)(θ)則從驅(qū)動(dòng)視頻中提取。生成的渲染圖作為姿勢(shì)條件,確保生成視頻的體型與參考圖像準(zhǔn)確對(duì)齊,同時(shí)跟隨驅(qū)動(dòng)視頻中的動(dòng)態(tài)姿勢(shì),從而生成逼真且連貫的動(dòng)畫。

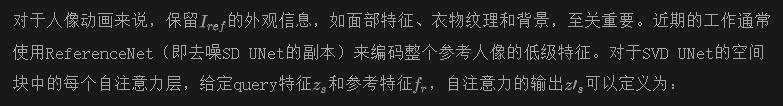

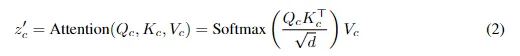

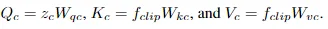

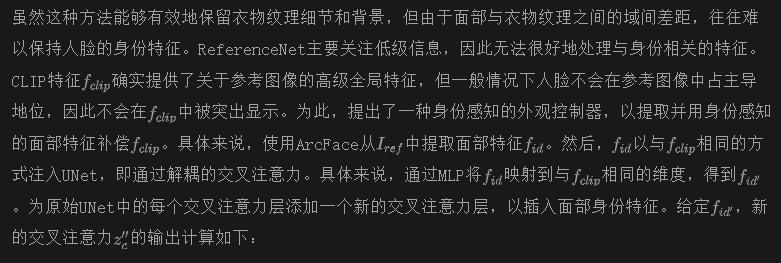

身份感知的外觀控制

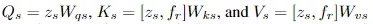

其中,

其中

其中,

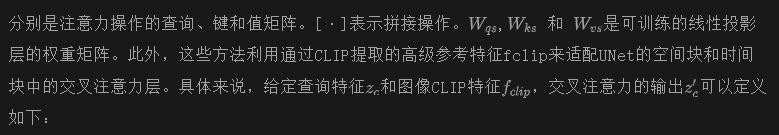

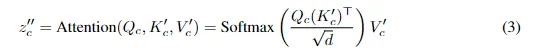

因此,解耦交叉注意力的最終公式定義如下:

額外的注意力,如方程式3所示,增強(qiáng)了面部身份,而不影響其他外觀信息,如服裝紋理和背景,從而確保將細(xì)粒度的面部特征有效地與UNet特征集成,而不干擾其他外觀特征。

幾何感知姿勢(shì)控制

人體圖像動(dòng)畫pipeline以參考圖像和從任何駕駛視頻中提取的姿勢(shì)序列作為輸入。現(xiàn)有方法通常使用骨架圖或密集圖(均來自2D姿勢(shì)估計(jì)器)作為姿勢(shì)驅(qū)動(dòng)信號(hào)。這經(jīng)常導(dǎo)致形狀不對(duì)齊問題。具體而言,骨架圖僅捕獲姿勢(shì)信息,忽略了身體形狀的細(xì)節(jié)。而密集圖包含姿勢(shì)和形狀信息,但身體形狀來自駕駛視頻,無法修改以與參考圖像的身體形狀對(duì)齊。因此,這導(dǎo)致姿勢(shì)驅(qū)動(dòng)信號(hào)的形狀與參考圖像中的形狀不對(duì)齊,從而在生成的視頻人體形狀中產(chǎn)生不準(zhǔn)確性。

為了解決這個(gè)問題,將3D參數(shù)化人體模型SMPL-X的渲染圖納入姿勢(shì)驅(qū)動(dòng)信號(hào)中。由于SMPL-X的參數(shù)化表示,可以建立重構(gòu)的SMPL-X與從駕駛視頻中提取的基于SMPL-X的姿勢(shì)序列之間的幾何對(duì)應(yīng)關(guān)系。這種對(duì)齊不僅確保了姿勢(shì)驅(qū)動(dòng)信號(hào)的形狀與參考圖像的形狀匹配,而且從3D信息中提供了額外的幾何關(guān)系(例如,手交叉和身體遮擋)。通過分別從參考圖像和駕駛視頻中提取形狀和姿勢(shì)參數(shù),可以創(chuàng)建渲染圖,確保生成的視頻人體形狀與參考圖像對(duì)齊,同時(shí)遵循駕駛視頻的姿勢(shì)。這種全面的表示對(duì)于實(shí)現(xiàn)逼真和連貫的動(dòng)畫至關(guān)重要,捕捉手部動(dòng)作中的微妙細(xì)微差別,并有效處理身體形狀的變化。

將添加到噪聲潛變量中,然后將其輸入到UNet中。

實(shí)驗(yàn)

設(shè)置

數(shù)據(jù)集。在兩個(gè)常用的學(xué)術(shù)基準(zhǔn)數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),即UBC-Fashion和 TikTok 數(shù)據(jù)集。還精心收集和處理了來自互聯(lián)網(wǎng)的 3000 個(gè)視頻,以進(jìn)一步驗(yàn)證本文的方法在實(shí)際場(chǎng)景中的適用性。具體而言,UBC-Fashion 包括 500 個(gè)訓(xùn)練視頻和 100 個(gè)測(cè)試視頻,每個(gè)視頻大約包含 350 幀。該數(shù)據(jù)集非常適用于與時(shí)尚相關(guān)的人體動(dòng)畫任務(wù)。TikTok 包含 340 個(gè)單人舞蹈視頻,每個(gè)視頻持續(xù) 10-15 秒。大多數(shù) TikTok 視頻側(cè)重于人物的上半身。遵循 DISCO 并使用相同的訓(xùn)練和測(cè)試劃分。精心篩選的數(shù)據(jù)集包括來自嗶哩嗶哩的 2224 個(gè)舞蹈視頻和來自抖音的 776 個(gè)視頻。這些視頻涵蓋了各種外觀和姿勢(shì)變化,如室內(nèi)外場(chǎng)景、不同的服裝紋理、不同年齡段和各種舞蹈風(fēng)格。所有這些數(shù)據(jù)集的幀都根據(jù)原始視頻的幀速率提取,并分別應(yīng)用于每幀的 DWPose和 SMPLer-X 來推斷骨架圖和渲染圖。

評(píng)估指標(biāo)。評(píng)估單幀圖像質(zhì)量和整體視頻保真度,以確保全面評(píng)估。對(duì)于單幀質(zhì)量,使用 L1 誤差、SSIM 、LPIPS 、PSNR 和 FID 。視頻保真度通過 FID-VID 和 FVD進(jìn)行評(píng)估。這些指標(biāo)能夠嚴(yán)格衡量單個(gè)幀的視覺質(zhì)量和生成視頻的時(shí)間連貫性,確保對(duì)方法的性能進(jìn)行徹底評(píng)估。

實(shí)現(xiàn)細(xì)節(jié)。在訓(xùn)練過程中,個(gè)別視頻幀被采樣、調(diào)整大小并居中裁剪到分辨率為 512×768。使用 SVD-img2vid 初始化去噪 UNet 來一次生成 14 幀,并使用 SD2.1 初始化 ReferenceNet。去噪 UNet、ReferenceNet、身份控制器和姿勢(shì)控制器都以端到端的方式進(jìn)行訓(xùn)練。所有實(shí)驗(yàn)都在 8 個(gè) NVIDIA 80GB H800 GPU 上進(jìn)行,batch大小為 32。

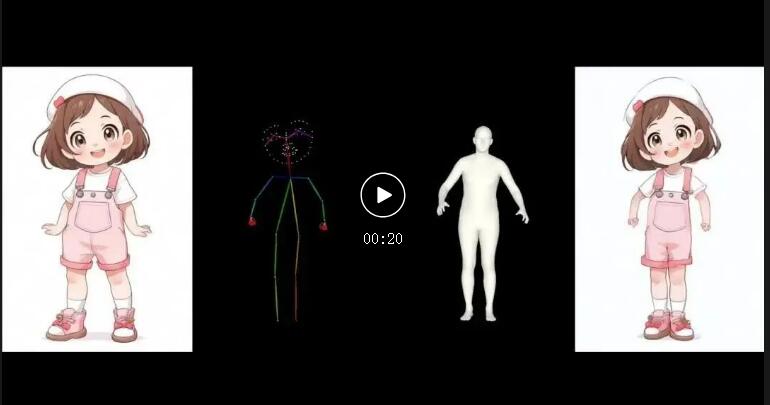

比較方法。評(píng)估包括與人體圖像動(dòng)畫領(lǐng)域一系列最先進(jìn)方法的全面比較:(1) MRAA 是一種基于 GAN 的方法,利用來自駕駛序列的光流估計(jì)來扭曲源圖像。最近的基于擴(kuò)散的方法,如 (2) MagicAnimate 和 (3) AnimateAnyone ,以其復(fù)雜的外觀和時(shí)序建模而聞名,表現(xiàn)出令人印象深刻的性能。為了進(jìn)行定量比較,還與 (4) DreamPose 進(jìn)行了比較,該方法設(shè)計(jì)了一個(gè)適配器,以整合人體圖像的特征。(5) DisCo也是一種先進(jìn)的基于擴(kuò)散的方法,它包含用于各種元素的不同條件模塊,例如姿勢(shì)、前景人物和背景。(6) BDMM 在時(shí)尚視頻生成方面表現(xiàn)良好。由于采用了相同的基準(zhǔn)和數(shù)據(jù)分割,定量比較是基于直接引用原始論文的統(tǒng)計(jì)數(shù)據(jù)進(jìn)行的。

比較

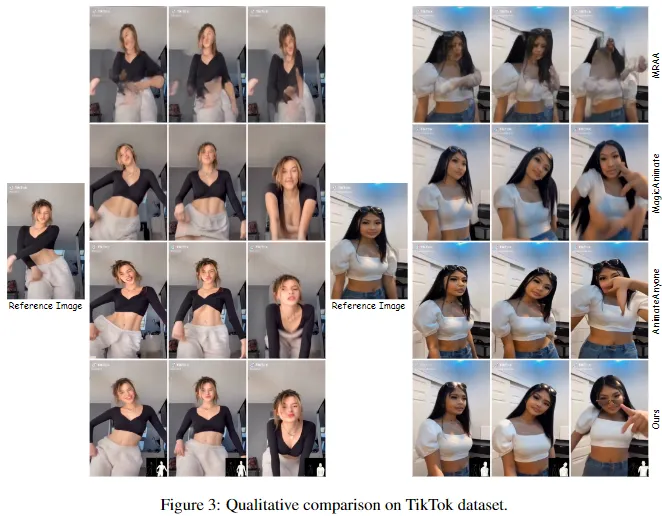

定性比較。從下圖3可以明顯看出,本文的方法在激烈運(yùn)動(dòng)過程中保持了更好的面部身份一致性,并成功實(shí)現(xiàn)了復(fù)雜的手勢(shì)。一個(gè)有趣的案例(第四行,最后一列)顯示,在劇烈運(yùn)動(dòng)后,本文的方法生成的角色佩戴的太陽鏡從頭上掉落,完美地落在了眼睛上。這表明本文的方法對(duì)物理世界有著更優(yōu)秀的理解,進(jìn)一步強(qiáng)調(diào)了它在創(chuàng)建逼真動(dòng)畫方面的優(yōu)勢(shì)。

總之,VividPose在幾個(gè)關(guān)鍵領(lǐng)域明顯優(yōu)于最先進(jìn)的方法。本文的方法在保留服裝紋理細(xì)節(jié)、保持高度的面部身份一致性以及準(zhǔn)確捕捉身體姿勢(shì)變化方面表現(xiàn)出色。此外,VividPose有效地處理了涉及手部交叉和動(dòng)態(tài)運(yùn)動(dòng)的復(fù)雜場(chǎng)景。這些優(yōu)勢(shì)突顯了本文方法的穩(wěn)健性和精確性,確保了超越現(xiàn)有技術(shù)性能的逼真連貫的人體圖像動(dòng)畫。

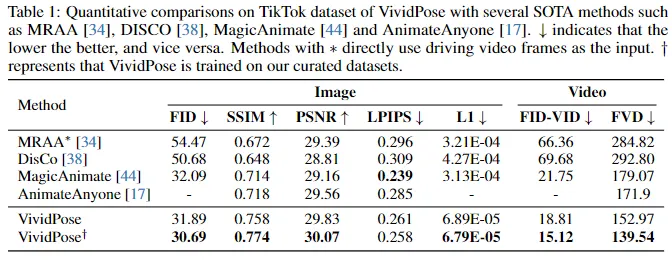

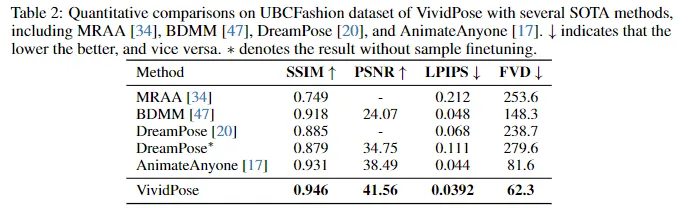

定量比較。對(duì)TikTok和UBCFashion數(shù)據(jù)集進(jìn)行了廣泛的定量比較,評(píng)估VividPose與幾種最先進(jìn)方法(包括BDMM、DisCo、MagicAnimate、AnimateAnyone和DreamPose)的性能。在TikTok數(shù)據(jù)集上的結(jié)果(下表1)顯示,VividPose在多個(gè)指標(biāo)上優(yōu)于其他方法,實(shí)現(xiàn)了最低的FID得分、最高的SSIM和PSNR,以及最低的LPIPS得分之一。這些結(jié)果表明了出色的視覺質(zhì)量、結(jié)構(gòu)相似性和感知相似性。

在視頻保真度方面,VividPose以最低的FID-VID和FVD表現(xiàn)出色,顯示出優(yōu)秀的時(shí)間一致性。當(dāng)VividPose在精心篩選的數(shù)據(jù)集上進(jìn)行訓(xùn)練時(shí),性能進(jìn)一步提高。在UBCFashion數(shù)據(jù)集上的結(jié)果(下表2)突顯了VividPose的優(yōu)勢(shì),在保持圖像質(zhì)量和感知相似性方面實(shí)現(xiàn)了最高的SSIM和PSNR,以及最低的LPIPS,表明了其在保留圖像質(zhì)量和感知相似性方面的優(yōu)越能力。此外,VividPose實(shí)現(xiàn)了最低的FVD,證實(shí)了其生成時(shí)間連貫視頻的能力。這些結(jié)果突顯了VividPose在保留細(xì)粒度外觀細(xì)節(jié)、保持面部身份和準(zhǔn)確捕捉復(fù)雜身體姿勢(shì)和動(dòng)作方面的優(yōu)勢(shì)。VividPose在圖像質(zhì)量和視頻保真度方面持續(xù)優(yōu)于現(xiàn)有方法,使其成為人體圖像動(dòng)畫的穩(wěn)健可靠解決方案。

消融研究

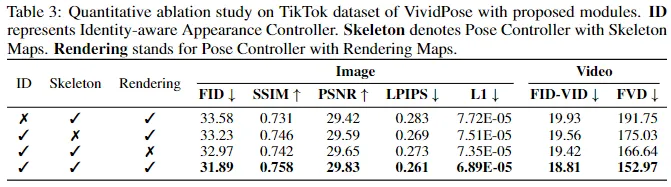

ID控制器的有效性。在TikTok數(shù)據(jù)集上的定量和定性割舍研究,如下表3和圖5所示,強(qiáng)調(diào)了ID控制器的有效性。定量上,包含ID控制器改善了圖像質(zhì)量指標(biāo):FID從33.58降至31.89,SSIM從0.731增至0.758,LPIPS從0.283降至0.261。定性上,ID控制器確保了更好的面部身份一致性,在不同的姿勢(shì)中保留了關(guān)鍵的面部特征。這對(duì)于保持被拍攝對(duì)象的識(shí)別度至關(guān)重要,特別是在動(dòng)態(tài)場(chǎng)景中。ID控制器通過有效地編碼和保留特定于身份的特征,確保生成的視頻既視覺上吸引人,又在時(shí)間上連貫。

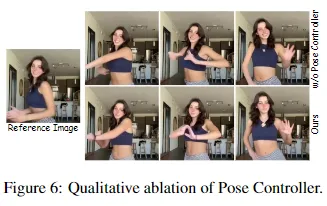

姿勢(shì)控制器的有效性。姿勢(shì)控制器利用骨架圖和渲染圖,對(duì)于保持運(yùn)動(dòng)連續(xù)性和處理復(fù)雜手勢(shì)至關(guān)重要。如表3和下圖6所示,啟用這兩個(gè)組件會(huì)導(dǎo)致更好的視頻質(zhì)量指標(biāo)。骨架圖為整體身體結(jié)構(gòu)和運(yùn)動(dòng)提供了稀疏的框架,而渲染圖則補(bǔ)充了關(guān)于身體形狀和表面變形的詳細(xì)信息。這種雙重方法允許對(duì)動(dòng)態(tài)姿勢(shì)和復(fù)雜手勢(shì)進(jìn)行精確建模,這些通常很難復(fù)制。這些改進(jìn)突顯了姿勢(shì)控制器在確保平滑連貫運(yùn)動(dòng)方面的有效性,特別是在涉及復(fù)雜手勢(shì)和動(dòng)態(tài)姿勢(shì)的場(chǎng)景中。

結(jié)論

本文介紹了VividPose,一種基于Stable Video Diffusion(SVD)的人體圖像動(dòng)畫的新型端到端pipeline。VividPose包括兩個(gè)主要模塊:(1)身份感知外觀控制器通過合并面部信息增強(qiáng)了人體身份的保留,而不影響其他外觀細(xì)節(jié)。

(2)幾何感知姿勢(shì)控制器使用來自SMPL-X的密集渲染圖和稀疏骨架圖,以適應(yīng)多樣化的身體形狀和手勢(shì)效果。在UBCFashion和TikTok基準(zhǔn)上的大量實(shí)驗(yàn)表明,VividPose在時(shí)間一致性、視覺保真度和泛化能力方面取得了最先進(jìn)的結(jié)果。它在數(shù)據(jù)集上也表現(xiàn)出色,展示了在實(shí)際場(chǎng)景中的穩(wěn)健性。

本文轉(zhuǎn)自 AI生成未來,作者:Qilin Wang等