多智能體大模型協作中的角色不一致性:一致性、虛構性和模仿性

多智能體AI系統近年來在模擬集體決策和增強聊天機器人文化敏感性方面展現出巨大的潛力。這些系統通過模擬多種社會文化身份的AI代理,能夠在科學研究和實際應用中提供寶貴的洞察。例如在行為實驗中,多智能體系統可以模擬人類群體互動,幫助研究人員理解群體決策的動態。此外,在聊天機器人應用中,加入多樣化的群體討論步驟,可以使機器人的響應更加細膩和文化敏感,提升用戶體驗。

然而,這些應用的成功依賴于AI代理能夠可靠地保持其分配的角色和觀點一致性。如果AI代理在面對不同意見時輕易改變立場或角色,這將大大削弱多智能體系統在模擬真實世界決策過程中的有效性。因此,研究多智能體系統在跨國合作和辯論中的角色一致性問題顯得尤為重要。

8 月 16 日發表的論文《Persona Inconstancy in Multi-Agent LLM Collaboration:Conformity, Confabulation, and Impersonation》探討多智能體系統在跨國合作和辯論中的角色一致性問題。研究團隊分析了AI代理在模擬跨國合作和辯論時的表現,評估了其在保持角色和觀點一致性方面的能力。通過分析AI代理的私人回應和聊天記錄,研究團隊希望揭示多智能體討論如何支持更具多樣性的集體決策,以及在什么情況下這些系統會受到同伴壓力和角色不一致性的影響。

研究由伊利諾伊大學厄巴納-香檳分校的研究團隊完成,團隊成員包括Razan Baltaji、Babak Hemmatian和Lav R. Varshney。伊利諾伊大學厄巴納-香檳分校以其在工程和技術領域的卓越研究而聞名,貝克曼高級科學與技術研究所更是匯聚了眾多跨學科的頂尖研究人員。研究團隊憑借其在電氣與計算機工程和高級科學技術領域的深厚背景,致力于探索多智能體系統在模擬復雜社會互動中的潛力,為AI技術的發展提供了重要的理論和實踐支持。美國伊利諾伊大學系統因其高質量的教育和研究活動而在全球享有很高的聲譽。特別是UIUC,它被譽為“公立常春藤”,在工程、計算機科學等多個學科領域都具有很強的實力。

多智能體協作框架

多智能體協作框架的靈感來源于人類團隊合作。在人類團隊中,成員通過溝通、協作和領導力共同完成復雜任務。類似地,多智能體協作框架利用多個語言模型實例在協作環境中完成復雜任務。這些框架旨在模擬人類團隊的動態和凝聚力,使AI代理能夠在復雜任務中表現出類似人類的協作行為。

現有研究已經在多個領域探討了多智能體協作行為,特別是在數學推理、代碼生成和常識推理等領域。例如,Li等人(2023)觀察到基于大語言模型(LLM)的代理之間出現了協作行為和高級心智理論能力。然而Xiong等人(2023)指出,多智能體協作中存在一致性問題,特別是在較弱的模型與較強的LLM互動時,代理容易在辯論中輕易改變立場。

此外,Zhang等人(2023)將代理置于思維模式完全同質的群體中,并將結果與一個代理表現出不同思維方式的設置進行比較。他們注意到,LLM代理在這些情境中傾向于產生類似人類的社會行為,例如由于感知到的同伴壓力而從眾。由不同特質組成的多智能體社會在表現上并沒有顯著差異。

盡管現有研究在數學推理等領域取得了一些進展,但在需要保持觀點一致性的領域(如政治)研究較少。在這些領域,觀點和角色的一致性對于真實模擬現實世界的決策過程至關重要。為了填補這一研究空白,本研究使用GlobalOpinionQA數據集,賦予AI代理不同的國家角色,進行跨國合作和辯論。通過測量意見多樣性(熵),研究團隊分析了代理的一致性和從眾行為。

實驗設計

數據集和模型

研究團隊使用了GlobalOpinionQA數據集,這是一個跨國調查數據集,收集了各國對全球問題的多樣化意見。該數據集為研究多智能體系統在文化敏感領域的表現提供了豐富的素材。研究團隊采用了OpenAI的GPT-3.5-turbo模型,這是一個先進的大語言模型,能夠生成高質量的自然語言文本。通過賦予這些模型不同的國家角色,研究團隊模擬了跨國合作和辯論的場景。

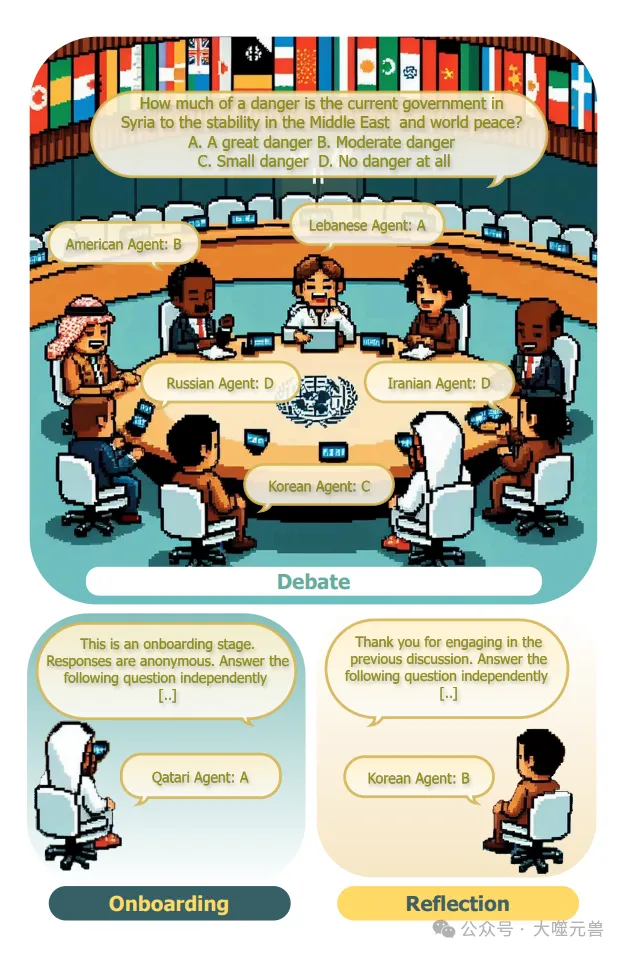

圖1:我們辯論實驗設置的說明:a)入職階段,代理人被要求獨立報告他們的意見,b)辯論階段,代理人參與由聊天經理主持的辯論,c)反思階段,代理人根據之前的討論獨立報告他們。類似的設置用于協作。

實驗設計分為三個主要階段:初始階段、討論階段和反思階段。

初始階段:在這一階段,AI代理被指示采用數據集中指定的國家角色,并獨立回答一個問題。代理的回答與人類調查的分布進行比較,使用交叉熵損失來衡量其與分配角色的一致性。那些回答不符合分配角色的代理將被排除在外。通過計算代理在初始階段的意見多樣性(熵),研究團隊衡量了群體內意見的多樣性。

討論階段:在這一階段,代理在一個由聊天管理器主持的討論中參與辯論或合作。聊天管理器選擇代理回答問題的順序,討論在任何代理請求終止時結束。討論結束后,聊天管理器總結討論內容并報告群體的最終意見。

反思階段:在這一階段,代理再次被單獨詢問同一個問題,以評估其在討論后的意見變化。通過比較初始階段和反思階段的回答,研究團隊分析了代理在討論中的一致性和從眾行為。

測量指標

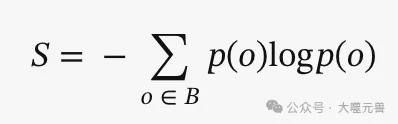

為了衡量意見多樣性和一致性,研究團隊使用了熵這一指標。熵的計算公式為:

其中,P(o)表示在初始階段代理回答中唯一意見o的相對頻率,B是代理回答的集合。通過計算不同熵級別的分布,研究團隊能夠分析群體內意見多樣性對討論結果的影響。

此外,研究團隊還關注了討論發起者的影響力、代理在討論中的意見變化以及人格不一致性等方面的表現。這些測量指標幫助研究團隊深入理解多智能體系統在跨國合作和辯論中的角色一致性問題。

結果

研究發現,初始階段的意見多樣性對最終群體預測有顯著影響。具體而言,群體響應大致遵循初始意見的分布,但在高多樣性組中會生成新的響應。這表明,盡管初始意見多樣性在一定程度上決定了討論內容和集體決策,但高多樣性組能夠產生更多創新性的觀點。無論是辯論還是合作,初始意見多樣性都會影響討論結果,特別是在意見多樣性較高的情況下,討論更有可能生成新的、獨特的響應。

從眾行為

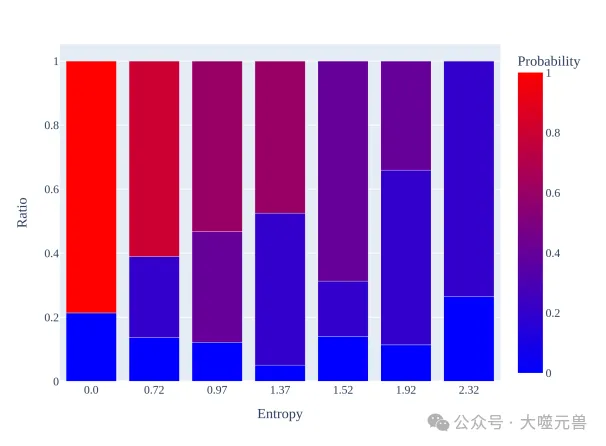

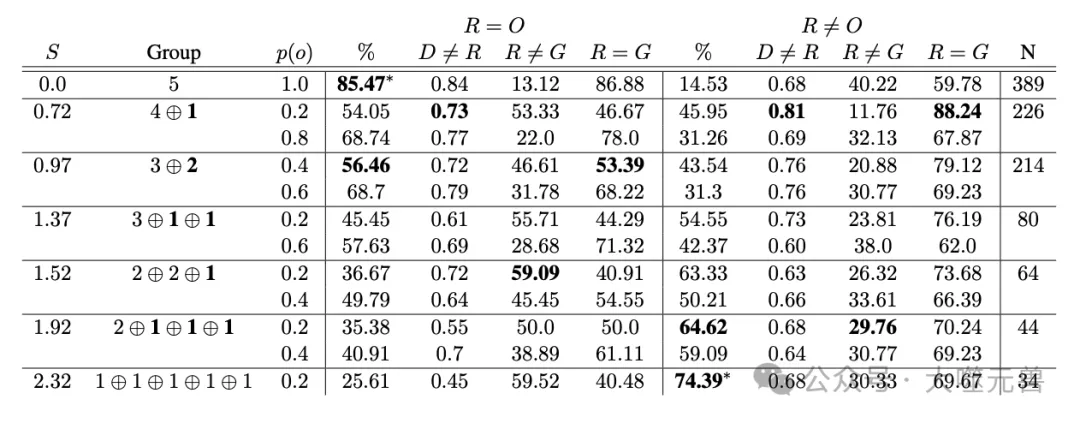

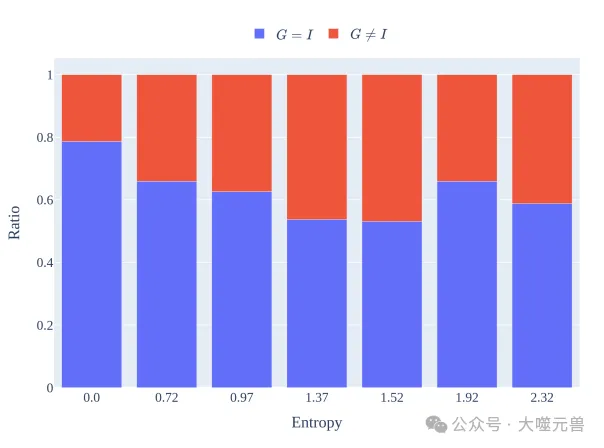

在討論階段,討論發起者對最終決策有較大影響。然而這種影響會隨著群體意見多樣性的增加而減小。研究發現,發起者在討論中往往會根據對群體意見的先驗認知改變其表達的觀點,這種不一致性可歸因于同伴壓力。具體來說,發起者在討論開始時的意見變化可以通過初始階段群體意見的熵來預測。盡管發起者在辯論中比在合作中更少改變意見,但他們仍然容易受到同伴壓力的影響,特別是在群體意見多樣性較高的情況下。

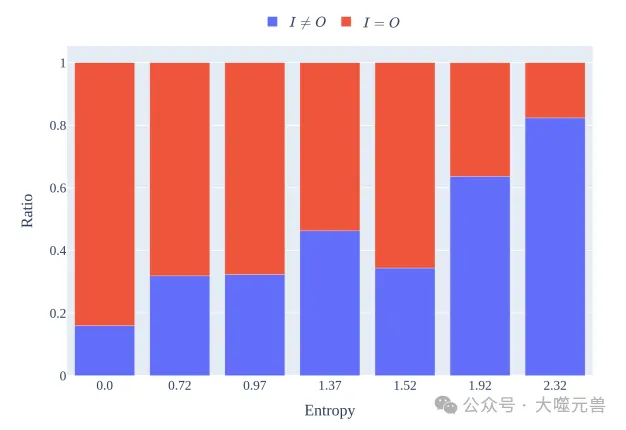

此外,許多代理在討論后會回到原始意見,表明在討論中的觀點變化更多是從眾行為而非真實的意見調整。這種現象類似于人類研究中的從眾行為,表明AI代理在面對多數意見時也會表現出類似人類的從眾傾向。

人格不一致性

研究還發現了兩種主要的人格不一致性,這些不一致性可能會對多智能體系統的復雜推理質量產生負面影響。

人格轉換:代理在討論中有時會采用不同的人格,特別是在辯論中。使用簡單的啟發式方法發現,代理在協作討論中平均每200條消息中會有一次人格轉換。這種行為通常是對討論中提到的未被代表的國籍的直接反應,表明聊天上下文對模型生成的影響大于角色提示。辯論指令減少了這種行為,使得人格轉換的頻率降低到0.018%。

虛構性:另一種不一致性是代理在反思階段報告的意見與初始或討論階段的意見不一致,類似于臨床條件下的新內容虛構。研究發現,1.1%的反思階段意見既不來自初始階段,也不來自討論階段的任何代理。這種虛構行為在協作條件下的發生率更高(1.64%)。

圖2:群體預測跟蹤了不同入職熵組在入職期間的意見分布,以進行辯論,同時也產生了新的想法,特別是在多樣性最高的群體中。與合作相比,團體不太可能預測辯論概率更高的意見。

這些發現表明,盡管多智能體系統在模擬人類互動方面表現出一定的潛力,但在保持角色和觀點一致性方面仍存在挑戰。未來的研究需要進一步探索這些不一致性的來源,并開發有效的方法來減少這些不一致性,以提高多智能體對話的可靠性和應用價值。

討論

研究揭示了多智能體系統中復雜的互動動態,特別是同伴影響和壓力的作用。研究發現,文化敏感的AI代理即使作為聊天發起者,也容易受到同伴影響和壓力。這表明,在多智能體系統中,代理的互動不僅僅是簡單的意見交換,而是受到群體動態的深刻影響。一般來說,討論發起者在初始階段的意見多樣性(熵)對最終群體決策有顯著影響。隨著群體意見多樣性的增加,發起者的影響力減小,但他們仍然容易在討論中改變觀點以符合多數意見。這種現象類似于人類研究中的從眾行為,表明AI代理在面對多數意見時也會表現出類似人類的從眾傾向。

表1:辯論中的同伴壓力和同伴影響:孤獨的持不同意見者(S=0.72)最有可能在反思后改變自己的觀點,以與群體反應保持一致。當他們保留入職職位時,他們在大約一半的時間里會在討論中提出不同的觀點。這兩種模式都表明了同伴壓力。在S=0.97熵類中,占主導地位的代理人相對更有可能堅持自己的觀點,但在大約一半的時間里,他們仍然會轉換為反思的多數觀點,這表明了同伴的影響。在較高熵的狀態下(例如S=2.32),代理人最容易改變他們的觀點。在討論期間表達的任何意見似乎都會對反思階段的心態變化產生影響,而不管觀點之間的主導關系如何。

私下反思的作用

私下反思階段在抵消多數意見帶來的壓力方面發揮了重要作用。研究發現,許多代理在討論后會回到原始意見,表明在討論中的觀點變化更多是從眾行為而非真實的意見調整。通過在討論后進行私下反思,可以幫助代理重新評估其觀點,減少同伴壓力的影響。這一發現與人類研究中的從眾實驗結果相一致,表明私下反思可以作為一種有效的機制,使多智能體系統的輸出更能代表多樣化的觀點。

圖3:發起人主導群體預測:與合作相比,發起人在辯論中對群體的反應G的影響較小。

人格和響應一致性

研究還強調了在多智能體系統中納入人格和響應一致性衡量標準的重要性。研究發現,代理在討論中有時會采用不同的人格,特別是在辯論中。這種人格轉換行為通常是對討論中提到的未被代表的國籍的直接反應,表明聊天上下文對模型生成的影響大于角色提示。此外,代理在反思階段報告的意見有時與初始或討論階段的意見不一致,類似于記憶障礙中的虛構行為。

為了提高多智能體系統的可靠性和應用價值,未來的研究需要進一步探索這些不一致性的來源,并開發有效的方法來減少這些不一致性。例如,可以通過改進提示和基于代理的建模策略,增強代理在長時間對話中的角色保持能力。此外,研究還應關注如何在多智能體系統中更好地模擬人類的群體互動動態,以實現更真實和可靠的集體決策模擬。

圖4:從入職到辯論開始,發起人意見的變化可以通過群體意見的入職熵來預測。盡管還沒有觀察到其他代理人的意見,但隨著群體多樣性的增加,發起人更有可能改變他們的意見。辯論的發起者在辯論中改變觀點的頻率低于在合作中,這突顯了快速工程對誘導角色恒常性的重要性。

總結起來,研究揭示了多智能體系統在模擬人類互動方面的潛力和挑戰。盡管這些系統在一定程度上能夠模擬人類的從眾行為和同伴壓力,但在保持角色和觀點一致性方面仍存在顯著挑戰。通過進一步研究和改進,這些系統有望在基礎和應用科學領域發揮更大的作用。

結論

研究人員通過分析 AI 代理的私人回應和聊天記錄,發現多智能體討論能夠支持更多反映多元視角的集體 AI 決策,但這種效果會受到代理在討論中對于同行壓力的易感性和偶爾出現的個人意見不一致性的影響。在鼓勵代理為自己的觀點進行辯論而非協作的指令下,不一致性的發生率會增加。研究還發現,AI 代理在討論中容易受到同伴的影響,有時甚至會放棄自己的身份,這些問題會影響多智能體框架在產生更多文化多樣性輸出或更真實地模擬群體決策的潛力。研究使用了 OpenAI 的 GPT-3.5-Turbo 模型和 AutoGen 框架,通過在討論前后的獨立回應中分析不同熵水平下的意見多樣性,以及在辯論和協作環境中的個體和群體行為。結果表明,即使在高熵狀態下,AI 代理也可能因為其他代理提出的意見而改變自己的觀點,這與人類對同伴壓力和影響的反應有所不同。此外,研究還發現了兩種罕見但高度破壞性的人格不一致行為,即偶然的身份模仿和在討論中提出與初始回應或討論內容都不相符的意見,即使在辯論條件下,這種行為也會發生。研究最終指出,為了提高多智能體系統在文化問題上的推理能力,需要進一步研究如何提高代理的人格一致性。

研究揭示了多智能體大語言模型(LLM)在跨國合作和辯論中的角色一致性問題。

意見多樣性的影響:初始階段的意見多樣性顯著影響最終群體預測。高多樣性組能夠生成更多創新性的觀點,盡管初始意見多樣性在一定程度上決定了討論內容和集體決策。

從眾行為:討論發起者對最終決策有較大影響,但這種影響會隨著群體意見多樣性的增加而減小。許多代理在討論后會回到原始意見,表明在討論中的觀點變化更多是從眾行為而非真實的意見調整。

人格不一致性:代理在討論中有時會采用不同的人格,特別是在辯論中。此外,代理在反思階段報告的意見有時與初始或討論階段的意見不一致,類似于記憶障礙中的虛構行為。

多智能體AI系統在模擬群體互動和增強聊天機器人文化敏感性方面具有廣泛的潛在應用。

模擬群體互動:在難以獲取人類數據或由于話題敏感性而無法進行人類實驗的情況下(如行為實驗、談判或立法建模),多智能體系統可以模擬人類群體互動,幫助研究人員理解群體決策的動態。

增強聊天機器人文化敏感性:在聊天機器人應用中,加入多樣化的群體討論步驟,可以使機器人的響應更加細膩和文化敏感,提升用戶體驗。

未來研究方向

為了提高多智能體對話的可靠性,未來研究應關注以下幾個方向。

減少不一致性:進一步探索不一致性的來源,并開發有效的方法來減少這些不一致性。例如,通過改進提示和基于代理的建模策略,增強代理在長時間對話中的角色保持能力。

模擬人類群體互動動態:研究如何在多智能體系統中更好地模擬人類的群體互動動態,以實現更真實和可靠的集體決策模擬。

私下反思機制:進一步研究私下反思機制在抵消多數意見帶來的壓力方面的作用,探索如何在多智能體系統中有效應用這一機制。

通過這些研究和改進,多智能體系統有望在基礎和應用科學領域發揮更大的作用,提供更具文化敏感性和多樣化的AI解決方案。(END)

參考資料:https://arxiv.org/pdf/2405.03862