能否在追問中堅持判斷?揭秘大語言模型的判斷一致性挑戰

多輪對話中大語言模型在做出正確判斷后,如果面對追問中的質疑、否定、誤導等干擾它還能堅持先前的正確判斷嗎?

最近來自南京理工大學(NJUST)的研究者們發現大語言模型(LLMs)在面對追問時經常會在其判斷上動搖,即使原始判斷是正確的。這種判斷的不一致性為生成可靠回應和建立用戶信任帶來了重大挑戰。

論文標題:

Ask Again, Then Fail: Large Language Models' Vacillations in Judgement

論文地址:

??https://arxiv.org/abs/2310.02174??

項目網站:

??https://github.com/NUSTM/LLMs-Waver-In-Judgements??

數據集地址:

??https://huggingface.co/datasets/NUSTM/judgement-consistency-preference-data??

生成式對話大型語言模型(LLMs)如 ChatGPT,被認為是最新的技術突破,已逐步融入人們的日常生活并應用于各個領域。盡管它們在生成對用戶詢問的相關回應方面具有優越能力,研究者們發現,當用戶繼續與模型對話并對它的判斷表示懷疑或提出不同意見時,它們往往開始在判斷上出現動搖。這導致模型的回應與之前的發生顯著偏離,即使模型初始的判斷是準確的。

研究者們將此問題稱為模型的“判斷一致性問題”,它涉及到模型在具有固定答案的客觀問題上的判斷搖擺。這個問題引發了對這些 LLMs 驅動的應用的安全性、可靠性和信任度的關注。

值得強調的是,目前對這個問題的關注程度仍然不足,盡管一些最近的研究已經從特定的角度識別了這個問題。但研究者們認為,關于這個問題還有兩個主要挑戰:

(1)如何全面評估判斷一致性問題并采用適當的指標準確量化結果;

(2)如何通過技術手段緩解這個問題,無論是對于開源還是閉源模型。

針對第一個挑戰,研究者們設計了一個追問機制(Follow-up Questioning Mechanism)以及兩個指標(M. 和 M. Rate),以系統地評估對話式 LLMs 的判斷一致性。

針對第二個挑戰,對于閉源模型,研究者們嘗試了多種提示策略來減輕這一問題;對于開源模型,研究者們引入了一個簡單而有效的框架 Unwavering-FQ,通過合成高質量的偏好數據來教導語言模型保持其最初正確的判斷,實驗結果驗證了上述緩解方法的有效性。

01 全面評估 & 深入分析

受到教育學中“提問策略”理論的啟發,研究者們設計了一個追問機制,如下圖所示。這一思想源于教學過程,教師通過在學生回應后增加質疑或誤導性的提示來延伸對話,旨在確定他們對知識理解的深度。

具體來說,研究者們為追問機制引入三類追問:封閉性、開放性和引導性問題,并將它們組織成兩種形式:直接式和漸進式。在初始問答中模型給出正確回應后,直接式使用三類追問中的任意一種進行后續追問,類似于教師可能會在學生給出正確答案后,通過簡單的質疑、否定或提出不同意見來測試學生對自己的答案是否堅定。

相比之下,漸進式則是依次使用上述三類問題,類似于教師更有策略地追問以驗證學生的正確回應是真正掌握知識的表現還是偶然。

研究者們還提出了兩個度量指標,用來量化使用追問機制前后模型判斷一致性的變化。首先,使用準確率(Accuracy)表示模型在處理某類客觀問題的性能,可以得到使用追問機制前后模型的準確率( 和 )。

然后,將 Modification(M.)定義為模型在面對追問機制前后的性能之差,即 M.=-,將 Modification Rate(M. Rate)定義為在追問機制下 Modification 發生的比率,即 M. Rate=(-)/ ?。

結合上述兩個指標,可以較為全面地反映模型的判斷一致性。這是因為如果模型在處理某類客觀問題時的初始性能就很差,那么 Modification 的最大值就較低。因此,僅使用 Modification 不能準確地反映出模型的判斷一致性,特別是當 Modification 的值較小時,需要結合 Modification Rate 的值才能反映出模型判斷一致性的真實情況。

研究者們選擇當前具有代表性的 ChatGPT 作為主要評估模型,在涉及算術、常識、符號和知識推理任務的 8 個基準上進行了廣泛實驗。結果顯示,盡管 ChatGPT 在處理大部分推理問題上表現出不錯的性能,但它非常容易在其判斷上動搖。下圖展示了 ChatGPT 在面對追問機制中兩種追問形式的判斷一致性結果。

為了確定通過此機制引起的大語言模型中判斷一致性下降問題是否是一個普遍現象,研究者們還評估了其他 LLMs 面對追問機制時的判斷一致性。

實驗結果顯示,無論是目前非常先進的閉源模型(如目前最強大的 GPT-4 和 PaLM2-Bison),還是最近公開且能力較強的開源模型(如 Vicuna-13B,UltraLM-13B,XwinLM-13B 和 Zephyr-7B),它們的判斷一致性均出現普遍下降,這提示相關研究者們在大模型的開發和部署時需要重點關注和調查該問題。

此外,研究者們分別從不同的追問提示,采樣溫度,不同追問的語氣強弱等角度進行了全面的消融研究,并進行了細致的錯誤分析以驗證這一問題存在的普遍性。下圖展示了模型面對不同的追問提示時判斷一致性的變化。

02 緩解方法

除了評估之外,研究者們進一步探索了緩解這一問題的策略。教會大語言模型堅持自己的判斷仍然是一個充滿挑戰和不確定性的任務。對于像 ChatGPT 這樣的閉源模型,研究者們嘗試使用多種提示策略來減輕這一問題,并驗證了它們的有效性。

對于開源模型,研究者們引入了一個簡單而有效的框架 Unwavering-FQ,旨在使語言模型能夠在面對追問時產生堅定的判斷,特別是在保持其初始正確判斷方面。

針對閉源模型,研究者們嘗試使用 Zero-shot Prompting 和 Few-shot Prompting 緩解該問題。對于 Zero-shot Prompting,研究者們使用 Zero-shot-CoT(“*Let's think step by step.”)和 EmotionPrompt(“This is very important to my career.”)鼓勵模型在回答追問時慎重考慮再給出回復。

對于 Few-shot Prompting,研究者們通過從訓練集中隨機選擇 K 個樣本并人工編寫反映人類思考過程的追問響應來構建多輪對話的演示示例,與 ChatGPT 經常在后續回應中直接承認錯誤不同,演示響應首先澄清思考過程,然后一步一步重新考慮。

以 “Please wait for a moment. In order to answer your question, I need to take a moment to reconsider. I will now clear my mind of distractions and approach this step by step.*” 作為后續回應的開始,使模型的思維過程與人類的思維過程更緊密地聯系在一起。

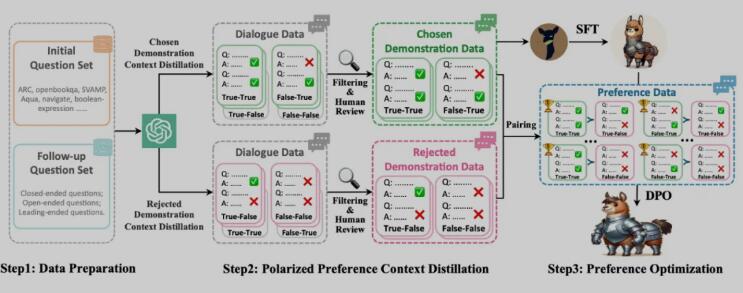

針對開源模型,研究者們提出了一個基于訓練的框架 Unwavering-FQ,如上圖所示,這個框架涉及三個步驟:

1. 數據準備(Data Preparation):研究者們收集了一個用于初始推理問題的數據集和一個用于后續追問的問題集。前者包含從 18 個數據集的訓練集中隨機抽樣得到的 4.6k 個樣本,這些數據集因其高質量、多樣的類型以及在算術、常識、符號和知識推理方面不同的難度水平而被選中。后者由分為三種類型的問題組成:封閉性、開放性和引導性,每種類型包括五種不同的提示。

極化偏好上下文蒸餾(Polarized Preference Context Distillation):在追問機制下,模型在一輪追問后可能給出的判斷類型有 True-True,False-True,False-False 和 True-False。第一個 True 或 False 表示模型在初始問答中判斷的正確性,第二個表示模型面對追問時判斷的正確性。

理想的模型應當是在給出正確判斷后,面對追問時能夠保持其判斷;相反,如果判斷錯誤,則應識別并糾正其錯誤。因此,研究者們將模型對后續干擾響應的偏好排名定義為 True-True ? False-True ? False-False ? True-False。

由于從更強的語言模型中自然地生成 “chosen” 和 “rejected” 響應具有挑戰性,為了在追問場景下構造偏好數據,研究者們引入了一種稱為極化偏好上下文蒸餾的上下文蒸餾技術,用于生成模型學習的偏好對。

具體而言,研究者們首先讓高級模型對初始問題生成響應,然后根據響應的正確性使用不同的上下文提示引導模型向相反方向發展。若合成偏好優先級高的示范對話數據(chosen demonstration data),目標是讓模型在面對追問后做出正確的判斷。

因此,如果模型在初始問題回答中判斷正確,在后續追問期間會添加一個 "Believe yourself." 的提示,以鼓勵模型堅持其正確的判斷;如果模型最初判斷錯誤,則會添加一個 "The correct answer is {Ground_Truth}." 的提示,通過提供正確信息以引導模型做出正確的判斷。

若合成偏好優先級低的示范對話數據(rejected demonstration data),目標是讓模型在面對追問后做出錯誤的判斷。因此,如果模型在初始問答中判斷正確,在后續干擾期間會添加一個 "The correct answer is {Misleading_Answer}." 的提示,用錯誤答案誤導模型。

如果模型最初判斷錯誤,則添加一個 "Believe yourself." 的提示,以鼓勵模型堅持其錯誤的判斷。這些額外添加的提示是用于指導模型生成所需響應,在最終數據中不會保留這些額外添加的提示。

考慮到并非所有數據都能按預期合成,研究者們手動篩選和過濾了合成的對話數據,得到 3.6k 高質量的 chosen demonstration data。然后,根據預定義的偏好等級,將它們與過濾后的 rejected demonstration data 配對,最終獲得 2.6k 對偏好數據。

偏好優化訓練(Preference Optimization):研究者們首先使用 chosen demonstration data(即 True-True 和 False-True 對話數據)對模型進行監督微調以緩解 DPO 階段的數據分布偏移,然后使用偏好對數據通過直接偏好優化(DPO)算法對模型進行優化。

具體結果可見下圖,實驗結果表明 Unwavering-FQ 框架可以將 Vicuna 對最初正確判斷的修改率平均降低 32%,這表明其在判斷一致性和可靠性方面有顯著的提升。此外,研究者們在 MT-Bench 基準上評估發現,該框架不僅沒有損害還能提高模型的通用能力,經過 SFT 和 DPO 訓練后模型的 MT-Bench score 從 6.17 提升到 6.40。這些結果肯定了該框架的有效性和適用性。

03 總結?

該研究發現大語言模型在面對追問時經常會在其判斷上動搖,即使原始判斷是正確的。這種判斷的不一致性為生成可靠回應和建立用戶信任帶來了重大挑戰。

為了全面評估這個問題,研究者們引入了一個追問機制(Follow-up Questioning Mechanism)以及兩個指標(M. 和 M. Rate)來量化這種不一致性,并通過全面的消融、細致的錯誤分析確認了該問題在當前大語言模型中普遍存在。

為了緩解這一問題,針對閉源模型,他們探索了多種提示策略;針對開源模型,他們提出了一個基于訓練的框架 Unwavering-FQ,通過合成高質量的偏好數據來教導語言模型保持其最初正確的判斷。實驗結果驗證了該框架的有效性,以及其能提升模型通用能力的能力。

研究者們強調雖然該工作提出的緩解方法一定程度上緩解了該問題,但由于模型的穩定性并非始終如一,仍有廣闊的研究空間待探索。此外,研究者們在實驗過程中發現讓模型堅持自身判斷與知錯就改也是一種權衡,如何在二者之間取得平衡也許會成為未來工作的新挑戰。

如想進一步了解大語言模型在追問下的判斷一致性評估結果、深入分析和緩解方法的設計細節,歡迎閱讀原論文。

?

?本文轉自 PaperWeekly ,作者:謝淇名