多智能體合作的新路徑,PRD-MAPPO的設計與實現 精華

多智能體強化學習(MARL)近年來在解決復雜的決策問題上取得了顯著進展。MARL系統通過多個智能體的協作,能夠在諸如DOTA 2、星際爭霸II和旗幟爭奪等復雜任務中實現超人表現。然而,這些成就的背后是巨大的計算成本和環境交互需求,通常需要數百萬甚至數十億次的環境交互,這使得這些算法只能在高成本的計算集群上運行。

在多智能體系統中,信用分配問題是一個關鍵挑戰。隨著智能體數量的增加,評估每個智能體對整體成功的貢獻變得愈加困難。這種困難在合作任務中尤為突出,因為每個智能體不僅要優化自身的獎勵,還要考慮其行為對其他智能體獎勵的影響。信用分配問題導致了策略梯度方法中的高方差問題,使得學習過程變得緩慢且不穩定。

8 月 9 日來自卡內基梅隆大學機器人研究所的研究團隊提出了一種改進的多智能體強化學習算法,稱為PRD-MAPPO(部分獎勵解耦的多智能體近端策略優化)。該算法通過引入部分獎勵解耦(PRD)機制,利用學習的注意力機制動態將大群體智能體分解為更小的子群體,從而簡化信用分配。實驗結果表明,PRD-MAPPO在多個多智能體任務中,比現有的先進方法具有更高的數據效率和最終性能。論文的核心貢獻在于:

- 提出了適用于共享獎勵環境的PRD-MAPPO版本。

- 引入了“軟”變體,通過注意力權重重新加權優勢項,而不是嚴格解耦。

- 修改了優勢估計策略,使學習更新的計算時間從二次方減少到線性。

通過這些改進,PRD-MAPPO顯著提高了多智能體系統的學習效率和穩定性,為解決大規模合作任務中的信用分配問題提供了新的思路和方法。

研究團隊是來自卡內基梅隆大學機器人研究所的Benjamin Freed、Howie Choset、Jeff Schneider 和來自Tata Consultancy Services 的Aditya Kapoor,他們主要研究方向包括多智能體系統、強化學習和機器人技術。以其在機器人技術和多智能體系統方面的開創性工作而聞名。這個團隊結合了工業界和學術界的力量,致力于解決多智能體強化學習中的信用分配問題,并提出了部分獎勵解耦(PRD)的方法,以提高多智能體系統的學習效率和穩定性。

方法介紹

馬爾可夫博弈的定義

在多智能體強化學習中,問題通常被建模為馬爾可夫博弈。一個馬爾可夫博弈由以下幾個部分組成:

狀態空間(S):表示所有可能的系統狀態的集合。

動作空間(A):表示所有智能體的聯合動作空間,即每個智能體的動作組合。

狀態轉移概率(P):定義了在給定當前狀態和聯合動作的情況下,系統轉移到下一個狀態的概率分布。

獎勵分布(R):定義了在給定當前狀態和聯合動作的情況下,智能體獲得的獎勵分布。

初始狀態分布(ρ0):表示系統初始狀態的概率分布。

折扣因子(γ):用于折扣未來獎勵的影響,取值范圍為(0, 1]。

在每個時間步t,智能體i根據其狀態選擇一個動作,目標是最大化整個團隊的總回報,即所有智能體在所有時間步的獎勵之和。這種合作行為的目標要求智能體不僅要考慮自己的獎勵,還要考慮其行為對其他智能體獎勵的影響。

信用分配與策略梯度方差

在策略梯度算法中,優勢函數用于衡量在特定狀態下選擇某個動作比隨機選擇動作更好的程度。優勢函數通常定義為:

Aπ(s, a) = Qπ(s, a) - Vπ(s)

其中,Qπ(s, a)是狀態-動作值函數,Vπ(s)是狀態值函數。優勢函數的高方差會導致策略梯度估計的高方差,使得學習過程變得噪聲且不穩定。

在多智能體設置中,單個智能體的策略梯度估計方差不僅取決于每個智能體的優勢估計方差,還取決于智能體之間優勢的協方差。通過消除不相關的優勢項,可以減少方差,提高數據效率。因此,改進信用分配策略,減少策略梯度估計的方差,是提高多智能體系統學習效率的關鍵。

近端策略優化(PPO)

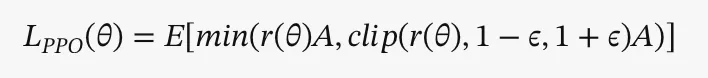

近端策略優化(PPO)是一種改進的策略梯度算法,通過允許在單個數據批次上進行多次策略更新,提高了數據效率。PPO通過優化一個“代理”目標,懲罰與舊策略的過大偏離,從而避免策略過度偏離。具體來說,PPO在每次策略優化步驟中,優化以下目標函數:

其中,r(θ)是更新后和舊策略的比率,A是優勢估計。

PPO在多智能體問題上表現出色,但隨著團隊規模的增加,策略梯度更新的方差也增加,需要更大的數據批次來達到滿意的信噪比。因此,盡管PPO提高了數據效率,但在處理大規模多智能體系統時,仍面臨高方差和數據需求的問題。

部分獎勵解耦(PRD)

部分獎勵解耦(PRD)是一種通過將大規模多智能體問題動態分解為較小的子群體,改進信用分配的方法。PRD利用注意力機制估計每個智能體的相關集,從而簡化信用分配。具體來說,如果智能體i在某個時間步t對智能體j的注意力權重為零,則可以認為智能體i不在智能體j的相關集中,從而可以忽略其對策略梯度的影響。

PRD最初應用于Actor-Critic(AC)算法,通過減少無關智能體的貢獻,提高了數據效率。然而,PRD在AC算法中的應用存在計算復雜度高和假設環境提供每個智能體的獎勵流等局限性。論文提出的PRD-MAPPO通過將PRD整合到MAPPO中,改進了相關集估計和優勢函數計算,顯著提高了多智能體系統的學習效率和穩定性。

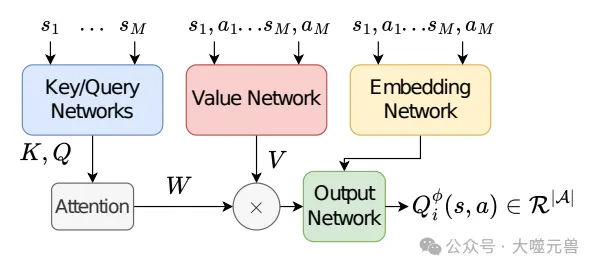

圖1:Q和價值函數網絡架構。每個代理使用所有代理的狀態來計算除自身之外的每個代理的注意力權重。然后,這些注意力權重用于聚合除自身之外的所有主體的注意力值。最后,將代理i的聚合注意力值與代理i的嵌入式狀態動作向量(如果網絡作為Q函數運行)或代理i的嵌入狀態向量(如果該網絡作為值函數運行)連接起來。最后,通過輸出網絡生成Q?i(s,a)或Vψi(s,a?=i)。

通過這些方法的改進,PRD-MAPPO在多個多智能體任務中表現出色,展示了其在解決大規模合作任務中的潛力。

PRD-MAPPO算法

PRD-MAPPO的提出與改進

PRD-MAPPO(部分獎勵解耦的多智能體近端策略優化)是通過將部分獎勵解耦(PRD)機制整合到多智能體近端策略優化(MAPPO)中提出的。PRD的核心思想是利用注意力機制來估計每個智能體的相關集,從而動態地將大規模多智能體問題分解為較小的子群體。這種分解使得每個智能體只需關注與其相關的其他智能體,簡化了信用分配問題。

在PRD-MAPPO中,每個智能體通過學習的Q函數來估計其相關集。具體來說,如果智能體i在某個時間步t對智能體j的注意力權重為零,則可以認為智能體i不在智能體j的相關集中,從而可以忽略其對策略梯度的影響。為了提高計算效率,PRD-MAPPO引入了兩個獨立的評論家:一個用于相關集估計的Q函數,另一個用于優勢函數估計的價值函數。通過這種方式,PRD-MAPPO將計算復雜度從二次方減少到線性,提高了數據效率。

PRD-MAPPO參數更新規則

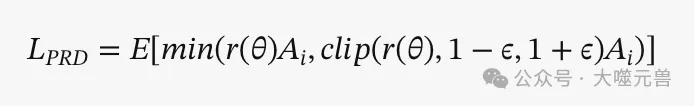

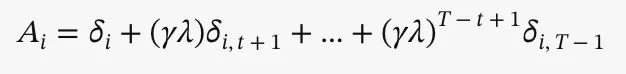

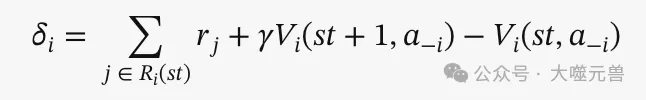

PRD-MAPPO通過修改MAPPO的目標函數,消除了不相關智能體的獎勵項,從而減少了學習更新中的噪聲。具體來說,PRD-MAPPO的目標函數為:

其中,Ai是智能體i的優勢估計,忽略了不相關智能體的獎勵項。

為了進一步提高PRD-MAPPO的性能,論文提出了軟變體PRD-MAPPO-soft。該變體通過注意力權重重新加權智能體的獎勵,而不是嚴格解耦。具體來說,軟變體的優勢估計為:

其中,

通過這種方式,PRD-MAPPO-soft在實踐中表現出更高的性能。

共享獎勵環境中的PRD

在某些多智能體系統中,環境只提供單一的共享獎勵,而不是每個智能體的獨立獎勵流。為了在這種環境中應用PRD,論文提出了一種將共享回報分解為個體回報的方法。具體來說,首先訓練一個共享Q函數來預測共享回報,然后使用注意力權重將共享回報分配給各個智能體。

在共享獎勵環境中,PRD-MAPPO-shared通過將共享回報分解為個體回報,并應用PRD-MAPPO進行學習更新。具體來說,PRD-MAPPO-shared的優勢估計為:

通過這種方式,PRD-MAPPO-shared能夠在共享獎勵環境中有效地進行信用分配,提高學習效率和穩定性。

通過這些改進,PRD-MAPPO在多個多智能體任務中表現出色,展示了其在解決大規模合作任務中的潛力。

實驗與結果

實驗設計

為了驗證PRD-MAPPO的有效性,研究團隊設計了一系列實驗,比較了多種算法在不同多智能體強化學習(MARL)環境中的表現。

PRD-MAPPO:論文提出的結合部分獎勵解耦(PRD)的多智能體近端策略優化(MAPPO)。

PRD-MAPPO-soft:PRD-MAPPO的軟變體,通過注意力權重重新加權智能體的獎勵。

PRD-MAPPO-shared:適用于共享獎勵環境的PRD-MAPPO軟變體。

MAPPO:多智能體近端策略優化算法,由Yu等人(2021)提出。

HAPPO:一種擴展信任區域學習到合作多智能體強化學習的算法,由Kuba等人(2021)提出。

G2ANet-MAPPO:結合G2ANet風格評論家的MAPPO,嘗試將G2ANet的信用分配優勢引入MAPPO。

COMA:反事實多智能體策略梯度算法,由Foerster等人(2018)提出,通過反事實基線改進信用分配。

PRD-V-MAPPO:使用基于價值函數的相關集估計方法的PRD-MAPPO,由Freed等人(2022)提出。

LICA:隱式信用分配方法,由Zhou等人(2020)提出,通過超網絡表示集中評論家。

QMix:聯合狀態-動作值函數學習算法,由Rashid等人(2018)提出。

實驗環境包括以下幾種典型的多智能體任務:

- 碰撞避免:智能體需要在避免碰撞的情況下到達指定目標位置。

- 追捕:智能體需要合作追捕目標。

- 壓力板:智能體需要合作按下壓力板以完成任務。

- 基于等級的覓食:智能體需要根據等級合作覓食。

- 星際爭霸多智能體挑戰(SMAClite):包括5m_vs_6m、10m_vs_11m和3s5z戰斗場景。

實驗結果與分析

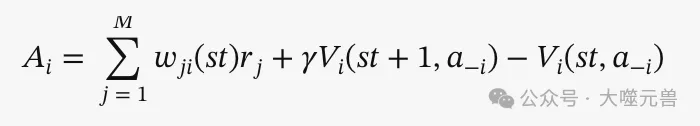

實驗結果顯示,PRD-MAPPO、PRD-MAPPO-soft和PRD-MAPPO-shared在所有環境中表現出色,尤其是PRD-MAPPO-soft在大多數任務中表現最佳。具體來說,PRD-MAPPO-soft僅在壓力板環境中被QMix超越,其余任務中均優于其他算法。PRD-MAPPO和PRD-MAPPO-shared也表現出色,整體上優于MAPPO和其他先進的多智能體強化學習算法。

圖2:PRD MAPPO soft、PRD-MAPPO、PRDV-MAPPO、COMA、LICA、QMix、MAPPO、MAPPO-G2ANet在A)團隊避碰、B)追擊、C)壓力板、D)基于級別的覓食、E)星際爭霸5m_vs_6m、F)星際爭霸10m_vs_11m任務和G)星際爭霸3s5v上的平均獎勵與劇集。實線表示5個隨機種子的平均值,陰影區域表示95%的置信區間。采用PRD的方法(PRD-MAPPO和PRD-MAPPO-soft)往往優于所有其他方法,表明可以通過改善信貸分配來利用PRD來改善PPO。

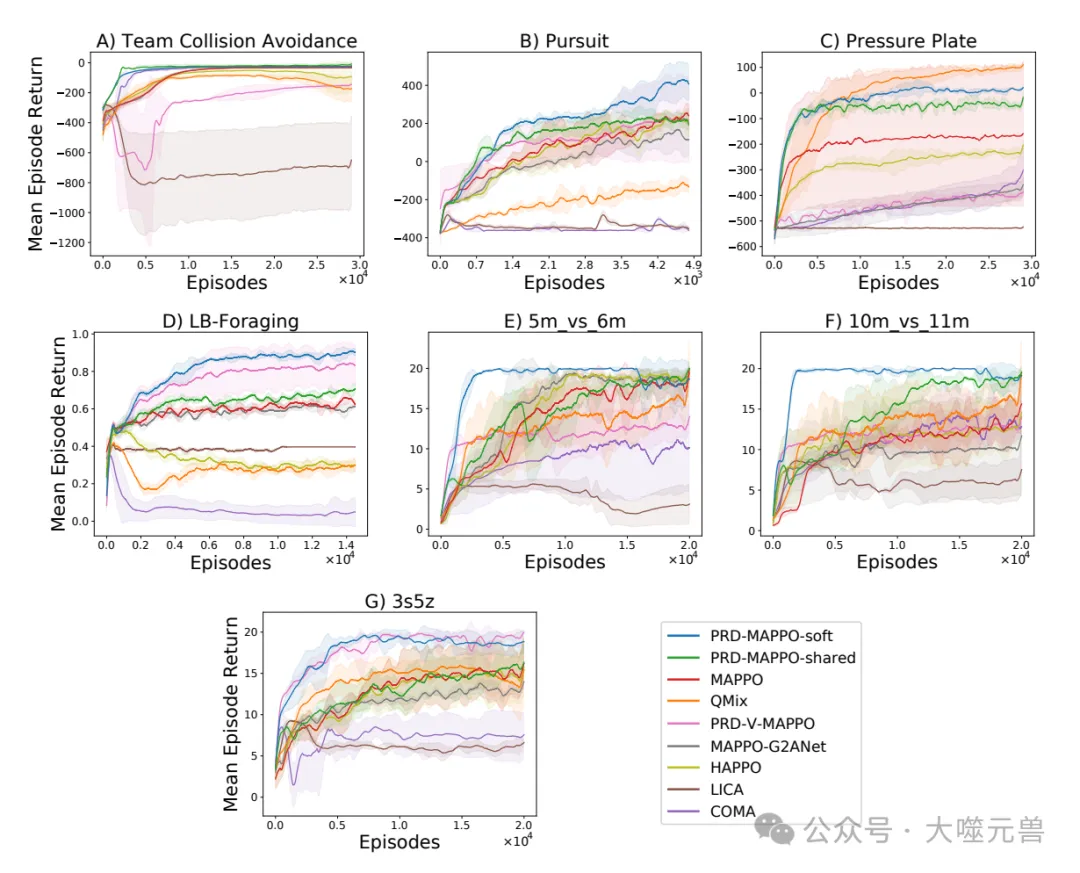

為了深入了解相關集選擇過程,研究團隊在碰撞避免任務中可視化了訓練后的智能體的注意力權重。結果顯示,智能體主要對同隊智能體分配較高的注意力權重,而對其他隊的智能體分配的注意力權重接近于零。這驗證了PRD機制在相關集選擇上的有效性。

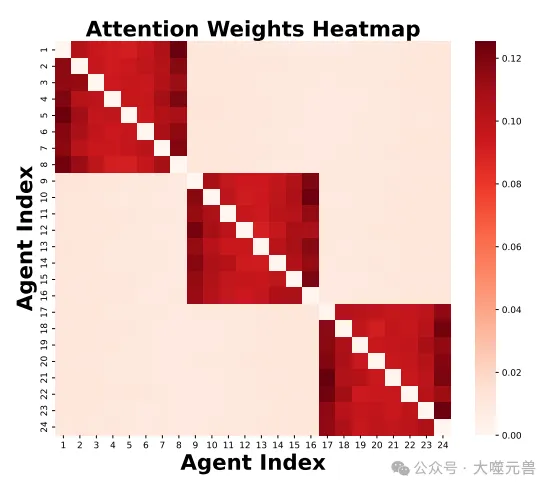

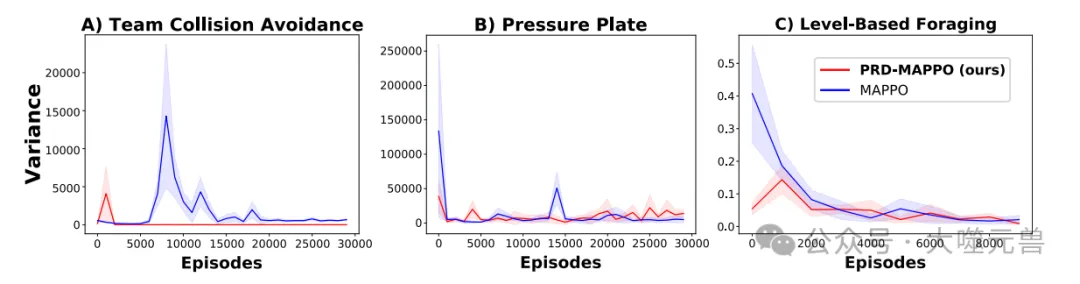

為了驗證部分獎勵解耦減少策略梯度估計方差的效果,研究團隊在訓練過程中估計了MAPPO和PRD-MAPPO的梯度方差。結果表明,PRD-MAPPO在訓練過程中顯著減少了梯度方差,避免了MAPPO中出現的劇烈波動。這一結果進一步證明了PRD-MAPPO在提高數據效率和學習穩定性方面的優勢。

通過這些實驗結果,PRD-MAPPO展示了其在解決大規模合作任務中的潛力,顯著提高了多智能體系統的學習效率和穩定性。

相關工作

現有信用分配方法的綜述

在多智能體強化學習(MARL)中,信用分配問題是一個關鍵挑戰。為了應對這一問題,研究人員提出了多種方法。

G2ANet:由Liu等人(2020)提出,G2ANet是一種基于注意力的游戲抽象機制,使評論家能夠更好地隔離重要的智能體交互,忽略不重要的交互。雖然G2ANet沒有像PRD那樣進行顯式解耦,但它通過注意力機制改進了信用分配。

COMA:反事實多智能體策略梯度(Counterfactual Multi-Agent Policy Gradient)算法由Foerster等人(2018)提出。COMA使用反事實基線,通過將單個智能體的動作邊際化,同時保持其他智能體的動作不變,來更精確地確定每個智能體的貢獻。COMA基于差異獎勵的思想,使每個智能體使用修改后的獎勵來比較共享獎勵與反事實情境下的默認動作。

VDAC:價值分解Actor-Critic(Value-Decomposition Actor-Critics)方法由Su等人(2021)提出。VDAC使用價值分解網絡作為評論家,在Actor-Critic框架中進行信用分配。該方法通過將聯合價值函數分解為每個智能體的價值函數,提高了信用分配的效率。

LICA:由Zhou等人(2020)提出,LICA是一種隱式信用分配方法。LICA通過將集中評論家表示為超網絡,并在聯合動作值梯度的方向上優化策略,從而隱式地解決了信用分配問題。LICA通過引入額外的潛在狀態表示,提供了足夠的信息來學習最優的合作行為。

QMix:由Rashid等人(2018)提出,QMix學習一個聯合狀態-動作值函數,該函數表示為每個智能體價值函數的復雜非線性組合。聯合價值函數在結構上保證了單個智能體價值的單調性,使智能體能夠通過貪婪地選擇最佳動作來最大化聯合價值函數。

圖3:防撞環境中的相關集合可視化。我們將每個代理分配給其他代理的平均注意力權重可視化,平均值為5000個獨立事件。因為代理總是給自己分配1的注意力權重,所以我們從圖中刪除了這些元素,因為它們沒有信息。我們注意到,與其他團隊的代理人相比,代理人通常會給團隊中的代理人分配更高的注意力權重,這是意料之中的,因為只有代理人的隊友才能影響其獎勵。

PRD-MAPPO與現有方法的比較

PRD-MAPPO通過將部分獎勵解耦(PRD)機制整合到多智能體近端策略優化(MAPPO)中,提出了一種新的信用分配策略。與現有方法相比,PRD-MAPPO具有以下優勢:

- 顯式解耦:與G2ANet不同,PRD-MAPPO通過顯式解耦無關智能體的貢獻,減少了策略梯度估計的方差,提高了數據效率和學習穩定性。

- 改進的反事實基線:雖然COMA使用反事實基線來改進信用分配,但PRD-MAPPO通過注意力機制動態估計相關集,進一步簡化了信用分配問題。

- 計算效率:PRD-MAPPO通過引入兩個獨立的評論家(Q函數和價值函數),將計算復雜度從二次方減少到線性,提高了計算效率。

- 適用于共享獎勵環境:PRD-MAPPO-shared通過將共享回報分解為個體回報,擴展了PRD的適用范圍,使其能夠在共享獎勵環境中有效應用。

- 軟變體的提出:PRD-MAPPO-soft通過注意力權重重新加權智能體的獎勵,而不是嚴格解耦,在實踐中表現出更高的性能。

圖4:團隊避碰、壓力板和LBF環境的梯度估計器方差與事件。實線表示5個隨機種子的平均值,陰影區域表示95%的置信區間。PRD-MAPPO傾向于避免MAPPO所表現出的梯度方差的急劇峰值。

PRD-MAPPO在多個多智能體任務中表現出色,展示了其在解決大規模合作任務中的潛力。通過顯式解耦和改進的信用分配策略,PRD-MAPPO顯著提高了多智能體系統的學習效率和穩定性,優于現有的多智能體強化學習算法。

局限性與未來工作

PRD-MAPPO的局限性

盡管PRD-MAPPO在多個多智能體任務中表現出色,但它仍然存在一些局限性:

PRD-MAPPO并不能在所有環境中加速學習。在某些任務中,智能體之間的交互過于復雜或密集,使得PRD的解耦效果有限。例如,在交通路口實驗中,由于智能體之間的交互過于密集,PRD的效果可能僅有部分提升。這表明,PRD-MAPPO在處理高度復雜和密集交互的任務時,可能無法顯著提高學習效率。

在某些任務中,每個智能體的相關集可能包含大多數或所有其他智能體,這使得PRD的解耦策略難以發揮作用。當智能體之間的交互非常密集時,PRD-MAPPO的優勢會被削弱,因為幾乎所有智能體的行為都對其他智能體的獎勵產生影響。在這種情況下,PRD-MAPPO的計算復雜度和數據需求可能會顯著增加,影響其性能。

未來研究方向

為了進一步提高PRD-MAPPO的適用性和性能,未來的研究可以從以下幾個方向展開。

未來的研究可以探索如何改進PRD-MAPPO,使其在更多類型的任務中表現出色。例如,可以研究更先進的注意力機制或相關集估計方法,以更好地處理密集交互的任務。此外,可以探索如何動態調整PRD的解耦策略,使其能夠適應不同任務的需求,從而提高其通用性和適應性。

除了PRD,未來的研究還可以探索其他新的信用分配策略,以進一步提高多智能體系統的學習效率和穩定性。例如,可以研究基于圖神經網絡的信用分配方法,通過捕捉智能體之間的復雜關系來改進信用分配。此外,可以探索結合多種信用分配策略的混合方法,以充分利用不同策略的優勢,解決不同類型的任務。

未來的研究還可以將PRD-MAPPO應用于更多實際場景,如自動駕駛、機器人協作和智能電網等。這些實際應用場景通常具有高度復雜和動態的環境,對多智能體系統的學習效率和穩定性提出了更高的要求。通過在實際場景中驗證和改進PRD-MAPPO,可以進一步提升其實用性和影響力。

通過這些研究方向的探索,PRD-MAPPO有望在更多類型的任務和實際應用中發揮重要作用,進一步推動多智能體強化學習的發展。(END)

參考資料:https://arxiv.org/pdf/2408.04295

本文轉載自 ??大噬元獸??,作者: FlerkenS