自我一致性提升大模型中的思維鏈推理能力 原創(chuàng)

摘要:結合預訓練大型語言模型的鏈式思考提示在復雜推理任務上已取得令人鼓舞的成果。本文提出了一種新的解碼策略——自我一致性,以替代鏈式思考提示中使用的樸素貪婪解碼。該策略首先采樣一套多樣化的推理路徑,而非單一的貪心路徑,并通過邊緣化采樣的推理路徑來選擇最一致的答案。自我一致性利用了這樣一種直覺:一個復雜的推理問題通常允許通過多種不同的思考方式達到其唯一正確的答案。廣泛的實證評估表明,自我一致性顯著提升了鏈式思考提示在一系列流行算術和常識推理基準上的性能,包括GSM8K(+17.9%)、SVAMP(+11.0%)、AQuA(+12.2%)、StrategyQA(+6.4%)以及ARC挑戰(zhàn)賽(+3.9%)。

1、引言

盡管語言模型在眾多自然語言處理任務中展現出卓越的成功,但它們展現推理能力的能力常被視為局限,這一局限性不能僅通過增加模型規(guī)模來克服(Rae等人,2021;BIG-bench合作項目,2021等)。為了應對這一不足,Wei等人(2022)提出了鏈式思考提示方法,即促使語言模型生成一系列簡短句子,模擬個人在解決問題時可能采用的推理過程。例如,面對問題“停車場有3輛車,又有2輛車到達,現在停車場有多少輛車?”時,語言模型不是直接回答“5”,而是被提示輸出整個思考鏈:“停車場已有3輛車。又有2輛到達。現在是3+2=5輛車。答案是5。”。人們觀察到,鏈式思考提示顯著提高了模型在多種多步推理任務上的表現(Wei等人,2022)。

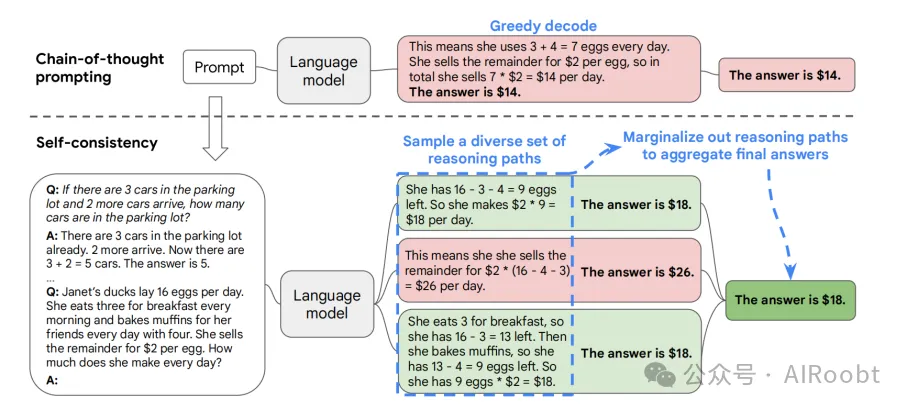

在本文中,我們引入一種新穎的解碼策略——自我一致性,用以替代鏈式思考提示(Wei等人,2022)中使用的貪婪解碼策略,進一步顯著提升語言模型的推理性能。自我一致性利用了這樣一個直覺:復雜的推理任務通常允許多條推理路徑達到正確答案(Stanovich & West, 2000)。一個問題越是需要深思熟慮和分析(Evans, 2010),能恢復答案的推理路徑多樣性就越大。圖1通過示例說明了自我一致性方法。我們首先使用鏈式思考提示激發(fā)語言模型,然后不是貪心地解碼最優(yōu)推理路徑,而是提出一個“采樣-邊緣化”解碼過程:我們首先從語言模型的解碼器中采樣生成多樣化的推理路徑集合;每條路徑可能導致不同的最終答案,因此我們通過對采樣的推理路徑進行邊緣化,從最終答案集中找出最一致的答案。這種方法類似于人類的經驗,如果多種不同的思考方式都能得出相同的答案,人們對最終答案的正確性會有更大的信心。與其他解碼方法相比,自我一致性避免了貪婪解碼的重復性和局部最優(yōu)性,同時減輕了單次采樣生成的隨機性。

圖 1:自一致性方法包含三個步驟:(1)使用鏈式思維(CoT)提示來提示語言模型;(2)將 CoT 提示中的“貪婪解碼”替換為從語言模型的解碼器中采樣,以生成多樣化的推理路徑集合;(3)對推理路徑進行邊際化處理,并通過選擇最終答案集中最一致的答案進行匯總。

(注釋:這張圖展示了“自一致性”方法在使用鏈式思維(Chain-of-Thought, CoT)提示中的應用過程,用于提高語言模型在復雜推理任務中的準確性。圖中通過三個步驟展示了自一致性方法如何優(yōu)化推理過程和最終答案。

1. Chain-of-Thought 提示

首先,通過鏈式思維提示方法,向語言模型(Language Model)提供一個問題以及推理過程的提示。例如,問題是:

- Q: 如果停車場里已經有3輛車,又來了2輛車,那么停車場里有多少輛車?

- A: 停車場里已經有3輛車,又來了2輛車。現在3 + 2 = 5輛車。答案是5。

然后給出一個更復雜的問題:

- Q: 珍妮的鴨子每天產16個蛋。她每天早上吃3個蛋做早餐,并用4個蛋烤松餅給她的朋友們。她把剩下的蛋以每個蛋2美元的價格賣掉。她每天能賺多少錢?

2. 貪心解碼(Greedy Decode)

傳統方法使用貪心解碼,即模型一次生成一個最可能的下一個詞,直到完成整個回答。在圖中,貪心解碼給出的答案是:

- 她每天用3 + 4 = 7個蛋。她把剩下的蛋以每個蛋2美元的價格賣掉,所以她每天賣7 * 2美元 = 14美元。答案是14美元。

但這個答案可能不是最優(yōu)的,因為貪心解碼沒有探索其他可能的推理路徑。

3. 自一致性方法

3.1 生成多樣化的推理路徑

自一致性方法通過從語言模型的解碼器中采樣,生成一組多樣化的推理路徑,而不是單一的貪心解碼。例如,在圖中,生成了多個推理路徑:

- 路徑1:她有16 - 3 - 4 = 9個蛋剩下。所以她每天賺2美元 * 9個蛋 = 18美元。答案是18美元。

- 路徑2:這意味著她把剩下的蛋以每個2美元的價格賣掉,所以她每天賺2美元 * (16 - 4 - 3) = 26美元。答案是26美元。

- 路徑3:她每天早餐吃3個蛋,所以她有16 - 3 = 13個蛋剩下。然后她用4個蛋烤松餅,所以她有13 - 4 = 9個蛋剩下。所以她每天賺2美元 * 9個蛋 = 18美元。答案是18美元。

3.2 推理路徑的邊際化(Marginalize out Reasoning Paths)

在生成了多個推理路徑后,自一致性方法通過邊際化這些推理路徑來匯總最終的答案。即選擇最一致的答案作為最終答案。圖中顯示,答案“18美元”在多個路徑中出現,因此被選擇為最終答案。

通過這種方法,自一致性方法可以更好地處理復雜的推理任務,提供更準確的答案。通過生成多樣化的推理路徑并選擇最一致的答案,這種方法克服了貪心解碼的局限性,提高了語言模型的推理能力和準確性。)

自我一致性遠比那些需要訓練額外驗證器(Cobbe等人,2021)或給定額外人工注釋以改進生成質量的重排序訓練方法(Thoppilan等人,2022)更為簡單。相反,自我一致性完全是無監(jiān)督的,可即插即用與預訓練語言模型配合,無需額外的人工注釋,也不需要任何額外訓練、輔助模型或微調。自我一致性也不同于典型的集成方法,后者需要訓練多個模型并將每個模型的輸出匯總,自我一致性更像是在單一語言模型之上的“自集成”。

我們在四種不同規(guī)模的語言模型上,包括公開的UL2-20B(Tay等人,2022)和GPT-3-175B(Brown等人,2020),以及兩個密集激活的解碼器型語言模型LaMDA-137B(Thoppilan等人,2022)和PaLM-540B(Chowdhery等人,2022),評估了自我一致性在廣泛的算術和常識推理任務上的表現。在所有四個語言模型上,自我一致性在所有任務上都顯著超越了鏈式思考提示。特別是,當與PaLM-540B或GPT-3結合使用時,自我一致性在算術推理任務上達到了新的最佳水平,包括GSM8K(Cobbe等人,2021)(絕對準確率提高17.9%)、SVAMP(Patel等人,2021)(+11.0%)、AQuA(Ling等人,2017)(+12.2%),以及在諸如StrategyQA(Geva等人,2021)(+6.4%)和ARC挑戰(zhàn)(Clark等人,2018)(+3.9%)等常識推理任務上。在額外的實驗中,我們展示自我一致性能在添加鏈式思考可能損害性能的標準提示相比時,穩(wěn)健地提升NLP任務的性能(Ye & Durrett, 2022)。我們也證明自我一致性顯著優(yōu)于采樣排序、波束搜索、基于集成的方法,并且對采樣策略和不完美提示具有魯棒性。

2、自一致性在多樣化推理路徑中的應用

人類思考問題的方式各不相同,這一點非常明顯。在需要深思熟慮的任務中,往往會有多種解決問題的方法。我們提出,通過從語言模型的解碼器中進行采樣,可以模擬這種過程。例如,如圖1所示,模型可以對一個數學問題生成多個合理的回答,并且都得出正確的答案(輸出1和輸出3)。由于語言模型不是完美的推理工具,模型可能會產生錯誤的推理路徑或在某個推理步驟中犯錯(如輸出2),但這樣的解決方案較少能得出相同的答案。我們假設,正確的推理過程,即使是多樣化的,最終答案的一致性往往高于錯誤的過程。

我們利用這一直覺,提出了以下自一致性方法。首先,用一組手動編寫的鏈式思維示例(Wei等,2022)對語言模型進行提示。接下來,從語言模型的解碼器中采樣,生成一組多樣化的候選推理路徑。自一致性方法兼容大多數現有的采樣算法,包括溫度采樣(Ackley等,1985;Ficler & Goldberg,2017)、top-k采樣(Fan等,2018;Holtzman等,2018;Radford等,2019)和核采樣(Holtzman等,2020)。最后,通過邊際化采樣的推理路徑,選擇生成答案中最一致的作為最終答案。

更詳細地說,假設生成的答案ai 來自固定答案集ai∈ A,其中 i = 1, . . . , m 標識從解碼器中采樣的m 個候選輸出。給定一個提示和一個問題,自一致性方法引入一個額外的潛在變量 ri,它是表示第i個輸出中推理路徑的一系列標記,然后結合生成 (ri, ai),其中 ri→ai,即生成推理路徑ri 是可選的,僅用于得出最終答案ai。例如,考慮圖1中的輸出3:前幾句話“她吃了3個蛋做早餐……所以她有9個蛋*2美元=18美元。”構成了 ri,而最后一句話中的答案18,即“答案是18美元”,則解析為 ai。

在從模型的解碼器中采樣多個(ri, ai)后,自一致性方法通過對ri進行邊際化,采取多數投票來選擇答案,即 maxaΣmi=11(ai = a),或我們定義為最終答案集中最“一致”的答案。

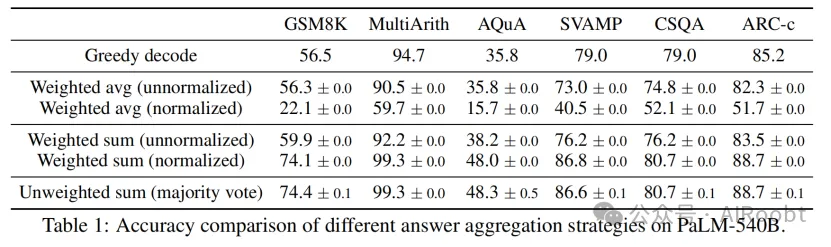

在表1中,我們展示了在一組推理任務上使用不同答案聚合策略的測試準確率。除了多數投票外,在聚合答案時,也可以通過 P(ri, ai| 提示, 問題) 對每個(ri, ai)進行加權。注意,為計算P(ri, ai| 提示, 問題),我們可以采取模型生成 (ri, ai) 給定 (提示, 問題) 的非歸一化概率,或者我們可以通過輸出長度進行歸一化的條件概率(Brown等,2020),即

其中 log P(tk | 提示, 問題, t1, ..., tk-1)是在先前標記的條件下生成第k 個標記 tk的對數概率,K 是 (ri, ai)中標記的總數。

在表1中,我們展示了直接對ai進行多數投票的“未加權總和”方法與使用“歸一化加權總和”進行聚合的準確率非常相似。我們仔細觀察了模型的輸出概率,發(fā)現這是因為對于每個 (ri, ai),歸一化的條件概率 P(ri, ai| 提示, 問題)非常接近,即語言模型認為這些生成是“同樣可能的”。此外,當聚合答案時,表1中的結果顯示“歸一化”加權總和(即公式1)的準確率遠高于未歸一化的對應方法。為了完整性,表1中還報告了“加權平均”方法的結果,即每個答案 a 得到的分數為其加權總和除以Σmi=11(ai = a),這導致了更差的性能。

自一致性探索了開放式文本生成和具有固定答案的最佳文本生成之間的有趣空間。推理任務通常有固定答案,這就是為什么研究人員通常考慮貪心解碼方法(Radford等,2019;Wei等,2022;Chowdhery等,2022)。然而,我們發(fā)現即使期望的答案是固定的,引入推理過程中的多樣性也非常有益;因此我們利用采樣,作為常用于開放式文本生成的方法(Radford等,2019;Brown等,2020;Thoppilan等,2022),來實現這一目標。需要注意的是,自一致性只能應用于最終答案來自固定答案集的問題,但原則上,如果能夠定義多個生成之間一致性的良好度量,這種方法可以擴展到開放文本生成問題,例如兩個答案是否一致或矛盾。

3、實驗(略)

4、相關工作

語言模型中的推理。眾所周知,語言模型在第2類任務上存在困難,例如算術、邏輯和常識推理(Evans,2010)。以前的工作主要集中在改進推理的專業(yè)方法上(Andor等人,2019;Ran等人,2019;Geva等人,2020;Pi?ekos等人,2021)。與以往的工作相比,自我一致性適用于廣泛的推理任務,無需額外的監(jiān)督或微調,同時仍然顯著提高了Wei等人(2022)提出的思維鏈提示方法的性能。

語言模型中的采樣和重新排序。在文獻中提出了多種語言模型的解碼策略,例如溫度采樣(Ackley等人,1985;Ficler和Goldberg,2017)、top-k采樣(Fan等人,2018;Holtzman等人,2018;Radford等人,2019)、核心采樣(Holtzman等人,2020)、最小貝葉斯風險解碼(Eikema和Aziz,2020;Shi等人,2022)和典型解碼(Meister等人,2022)。其他工作試圖在解碼過程中明確促進多樣性(Batra等人,2012;Li等人,2016;Vijayakumar等人,2018)。重新排序是提高語言模型生成質量的另一種常用方法(Adiwardana等人,2020;Shen等人,2021)。Thoppilan等人(2022)收集額外的人類注釋來訓練一個重新排序器進行響應過濾。Cobbe等人(2021)訓練一個“驗證器”對生成的解決方案進行重新排序,與僅僅微調語言模型相比,這在數學任務上的解決率有了顯著提高。Elazar等人(2021)通過擴展預訓練增加額外的一致性損失來提高事實知識提取的一致性。所有這些方法都需要額外訓練一個重新排序器或收集額外的人類注釋,而自我一致性不需要額外的訓練、微調或額外的數據收集。

提取推理路徑。一些以前的工作考慮了識別推理路徑的任務特定方法,例如構建語義圖(Xu等人,2021a)、學習一個RNN在Wikipedia圖上檢索推理路徑(Asai等人,2020)、在數學問題上用人類注釋的推理路徑進行微調(Cobbe等人,2021)或用基于啟發(fā)式的偽推理路徑訓練提取器(Chen等人,2019)。最近,推理過程中的多樣性的重要性已經被注意到,但只通過任務特定的訓練來利用,要么通過額外的QA模型在提取的推理路徑上(Chen等人,2019),要么通過在常識知識圖中引入潛在變量(Yu等人,2022)。與這些方法相比,自我一致性要簡單得多,不需要額外的訓練。我們提出的方法是簡單地通過從解碼器中采樣將生成推理路徑和最終答案結合起來,使用聚合來恢復最一致的答案,而不需要額外的模塊。

語言模型中的一致性。一些以前的工作表明,語言模型在對話(Adiwardana等人,2020)、解釋生成(Camburu等人,2020)和事實知識提取(Elazar等人,2021)中可能會有不一致性。Welleck等人(2020)使用“一致性”來指代在遞歸語言模型中生成無限長度序列。Nye等人(2021)通過添加一個受System 2啟發(fā)的邏輯推理模塊來提高System 1模型樣本的邏輯一致性。在本文中,我們關注一個稍微不同概念的“一致性”,即利用多樣化推理路徑中的答案一致性來提高準確性。

5、結論與討論

我們介紹了一種稱為自我一致性的簡單而有效的方法,并觀察到它顯著提高了在一系列算術和常識推理任務中的準確性,涵蓋了四種不同規(guī)模的大型語言模型。除了準確性的提升,自我一致性在執(zhí)行推理任務時收集理由、提供不確定性估計以及改善語言模型輸出的校準時也具有用處。

自我一致性的一個限制是它會增加計算成本。在實踐中,人們可以嘗試少量路徑(例如,5或10條)作為一個起點,在不增加太多成本的情況下實現大部分收益,因為在大多數情況下性能會迅速飽和(見圖2)。作為未來工作的一部分,可以使用自我一致性生成更好的監(jiān)督數據來微調模型,以便模型在微調后的單次推理運行中給出更準確的預測。此外,我們觀察到語言模型有時可能會生成不正確或無意義的推理路徑(例如,表4中的StrategyQA示例,兩個人口數字并不完全正確),需要進一步的工作來更好地基礎化模型的理由生成。

Wang X, Wei J, Schuurmans D, et al. Self-consistency improves chain of thought reasoning in language models[J]. arXiv preprint arXiv:2203.11171, 2022.

Google Research, Brain Team

本文轉載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/RTQP54E9m2_HXVmlDVVrxA??