微軟Phi-4-Mini技術報告:Phi-4-Mini如何以小博大 精華

想象一下,如今的AI世界里,大模型如GPT-4、Claude動輒上百億參數,能力驚人卻耗資巨大,像是一輛輛豪華跑車,雖快卻燒油無數。普通人或中小企業想用AI解決問題時,常常被高昂的成本擋在門外。可就在這時候,微軟扔出了一顆“重磅炸彈”——Phi-4-Mini和Phi-4-Multimodal。這兩個小巧的模型,參數量僅3.8億,卻在語言、數學、編碼甚至多模態任務上表現出色,堪稱“小身軀,大能量”。這不禁讓人好奇:微軟是怎么讓“小個子”打敗“大塊頭”的?它能給論文帶來什么驚喜?今天,論文就來拆開這篇論文,聊聊Phi-4-Mini的秘密。

一、小模型逆襲:Phi-4-Mini解決了什么難題?

在AI領域,普遍認為模型越大越強,但大模型的訓練和運行成本高得嚇人,尤其是在手機、邊緣設備上幾乎沒法用。Phi-4-Mini要解決的核心問題是如何用更少的參數,實現媲美甚至超越大模型的性能。論文里提到,Phi-4-Mini只有3.8億參數,卻能在數學推理、編程任務上匹配參數量兩倍的模型,甚至在某些場景下挑戰像DeepSeek這樣的7億、8億參數對手。這就像一個輕量級拳手,竟然能和重量級選手過招還不落下風。

更厲害的是,Phi-4-Multimodal把能力擴展到了多模態,能同時處理文字、圖片和語音。比如,你給它一張圖和一段語音,它能直接告訴你圖里是什么,還能把語音內容總結出來。這種多才多藝的設計,瞄準的是未來AI的趨勢——用一個模型搞定多種任務,而不是像現在這樣,每種任務都得單獨訓練一個大模型。微軟的野心很明顯:讓AI更輕、更快、更全能。

二、技術揭秘:微軟是怎么做到的?

1.數據精挑細選,像篩金子一樣訓練模型

Phi-4-Mini的成功離不開高質量的數據。微軟沒用海量雜亂的數據轟炸模型,而是像淘金一樣,精心挑選了優質的網絡數據和合成數據,尤其在數學和編碼上加碼。比如,他們用專門的數學題和代碼數據集,讓模型學會“深度思考”,而不是只會背答案。這種“少而精”的策略,讓Phi-4-Mini在關鍵任務上效率爆棚。

(1)預訓練數據:與Phi-3.5-Mini相比,論文從以下幾個關鍵方面改進了預訓練數據的質量:

1)更好的數據過濾:通過使用經過增強的質量分類器,該分類器在由更干凈的正負樣本組成的更大規模精選數據集上訓練,論文最終在多種語言的各個方面(如有毒、晦澀、科學等)實現了更好的過濾質量,從而形成了一個更全面、更可控的過濾策略。

2)更好的數據和編程數據:對于數學和編程數據,論文使用特定的基于指令的數學和編程數據集增強了原始數據。這種增強在數學、編程和推理方面取得了有效的結果。

3)更好的合成數據:論文將Phi-4合成數據[AAB+ 24]以相同的處理和去污染方式納入了模型訓練。

4)更好的數據混合:借助更好的分類器,論文通過消融實驗重新調整了數據混合。特別是,論文增加了推理數據的比例。這為模型質量帶來了提升。

通過這些技術,論文構建了5萬億的預訓練數據語料庫,相比Phi-3.5-Mini,數據規模更大、質量更高。

(2)后訓練數據:與Phi-3.5-Mini相比,Phi-4-Mini包含了顯著更大、更多樣的函數調用和總結數據。此外,論文還合成了大量的指令跟隨數據,以增強模型的指令跟隨能力。

在編程方面,論文整合了大量代碼補全數據,包括要求模型在現有代碼片段中間生成缺失代碼的任務。這挑戰模型理解需求和現有上下文,從而帶來顯著的性能提升。

(3)推理訓練數據:論文從更大的推理模型生成大量合成的思維鏈(Chain-of-Thought, CoT)數據,覆蓋不同領域和難度級別。在采樣過程中,論文同時采用基于規則和基于模型的拒絕方法來丟棄不正確的生成結果,并將其反饋重新采樣。

此外,論文將正確采樣的答案標記為"受偏好"的生成,將錯誤的答案標記為"不受偏好",并創建DPO數據。這些數據僅用于實驗性推理模型,尚未應用于正式發布的Phi-4-Mini檢查點。

(4)視覺-語言訓練數據:Phi-4-Multimodal模型的預訓練階段涉及豐富多樣的數據集,包括交錯的圖像-文本文檔、圖像-文本對、圖像基礎數據、來自PDF和真實圖像的OCR合成數據集,以及圖表理解的合成數據集。

在此階段,模型的主要重點是預測下一個標記,僅專注于文本標記,忽略與圖像標記相關的任何損失。預訓練過程共涉及0.5T標記,結合了視覺和文本元素。另外,最大圖像分辨率限制在1344x1344,因為大多數訓練圖像尺寸小于此大小。

(5)視覺-語音訓練數據:對于視覺-語音數據,Phi-4-Multimodal模型在多樣的合成視覺-語音數據上進行訓練,覆蓋單幀和多幀場景。具體而言,我們重用視覺-語言SFT數據的子集,并使用內部文本到語音(TTS)引擎將用戶查詢從文本轉換為音頻。這個子集經過仔細選擇,以避免某些不適合朗讀的數據集。

還通過使用內部自動語音識別(ASR)模型轉錄音頻,并計算原始文本和轉錄之間的詞錯誤率(WER)來衡量合成語音的質量。我們最終的視覺-語音數據是通過基于WER的過濾生成的,以確保質量。

(6)語音和音頻訓練數據:語音/音頻功能的訓練數據可分為兩類:

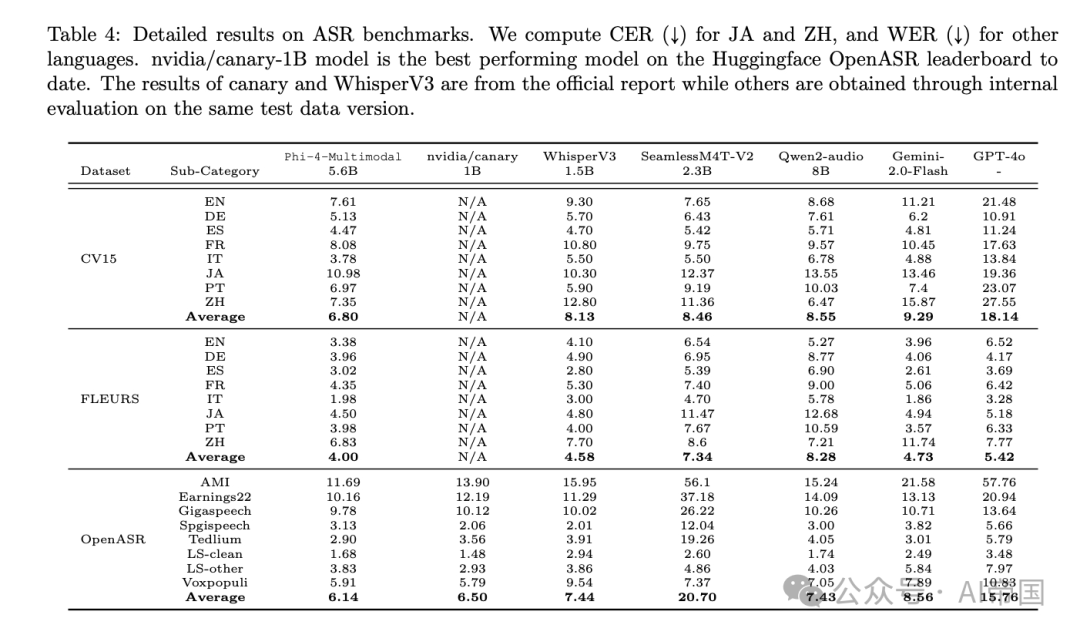

1)帶有ASR轉錄的預訓練數據,以在語音和文本模態之間提供強大的對齊;

2)后訓練數據,用于解鎖涉及語音/音頻模態的Phi-4-Multimodal的指令跟隨能力。

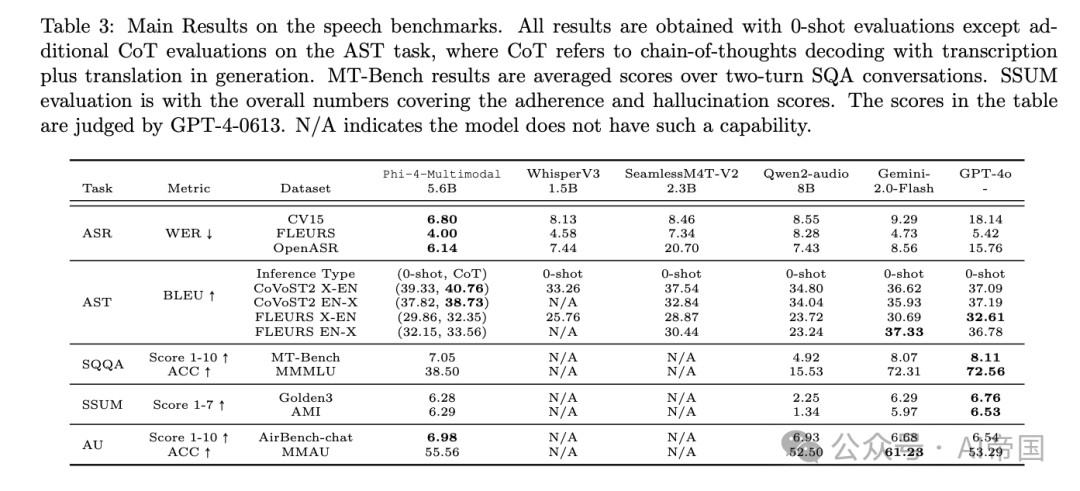

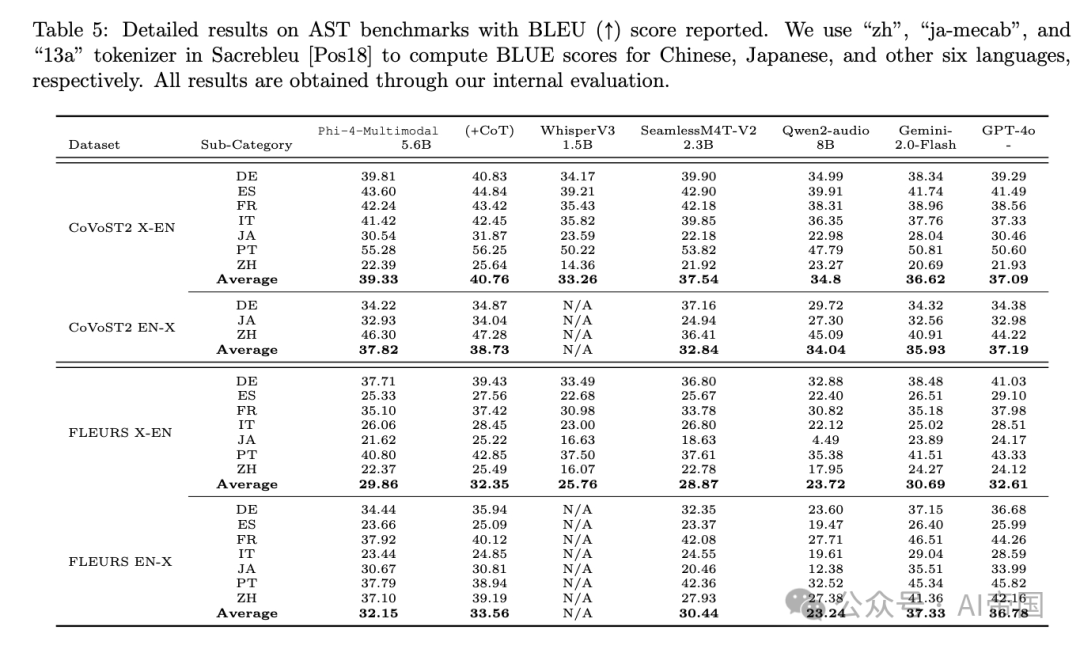

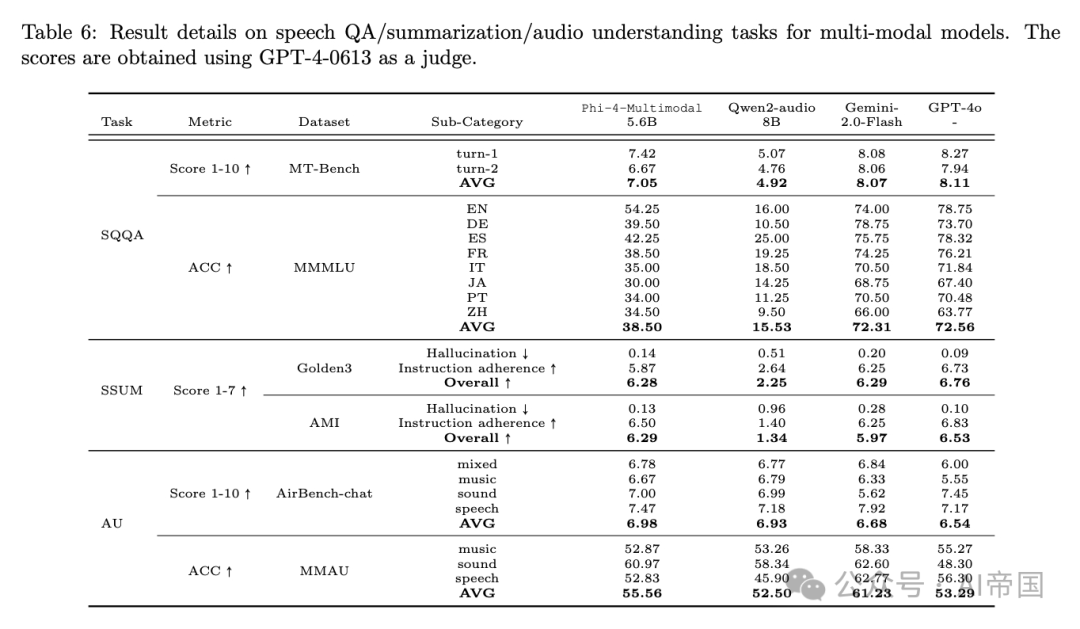

后訓練數據涵蓋多種任務,包括自動語音識別(ASR)、自動語音翻譯(AST)、語音問答(SQA)、口語查詢問答(SQQA)、語音總結(SSUM)和音頻理解(AU)。

2. 架構升級:Group Query Attention的巧妙優化

技術上,Phi-4-Mini用了一種叫Group Query Attention(GQA)的機制。簡單說,這就像給模型裝了個“省油引擎”,通過優化內存使用(KV cache),讓它在處理長文本時更快、更省資源。具體來說,它把查詢頭設為24個,鍵值頭只有8個,內存消耗降到原來的三分之一。這意味著Phi-4-Mini能輕松處理長達12.8萬字符的上下文,比很多大模型還靈活。

3. LoRA混合:多模態的“魔法插件”

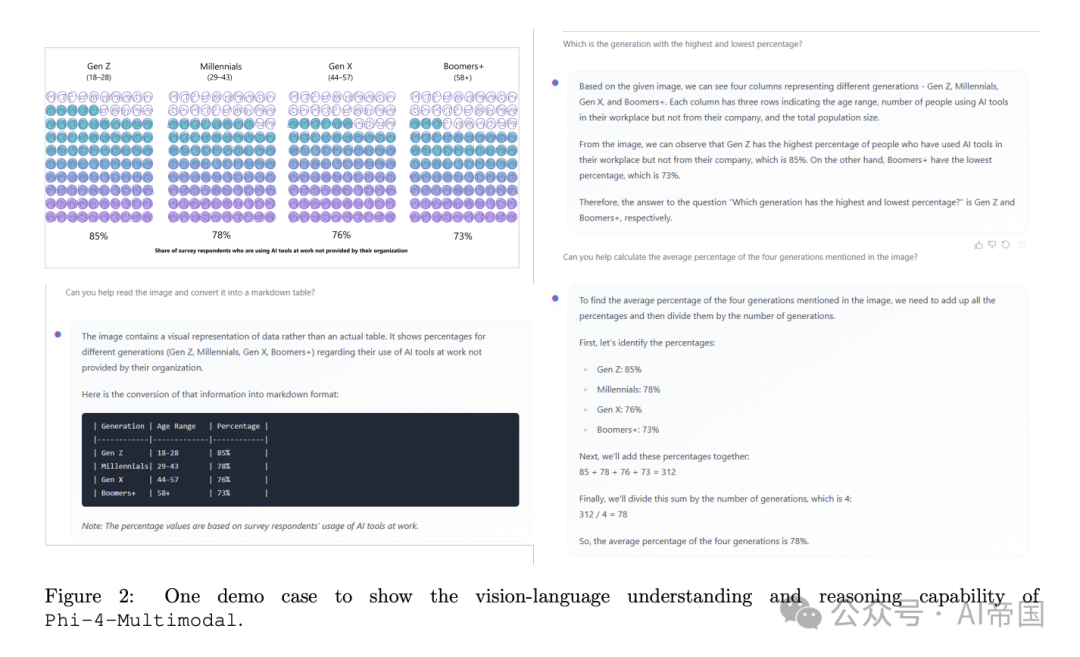

Phi-4-Multimodal更牛,它用了一種“LoRA混合”技術。LoRA就像模型的“插件”,不用動基礎語言模型,只加裝特定模塊就能處理圖片、語音。比如,想讓模型看圖說話,就插上視覺LoRA;想聽語音做總結,就用語音LoRA。這種設計不僅靈活,還避免了不同任務互相干擾。訓練時,微軟分階段進行:先練語言,再加視覺,最后融合語音,層層遞進,確保每個能力都扎實。

三、效果如何?小模型真能干大事!

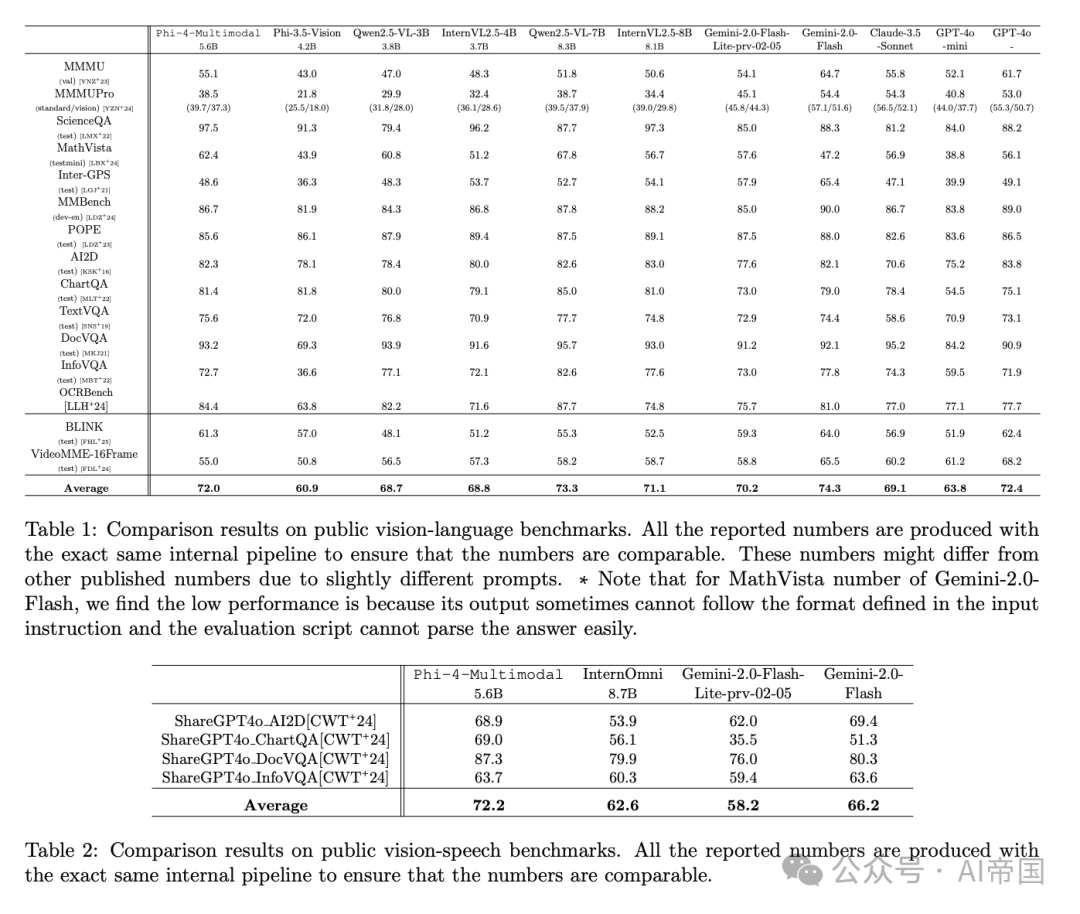

結果讓人眼前一亮。Phi-4-Mini在數學和編碼任務上,能和參數量兩倍的模型打平手,甚至在推理能力上比肩更大規模的DeepSeek模型。Phi-4-Multimodal更夸張,它在語音識別(OpenASR排行榜第一)、圖像描述、視頻總結等任務上吊打同級別對手,甚至在某些測試中超過GPT-4o和Gemini。比如,它能把30分鐘的語音總結成幾句話,還幾乎沒錯漏;給它張科學圖表,它能瞬間讀懂并回答問題,準確率讓大模型都汗顏。

圖片

圖片

更重要的是,這兩個模型體積小巧,適合在普通設備上跑。想象一下,未來你的手機就能裝個Phi-4-Multimodal,拍照問問題、語音記筆記,全都不用聯網。這不只是技術突破,更是AI普及的希望。

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

圖片

四、未來展望:AI的新方向在哪里?

Phi-4-Mini和Phi-4-Multimodal告訴論文,AI不一定非要“大而全”,小而精可能是未來。微軟用事實證明,通過聰明的數據選擇和架構設計,小模型也能挑大梁。這對普通用戶和開發者來說是福音:成本低了,門檻降了,AI可以走進更多人的生活。從智能助手到教育工具,再到醫療輔助,Phi-4系列的潛力才剛開始顯現。它還挑戰了一個常識——“越大越好”,用實力證明“濃縮才是精華”。

想知道它有多強?拿個場景感受下:你拍張數學作業的照片,錄段語音問“怎么解”,Phi-4-Multimodal幾秒鐘就給你答案,還順便把解題思路講得清清楚楚。這樣的AI,誰不想試試呢?

論文標題:Phi-4-Mini Technical Report: Compact yet Powerful Multimodal Language Models via Mixture-of-LoRAs

論文鏈接:???https://arxiv.org/abs/2503.01743??

本文轉載自AI帝國,作者:無影寺