ACM MM 2024 | 比SDXL和DALL-E·3更引人入勝!ReCorD:交互場景生成最新SOTA! 精華

文章鏈接:https://arxiv.org/pdf/2407.17911

git鏈接:https://alberthkyhky.github.io/ReCorD/

亮點直擊:

- 引入了一種新穎的推理框架,將潛在擴散模型(LDM)與視覺語言模型(VLM)相結合,以克服生成逼真的人與物體互動(HOI)時面臨的挑戰,緩解了以往方法中的問題,例如大語言模型(LLM)對簡單文本提示的過度分析以及LDM中的訓練數據偏差。

- 為了提升人物形象描繪的準確性,在LDM中設計了一個校正機制,用于動態圖像調整,使得對生成圖像中人類互動的精確控制和精細化成為可能,從而顯著提高了描繪的準確性。

- 大量實驗表明,本文的免訓練方法ReCorD在創建引人入勝且逼真的HOI場景方面表現出色,優于其它SOTA方法。

擴散模型通過利用自然語言引導多媒體內容的創作,徹底改變了圖像生成技術。盡管在這些生成模型上取得了顯著進展,但在描繪人類與物體的詳細互動方面仍存在挑戰,特別是在姿勢和物體放置準確性方面。

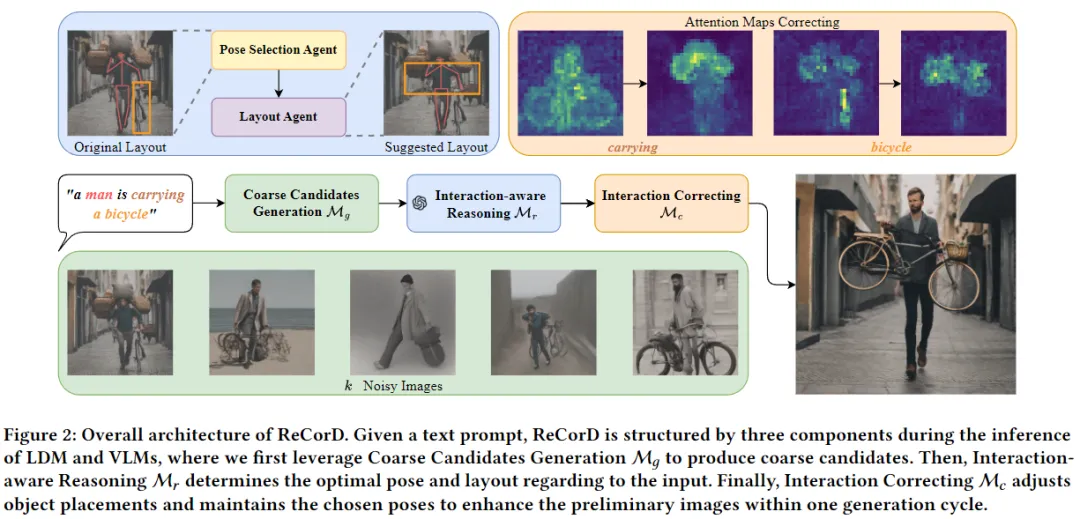

本文引入了一種名為推理和校正擴散(ReCorD)的免訓練方法來解決這些挑戰。該模型結合了潛在擴散模型和視覺語言模型,以優化生成過程,確保精確描繪人與物體的互動(HOI)。提出了一個互動感知推理模塊來改進互動的解釋,并引入一個互動校正模塊,以精細化輸出圖像,達到更精確的HOI生成效果。通過精心的姿勢選擇和物體定位過程,ReCorD在生成圖像的保真度方面表現出色,同時有效減少了計算需求。在三個基準上進行了全面的實驗,展示了在解決文本到圖像生成任務上的顯著進展,ReCorD通過在HOI分類評分、FID和動詞CLIP評分上的優越表現,展示了其精確渲染復雜互動的能力,優于現有方法。

方法

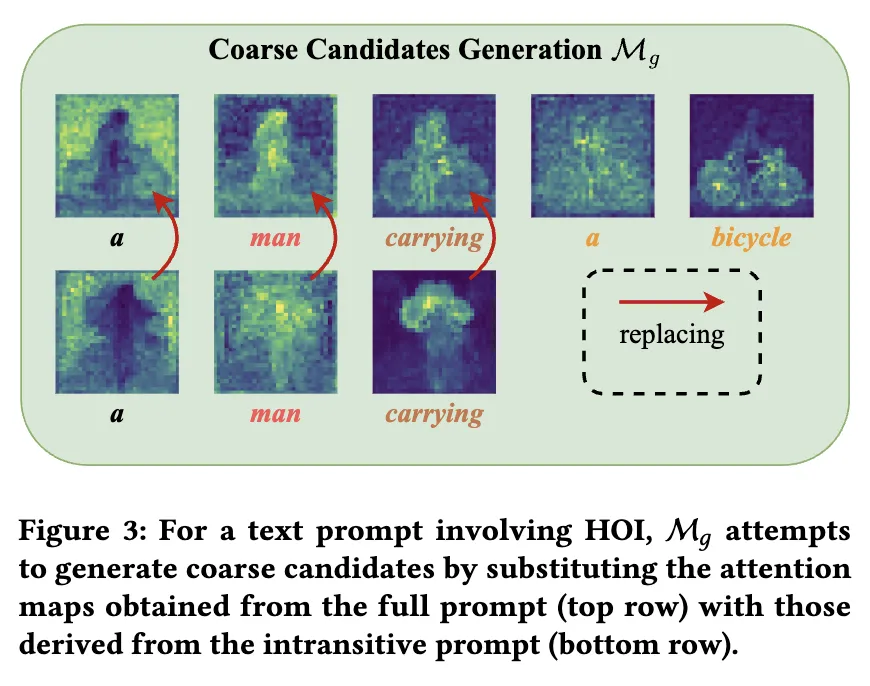

粗略候選生成模塊

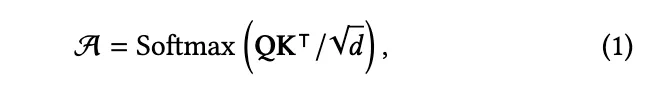

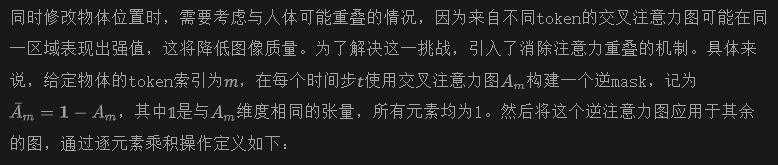

其中,??表示文本標記的索引。理想情況下,如果文本tokens存在于不及物提示中,會接受這些注意力圖。

自注意力圖操控。與交叉注意力圖不同,自注意力圖缺乏直接的tokens關聯,但仍然會影響生成圖像的空間布局和外觀。因此,在去噪步驟?? >??后,同樣對潛在表示的自注意力圖進行操控,以獲得,其中??是一個預定義參數,確保可以有效生成來自原始token ??(??)的場景和物體。

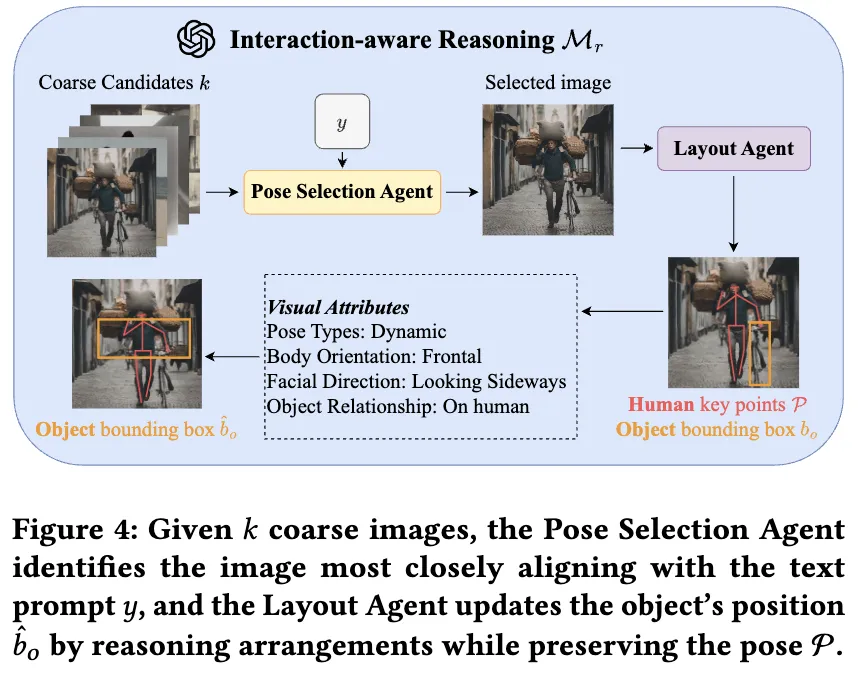

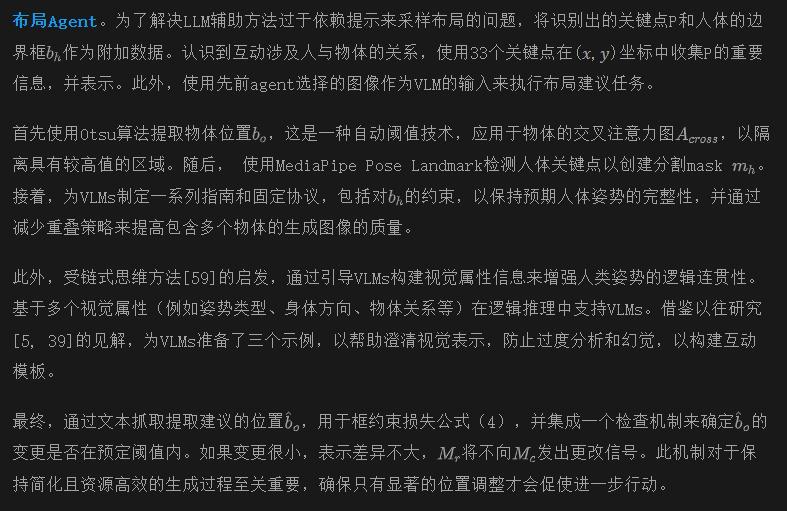

互動感知推理模塊

姿勢選擇Agent。由于姿勢在HOI生成中具有重要特征,首先結合一個agent來選擇與提示條件一致的適當姿勢。姿勢選擇agent將初始提示??與先前生成的候選相結合,以創建姿勢模板。利用VLM的視覺理解能力,該agent在識別與??對應的精確姿勢方面表現出色,增強了模型對視覺數據的解釋能力,而不僅僅依賴于LLM中的文本認知。這一步驟確保了從LDMs初始獲得的姿勢信息在后續階段得到精細化處理。

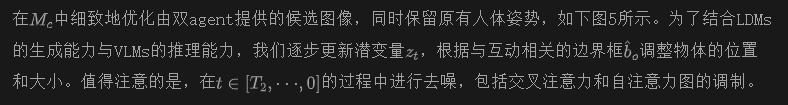

互動校正模塊

通過公式(3),可以在更新物體位置時減輕人與物體之間的注意力重疊問題,確保成功生成更新后的物體。

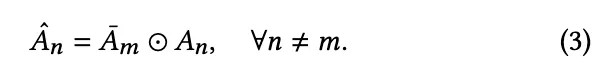

條件空間約束 由于ReCorD是免訓練的,并且不涉及用于知識轉移的額外可學習網絡,采用框約束來規范去噪器,其公式如下:

實驗

實驗設置

數據集。鑒于缺乏專門為HOI生成設計的標準基準,通過從兩個已建立的HOI檢測數據集中提取HOI三元組來評估我們方法的有效性,即HICO-DET和VCOCO,以形成輸入文本提示。HICO-DET包含600個三元組,涵蓋80個物體類別和117個動詞類別,而VCOCO包含228個三元組,跨越80個物體類別和29個動詞類型。為了全面評估,結合了T2I-CompBench中的非空間關系類別,該類別包含875個互動術語。選擇T2I-CompBench中僅涉及HOI的提示。為了增強多樣性,對從數據集中提取的每個動詞和物體對應用隨機主體增強以形成輸入提示。因此,實驗在三個數據集上進行:HICO-DET,有7,650個HOI提示;VCOCO,提供2,550個提示;以及T2I-CompBench的非空間關系類別,增加465個提示。

Baselines。與九個表現強勁的模型的比較,

- T2I模型:Stable Diffusion (SD)、Attend-and-Excite (A&E)、SDXL和DALL-E 3。

- L2I模型:BoxDiff、MultiDiffusion和InteractDiffusion。

- LLM輔助的T2I模型:LayoutLLM-T2I和LMD。

使用了每個Baseline的官方實現和默認設置。對于L2I模型,除了文本提示外,還提供了來自HICO-DET和VCOCO數據集的實際邊界框數據。對于LLM輔助的方法,輸入布局完全由LLMs生成,而不是來自數據集。

質量結果

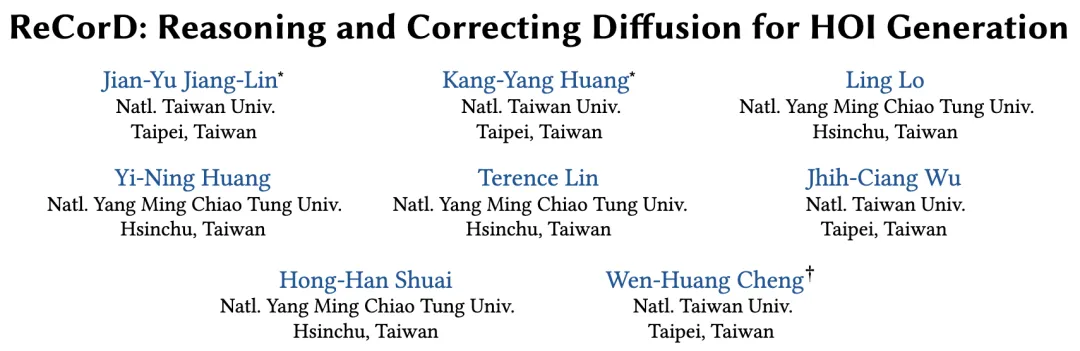

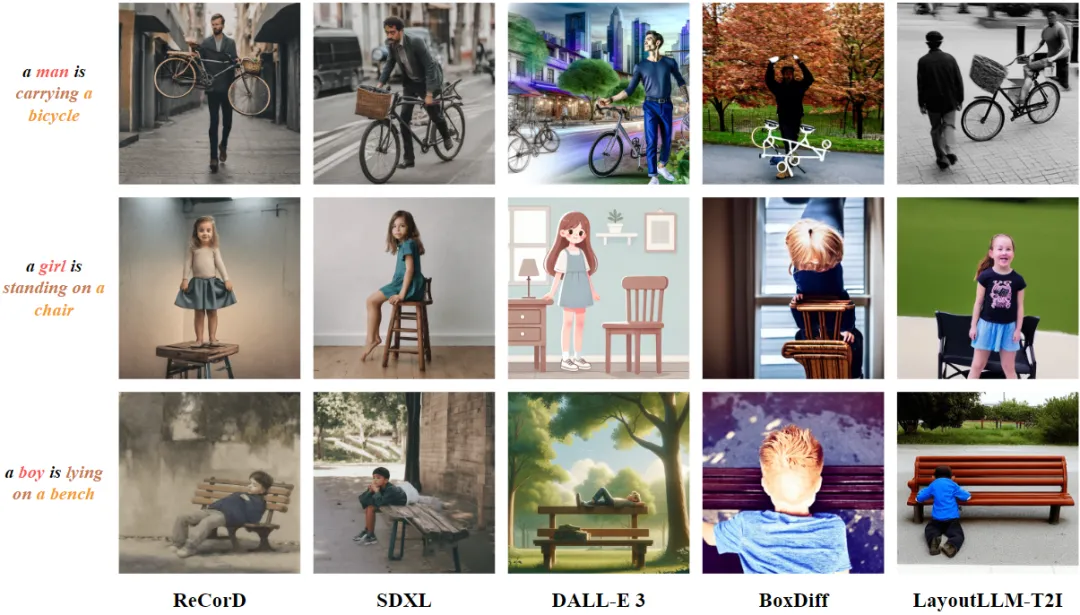

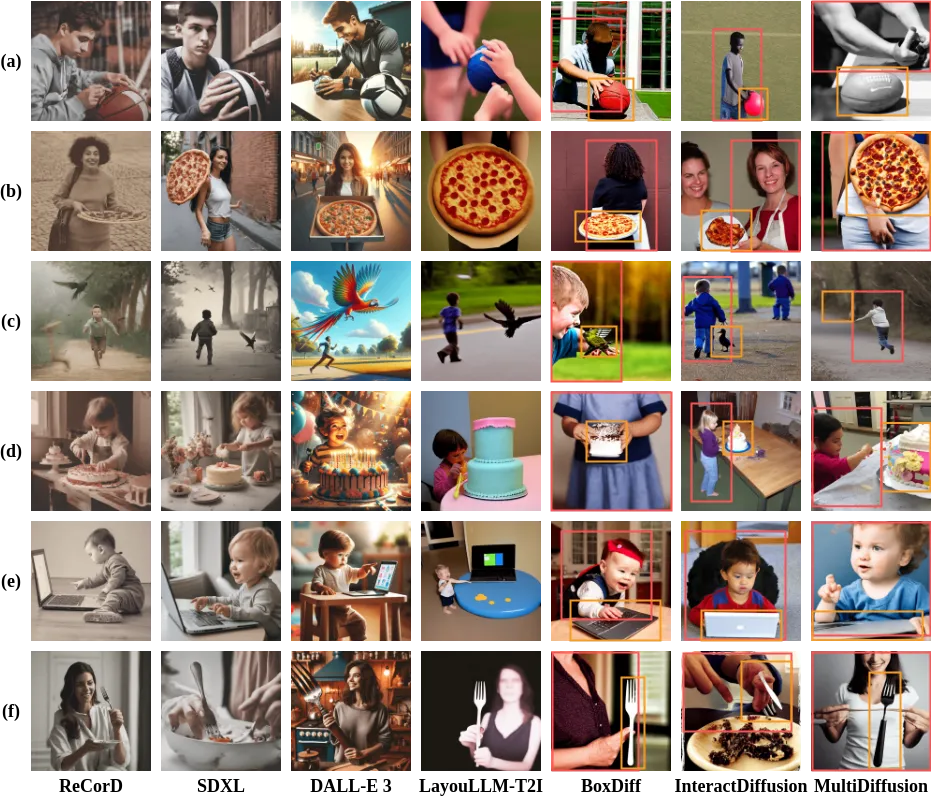

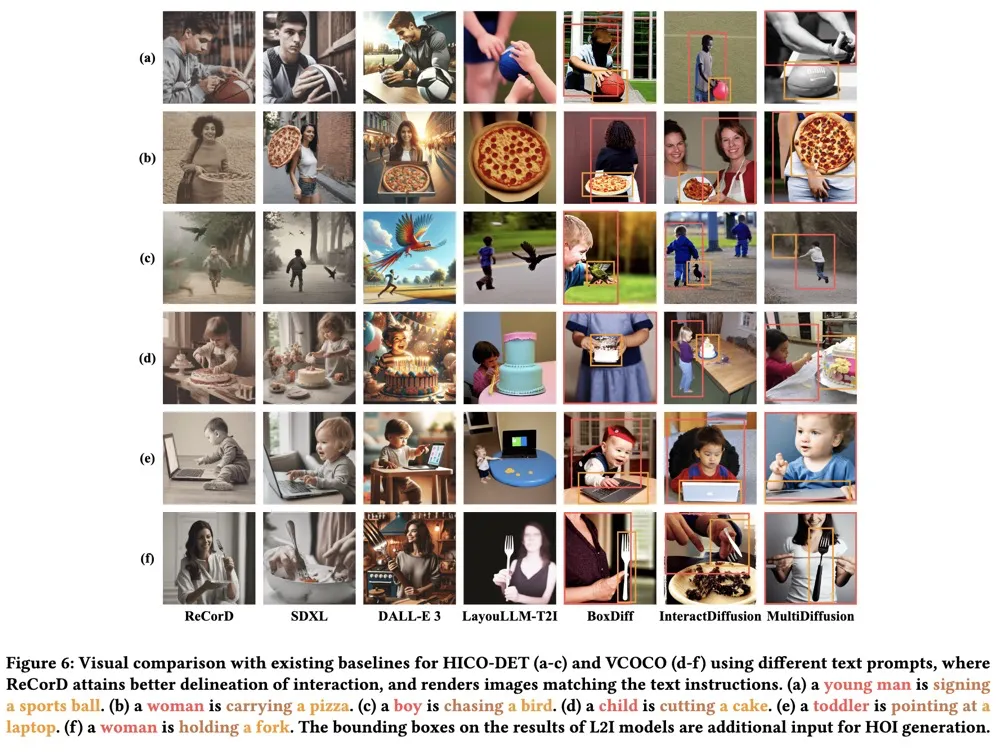

提供了一個定性比較來評估生成的HOI。如下圖6所示,ReCorD在生成符合文本提示的真實人體姿勢和物體位置方面優于其他最先進的方法,證明了其在高保真度描繪物體互動方面的能力。相比之下,Baseline方法往往會錯誤地放置物體或無法捕捉預期動作的細微差別。對于L2I模型,雖然BoxDiff在物體大小要求方面表現良好,但在準確描繪互動姿勢方面存在困難;InteractDiffusion即使經過微調,仍無法準確呈現細微動作,如(a)、(d)、(e)和(f)所示;MultiDiffusion盡力實現精確的物體定位,但生成的圖像大小各異。

另一方面,盡管LayoutLLM-T2I利用語言模型來改善布局生成,但通常會產生與人類不成比例的物體,這在(e)和(f)中尤為明顯。此外,MultiDiffusion定義了一種新的生成優化過程,但它嚴重依賴于預訓練模型的先驗知識。特別是,SDXL在動作姿勢(a)、(b)、(d)和(e)方面存在困難,而DALL-E 3在物體大小和位置(a)、(c)、(e)和(f)方面存在問題,顯示了ReCorD在超越現有解決方案的局限性方面的關鍵進展。

定量結果

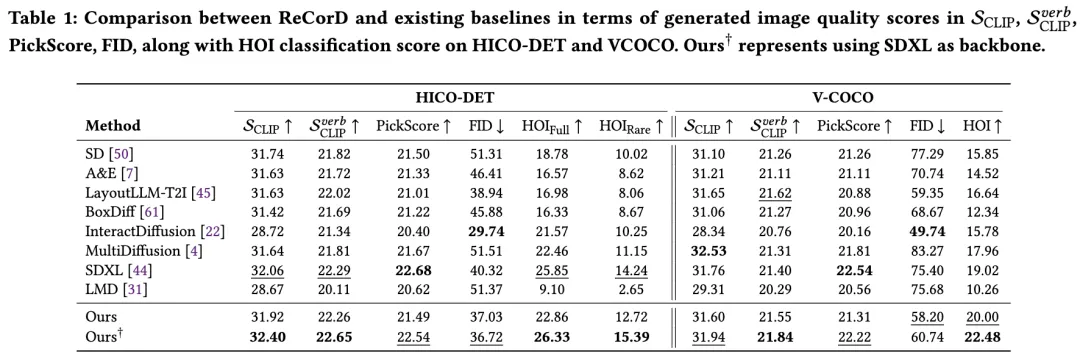

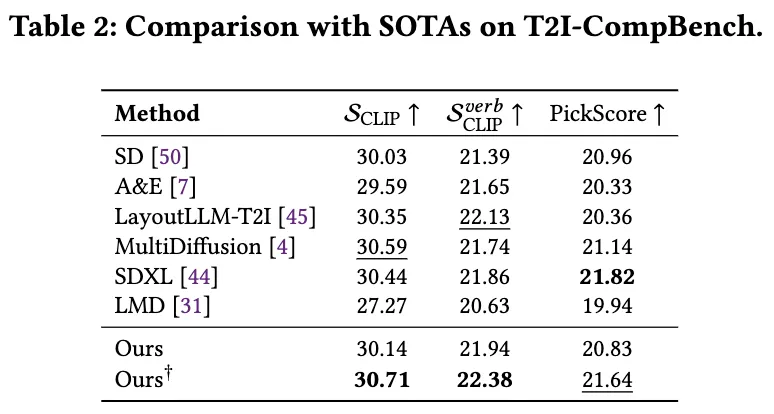

生成結果的定量比較,其中HICO-DET和VCOCO的數據提示見下表1,T2I-CompBench數據提示見表2。

圖像質量評估。根據PickScore評估,ReCorD模型與SDXL模型相當,并且優于其他方法。這表明,在將設計的互動校正模塊與SD模型結合后,ReCorD可以保持模型的圖像生成質量,同時實現更真實的互動。此外,當使用FID分數比較HICO-DET和VCOCO數據集中的生成圖像與真實圖像時,ReCorD優于其他方法,除了InteractDiffusion。值得注意的是,考慮到InteractDiffusion使用HICO-DET和COCO數據集進行了微調,ReCorD在無需訓練或額外HOI數據的情況下表現尤為突出。

互動準確性評估。上表1驗證了ReCorD顯著提高了HOI生成的準確性,顯示了在合成更精確HOI方面的效果。

生成速度和內存使用

生成一張圖像時,使用了Nvidia RTX 6000 GPU,當使用SD/SDXL作為骨干網時,內存消耗分別為14/42 GB,總推理時間為40.66/61.48秒。

比較布局建議的MLLM

評估了BLIP-2,通過隨機調整HICO-DET中真實邊界框的大小和位置。然而,BLIP-2常常誤解現實世界的分布,提供無關的答案和無效的mIoU分數。相比之下,GPT-4V達到了49.72%的mIoU分數,展示了優越的布局建議準確性,使其非常適合ReCorD。

GPT-4V的評估

根據T2I-CompBench對非空間關系的評估,ReCorD取得了98.16的GPT分數,優于SOTA T2I方法如SDXL(97.87)、MultiDiffusion(97.43)和LayoutLLM-T2I(96.75)。這證明了ReCorD生成與基礎模型知識對齊的準確HOI圖像的能力。

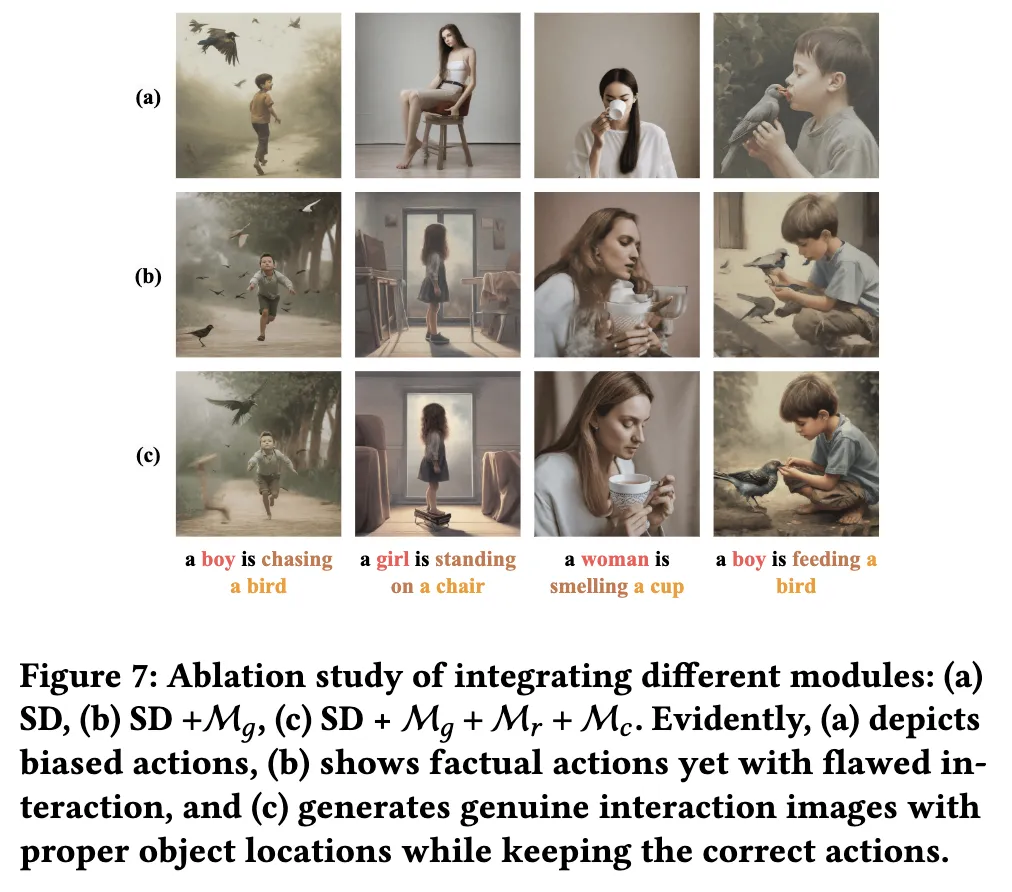

消融研究

結論

本文引入了專門為HOI(人-物體交互)圖像生成量身定制的ReCorD框架。該方法包括三個特定于交互的模塊,這些模塊相互協作。核心思想圍繞使用基于VLM(視覺語言模型)的agent和LDM(潛在擴散模型)來推理布局和修正注意力圖,以解決這一挑戰。大量實驗證明了本文方法在提高圖像準確性和語義忠實度方面的有效性,特別是在捕捉復雜交互概念方面,這是許多Baseline生成模型難以處理的。此外,通過各種協議和針對HOI生成的用戶調查量化了我們的改進,提供了有價值的見解,并為該領域未來的探索鋪平了道路。

本文轉自AI生成未來 ,作者:Jian-Yu Jiang-Lin等