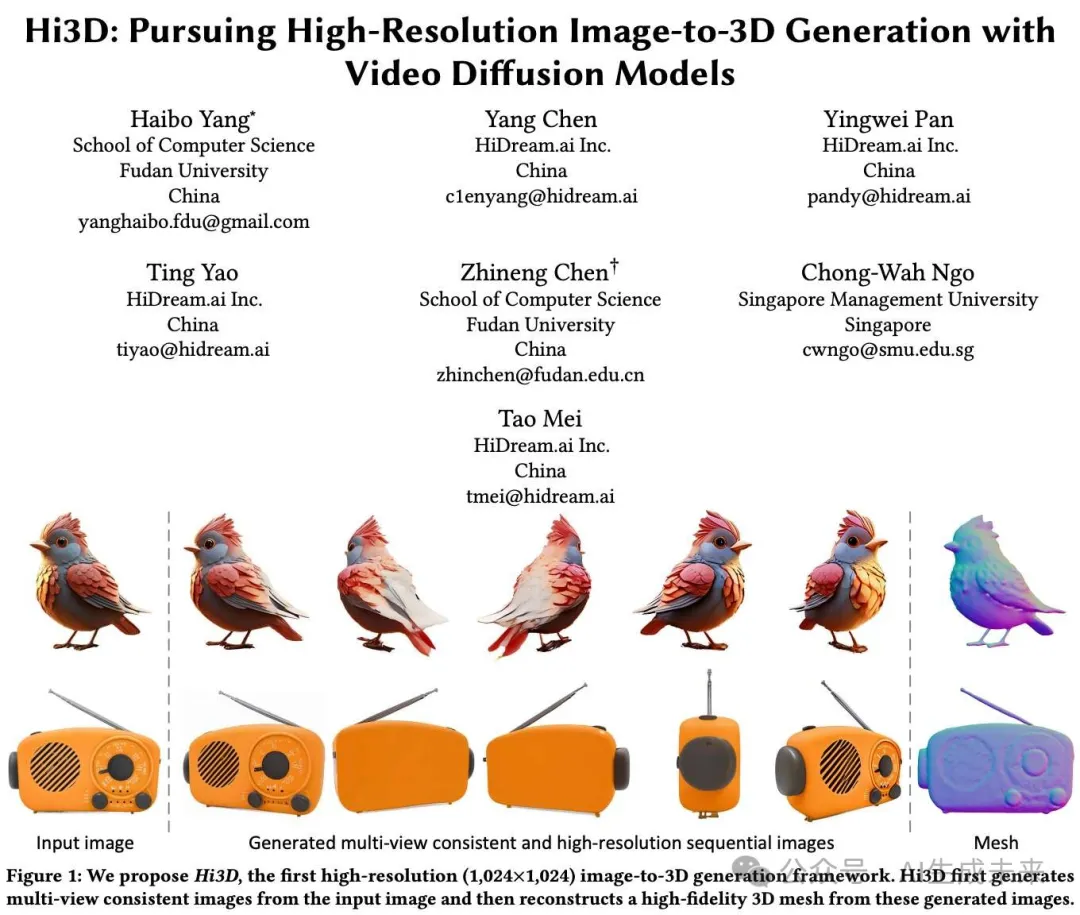

ACM MM24 | Hi3D: 3D生成領域再突破!新視角生成和高分辨率生成雙SOTA(復旦&智象等)

文章鏈接:https://arxiv.org/pdf/2409.07452

Github 鏈接:https://github.com/yanghb22-fdu/Hi3D-Official

亮點直擊

- 本文提出了高分辨率圖像到3D模型(Hi3D),這是一種基于視頻擴散的新范式,將單個圖像重新定義為多視角圖像,作為3D感知的序列圖像生成(即軌道視頻生成)。該方法深入探討了視頻擴散模型中潛在的時間一致性知識,這些知識在3D生成中能夠很好地推廣到多個視角之間的幾何一致性。

- 提出了基于視頻擴散模型的圖像到3D生成方法,通過利用視頻擴散模型的時間一致性來增強3D幾何一致性。

- 提出了高分辨率圖像到3D模型(Hi3D),在兩階段中生成高分辨率的3D網格和紋理:首先生成低分辨率軌道視頻,然后通過3D感知精化器生成高分辨率視頻。

- 在新視角合成和單視角重建任務中表現出色,實現了高質量的3D網格和紋理。

總結速覽

解決的問題

Hi3D框架旨在解決從高分辨率圖像生成3D模型時面臨的挑戰,特別是如何在多個視角之間保持幾何一致性和高質量的紋理細節。傳統方法往往在生成多視角圖像時缺乏時間一致性,導致生成的3D內容在視覺上不連貫。

提出的方案

Hi3D提出了一種基于視頻擴散的新范式,通過將單個圖像重新定義為多視角圖像,形成一個序列圖像生成的過程(即軌道視頻生成)。該方案利用3D感知先驗(如相機姿態條件)來增強預訓練的視頻擴散模型,從而生成低分辨率的多視角圖像。接著,使用學習到的3D感知視頻到視頻的細化器進一步提升這些圖像的分辨率和細節。

應用的技術

視頻擴散模型:用于生成多視角圖像,特別關注時間一致性。3D感知先驗:通過相機姿態條件增強模型的生成能力。3D高斯點云:用于進一步增強生成的多視角圖像,以便進行高保真網格重建。

達到的效果

實驗結果表明,Hi3D能夠生成具有高度詳細紋理的優越多視角一致圖像。大量關于新視圖合成和單視圖重建的實驗驗證了該方法在生成高保真3D模型方面的有效性,顯著提升了生成內容的幾何一致性和視覺質量。

方法

本文設計了一種新的高分辨率圖像到3D生成架構,稱為Hi3D,創新性地將視頻擴散模型整合到3D感知的360°序列圖像生成中(即軌道視頻生成)。 本文的出發點是利用視頻擴散模型中固有的時間一致性知識,以增強3D生成中的視角一致性。首先在本節中詳細闡述圖像到3D生成的問題表述,再詳細介紹Hi3D框架中兩階段視頻擴散范式的細節。

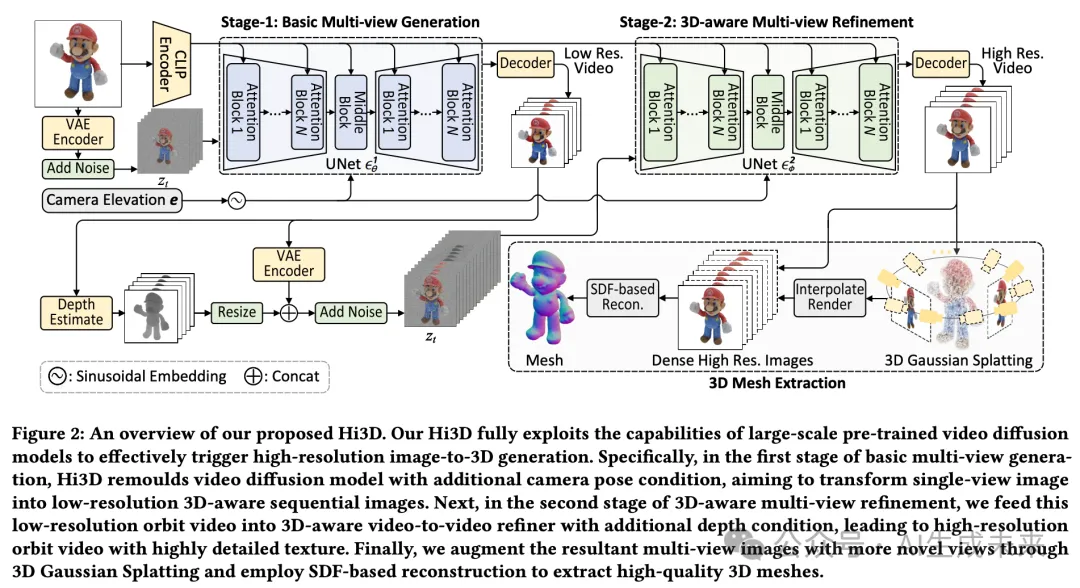

第一階段,本文重新構建了預訓練的圖像到視頻擴散模型,增加了相機姿態的條件,然后在3D數據上進行微調,以實現軌道視頻生成。在第二階段,本文通過3D感知的視頻到視頻細化器進一步提升多視角圖像的分辨率。最后,本文引入了一種新穎的3D重建 pipeline,從這些高分辨率的多視角圖像中提取高質量的3D網格。Hi3D的整體架構如下圖2所示。

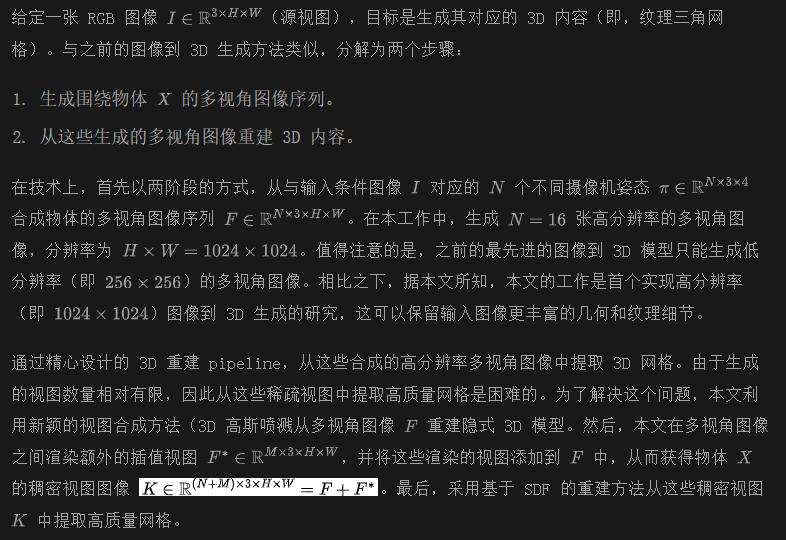

問題表述

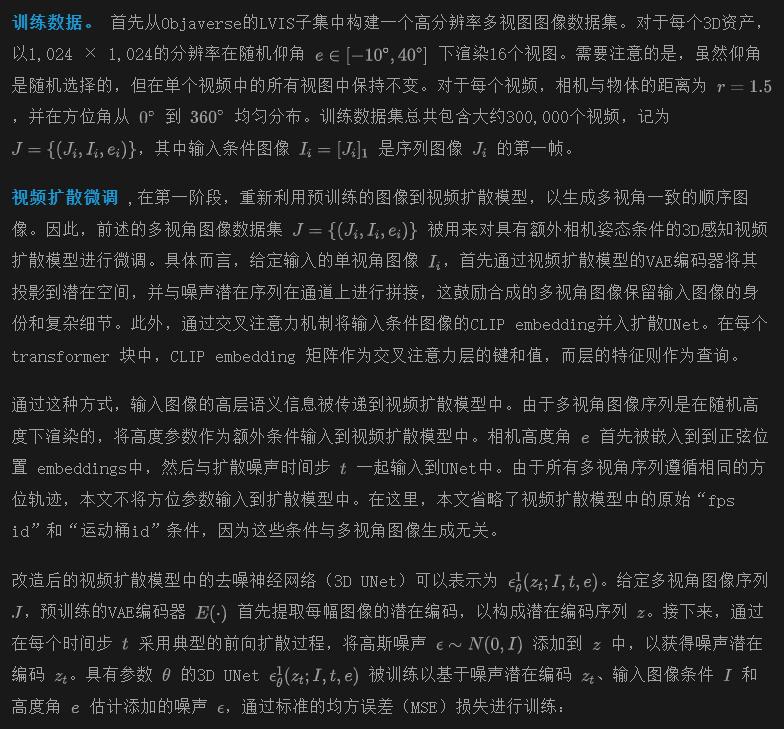

第一階段:基本多視圖生成

之前的圖像到3D生成方法通常依賴于預訓練的圖像擴散模型來實現多視圖生成。這些方法通常通過注入多視圖交叉注意力層,將圖像擴散模型中的2D UNet擴展為3D UNet。這些新增的注意力層在3D數據集上從頭開始訓練,以學習多視圖一致性。然而,為了確保訓練的穩定性,這些方法中的圖像分辨率被限制在256×256。正如Zero123所指出的,保持預訓練圖像擴散模型中的原始分辨率(512×512)會導致收斂速度變慢和方差增加。因此,由于這種低分辨率限制,這些方法無法完全捕捉輸入2D圖像中的豐富3D幾何和紋理細節。

此外,研究者們觀察到這些方法仍然存在多視圖不一致的問題,特別是對于復雜物體的幾何形狀。這可能是因為底層預訓練的2D擴散模型僅在單個2D圖像上訓練,缺乏對多視圖相關性的3D建模。為了解決上述問題,將單張圖像到多視圖圖像重新定義為3D感知序列圖像生成(即軌道視頻生成),并利用預訓練的視頻擴散模型實現這一目標。特別是,重新利用Stable Video Diffusion (SVD) 從輸入圖像生成多視圖圖像。SVD的吸引力在于它在大量不同的視頻上進行了訓練,使網絡在訓練期間能夠遇到物體的多個視圖。這可能緩解了3D數據稀缺問題。此外,SVD已經通過時間注意力層明確建模了多幀關系。我們可以繼承這些時間層中固有的多幀一致性知識,以追求3D生成中的多視圖一致性。

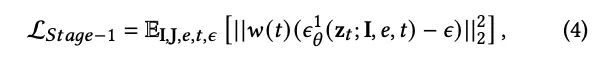

w(t)是一個對應的權重因子。本文并沒有直接在高分辨率(即 1024 × 1024)下訓練去噪神經網絡,而是以粗到細的方式將這個復雜的問題分解為更穩定的子問題。在第一階段,使用公式 (4) 在 512 × 512 分辨率下訓練去噪神經網絡,以生成低分辨率的多視角圖像。第二階段則進一步將 512 × 512 的多視角圖像轉換為高分辨率(1024 × 1024)的多視角圖像。

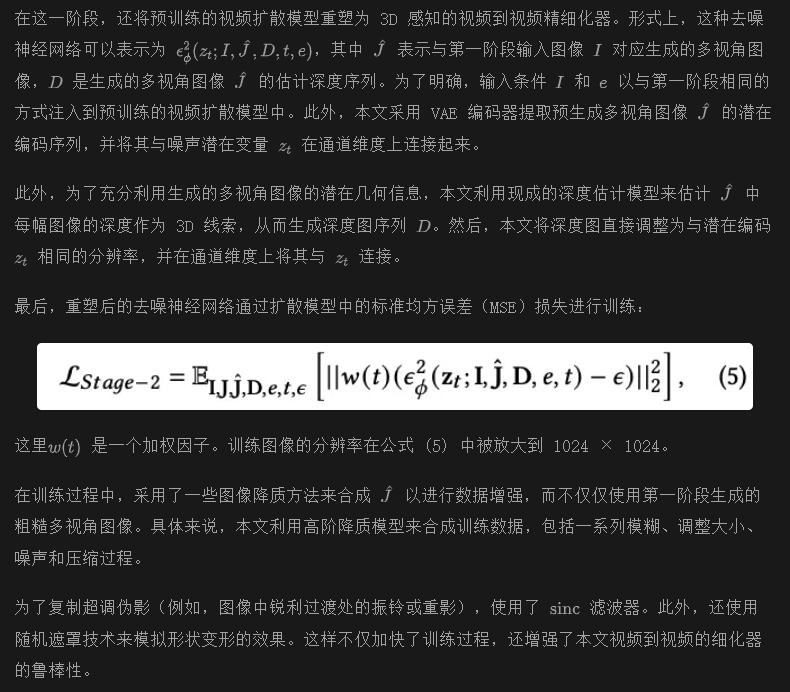

第 2 階段:3D 感知多視圖細化

階段一輸出的 512 × 512 多視角圖像展現了良好的多視角一致性,但仍未能完全捕捉輸入的幾何和紋理細節。為了解決這個問題,增加了一個額外的階段,通過新的 3D 感知視頻到視頻的精細化器,進一步放大第一階段的低分辨率輸出,從而生成更高分辨率(即 1024 × 1024)的多視角圖像,具有更精細的 3D 細節和一致性。

3D 網格提取

實驗

實驗設置

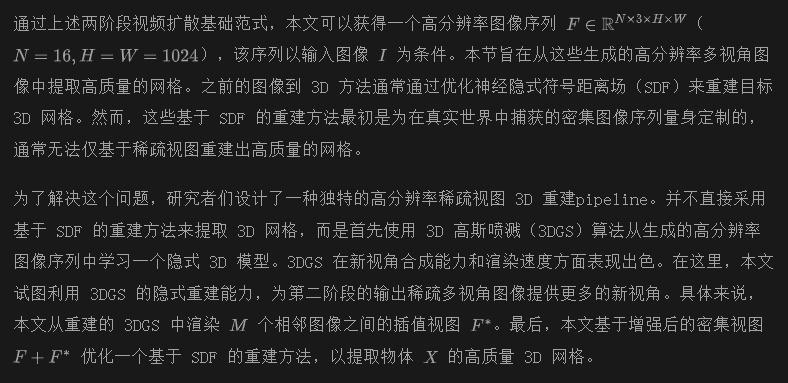

數據集與評估。 通過在兩個主要任務上進行實驗來實證驗證本文的Hi3D模型的優越性,即新視圖合成和單視圖重建。在Google掃描物體(GSO)數據集上進行定量評估。在新視圖合成任務中,采用三種常用指標:PSNR、SSIM 和LPIPS。在單視圖重建任務中,使用Chamfer距離和體積IoU來衡量重建3D模型的質量。此外,為了評估本文Hi3D的泛化能力,對來自互聯網的各種風格的單幅圖像進行了定性評估。

實現細節。 在基本多視圖生成的第一階段,將視頻數據集縮放為512 × 512的視頻。在多視圖精細化的第二階段,不僅使用第一階段的輸出,還采用合成數據生成策略(類似于傳統的圖像/視頻恢復方法進行數據增強。該策略旨在加速訓練過程并增強模型的魯棒性。整體實驗在八個80G A100 GPU上進行。具體來說,第一階段經歷了80,000個訓練步驟(大約3天),學習率為1 × 10??,總批量大小為16。第二階段包含20,000個訓練步驟(約3天),學習率為5 × 10??,批量大小減少為8。

對比方法。 本文將Hi3D與以下最先進的方法進行比較:RealFusion和Magic123利用2D擴散模型(Stable Diffusion)和SDS損失從單視圖圖像重建。Zero123學習從不同視角生成同一物體的新視圖圖像,并可以與SDS損失結合進行3D重建。Zero123-XL和Stable-Zero123通過提高訓練數據質量進一步升級Zero123。One-2-3-45通過多視圖圖像(即Zero123的輸出)直接學習顯式3D表示,利用3D有符號距離函數(SDFs)。Point-E和Shap-E在一個廣泛的內部OpenAI 3D數據集上進行預訓練,從而能夠直接將單視圖圖像轉換為3D點云或以MLP編碼的形狀。SyncDreamer引入了3D全局特征體積以保持多視圖一致性。Wonder3D和EpiDiff利用3D注意力機制,通過交叉注意力層使多視圖圖像之間能夠相互作用。值得注意的是,在新視圖合成任務中,本文僅包含部分基線(即Zero123系列、SyncDreamer、EpiDiff),以便與本文的Hi3D進行公平比較。

新穎的視圖合成

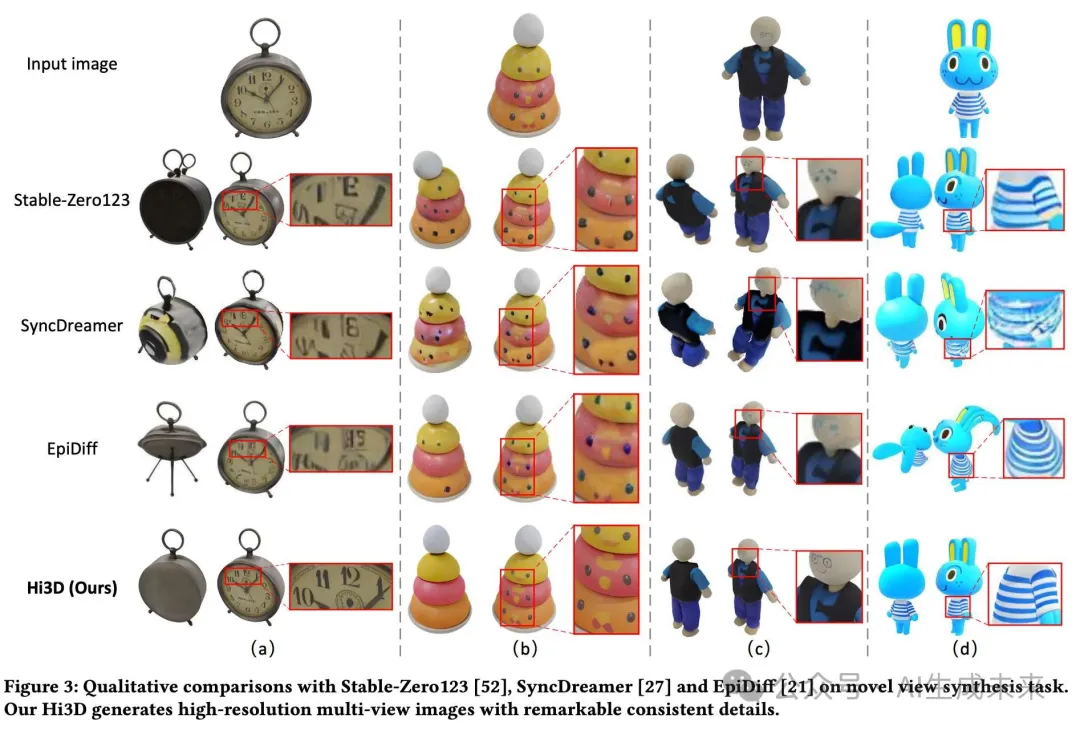

下表1總結了新視圖合成任務的性能比較,下圖3展示了在兩種不同視圖下的定性結果。Hi3D在性能上始終優于現有的基于2D擴散的方法。具體來說,Hi3D的PSNR達到了24.26%,比最佳競爭對手EpiDiff高出3.77%。Hi3D的最高圖像質量得分突顯了視頻擴散基于范式的關鍵優勢,即利用3D先驗知識來提升新視圖合成的效果。

由于圖像獨立翻譯,Zero123系列(例如,Stable-Zero123)未能實現多視圖一致性結果(例如,上圖3(a)中鬧鐘頭部在不同視圖下的一/兩個環)。SyncDreamer和EpiDiff通過利用3D中間信息或使用多視圖注意機制進一步增強了多視圖一致性。然而,由于受到限制的低圖像分辨率(256×256),它們的新視圖結果仍然存在模糊和不真實的問題(例如,上圖3(a)中模糊的鬧鐘數字)。相反,通過挖掘3D先驗并通過視頻擴散模型提升多視圖圖像分辨率,本文的Hi3D成功生成了多視圖一致且高分辨率的1024×1024圖像,從而實現了最高的圖像質量(例如,上圖3(a)中清晰可見的鬧鐘數字)。

單視圖重建

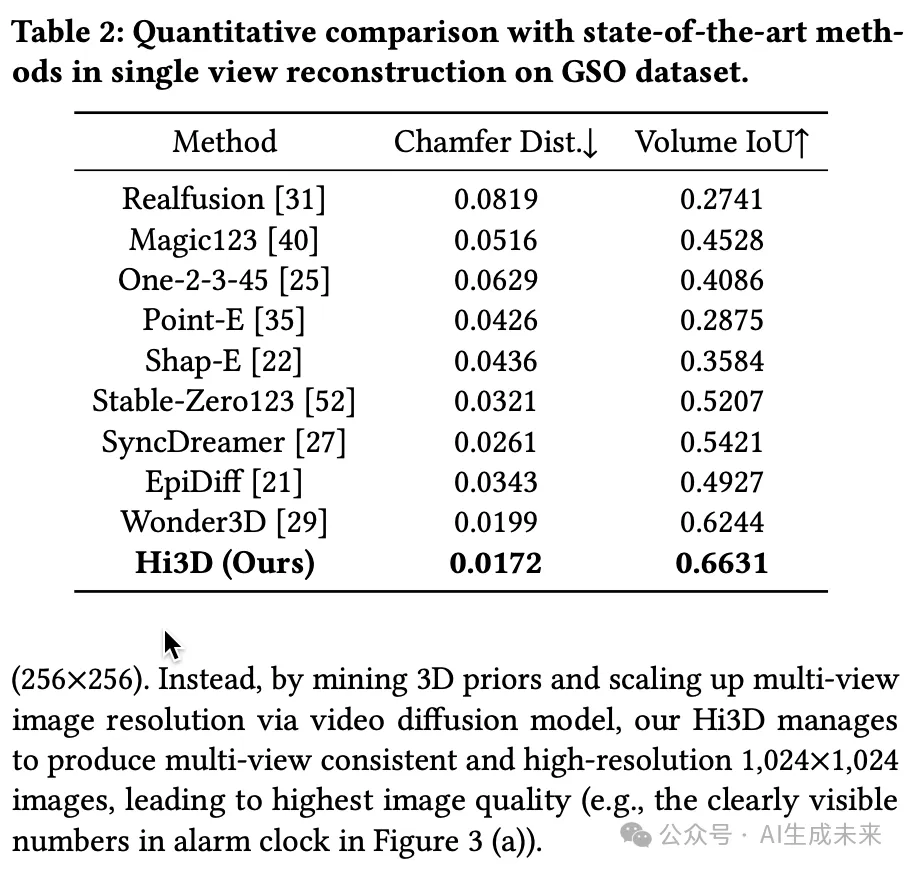

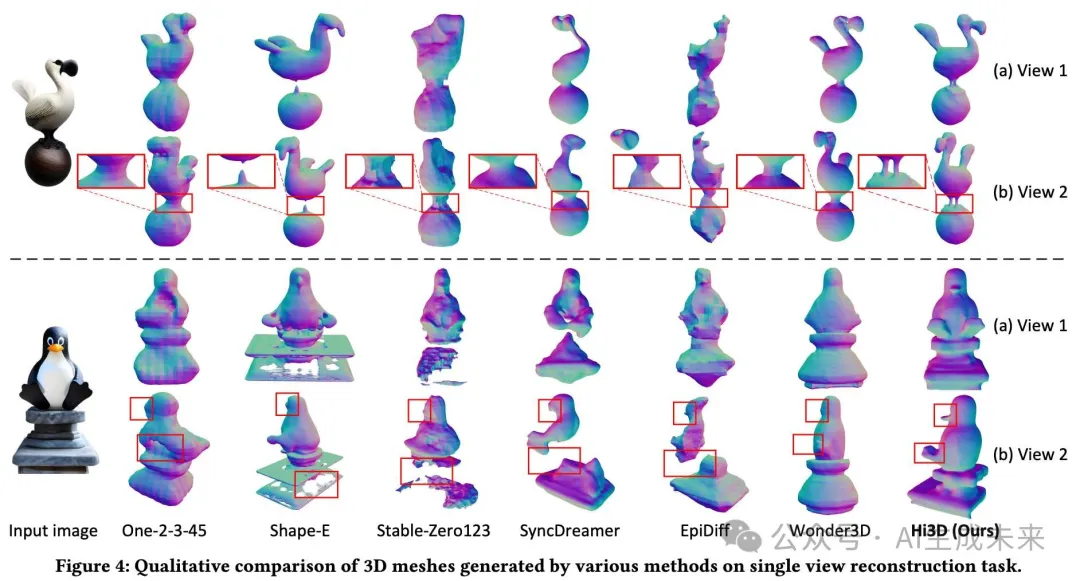

下表2中評估了Hi3D的單視圖重建性能。此外,下圖4展示了Hi3D與現有方法的定性比較。總體而言,Hi3D在兩個指標上均優于最先進的方法。One-2-3-45直接利用Zero123的多視圖輸出進行重建,但其3D一致性較差,通常導致生成的網格過于平滑,細節較少。Stable-Zero123通過使用更高質量的訓練數據進一步提高了3D一致性,但仍然存在缺失或過于平滑的網格問題。與Zero123中的獨立圖像翻譯不同,SyncDreamer、EpiDiff和Wonder3D通過2D擴散模型同時進行多視圖圖像翻譯,從而實現了更好的3D一致性。然而,由于低分辨率多視圖圖像的限制,它們在重建復雜的3D網格和豐富細節方面仍然面臨挑戰。相比之下,Hi3D充分發揮了預訓練視頻擴散模型中固有的3D先驗知識,并將多視圖圖像提升到更高的分辨率。這種設計使得3D網格重建的質量更高,細節更豐富(例如,下圖4中鳥和企鵝的腳部)。

消融研究

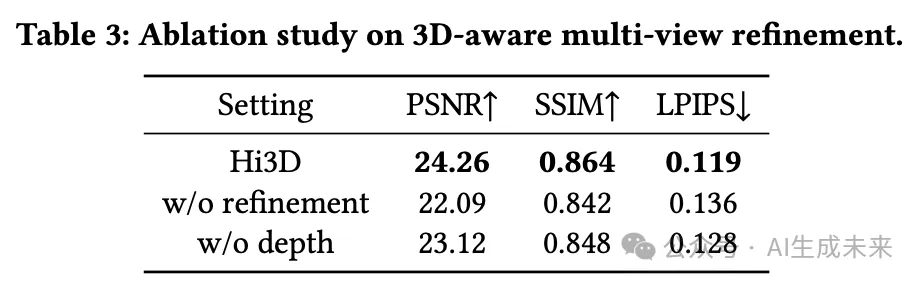

3D感知多視圖優化階段的效果。 在這里檢查第二階段(即3D感知多視圖優化)對新視圖合成的有效性。下表3詳細列出了Hi3D的消融實驗結果。具體而言,第二行去除了整個第二階段,性能大幅下降。這驗證了通過3D感知視頻到視頻的優化器提升多視圖圖像分辨率的有效性。此外,當僅去除第二階段中的深度條件(第三行)時,性能明顯下降,這表明深度條件在增強多視圖圖像之間的3D幾何一致性方面的有效性。

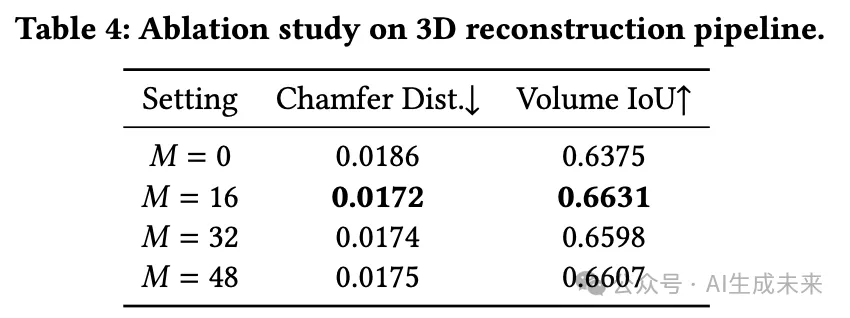

3D重建中插值視圖數量的影響。 下表4顯示了使用不同數量的插值視圖??的單視圖重建性能。在極端情況下,當?? = 0時,不使用插值視圖,3D重建流程退化為典型的基于SDF的重建。隨著??增加到16,重建性能明顯提高,這基本上顯示了通過3DGS插值視圖的優勢。然而,當進一步增大??時,性能略有下降。推測這可能是由于視圖之間不必要的信息重復和錯誤累積所致。在實際應用中,??通常設置為16。

更多討論

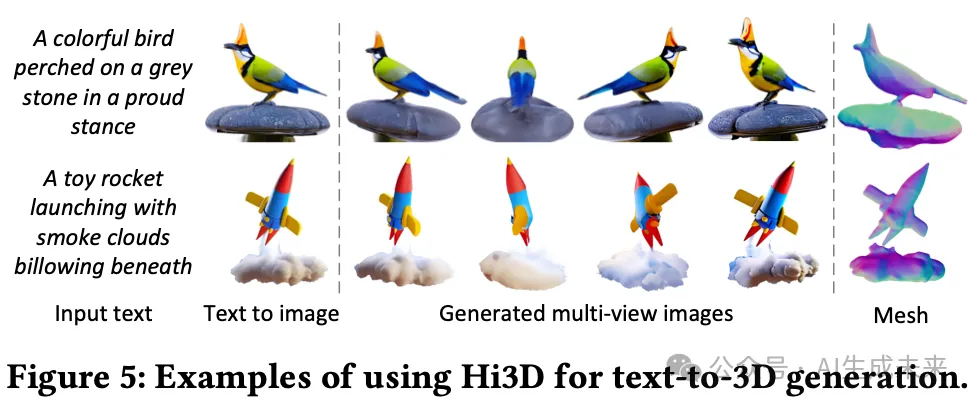

文本到圖像再到3D。 通過將先進的文本到圖像模型(例如,Stable Diffusion、Imagen)集成到Hi3D中,能夠直接從文本描述生成3D模型,如下圖5所示。本文的方法能夠生成高保真度的3D模型,具有高度細致的紋理,這再次突顯了高分辨率多視圖圖像生成與3D一致性的優點。

3D模型生成中的多樣性和創造力。 在這里,本文通過使用不同的隨機種子來考察本文的Hi3D的多樣性和創造力。如下圖6所示,Hi3D能夠生成多樣且合理的實例,每個實例都有獨特的幾何結構或紋理。這種能力不僅增強了3D模型創建的靈活性,還顯著促進了在3D設計和可視化中的創造性探索。

結論

本文探討了在預訓練視頻擴散模型中固有的3D先驗知識,以促進圖像到3D生成的提升。本文從一個新穎的視角研究了將單幅圖像轉化為多視圖圖像的問題,提出了3D感知的序列圖像生成(即軌道視頻生成)。為了實現本文的想法,本文引入了Hi3D,該方法采用兩階段視頻擴散的范式,以觸發高分辨率的圖像到3D生成。

在技術上,在基本多視圖生成的第一階段,重新塑造了一個視頻擴散模型,并增加了相機姿態的3D條件,旨在將單幅圖像轉化為低分辨率軌道視頻。在3D感知的多視圖細化的第二階段,設計了一個帶有深度條件的視頻到視頻細化器,以將低分辨率軌道視頻放大為具有豐富紋理細節的高分辨率序列圖像。最終,生成的高分辨率輸出通過3D高斯點云進行插值視圖增強,并采用基于SDF的重建方法實現3D網格。

在新視圖合成和單視圖重建任務上的實驗驗證了本文的方法在性能上優于最先進的技術。

本文轉自 AI生成未來 ,作者:Haibo Yang 等