大模型真能模擬人類語言?中國人民大學提出新的數(shù)據(jù)增強方法

論文標題:LLM-Generated Natural Language Meets Scaling Laws: New Explorations and Data Augmentation Methods

機構:

- School of Information Resource Management, Renmin University of China

- School of Computing, National University of Singapore

論文鏈接:??https://arxiv.org/pdf/2407.00322.pdf??

在人工智能領域,大型語言模型(LLM)如GPT-4的出現(xiàn)引起了廣泛關注,特別是它們在自然語言處理(NLP)中的應用。這些模型通過生成與人類自然語言(HNL)極為相似的文本,推動了NLP的發(fā)展。然而,盡管LLM在文本生成方面表現(xiàn)出色,它們在生成人類自然語言的準確性和深度上仍存在疑問。

這篇論文主要探討了大語言模型(LLM)生成的自然語言與人類自然語言(HNL)之間的對齊問題和數(shù)據(jù)增強方法。作者提出了一種新的數(shù)據(jù)增強方法ZGPTDA,利用基于縮放定律的模糊計算機制來提高文本分類的效果。通過大量的實驗驗證,該方法在性能上優(yōu)于現(xiàn)有的方法。此外,論文還揭示了一些有趣的見解,如Hilberg's law和Taylor's law可以為文本分類帶來更多好處等。

LLM與HNL的基本對比

1. 訓練和反饋機制的差異

LLM通常通過從人類反饋中學習的強化學習進行訓練,這種方法預設生成的文本與HNL一致。然而,這一假設的實證真實性尚未得到充分探索。與之相對,HNL是通過日常交流和長期的語言習得過程形成的,這一過程涉及復雜的認知和社會互動因素,這些是LLM難以完全模擬的。

2. 語言的復雜性和深度

從語言的復雜性來看,HNL具有豐富的變化和深度,這反映在不同語境下語言的靈活運用上。相比之下,盡管LLM能夠生成語法結構正確的文本,但它們生成的內(nèi)容往往缺乏人類語言的微妙情感和語境深度。例如,LLM在處理具有雙關語或幽默等元素的文本時,可能無法完全捕捉其語言的微妙之處。

3. 數(shù)據(jù)增強與真實性問題

在使用LLM進行數(shù)據(jù)增強時,一個關鍵問題是生成的文本數(shù)據(jù)(Daug)與人類語言的一致性。研究表明,盡管通過LLM生成的文本可以擴展訓練數(shù)據(jù)集,但這些文本的質(zhì)量和多樣性之間的權衡可能會影響模型的最終性能。此外,由于缺乏策略性過濾,可能會包含一些低質(zhì)量或與人類語言差異較大的數(shù)據(jù),這一點在訓練過程中需要特別注意。

通過對LLM和HNL的這些基本對比,我們可以看到盡管LLM在模擬人類語言方面取得了一定的成就,但在真實性、復雜性和深度上仍有較大的提升空間。這些差異提示我們在將LLM應用于實際NLP任務時,需要仔細考慮其局限性,并探索更有效的方法來提高其與人類語言的一致性。

新的數(shù)據(jù)增強方法:ZGPTDA

在自然語言處理(NLP)領域,大型語言模型(LLM)如GPT-4的出現(xiàn),已經(jīng)顯著推動了文本生成技術的發(fā)展。然而,這些模型生成的文本(LLMNL)與人類自然語言(HNL)的一致性仍是一個未解之謎。為了解決這一問題,本文提出了一種新的文本數(shù)據(jù)增強方法,名為ZGPTDA(基于縮放法則的GPT數(shù)據(jù)增強方法)。

1. ZGPTDA的動機和目標

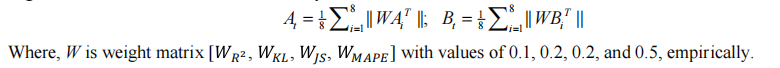

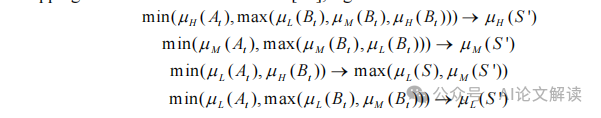

ZGPTDA的核心動機是解決LLM生成的文本隨機性問題,即不是所有生成的文本都對訓練有同等的價值。這種方法特別關注那些更接近人類語言的文本,因為分類器的設計初衷是服務于人類,并在現(xiàn)實生活中使用。因此,ZGPTDA通過評估這些文本與八個縮放法則的符合度來確定其適用性,如擬合優(yōu)度(goodness of fit)等,從而選擇出最佳的增強實例。

2. ZGPTDA的實現(xiàn)機制

ZGPTDA首先使用GPT-4從原始數(shù)據(jù)集生成額外的訓練文本。然后,這些生成的文本將根據(jù)它們與已知的縮放法則(如Zipf定律、Heaps定律等)的一致性來評估。通過這種方式,ZGPTDA能夠量化每個文本實例的“適用性”。具有較高適用性的實例被認為更具代表性,更符合人類語言的特性,因此更適合被納入訓練過程中。

3. ZGPTDA的評估和效果

通過對比實驗,ZGPTDA在多個數(shù)據(jù)集上的應用顯示出了其有效性。例如,在使用Bert和RoBerta分類器的測試中,ZGPTDA能夠提高7-10%的F1得分,并且在一些情況下超過了最近的AugGPT方法。這些結果驗證了ZGPTDA在處理由LLM生成的文本時,通過縮放法則進行篩選和決策的有效性。

總之,ZGPTDA提供了一種新的視角和方法,用于改進基于LLM的文本數(shù)據(jù)增強技術,特別是在訓練數(shù)據(jù)不足的情況下。通過精確地評估生成文本的人類語言適用性,ZGPTDA有助于提高NLP模型的性能和適用性。

實驗設置與驗證

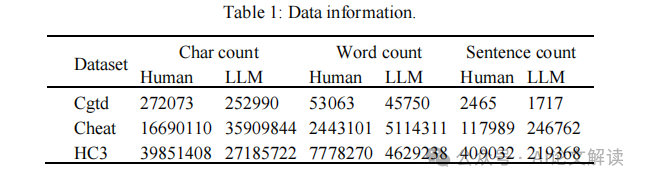

在本研究中,我們采用了三個數(shù)據(jù)集,每個數(shù)據(jù)集都包含由GPT-3.5和人類在相同提示下生成的文本。為了更好地進行實驗,我們將每個數(shù)據(jù)集中的LLM生成的自然語言(LLMNL)和人類自然語言(HNL)分別整合。表1展示了一些統(tǒng)計信息,包括文本數(shù)量和詞頻等。

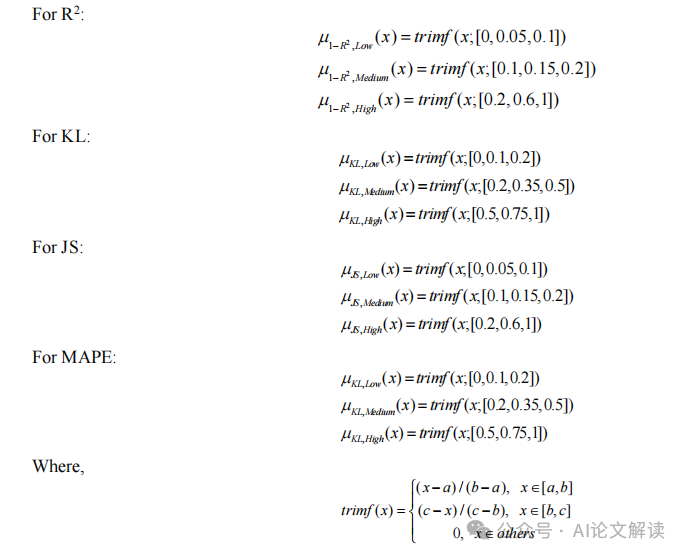

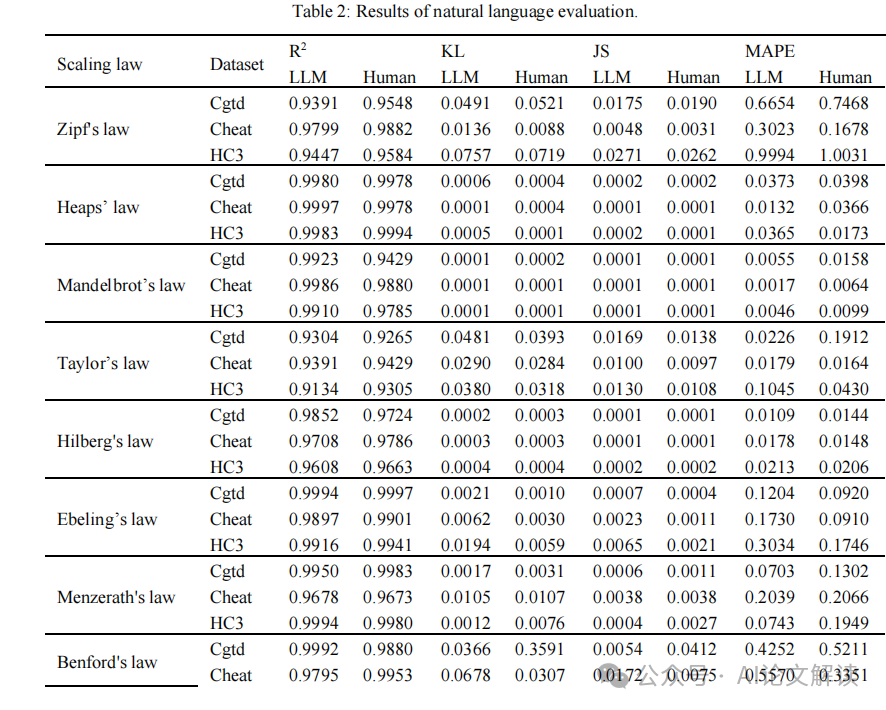

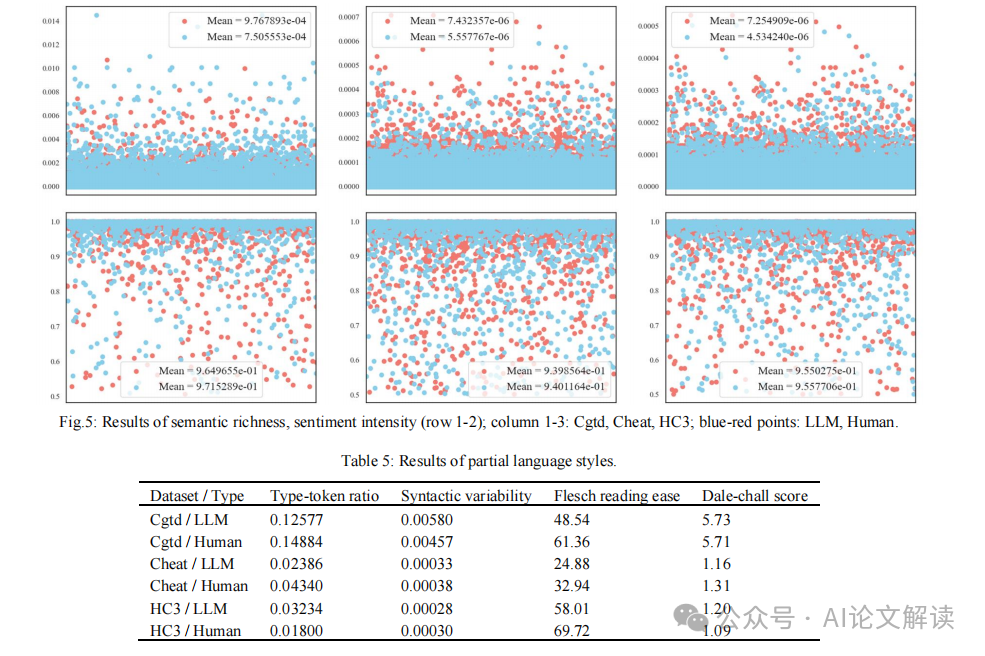

為了驗證LLM生成的文本與人類文本的一致性,我們采用了多種統(tǒng)計法則進行量化分析。這些包括Zipf定律、Heaps定律、Taylor定律等,通過這些定律的參數(shù)優(yōu)化和回歸分析來確定它們的適用性。我們使用R2、Kullback-Leibler散度(KL)、Jensen-Shannon散度(JS)和平均絕對百分比誤差(MAPE)等多種指標來衡量擬合的好壞。其中,R2值大于0.9通常表示很強的一致性。

實驗結果顯示,在三個數(shù)據(jù)集上,所有的R2值均高于0.9,甚至在Heaps定律和Mandelbrot定律上超過了0.99。此外,KL和JS散度的最小值(例如在Mandelbrot定律中低至0.001)也強有力地支持了LLM生成的語言與真實分布之間的一致性。這些結果充分證明了LLM在語言輸出上與人類語言的高度一致性。

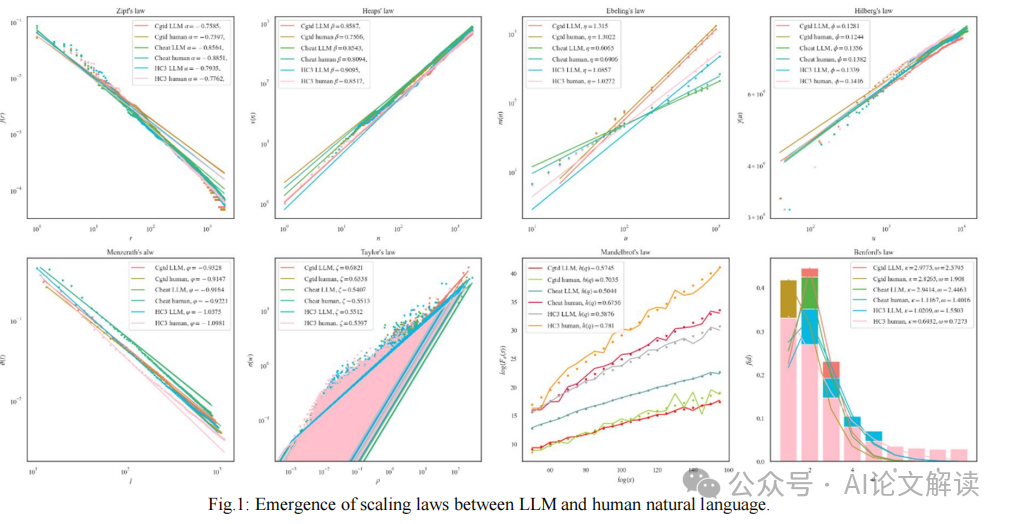

圖1清晰地展示了LLM和人類語言輸出中出現(xiàn)的定律的一致性,顯示出在不同數(shù)據(jù)集上的統(tǒng)一趨勢。例如,在HC3數(shù)據(jù)集上,Zipf指數(shù)α的差異被限制在0.03以下,顯示出對最小努力原則近乎等同。

通過這些嚴格的實驗設置和驗證,我們不僅證實了LLM生成的文本在結構和統(tǒng)計特性上與人類文本的高度相似,而且還為使用LLM進行文本數(shù)據(jù)增強提供了堅實的理論基礎和實踐證據(jù)。這些發(fā)現(xiàn)為自然語言處理的進一步研究和應用提供了重要的支持。

深入分析與討論

在探索大型語言模型(LLM)如GPT-4在自然語言處理(NLP)中的應用時,一個核心問題是這些模型生成的語言(LLMNL)與人類自然語言(HNL)的真實對應程度。盡管LLM通過從人類反饋中學習而設計,理論上應該能夠模擬人類語言,但實際上這一假設的經(jīng)驗驗證仍然是一個未知數(shù)。這種不確定性使得我們必須更加深入地研究LLM生成語言的真實性和適用性。

1. 語言生成與理解的差異

LLM如GPT-4在生成語言方面的能力無疑是革命性的,但它們在理解語言的能力上卻有所不足。這種生成與理解的差異在特定領域尤為明顯,例如在工業(yè)安全領域,由于缺乏特定領域的訓練數(shù)據(jù),LLM在進行危害分類等任務時可能效果不佳。

2. 數(shù)據(jù)增強的實際應用

在標簽數(shù)據(jù)稀缺的情況下,使用LLM生成的標簽文本來增強原始訓練數(shù)據(jù)集大小是一種直接有效的策略。這種方法可以在保證生成數(shù)據(jù)標簽的正確性(保真度)和生成數(shù)據(jù)的多樣性(多樣性)之間進行權衡。然而,這種方法也存在生成文本的隨機性和可能包含低質(zhì)量數(shù)據(jù)的問題,這些低質(zhì)量數(shù)據(jù)可能會被錯誤地包含在訓練集中。

3. 縮放法則的應用

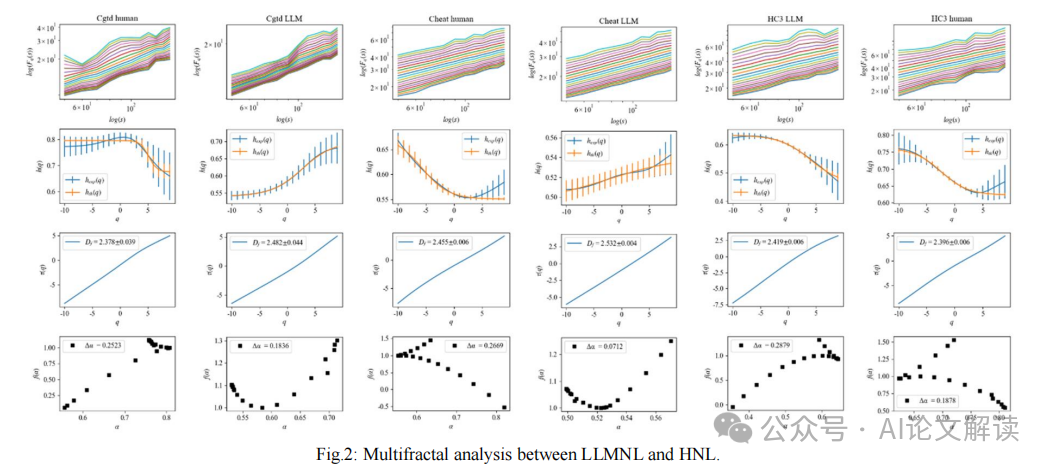

通過引入縮放法則,如Zipf定律、Heaps定律和Mandelbrot法則等,我們可以從一個新的角度來評估LLMNL與HNL之間的相似性和差異。這些法則幫助我們從統(tǒng)計物理的角度理解語言的復雜性,提供了一種量化語言本質(zhì)的方法。例如,Zipf定律揭示了詞頻分布的偏斜性,這可以被視為語言經(jīng)濟性的體現(xiàn),而Mandelbrot法則則從多重分形分析的角度提供了對語言自相似性的深入理解。

4. ZGPTDA方法的創(chuàng)新

在數(shù)據(jù)增強方面,我們提出了一種新的方法ZGPTDA,它基于LLM生成文本與縮放法則的符合度來評估這些文本的適用性。這種方法不僅考慮了生成文本的質(zhì)量,還通過決策過程來選擇最適合訓練目的的文本實例。ZGPTDA通過實驗顯示,能夠有效提高文本分類的F1分數(shù),并且在多個數(shù)據(jù)集上的表現(xiàn)優(yōu)于現(xiàn)有的數(shù)據(jù)增強方法。

通過這些深入的分析和討論,我們不僅加深了對LLM在自然語言處理中應用的理解,還推動了相關技術的進一步發(fā)展和優(yōu)化。這些研究成果為LLM在NLP領域的應用提供了理論基礎和實踐指導,為未來的研究方向指明了道路。

總結與未來展望

在本文中,我們探討了大型語言模型(LLM)生成的自然語言(LLMNL)與人類自然語言(HNL)之間的關系,并引入了縮放法則來深入分析這兩者之間的相似性和差異。通過廣泛的實驗,我們發(fā)現(xiàn)LLMNL與HNL之間存在微小的偏差,特別是在Mandelbrot的法則中觀察到約0.2的指數(shù)差異。這一發(fā)現(xiàn)不僅加深了我們對語言風格的理解,還為LLM的進一步應用和發(fā)展奠定了堅實的基礎。

此外,我們提出了一種新的文本分類數(shù)據(jù)增強方法——ZGPTDA,該方法利用縮放法則的一致性通過模糊計算機制對GPT-4增強數(shù)據(jù)進行決策。實際應用場景中的廣泛實驗驗證了ZGPTDA的有效性和競爭力,其在Bert和RoBerta上的F1得分提高了7-10%,并在DeBerta上的準確率上超過了最近的AugGPT和GENCO方法約2%。

我們的研究還揭示了一些有趣的見解,例如Hilberg法則和Taylor法則在文本分類中可能帶來更多的好處。這些發(fā)現(xiàn)為未來的研究提供了新的方向,例如在特征工程中優(yōu)先考慮這些法則,以提高效率和完善自然語言處理的范式。

本文轉載自 ??AI論文解讀??,作者:柏企