AI數學天才還是數字騙子?GSM-Symbolic揭秘大語言模型的數學推理能力

1、AI模型升級有妙招!"廢物利用"讓大語言模型更強大

想象一下,如果能把你的舊手機變成最新的智能設備,是不是很酷?在AI領域,研究人員就實現了類似的"魔法"!他們提出了一種叫做"upcycling"的方法,可以將現有的大語言模型(LLM)升級成更強大的"專家混合模型"(MoE)。這項技術不僅能提高模型性能,還能大幅節省訓練成本和時間。

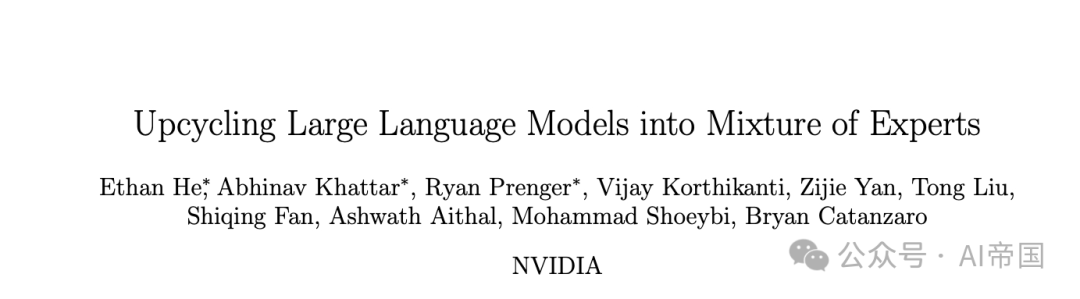

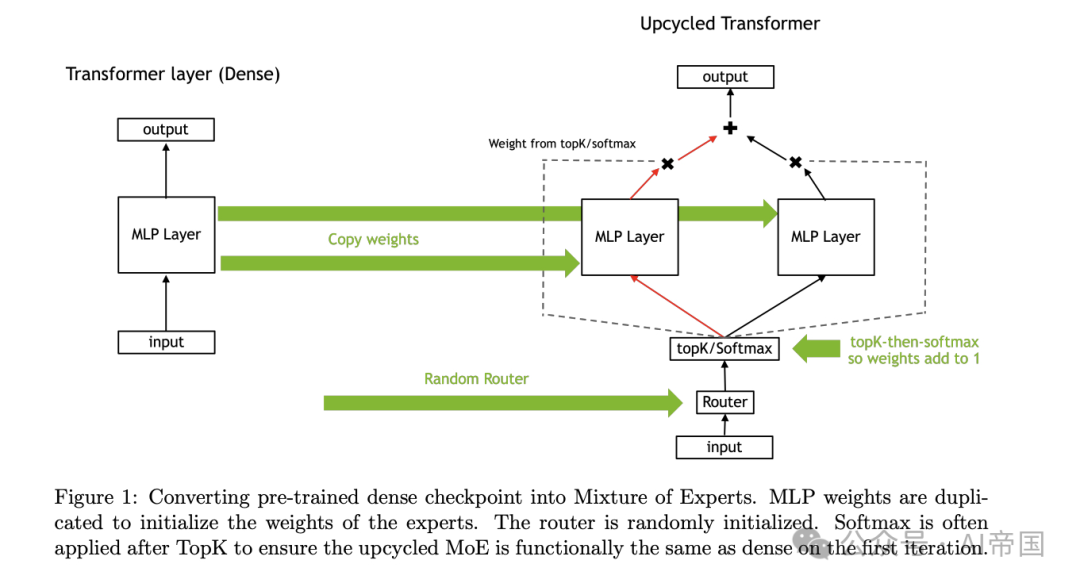

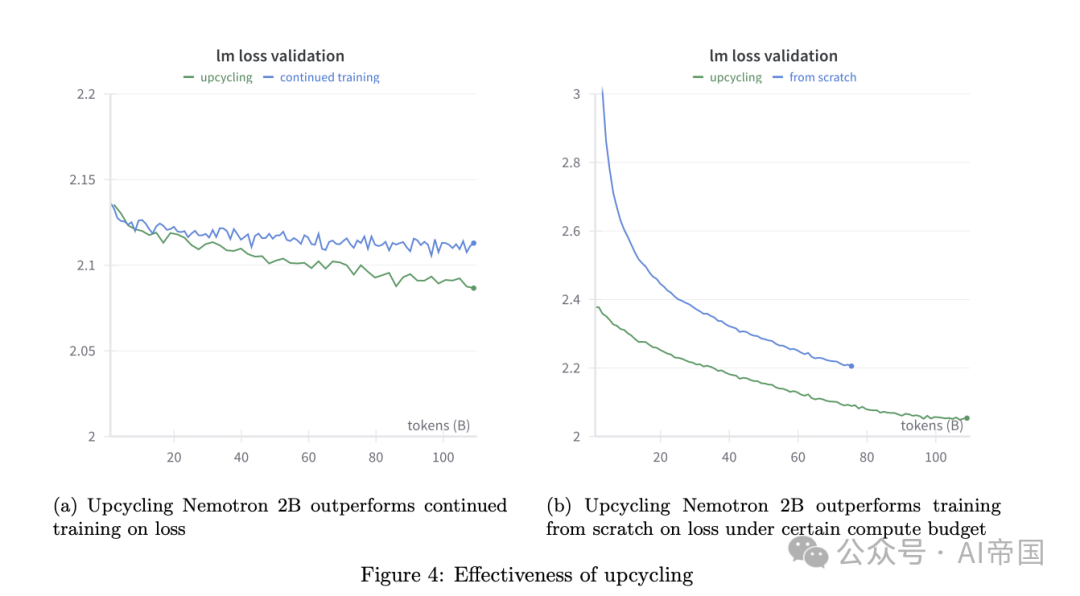

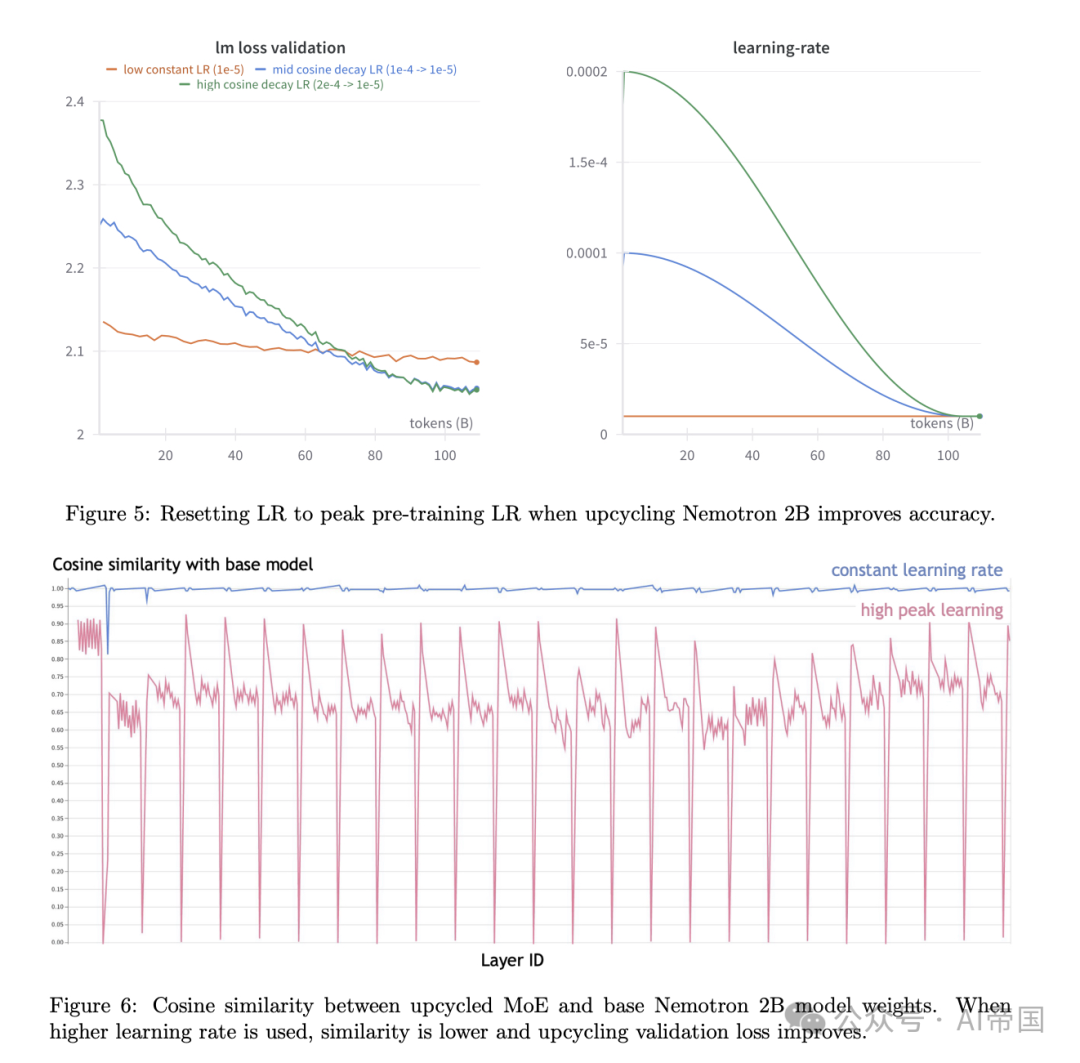

那么,這種"升級魔法"是如何實現的呢?研究團隊進行了大量實驗,探索了各種升級技巧和參數設置。他們發現,通過精心設計的訓練方案、新穎的"虛擬分組"初始化方法,以及巧妙的權重縮放策略,可以讓升級后的模型性能顯著提升。更令人興奮的是,他們還發現了一種新的"專家路由"方法,讓模型在處理信息時更加高效。

為了證明這種升級方法的威力,研究人員對Nemotron-4 15B模型進行了升級實驗。結果令人驚喜:在相同的訓練數據量下,升級后的模型在MMLU測試中的得分從65.3%提升到了67.6%。這意味著,通過"upcycling",我們可以讓現有的AI模型變得更聰明、更高效,而無需從頭開始訓練新模型。

這項研究不僅為AI領域帶來了新的發展方向,也為我們提供了一種全新的思路:如何更好地利用和提升現有資源。在未來,我們可能會看到更多的AI模型通過這種"升級魔法"變得更加強大,為各行各業帶來更智能、更高效的解決方案。AI的未來,也許就藏在這種創新的"廢物利用"中!

論文標題:Upcycling Large Language Models into Mixture of Experts

論文鏈接:??https://arxiv.org/abs/2410.07524??

2、AI數學天才還是數字騙子?GSM-Symbolic揭秘大語言模型的數學推理能力

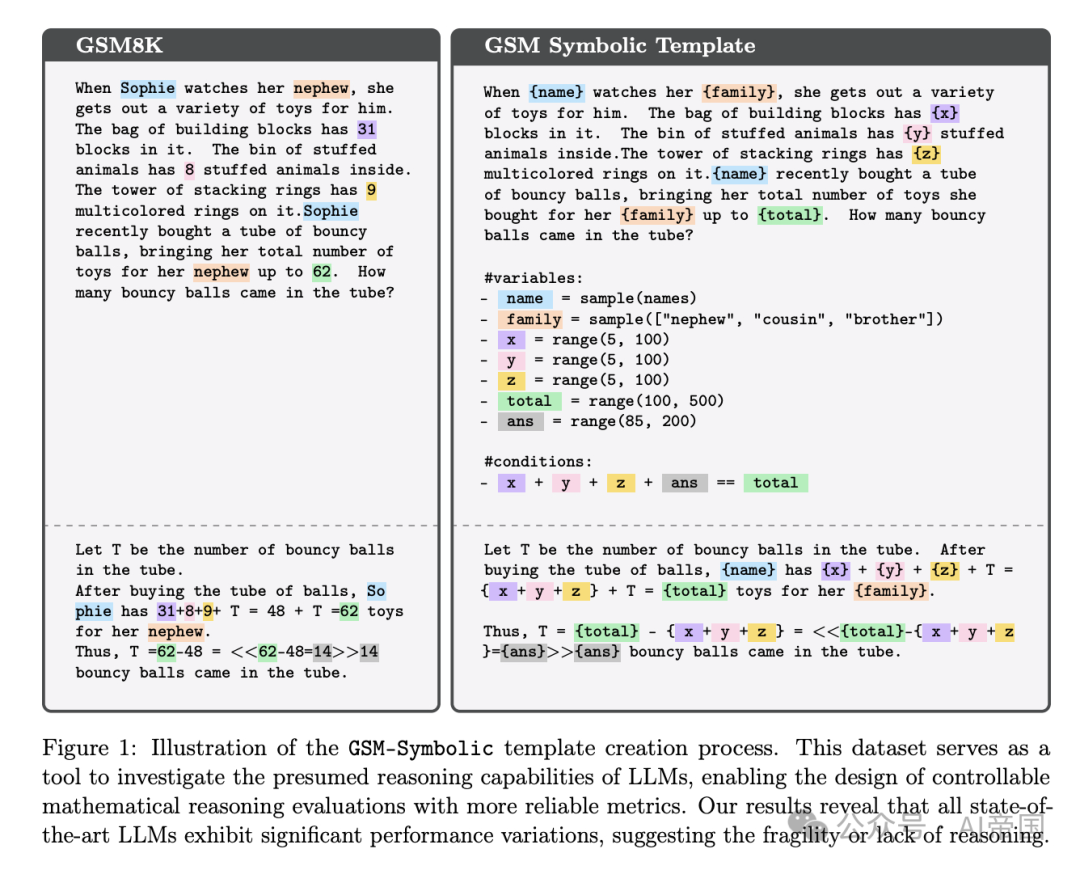

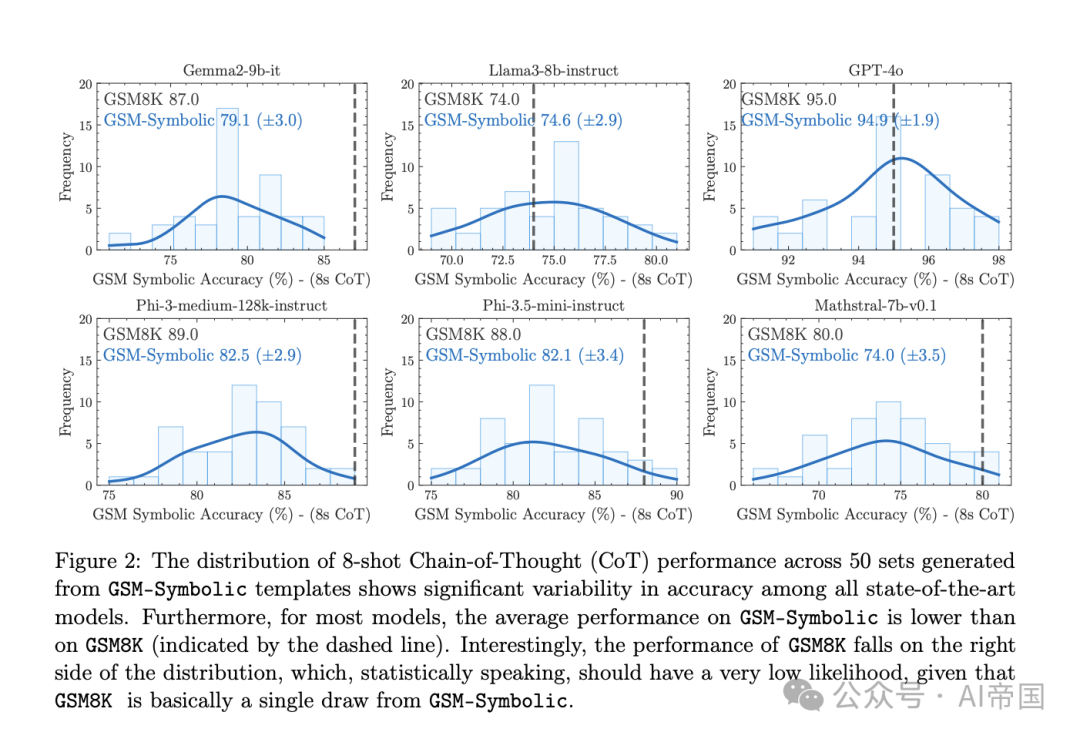

你可能聽說過AI在數學測試中表現驚人,但它們真的懂數學嗎?最新研究GSM-Symbolic給出了令人深思的答案。研究團隊通過創新的符號化模板,生成了大量變體問題,深入探究了大語言模型(LLMs)的數學推理能力。結果揭示,這些AI"數學天才"可能并不如我們想象的那么聰明!

研究發現,當面對GSM-Symbolic生成的新問題時,所有模型的表現都出現了下滑。這不禁讓人懷疑,之前在GSM8K測試中的高分是否只是數據污染導致的"假象"?更有趣的是,AI們對人名等表面變化還算"淡定",但一旦數字發生變化,它們就會變得"手足無措"。隨著問題復雜度增加,AI的表現更是每況愈下,暴露出其推理能力的局限性。

最令人驚訝的是GSM-NoOp實驗。研究者只是在問題中添加了一些看似相關但實際無關的信息,結果AI的表現就大幅下滑,最高降幅竟達65%!這說明AI在分辨關鍵信息方面還很"幼稚",其所謂的"推理"可能更像是一種模式匹配,而非真正的邏輯思考。即便給AI多個相似例子,它們仍然難以克服這一挑戰,暴露出其推理過程中的深層問題。

這項研究不僅揭示了當前AI在數學推理方面的局限性,也為我們提供了一個全新的視角來評估和改進AI系統。它提醒我們,在為AI的"聰明"歡呼之前,我們還需要更深入、更全面的評估方法。未來,如何讓AI真正掌握邏輯推理能力,而不是僅僅依賴表面模式匹配,將成為AI研究的一個重要方向。AI的數學之路,似乎還有很長的路要走!

論文標題:GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models

論文鏈接:??https://arxiv.org/abs/2410.05229??

本文轉載自 ??AI帝國??,作者: 無影寺