李飛飛:通過「空間智能」重構世界

在人工智能的持續演進中,多模態大語言模型(MLLMs)已成為核心研究領域之一,其在整合語言和視覺信息方面的潛力備受關注。李飛飛、謝賽寧團隊的最新研究成果猶如一顆璀璨的新星,照亮了 MLLM 在空間智能領域的探索之路,引發了學界和業界的廣泛關注。本文將深入剖析該團隊的研究,詳細闡述 MLLM 在空間智能方面的突破與挑戰,一同探索 MLLMs 在視覺空間智能方面的進展與難題。

1.引言視覺空間智能

在人類的日常生活中,視覺空間智能起著極為關鍵的作用。無論是在家中規劃家具擺放,還是在工作場所導航尋路,我們都在不斷運用這一能力。人類能夠憑借視覺感知和記憶,快速構建空間布局,并據此做出準確的判斷和決策。

對于人工智能而言,尤其是多模態大語言模型,視覺空間智能的發展卻面臨諸多挑戰。盡管語言模型在文本處理上取得了顯著成果,但在理解和處理視覺空間信息方面仍處于探索階段。這一能力的缺失限制了 MLLMs 在許多實際應用中的表現,如機器人控制、自動駕駛和增強現實等領域。

為了填補這一研究空白,本文引入了一個全新的基準測試——VSI-Bench。它基于大量真實的室內場景視頻,構建了超過 5000 個問題-答案對,旨在全面評估 MLLMs 的視覺空間智能。這一基準測試的出現,為 MLLMs 在該領域的研究提供了重要的工具和標準,開啟了深入探究的大門。

2.視覺空間智能內涵、范疇與關鍵要素解析

定義與范圍的精準界定

本文聚焦于視覺空間智能在現實世界環境中的應用,區別于傳統的抽象空間認知測試。在實際場景中,如家庭、辦公室和工廠等,視覺空間智能表現為對空間關系的準確感知和有效操作。例如,在家庭場景中,能夠判斷家具之間的合理間距;在辦公室里,能快速找到所需物品的位置;在工廠中,可規劃高效的物料運輸路徑。這種基于現實場景的定義,使得研究更具實際意義和應用價值。比如你要去宜家買家具,當你看到一個心儀的衣柜時你會在腦海里想一下你的臥室,放到哪里更合適,這時候我們會在腦海里重構一下自己的臥室空間,回憶一下房間里的物體、他們的位置以及大概的大小,判斷下新買的衣柜應該放到哪里。

能力分類的深度剖析

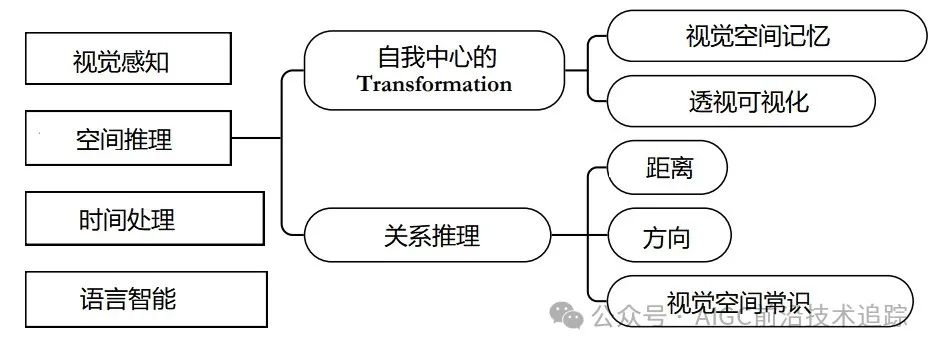

視覺空間智能涵蓋多個關鍵能力領域(見圖 2)。視覺感知是基礎,要求模型能夠從視頻中準確識別各類物體,這涉及到對物體形狀、顏色、紋理等特征的提取和識別。例如,在復雜的室內視頻中,模型需分辨出桌椅、電器等不同物體。

語言智能則負責理解與空間相關的語言描述,并將其與視覺信息相結合。當遇到“房間里有幾張椅子”這樣的問題時,模型要理解問題含義,并在視頻中找到對應的答案。

時間處理能力使模型能夠追蹤物體在視頻中的時間動態變化,構建其運動軌跡。比如在監控視頻中,模型可記錄人員或物體的移動路徑。

空間推理能力是核心,包括關系推理和自我中心-客體中心轉換。關系推理要求模型依據距離和方向判斷物體間的空間關系,如確定書架與窗戶的相對位置。自我中心-客體中心轉換則是在以自身視角和以環境為中心的視角之間切換,這類似于人類在空間中定位自己和周圍物體的過程。

3.VSI-Bench創新基準測試的構建與解析

概述:架構與任務體系

VSI-Bench 由 288 個真實視頻生成的 5000 多個問題-答案對組成,數據來源于 ScanNet、ScanNet++ 和 ARKitScenes 等權威數據集,涵蓋多種環境和地理區域。其任務分為配置、測量估計和時空三大類共八個任務(見圖 3)。

配置任務中的物體計數,考驗模型對視頻中特定物體數量的準確統計能力;相對距離任務要求模型判斷物體間的遠近關系;相對方向任務促使模型確定物體的方位;路線規劃任務模擬機器人導航,需要模型規劃出從起點到終點的合理路徑。

測量估計任務中,物體大小估計要求模型根據視頻判斷物體的尺寸;房間大小估計需模型估算出整個房間的面積;絕對距離估計則是精確計算兩個物體之間的實際距離。

時空任務的外觀順序,要求模型記住物體在視頻中首次出現的先后順序,測試其對空間信息的記憶能力。

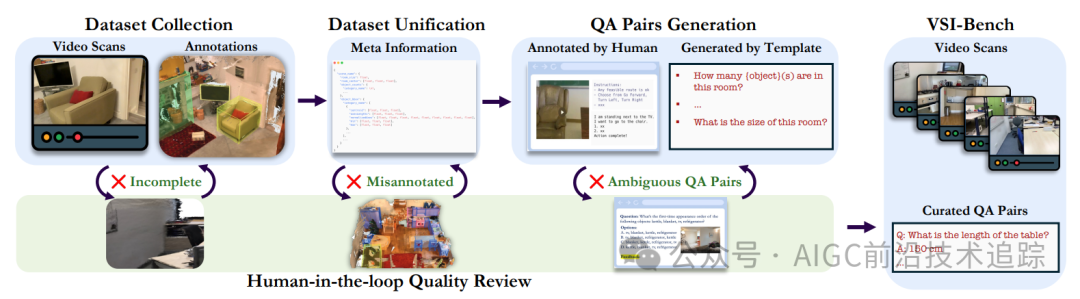

基準測試

數據收集與統一的精細操作:從不同數據集中選取樣本后,對視頻進行標準化處理。ScanNet 視頻轉換為 24 FPS,ScanNet++和 ARKitScenes 視頻子采樣到 30 FPS,并統一分辨率為 640 × 480 像素。同時,對不同數據集的注釋結構進行統一,提取包含數據集、視頻路徑、房間大小等關鍵信息的元信息,并精心篩選和重映射物體類別,確保數據的一致性和有效性。

問題-答案生成的科學方法:除路線規劃任務采用人工標注外,其他任務利用元信息和問題模板自動生成問題-答案對。例如物體計數的問題模板為“ How many {object} are in this room? ”,通過替換 {object} 生成具體問題。在數值答案任務中,合理生成選擇題選項,并對每個場景和任務的問題數量進行子采樣,保證數據集的平衡性。

人工循環質量審查的嚴格把控:在數據集收集和問題-答案對生成階段,均實施人工審查。收集時過濾掉 3D 網格重建不完全的場景,生成后手動驗證元信息正確性,尤其關注物體數量。在問題-答案對審查中,人工評估人員標記錯誤或模糊的問題,研究團隊據此追溯錯誤源并采取糾正措施,如刪除問題樣本、修改元信息或問題模板等,經過多次迭代確保基準測試質量。

4. VSI-Bench 上的評估模型性能的全面審視

評估設置

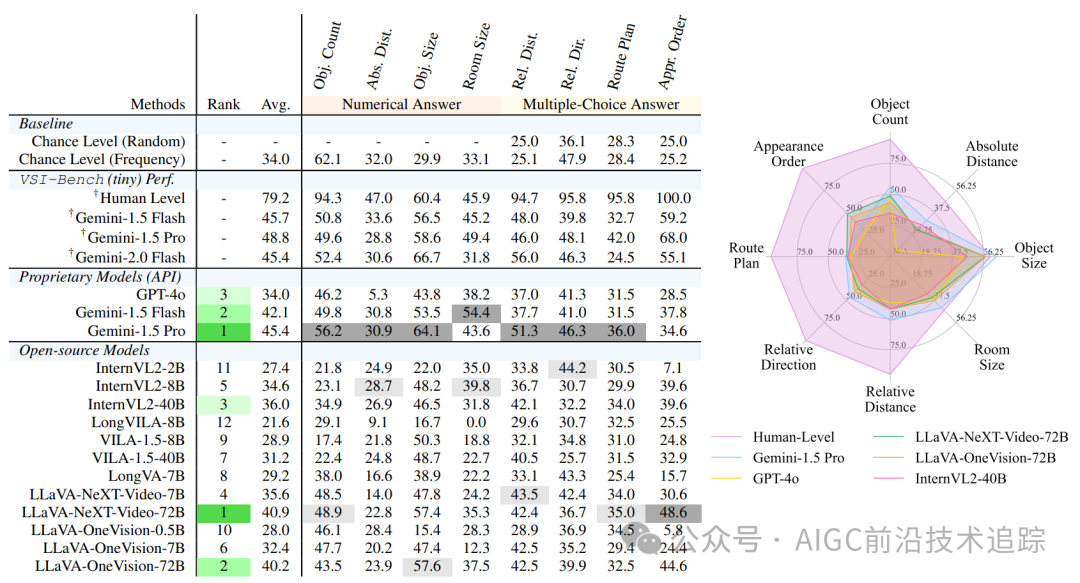

基準模型的廣泛涵蓋:全面評估了 15 個涵蓋不同家族、參數規模和訓練方法的視頻支持 MLLMs,包括專有模型如 Gemini1.5 和 GPT-4o,以及開源模型如 InternVL2、ViLA 等,確保評估的全面性和代表性。

指標設計的合理考量:根據答案類型采用不同評估指標。選擇題答案(MCA)任務使用準確率(ACC),基于精確匹配(可含模糊匹配)計算;數值答案(NA)任務采用平均相對準確率(MRA),通過考慮相對誤差率來衡量模型預測的準確性,以適應不同類型問題的評估需求。

基線設置的有效參照:設置Chance Level (Random) 作為 MCA 任務隨機選擇答案的準確率基線,Chance Level (Frequency) 為選擇每個任務最頻繁答案的準確率基線,為模型性能評估提供清晰的參照標準。

結果分析

人類水平與模型的對比洞察:人類評估者在基準測試中平均準確率達 79%,在配置和時空任務上表現卓越,準確率在 94% - 100%之間,體現了人類在視覺空間智能方面的優勢。在測量任務中,人類與最佳 MLLM 的差距相對較小,表明 MLLMs 在定量估計方面有一定潛力,但仍需提升。

專有與開源模型的差異解讀:專有模型 Gemini1.5 Pro 表現突出,雖與人類有差距,但遠超基線水平,在絕對距離和房間大小估計等任務中接近人類表現,得益于其強大的研發資源和架構。開源模型中,部分頂級模型如 LLaVA-NeXT-Video-72B 和 LLaVA-OneVision-72B 有競爭力,僅落后 Gemini1.5 Pro 4%-5%,但多數開源模型(7/12)低于基線水平,反映出開源模型在視覺空間智能方面的局限性。

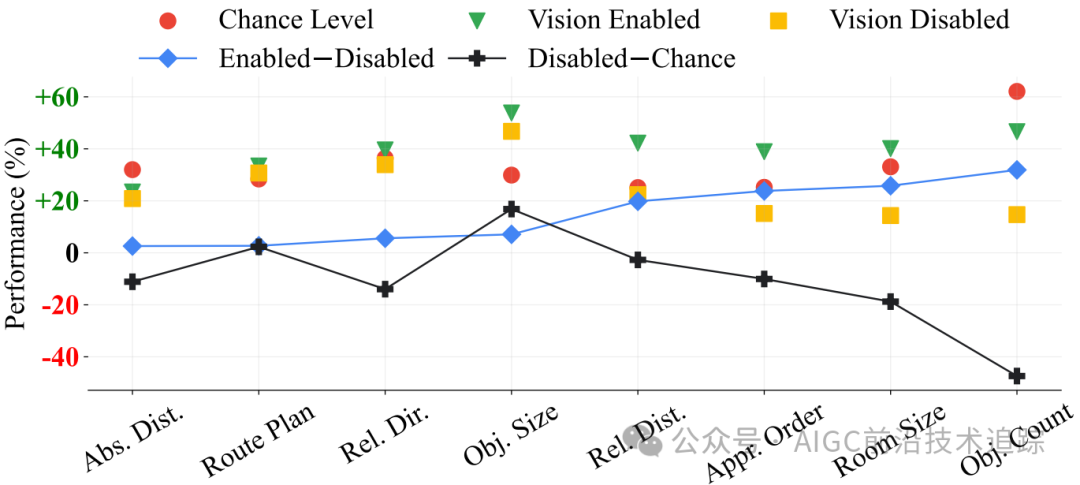

視覺信息影響的顯著發現:對比視覺啟用、禁用和基線水平結果發現,視頻對任務至關重要,視覺啟用模型性能優于禁用模型,而禁用模型低于基線水平。在絕對距離估計、路線規劃和相對方向等任務中,MLLMs 即使有視覺信息也難以超越基線,凸顯這些任務的難度。

5.MLLMs 的語言空間推理機制探究與瓶頸剖析

通過自我解釋揭示推理過程

案例研究的深刻啟示:以 Gemini1.5 Pro 為例,在成功案例中,模型展示出較強的視頻理解和語言推理能力,能準確描述視頻信息并構建合理推理步驟,如在相對方向任務中正確判斷物體方位。但在錯誤案例中,常出現自我中心 - 客體中心轉換和關系推理錯誤,表明模型在復雜空間推理上存在不足。

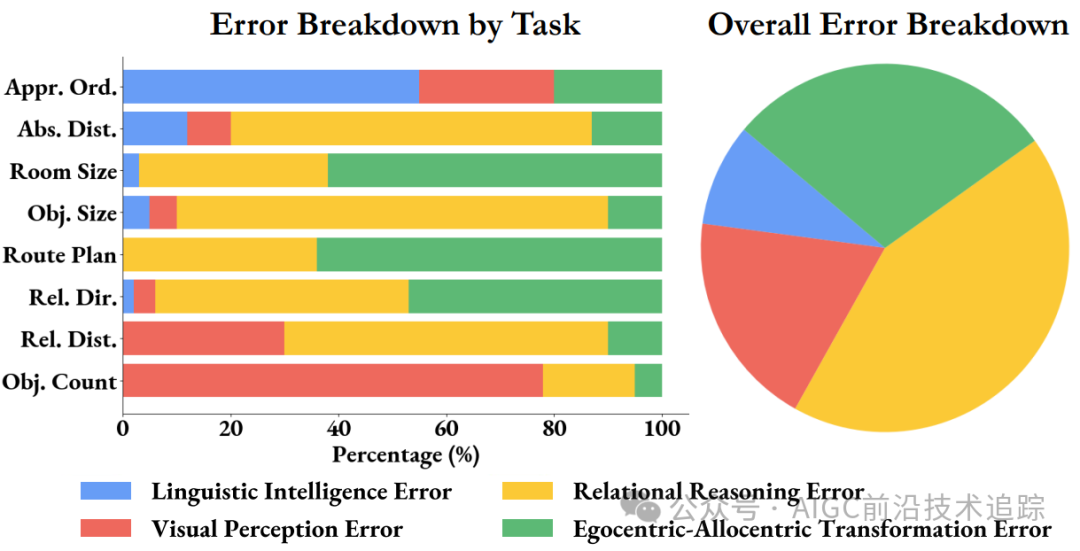

錯誤類型的詳細分析:對 Gemini1.5 Pro 在 VSI - Bench(tiny)上的錯誤分類分析發現,約 71%的錯誤源于空間推理能力缺陷,其他包括視覺感知、語言智能和自我中心-客體中心轉換錯誤,但空間推理錯誤占主導,成為 MLLM 性能提升的關鍵瓶頸。

CoT 方法

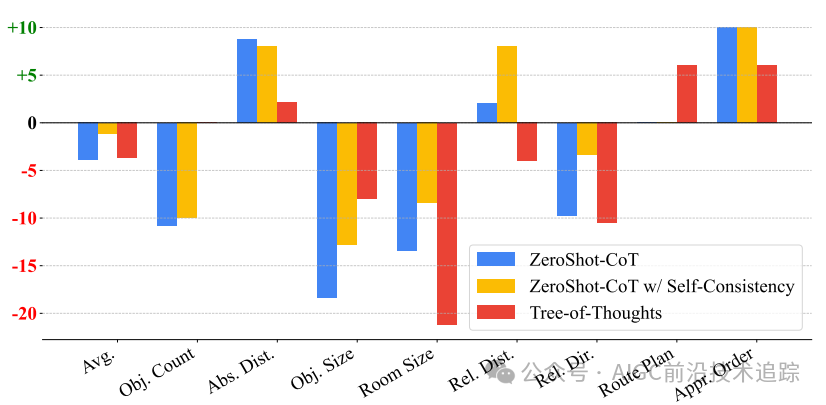

研究三種語言提示技術【零樣本思維鏈(CoT)、自一致性 CoT 和思維樹(ToT)】發現,它們在 VSI-Bench 上平均導致性能下降。雖在部分任務有輕微提升,但在房間大小和物體大小等任務中大幅下降,說明在視覺空間推理任務中,單純依靠語言提示技術提升模型性能不可行,與傳統語言推理任務有顯著差異。

6.創新方法與效果評估MLLMs 的視覺空間記憶與認知地圖

通過認知地圖探索空間記憶

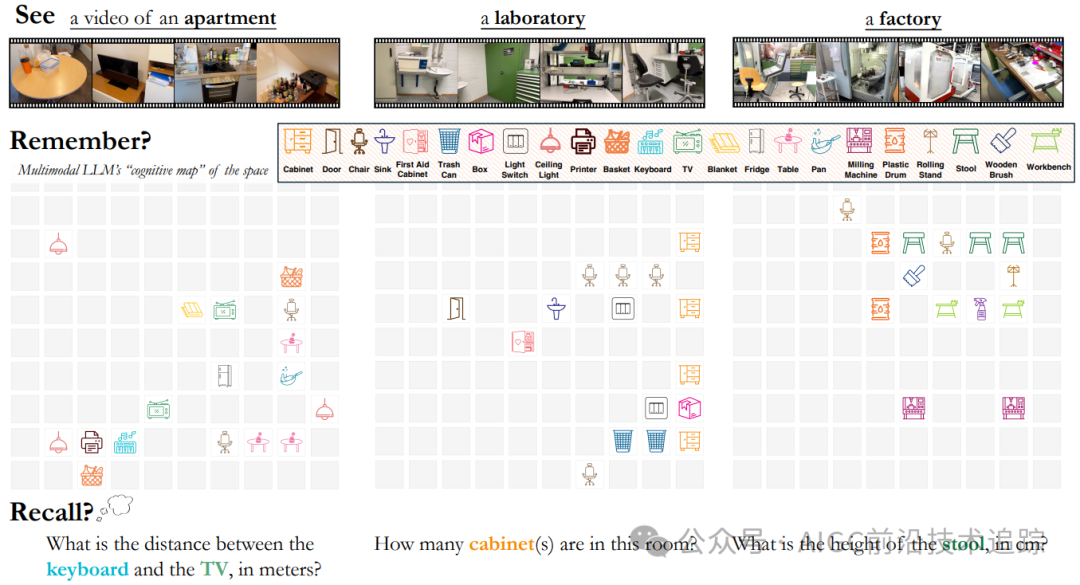

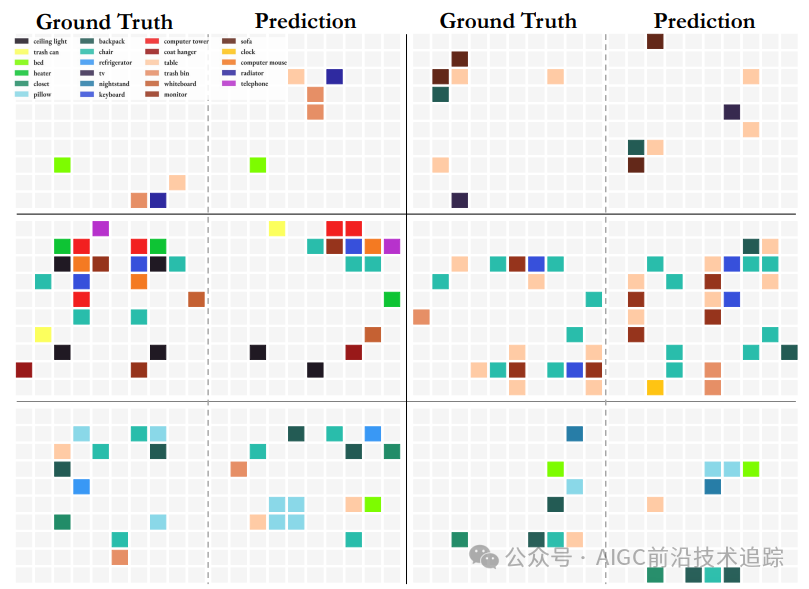

認知地圖生成的獨特方式:提示 Gemini1.5 Pro 根據視頻在 10×10 網格中預測物體中心位置生成認知地圖(見圖 10),模擬人類構建空間認知的過程,以探究模型如何在內部表示空間信息。

局部空間意識的精準評估:通過計算認知地圖中物體間歐幾里得距離并與真實地圖比較,發現 MLLMs 定位相鄰物體準確率達 64%,表明有一定局部空間意識。但隨著物體距離增加準確率下降,說明模型構建全局空間模型困難,多形成局部世界模型(見圖 11)。

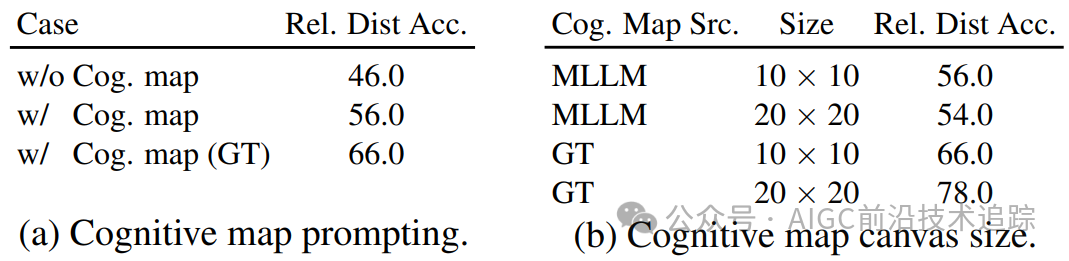

利用認知地圖提升距離推理能力的效果

實驗表明,讓 Gemini1.5 Pro 先生成認知地圖再回答相對距離問題,準確率提高 10%(見表 3)。這顯示認知地圖能輔助模型進行更準確的距離推理,為提升 MLLMs 視覺空間智能提供了新途徑。

7.相關工作

具有視覺空間意識的 MLLMs

近年來,MLLMs 借助 LLMs 的語言和推理能力及視覺編碼器的特征提取能力,在視覺理解上取得進展。但在應用于現實世界視覺空間任務時仍面臨諸多挑戰,如準確感知和理解空間信息。本文與以往關注 2D 圖像或純語言的研究不同,采用真實視頻評估模型,更貼合實際應用場景。

MLLMs 在視頻上的基準測試

隨著 MLLMs 在靜態圖像任務的出色表現,其視頻理解能力評估受關注。已有 Video-MME、EgoSchema 和 OpenEQA 等基準測試,但多側重內容級理解,缺乏 3D 空間考慮。本文的 VSI-Bench 填補了這一空白,為研究 MLLMs 視覺空間能力提供了重要工具。

8.討論與未來工作

通過 VSI-Bench 對 MLLMs 的研究發現,其在視覺空間智能方面有優勢也有瓶頸。雖在感知、時間處理和語言能力上有表現,但空間推理能力尤其是自我中心-客體中心轉換和關系推理能力亟待提高。

當前語言提示方法對空間推理效果不佳,但認知地圖為提升空間距離推理能力帶來希望。未來可從特定任務微調、開發空間推理自監督學習目標和設計視覺空間提示技術等方向努力,推動 MLLMs 在視覺空間領域取得更大突破,為人工智能發展注入新動力。

論文地址:??https://arxiv.org/pdf/2412.14171??

Thinking in Space: How Multimodal Large Language Models See, Remember, and Recall Spaces

代碼地址:

??https://github.com/vision-x-nyu/thinking-in-space??

原文鏈接:

??https://www.yuque.com/u21774036/qnmlr1/ecqfh7gtbquvvwk5?#《李飛飛:通過「空間智能」重構世界》??

本文轉載自??AIGC前沿技術追蹤??,作者: 愛讀論文的吳彥祖 ????