華為諾亞方舟實驗室突破具身AI瓶頸, SpatialCoT通過坐標對齊和思路鏈推進空間推理

具身人工智能的目標是使機器人或虛擬代理能夠像人類一樣理解和操作其所在的物理環境,而空間推理被視為實現具身任務規劃的關鍵能力。導航和操作任務是具身AI中常見的挑戰,依賴于模型對空間關系的理解和高效執行復雜任務的能力,但現有方法在處理復雜空間推理任務時仍面臨諸多局限,難以滿足實際應用的需求。

現有方法大多通過補充空間數據和模型微調來提升空間推理能力,可是這些方法主要依賴于語言生成的粗粒度結果,難以在復雜環境中管理更精細的任務。一些方法引入了基于點的動作空間來緩解這一問題,但在處理復雜任務時仍存在明顯不足,原因在于未充分利用視覺語言模型固有的思維和推理能力。另外,現有模型主要在配有文本的2D圖像數據上訓練,缺乏理解空間關系所需的信息。

為了解決上述問題,華為諾亞方舟實驗室提出了一種新方法SpatialCoT,目標是增強視覺語言模型(VLMs)的空間推理能力。SpatialCoT由兩個主要階段組成:空間坐標雙向對齊和鏈式思維空間定位。通過這些階段,模型能夠更好地理解和生成坐標基于的響應,并利用語言模型的推理能力進行高級空間推理。實驗結果表明,SpatialCoT在導航和操作任務中顯著優于之前的最先進方法。研究團隊的相關論文《SpatialCoT: Advancing Spatial Reasoning through Coordinate Alignment and Chain-of-Thought for Embodied Task Planning》近日發表于 arXiv,引起業內廣泛關注。

研究團隊是由來自華為諾亞方舟實驗室的一組杰出研究人員組成,包括Yuecheng Liu, Dafeng Chi, Shiguang Wu, Zhanguang Zhang, Yaochen Hu, Lingfeng Zhang, Yingxue Zhang, Shuang Wu, Tongtong Cao, Guowei Huang, Guangjian Tian, Xingyue Quan, Jianye Hao和 Yuzheng Zhuang。華為諾亞方舟實驗室是華為旗下專注于人工智能和機器學習研究的機構,致力于推動前沿技術的發展,特別是在視覺語言模型和具身人工智能等領域的創新與應用。團隊成員在各自領域擁有豐富的研究經驗和專業知識,共同推動了SpatialCoT的開發和應用。

這些研究人員在視覺語言模型、具身AI和空間推理領域積累了豐富的經驗和深厚的知識基礎。他們的合作與研究不僅推動了理論的發展,也對實際應用產生了重要影響。通過他們的不懈努力,SpatialCoT為具身任務規劃提供了一個創新的解決方案,展示了其在復雜環境中處理導航和操作任務的巨大潛力。

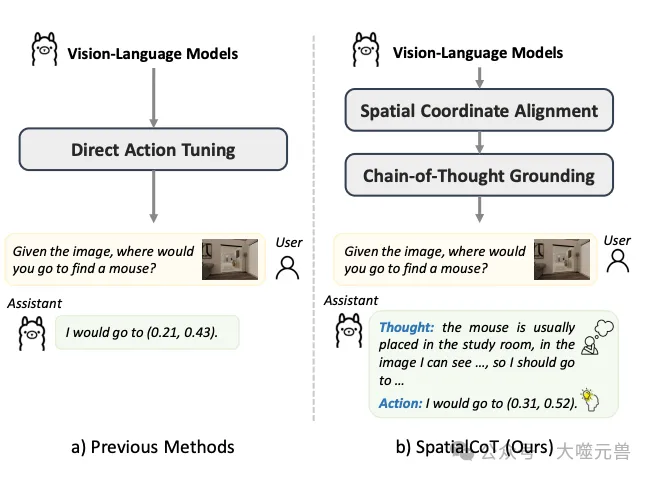

圖1:SpatialoT與以前方法的比較。a) 以前的方法通常直接根據語言指令輸出動作。b) SpatialoT通過有效利用VLM的推理能力來提高動作生成質量。這是通過兩個階段的微調過程實現的,涉及空間坐標對齊和思維鏈空間基礎。

這篇論文的貢獻不僅在于提出了一種新的空間推理方法,更在于其對未來研究方向的引領和啟發。隨著技術的不斷進步,SpatialCoT方法有望在更多實際應用中發揮重要作用,為機器人和智能代理的自主性和智能化提供堅實的技術支持。

方法介紹

空間坐標雙向對齊

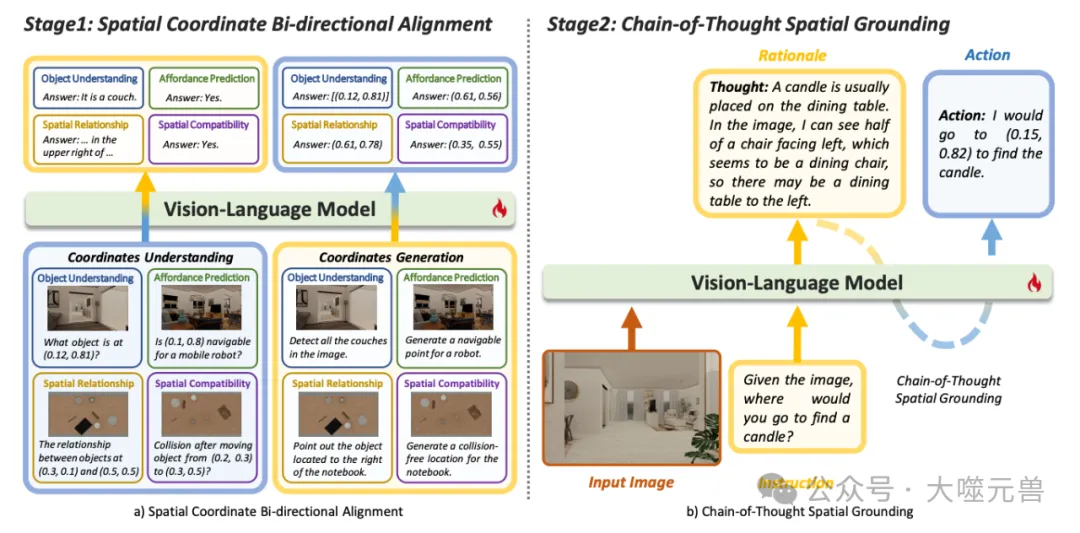

圖2:SpatialIoT概述,包括兩個核心階段。a) 空間坐標雙向對齊,包括將坐標轉換為語言(由左側的藍色到黃色箭頭表示)和語言轉換為坐標(由右側的黃色到藍色箭頭表示)。b) 思維鏈空間接地:該模型首先通過生成基于語言的基本原理進行綜合思維,然后將其接地為基于坐標的動作(黃色到藍色虛線),顯著提高了模型在復雜空間推理任務中的性能。

空間坐標雙向對齊是SpatialCoT方法的第一個核心階段。其主要目的是通過明確對齊視覺-語言輸入與空間坐標,從而增強模型的空間理解和響應生成能力。具體而言,這一階段涉及將圖像和文本描述與具體坐標進行雙向映射,使模型能夠更精準地理解和生成基于坐標的反饋。

空間坐標雙向對齊通過兩種形式的數據對齊實現。第一種形式是將圖像與包含坐標的文本指令進行配對,模型需輸出指令中描述坐標的相關信息。第二種形式是將圖像與不含坐標的語言指令進行配對,模型需生成一個或多個坐標來指示指令中描述的位置或區域。

圖3:思維鏈空間接地的數據采集管道。

在圖像與坐標的雙向對齊機制中,首先將視覺-語言數據與坐標進行顯式對齊,這一過程通過設計不同類型的數據(如對象理解、可用性預測、空間關系和空間兼容性)來實現。通過雙向對齊,使得模型不僅能根據坐標理解文本描述,還能根據文本描述生成準確的坐標。

在具體數據處理過程中,模型需要處理兩種主要的數據形式。一種是圖像與包含具體坐標的文本描述配對,另一種是圖像與不包含坐標的文本描述配對。具體示例如“圖像中物體位于(0.81, 0.90)的位置”以及“請指出圖像中所有椅子的位置”,前者要求模型理解并生成關于坐標的反饋,而后者則要求模型生成對應的坐標。

鏈式思維空間定位

鏈式思維空間定位是SpatialCoT的第二個核心階段,旨在通過語言模型的推理能力進行高級空間推理。不同于直接生成基于坐標的動作,這一階段通過語言推理過程將復雜的空間推理問題逐步分解,生成細粒度的動作計劃。

鏈式思維空間定位通過生成包含推理過程和具體動作的數據來實現。首先,模型需生成基于任務的推理過程,利用語言空間中的推理能力進行任務指導。然后,模型基于推理過程生成對應的基于坐標的動作。這一過程通過在前一階段對齊的語言和坐標數據中實現,無需大量的微調數據。

在這一階段,模型通過內在推理能力進行復雜的空間定位。模型首先生成任務的推理過程,利用語言模型中的空間和常識推理能力,指導任務的完成。然后,基于推理過程生成相應的坐標動作,實現高級空間推理任務的解決。

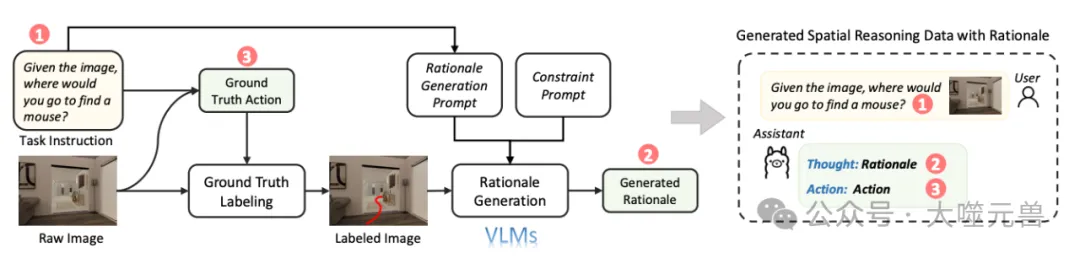

為了高效地生成高質量的推理-動作數據對,我們設計了一條自動化數據生成流水線。初始階段,基于圖像和任務指令從模擬器中獲取真實動作,并在圖像上進行標注。接著,利用強大的視覺語言模型生成基于動作標注圖像和任務指令的推理過程,并通過加入額外的約束來確保推理過程的有效性。最終,通過微調模型,使其能夠高效處理復雜的空間推理任務。

實驗設計

SpatialCoT的方法通過一系列精心設計的實驗驗證了其在具身任務中的有效性。

圖4:現實世界的重排實驗,SpatialoT將各種對象組合排列成合理的布局,遵守物理約束并避免碰撞。

研究團隊采用閉環具身任務規劃的方法,通過在模擬器中進行任務設置和評估,全面考察SpatialCoT在導航和操作任務中的表現。任務設置包括狀態、目標、動作和轉換的具體設置,以確保任務的復雜性和真實性。

狀態、目標、動作、轉換的具體設置

在狀態方面,研究團隊主要考慮了視覺遮擋、物體堆疊和封裝遮擋等因素。此外,還涉及物體屬性如幾何形狀和可移動性。目標設置包括物體數量、空間約束和目標描述的抽象程度。動作設置則考慮了動作空間的格式和所需技能的數量。轉換方面,研究團隊處理了環境的動態不確定性,通過不同復雜度的層次進行任務分解。

導航任務和操作任務的詳細描述

導航任務采用了更具挑戰性的目標物體導航評估任務。與傳統的區域定位任務不同,目標物體導航要求模型生成最佳的次目標點,以盡快找到不在視野內的目標物體。例如,模型需要根據圖像生成最佳路徑點,以找到目標物體的位置。

操作任務采用了餐桌功能重排評估任務,這是對RoboPoint任務的進一步擴展。給定一個目標布局描述,模型需要逐步生成每個物體的起始和結束位置,直到達到期望的布局。例如,模型需要根據語言指令逐步將餐桌上的物品擺放到指定位置。

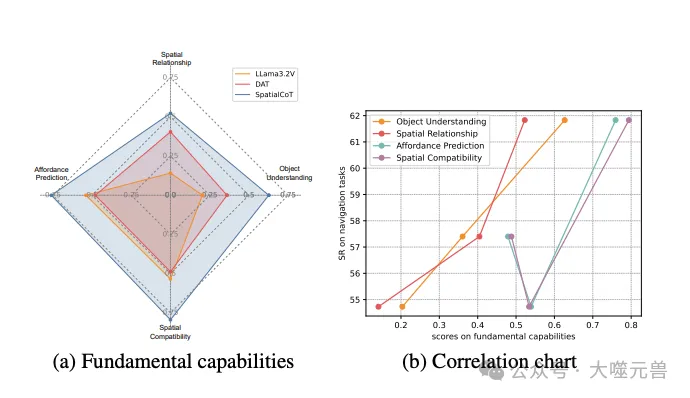

基本能力評估

除了具身任務規劃,研究團隊還評估了視覺語言模型的基本能力,以理解這些能力與任務規劃性能之間的關系。這些基本能力包括對象理解、可用性預測、空間關系和空間兼容性。

- 對象理解:匹配自然語言描述與圖像中的具體視覺內容。

- 可用性預測:識別和預測環境中可執行的動作,如確定可導航區域或如何操作物體。

- 空間關系:理解物體之間的空間關系。

- 空間兼容性:預測和理解物體之間的兼容性。

實驗設置

數據收集方面,研究團隊使用了兩個主要場景數據集。導航任務的數據收集依賴于Habitat合成場景數據集(HSSD),并使用Habitat作為模擬器進行閉環模型評估。操作任務的數據收集則使用Sapien作為模擬器,生成多樣的桌面重排任務和數據。為了提高視覺真實度并減少模擬與現實的差距,研究團隊使用Blender渲染器獲取高質量圖像進行數據收集。

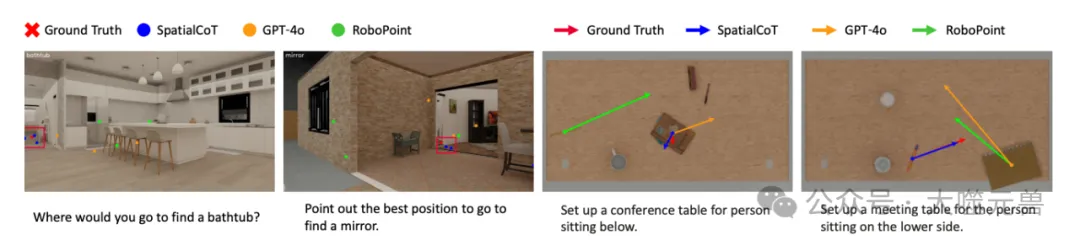

圖5:導航和操縱任務中空間推理結果的可視化

數據生成和處理

數據生成過程中,研究團隊通過大語言模型的強大生成能力,半自動化地構建桌面功能重排任務的數據。此外,通過引入高質量數據進行模型微調,使得SpatialCoT在復雜環境中的表現更加穩定和出色。

模型訓練

在模型訓練過程中,研究團隊選擇了Llama3.2-Vision 11B作為視覺語言模型的骨干。訓練方法包括使用LoRA進行微調,整個訓練過程分為兩個階段,每個階段進行了2個epoch的訓練。所有實驗在配備8塊NVIDIA L40 GPU的單臺機器上進行,確保了訓練的高效和穩定。

對比基線

為了驗證SpatialCoT的有效性,研究團隊將其與多個基線模型進行對比。這些基線模型包括專門的空間推理模型RoboPoint、開源視覺語言模型LLaMA3.2V以及閉源模型GPT-4o。通過對比這些基線模型,研究團隊全面評估了SpatialCoT在不同任務和環境中的性能表現。

實驗結果

通過一系列實驗,SpatialCoT展示了其在導航和操作任務中的顯著優勢。

導航任務結果

在導航任務中,研究團隊引入了兩個關鍵指標:距離增益(DG)和成功率(SR)。距離增益衡量生成動作的質量,成功率則評估模型在模擬器內的整體表現。

在比較不同基線模型時,GPT-4o ICL和Llama3.2V 11B零樣本的距離增益分別為-0.27和-2.47,表明這些模型生成的動作質量低于平均水平。而RoboPoint模型的距離增益為0.21,盡管有所提升,但仍不足以應對需要高推理能力的復雜任務。采用直接在動作生成數據上微調模型的方法,距離增益達到了2.28。通過加入空間坐標雙向對齊,這一數值進一步提高到3.23,而鏈式思維空間定位則將其提升至2.83。當結合這兩個階段時,距離增益達到了3.33,相比直接動作微調提升了46%。

在成功率方面,SpatialCoT達到了61.83%,相比直接動作微調提高了4.43%,并且在所有評估的開源和閉源模型中表現最佳。

操作任務結果

在操作任務中,研究團隊引入了碰撞率(CR)和成功率(SR)作為評估指標。碰撞率衡量生成動作的有效性,成功率則評估任務在指令描述和無碰撞條件下的完成情況。

零樣本評估中,先前模型的成功率為零,主要由于碰撞率較高。而直接動作微調將碰撞率降至21.3%,成功率提高至75.8%。SpatialCoT進一步改進了這些指標,碰撞率降至15.6%,成功率提高到82.6%,表明在端到端任務成功率上有顯著提升。

問題分析

圖6:分析VLM的基本能力和具體任務規劃之間的相關性,DAT表示直接動作調整。

通過對具體任務規劃的分析,研究團隊發現SpatialCoT在高復雜度任務中表現尤為出色。操作任務中,主要的失敗來源于非獨特物體和大量物體的處理,這些場景容易導致碰撞。而在導航任務中,SpatialCoT在需要稀疏獎勵信號的任務中表現尤為突出,特別是在目標較少且距離較大的復雜任務中表現顯著提高。

對基本能力與下游任務性能的相關性分析顯示,SpatialCoT在所有評估類別中均優于其他模型。特別是對象理解和空間關系這兩個類別顯示出明顯的正相關關系,表明這些基本能力對模型在具體任務中的表現具有重要影響。

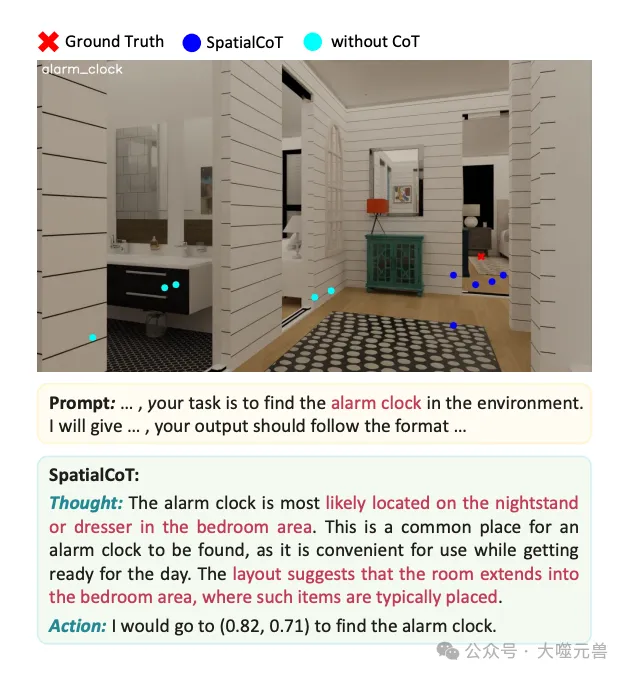

圖7:思維鏈空間基礎案例研究。

鏈式思維對空間推理能力的貢獻也在實驗中得到驗證。通過鏈式思維過程,模型能夠更好地利用空間和上下文信息,如房間布局和常識知識,以得出正確答案。例如,在尋找鬧鐘的任務中,SpatialCoT首先考慮鬧鐘的典型位置,然后根據布局推斷臥室位置,最終生成準確結果。而基線模型在沒有鏈式思維的情況下,生成的結果則較為無序。

方法的局限性

雖然SpatialCoT在許多方面展示了其強大的空間推理能力,但仍有一些局限性需要注意。

處理復雜動作(如旋轉)的局限

首先,SpatialCoT的方法主要基于坐標的動作生成,這使得其在處理某些復雜動作時顯得力不從心,特別是涉及物體旋轉的任務。具體來說,當前的方法未能有效處理需要精確控制物體旋轉角度的任務,這在實際應用中可能導致一些局限。例如,在需要機器人旋轉物體以便更好地定位或操作時,SpatialCoT的模型可能無法生成足夠精確的動作指令。這一局限性限制了模型在某些復雜場景中的應用,因此未來的研究需要進一步探索和解決這一問題。

對3D輸入的依賴和未來研究方向

另一個需要注意的局限性是SpatialCoT目前依賴于2D圖像作為視覺輸入。雖然2D圖像在許多場景中已經能夠提供足夠的信息,但在更大、更復雜的空間中,3D輸入的需求變得尤為重要。3D輸入可以提供更豐富的空間信息,使模型能夠更準確地理解和導航復雜環境。然而,引入3D輸入也帶來了新的挑戰,包括更高的數據處理復雜度和計算資源需求。因此,未來的研究應當探索如何有效地利用3D輸入來提升模型的空間推理能力。

結論

SpatialCoT方法的創新點在于它結合了空間坐標雙向對齊和鏈式思維空間定位兩大核心技術,以增強視覺語言模型的空間推理能力。這種方法通過明確對齊視覺-語言輸入與空間坐標,使模型能夠更精準地理解和生成基于坐標的響應。同時,通過引入鏈式思維,使模型能夠利用語言推理能力進行高級空間推理,從而更好地解決復雜的具身任務。

研究結果表明,SpatialCoT在導航和操作等復雜具身任務中的表現顯著優于現有的最先進方法。在導航任務中,SpatialCoT在距離增益和成功率兩個關鍵指標上均取得了優異的成績,展示了其在生成高質量動作方面的能力。在操作任務中,SpatialCoT在碰撞率和成功率上均表現出色,進一步證明了其在復雜場景中執行精細操作的能力。

盡管SpatialCoT已經展示了其強大的空間推理能力,但仍存在一些需要進一步研究的領域。未來的研究可以探索如何更好地處理復雜動作(如物體旋轉),以增強模型在實際應用中的適用性。此外,雖然當前的方法主要依賴于2D圖像作為視覺輸入,但隨著技術的發展,探索3D輸入的潛力也將成為未來研究的一個重要方向。3D輸入可以提供更豐富的空間信息,使模型能夠更準確地理解和操作復雜環境,但同時也帶來了更高的數據處理復雜度和計算資源需求。(END)

參考資料:https://arxiv.org/abs/2501.10074

本文轉載自??大噬元獸??,作者: FlerkenS ????