只需50美元!最簡單的推理擴展方案,效果媲美o1!

這個工作目標是,找到一種簡單的方法,可以實現test-time scalling。

關鍵點有2個,構建高質量的監督數據1k,用于監督微調;一個Budget Forcing的方法,用于限定模型的推理過程。

經過這么一折騰,模型的性能隨著推理token數量變長而編號。

- 如何構建高質量的1k數據

- 初始收集:從 16 個不同的來源收集了 59,029 個問題,包括 NuminaMATH、AIME、OlympicArena、OmniMath、AGIEval 等。

- 最終篩選:通過質量、難度和多樣性三個標準,從 59K 個問題中篩選出 1,000 個樣本。具體步驟包括:

質量:去除格式錯誤或低質量的樣本。

難度:根據模型性能和推理長度評估問題難度,去除模型能正確解答的問題。

多樣性:使用 Claude 3.5 Sonnet 將問題分類到不同的領域,確保樣本覆蓋廣泛的學科。

- Budget Forcing (通過在測試時強制設定最大或最小思考 token 數量來控制模型的推理過程)

強制最大思考 token 數量:如果模型生成的思考 token 超過設定的上限,強制結束思考過程,并追加“Final Answer:”以提供當前最佳答案。

強制最小思考 token 數量:如果模型試圖結束思考過程,抑制思考結束 token 的生成,并在當前推理軌跡后追加“Wait”,鼓勵模型繼續思考。

消融實驗:

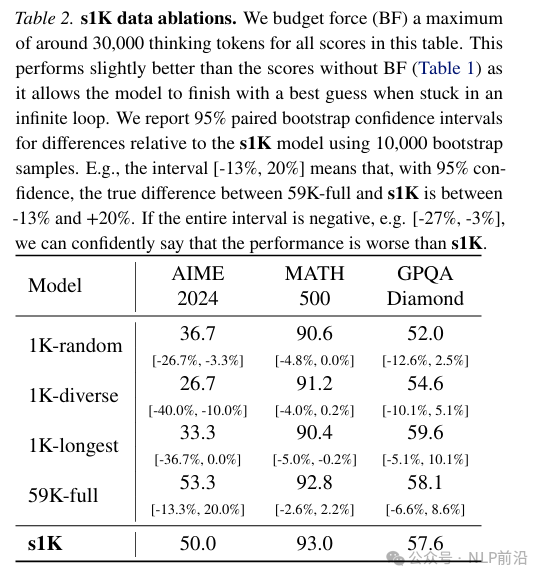

數據量、多樣性和難度:通過隨機選擇、僅選擇最長推理軌跡或僅最大化多樣性來構建數據集,測試結果表明這些方法的性能均低于結合質量、難度和多樣性的方法。

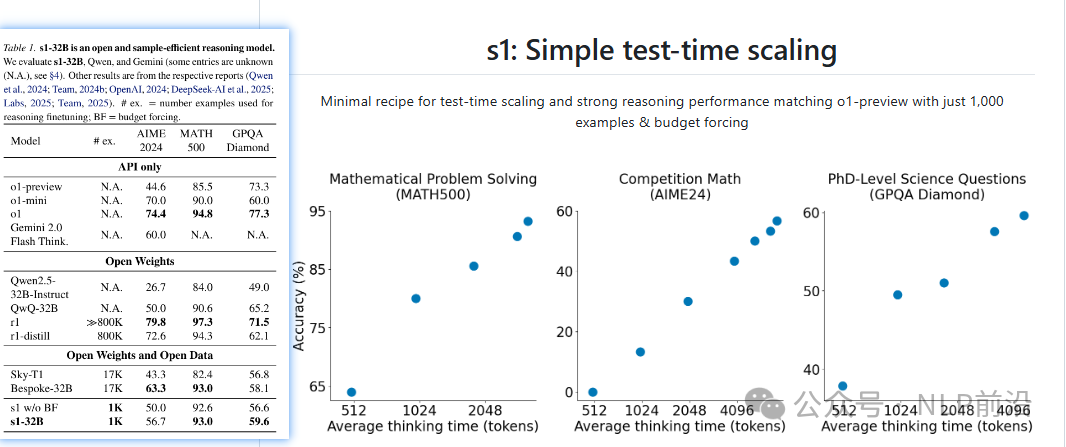

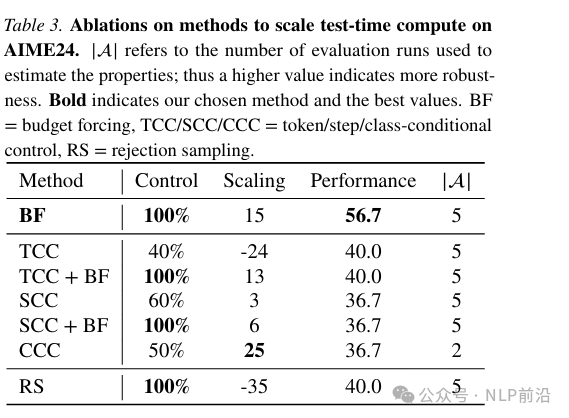

測試時擴展方法:比較了Budget Forcing、條件長度控制和拒絕采樣等方法,發現Budget Forcing在控制性和性能上表現最佳。

最后,整個過程證明了通過簡單的測試時擴展方法,使用少量數據即可實現強大的推理性能。s1-32B 模型在多個基準測試中表現出色,超越了閉源模型如 OpenAI 的 o1-preview。

本文轉載自??NLP前沿??,作者: 獼猴桃

已于2025-2-7 15:40:45修改

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦