CVPR 2025 | 多模態六邊形戰士Magma:會點按鈕會搬磚,標注竟讓AI長出"時空大腦"

文章鏈接:https://www.arxiv.org/pdf/2502.13130

項目鏈接:https://microsoft.github.io/Magma/

模型鏈接:https://huggingface.co/microsoft/Magma-8B

亮點直擊

- 提出了Magma,第一個不僅具備多模態理解能力,還具備空間-時間推理能力的基礎模型,能夠在數字和物理環境中完成智能體任務。

- 提出了使用Set-of-Mark (SoM)和Trace-of-Mark (ToM)技術,顯著增強了空間-時間智能,用于行動定位和規劃,并使Magma能夠在大規模異構數據集上進行有效的預訓練。

- 構建了一個大規模的預訓練數據集,其中不僅包含開源的多模態視覺-語言(VL)數據集,還包括UI數據、機器人數據以及通過SoM和ToM自動標注的人類教學視頻。訓練語料庫總共包含約3900萬個多樣化的樣本。

- 廣泛評估了預訓練的Magma模型,展示了其在廣泛任務中的卓越性能。Magma通過單一參數配置,在機器人操作和UI導航任務上均超越了開源模型,達到了新的SOTA水平。

- 展示了所提出的Magma預訓練方法顯著提升了模型的語言智能和空間-時間智能能力。

總結速覽

解決的問題

- 多模態理解與行動的分離:現有的視覺-語言-行動(VLA)模型通常在特定任務上表現良好,但在跨任務和跨領域的泛化能力上表現有限。這些模型往往在特定任務上學習行動策略,而犧牲了通用的多模態理解能力。

- 環境差異帶來的挑戰:2D數字世界和3D物理世界之間的差異使得VLA模型通常需要分別訓練,難以在多個環境中通用。

- 數據集之間的差距:多模態理解(主要是文本描述)與行動任務(主要是空間坐標)之間存在顯著差距,導致直接結合數據集難以提升模型性能。

提出的方案

- Magma基礎模型:提出了一個多模態AI智能體的基礎模型Magma,旨在同時具備多模態理解和多模態行動預測能力。

- Set-of-Mark (SoM) 和 Trace-of-Mark (ToM):通過SoM標記圖像中的可操作視覺對象(如GUI中的可點擊按鈕),通過ToM標記視頻中的對象運動軌跡(如人手或機械臂的軌跡),將圖像和視頻數據集轉化為“視覺-語言-行動”數據,以彌合不同任務類型之間的差距。

- 統一訓練:通過大量異構數據集(包括UI數據集、機器人操作數據集、人類教學視頻等)進行統一訓練,使模型能夠在零樣本情況下應用于不同的下游任務。

應用的技術

- 多模態理解:模型能夠理解來自不同領域(數字和物理)的多模態輸入,不僅在語義上,還在空間和時間上。

- 多模態行動預測:模型能夠將長時程任務分解為準確的行動序列,并由AI智能體系統有效執行。

- SoM和ToM:通過SoM和ToM標記技術,將圖像和視頻數據集轉化為可用于行動任務的數據,提升模型的空間-時間智能。

達到的效果

- 新SOTA結果:Magma在UI導航和機器人操作任務上創造了新的SOTA結果,超越了專門針對這些任務的模型。

- 廣泛適用性:Magma在圖像和視頻相關的多模態任務上也表現出色,與訓練在更大數據集上的大型多模態模型相比具有競爭力。

- 環境無關性:SoM和ToM技術環境無關,易于推廣到新的智能體任務,為使用大量未標記視頻(如原始教學視頻)擴展模型預訓練提供了有效且高效的方法。

多模態智能體建模

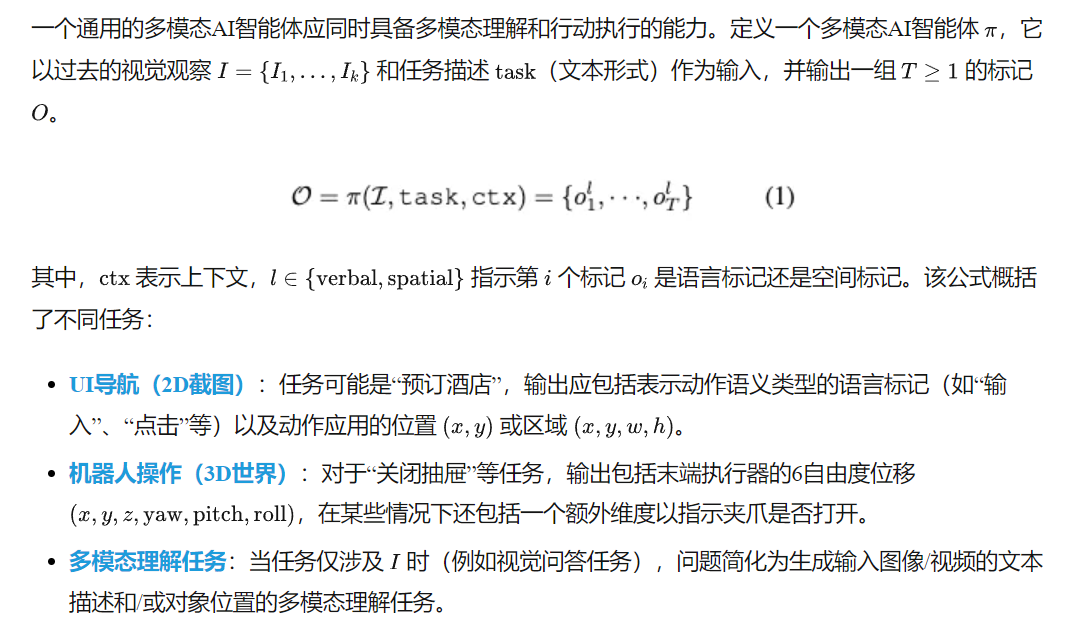

問題定義

對于這些看似不同的輸出模態,遵循一種常見做法,將所有輸出轉換為文本標記,以促進模型學習。將2D動作轉換為文本字典(如[19]),并使用大型語言模型(LLMs)中幾乎未使用的最后256個離散語言標記表示機器人動作。盡管這種統一到語言空間的方法簡化了學習,但我們注意到任務之間存在顯著沖突,實驗中將展示這一點。接下來,我們將討論如何緩解這些挑戰,以在廣泛的數據集上訓練智能體基礎模型。

方法

在構建多模態AI智能體的強大基礎時,解決了兩個關鍵挑戰:預訓練目標:如何構建統一的預訓練接口以促進聯合訓練?一種直接的方法是預測UI導航的2D坐標、末端執行器的3D位置以及多模態視覺-語言(VL)任務的常規文本輸出。然而,在實驗中,觀察到這些任務在輸入和輸出上存在固有的領域差距。前者導致像素級別的巨大搜索空間,后者直接預測本體感知動作的輸出,而未基于圖像觀察進行接地。我們能否設計一個智能體任務來彌合所有任務之間的差距?

數據擴展:現有的視覺-語言-動作數據在數量和多樣性上有限,與LLMs的語言數據或LMMs的圖像-文本語料庫不同。例如,最大的開源機器人數據集OXE 包含來自22個環境的約100萬條軌跡。另一方面,像LAION 這樣的大規模圖像-文本數據集幾乎不包含對動作預訓練有用的監督信息,因為它們都是靜態的,沒有動作的概念。然而,視頻描繪了大量的人類動作和人與物體的交互。我們能否充分利用這些視頻數據進行智能體預訓練?

本工作提出了一種簡單而有效的方法來解決上述挑戰。受Set-of-Mark (SoM) 提示 [126] 的通用性啟發,采用它來實現UI和機器人任務中的動作接地,因為模型在預測圖像空間中的可點擊按鈕或機器人手臂的數字標記時面臨的困難較小。我們進一步沿時間軸擴展它,要求模型預測**Trace-of-Mark (ToM)**,這迫使模型通過預測遠期的未來“動作”來學習更長的時間范圍,更重要的是,提供了一種有效利用未標記視頻數據的方法。SoM和ToM的結合實現了數字和物理領域中智能體任務的無縫協同,以及從原始視頻中提取“動作”監督的可擴展方法。

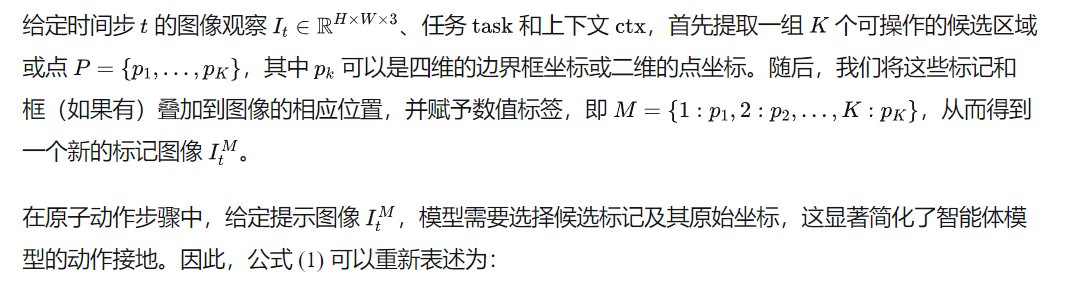

Set-of-Mark 用于動作接地

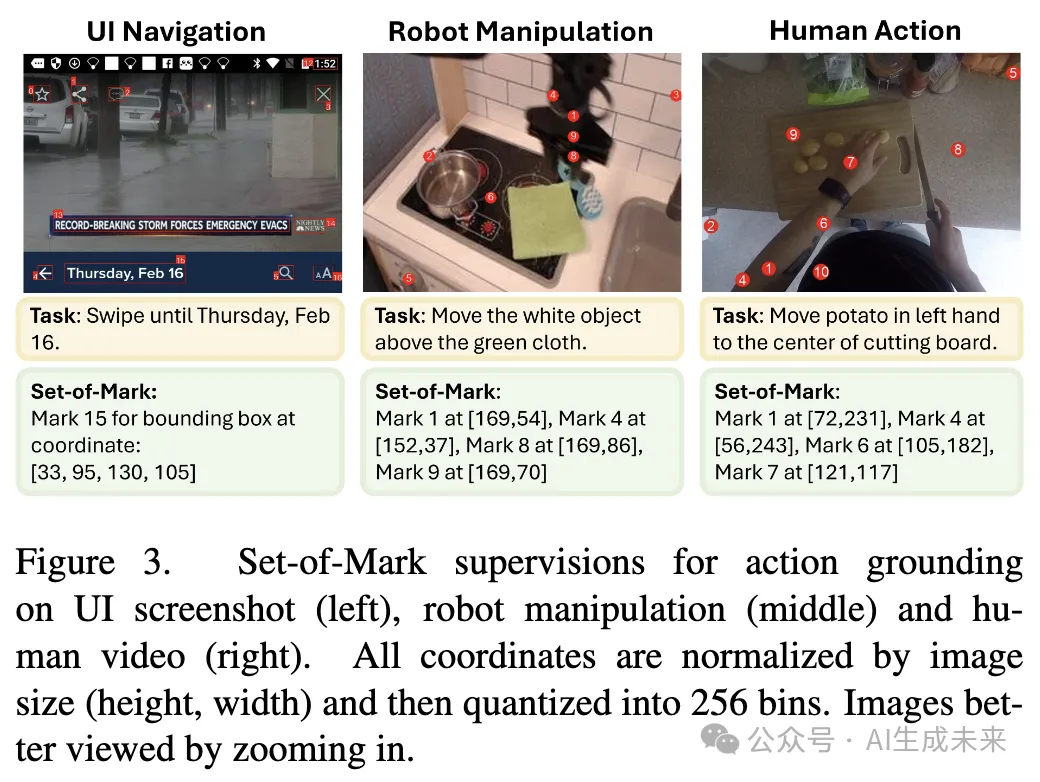

SoM提示最初是為了增強GPT-4V的接地能力而提出的,隨后被廣泛用于各種智能體任務。與之前利用它提示現成的LMMs以增強視覺-語言接地的工作不同,我們在此提出訓練一個智能體模型用于動作接地,即定位特定任務的可操作點/區域,并在需要時進一步預測原子動作。

其中 是標記

的一個子集。

在下圖3中,展示了一些實例,以演示基于SoM的動作接地(如下圖1所示)。為了獲得要標記的候選區域,可以利用不同的提議網絡,如圖像分割模型 、目標檢測模型或領域特定模型。

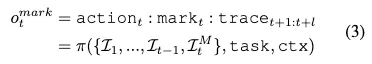

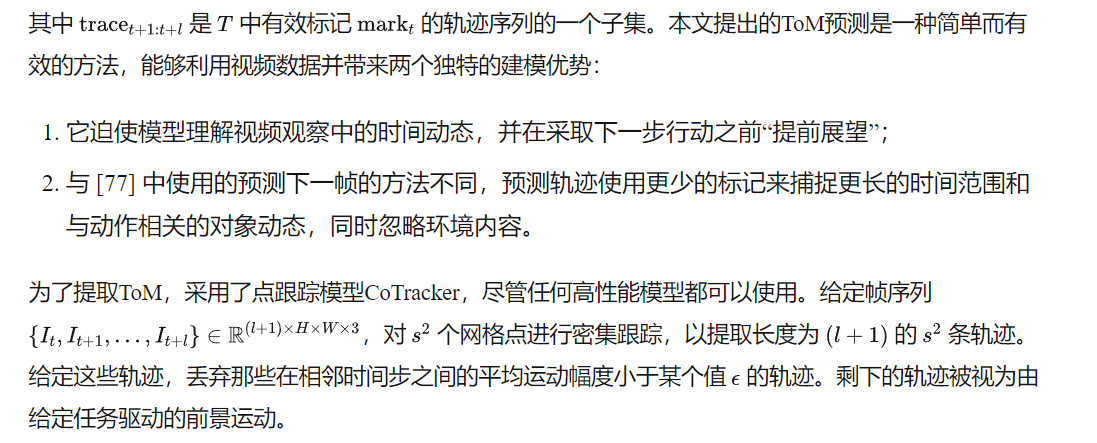

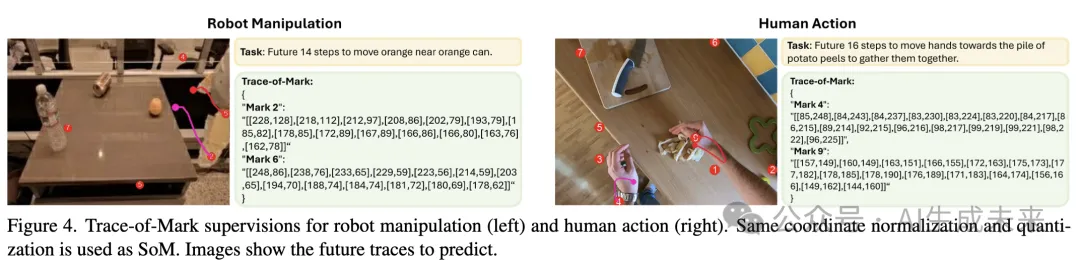

Trace-of-Mark 用于動作規劃

視頻數據包含大量關于人類動作和行為的信息,這些信息可以有效地用于提升智能體模型的能力。然而,由于缺乏動作標簽,之前的方法很少探索這一方向,除了一些專注于世界模型學習的工作。通過提出Trace-of-Mark (ToM),將“疊加標記”策略從靜態圖像擴展到動態視頻,使智能體模型能夠有效地從視頻中學習規劃和行動。

建模

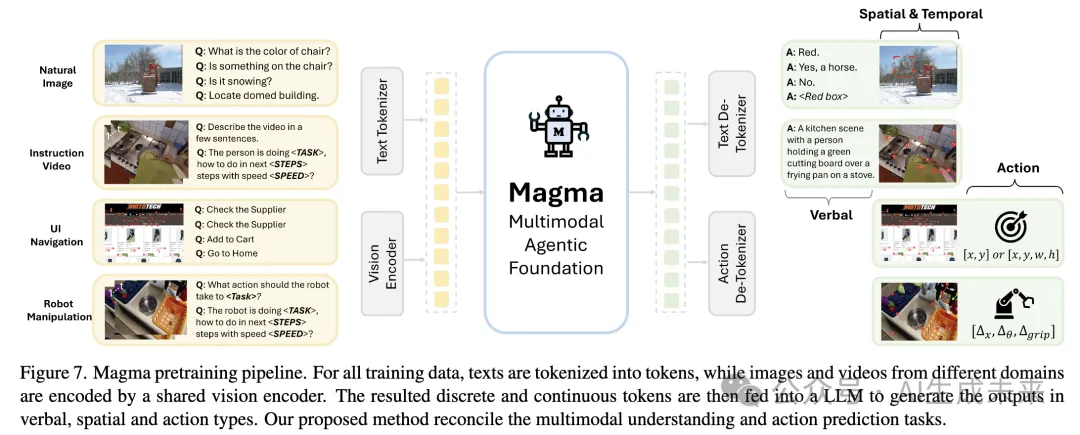

為了保留Magma所需的多模態理解能力,采用了當前視覺-語言模型(VLMs)中的常見做法(例如LLaVA和 Phi-3-Vision)。給定視覺觀察 I,使用視覺編碼V將每一幀編碼為若干標記,然后將所有標記連接成一個序列,并將其與編碼任務描述的語言標記一起輸入到僅解碼器的大型語言模型(LLM)中。由于任務的多樣性,需要一個能夠無縫編碼各種分辨率的圖像和視頻的視覺編碼器。本文提出使用卷積網絡ConvNeXt 作為視覺骨干網絡,因為它默認支持任意圖像分辨率。為了處理高分辨率圖像(例如高達2000的UI截圖),簡單地執行全局編碼,而不使用之前工作中的復雜技巧,并發現它可以編碼全局上下文,同時結合全局和局部裁剪。最終,將智能體建模公式化為自回歸解碼過程:

多模態智能體預訓練

數據集

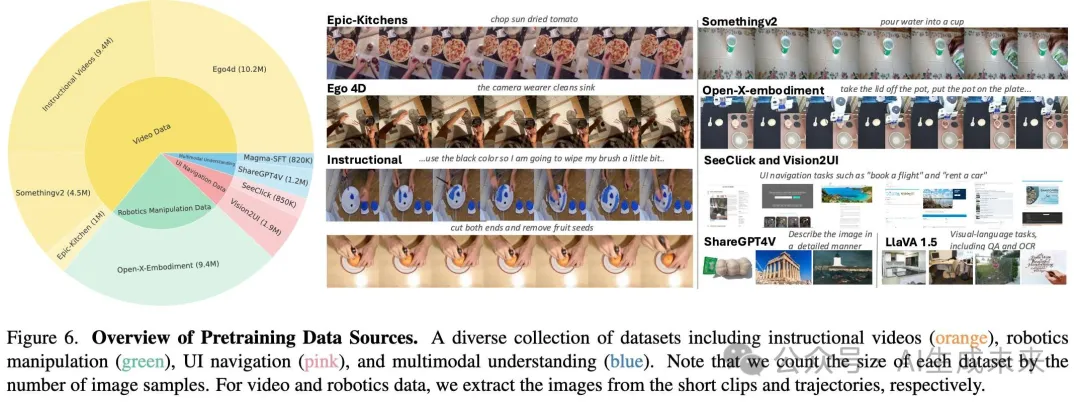

為了開發一個具備語言和空間智能的基礎模型,能夠處理多樣化的智能體任務,我們從廣泛的圖像、視頻和機器人領域整理了一個綜合的預訓練數據集。

- 機器人操作數據:對于機器人任務,遵循OpenVLA,使用Open-X-Embodiment 的機器人數據集。

- UI導航數據:利用兩個預訓練數據集,SeeClick 和 Vision2UI 。

- 教學視頻:整理了Epic-Kitchen、Ego4d、Somethingv2 和其他相關數據集,考慮到其中包含粗糙但豐富的目標驅動的人類動作。

- 多模態理解:最后,納入了ShareGPT4V、LLaVA-1.5中的指令調優數據,以及其他一些OCR相關數據集,以獲得圖像理解能力。

還有許多相關數據集可以用于模型預訓練,例如大規模指令調優數據 和更多樣化的視頻數據。本研究專注于展示我們的預訓練方法,并將進一步的擴展留給未來。接下來,將詳細闡述如何通過Set-of-Mark (SoM) 和 Trace-of-Mark (ToM) 提取智能體動作監督。

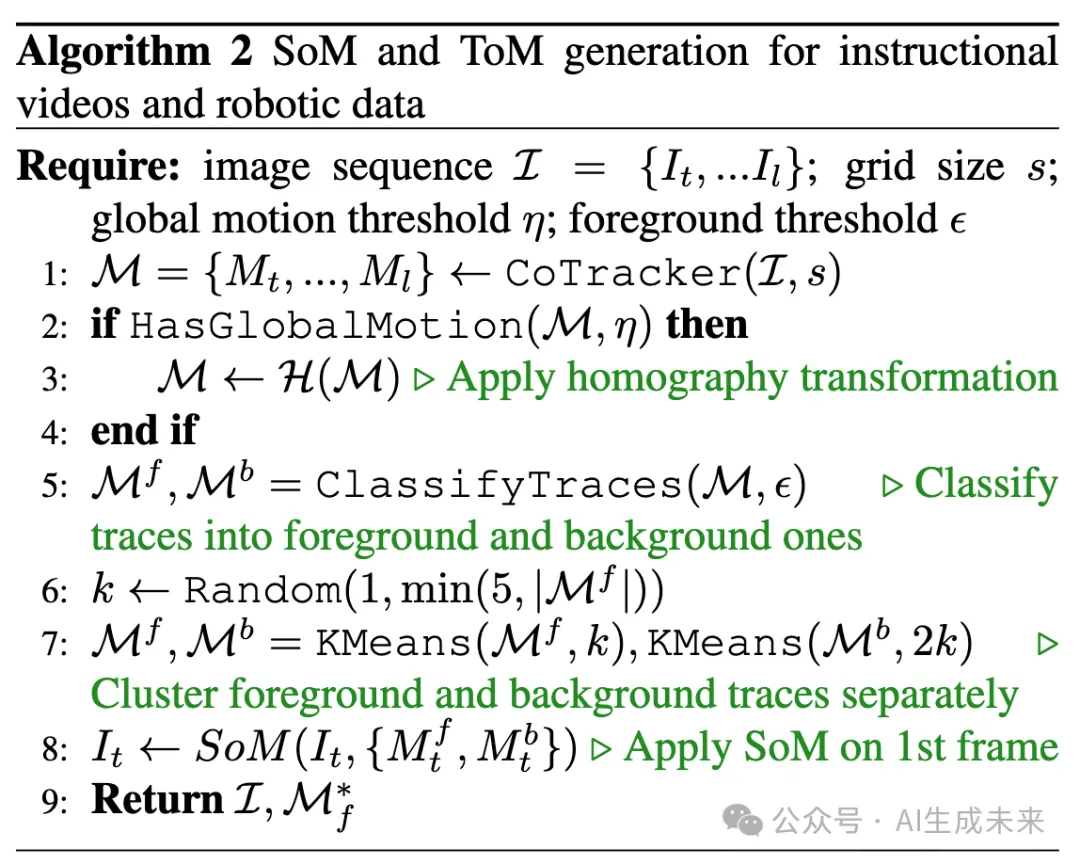

SoM 和 ToM 生成

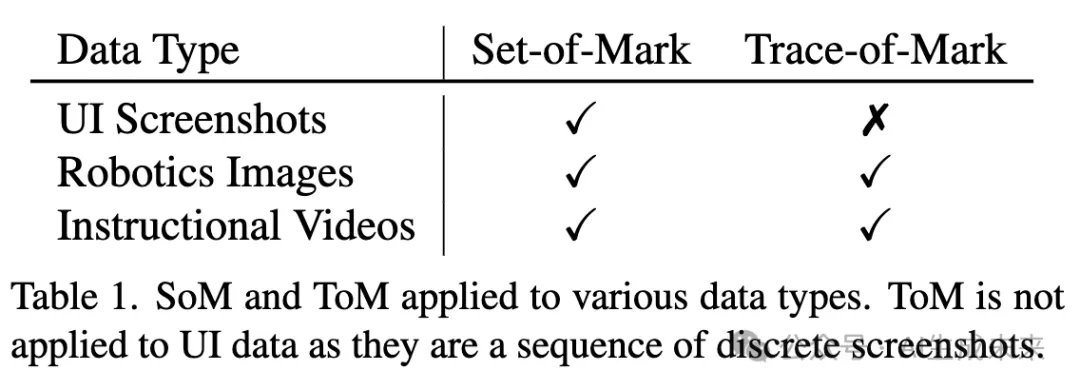

如下表1所示,對不同的數據類型應用SoM和ToM,其中SoM應用于所有數據以學習統一的動作接地。ToM不適用于UI數據,因為UI數據由離散的截圖序列組成。

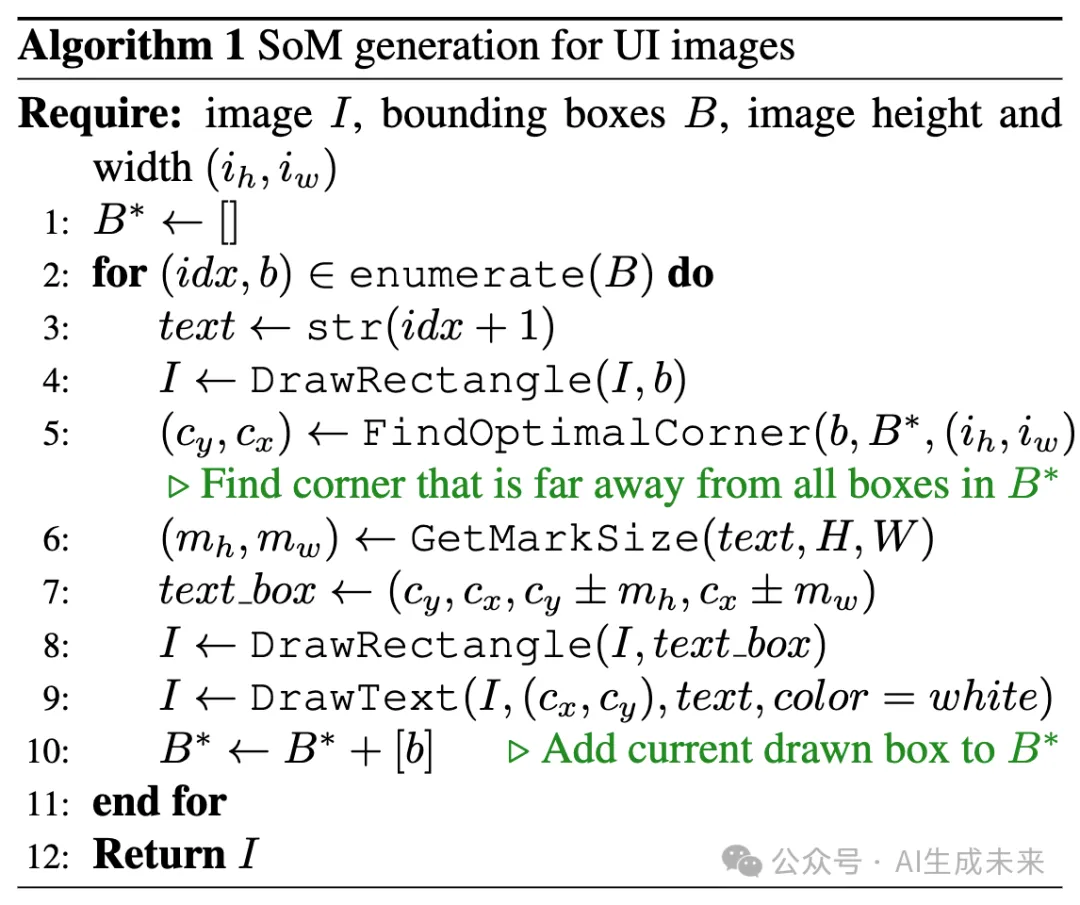

SoM 用于 UI 導航

對于預訓練數據中的UI截圖,主要依賴于基于DoM Tree提取的原始注釋。除了從HTML代碼中提取的邊界框,還進一步使用Android視圖層次結構 對SeeClick數據中的移動截圖進行邊界框標注。給定圖像中提取的候選邊界框,我們應用下算法1為對象分配文本標簽(第3行)并繪制邊界框。為了最小化重疊框的放置,我們在計算文本框大小并分配其坐標之前(第7行),使用先前繪制的框確定標簽的最佳位置(第5行)。在評估期間,遵循常見做法,使用OmniParser 對ScreenSpot 進行零樣本評估,并使用 [27] 提供的候選框對Mind2Web進行下游訓練和評估。

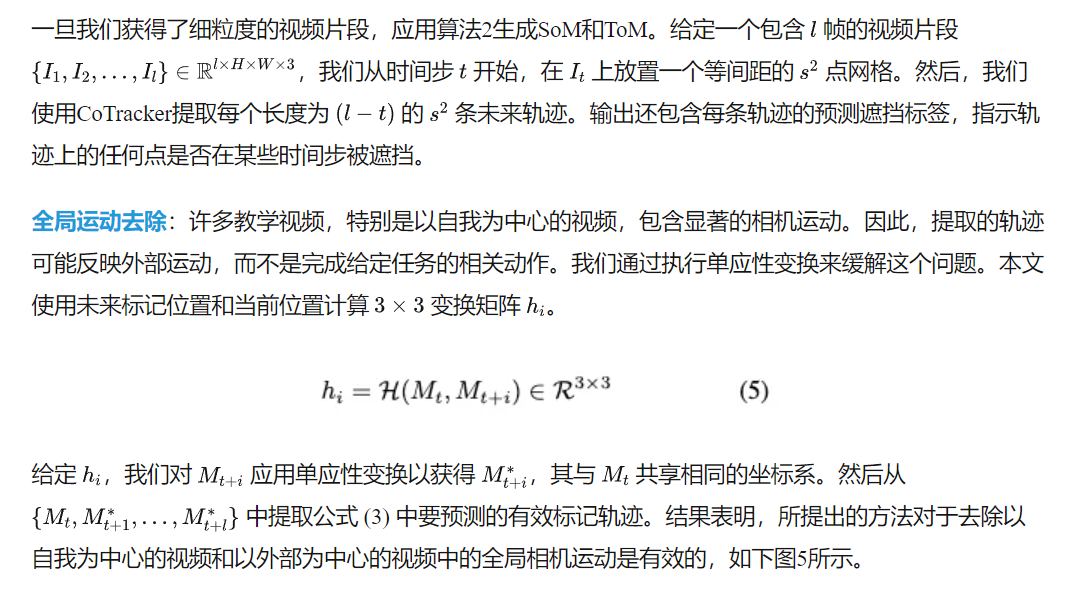

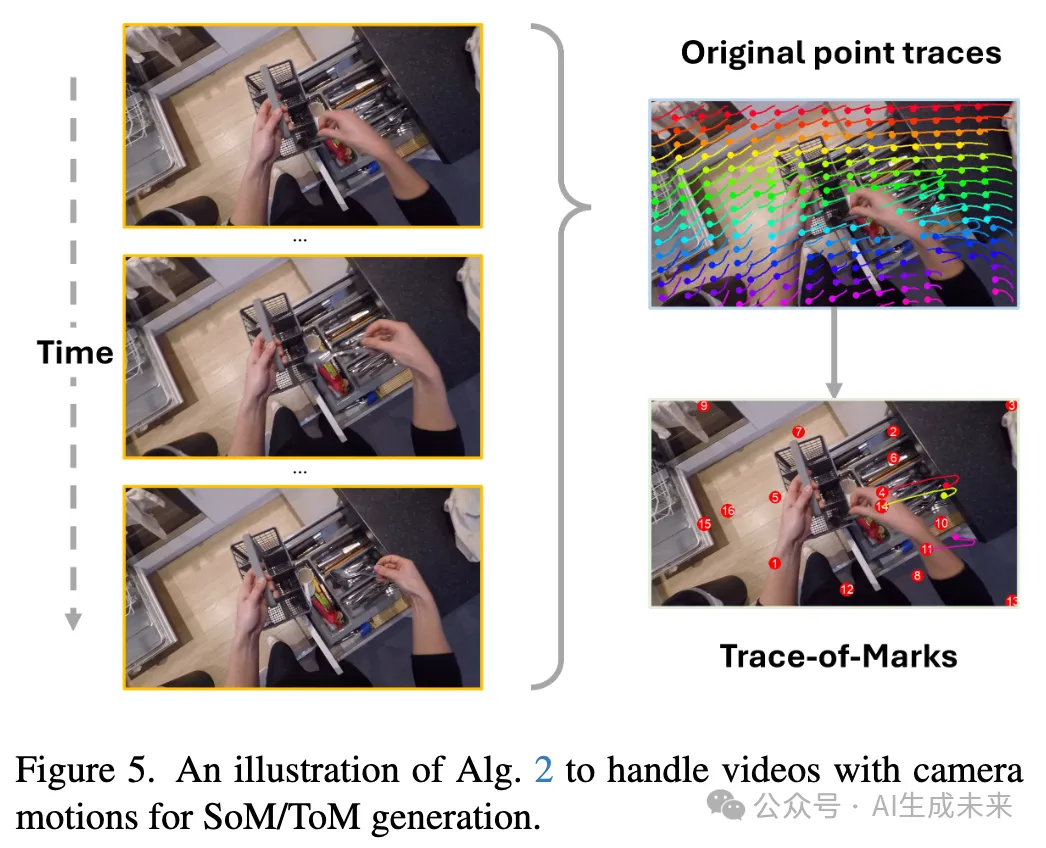

SoM 和 ToM 用于視頻和機器人數據

使用標記和軌跡作為智能體動作監督,預訓練Magma模型以進行動作接地和規劃。為了提取可靠的軌跡,使用最先進的點跟蹤模型CoTracker 來跟蹤每個視頻片段中的關鍵點。與之前工作中使用的目標檢測和跟蹤系統不同,點跟蹤提供了最精細的末端執行器(機器人手臂或人手)和對象的運動軌跡,更重要的是,它可以應用于任何視頻,因為它不需要對象識別。

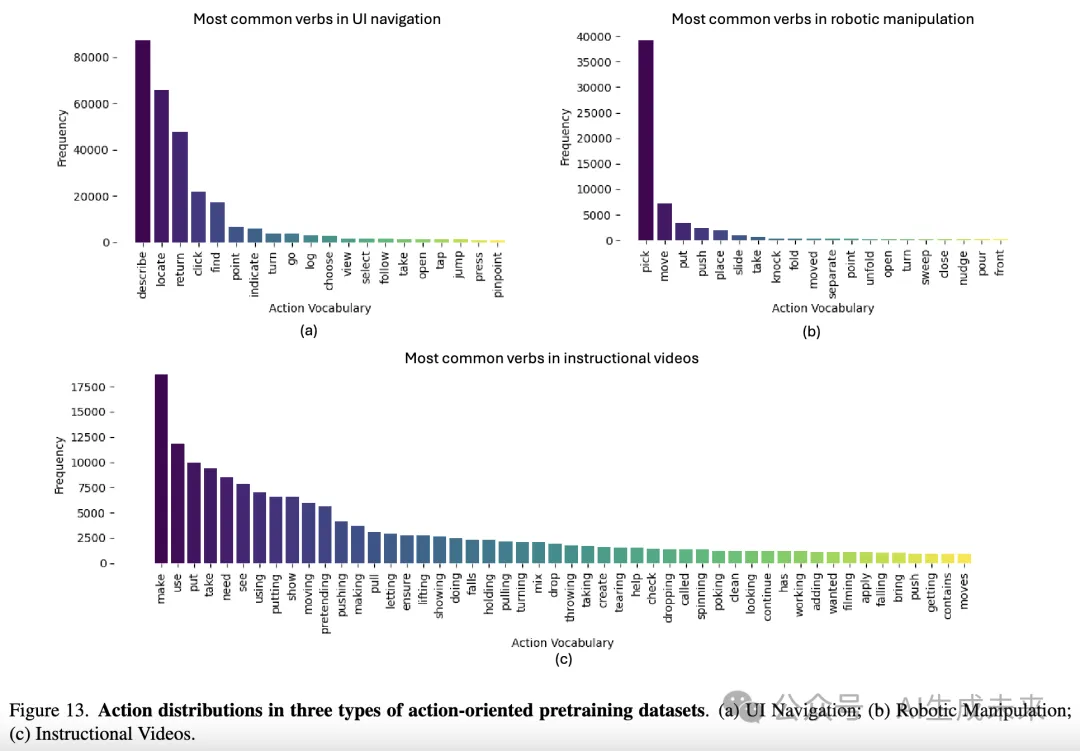

CoTracker的可靠性:為了確定這些軌跡的泛化能力,在所有預訓練數據上運行算法之前檢查了CoTracker的可靠性。CoTracker已經在多個視頻數據集(如TAP-Vid 和 PointOdyssey)上得到了充分驗證。在本工作中,提出了全面的策略來處理視頻中的場景轉換和相機運動(下算法2),這些策略有效地擴展到Ego4D和其他教學視頻數據集(下圖13)。為了進一步驗證ToM的可靠性,在YouCook2-BB的一個子集上定量評估了軌跡,該子集包含人類標注的邊界框。從每個標注的框中提取軌跡,并統計1秒后仍落入框內的未來軌跡數量。在1320個片段上,得到了0.89的精度,表明軌跡可靠地捕捉了時間運動。

片段和CLIP分數過濾:由于點跟蹤系統在短時間窗口內工作,首先使用提供的注釋將每個視頻分割成片段,然后使用PySceneDetect進一步將每個片段分解為具有一致鏡頭的短視頻片段。然而,檢測到的視頻片段可能并不總是與其相關的文本注釋相關。因此,使用預訓練的CLIP視覺和文本編碼器計算每個片段和文本對之間的余弦相似度分數,并過濾掉分數低于0.25的片段。

預訓練

上述數據和注釋整理形成了一個綜合的預訓練套件,涵蓋:

- 不同的數字和物理環境;

- 語言和空間注釋;

- 各種多模態理解和智能體任務。

如下圖6(左)所示,包含了來自SeeClick 和 Vision2UI 的近270萬張UI導航截圖。遵循OpenVLA,將Open-X-Embodiment中的97萬條軌跡納入其中,這些軌跡包含940萬條圖像-語言-動作三元組。預訓練數據的大部分是視頻,包含超過2500萬個樣本,源自約400萬個鏡頭一致的視頻片段。最后,我們納入了來自ShareGPT4V、LLaVa-1.5 和其他一些OCR相關數據集 的120萬張圖像和文本對,將其稱為Magma-SFT(82萬)。

默認情況下,使用LLaMA-3-8B作為語言骨干網絡,ConvNext-XXlarge作為視覺骨干網絡。在下圖7中展示了預訓練架構。本文提出的SoM和ToM作為橋梁,連接了所有四種類型數據的語言和動作監督,并顯著增強了模型的空間智能,正如在實驗中所觀察到的那樣。

為了進行比較,在實驗中運行了一些變體以進行消融研究:

- Magma-8B (SFT):使用Magma-SFT(82萬)進行指令調優的模型,遵循LMM訓練中使用的常規方法。

- Magma-8B (UI)和Magma-8B (OXE):分別在UI截圖和OXE機器人數據上預訓練的模型。

- Magma-8B (ACT):在UI截圖和機器人數據上聯合預訓練的模型。

- Magma-8B (Full):使用整個數據集(包含SoM和ToM注釋)訓練的完整模型。

除非另有說明,所有預訓練都包括Magma-SFT(82萬)。使用整理的數據對模型進行最多三個epoch的預訓練,學習率恒定為1e-5,并在零樣本設置下評估預訓練模型在不同任務上的表現,同時在下游任務上微調其權重。整個模型(包括語言模型和視覺編碼器的參數)都會被調整。

實驗

智能體能力評估

評估 Magma 作為多模態智能體的基礎模型在數字世界中的UI導航任務、物理世界中的機器人操作任務,以及通用多模態理解方面的有效性。

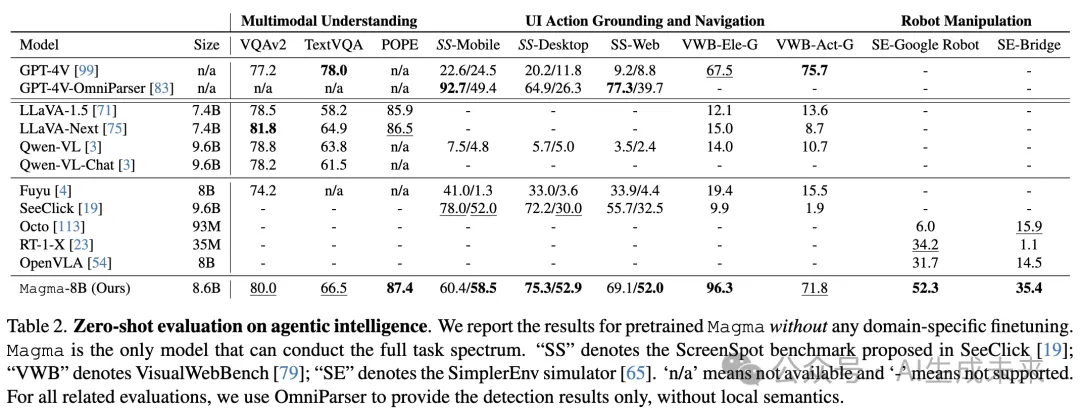

零樣本評估

為了評估 Magma 的零樣本遷移能力,采用 ScreenSpot 和 VisualWebBench評估 UI 動作定位和導航,并使用 SimplerEnv 評估機器人操作。此外,還在通用和文本豐富的 VQA 任務以及幻覺基準 POPE上驗證了本文的模型。

如下表 2 所示,Magma 在所有其他通用領域的大型多模態模型(LMMs)(如 LLaVA、Qwen-VL)以及特定領域的智能體模型(如用于 UI 導航的 SeeClick和用于機器人操作的 OpenVLA)上始終表現優越。值得注意的是,Magma 在 UI 任務上的零樣本性能遠超使用 GPT-4V 和 Omniparser 的最先進視覺方法。

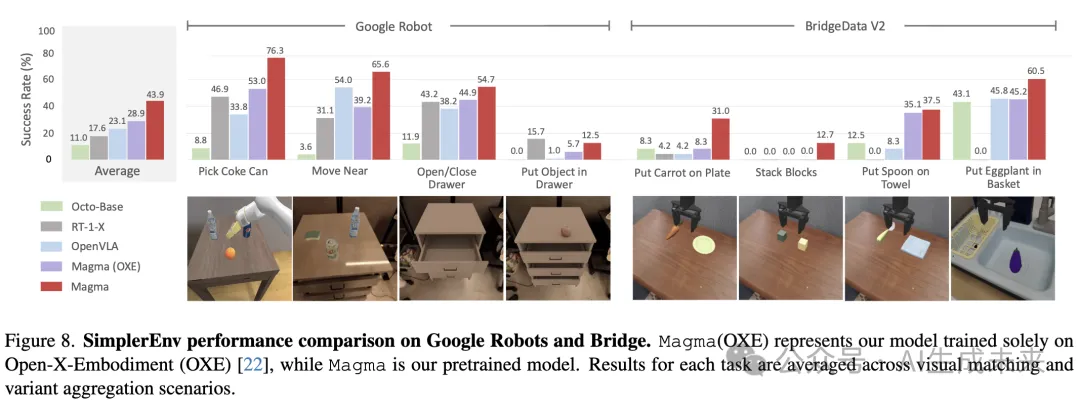

本文報告了 SimplerEnv 中兩種常用模擬器(Bridge 和 Google Robot)的結果,包括 8 項任務,共 172 個視覺匹配和變體聚合場景。由于 OpenVLA 在真實機器人軌跡上進行預訓練,該模型在真實到模擬(real-to-sim)自適應過程中容易受到領域差距的影響。相比之下,本文的 Magma 模型在多模態理解和動作預測方面使用了廣泛的異構數據集進行訓練,對這種差距更具適應性,并取得了顯著更高的成功率。

下圖 8 展示了預訓練的 Magma 模型與其他代表性模型的詳細對比。值得注意的是,Magma 領先排名第二的 OpenVLA 19.6%,幾乎將平均成功率翻倍。在“將物體放入抽屜”和“將胡蘿卜放在盤子上”等具有挑戰性的任務中,Magma 取得了卓越的成功率,而大多數基線模型完全失敗。此外,在預訓練模型的基礎上微調的 Magma 版本比僅在機器人數據集上訓練的版本表現更好,這凸顯了從多樣化數據集中學習的空間智能對于物理機器人操作任務的價值。

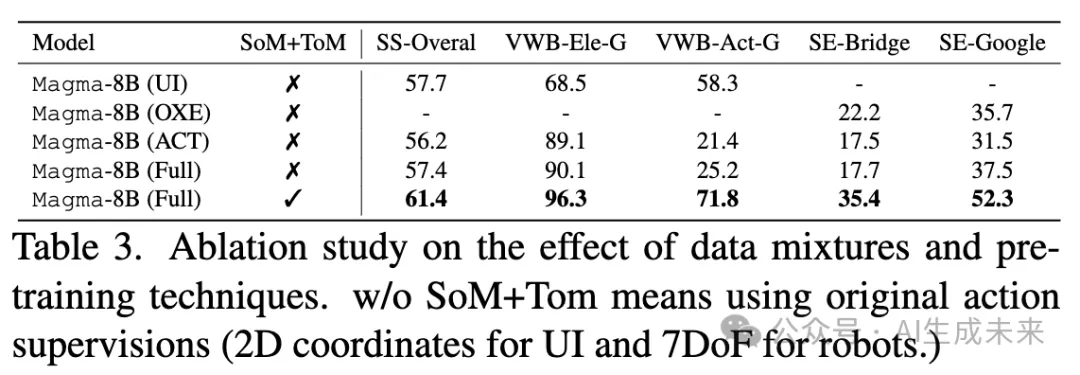

消融研究對模型的預訓練技術和數據組合進行消融實驗,結果如下表 3 所示。首先,簡單地將 UI 和機器人數據結合并不會帶來性能提升,反而會對兩類任務的性能造成損害。這是可以預見的,因為這兩個智能體任務在圖像域和動作空間(2D 坐標 vs. 7-DoF)上存在顯著差異。在預訓練中加入視頻數據可以在整體上略微提升性能,但仍無法彌合二者之間的差距,因為額外的視頻解說只能增強語言智能。然而,當在所有預訓練數據上應用 SoM 和 ToM 并將其映射到統一接口后,模型能夠有效地從異構數據中學習語言和空間智能。該研究表明,本文提出的方法是有效的,并且語言理解與空間理解對于智能體任務同等重要。

高效微調

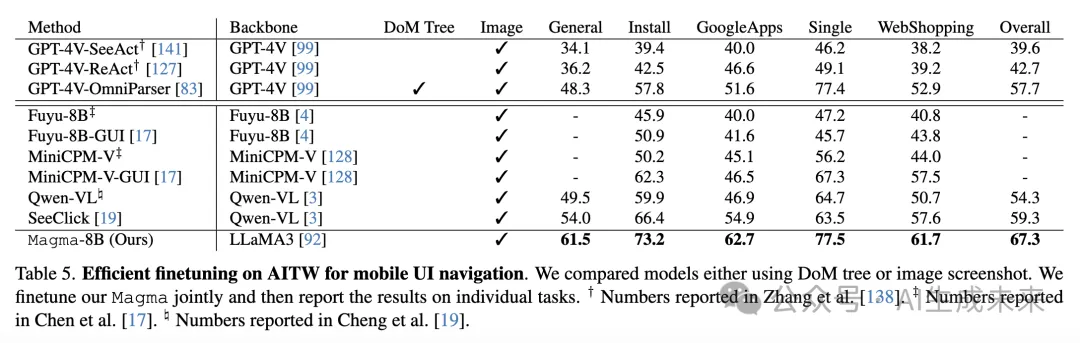

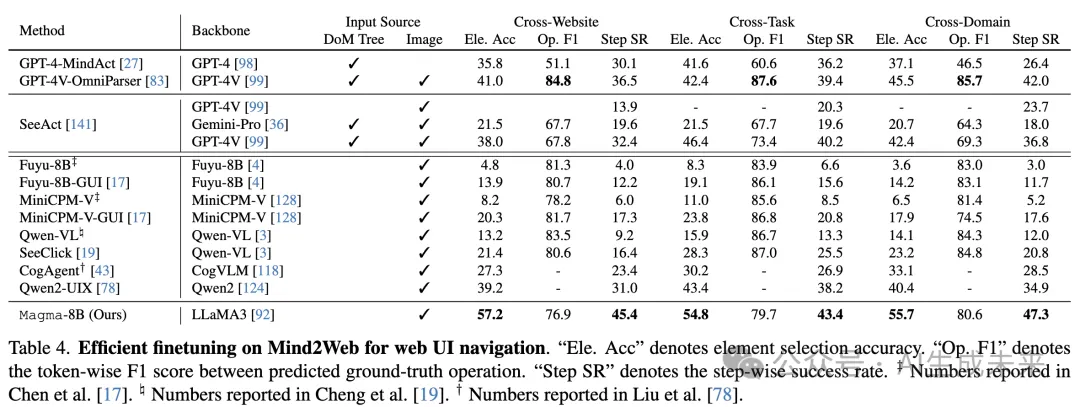

UI導航:遵循之前的工作 [19, 43],在Mind2Web和AITW上對Magma進行微調,分別測試其在網頁和移動UI導航中的能力。對于Mind2Web,首先根據 [140] 選擇的候選框對訓練樣本應用SoM提示,然后在與SeeClick相同的樣本上對Magma進行微調。下表4顯示了三個子任務的結果,清楚地表明Magma優于通用領域和特定領域的LMMs。同樣,在AITW上,Magma超越了基于開源或專有模型的最先進方法。考慮到我們使用了類似規模的LLM和適量的UI相關預訓練數據,這種出色的性能主要歸功于所提出的SoM和ToM建模技術,這些技術顯著促進了UI導航中的動作接地。

機器人操作:前面表2顯示,未經領域特定微調的Magma模型已經優于在相同數量OXE數據上預訓練27個epoch的最近提出的OpenVLA模型。接下來,我們通過將微調后的Magma模型與OpenVLA在三種設置下進行比較,驗證其有效性:

- 在真實機器人數據上微調:評估分布外操作任務;

- 在模擬機器人設置中微調:使用LIBERO基準測試評估Magma在有限軌跡下的任務適應能力;

- 在物理WidoxW 250 Arm上評估。

研究者們收集了四個操作任務,每個任務大約有50條軌跡(詳見補充材料),并在這些任務上聯合微調OpenVLA和Magma。為了評估,我們每個任務進行10次試驗,確保模型之間的初始狀態(末端執行器和對象的位置和方向)相同。如下圖9所示,結果清楚地展示了Magma的優越性能。對于涉及日常對象的挑戰性任務,如“Pick Place Hotdog Sausage”、“Put Mushroom in Pot”和“Push Cloth Right to Left”,OpenVLA幾乎無法完成任務,主要是由于觀察到的臂部運動和對象定位不精確。相比之下,Magma在這些復雜任務上表現良好,這主要歸功于其從預訓練中獲得的空間理解和接地能力。此外評估了模型在未見任務“Push Cloth Left to Right”上的表現,該任務未包含在微調數據集中。Magma顯著優于基線,表明其具有更強的保留預訓練知識并泛化到新任務的能力。

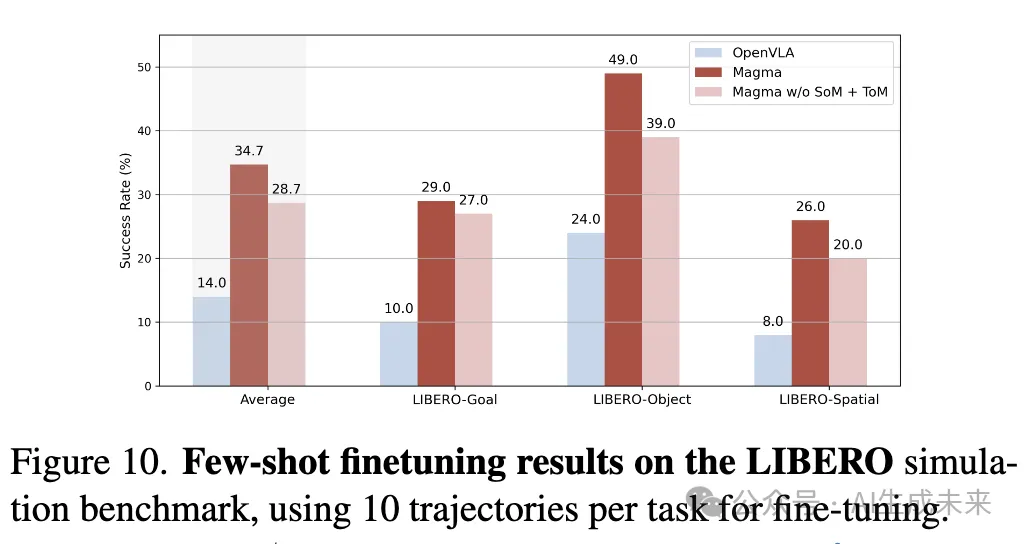

Magma的高效適應能力(通過微調)在LIBERO基準測試中的少樣本微調評估中得到了進一步驗證。對于基準測試中的每個任務套件,我們僅采樣10條軌跡進行微調。在評估期間,每個任務套件進行100次試驗。如下圖10所示,結果表明Magma在所有任務套件中實現了顯著更高的平均成功率。此外,在預訓練期間移除SoM和ToM會對模型性能產生負面影響,這進一步證明了我們預訓練方法的有效性。

評估空間推理能力

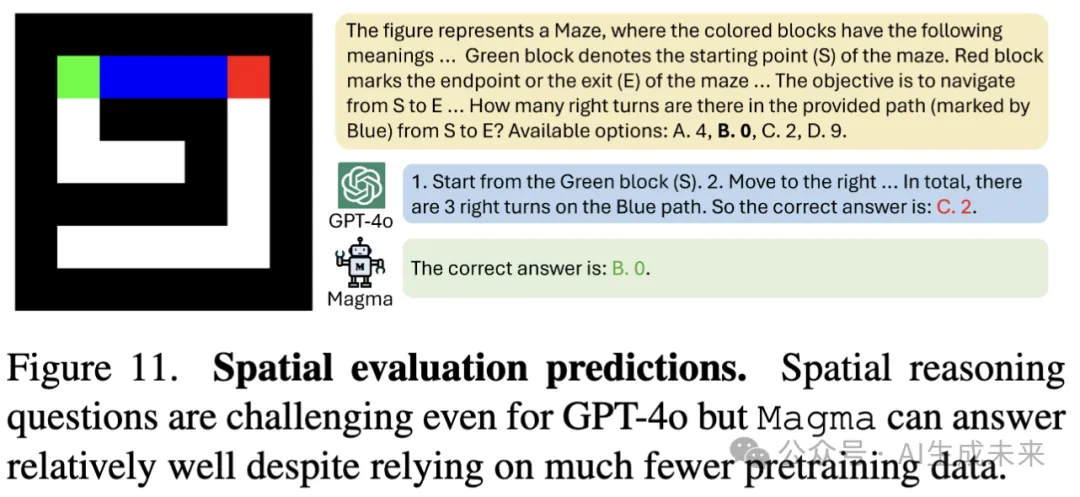

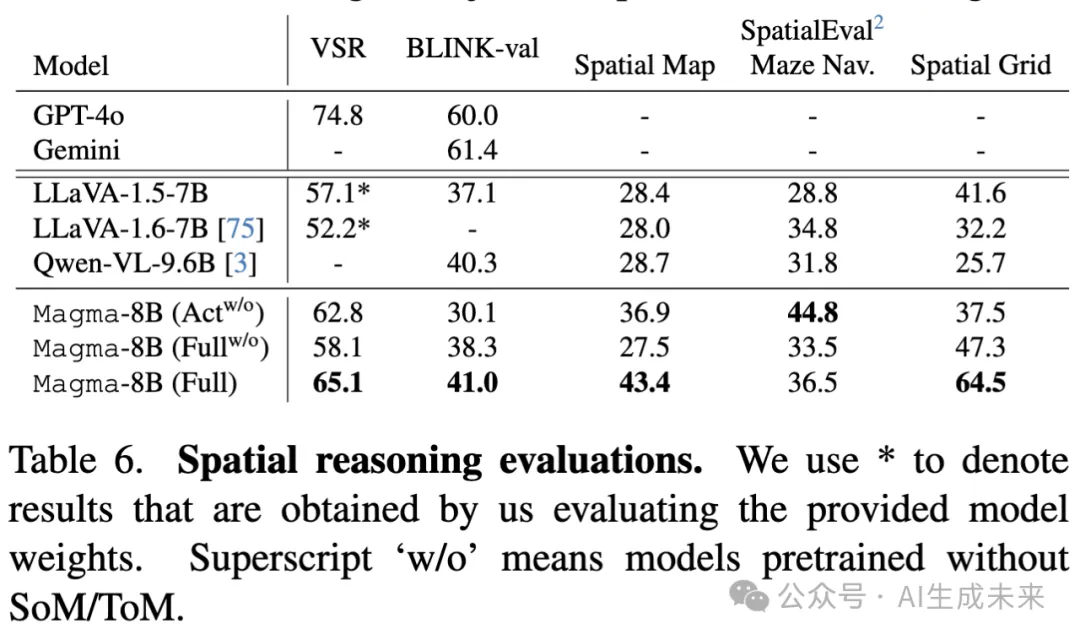

將 Magma 模型在 UI 導航和機器人操作任務上的顯著性能提升(如上所示)歸因于其增強的空間推理能力。為了驗證這一假設,我們在具有挑戰性的視覺空間推理(VSR)、BLINK 和 SpatialEval基準測試上,以零樣本(zero-shot)設置評估我們預訓練模型所學到的空間智能的有效性。結果匯總在表 6 中。我們發現,Magma 在 VSR 和 SpatialEval 上的表現大幅超越現有方法,并且在 BLINK 任務上的表現與 CogVLM 相當,盡管后者使用了約 15 億張圖像進行預訓練,而 Magma 僅使用了約 2900 萬張圖像。此外,我們的消融研究表明,SoM 和 ToM 預訓練任務對于 Magma 提升空間推理能力具有重要作用。最后,在預訓練過程中使用視頻數據的優勢,并通過實驗表明,在訓練數據中去除視頻會導致 BLINK 任務的性能下降約 8%。此外,在下圖 11 中提供了一些 Magma 模型的預測示例。空間推理問題對 GPT-4o 等最新專有模型仍然具有挑戰性。盡管 Magma 沒有在包含迷宮的數據上進行預訓練,但它仍然能夠回答與迷宮相關的空間推理問題。

評估多模態理解

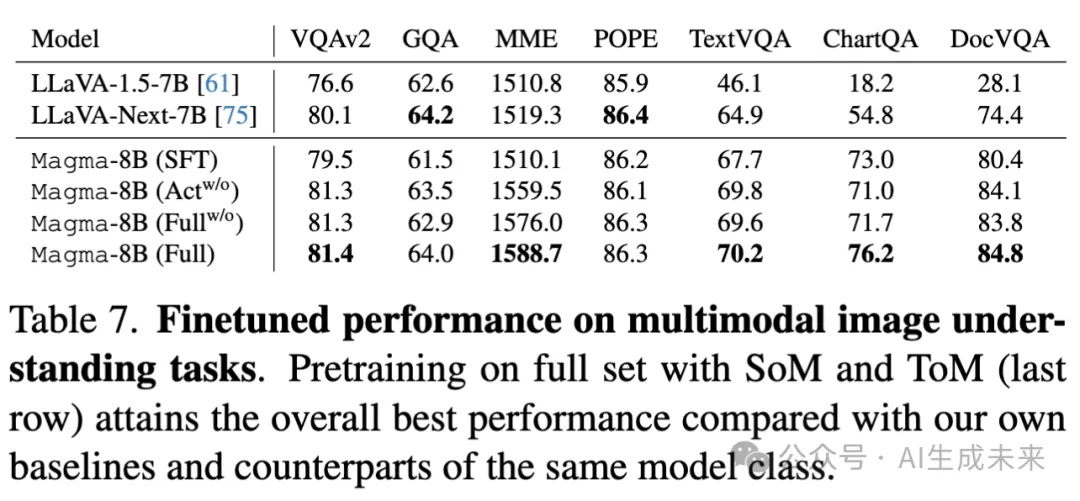

圖像指令微調為了進一步評估 Magma 的多模態理解能力,在 Magma-SFT-820K 數據上進行持續微調。然后,將微調后的 Magma 模型與現有的 VLMs(視覺語言模型)進行比較,使用一系列常用的圖像推理基準,例如 MME 和 GQA。如下表 7 所示,Magma 在大多數任務上超越了最近提出的 VLMs,尤其是在 TextVQA 和 ChartQA 上分別取得了約 5% 和 22% 的顯著提升。與下表 6 中的觀察結果類似,我們的消融研究強調了 SoM 和 ToM 預訓練任務的有效性,這在 ChartQA 上帶來了約 5% 的提升。

視頻指令微調下表 8中報告了 Magma 模型在多個挑戰性視頻問答(QA)基準測試中的表現,包括 IntentQA、NextQA、VideoMME 和 MVBench。使用 LMMs-Eval 框架進行后三個基準測試,以確保評估結果的可重復性。

結果展示了本文預訓練方法的有效性,在不同基準測試中,Magna consistently 在大多數具有可比參數數量的最新模型中表現更好。例如,我們的 Magma 模型在 IG-VLM 和 SF-LLaVA 模型上實現了約 28% 的性能提升。IntentQA 基準評估模型理解視頻中觀察到的動作背后意圖的能力。因此,Magma 在該數據集上取得的顯著提升可能歸因于我們 ToM 預訓練任務的有效性,該任務鼓勵模型推理未來視頻幀中的時間動態。MVBench 中動作預測子任務上的顯著提升也進一步證實了這一點,Magma 超越了 VideoChat2 和 LLaVA-OV 等最先進的模型。

最先進的視頻 LMMs 通常依賴于像 Webvid 和 ShareGPT4Video 這樣的大型視頻和文本數據集進行預訓練,這些數據集包含超過 400 萬個樣本,并且有經過策劃的文本。此外,前述模型在預訓練時也使用了更多的幀數。相比之下,即使在我們的案例中進行了多幀預訓練,由于計算限制,我們最多只使用了 4 幀。因此,Magma 在 VideoMME 和 MVBench 上超越了 LLaVA-OV 和 ShareGPT4Video 等方法尤其具有意義,因為這些方法通常使用更大的指令微調數據集,包括圖像和視頻數據。此外,正如 Magma 在專有模型 GPT-4V 上獲得的性能提升所證明的那樣,我們注意到這些結果的改進不僅僅是因為使用了像 LLama-3 這樣更新更強大的語言模型。值得注意的是,Magma 在性能上遠超 LongVA,盡管它只使用了 32 幀,而 LongVA 使用了 64 幀。

結論

本文提出了 Magma 基礎模型,它能夠理解和處理多模態輸入,以完成不同環境中的智能體任務。實驗表明,在預訓練中使用 SoM 和 ToM 預測任務幫助模型分別學習如何進行基礎推理和規劃動作。在實驗中,Magma 展示了強大的時空推理能力,并且在下游的 UI 導航和機器人操作任務上顯著超越了基準模型。

社會影響和局限性為了開發一個具有語言和空間智能、能夠處理數字和物理環境中多樣化智能體任務的基礎模型,從多個領域收集了全面的預訓練數據集,包括圖像、視頻和機器人領域:

- UI 導航數據:利用了兩個預訓練數據集 SeeClick 和 Vision2UI。

- 教學視頻:由于我們的目標是學習一個能夠執行日常任務(如人類)的智能體模型,我們匯編了來自 Epic Kitchen、Ego4d、Something-Something v2 和其他教學視頻的數據。

- 機器人操作數據:對于機器人任務,遵循 OpenVLA 方法,利用了 Open-X-Embodiment 中的機器人數據。

- 多模態理解數據:最后,包括了一小部分多模態預訓練數據 ShareGPT4V,以及指令調優數據 LlaVA-1.5 和其他領域特定的數據,以保持預訓練模型的通用多模態理解能力。

機器人和 UI 導航數據的標注非常標準化,集中于通用的操作任務(“將 x 物體放置在 y 物體上”)和通用的 UI 導航任務(“點擊搜索按鈕”)。然而,我們對執行特定任務的人物視頻數據進行了詳細的數據反思。在這些視頻中,我們的核心推論是任務執行時物體的運動軌跡。

教學視頻中身份和活動的分布并未代表全球人群及社會中的多樣性。意識到在使用這些數據進行訓練時,可能存在無意的社會性、性別、種族及其他偏見,因此我們將確保在發布模型時提供必要的免責聲明。訓練數據集、任務列表和描述僅關注要執行的下一步操作,而不是描述、處理或分析任務本身。雖然模型可能會基于不良的任務描述產生意外輸出,我們將確保突出展示模型訓練的用例及其預期用途。

負責任的 AI值得注意的是,該模型專為受控的 Web UI 和 Android 模擬器中的 UI 導航任務以及機器人操作任務設計,不應廣泛應用于其他任務。推薦的使用場景是在其訓練環境內,即配備機器人臂和日常物體的封閉空間用于機器人操作,及在計算機上運行的 Android 模擬器用于 UI 操作任務。對于 UI 導航任務,研究人員應確保在每個智能體系統生成的動作中,始終由人工干預和控制。由于模型本身無法獨立行動,因此研究人員使用的子模塊必須確保執行模型提出的 UI 操作時不會產生意外后果。

該模型本身展示了足夠的 UI 導航和機器人操作能力,但不能直接用于惡意利用場景。惡意攻擊者可以使用特定的訓練數據進行特定的惡意任務,將該模型作為基礎來執行自動化的 UI 導航任務。這是與智能體模型相關的普遍風險。

本文轉自AI生成未來 ,作者:AI生成未來

原文鏈接??https://mp.weixin.qq.com/s/z69YT0Ww_QGCYQ1ghiaFXQ??