效果&成本雙突破!快手提出端到端生成式推薦系統(tǒng)OneRec!

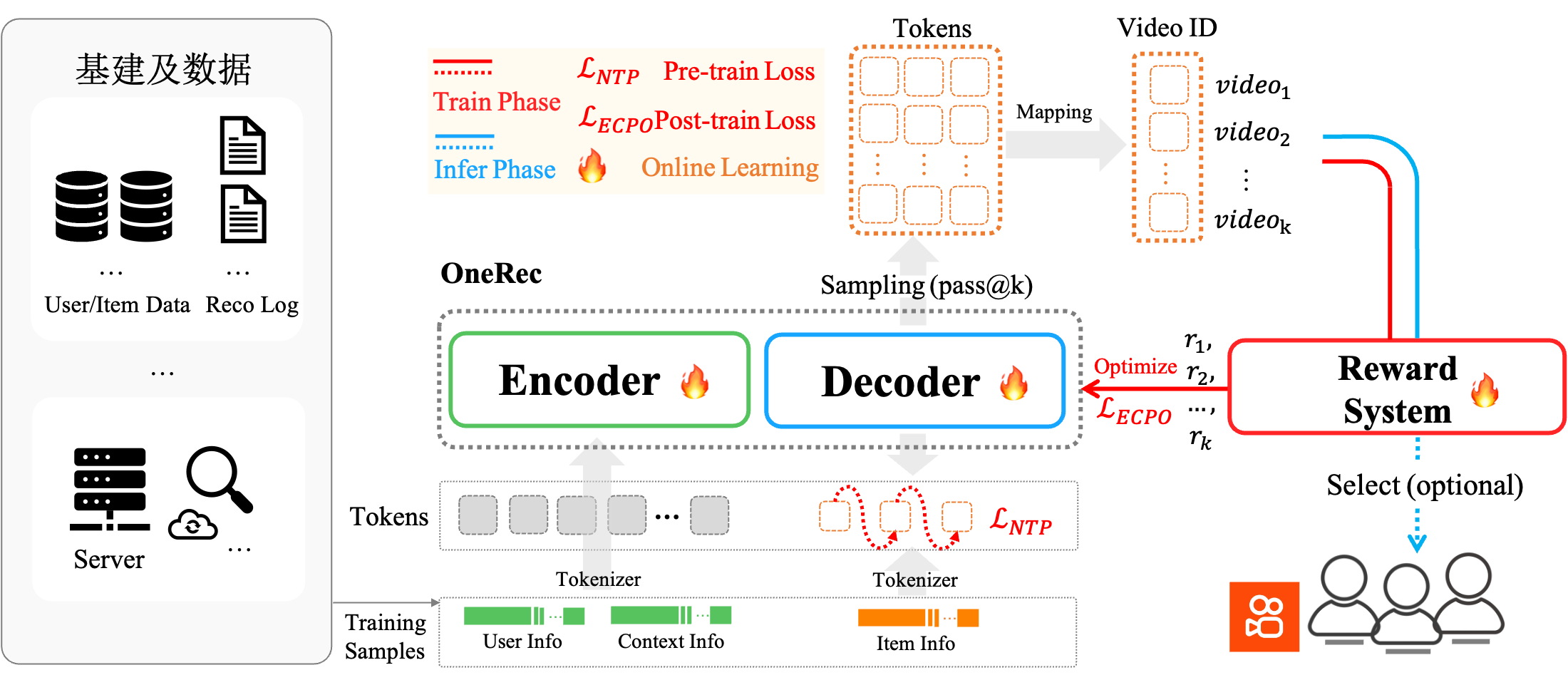

近日,快手推薦模型團(tuán)隊(duì)提出了一個(gè)端到端生成式推薦系統(tǒng) OneRec,該系統(tǒng)采用 Encoder-Decoder 架構(gòu),引入了基于獎(jiǎng)勵(lì)機(jī)制的偏好對(duì)齊方法,借助強(qiáng)化學(xué)習(xí)增強(qiáng)模型效果,可在獎(jiǎng)勵(lì)模型引導(dǎo)下直接生成契合用戶偏好的視頻內(nèi)容。通過極致的性能優(yōu)化,OneRec 在推薦模型 FLOPs 提升 10 倍的同時(shí),大幅削減了通信和存儲(chǔ)等運(yùn)營(yíng)成本近 90%。目前,OneRec 已在快手/快手極速版雙端承接 25%的線上流量,帶動(dòng) APP 停留時(shí)長(zhǎng)分別提升 0.54%和 1.24%。

當(dāng)生成式架構(gòu)重塑 AI 技術(shù)棧時(shí),推薦系統(tǒng)卻仍受困于模塊化設(shè)計(jì)的“算力泥潭”——傳統(tǒng)級(jí)聯(lián)架構(gòu)導(dǎo)致的算力碎片化、優(yōu)化不一致等問題,限制了這一核心基礎(chǔ)設(shè)施的創(chuàng)新步伐。為此,快手技術(shù)團(tuán)隊(duì)提出了端到端生成式推薦新范式「OneRec」。

【主要貢獻(xiàn)】

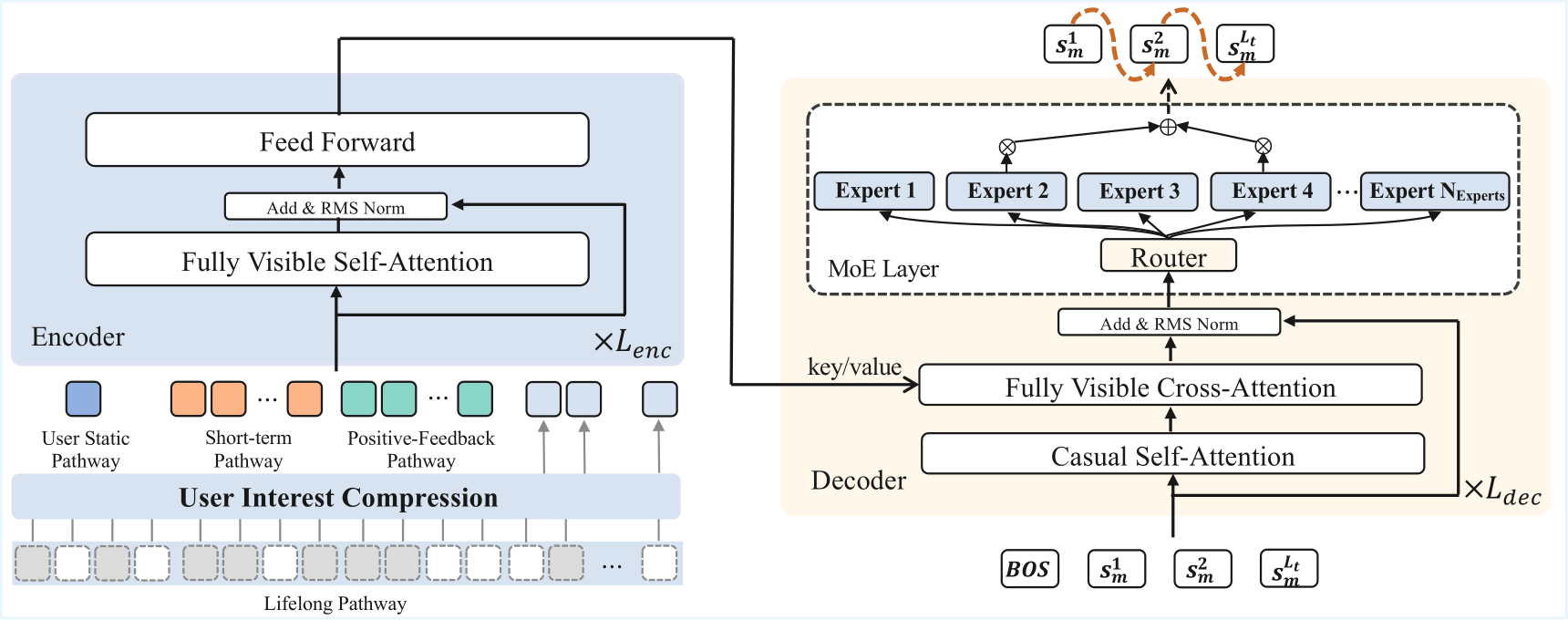

- 單階段編碼器-解碼器生成框架:該框架巧妙利用 Encoder 對(duì)用戶全生命周期行為序列進(jìn)行壓縮處理,以此實(shí)現(xiàn)精準(zhǔn)的興趣建模,同時(shí)基于 MoE 架構(gòu)的 Decoder 具備超大規(guī)模參數(shù)擴(kuò)展能力,有力保障了短視頻推薦的端到端精準(zhǔn)生成。

- 引入了基于獎(jiǎng)勵(lì)機(jī)制的偏好對(duì)齊方法:通過獎(jiǎng)勵(lì)反饋機(jī)制,并借助強(qiáng)化學(xué)習(xí)增強(qiáng)模型效果,模型能夠敏銳捕捉到更為細(xì)粒度的用戶偏好信息。為此,OneRec 精心設(shè)計(jì)并搭建了一套多維度獎(jiǎng)勵(lì)系統(tǒng),涵蓋偏好獎(jiǎng)勵(lì)、格式獎(jiǎng)勵(lì)、工業(yè)場(chǎng)景獎(jiǎng)勵(lì),全方位助力模型理解用戶偏好。

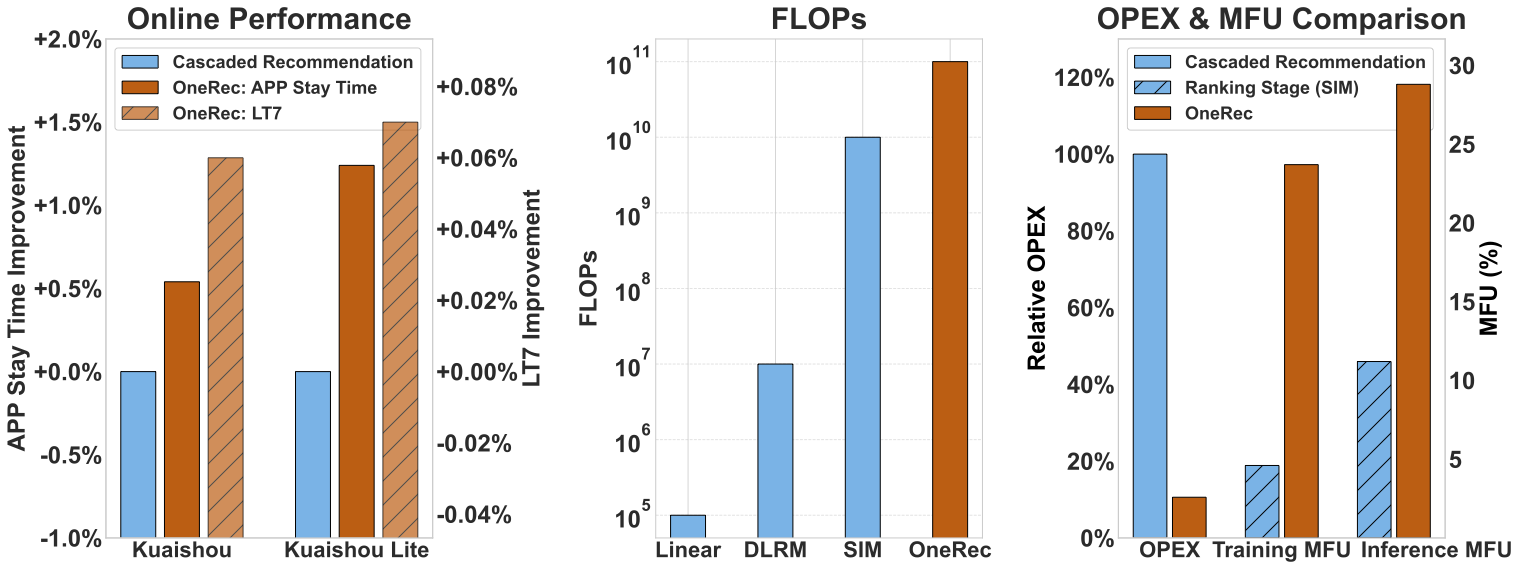

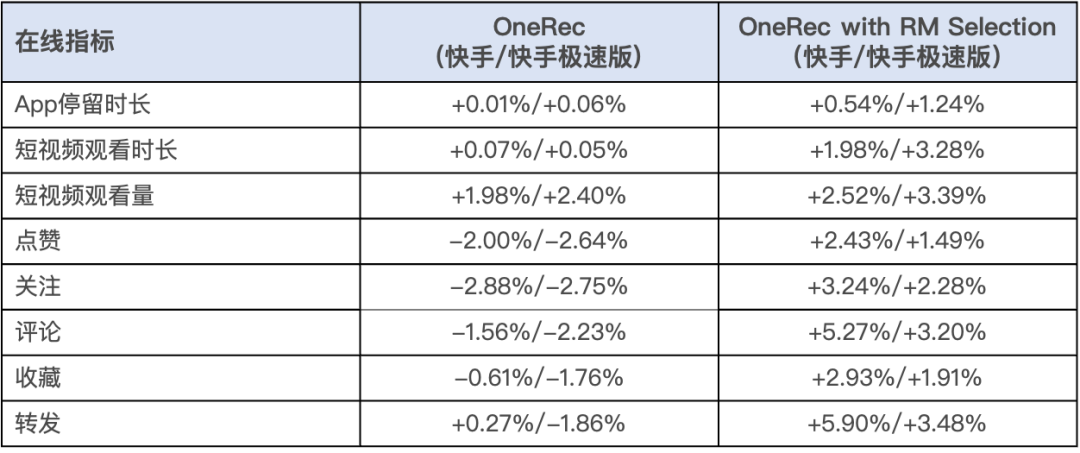

- 首個(gè)工業(yè)級(jí)端到端生成式推薦落地方案:本系統(tǒng)在快手主站/極速版雙端短視頻推薦主場(chǎng)景完成驗(yàn)證。為期一周、覆蓋 5% 流量 的 A/B 測(cè)試表明,純生成式模型 (OneRec) 僅通過強(qiáng)化學(xué)習(xí)對(duì)齊用戶偏好,即達(dá)到與原復(fù)雜級(jí)聯(lián)系統(tǒng)相當(dāng)?shù)男Ч/B加獎(jiǎng)勵(lì)模型選擇策略 (OneRec with RM Selection) 后,更實(shí)現(xiàn)了用戶停留時(shí)長(zhǎng)顯著提升(主站 +0.54%,極速版 +1.24%),以及 7 日用戶生命周期 (LT7) 增長(zhǎng)(主站+0.05%,極速版+0.08%)的業(yè)務(wù)突破。

下圖(左)展示了快手 / 快手極速版中 OneRec 與級(jí)聯(lián)推薦架構(gòu)的 Online 性能比較,圖(中)展示了 OneRec 與 Linear、DLRM、SIM 的 FLOPs 比較,圖(右)展示了 OneRec 與級(jí)聯(lián)推薦架構(gòu)的 OPEX 對(duì)比,以及和鏈路中計(jì)算復(fù)雜度最高的精排模型 SIM 的 MFU 對(duì)比。

論文鏈接:??https://arxiv.org/abs/2506.13695??

一、傳統(tǒng)推薦系統(tǒng)框架的局限性

推薦系統(tǒng)是一種基于用戶歷史行為、物品屬性以及上下文信息,通過模型算法來預(yù)測(cè)用戶偏好并主動(dòng)推送個(gè)性化信息的信息過濾技術(shù)。在個(gè)性化新聞推送、音樂推薦、視頻推薦以及商品推薦等眾多場(chǎng)景中,推薦系統(tǒng)都發(fā)揮著至關(guān)重要的作用。

傳統(tǒng)推薦系統(tǒng)通常采用召回->粗排->精排的多層級(jí)聯(lián)架構(gòu)模式,以平衡系統(tǒng)時(shí)延和效果,然而在實(shí)際應(yīng)用中,卻面臨著三大核心瓶頸:

其一:算力效率低下:以快手為例的分析顯示,即使是在推薦系統(tǒng)中計(jì)算復(fù)雜度最高的精排模型(SIM),在旗艦版 GPU 上進(jìn)行訓(xùn)練和推理時(shí),其 MFU 分別僅為 4.6%和 11.2%。與之形成鮮明對(duì)比的是,大語言模型在 H100 上的 MFU 能夠達(dá)到 40%-50%的水平。

其二:目標(biāo)函數(shù)相互沖突。平臺(tái)需要同時(shí)優(yōu)化用戶、創(chuàng)作者和生態(tài)系統(tǒng)的數(shù)百個(gè)目標(biāo),這些目標(biāo)在不同階段相互掣肘,導(dǎo)致系統(tǒng)整體的一致性和效率持續(xù)惡化。

更嚴(yán)峻的是,技術(shù)代差逐漸拉大。隨著 AI 技術(shù)的飛速發(fā)展,Scaling Law、強(qiáng)化學(xué)習(xí)等前沿技術(shù)不斷涌現(xiàn),并在眾多領(lǐng)域取得了顯著成效。然而,現(xiàn)有架構(gòu)卻難以將這些最新的 AI 技術(shù)成果有效吸納。同時(shí),由于架構(gòu)的限制,推薦系統(tǒng)也難以充分利用先進(jìn)計(jì)算硬件的能力。這使得推薦系統(tǒng)與主流 AI 技術(shù)的發(fā)展步伐逐漸脫節(jié),技術(shù)代差日益拉大。

二、快手端到端生成式推薦系統(tǒng) OneRec

面對(duì)這些挑戰(zhàn),快手團(tuán)隊(duì)提出端到端生成式推薦系統(tǒng) OneRec,其核心在于利用 Encoder 壓縮用戶全生命周期行為序列實(shí)現(xiàn)興趣建模,同時(shí)基于 MoE 架構(gòu)的 Decoder 實(shí)現(xiàn)超大規(guī)模參數(shù)擴(kuò)展,確保短視頻推薦的端到端精準(zhǔn)生成。同時(shí)配合定制化強(qiáng)化學(xué)習(xí)框架和極致的訓(xùn)練/推理優(yōu)化,使模型實(shí)現(xiàn)效果和效率的雙贏。目前,新系統(tǒng)在以下幾個(gè)方面的效果顯著:

- 可以用遠(yuǎn)低于線上系統(tǒng)的成本,采用更大的模型,取得更好的推薦效果;

- 在一定范圍內(nèi),找到了推薦場(chǎng)景的 scaling law;

- 過去很難影響和優(yōu)化推薦結(jié)果的 RL 技術(shù)在這個(gè)架構(gòu)上體現(xiàn)出了非常高的潛力;

- 目前該系統(tǒng)從訓(xùn)練到 serving 架構(gòu)以及 MFU 水平都和 LLM 社區(qū)接近,LLM 社區(qū)的很多技術(shù)可以很好地在這個(gè)系統(tǒng)上落地。

2.1 OneRec 模型框架

OneRec 采用編碼器-解碼器架構(gòu)(如下圖),將推薦問題轉(zhuǎn)化為序列生成任務(wù),在訓(xùn)練過程中使用 NTP (Next Token Prediction) 損失函數(shù)優(yōu)化。

2.1.1 語義分詞器

面對(duì)快手平臺(tái)上億級(jí)別的視頻內(nèi)容,如何讓模型"理解"每個(gè)視頻成為關(guān)鍵挑戰(zhàn)。OneRec 首創(chuàng)了協(xié)同感知的多模態(tài)分詞方案:

● 多模態(tài)融合:同時(shí)處理視頻的標(biāo)題、標(biāo)簽、語音轉(zhuǎn)文字、圖像識(shí)別等多維信息;

● 協(xié)同信號(hào)集成:不僅關(guān)注內(nèi)容特征,更融入用戶行為信息建模;

● 分層語義編碼:采用 RQ-Kmeans 技術(shù),將每個(gè)視頻轉(zhuǎn)化為 3 層粗到細(xì)的語義 ID。

2.1.2 編碼器-解碼器

在訓(xùn)練階段,OneRec 通過編碼器-解碼器架構(gòu)執(zhí)行下一個(gè) token 預(yù)測(cè),進(jìn)而實(shí)現(xiàn)對(duì)目標(biāo)物品的更高效預(yù)測(cè)。該架構(gòu)在不同階段起到的作用分別如下:

● 多尺度用戶建模:編碼階段同時(shí)考慮用戶靜態(tài)特征、短期行為序列、有效觀看序列和終身行為序列;

● 專家混合解碼器:解碼階段采用逐點(diǎn)生成策略,通過 Mixture of Experts(MoE)架構(gòu)提升模型容量和效率。

2.1.3 推薦系統(tǒng)中的 Scaling Laws

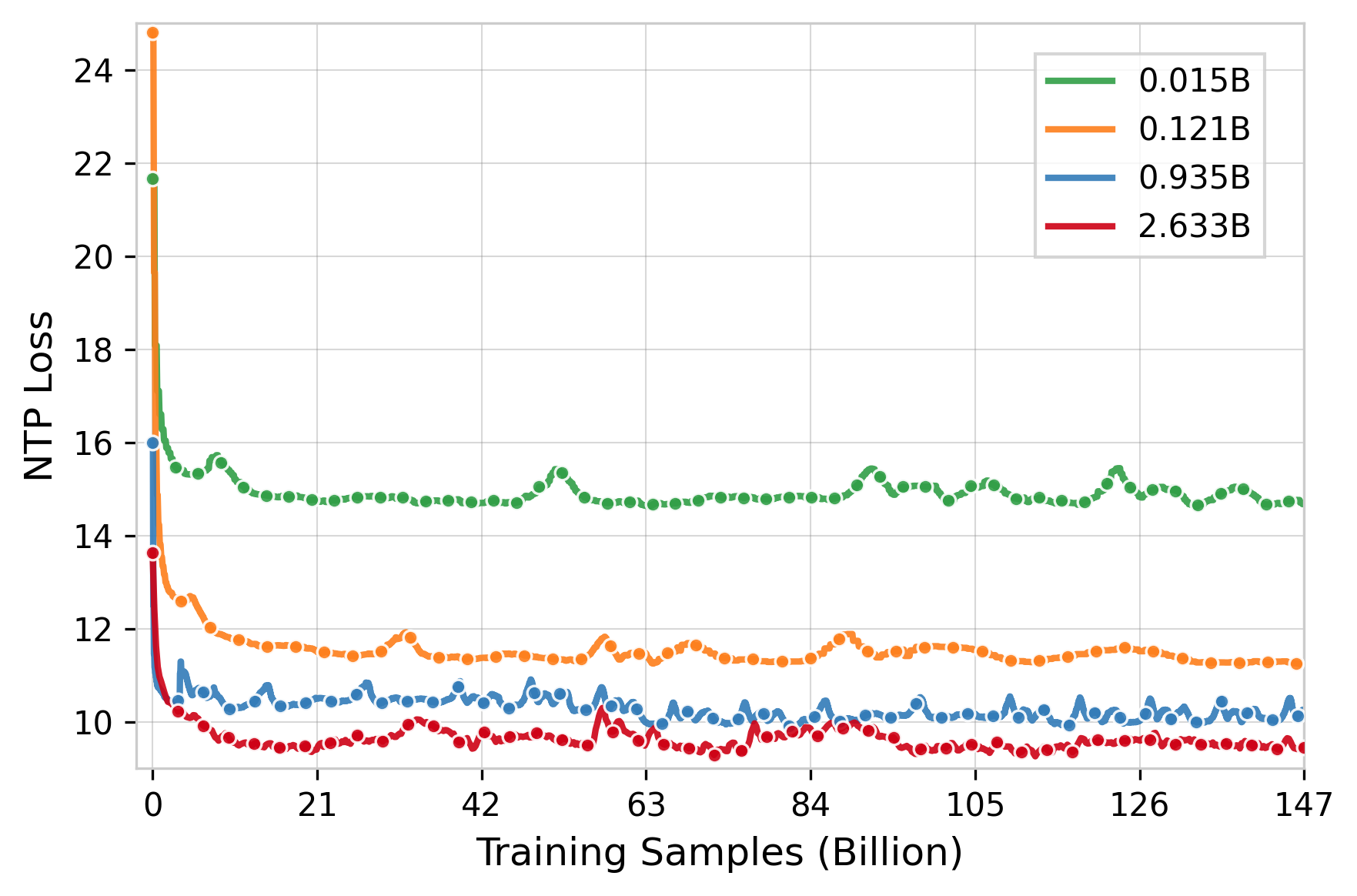

參數(shù)規(guī)模實(shí)驗(yàn)是 OneRec 研究中的另一亮點(diǎn),它試圖回答一個(gè) fundamental 的問題:推薦系統(tǒng)是否同樣遵循大語言模型領(lǐng)域已被證實(shí)的 Scaling Law?實(shí)驗(yàn)結(jié)果清晰地表明,隨著模型參數(shù)量從 0.015B 到 2.633B 的遞增,訓(xùn)練損失呈現(xiàn)出明顯的下降趨勢(shì)。

技術(shù)報(bào)告中還介紹了包含 Feature Scaling、Codebook Scaling 和 Infer Scaling 等,極大地利用算力來提升推薦的精度。

2.2 RL 偏好對(duì)齊

預(yù)訓(xùn)練模型雖然可以通過下一個(gè) token 預(yù)測(cè)來擬合曝光物品的空間分布,但這些曝光物品來源于過去的傳統(tǒng)推薦系統(tǒng),這導(dǎo)致模型無法突破傳統(tǒng)推薦系統(tǒng)的性能天花板。

傳統(tǒng)推薦系統(tǒng)通常定義多個(gè)目標(biāo),如點(diǎn)擊量、點(diǎn)贊數(shù)、評(píng)論數(shù)和觀看時(shí)長(zhǎng),然后通過加權(quán)融合每個(gè)目標(biāo)的預(yù)測(cè)值(xtr)將其組合成一個(gè)分?jǐn)?shù)。然而,手動(dòng)調(diào)整這些融合權(quán)重既缺乏準(zhǔn)確性,又缺乏個(gè)性化,并且常常導(dǎo)致目標(biāo)之間的優(yōu)化沖突。

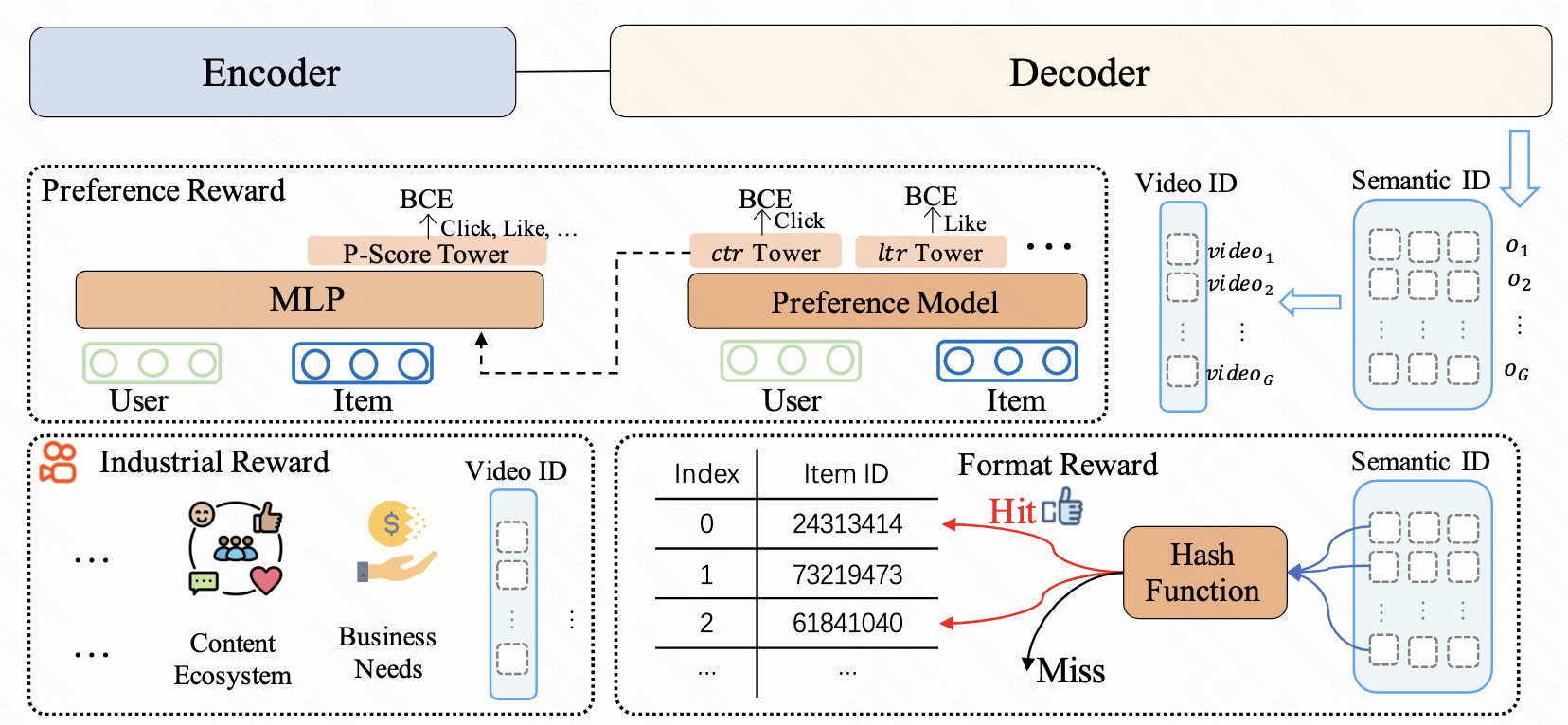

為了解決這一挑戰(zhàn),OneRec 引入了基于獎(jiǎng)勵(lì)機(jī)制的偏好對(duì)齊方法,利用強(qiáng)化學(xué)習(xí)增強(qiáng)模型效果。通過獎(jiǎng)勵(lì)反饋機(jī)制,模型得以感知更為細(xì)粒度的用戶偏好信息。為此,OneRec 構(gòu)建了一套綜合性的獎(jiǎng)勵(lì)系統(tǒng),包括如下:

- 偏好獎(jiǎng)勵(lì)(Preference Reward)用于對(duì)齊用戶偏好

- 格式獎(jiǎng)勵(lì)(Format Reward)確保生成的 token 均為有效格式

- 工業(yè)場(chǎng)景獎(jiǎng)勵(lì)(Industrial Reward)以滿足各類業(yè)務(wù)場(chǎng)景的需求

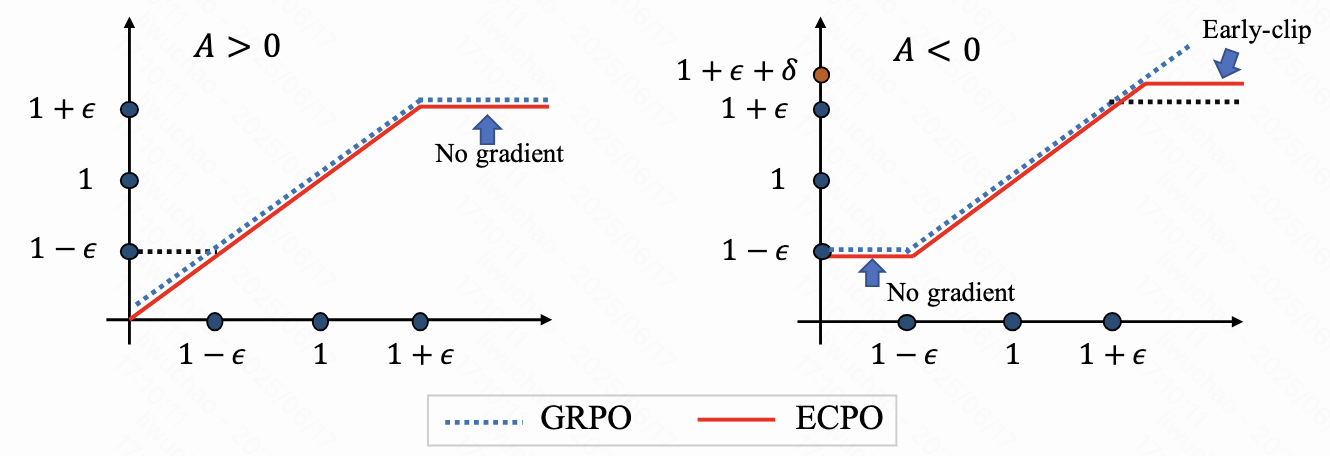

首先,什么樣的視頻應(yīng)該被獎(jiǎng)勵(lì)呢?面對(duì)這一問題,OneRec 提出采用偏好獎(jiǎng)勵(lì)模型,能基于用戶特征,輸出對(duì)不同目標(biāo)預(yù)測(cè)值進(jìn)行「?jìng)€(gè)性化融合」后的偏好分?jǐn)?shù)。過程中,利用該分?jǐn)?shù)「P-Score」作為強(qiáng)化學(xué)習(xí)的獎(jiǎng)勵(lì) r_i,并通過 GRPO 的改進(jìn)版 ECPO(Early-Clipped GRPO)進(jìn)行優(yōu)化。結(jié)果顯示,相較于 GRPO,ECPO 對(duì)負(fù)優(yōu)勢(shì)(A<0)樣本進(jìn)行更嚴(yán)格的策略梯度截?cái)啵A魳颖镜耐瑫r(shí)防止梯度爆炸使訓(xùn)練更加穩(wěn)定。

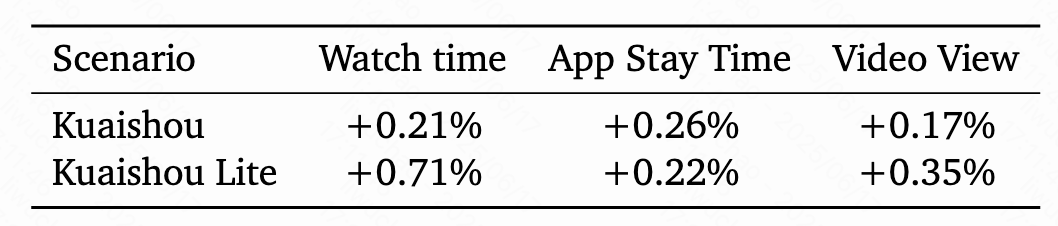

OneRec 在快手兩個(gè)場(chǎng)景進(jìn)行了強(qiáng)化學(xué)習(xí)的消融實(shí)驗(yàn),線上結(jié)果顯示:在不損失視頻曝光量的情況下顯著提升 APP 使用時(shí)長(zhǎng)。

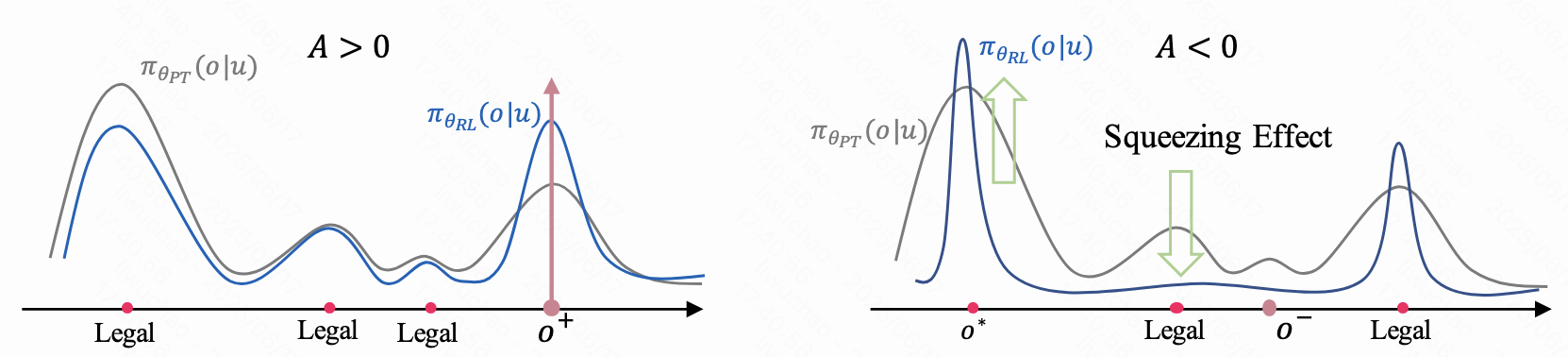

其次,在 OneRec 中,詞表空間遠(yuǎn)大于全部視頻數(shù)量,這會(huì)導(dǎo)致在推理階段生成的語義 ID 序列可能無法映射回真實(shí)視頻 ID,即非法生成。OneRec 指出強(qiáng)化學(xué)習(xí)雖然能提升效果,但由于「擠壓效應(yīng)」會(huì)導(dǎo)致模型輸出的合法性顯著下降,不僅推理成本變大且不利于推薦的多樣性。

擠壓效應(yīng):負(fù)向優(yōu)勢(shì)的梯度會(huì)將大部分的概率質(zhì)量擠壓到當(dāng)前模型的最優(yōu)輸出 o*,大部分合法輸出的概率被抹平。

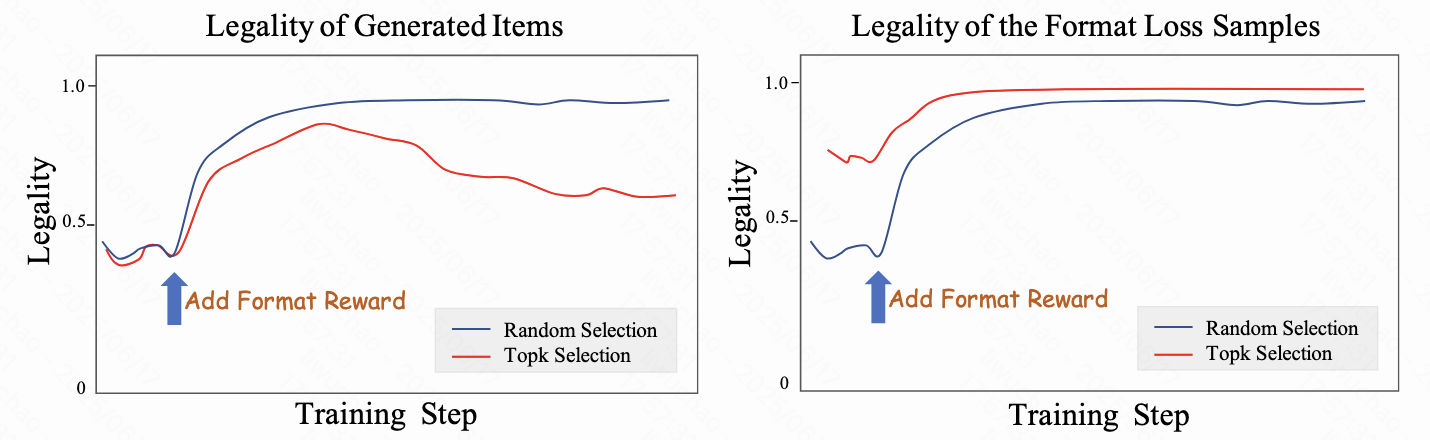

針對(duì)這個(gè)問題,OneRec 提出「以暴制暴」,用強(qiáng)化學(xué)習(xí)的方法解決強(qiáng)化學(xué)習(xí)的問題,引入格式獎(jiǎng)勵(lì)(Format Reward)鼓勵(lì)合法的輸出以緩解擠壓效應(yīng)。OneRec 對(duì)兩種合法樣本的挑選方法進(jìn)行了實(shí)驗(yàn),并觀察到非常有趣的結(jié)論:

- 從生成樣本中挑選概率最大的 k 個(gè):生成樣本的總體合法性先上升后衰減,所挑選樣本的合法性很快收斂到 100%

- 從生成樣本中隨機(jī)挑選 k 個(gè):生成樣本的總體合法性和所挑選樣本的合法性同時(shí)上升,未出現(xiàn)衰減。

這些現(xiàn)象表明,如果用概率最大的 k 個(gè)樣本訓(xùn)練,模型會(huì)很快捕捉到獎(jiǎng)勵(lì)的內(nèi)在機(jī)制,從而引發(fā)「Rward Hacking」現(xiàn)象。該實(shí)驗(yàn)不僅驗(yàn)證了格式獎(jiǎng)勵(lì)的有效性,而且表明獎(jiǎng)勵(lì)的準(zhǔn)確定義十分重要。

除了以上提到的用戶偏好獎(jiǎng)勵(lì)和格式獎(jiǎng)勵(lì),OneRec 還引入了工業(yè)場(chǎng)景獎(jiǎng)勵(lì),以滿足特殊工業(yè)需求,如營(yíng)銷號(hào)的打壓、冷啟視頻和長(zhǎng)尾視頻的分發(fā)等。

2.3 性能優(yōu)化

從衡量算力效率的核心指標(biāo) MFU(模型浮點(diǎn)運(yùn)算利用率)來說,傳統(tǒng)推薦排序模型長(zhǎng)期深陷"個(gè)位數(shù)魔咒",主要有兩方面的原因:

- 一是業(yè)務(wù)迭代積累的歷史包袱,如快手精排模型算子數(shù)量高達(dá) 15000+個(gè),復(fù)雜結(jié)構(gòu)導(dǎo)致無法像 LLM 那樣進(jìn)行深度優(yōu)化;

- 二是成本與延遲約束下的規(guī)模瓶頸,致使單個(gè)算子計(jì)算密度低下,顯存帶寬成為性能天花板,GPU 算力利用率長(zhǎng)期低于 10%。

而 OneRec 的生成式架構(gòu)帶來破局性變革:通過采用類 LLM 的 encoder-decoder 架構(gòu)精簡(jiǎn)組件,將關(guān)鍵算子數(shù)量壓縮 92%至 1,200 個(gè),配合更大模型規(guī)模提升計(jì)算密度;同時(shí)通過重構(gòu)推薦鏈路釋放延遲壓力,使訓(xùn)練/推理 MFU 分別飆升至 23.7%和 28.6%,較傳統(tǒng)方案實(shí)現(xiàn) 3-5 倍提升,首次讓推薦系統(tǒng)達(dá)到與主流 AI 模型比肩的算力效能水平。

除了模型結(jié)構(gòu)的天然優(yōu)勢(shì),團(tuán)隊(duì)還針對(duì) OneRec 特性在訓(xùn)練和推理框架層面進(jìn)行了深度定制優(yōu)化。

2.3.1 系統(tǒng)深度優(yōu)化

除了模型結(jié)構(gòu)的天然優(yōu)勢(shì),我們還針對(duì) OneRec 特性在訓(xùn)練和推理框架層面進(jìn)行了深度定制優(yōu)化。

訓(xùn)練優(yōu)化

- 計(jì)算壓縮:針對(duì)同一請(qǐng)求下的多條曝光樣本(如一次下發(fā) 6 個(gè)視頻,平均 5 條曝光),這些樣本共享用戶和 context 特征。我們按請(qǐng)求 ID 分組,避免在 context 序列上重復(fù)執(zhí)行 ffn 計(jì)算。同時(shí),利用變長(zhǎng) flash attention,有效避免重復(fù)的 kv 訪存操作,進(jìn)一步提升 attention 的計(jì)算密度。

- Embedding 加速優(yōu)化:針對(duì)單樣本需訓(xùn)練 1000 萬以上 Embedding 參數(shù)的挑戰(zhàn),我們自研了 SKAI 系統(tǒng),實(shí)現(xiàn)了 Embedding 訓(xùn)練全流程在 GPU 上完成,避免 GPU/CPU 同步中斷;通過統(tǒng)一 GPU 內(nèi)存管理(UGMMU)大幅減少 kernel 數(shù)量;采用時(shí)間加權(quán) LFU 智能緩存算法充分利用數(shù)據(jù)的時(shí)間局部性,并通過 Embedding 預(yù)取流水線將參數(shù)傳輸與模型計(jì)算重疊,有效隱藏傳輸延遲,整體大幅提升了 Embedding 訓(xùn)練效率。

- 高效并行訓(xùn)練:采用數(shù)據(jù)并行 + ZERO1 + 梯度累計(jì)的訓(xùn)練策略。選擇 ZERO1 是因?yàn)槟P?Dense 參數(shù)較小,單 GPU 可容納完整模型參數(shù)和梯度,在 interleaving 多個(gè) macro batch 時(shí)能夠減少數(shù)據(jù)并行組的同步開銷。

- 混合精度與編譯優(yōu)化:絕大部分 op 使用 BFloat16 進(jìn)行運(yùn)算,對(duì)全圖進(jìn)行編譯優(yōu)化,通過計(jì)算圖優(yōu)化和 kernel fusion 減少計(jì)算開銷。

推理優(yōu)化

OneRec 在推理階段采用大 beam size(通常為 512)來提升生成式推薦的多樣性和覆蓋率。面對(duì)如此大規(guī)模的并行生成需求,我們從計(jì)算復(fù)用、算子優(yōu)化、系統(tǒng)調(diào)度等多個(gè)維度進(jìn)行了深度優(yōu)化:

- 計(jì)算復(fù)用優(yōu)化: OneRec 針對(duì)大規(guī)模并行生成需求,通過多種計(jì)算復(fù)用手段大幅提升效率:首先,同一用戶請(qǐng)求下 encoder 側(cè)特征在所有 beam 上完全一致,因此 encoder 只需前向計(jì)算一次,避免了重復(fù)計(jì)算;其次,decoder 生成過程中 cross attention 的 key/value 在所有 beam 間共享,顯著降低顯存占用和算力消耗;同時(shí),decoder 內(nèi)部采用 KV cache 機(jī)制,緩存歷史步驟的 key/value,進(jìn)一步減少重復(fù)計(jì)算。

- 算子級(jí)優(yōu)化: OneRec 推理階段全面采用 Float16 混合精度計(jì)算,顯著提升了計(jì)算速度并降低了顯存占用。同時(shí),針對(duì) MoE、Attention、BeamSearch 等核心算子,進(jìn)行了深度 kernel 融合和手工優(yōu)化,有效減少了 GPU kernel 啟動(dòng)和內(nèi)存訪問次數(shù),全面提升了算子計(jì)算效率和整體吞吐能力。

- 系統(tǒng)調(diào)度優(yōu)化: OneRec 通過動(dòng)態(tài) Batching 策略,根據(jù)當(dāng)前系統(tǒng)負(fù)載和請(qǐng)求延遲實(shí)時(shí)調(diào)整 batch 的大小,盡可能提升每個(gè) batch 的并發(fā)度。這種方式能夠有效減少單次請(qǐng)求的平均訪存帶寬消耗,進(jìn)一步提升整體計(jì)算效率和系統(tǒng)吞吐。

通過以上系統(tǒng)性的優(yōu)化策略,OneRec 在性能方面取得了顯著提升。在算力利用率方面,訓(xùn)練和推理的 MFU 分別達(dá)到了 23.7% 和 28.8%,相比傳統(tǒng)推薦模型的 4.6% 和 11.2% 有了大幅改善。運(yùn)營(yíng)成本降低至傳統(tǒng)方案的 10.6%,實(shí)現(xiàn)了接近 90% 的成本節(jié)約。

2.4 Online 實(shí)驗(yàn)效果

OneRec 在快手主站/極速雙端 app 的短視頻推薦主場(chǎng)景上均進(jìn)行了嚴(yán)格實(shí)驗(yàn)。通過為期一周 5%流量的 AB 測(cè)試,純生成式模型(OneRec)僅憑 RL 對(duì)齊用戶偏好即達(dá)到原有復(fù)雜推薦系統(tǒng)同等效果,而疊加獎(jiǎng)勵(lì)模型選擇策略(OneRec with RM Selection)后更實(shí)現(xiàn)停留時(shí)長(zhǎng)提升 0.54%/1.24%、7 日用戶生命周期(LT7)增長(zhǎng) 0.05%/0.08%的顯著突破——須知在快手體系中,0.1%停留時(shí)長(zhǎng)或 0.01% LT7 提升即具統(tǒng)計(jì)顯著性。

更值得關(guān)注的是,模型在點(diǎn)贊、關(guān)注、評(píng)論等所有交互指標(biāo)上均取得正向收益(如下表),證明其能規(guī)避多任務(wù)系統(tǒng)的"蹺蹺板效應(yīng)"實(shí)現(xiàn)全局最優(yōu)。該系統(tǒng)目前已經(jīng)在短視頻推薦主場(chǎng)景承擔(dān) 25%的 QPS。

除了短視頻推薦的消費(fèi)場(chǎng)景之外,OneRec 在快手本地生活服務(wù)場(chǎng)景同樣表現(xiàn)驚艷:AB 對(duì)比實(shí)驗(yàn)表明該方案推動(dòng) GMV 暴漲 21.01%、訂單量提升 17.89%、購(gòu)買用戶數(shù)增長(zhǎng) 18.58%,其中新客獲取效率更實(shí)現(xiàn) 23.02%的顯著提升。

目前,該業(yè)務(wù)線已實(shí)現(xiàn) 100%流量全量切換。值得注意的是,全量上線后的指標(biāo)增長(zhǎng)幅度較實(shí)驗(yàn)階段進(jìn)一步擴(kuò)大,充分驗(yàn)證了 OneRec 在不同業(yè)務(wù)場(chǎng)景的泛化能力。

三、總結(jié)和展望

OneRec 通過創(chuàng)新的生成式架構(gòu)重構(gòu)推薦系統(tǒng)的技術(shù)范式。與此同時(shí)經(jīng)過極致的工程優(yōu)化,在效果與效率雙重維度上實(shí)現(xiàn)全面超越。當(dāng)然,新系統(tǒng)還有很多地方未完善,報(bào)告中仍指出了三個(gè)待突破的方向:

- 推理能力:Infer 階段 step 的 scaling up 能力尚不明顯,這預(yù)示著 OneRec 還不具備很強(qiáng)的推理能力;

- 多模態(tài)橋接:構(gòu)建用戶行為模態(tài)與 LLM/VLM 的原生融合架構(gòu),借鑒 VLM 中的跨模態(tài)對(duì)齊技術(shù),實(shí)現(xiàn)用戶行為序列、視頻內(nèi)容與語義空間的統(tǒng)一學(xué)習(xí),成為一個(gè)原生全模態(tài)的模型;

- 完備的 Reward System:目前 Reward System 的設(shè)計(jì)還比較初級(jí)。在 OneRec 端到端的架構(gòu)下,Reward System 既能影響在線結(jié)果也能影響離線訓(xùn)練,我們期望利用該能力引導(dǎo)模型更好地理解用戶偏好和業(yè)務(wù)需求,提供更優(yōu)的推薦體驗(yàn)。

可以預(yù)見,隨著 AI 能力的持續(xù)融入,OneRec 將釋放出更強(qiáng)大的能力,在更廣泛的推薦應(yīng)用場(chǎng)景中創(chuàng)造更大的業(yè)務(wù)價(jià)值。