人類偏好就是尺!SPPO對齊技術讓大語言模型左右互搏、自我博弈 精華

Richard Sutton 在 「The Bitter Lesson」中做過這樣的評價:「從70年的人工智能研究中可以得出的最重要教訓是,那些利用計算的通用方法最終是最有效的,而且優勢巨大。」

自我博弈(self play)就是這樣一種同時利用搜索和學習從而充分利用和擴大計算規模的方法。

今年年初,加利福尼亞大學洛杉磯分校(UCLA)的顧全全教授團隊提出了一種自我博弈微調方法 (Self-Play Fine-Tuning, SPIN),可不使用額外微調數據,僅靠自我博弈就能大幅提升 LLM 的能力。

最近,顧全全教授團隊和卡內基梅隆大學(CMU)Yiming Yang教授團隊合作開發了一種名為「自我博弈偏好優化(Self-Play Preference Optimization, SPPO)」的對齊技術,這一新方法旨在通過自我博弈的框架來優化大語言模型的行為,使其更好地符合人類的偏好。左右互搏再顯神通!

- 論文標題:Self-Play Preference Optimization for Language Model Alignment

- 論文鏈接:https://arxiv.org/pdf/2405.00675.pdf

技術背景與挑戰

大語言模型(LLM)正成為人工智能領域的重要推動力,憑借其出色的文本生成和理解能力在種任務中表現卓越。盡管LLM的能力令人矚目,但要使這些模型的輸出行為更符合實際應用中的需求,通常需要通過對齊(alignment)過程進行微調。

這個過程關鍵在于調整模型以更好地反映人類的偏好和行為準則。常見的方法包括基于人類反饋的強化學習(RLHF)或者直接偏好優化(Direct Preference Optimization,DPO)。

基于人類反饋的強化學習(RLHF)依賴于顯式的維護一個獎勵模型用來調整和細化大語言模型。換言之,例如,InstructGPT就是基于人類偏好數據先訓練一個服從Bradley-Terry模型的獎勵函數,然后使用像近似策略優化(Proximal Policy Optimization,PPO)的強化學習算法去優化大語言模型。去年,研究者們提出了直接偏好優化(Direct Preference Optimization,DPO)。

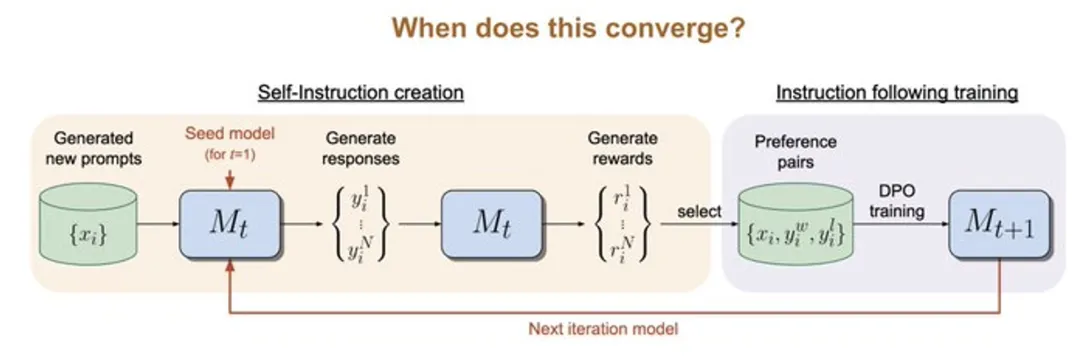

不同于RLHF維護一個顯式的獎勵模型,DPO算法隱含的服從Bradley-Terry模型,但可以直接用于大語言模型優化。已有工作試圖通過多次迭代的使用DPO來進一步微調大模型 (圖1)。

圖1.基于Bradley-Terry模型的迭代優化方法缺乏理論理解和保證

如Bradley-Terry這樣的參數模型會為每個選擇提供一個數值分數。這些模型雖然提供了合理的人類偏好近似,但未能完全捕獲人類行為的復雜性。

這些模型往往假設不同選擇之間的偏好關系是單調和傳遞的,而實證證據卻常常顯示出人類決策的非一致性和非線性,例如Tversky的研究觀察到人類決策可能會受到多種因素的影響,并表現出不一致性。

SPPO的理論基礎與方法

圖2.假想的兩個語言模型進行常和博弈。

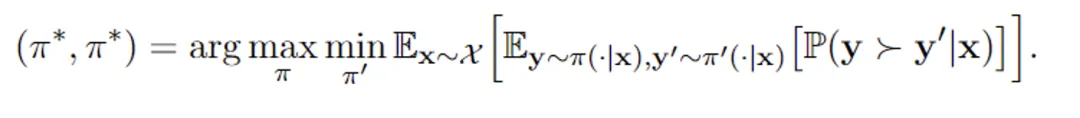

在這些背景下,作者提出了一個新的自我博弈框架 SPPO,該框架不僅具有解決兩玩家常和博弈(two-player constant-sum game)的可證明保證,而且可以擴展到大規模的高效微調大型語言模型。

具體來說,文章將RLHF問題嚴格定義為一個兩玩家常和博弈 (圖2)。該工作的目標是識別納什均衡策略,這種策略在平均意義上始終能提供比其他任何策略更受偏好的回復。

為了近似地識別納什均衡策略,作者采用了具有乘法權重的經典在線自適應算法作為解決兩玩家博弈的高層框架算法。

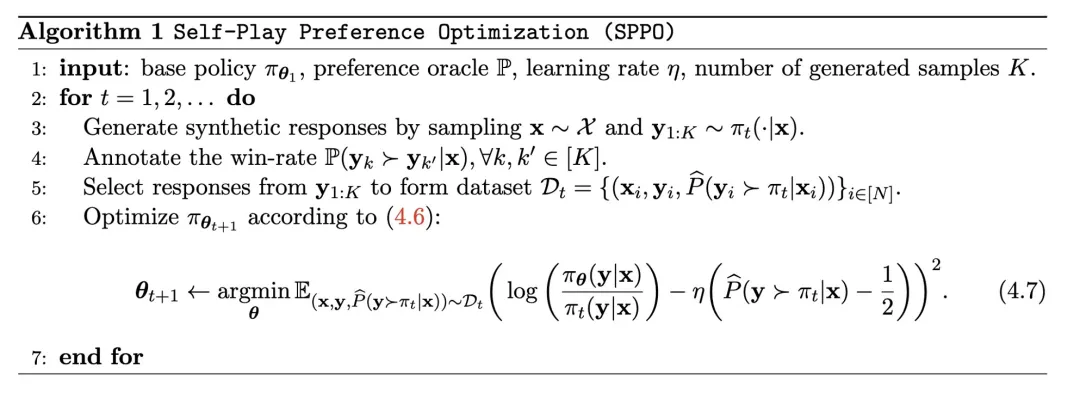

在該框架的每一步內,算法可以通過自我博弈機制來近似乘法權重更新,其中在每一輪中,大語言模型都在針對上一輪的自身進行微調,通過模型生成的合成數據和偏好模型的注釋來進行優化。

具體來說,大語言模型在每一輪回會針對每個提示生成若干回復;依據偏好模型的標注,算法可以估計出每個回復的勝率;算法從而可以進一步微調大語言模型的參數使得那些勝率高的回復擁有更高的出現概率(圖3)。

圖3.自我博弈算法的目標是微調自身從而勝過上一輪的語言模型

實驗設計與成果

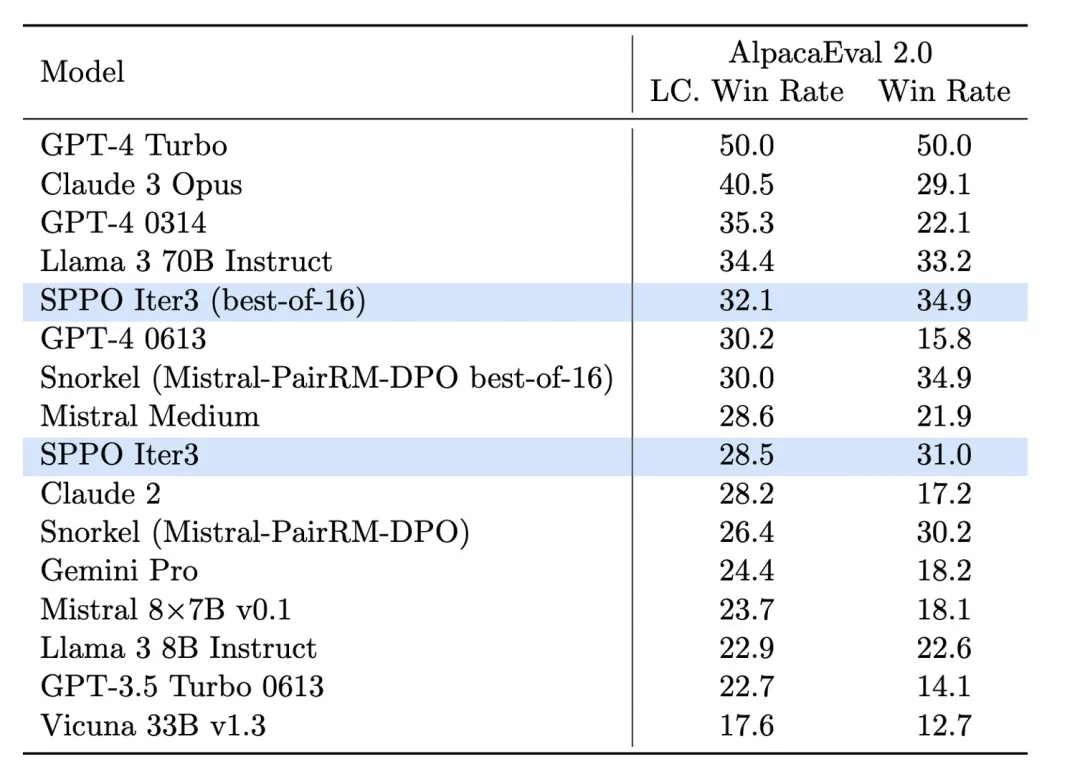

在實驗中,研究團隊采用了一種Mistral-7B作為基線模型,并使用了UltraFeedback數據集的60,000個提示(prompt)進行無監督訓練。他們發現,通過自我博弈的方式,模型能夠顯著提高在多個評估平臺上的表現,例如AlpacaEval 2.0和MT-Bench。這些平臺廣泛用于評估模型生成文本的質量和相關性。

通過SPPO方法,模型不僅在生成文本的流暢性和準確性上得到了改進,更重要的是:「它在符合人類價值和偏好方面表現得更加出色」。

圖4.SPPO模型在AlpacaEval 2.0上的效果提升顯著,且高于如 Iterative DPO 的其他基準方法。

在AlpacaEval 2.0的測試中(圖4),經過SPPO優化的模型在長度控制勝率方面從基線模型的17.11%提升到了28.53%,顯示了其對人類偏好理解的顯著提高。經過三輪SPPO優化的模型在AlpacaEval2.0上顯著優于多輪迭代的DPO, IPO和自我獎勵的語言模型(Self-Rewarding LM)。

此外,該模型在MT-Bench上的表現也超過了傳統通過人類反饋調優的模型。這證明了SPPO在自動調整模型行為以適應復雜任務方面的有效性。

結論與未來展望

自我博弈偏好優化(SPPO)為大語言模型提供了一個全新的優化路徑,不僅提高了模型的生成質量,更重要的是提高了模型與人類偏好的對齊度。

隨著技術的不斷發展和優化,預計SPPO及其衍生技術將在人工智能的可持續發展和社會應用中發揮更大的作用,為構建更加智能和負責任的AI系統鋪平道路。

本文轉自 機器之心 ,作者:機器之心