谷歌推出TransformerFAM架構,以更低的消耗處理長序列文本

Transformer對大模型界的影響力不言而喻,ChatGPT、Sora、Stable Difusion等知名模型皆使用了該架構。

但有一個很明顯的缺點,其注意力復雜度的二次方增長在處理書籍、PDF等超長文檔時會顯著增加算力負擔。

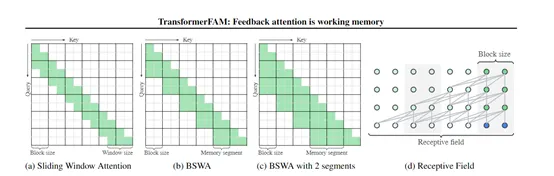

雖然會通過滑動窗口注意力和稀疏注意力等技術來解決這一問題,在處理極長序列時仍存在局限性。

因此,谷歌的研究人員提出了全新架構TransformerFAM,可以無縫與預訓練模型集成,并通過LoRA進行少量精調從而大幅度提升模型性能。

研究人員在1B、8B和24B三種參數的Flan-PaLM大語言模型上評估了Transformer FAM的性能。實驗結果顯示,與Transformer架構相比,TransformerFAM在長序列任務上取得了好的能力并且資源消耗更低。

論文地址:https://arxiv.org/abs/2404.09173

TransformerFAM的技術靈感來自人腦中工作記憶的機制。研究人員發現,大腦中的工作記憶能力是由前額葉皮層和視床之間的反饋循環維持的,即持續的神經元脈沖活動形成了一個反饋回路,從而實現了對短期記憶的維持和更新。

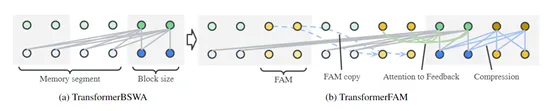

受此啟發,研究人員設計了一個集成在Transformer中的反饋循環,使得注意力機制不僅可以關注輸入序列,還能自我關注自身的潛在表示,使大模型能夠存儲超長和更新全局上下文信息。

簡單來說,可以把TransformerFAM看成是一個"便簽本",可以幫助大模型記住很多短暫、細小的事情,又不會對內存、算力造成過多的負擔。

反饋注意力記憶

?

反饋注意力記憶(Feedback Attention Memory,FAM)是TransformerFAM架構的核心模塊,主要通過反饋循環使神經網絡能夠注意到自身的潛在表示,從而允許大模型處理超長的輸入序列。

研究人員在每個Transformer層中都加入了FAM模塊,在自注意力過程中被激活,使得輸入查詢不僅關注當前塊和滑動窗口覆蓋的過去記憶段,還能關注前一步的FAM狀態,將全局上下文知識融入當前表示。

同時一個專門的FAM查詢則負責根據當前塊和上一步的FAM,更新后續的FAM狀態以實現全局上下文信息的傳遞。

這種巧妙設計使得每個Transformer層都能夠維持一個與其抽象層次相對應的分布式工作記憶狀態。

塊內壓縮

?

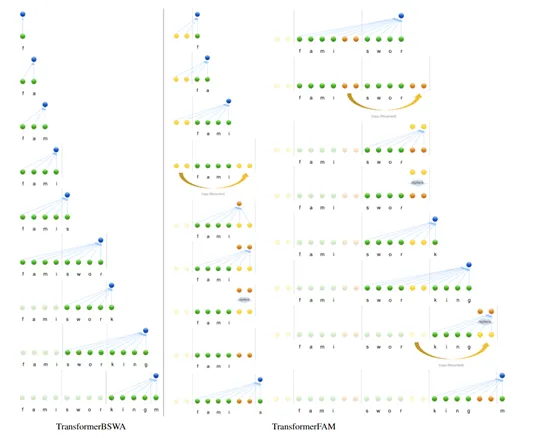

塊內壓縮是Transformer架構中處理長序列數據的關鍵技術。主要是將長序列分成若干個小塊,然后對每個塊中的信息進行壓縮,以便模型能夠更高效地處理和記憶這些信息。

在每個Transformer層中,塊內壓縮通過自注意力機制將當前塊的信息壓縮成一個固定長度的表示用于反饋記憶的激活。然后再與之前的FAM狀態結合,通過一個前饋網絡進行更新生成全新的FAM狀態。

更新后的FAM狀態會被傳遞到下一個塊,作為那里的額外上下文信息,從而實現跨塊的數據信息傳遞。

隨著模型逐塊處理整個序列,新的記憶狀態會包含越來越多跨塊的信息,從而形成一個全局的上下文理解,但對內存、算力的需求幾乎沒有額外增加,同時又獲得了“記憶存儲”的泛化能力。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區