LLM | SimPO:使用無參考獎勵的簡單偏好優化

一、結論寫在前面

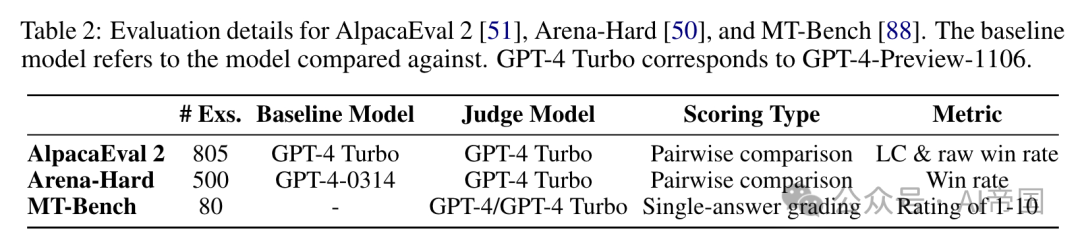

直接偏好優化(DPO)是一種廣泛使用的離線偏好優化算法,它通過人類反饋(RLHIP)重新參數化強化學習中的獎勵函數,以增強簡單性和訓練穩定性。

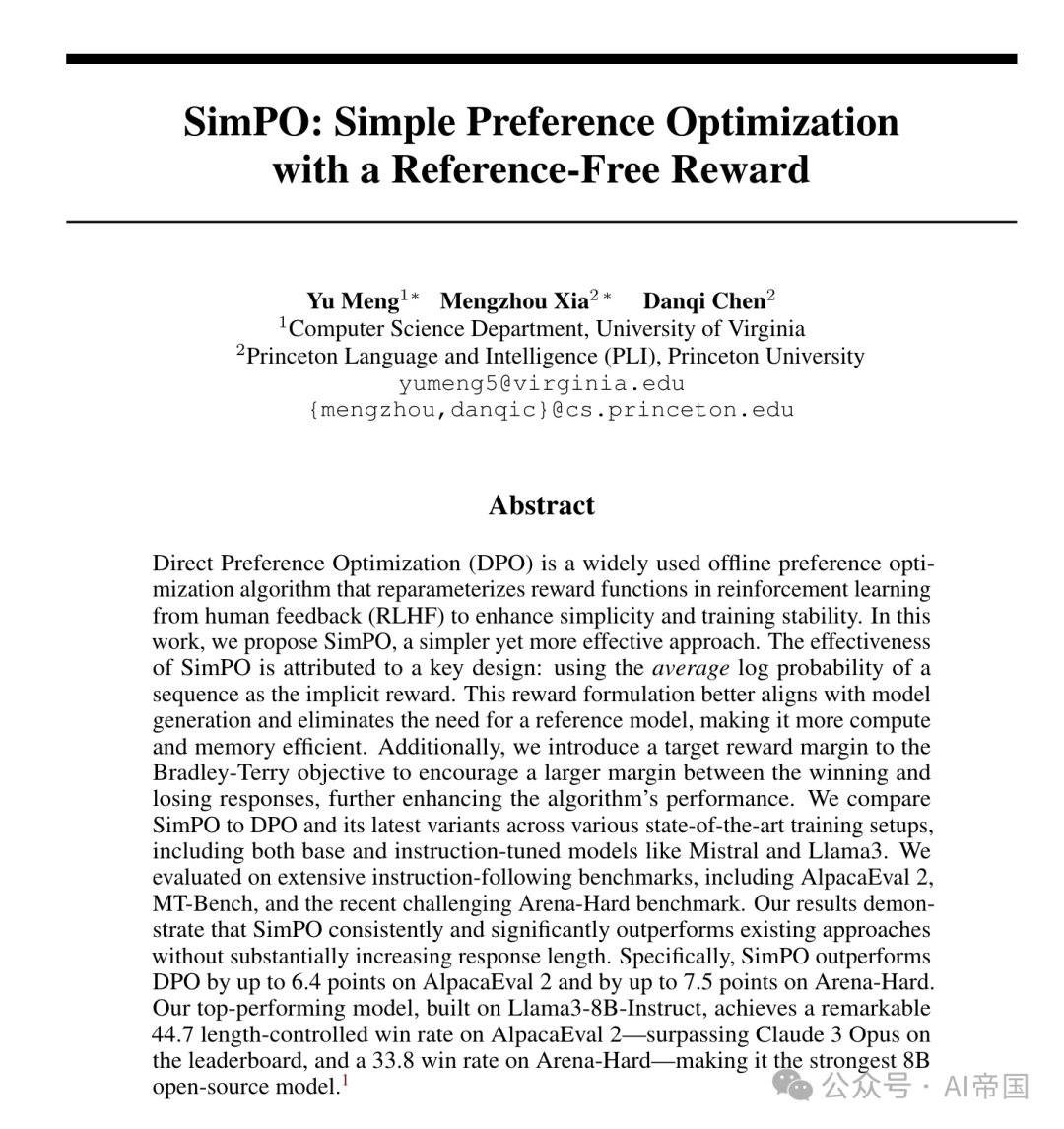

論文提出了SimPO,一種更簡單但更有效的方法。SimPO的有效性歸功于一個關鍵設計:使用序列的平均對數概率作為隱式獎勵。這種獎勵形式更好地與模型生成對齊,并消除了對參考模型的需求,使其在計算和內存上更高效。此外,論文在Bradley-Terry目標中引入了一個目標獎勵邊際,以鼓勵獲勝和失敗響應之間的更大邊際,進一步提升了算法的性能。論文將SimPO與DPO及其最新變體在各種最先進的訓練設置中進行了比較,包括Mistral和Llama3等基礎和指令調整模型。論文在廣泛的指令遵循基準上進行了評估,包括AlpacaEval 2、MT-Bench以及最近具有挑戰性的Arena-Hard基準。

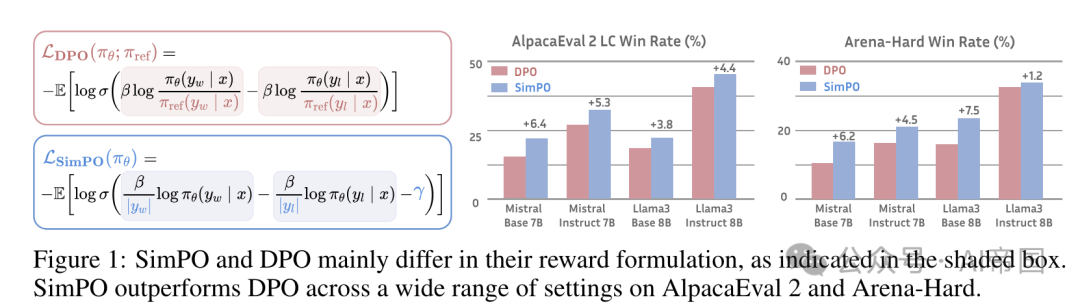

論文的結果表明,SimPO始終且顯著地優于現有方法,而不會大幅增加響應長度。具體而言,SimPO在AlpacaEval 2上超越DPO最多6.4分,在Arena-Hard上最多7.5分。論文基于Llama3-8B-Instruct構建的頂級模型在AlpacaEval 2上實現了驚人的44.7長度控制勝率——超越了排行榜上的Claude 3 Opus,并在Arena-Hard上達到了33.8的勝率,使其成為最強大的8B開源模型。

盡管SimPO在實證上取得了成功并具有直觀的動機,但論文缺乏對其工作原理的理論和嚴格理解。此外,引入目標獎勵邊際需要論文調整額外的超參數,未來的工作可以探索如何自動確定最佳邊際。其次,SimPO是一種離線偏好算法,并未利用迭代訓練或其他正交技術。未來的研究可以探索將SimPO與這些方法結合,以進一步提高模型性能。第三,論文的實驗僅專注于評估幫助性,忽略了模型行為的其他關鍵方面,如安全性、誠實性和公平性。在未來的研究中,調查SimPO在這些行為上的泛化能力是重要的。最后,論文觀察到在一些下游任務上,尤其是在數學基準測試上的性能下降。

二、論文的簡單介紹

2.1 論文的背景

從人類反饋中學習對于使大型語言模型(LLMs)與人類價值觀和意圖對齊至關重要,確保它們是有幫助的、誠實的和無害的。從人類反饋的強化學習(RLHF)是一種流行的方法,用于微調語言模型以實現有效對齊。盡管經典的RLIIF方法已顯示出令人印象深刻的結果,但由于其多階段程序,它提出了優化挑戰,該程序涉及訓練獎勵模型,然后優化策略模型以最大化該獎勵。

最近,研究人員一直在探索更簡單的離線算法。直接偏好優化(DPO)就是這樣一種方法。DPO重新參數化了RLHF中的獎勵函數,直接從偏好數據中學習策略模型,從而消除了顯式獎勵模型的需求。由于其簡單性和穩定性,它獲得了廣泛的實際采用。在DPO中,隱含的獎勵是使用當前策略模型和監督微調(SFT)模型之間響應的可能性對數比值來形式化的。然而,這種獎勵形式化并不直接與用于指導生成的度量相一致,這個度量大約是策略模型生成的響應的平均對數似然。論文假設訓練和推理之間的這種差異可能導致性能不佳。

圖1:SimPO和DPO主要在獎勵公式上有所不同,如圖中陰影框所示。在AlpacaEval 2和Arena-Hard的廣泛設置中,SimPO優于DPO

在本工作中,論文提出了SimPO,一種簡單而有效的離線偏好優化算法(圖1)。論文算法的核心是將偏好優化目標中的獎勵函數與生成度量對齊。SimPO包含兩個主要組件:(1) 一個長度歸一化獎勵,計算為策略模型中所有令牌在響應中的平均對數概率,以及(2) 一個目標獎勵邊際,確保獲勝和失敗響應之間的獎勵差異超過此邊際。

表1:AlpacaEval 2排行榜上頂級模型的長度控制(LC)和原始勝率(WR),以及生成長度。粗體為論文訓練的模型

2.2 論文的方法--SimPO

2.2.1 背景:直接偏好優化(DPO)

DPO 是最流行的離線偏好優化方法之一。DPO不是學習一個顯式的獎勵模型 ,而是使用一個封閉形式的表達式重新參數化獎勵函數。

2.2.2 與生成一致的簡單無參考獎勵

DPO中獎勵與生成的差異。使用公式(1)作為隱式獎勵表達式存在以下缺點:(1) 訓練期間需要參考模型Tref,這增加了內存和計算成本;(2) 訓練期間優化的獎勵與用于推理的生成指標之間存在差異。具體而言,在生成過程中,策略模型πθ用于生成序列,該序列大致最大化平均對數似然。

在解碼過程中直接最大化此指標是不可行的,可以使用各種解碼策略來近似它,例如貪心解碼、束搜索、核采樣和top-k采樣。此外,此指標常用于語言模型中的多項選擇任務中對選項進行排名。在DPO中,對于任何三元組,滿足獎勵排名并不一定意味著似然排名成立。事實上,當使用DPO訓練時,僅約50%的保留集三元組滿足此條件(見圖4b)。

2.2.3 SimPO目標

目標獎勵邊際。此外,論文在Bradley-Terry目標中引入了一個目標獎勵邊際項,以確保獲勝響應的獎勵至少超過失敗響應的獎勵。兩個類別之間的邊際被認為會影響分類器的泛化能力。在標準訓練設置中,隨機模型初始化下,增加目標邊際通常會提高泛化能力。在偏好優化中,兩個類別是單個輸入的獲勝和失敗響應。實際上,論文觀察到生成質量最初隨著目標邊際的增加與提高,但當邊際變得過大時會下降。DPO的一個變體,IPO,也提出了一個類似SimPO的目標獎勵邊際。然而,其完整目標不如SimPO有效。

目標。SimPO目標:

總之,SimPO采用了一種與生成指標直接對齊的隱式獎勵公式,消除了對參考模型的需求。此外,它引入了一個目標獎勵邊際y,以幫助區分獲勝和失敗響應。在附錄E中,論文提供了SimPO和DPO的梯度分析,以進一步理解這兩種方法之間的差異。

2.3 論文的效果

2.3.1 實驗設置

模型和訓練設置。論文在兩種模型系列Llama3-8B和Mistral-7B上進行偏好優化,分別在基礎和指令兩種設置下進行。

在Base設置中,論文首先在UltraChat-200k數據集上對一個基礎模型進行監督微調(SFT)以獲得SFT模型。接著,論文使用SFT模型作為起點,在UltraFeedback數據集上進行偏好優化。這種設置提供了高度的透明性,因為SFT模型是基于開源數據訓練的。

對于Instruct設置,論文使用現成的指令調優模型(作為SFT模型。這些模型經歷了廣泛的指令調優過程,使其比Base設置中的SFT模型更強大和穩健。然而,它們也更不透明,因為它們的RLIIF過程未公開披露。為了減輕SFT模型與偏好優化過程之間的分布偏移,論文根據使用SFT模型生成偏好數據集。

綜上所述,論文有四種設置:Llama3-Base、Llama3-Instruct、Mistral-Base和Mistral-Instruct。論文相信這些配置代表了最先進的技術水平,使論文的模型在各種排行榜上名列前茅。論文鼓勵未來的研究采用這些設置,以實現不同算法之間更好和更公平的比較。

此外,論文發現調整超參數對于所有離線偏好優化算法(包括SimPO)實現最佳性能至關重要。通常,對于SimPO,設置B在2.0到2.5之間,y在0.5到1.5之間,可以在所有設置中獲得良好的性能。更多詳情,請參閱附錄A。

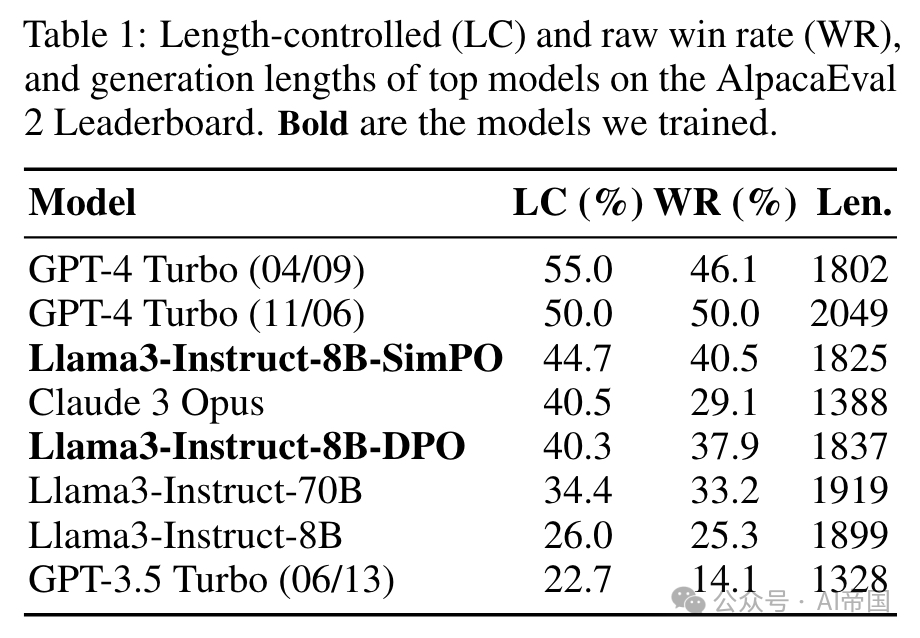

評估基準。 論文主要使用三個最受歡迎的開放式指令遵循基準來評估論文的模型:MT-Bench 、AlpacaEval 2 [和 Arena-Hard v0.1。這些基準測試了模型在多樣化查詢集上的多才多藝對話能力,并已被社區廣泛采用(詳情見表2)。

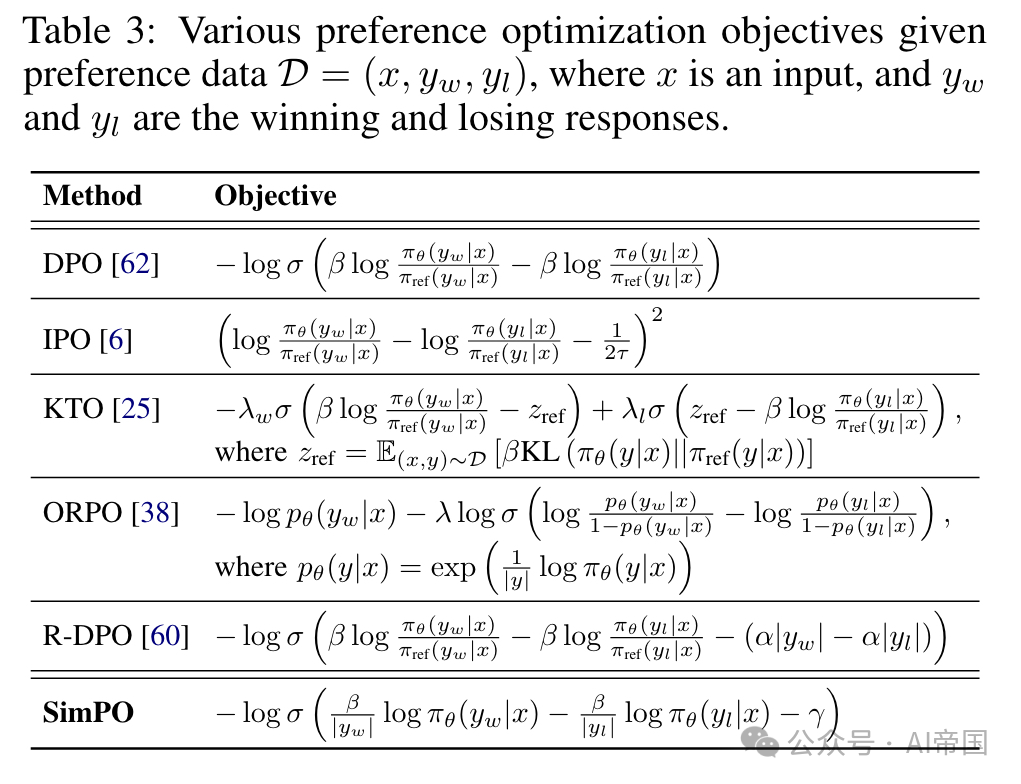

基線。 論文將SimPO與其他離線偏好優化方法進行了比較,這些方法列于表3中。IPO 是一種理論基礎方法,避免了DPO假設成對偏好可以被點態獎勵替代。KTO [25]從非配對偏好數據中學習。ORPO 引入了一個參考模型無關的奇數比率項,直接對比獲勝和失敗的響應與策略模型,并聯合訓練SFT目標。R-DPO 是DPO的修改版本,包含了一個額外的正則化項以防止長度利用。論文徹底調整了超參數。對于每個基線參數,論文報告最佳性能。論文發現許多DPO的變體在實證上并未顯示出優于標準DPO的優勢。更多細節可在附錄A中找到。

2.3.2實驗結果

2.3.2.1 主要結果和消融研究

表3:給定偏好數據D,各種偏好優化目標。

方法

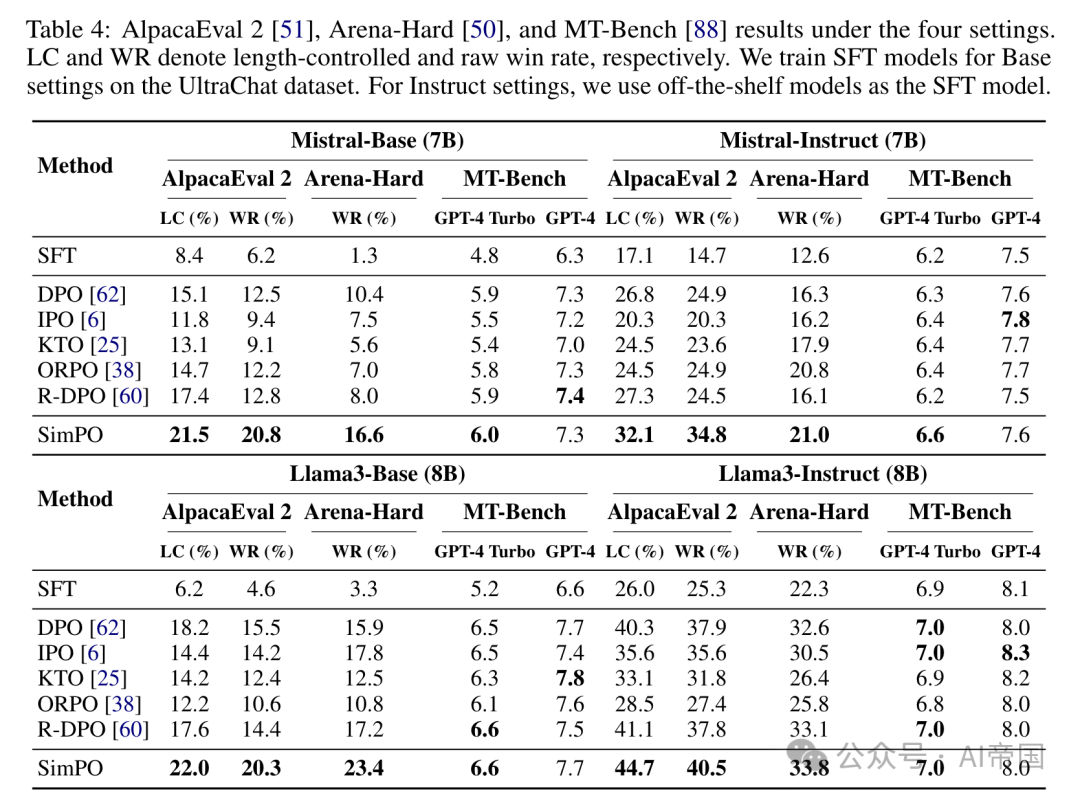

SimPO始終且顯著地超越了現有的偏好優化方法。如表4所示,盡管所有偏好優化算法都提升了SFT模型的性能,但SimPO,盡管其簡單性,在所有基準和設置中實現了最佳的整體性能。值得注意的是,SimPO在AlpacaEval 2 LC勝率上比最佳基線高出3.6至4.8個百分點,在Arena-Hard上跨不同設置高出0.2至6.2個百分點。這些一致且顯著的改進突顯了SimPO的魯棒性和有效性。

基準測試的質量有所不同。盡管所有三個基準測試都被廣泛采用,但論文發現MTBench在不同方法之間的可分離性較差。MTBench上方法之間的微小差異可能歸因于隨機性,這可能是由于其評估數據的規模有限以及其單實例評分協議所致。這一發現與 [50] 中報告的觀察結果一致。

相比之下,AlpacaEval 2和Arena-Hard能夠在不同方法之間提供更有意義的區分。另外,Arena-Hard采用了與基線模型不同的評判模型,可能會帶來更公平的評估。論文觀察到,Arena-Hard上的勝率明顯低于AlpacaEval 2,這表明Arena-Hard是一個更具挑戰性的基準測試。

表 4:在四種設置下的 AlpacaEval 2 [51]、Arena-Hard [50] 和 MT-Bench [88] 結果。LC 和 WR 分別表示長度控制和原始勝率。論文在 UltraChat 數據集上針對基礎設置訓練 SFT 模型。對于指令設置,論文使用現成的模型作為 SFT 模型

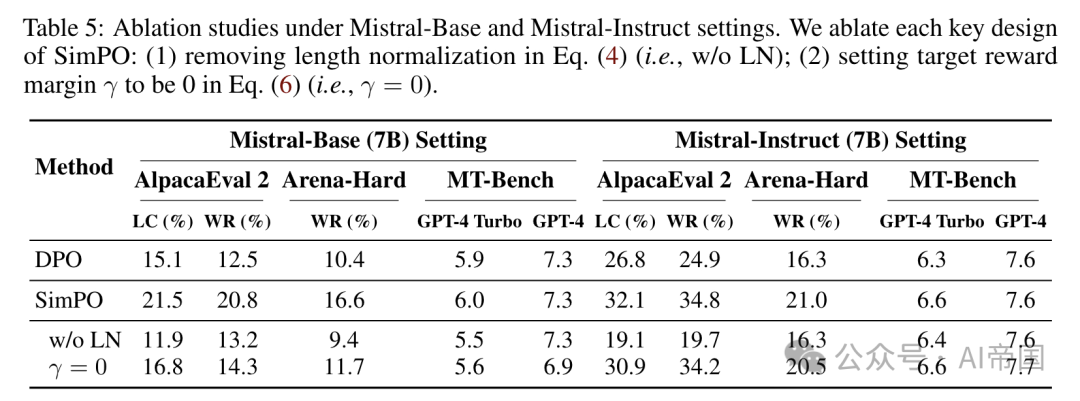

表 5:在 Mistral-Base 和 Mistral-Instruct 設置下的消融研究。論文對 SimPO 的每個關鍵設計進行消融:(1) 在等式 (4) 中去除長度歸一化(即,w/o LN);(2) 在等式 (6) 中將目標獎勵邊際  設為 0(即,

設為 0(即, )

)

Instruct設置引入了顯著的性能提升。在所有基準測試中,論文觀察到Instruct設置始終優于Base設置。這種改進可能是由于用于初始化的SFT模型質量更高,以及這些模型生成了更高質量的偏好數據。

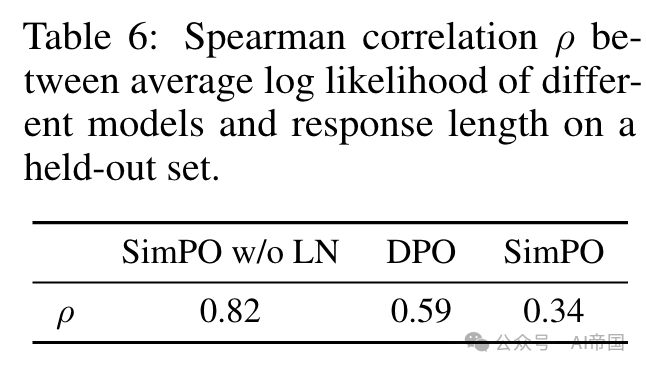

SimPO中的兩個關鍵設計至關重要。在表5中,論文展示了去除SimPO每個關鍵設計元素后的結果:(1) 在公式(4)中移除長度歸一化(即,無LN);(2) 在公式(6)中將目標獎勵邊際設為0(即,y = 0)。移除長度歸一化對結果產生了最大的負面影響。論文的檢查發現,這會導致生成冗長且重復的模式,顯著降低輸出整體質量(見附錄D)。將y設為0也導致性能下降,相比SimPO表現不佳,表明這并非最佳選擇。

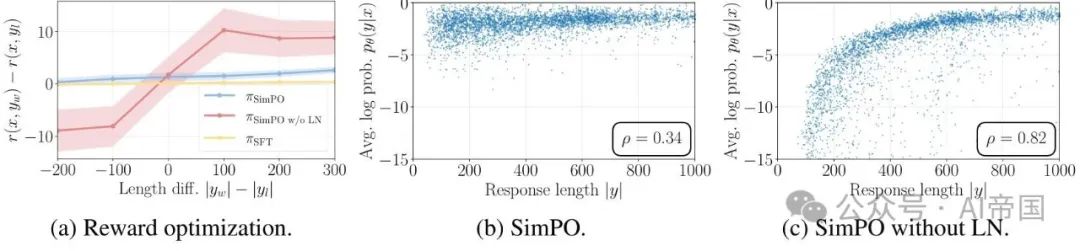

圖2:長度歸一化(LN)的影響。(a) 獎勵邊際與獲勝和失敗響應之間的長度差異的關系。(b) SimPO中平均對數概率與響應長度之間的Spearman相關性。(c) 未采用LN的SimPO的Spearman相關性

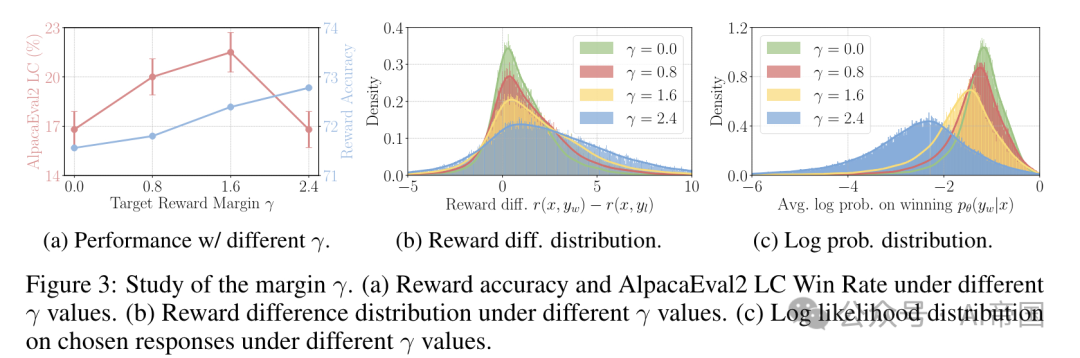

圖3:邊際研究。(a) 不同y值下的獎勵準確性和AlpacaEval2 LC勝率。(b) 不同y值下的獎勵差異分布。(c) 不同y值下選擇的響應的對數似然分布

2.3.2.2 長度歸一化(LN)防止長度利用

長度歸一化導致所有偏好對之間的獎勵差異增加,無論其長度如何。論文調查了從UltraFeedback訓練集中獲勝和失敗響應之間的學習獎勵差異與長度差異Δl = yw - yn之間的關系。論文使用SFT模型、SimPO模型以及未使用長度歸一化的SimPO訓練的模型來測量獎勵差異。結果如圖2a所示,觀察到帶有LN的SimPO始終為所有響應對實現正獎勵邊際,無論其長度差異如何,并且始終提高了邊際超過SFT模型。相比之下,不帶LN的SimPO在獲勝響應短于失敗響應的偏好對中導致了負獎勵差異,表明模型在這些實例上學習不佳。

移除LN導致獎勵與響應長度之間存在強烈的正相關關系,從而引發長度利用問題。圖2b和2c展示了在保留集上,使用SimPO訓練的模型與未使用LN訓練的模型的平均對數似然度與響應長度之間的關系。未使用LN訓練的模型顯示出比SimPO更強的正斯皮爾曼相關性,表明其傾向于利用長度偏差并生成更長的序列。相比之下,SimPO導致斯皮爾曼相關系數與SFT模型相似。

2.3.2.3 SimPO中目標獎勵邊際的影響

目標獎勵邊際y對獎勵準確性和勝率的影響。論文研究了SimPO中目標獎勵邊際n如何影響保留集上的獎勵準確性和AlpacaEval 2上的勝率,結果如圖3a所示。獎勵準確性被衡量為偏好對中獲勝響應最終獲得的獎勵高于失敗響應的比例。論文觀察到,在兩個基準測試上,獎勵準確性隨y的增加而提高,表明強制實施更大的目標獎勵邊際有效地提高了獎勵準確性。

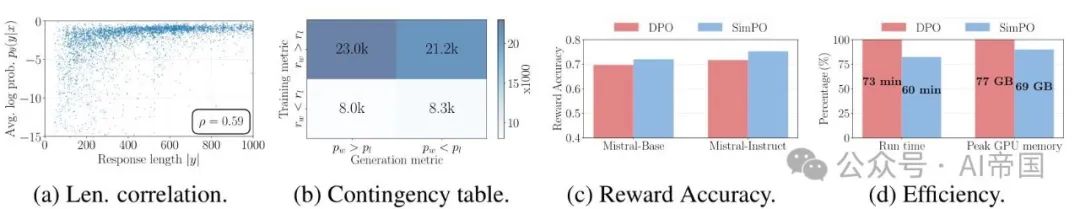

圖4:SimPO與DPO在UltraFeedback上的對比。(a) DPO中平均對數概率與響應長度之間的Spearman相關性。(b) 基于DPO獎勵和訓練集上的平均對數似然排名的列聯表。(c) DPO和SimPO的獎勵準確性。(d) DPO和SimPO的運行時間和內存使用情況。

2.3.2.4 DPO與SimPO的深入分析

本節中,論文從以下四個方面對比SimPO與DPO:(1) 似然-長度相關性,(2) 獎勵公式化,(3) 獎勵準確性,(4) 算法效率。論文證明SimPO在獎勵準確性和效率方面優于DPO。

DPO獎勵隱含地促進了長度歸一化。盡管DPO獎勵表達式缺少明確的長度歸一化項,但策略模型與參考模型之間的對數比值可以隱式地抵消長度偏差。如表6和圖4a所示,采用DPO降低了平均對數似然與響應長度之間的斯皮爾曼相關系數,相比于不進行任何長度歸一化的方法。然而,與SimPO相比,它仍然表現出更強的正相關性。

DPO獎勵與生成可能性不匹配。DPO的獎勵函數 與目標生成技術存在分歧,直接影響生成過程。相比之下,SimPO直接采用平均對數似然(按B縮放)作為獎勵表達式,從而完全消除了這種差異,如圖5b所示。

DPO在獎勵精度方面落后于SimPO。在圖4c中,論文比較了SimPO和DPO的獎勵精度,評估了它們最終學習到的獎勵與留出集上的偏好標簽的一致性。論文觀察到,SimPO始終比DPO取得更高的獎勵精度,這表明論文的獎勵設計有助于更有效的泛化,并導致更高質量的生成結果。

SimPO比DPO在內存和計算效率方面更有優勢。SimPO的另一個好處是效率較高,因為它不使用參考模型。圖4d展示了在使用8個H100 GPU的Llama3-Base設置下,SimPO和DPO的整體運行時間和每GPU內存峰值使用情況。與普通DPO實現相比,SimPO減少了約20%的運行時間,降低了約10%的GPU內存使用,這得益于不需要使用參考模型進行前向傳播。

論文標題:SimPO: Simple Preference Optimization with a Reference-Free Reward

論文鏈接:???https://arxiv.org/pdf/2405.14734??

本文轉載自 ??AI帝國??,作者: 無影寺