英特爾實驗室最新成果:LLaMA-NAS — — 大型語言模型的高效神經架構搜索 精華

隨著模型規模的不斷擴大,其對計算資源的需求也水漲船高。高昂的內存和計算成本不僅限制了LLMs在高性能計算平臺之外的應用,也增加了研究和開發的門檻,這對于資源有限的研究機構和企業尤其成問題。在這樣的背景下,減小LLMs的大小和計算復雜度顯得尤為重要。這可以使LLMs在更廣泛的硬件平臺上得到應用,包括那些價格更便宜、更易獲得的設備,從而推動AI技術的普及和應用。優化模型的計算效率對于環境的可持續性也至關重要,因為計算資源的消耗直接關聯到能源使用和碳排放。

來自于自英特爾公司的英特爾實驗室(Intel Labs)的研究團隊提出了一種有效的方法,他們找到基于LLaMA2-7B的Pareto最優網絡架構,使用一次性神經架構搜索(NAS)。他們通過一次性微調LLaMA2-7B,然后應用基于遺傳算法的搜索來找到更小、計算復雜度更低的網絡架構。研究表明,對于某些標準基準任務,預訓練的LLaMA2-7B網絡過于龐大和復雜。具體來說,他們展示了在幾乎不影響準確度的情況下,模型大小減少了1.5倍,吞吐量速度提高了1.3倍。此外,他們的方法比某些剪枝或稀疏化技術更有效、更高效。最后他們展示了量化技術是如何補充他們的方法的,以及使用量化技術可以進一步減少他們找到的網絡的大小和復雜度。他們相信,他們的工作提供了一種自動創建可以在更便宜、更容易獲得的硬件平臺上使用的大型語言模型(LLMs)的方法。

英特爾實驗室的研究動機正是基于優化模型的計算效率的需求,通過高效的神經架構搜索(NAS),LLaMA-NAS旨在找到Pareto最優的網絡架構,這些架構在保持模型性能的同時,能顯著減小模型的大小和計算需求。這不僅為LLMs的廣泛部署鋪平了道路,也為AI技術的綠色發展提供了可能。

英特爾公司的英特爾實驗室(Intel Labs)是一個致力于前沿科技研究的部門。英特爾實驗室以其在計算機科學和工程領域的深厚背景而聞名,其研究成果頻頻推動著整個行業的進步。在LLaMA-NAS的研究中,研究團隊憑借其在深度學習、神經網絡優化和硬件加速等方面的專業知識,提出了這一創新的解決方案,展現了英特爾在人工智能領域的深厚實力和遠見卓識。

1.方法

LLaMA-NAS(Large Language Model Architecture Neural Architecture Search)是一種針對大型語言模型(LLMs)的高效神經架構搜索方法。這項工作的方法論基于InstaTune方法,這是一種新穎的一次性NAS范例。InstaTune通過使模型的架構變得靈活,擴展了傳統微調過程,允許探索超越固定結構的更廣泛設計空間。這種靈活性使得能夠適應不同的任務、數據集和計算資源。InstaTune通過利用現有的模型權重,避免了從頭開始訓練超級網絡的需要。通過將NAS過程嵌入到微調階段,InstaTune節省了計算資源,同時確保衍生的子網絡特別針對目標任務進行了優化,而不是預訓練目標。

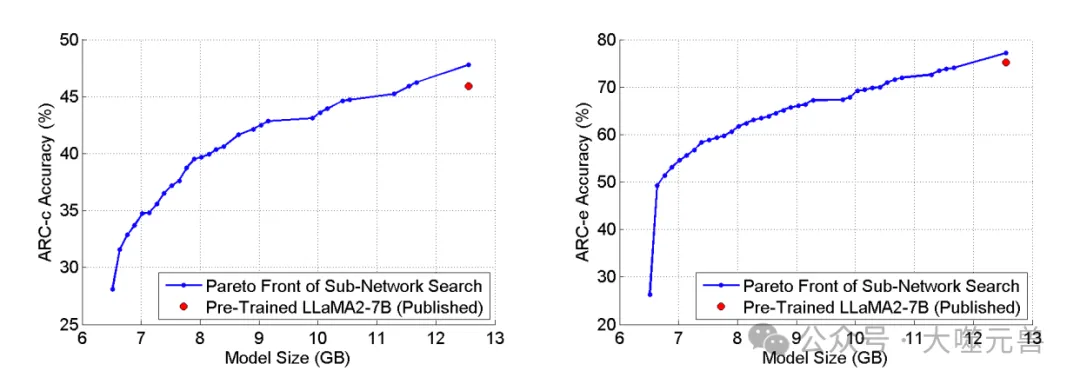

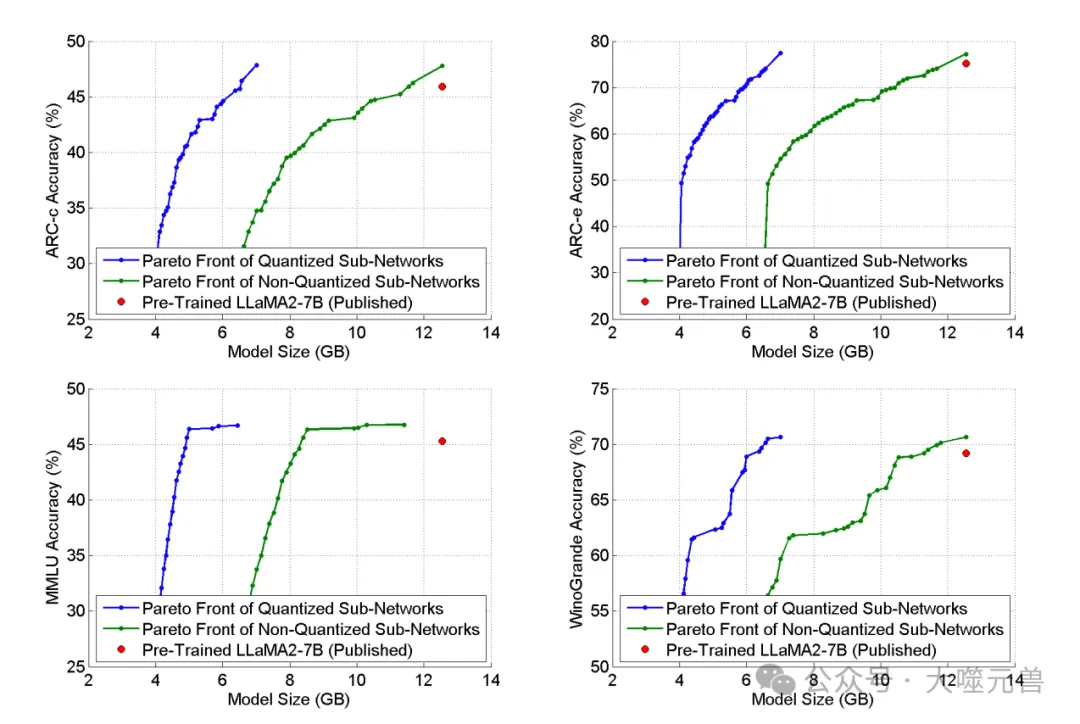

圖1:應用我們的方法搜索模型大小的最優子網絡架構后的Pareto前沿/ARC-c精度(左)和模型大小/ARC-e精度(右)目標空間。紅點表示[1]中預先訓練的LLaMA2-7B網絡的模型大小和精度。

一次性神經架構搜索(NAS)?

?大型語言模型(LLMs)在自然語言處理等領域取得了巨大的成功。然而這些模型的高內存和計算成本限制了它們在許多硬件平臺上的應用。傳統的模型壓縮方法,如剪枝、稀疏化和量化,雖然在一定程度上可以減小模型的大小,但對于LLMs來說并不一定有效。因此,我們需要一種更高效的方法來優化LLMs的網絡架構,以適應不同硬件平臺的需求。

LLaMA-NAS(Large Language Model Architecture Neural Architecture Search)的目標是找到Pareto最優的子網絡架構,以減小LLMs的大小和計算復雜度,同時保持模型性能。通過一次性神經架構搜索(NAS),LLaMA-NAS旨在在性能和資源消耗之間找到一個平衡點,使LLMs能夠更廣泛地部署,并在更多應用場景中發揮作用。?

方法步驟

LLaMA-NAS方法的核心思想是一次性神經架構搜索(NAS),旨在找到Pareto最優的子網絡架構,以減小大型語言模型(LLMs)的大小和計算復雜度,同時保持模型性能。

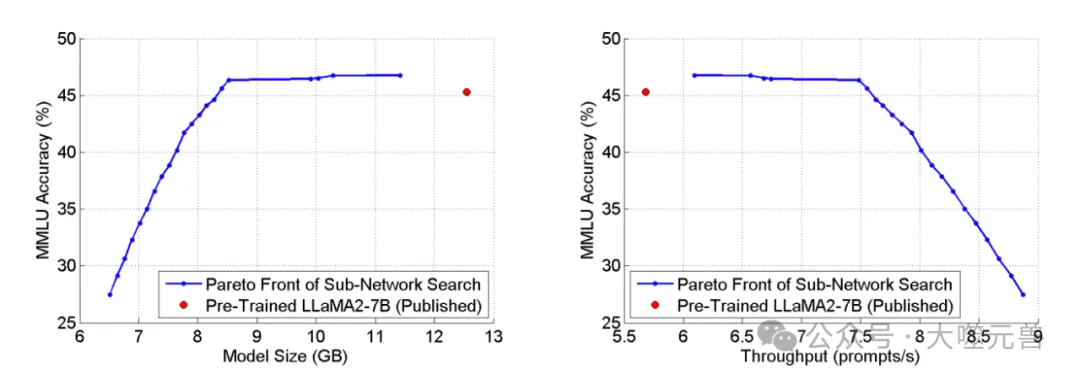

圖2:應用我們的方法搜索MMLU任務的最優子網絡后的Pareto前沿。左Pareto前沿在模型大小/MMLU精度目標空間中,而右Pareto前沿則在吞吐量中/MMLU精度目標空間。使用單個NVIDIA TitanV GPU評估吞吐量,紅點表示[1]中預訓練的LLaMA2-7B網絡的模型大小和精度。

預訓練模型微調:使用預訓練的LLaMA2-7B模型作為初始模型。通過微調(如InstaTune)對模型進行優化,以適應特定任務。微調的目標是在保持模型性能的同時,調整模型的參數,使其更適合特定任務。

遺傳算法搜索:基于遺傳算法進行神經架構搜索。在模型大小和準確度的目標空間中,搜索Pareto最優的子網絡架構。通過遺傳算法的迭代優化,找到更小、計算復雜度更低的網絡架構。

子網絡評估:對搜索到的子網絡進行評估,包括準確度、模型大小和計算速度等指標。確定哪些子網絡在Pareto前沿上,即在性能和大小之間具有優勢。

結果分析:展示搜索到的Pareto最優子網絡架構。比較這些子網絡與預訓練的LLaMA2-7B網絡的性能。

通過LLaMA-NAS,我們可以找到適用于更便宜、更易獲得的硬件平臺的高效LLMs網絡架構,從而推動人工智能技術的普及和可持續發展。

2.結果

LLaMA-NAS方法通過一次性神經架構搜索(NAS)找到了Pareto最優的子網絡架構,這些架構在保持模型性能的同時,顯著減小了模型的大小和計算需求。

Pareto最優子網絡架構

LLaMA-NAS方法通過遺傳算法搜索成功地找到了多個Pareto最優的子網絡架構。這些子網絡架構在準確度和大小方面都展現出顯著的優勢,與預訓練的LLaMA2-7B網絡相比,它們實現了性能和資源消耗之間的理想平衡。

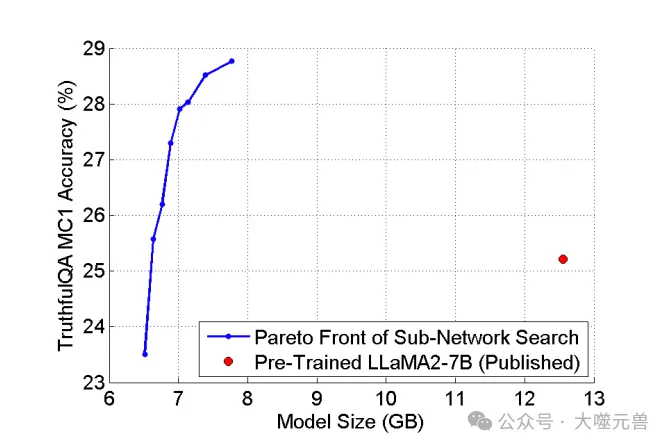

圖3:將我們的工作應用于模型大小/TruthfulQA MC1精度目標空間中的Alpaca微調LLaMA2-7B后的Pareto前沿。紅點表示使用來自的權重預訓練的LLaMA2-7B網絡https://huggingface.co/meta-llama/Llama-2-7b.

利用遺傳算法,LLaMA-NAS在模型大小和準確度的目標空間中進行搜索,以找到最優的子網絡架構。通過遺傳算法的迭代過程,不斷優化子網絡的結構,以達到更小的模型大小和更低的計算復雜度,同時保持或提升模型的準確度。

相對于預訓練的LLaMA2-7B網絡,LLaMA-NAS找到的子網絡在不犧牲準確度的前提下,顯著減小了模型的大小。這些子網絡在保持性能的同時,提高了計算速度,使得模型在實際應用中更加高效。

子網絡優勢分析

在多個標準基準任務中,LLaMA-NAS方法找到的子網絡相對于預訓練的LLaMA2-7B網絡展現出以下優勢,子網絡在保持準確度的同時,顯著減小了模型的大小,這對于在內存受限的設備上部署模型尤為重要。子網絡提高了計算速度,這對于需要快速響應的應用場景,如實時語言翻譯或在線客戶服務,具有重要意義。

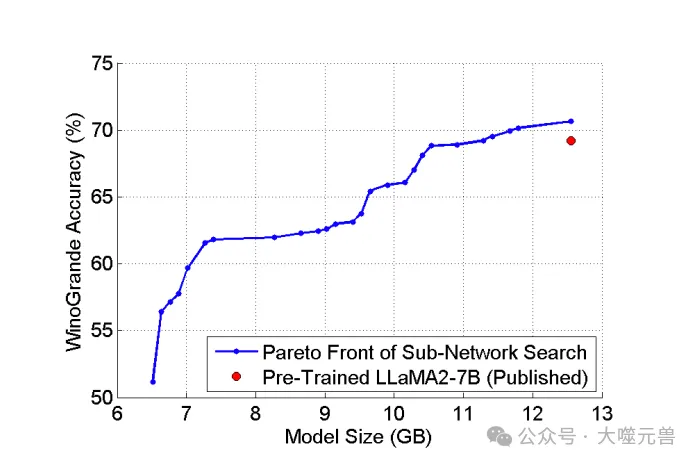

圖4:將我們的工作應用于模型大小/WinoGrande精度目標空間中的Alpaca微調LLaMA2-7B后的Pareto前沿。紅點表示[1]中預先訓練的LLaMA2-7B網絡的模型大小和精度。

例如,在TruthfulQA任務中,LLaMA-NAS找到的一個子網絡相對于預訓練的LLaMA2-7B網絡,在準確度上提高了3.6%,同時模型大小減小了1.6倍。這一結果不僅證明了LLaMA-NAS在優化網絡架構方面的有效性,也展示了其在實際應用中的潛力。

圖5:在模型大小/精度目標空間中將INT8量化應用于Alpaca微調LLaMA2-7B之前和之后的Pareto前沿。藍線是量化的(INT8)Pareto前沿,而綠線是原始的非量化的(FP16)Pareto前部,也如圖1至圖4所示。紅點表示[1]中預訓練的非量化LLaMA2-7B網絡的模型大小和精度。

LLaMA-NAS方法為大型語言模型的高效神經架構搜索提供了一種新途徑,使其適用于更廣泛的硬件平臺,并在性能和資源消耗之間取得了平衡。

3.量化效果分析

LLaMA-NAS方法不僅關注于找到Pareto最優的子網絡架構,還考慮了這些架構在實際部署中的計算效率。在這一部分,我們將討論應用固定點(INT8)量化對子網絡性能的影響。

量化方法

量化是一個簡單的過程,可以使用現有的多種技術來實現。研究團隊使用固定點(INT8)量化來進一步提高Pareto最優子網絡的性能。量化后,這些子網絡在模型大小和準確度的目標空間中被重新評估。所有解碼層中的線性操作都被量化為INT8,而其余層(例如嵌入層)保持在FP16。量化對準確度的影響很小,但在減小模型大小方面提供了很大的好處。例如,一個未量化的子網絡在MMLU任務中的準確度比預訓練的LLaMA2-7B網絡高1.1%,模型大小減少了1.5倍,量化后保持了準確度,但現在變得更小,減少了2.5倍。

INT8(8位整數)量化是一種常見的模型壓縮技術,用于減小模型的內存占用和計算需求。在INT8量化中,模型的權重和激活值被量化為8位整數,從而減小了存儲和計算開銷。

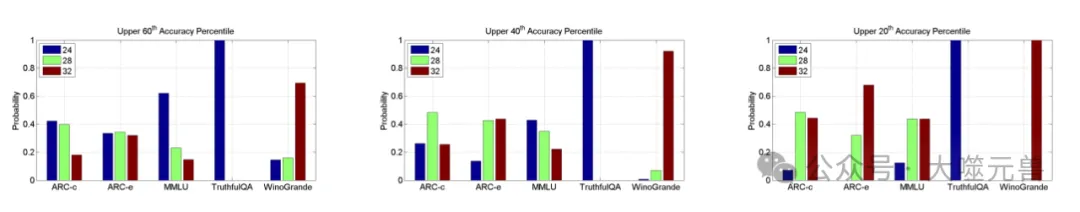

圖6:在搜索過程中選擇的網絡對于每個任務具有層計數l∈{24,28,32}的概率。概率適用于精度在上60(左)、40(中)和20(右)百分位數的子網絡。

量化效果

模型大小減小:應用INT8量化后,子網絡的模型大小顯著減小。這對于在資源受限的設備上部署LLMs至關重要。

計算速度提高:INT8量化可以加速模型的推理速度,因為8位整數的計算更高效。這對于實時應用和大規模部署非常有益。

準確度影響:雖然量化通常會對模型的準確度產生一定影響,但在LLaMA-NAS中,我們注意到量化對準確度的影響很小。例如,在某些子網絡中,即使應用了INT8量化,準確度仍然保持不變或僅有微小變化。

通過應用INT8量化,LLaMA-NAS找到的Pareto最優子網絡在保持性能的同時,顯著減小了模型的大小和計算需求。這為LLMs在更廣泛的硬件平臺上的部署提供了可能,同時也為環境的可持續性做出了貢獻。

4.網絡架構特征分析

LLaMA-NAS方法不僅關注于找到Pareto最優的子網絡架構,還深入研究了這些架構的特征。在這一部分,我們將分析子網絡的層數和中間大小的概率分布,并探討不同任務對網絡架構特征的敏感性。

層數分析

在大多數情況下,更深的網絡層數會導致更高的準確度。這是因為更多的層可以增加模型的學習能力和表達能力。然而,LLaMA-NAS的研究發現,在某些任務中,如ARC-c、MMLU和TruthfulQA,增加層數并不總是導致更好的性能。這表明預訓練的LLaMA2-7B模型對這些任務來說可能過于復雜,有過度參數化的傾向。

不同任務對網絡層數的選擇顯示出不同的敏感性。例如,TruthfulQA任務傾向于選擇較少層數的網絡,只選擇了24層的網絡,這可能是因為該任務不需要過于復雜的模型來處理。相比之下,WinoGrande任務則更傾向于選擇32層的網絡,這可能反映了該任務需要更復雜的模型來捕捉更細微的語言特征。

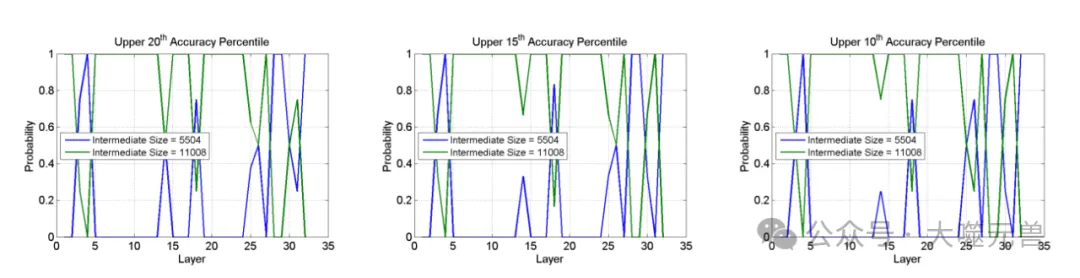

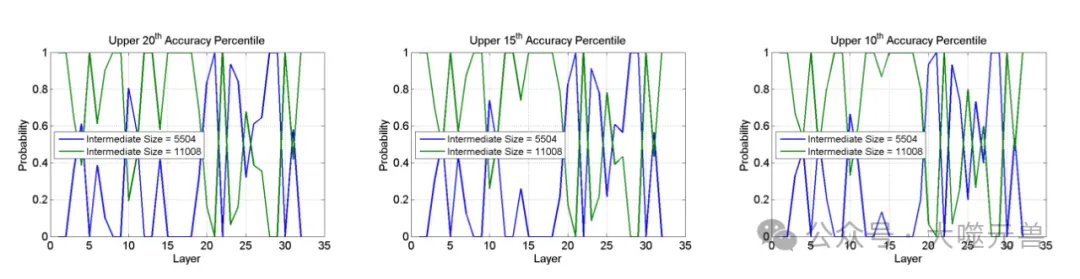

圖7:在Alpaca微調LLaMA2-7B的模型大小/ARC-c精度空間中進行子網絡搜索后,不同中間大小的概率。概率是針對32層子網絡的,精度在上20(左)、15(中)和10(右)百分位數。

中間大小分析

LLaMA-NAS的研究還發現,在某些子網絡中,特定層的中間大小對準確度有顯著影響。例如,在處理ARC-c任務時,選擇5504的中間大小而不是11008,可以在某些層上實現與預訓練的LLaMA2-7B網絡相當的準確度。這表明通過精細調整網絡的中間層大小,可以在不犧牲性能的情況下減小模型的復雜度。

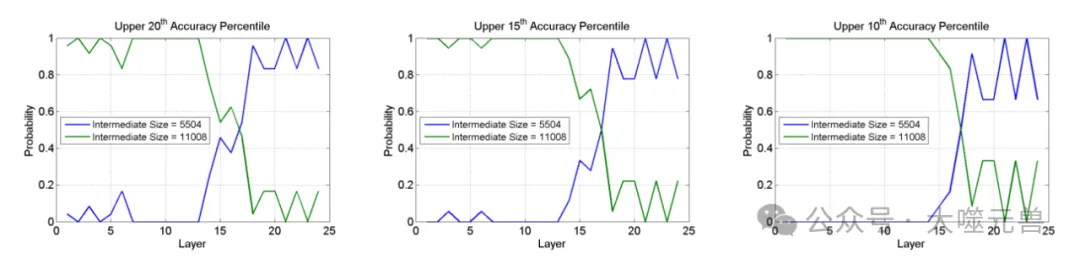

圖8:在Alpaca微調LLaMA2-7B的模型大小/MMLU精度空間中進行子網絡搜索后,不同中間大小的概率。概率適用于精度在上20(左)、15(中)和10(右)百分位數的24層子網絡。

不同任務對中間大小的選擇也表現出明顯的差異。在MMLU任務中,早期層(1-16層)更傾向于選擇11008的中間大小,而后期層(18-24層)則更傾向于選擇5504的中間大小。這可能是因為早期層需要更大的容量來捕捉基本的語言特征,而后期層則需要更小的容量來進行特定任務的細節處理。

圖9:在Alpaca微調LLaMA2-7B的模型大小/WinoGrande精度空間中進行子網絡搜索后,不同中間大小的概率。概率是針對32層子網絡的,精度在上20(左)、15(中)和10(右)百分位數。

LLaMA-NAS的網絡架構特征分析揭示了不同任務對網絡設計的需求差異,為更好地優化LLMs提供了指導。這種分析有助于我們理解如何根據特定任務的需求來調整網絡架構,以實現最佳的性能和效率平衡。

總結

LLaMA-NAS的研究為大型語言模型(LLMs)的神經架構搜索(NAS)領域帶來了革命性的進步。通過一次性NAS,LLaMA-NAS成功地在模型性能和計算資源之間找到了一個平衡點,這對于推動LLMs在更廣泛的應用場景中的部署具有重要意義。

LLaMA-NAS通過減小模型大小和計算復雜度,使LLMs能夠在資源受限的設備上運行,這對于在邊緣計算環境中部署AI模型尤為關鍵。盡管模型變得更加輕量,但LLaMA-NAS找到的子網絡仍能保持高準確度,確保了模型的實用性和可靠性。由于模型的計算需求降低,LLaMA-NAS促進了LLMs的快速部署,特別是在需要實時處理的應用中。

應用前景

LLaMA-NAS使得LLMs能夠在各種硬件平臺上運行,包括那些價格更便宜、更易獲得的設備,從而擴大了LLMs的潛在用戶群體。通過減少計算資源的需求,LLaMA-NAS為環境可持續性做出了貢獻,減少了能源消耗和碳足跡。LLaMA-NAS為在新興市場和應用中部署LLMs提供了可能性,包括移動設備、物聯網(IoT)和遠程地區的應用。

潛在價值

LLaMA-NAS降低了部署LLMs的成本,使得中小企業和低資源環境也能夠利用先進的NLP技術。通過使LLMs適用于更廣泛的硬件平臺,LLaMA-NAS有助于人工智能技術的普及和教育。LLaMA-NAS的方法為未來的研究提供了新的方向,鼓勵開發更高效、更智能的NAS算法。

LLaMA-NAS的研究不僅在技術層面取得了突破,更在實際應用和社會影響方面展現了巨大的潛力。隨著人工智能技術的不斷進步,LLaMA-NAS及其后續研究將繼續推動LLMs向著更高效、更可持續、更普及的方向發展。

參考資料:???https://arxiv.org/abs/2405.18377??

本文轉載自 ??大噬元獸??,作者: FlerkenS